面试题

网络协议

图论

web3

搭建网站

硬件工程

绘图机器人

点云

Linux命令

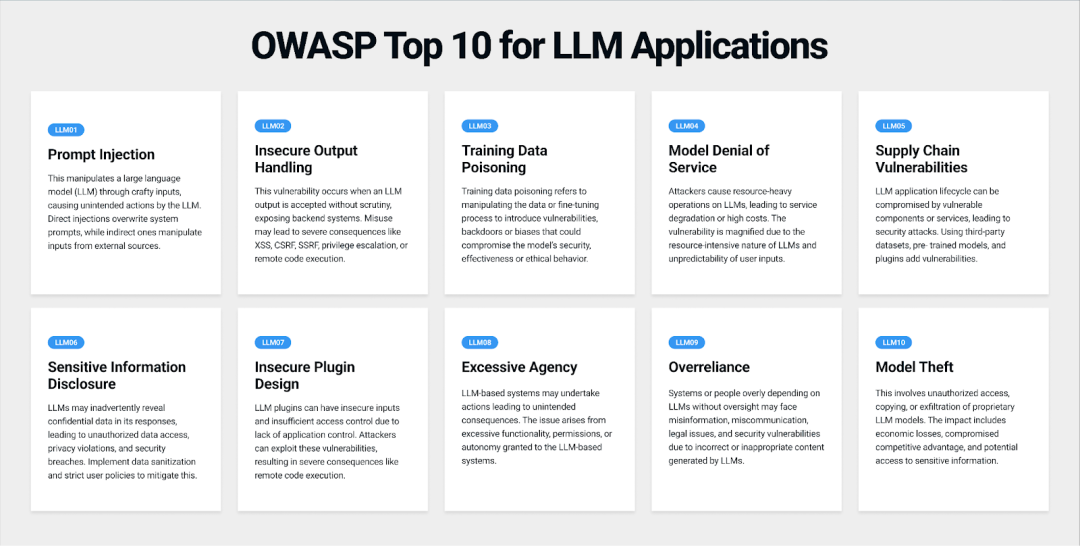

反射型XSS

globalmapper

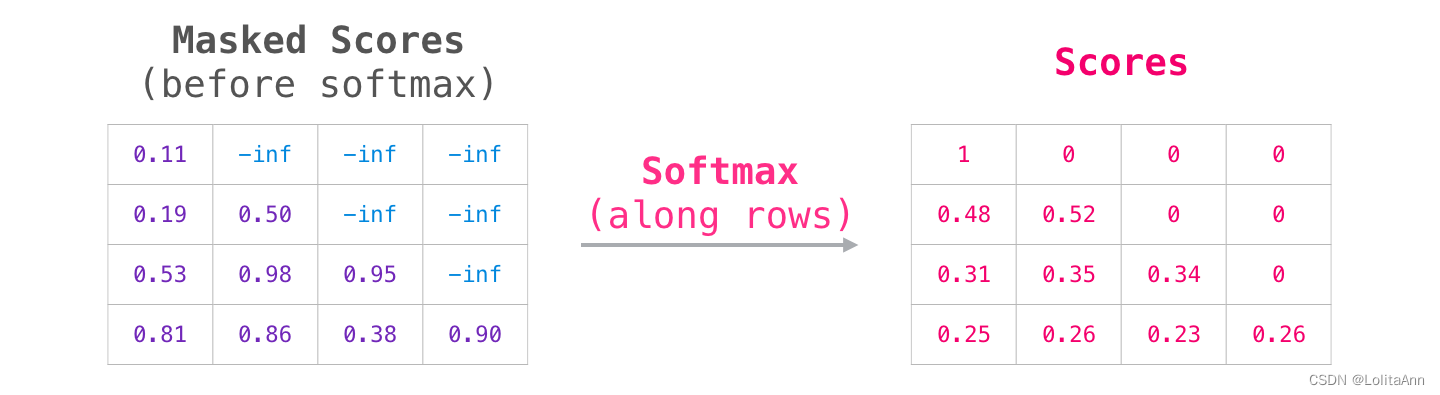

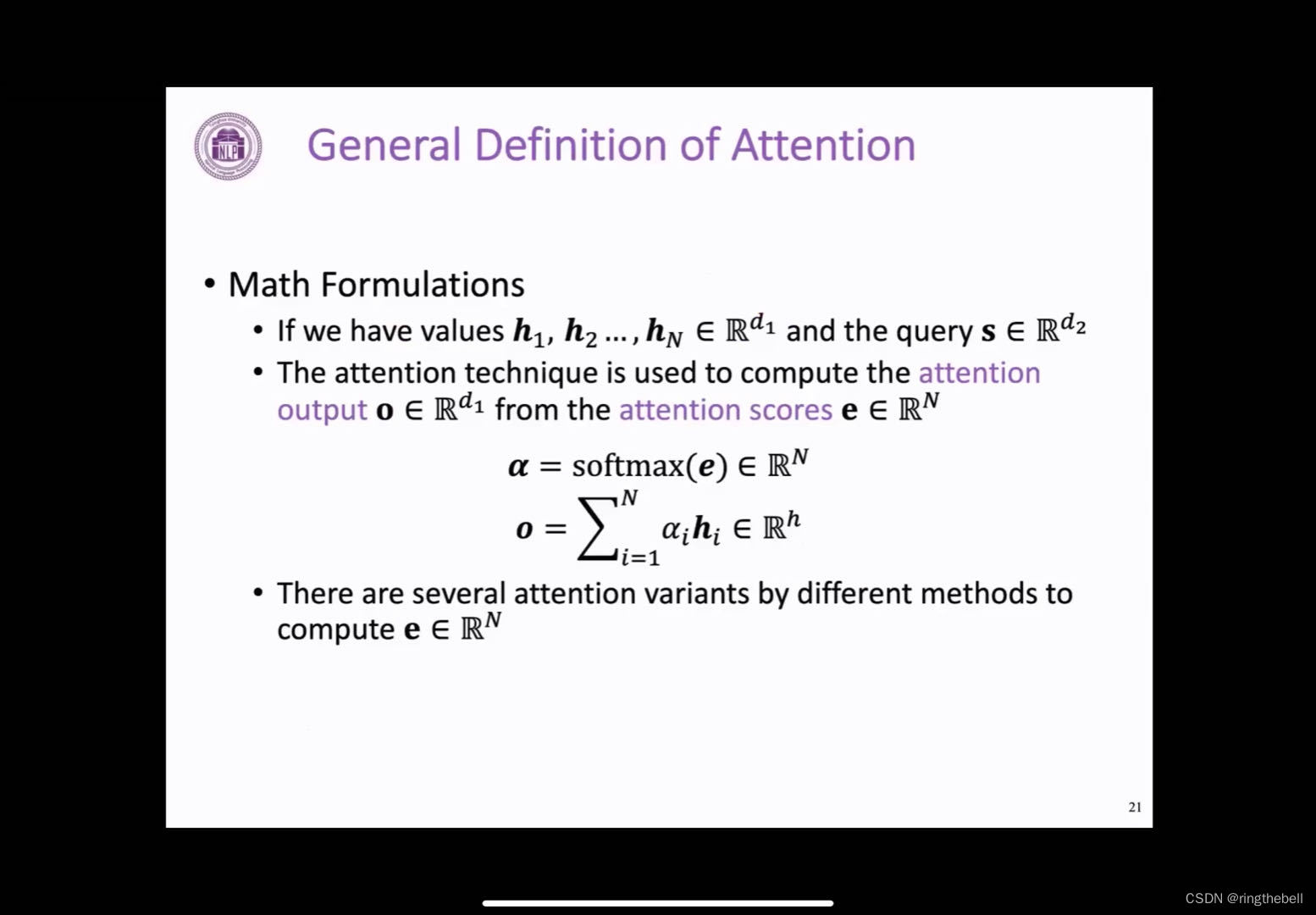

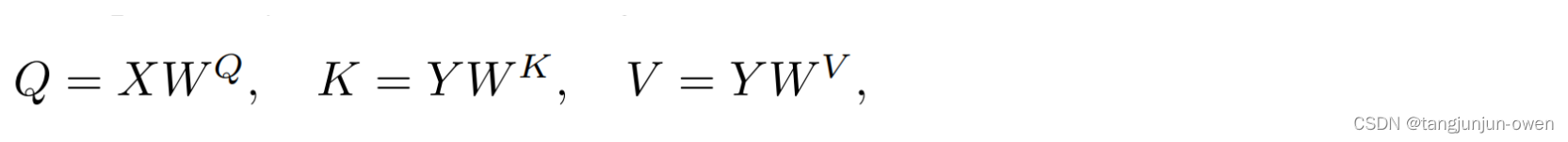

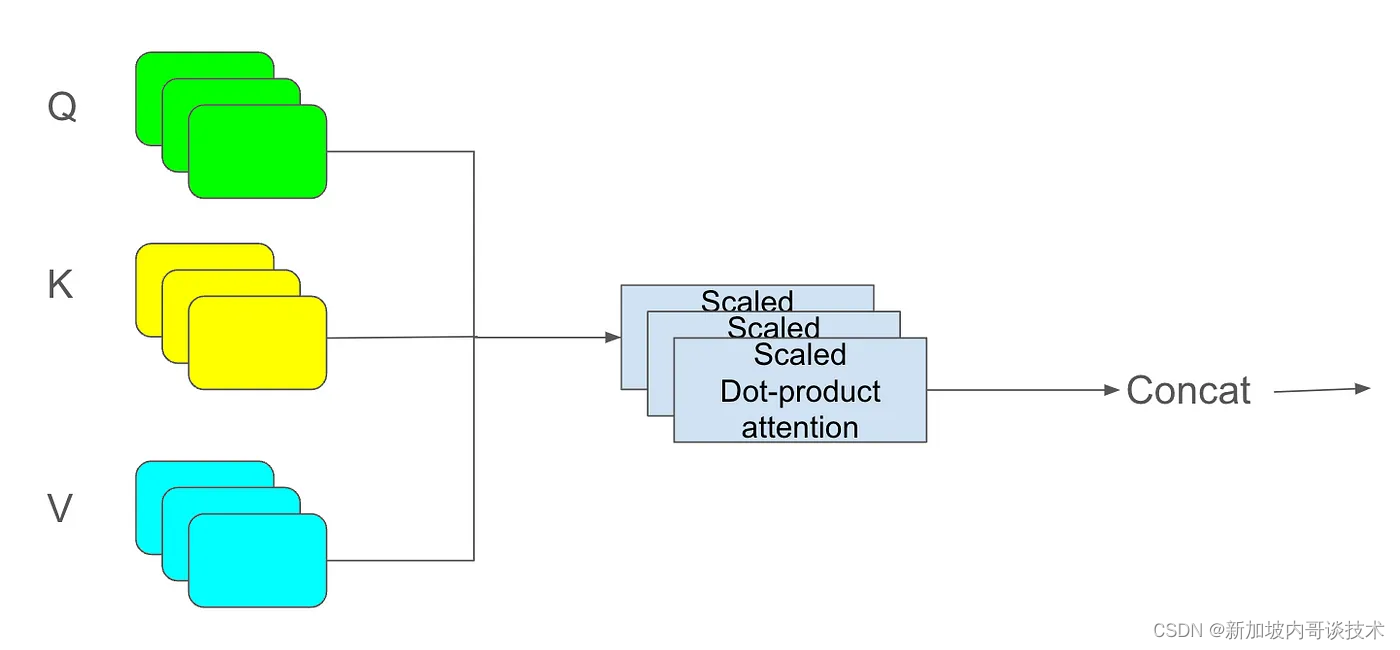

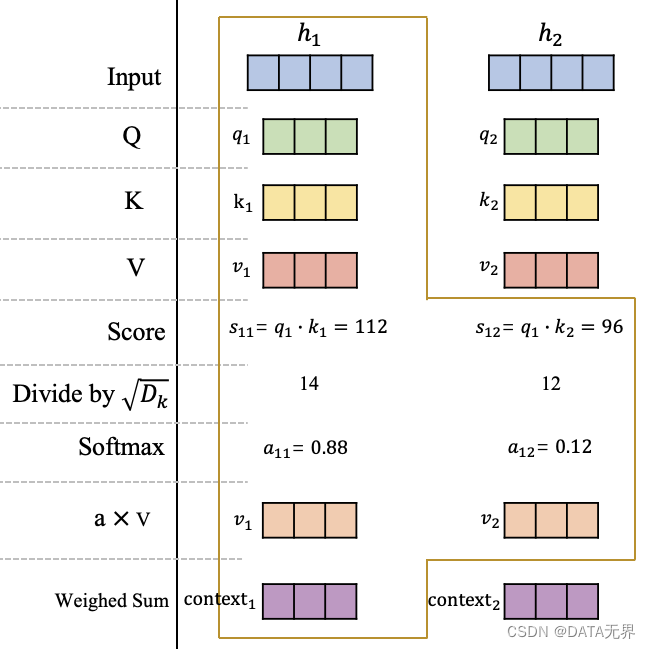

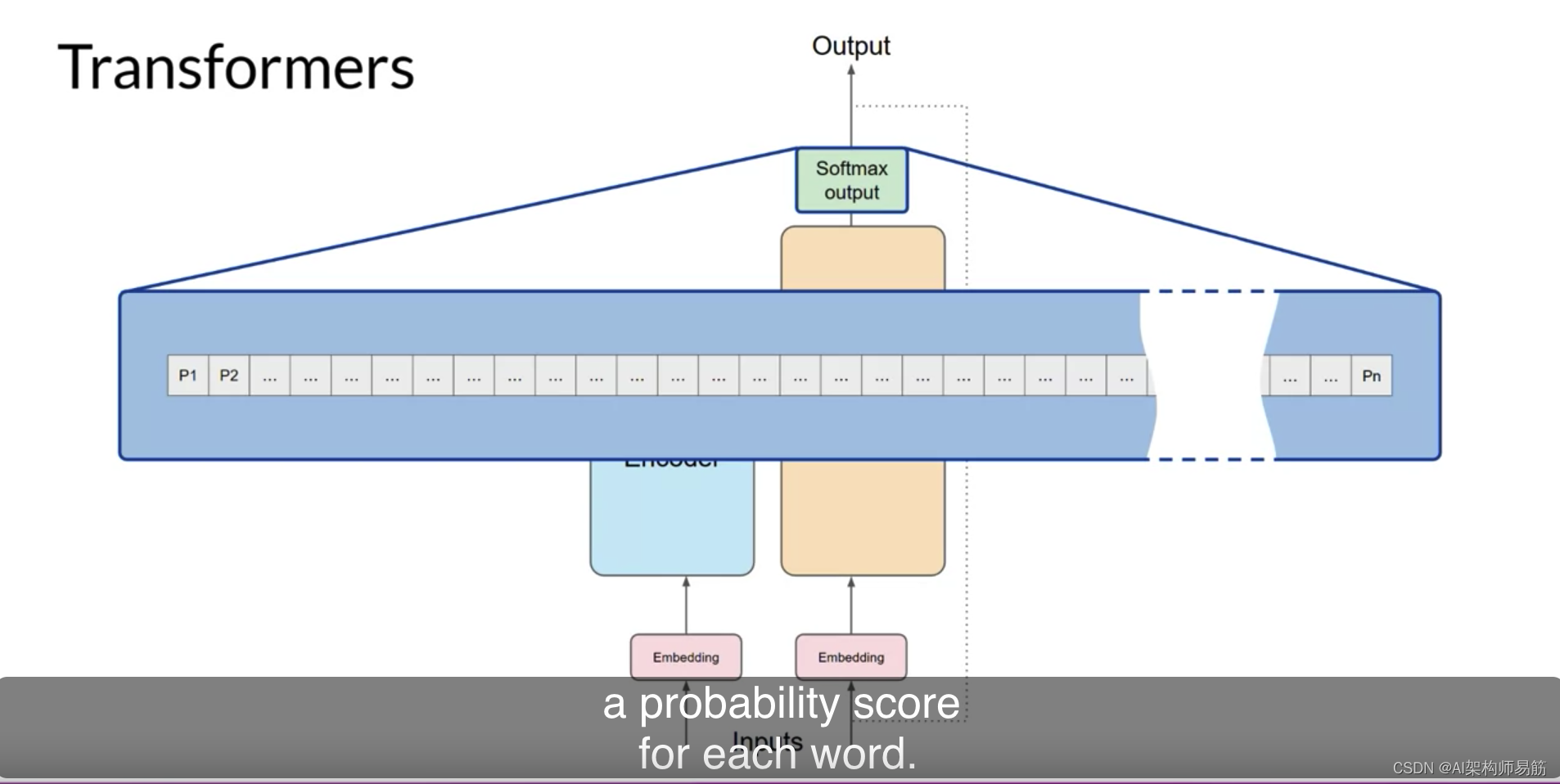

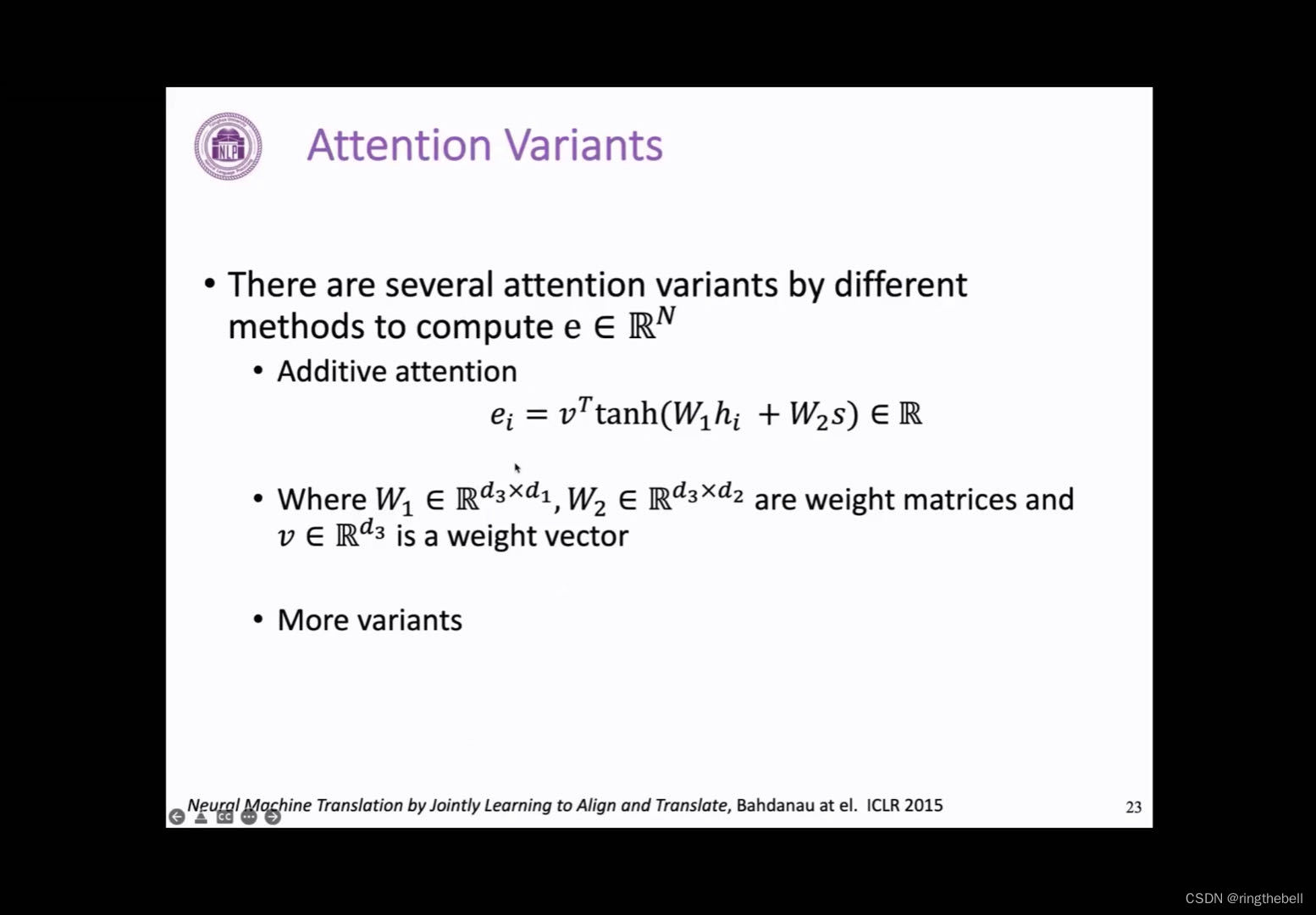

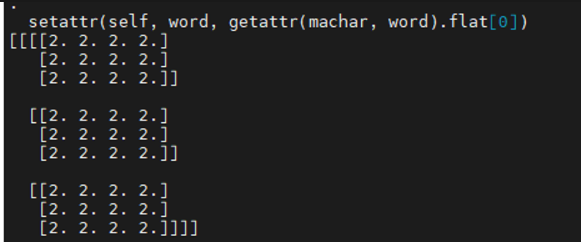

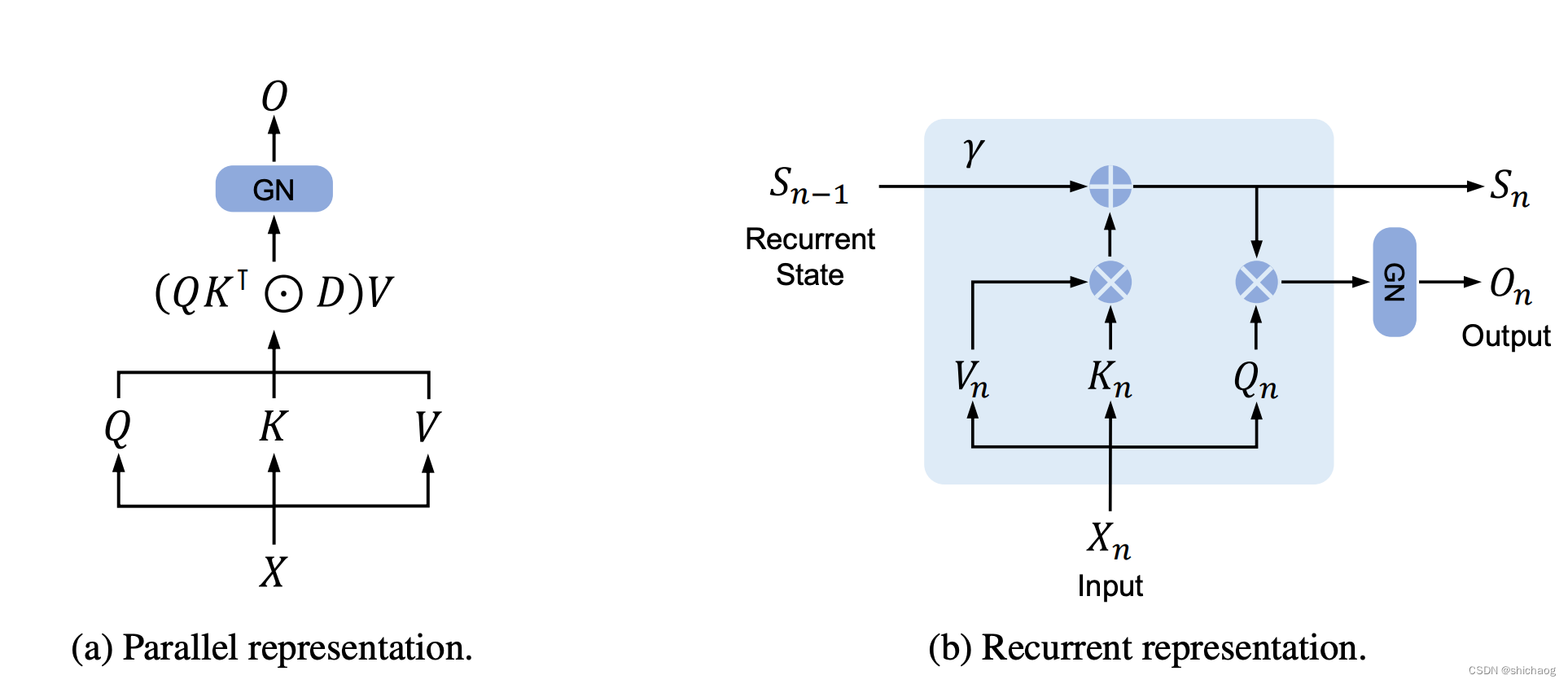

self-attention

制图表达

Exception

android-studio

哈夫曼树

期末考试

泰勒展开式

地图制图

链接

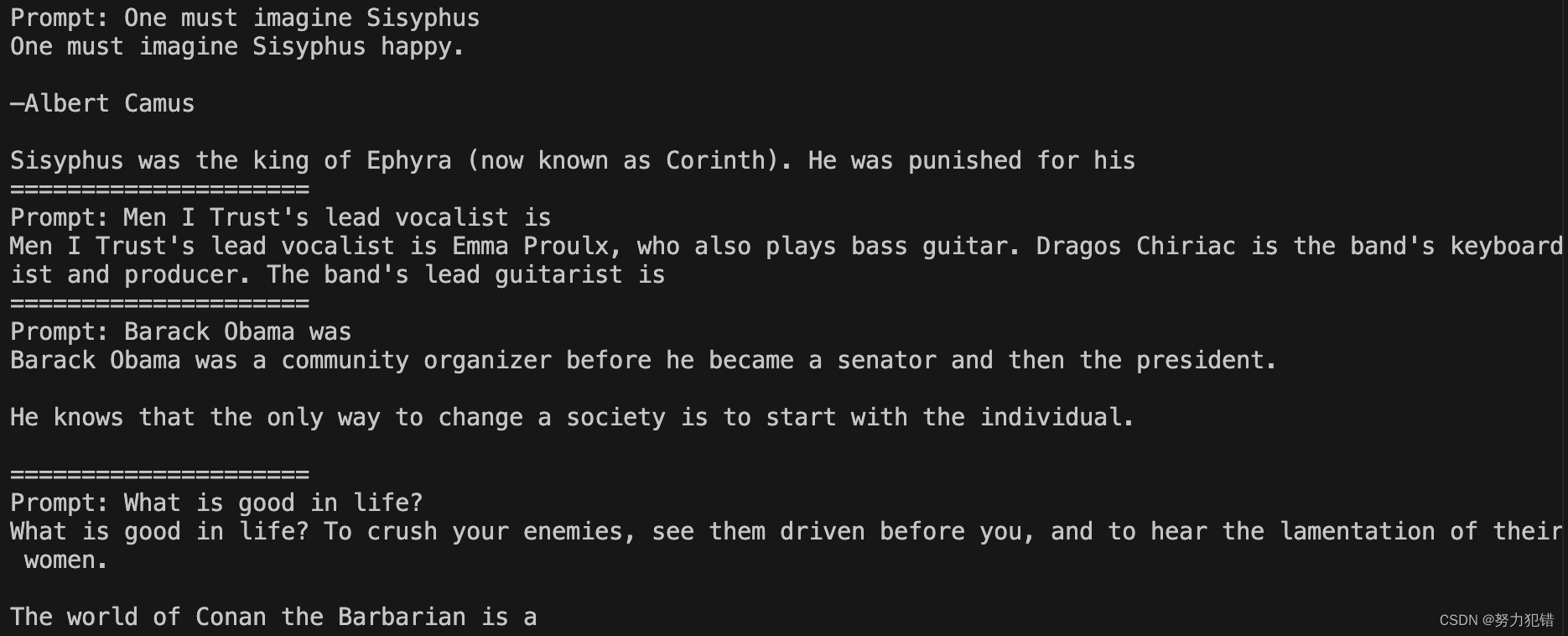

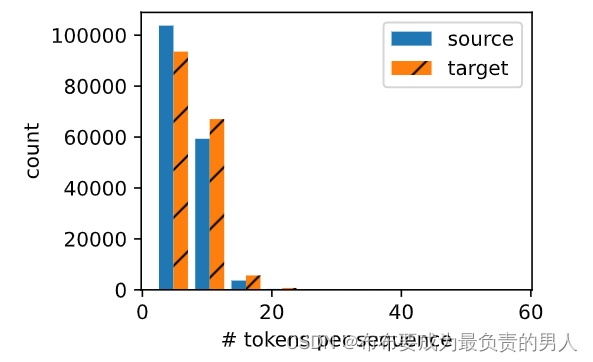

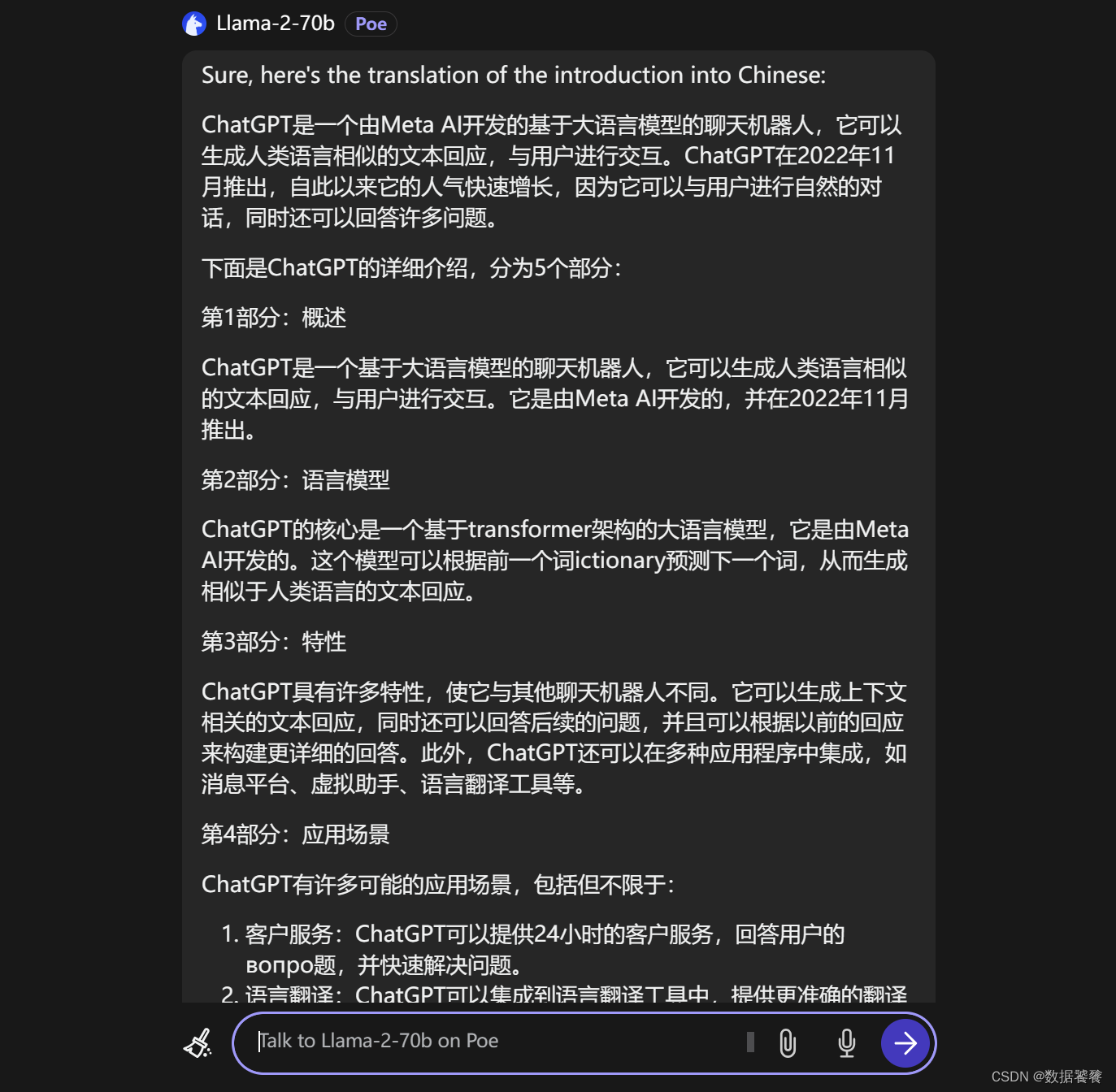

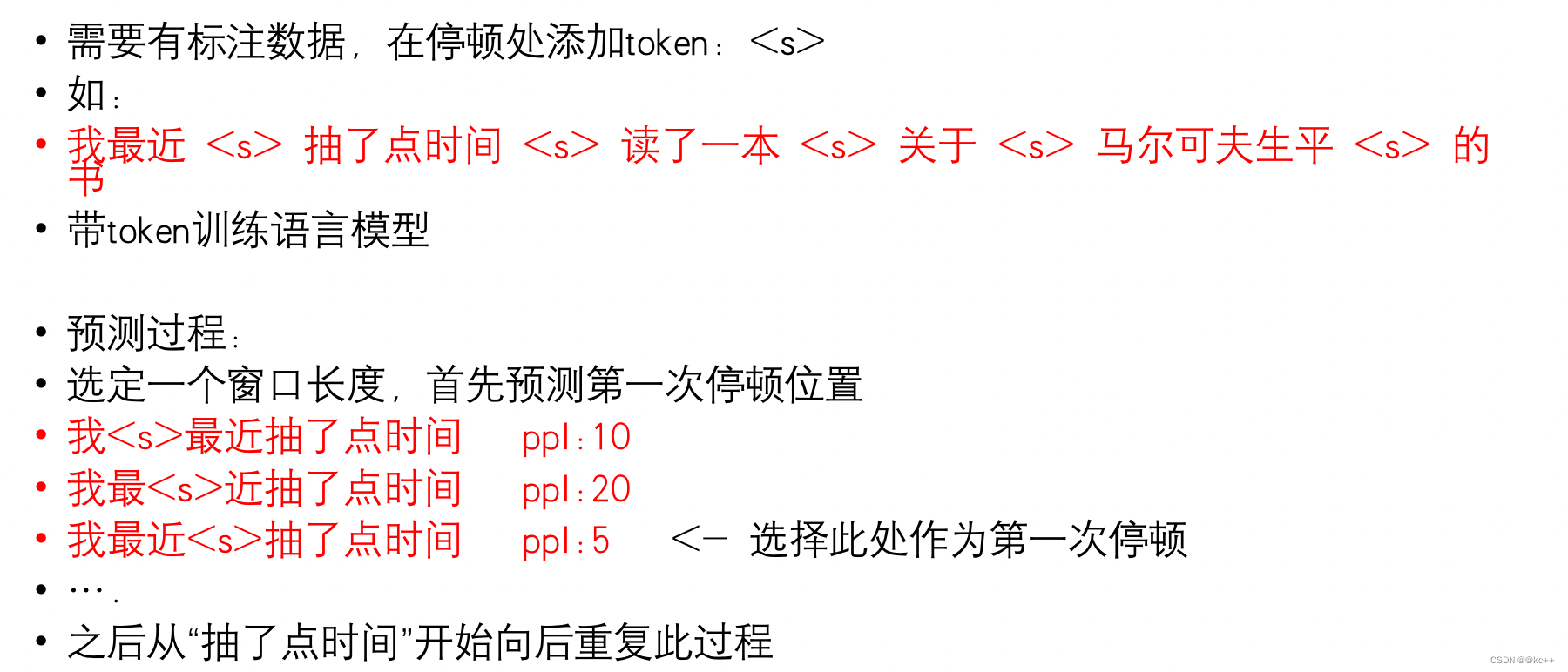

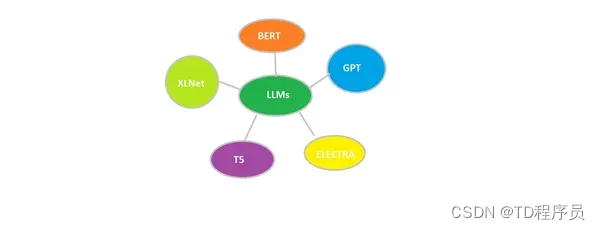

语言模型

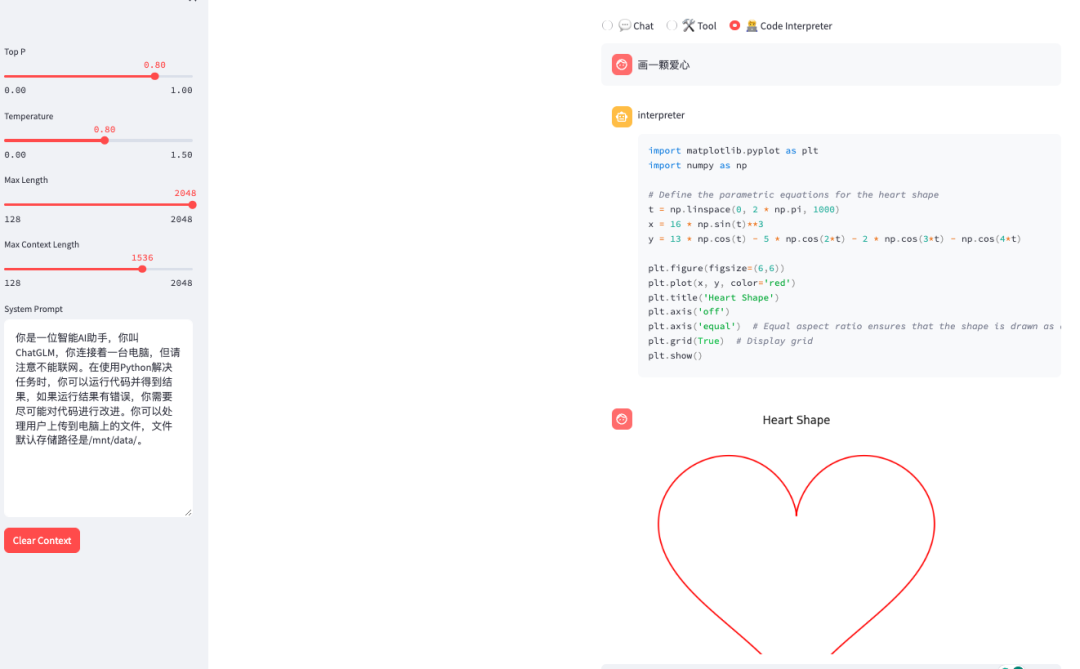

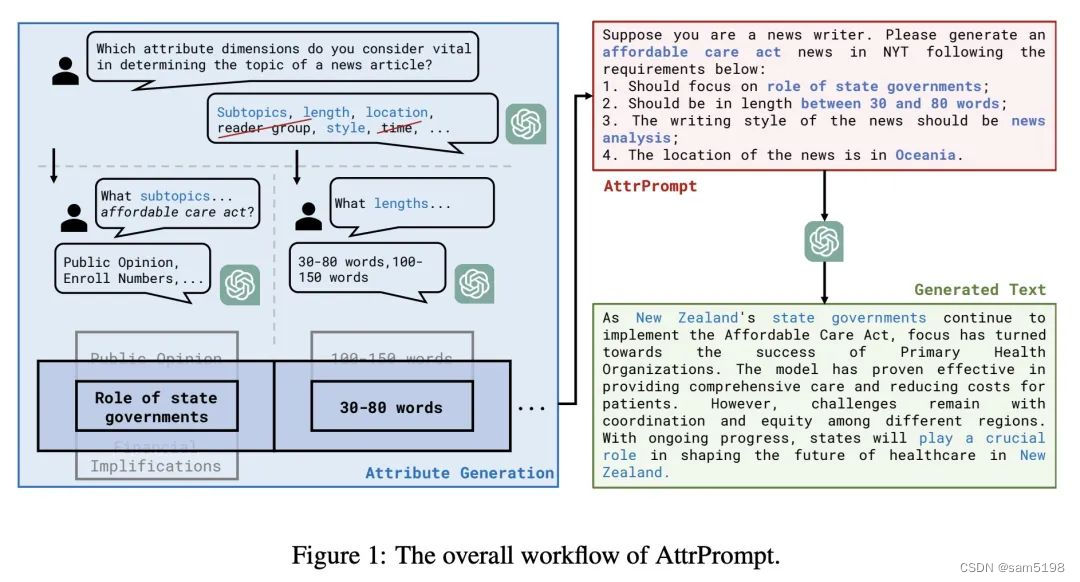

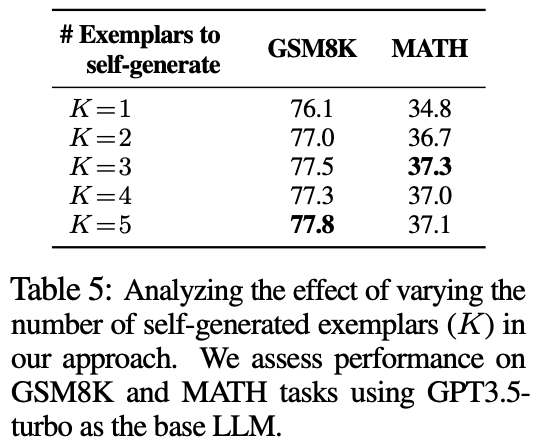

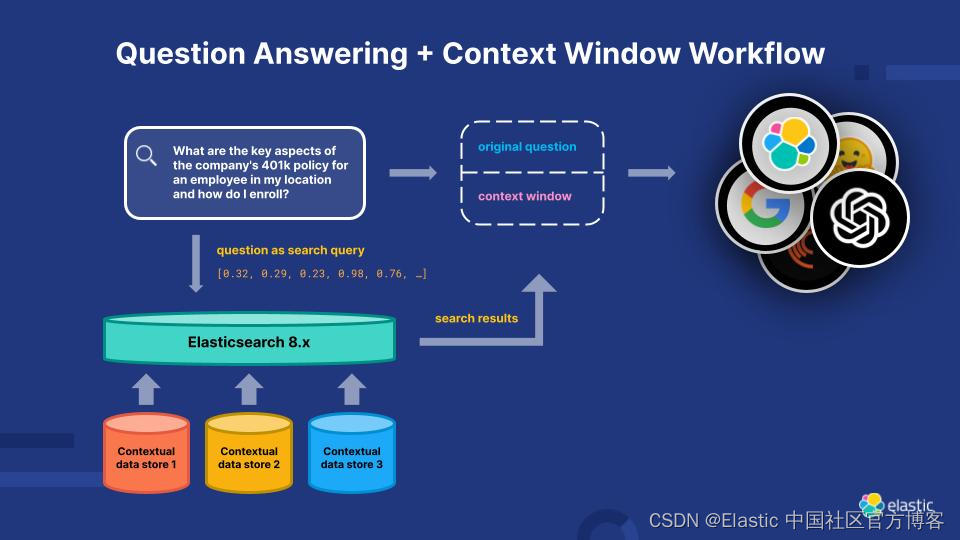

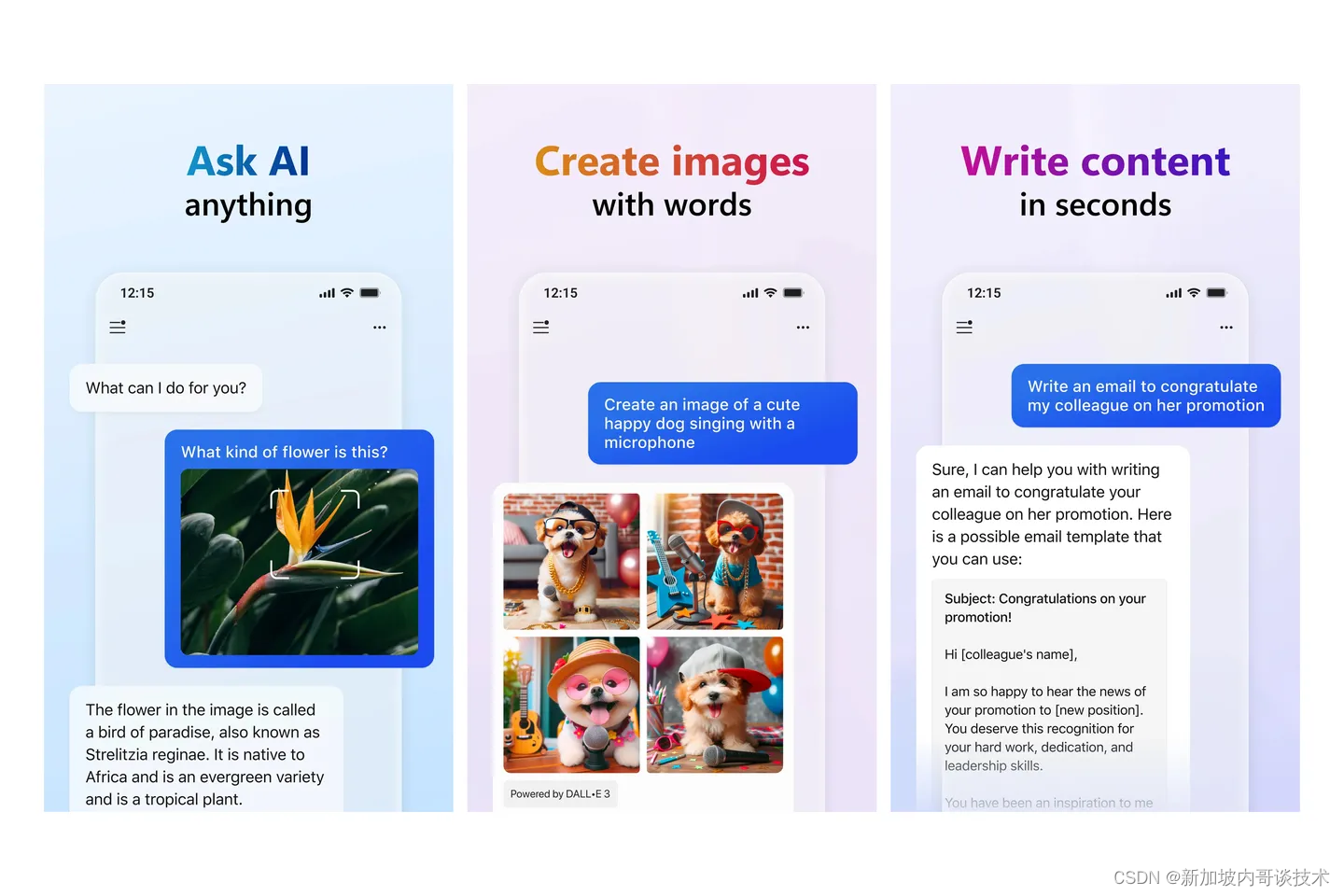

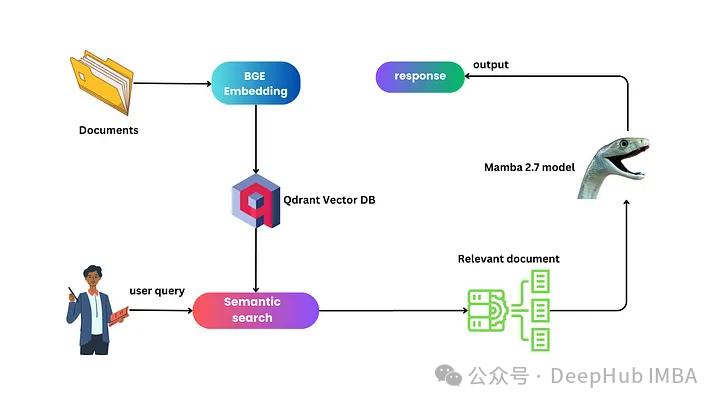

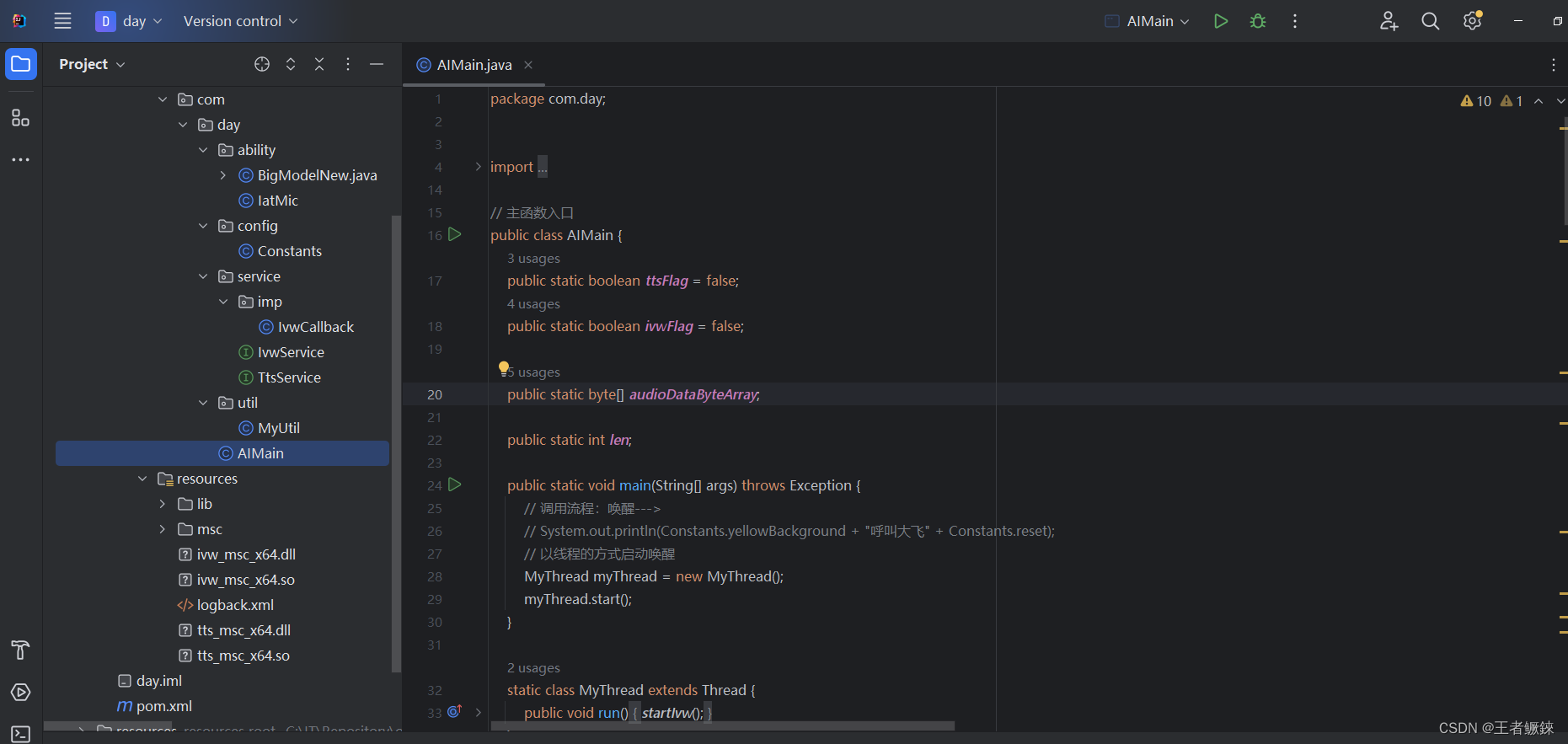

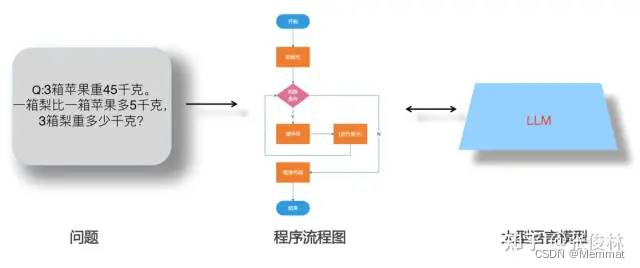

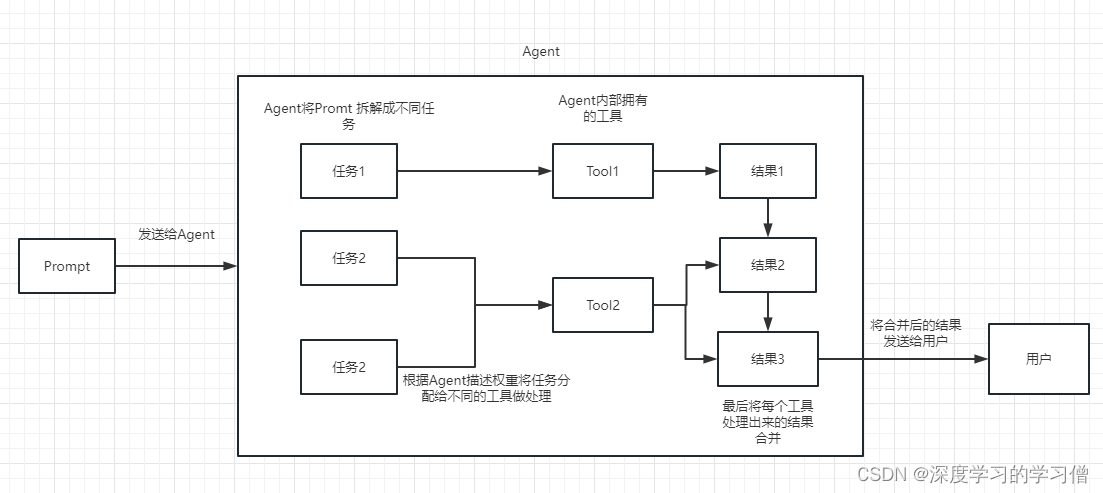

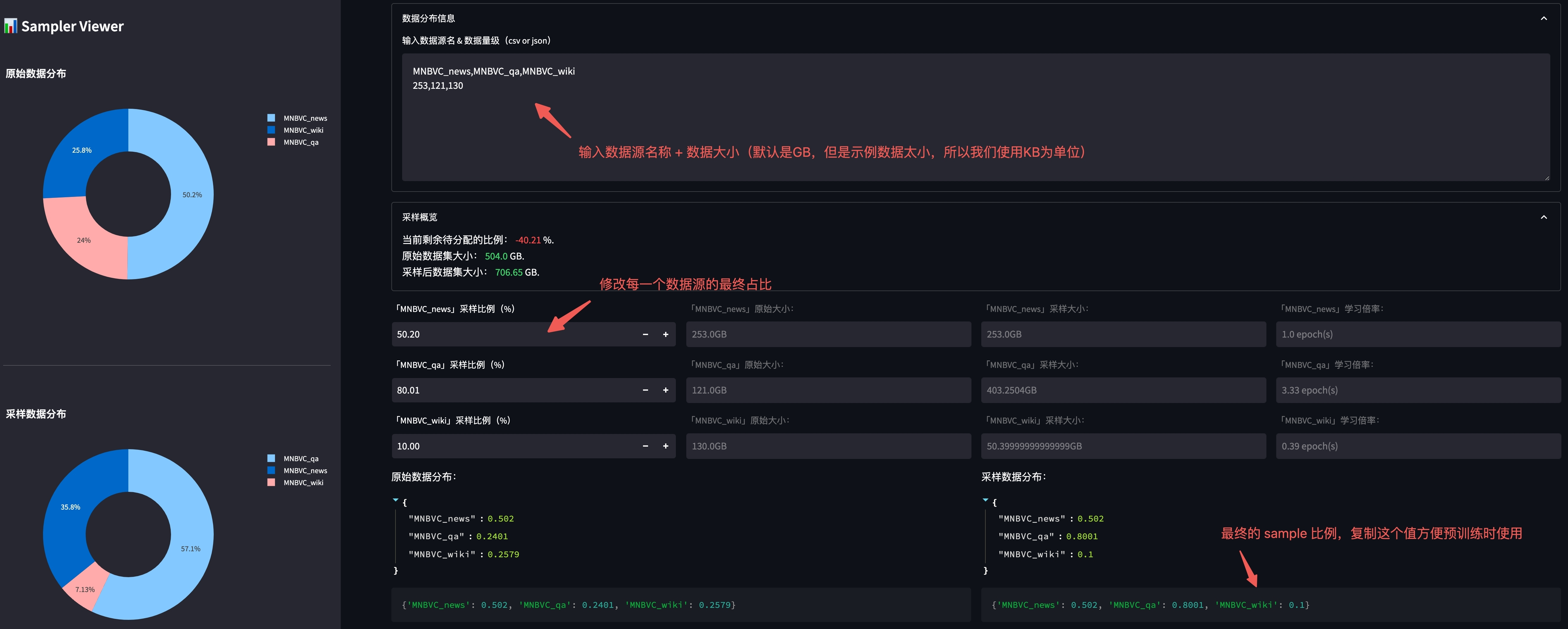

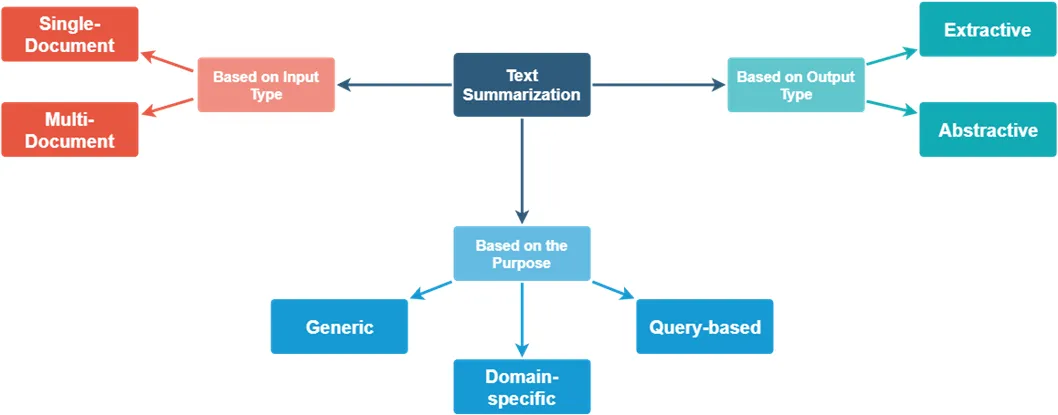

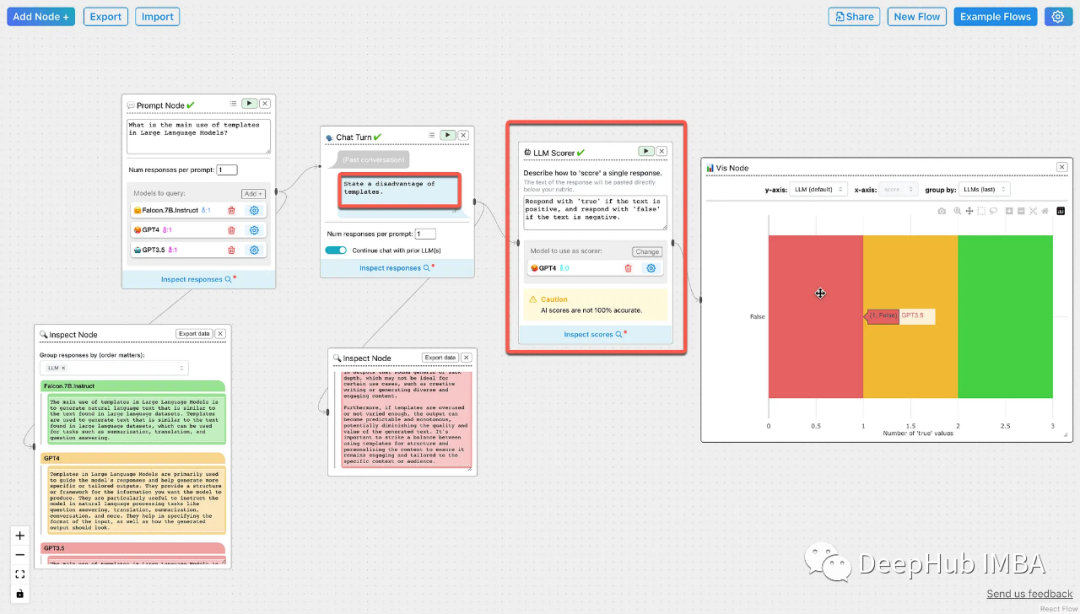

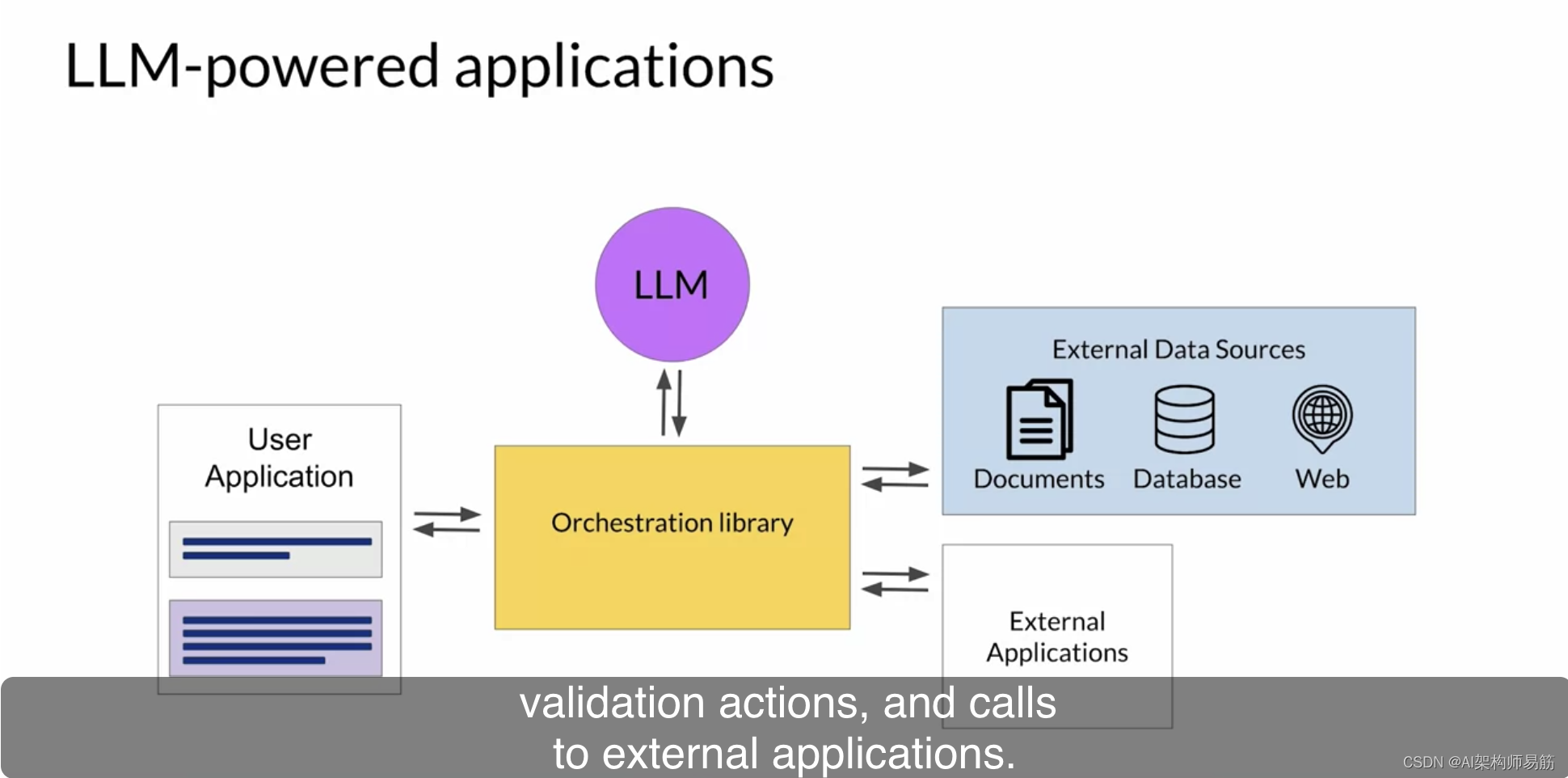

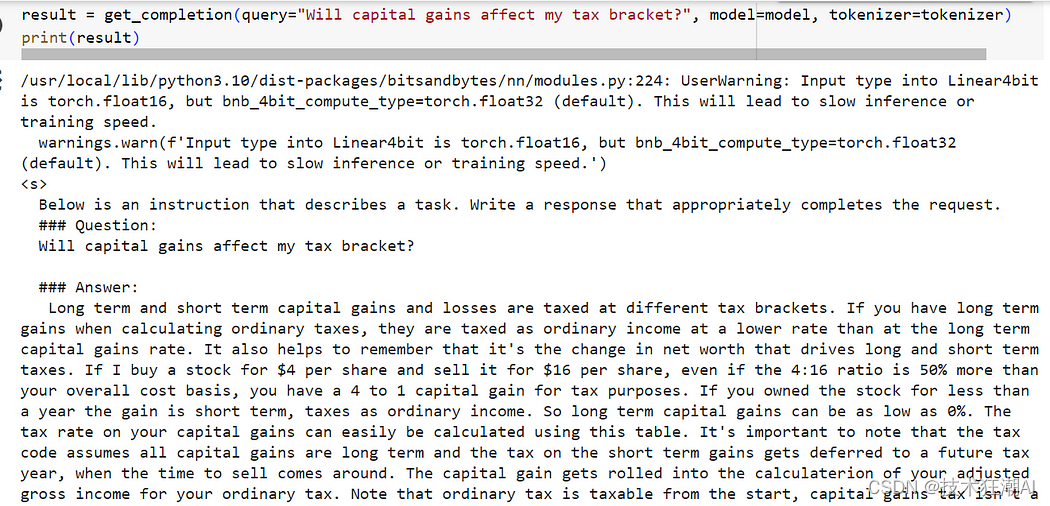

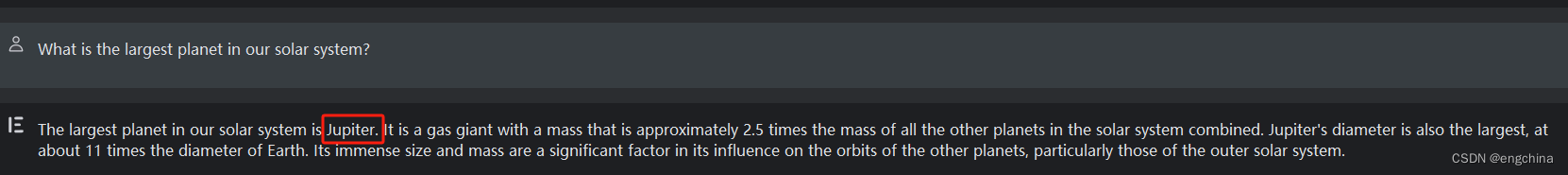

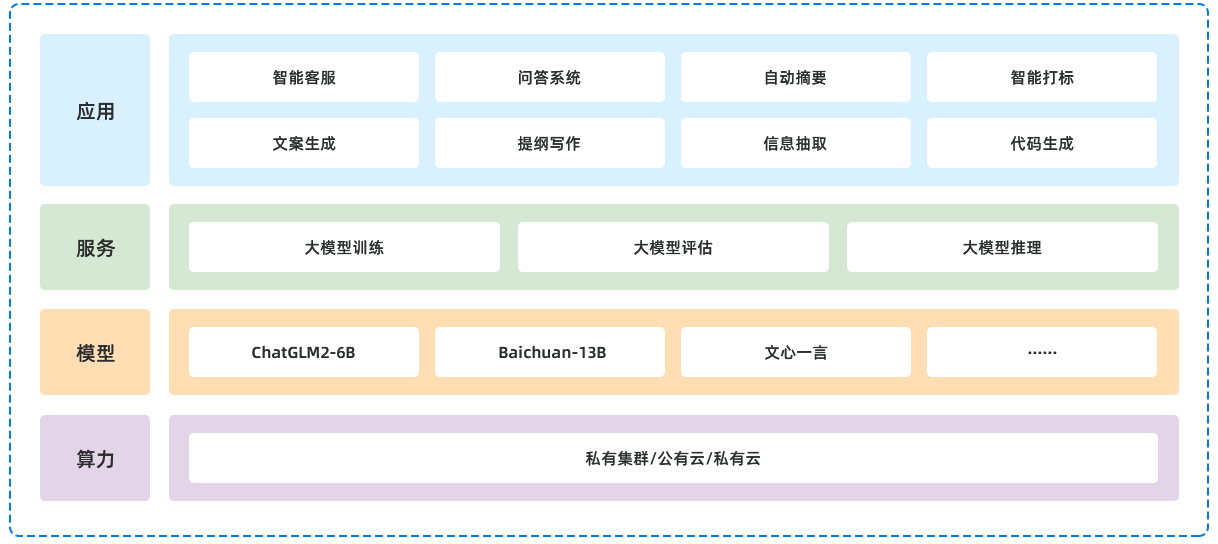

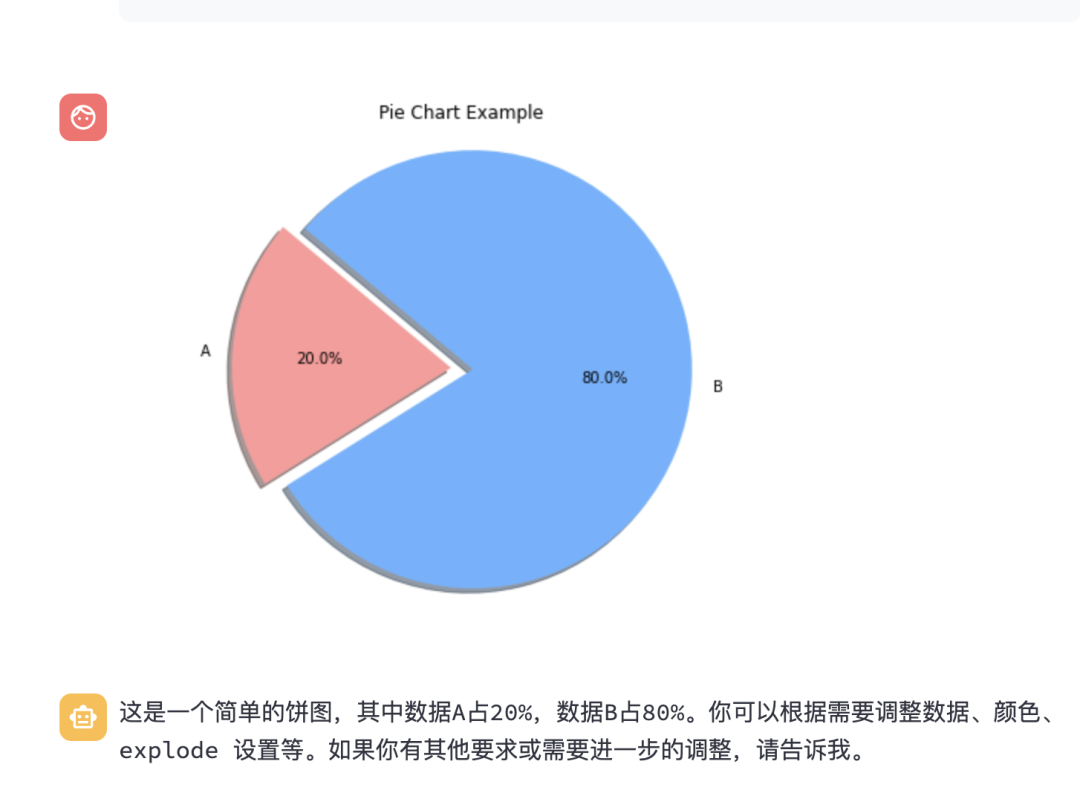

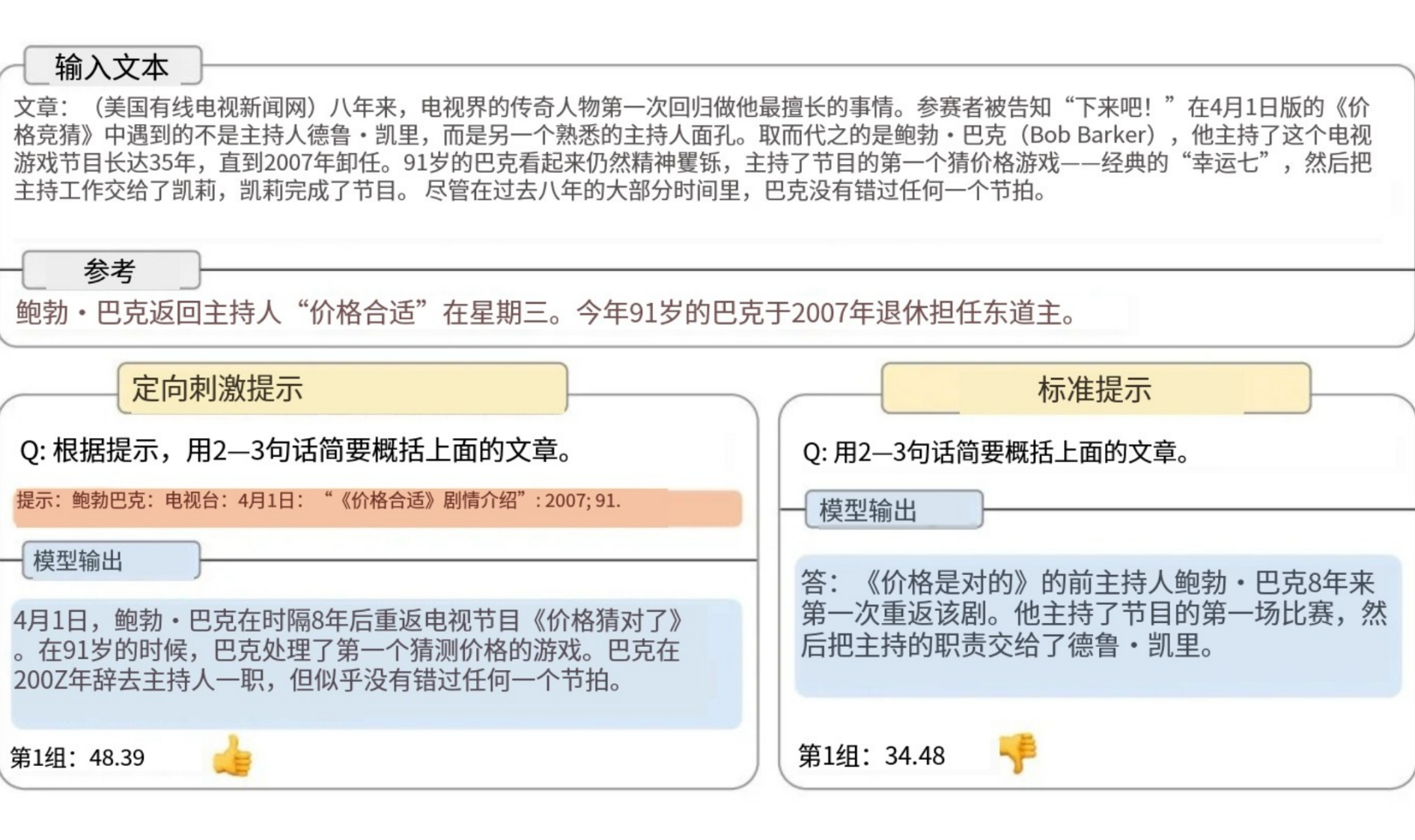

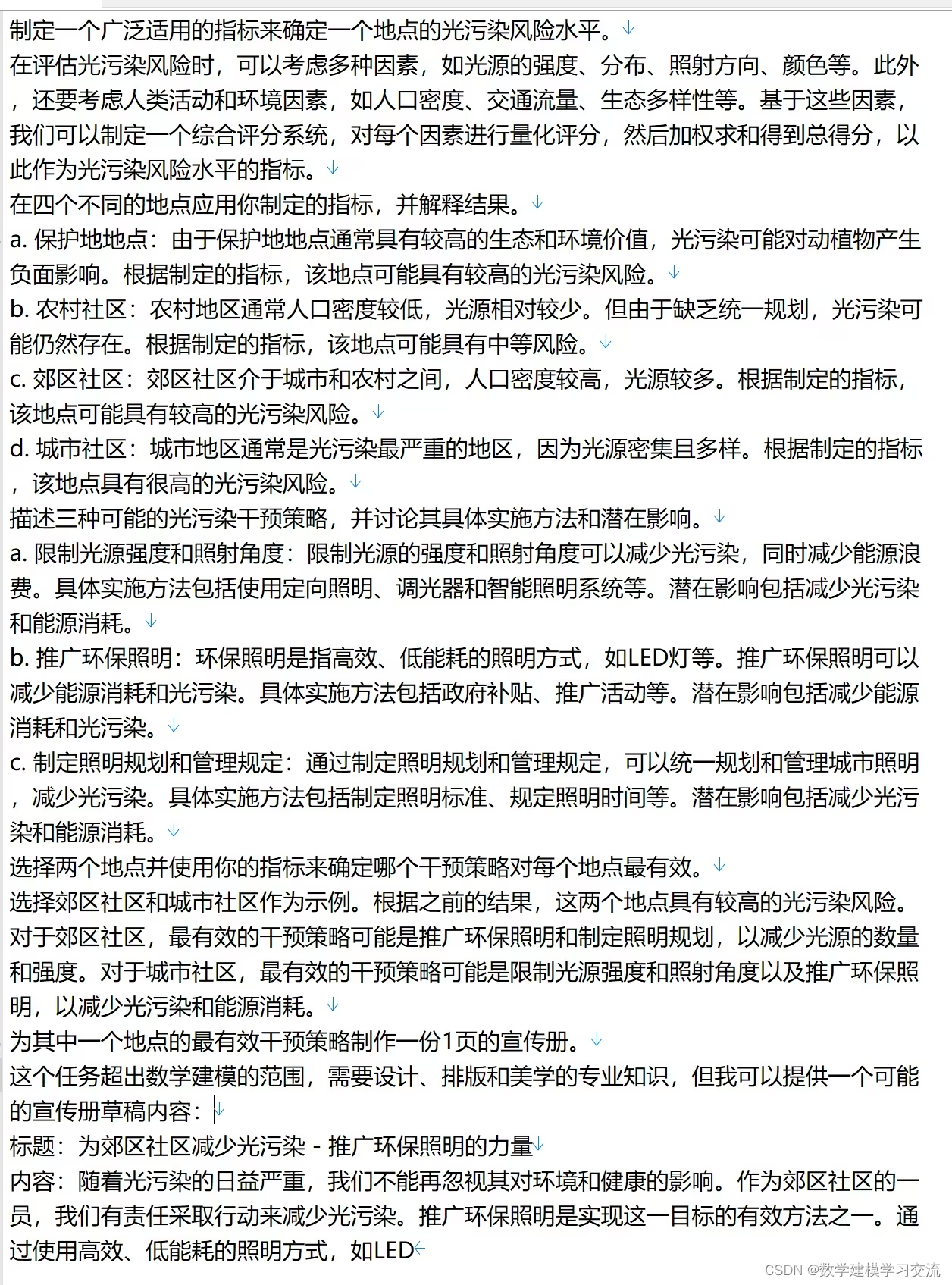

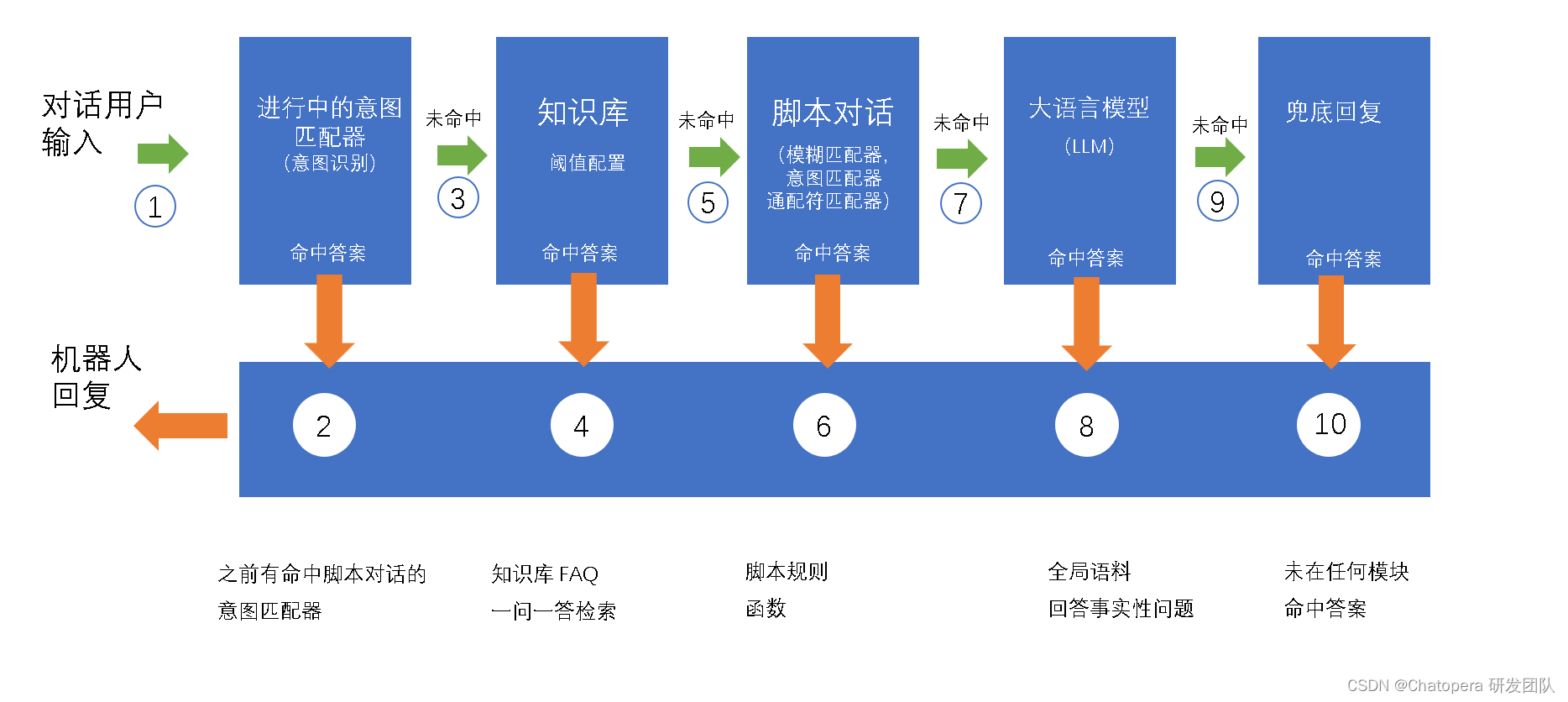

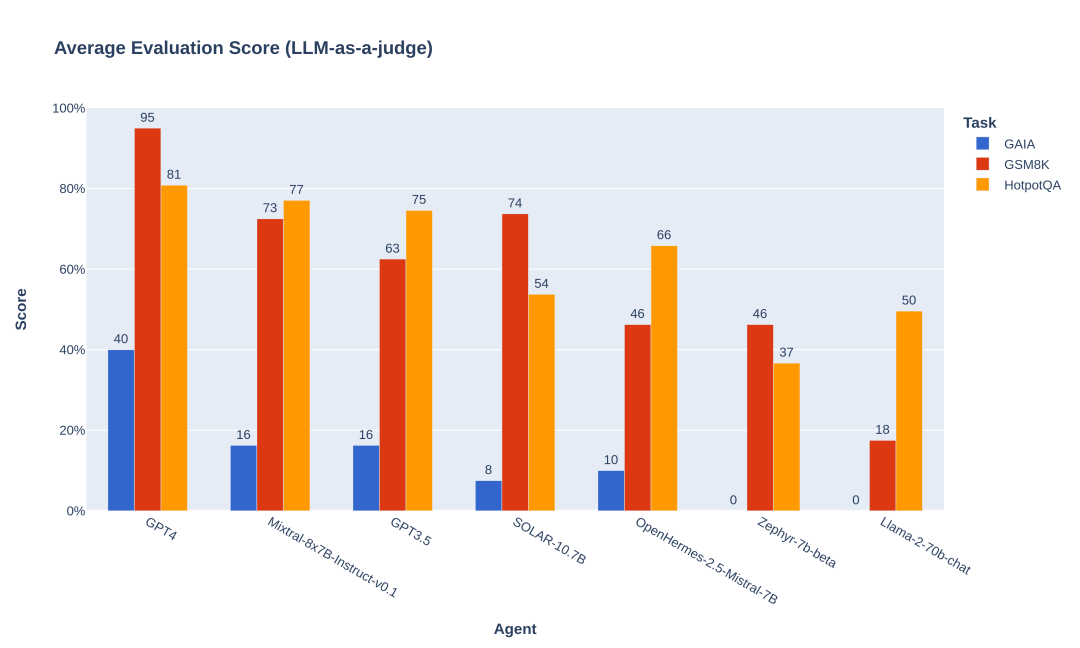

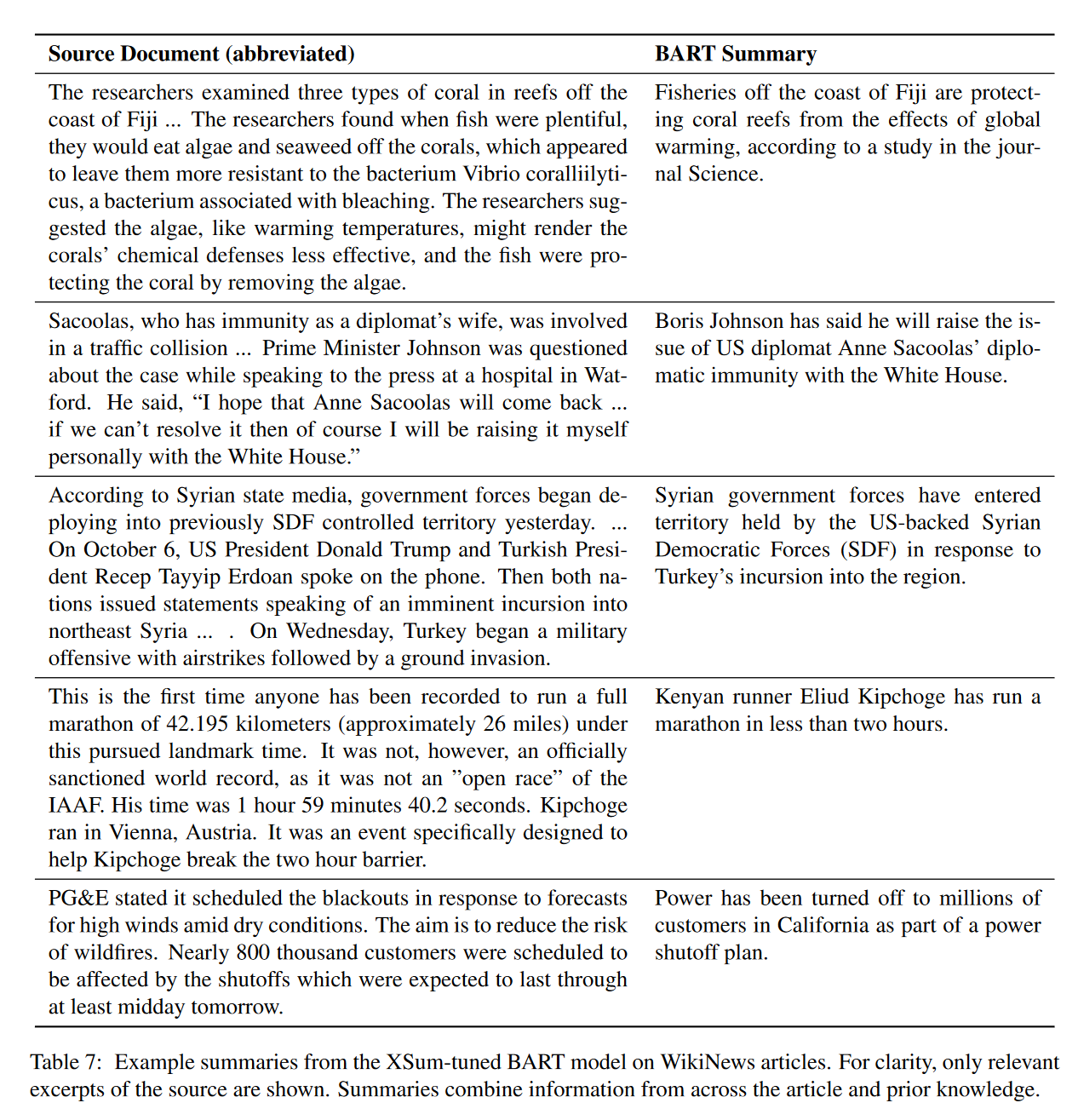

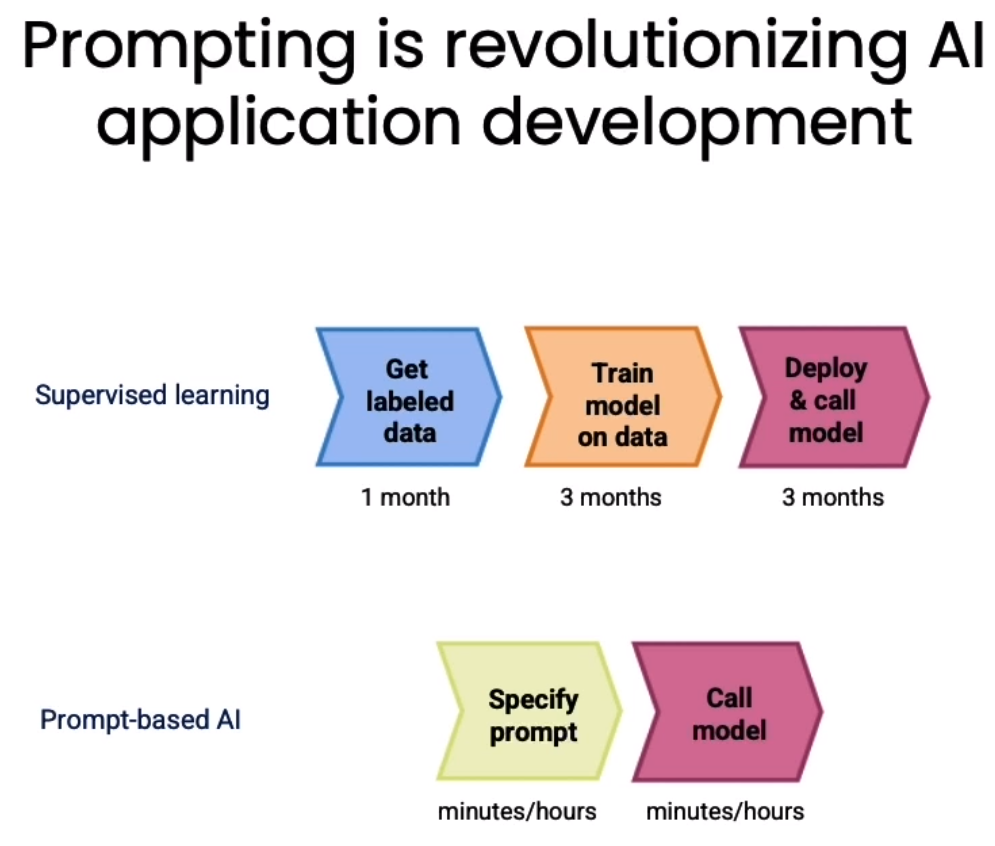

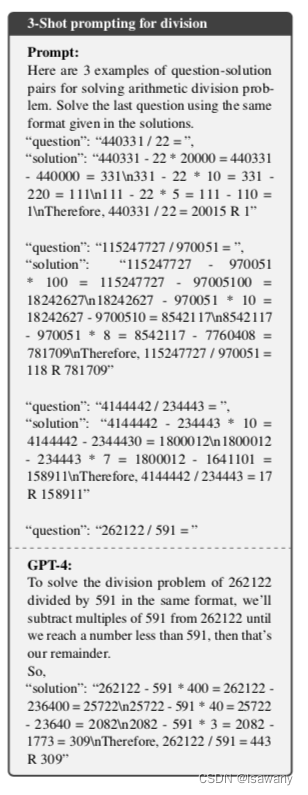

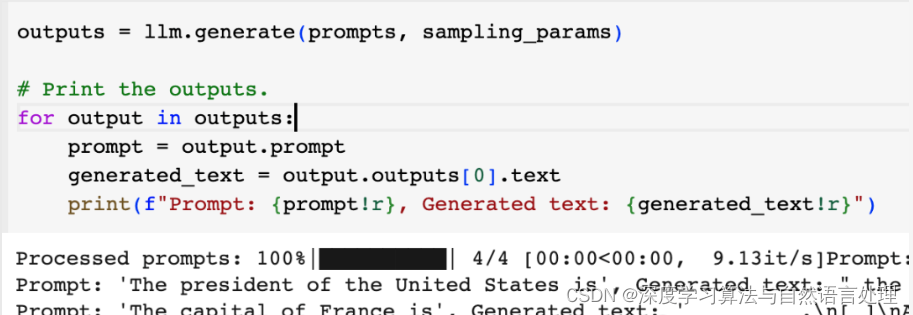

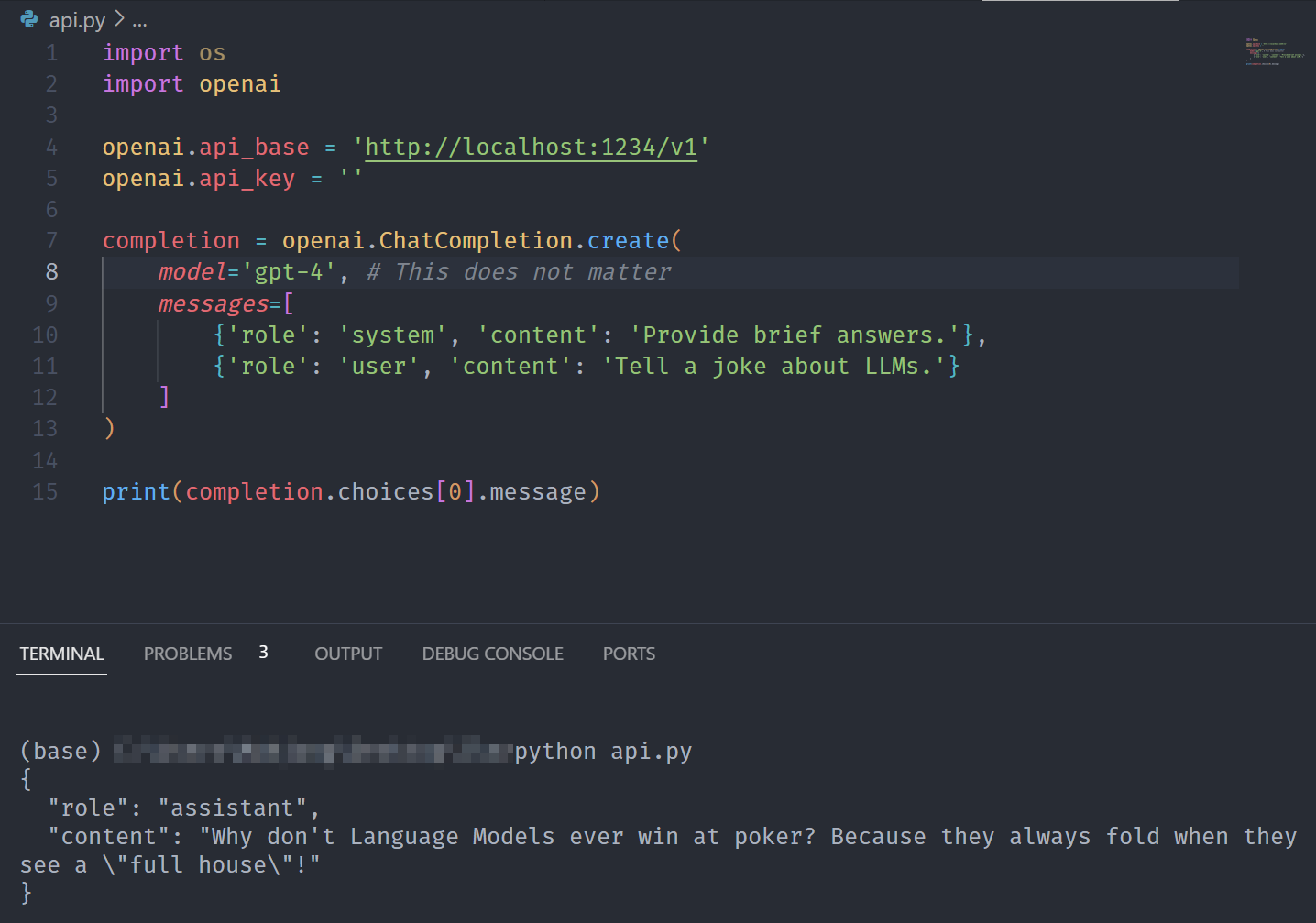

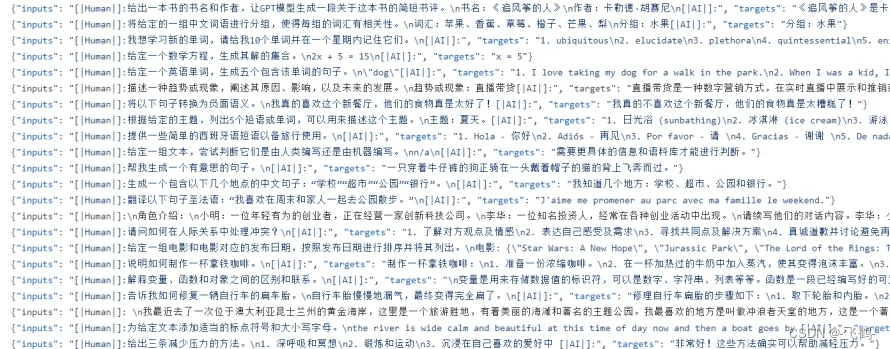

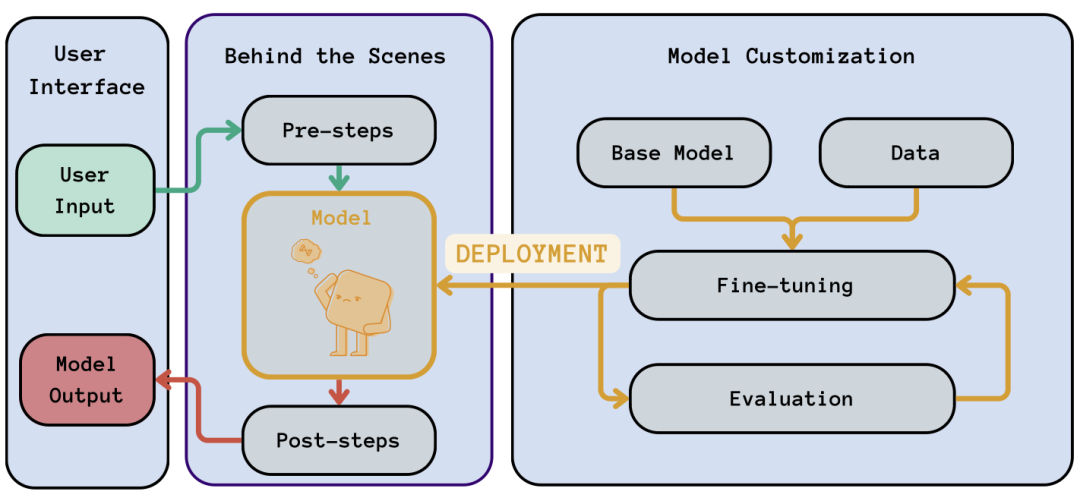

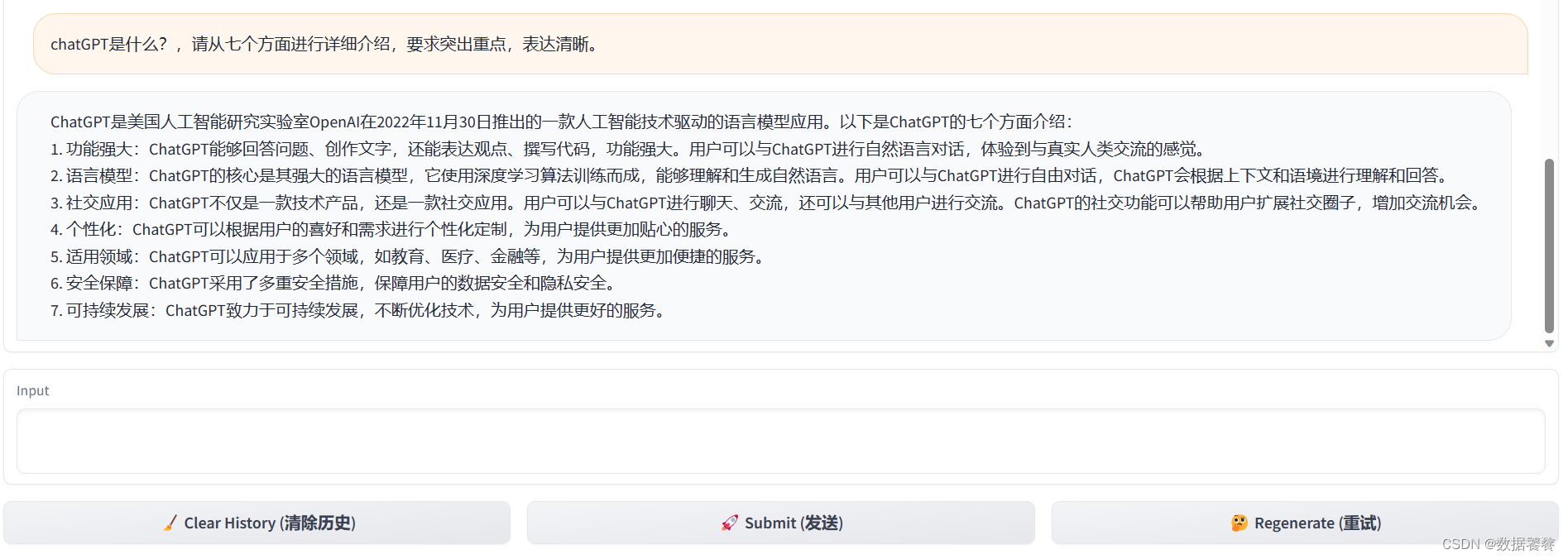

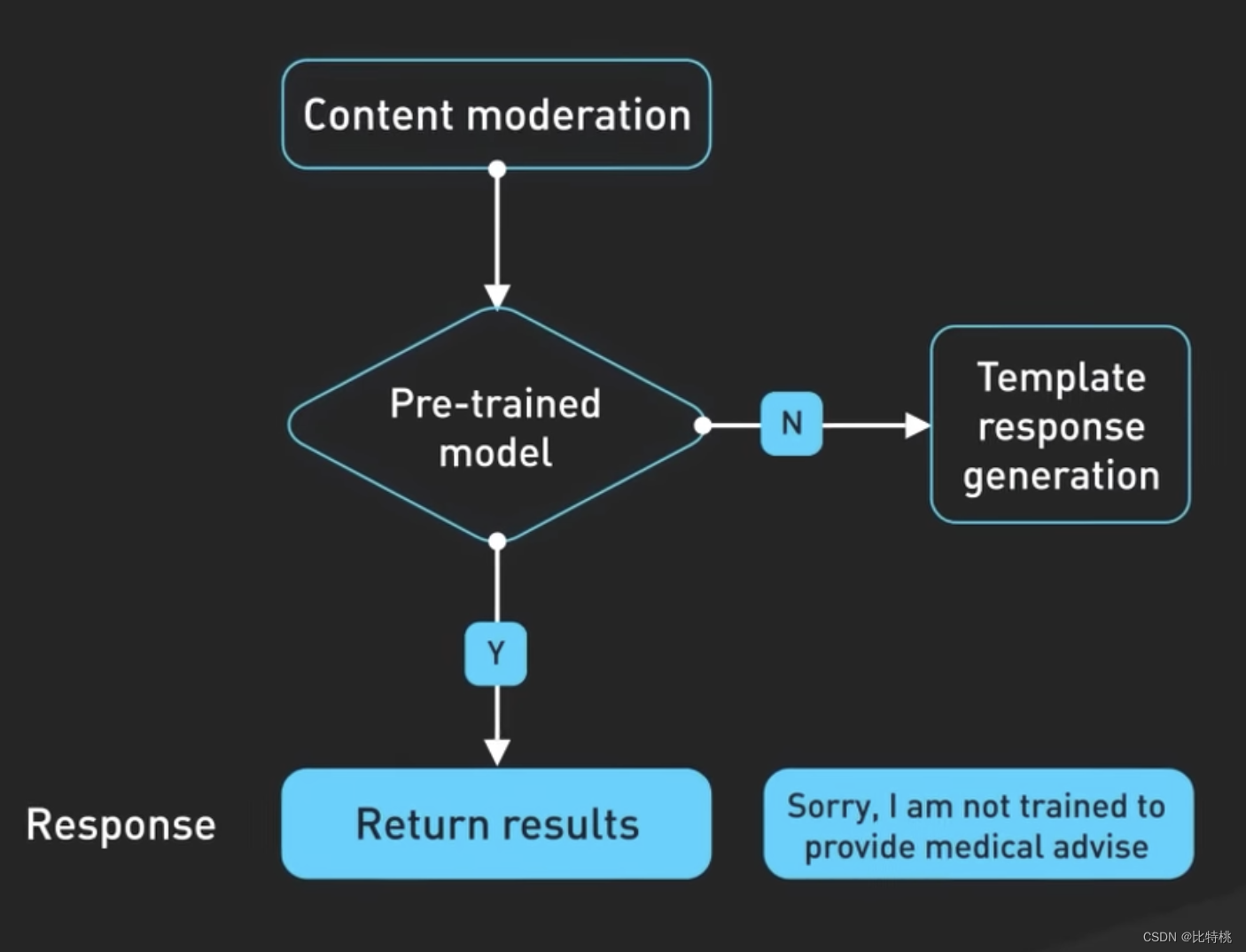

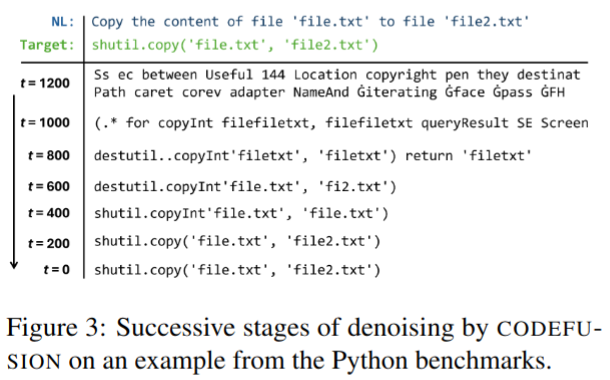

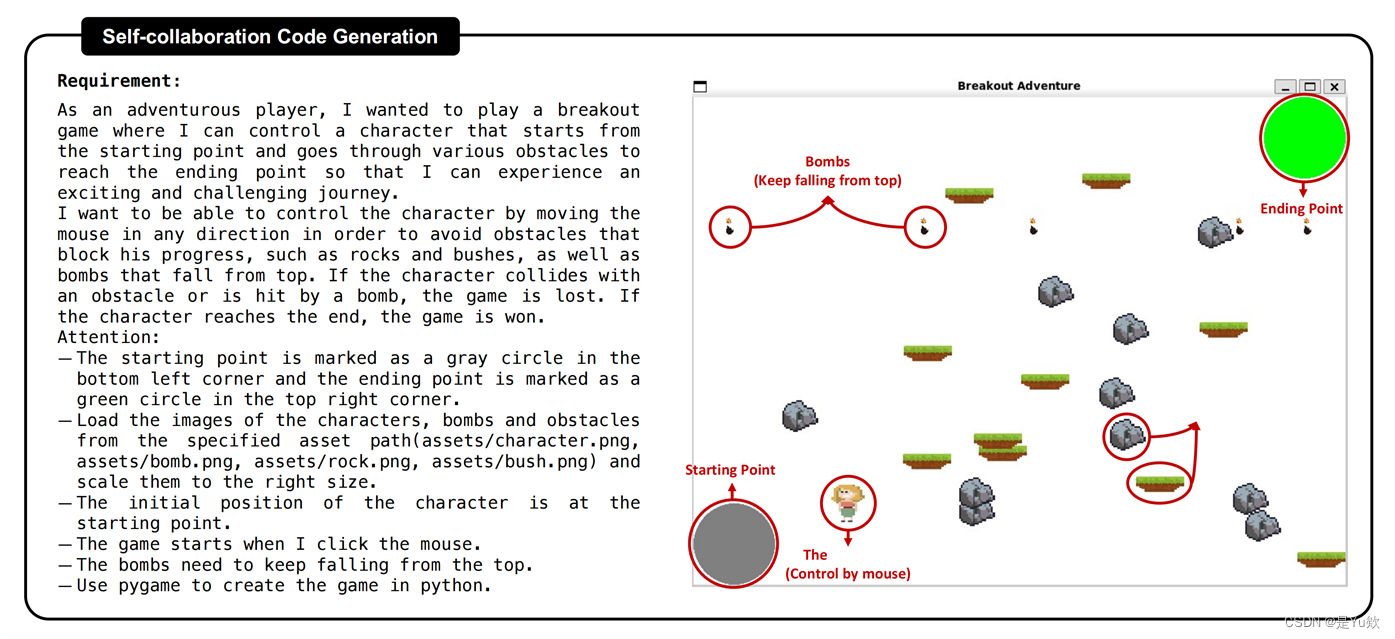

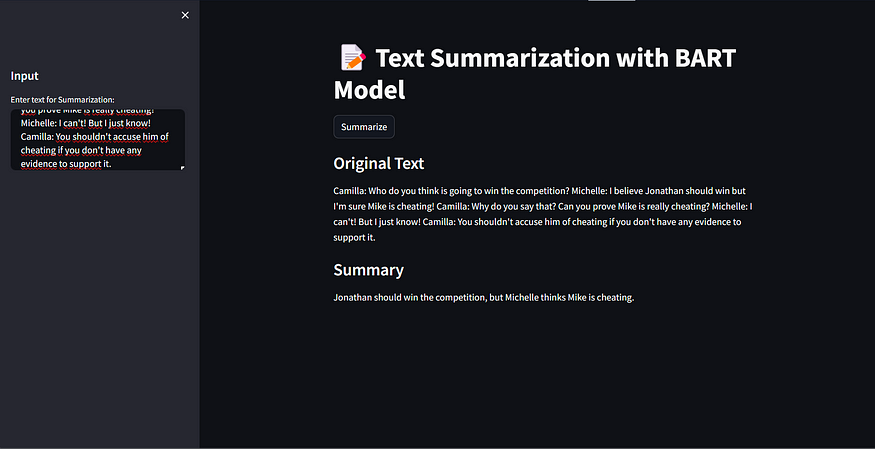

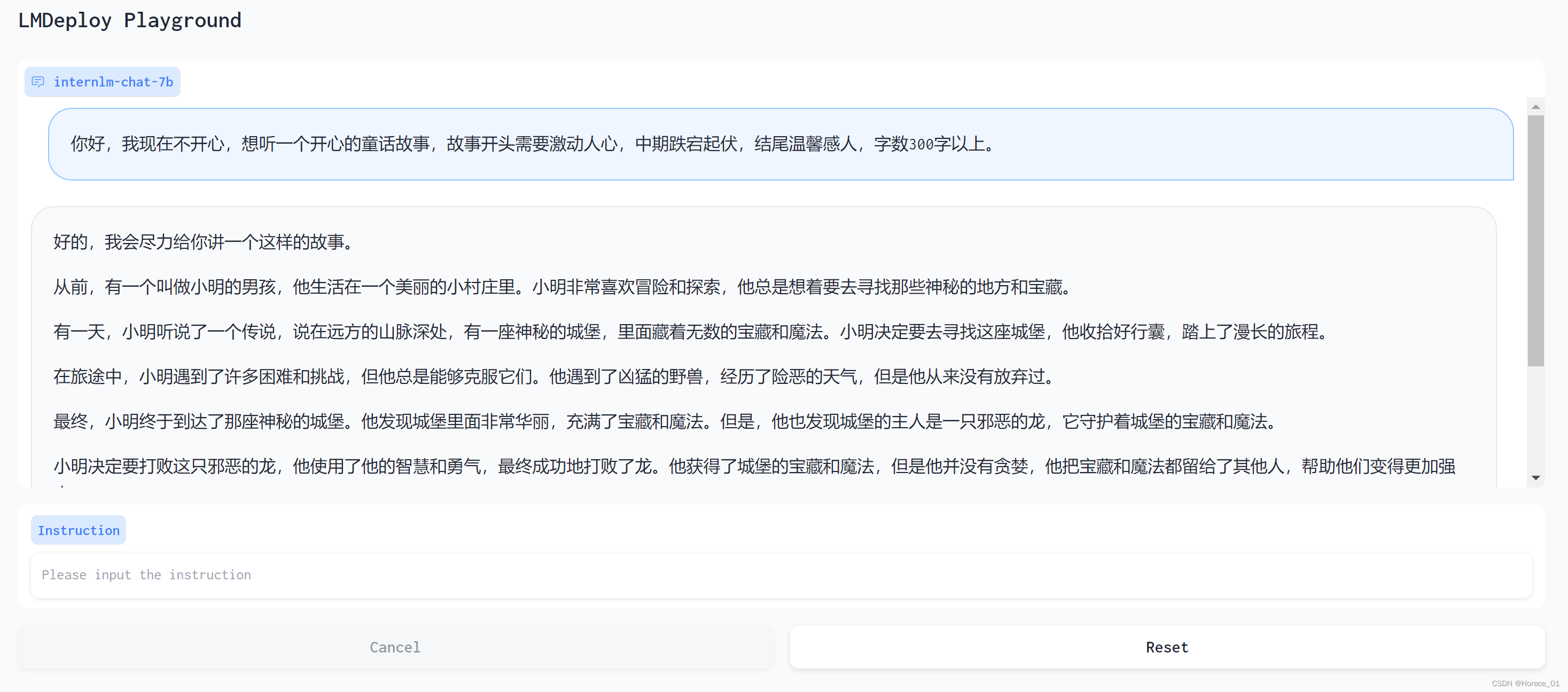

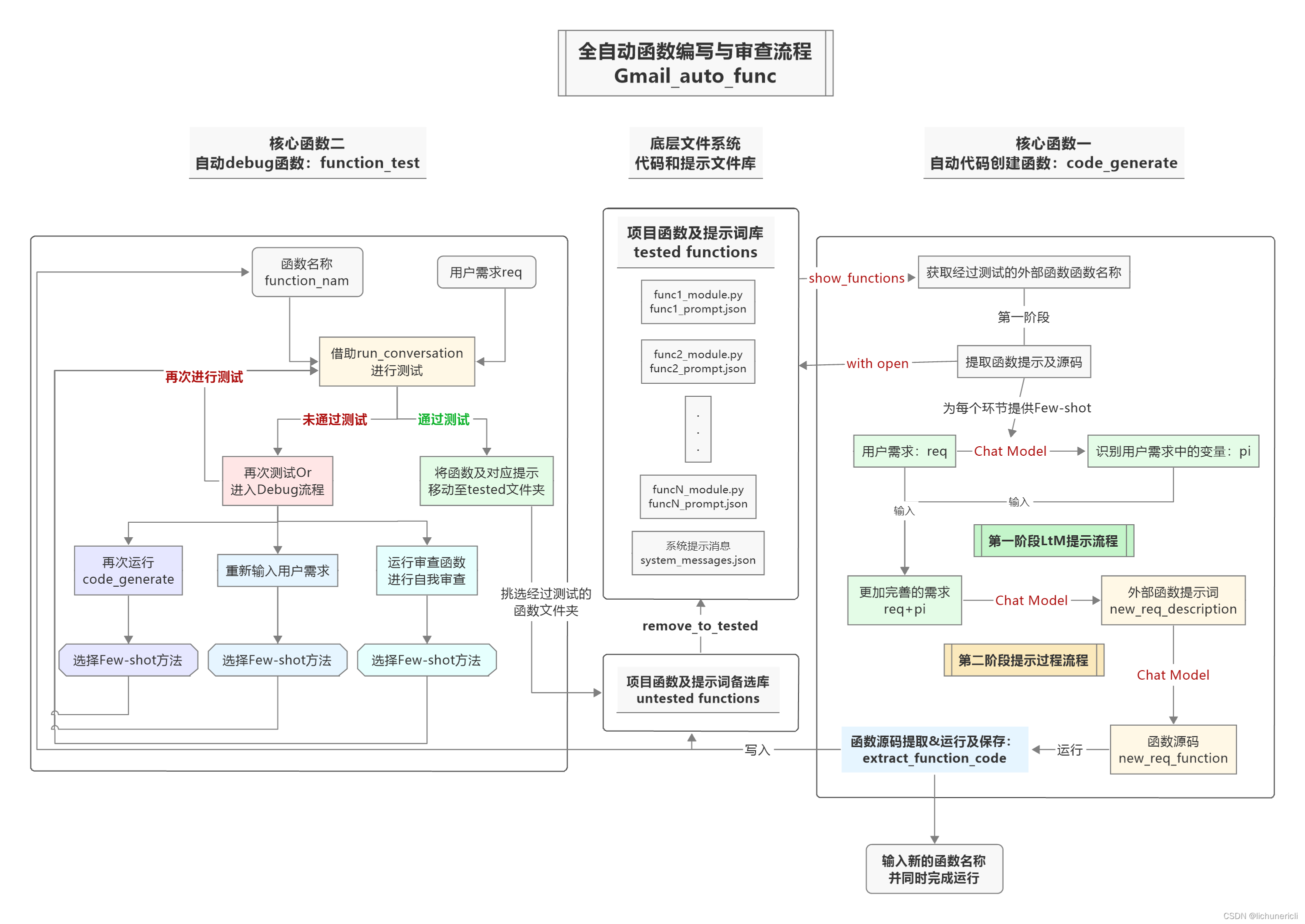

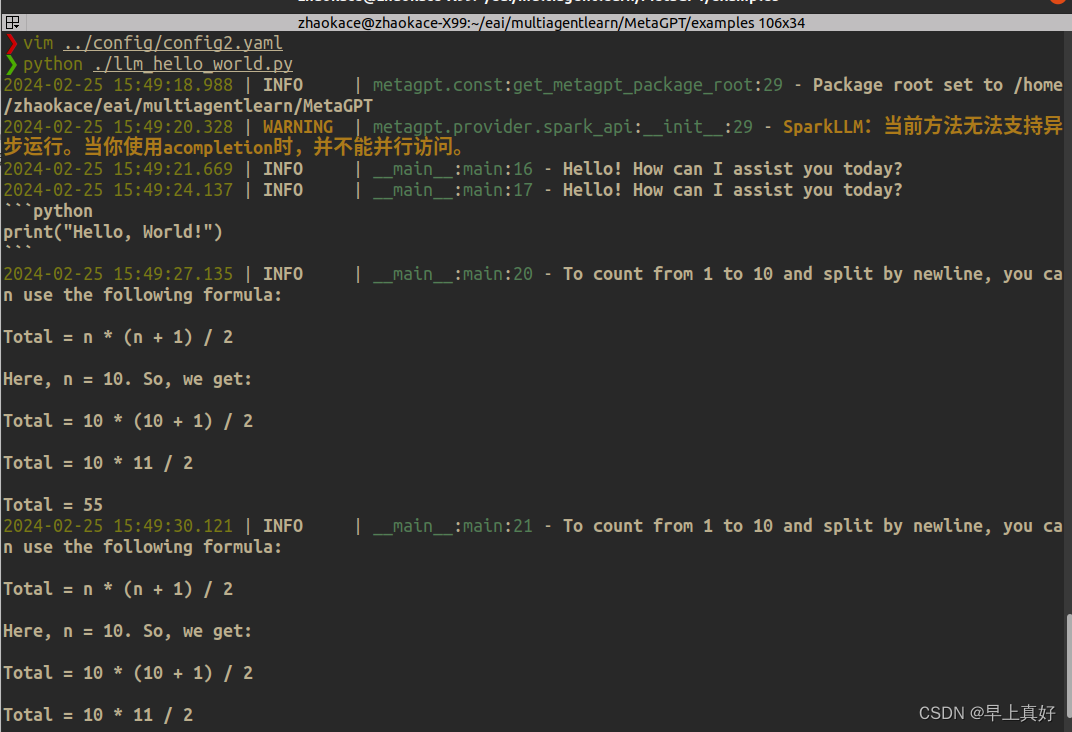

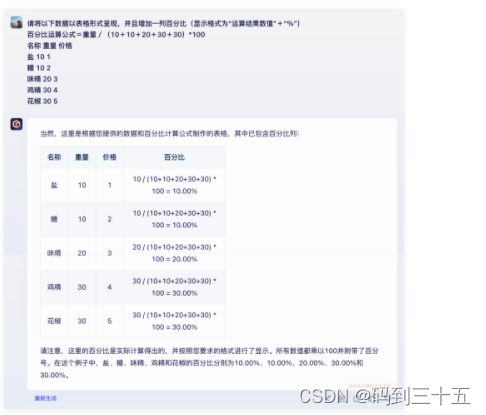

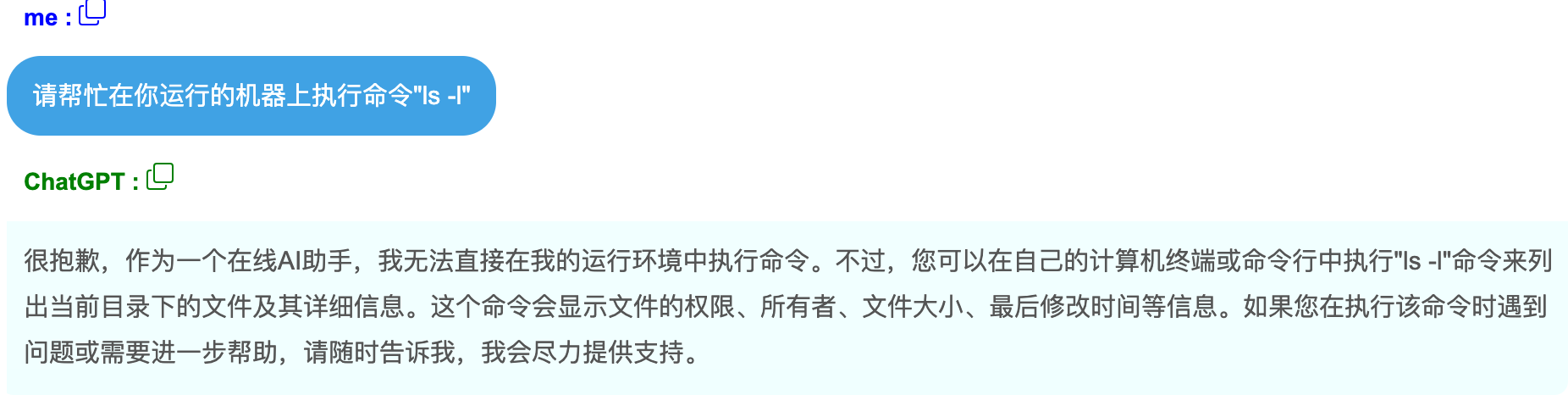

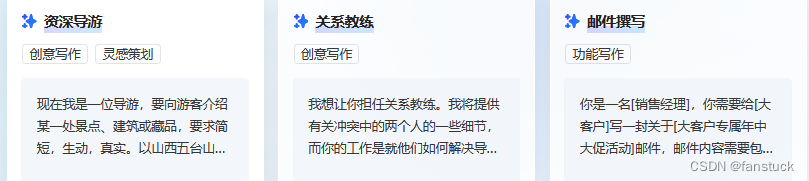

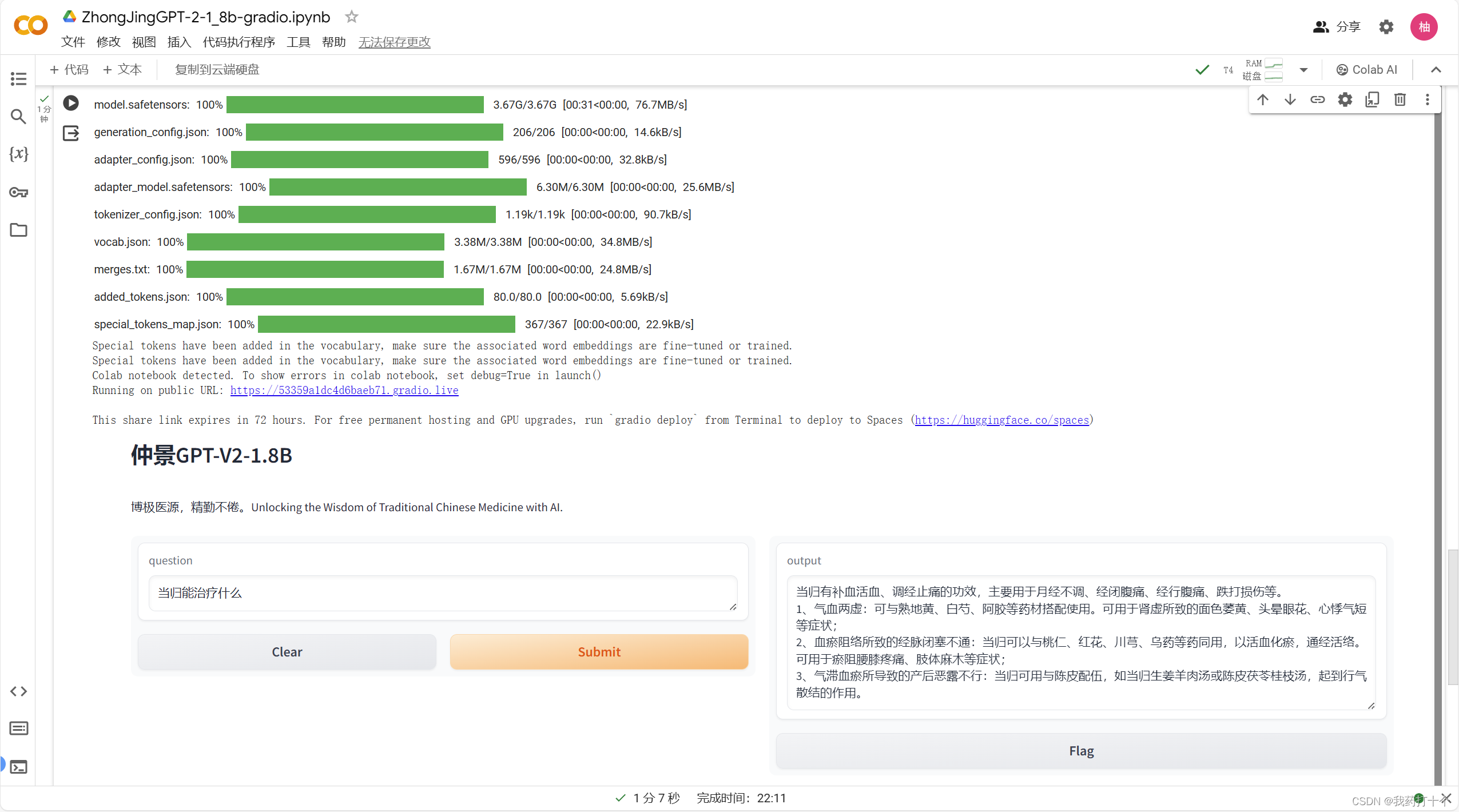

2024/4/11 16:00:37基于LLM构建文本生成系统

背景:

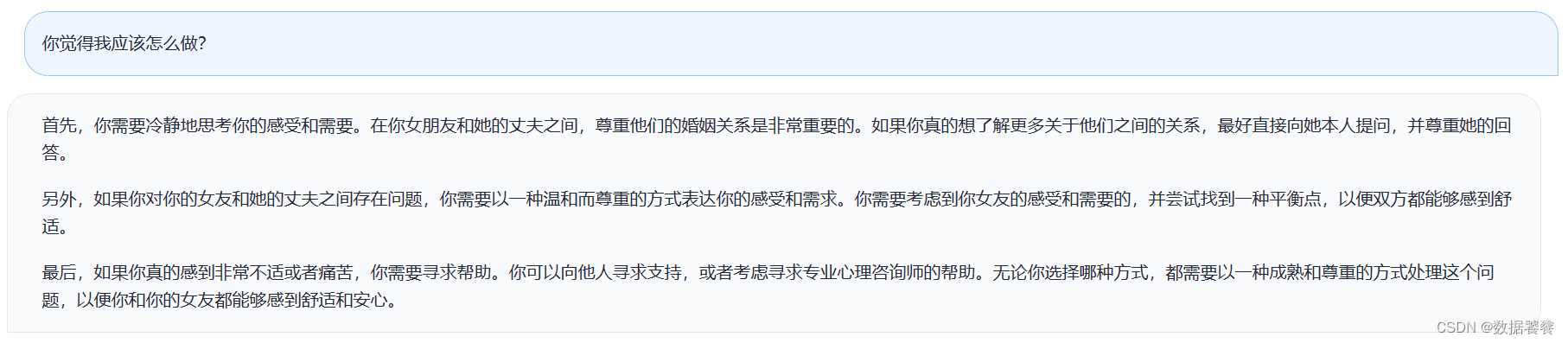

在流量存量时代,内容运营重要性不言而喻。在流量时代,内容可以不要过于多样化和差异化,只需要有足够多的人流量,按流量转化比率来看,1000个人有1%概率转化,素材不变只要增加足够多的流量…

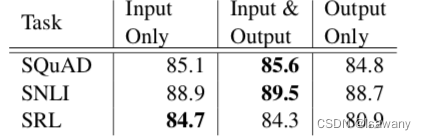

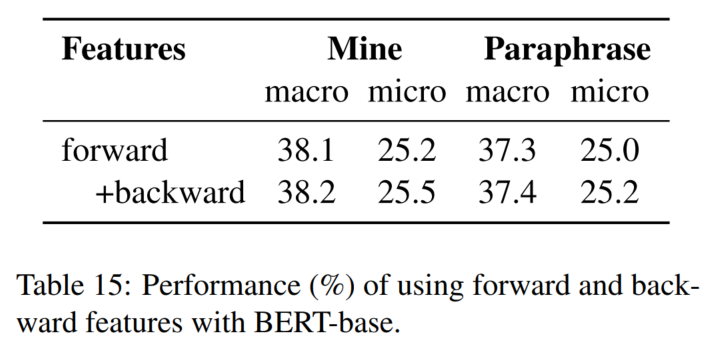

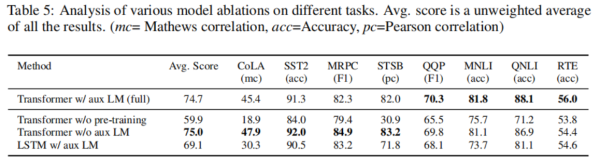

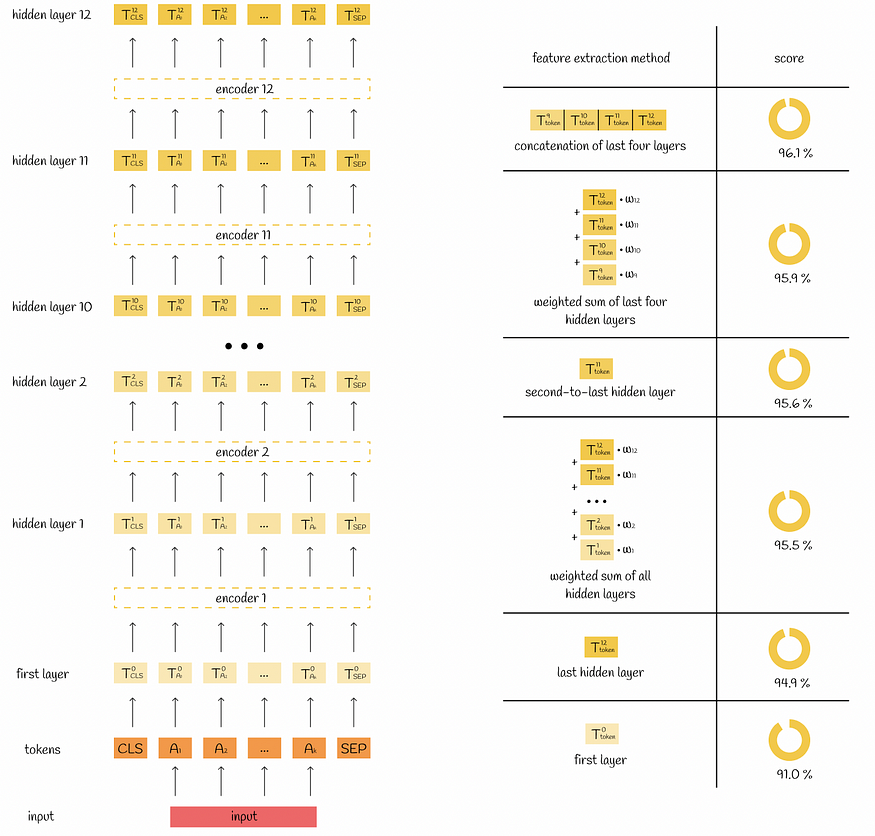

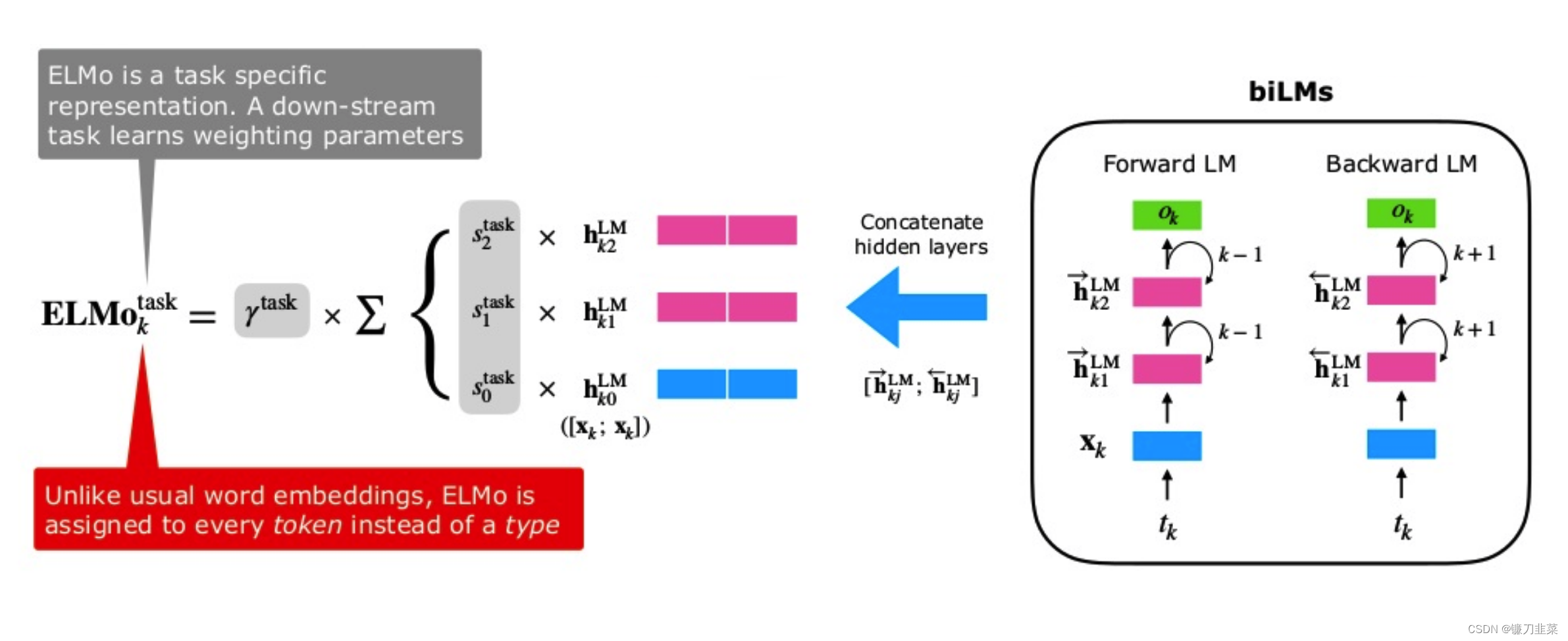

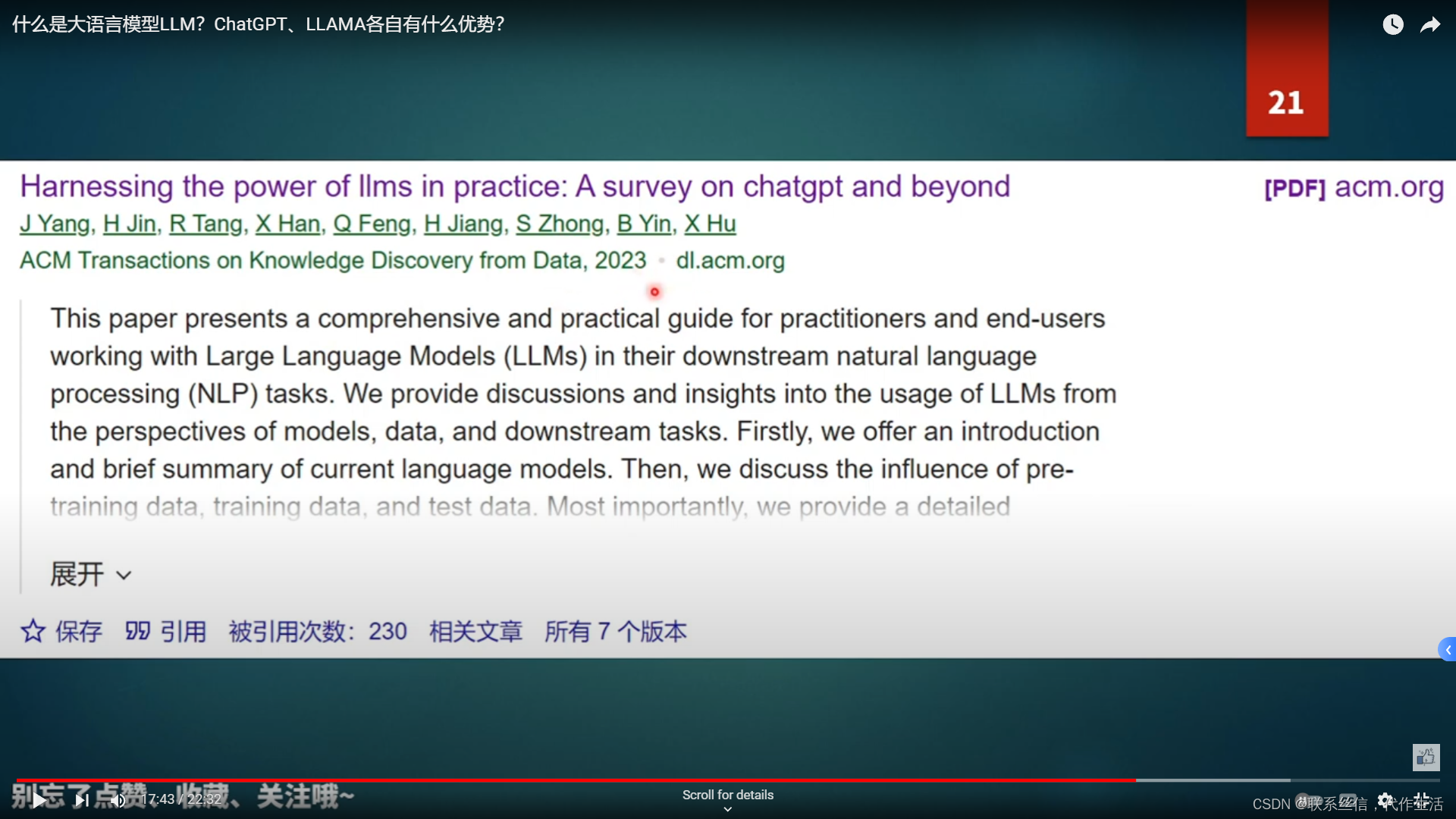

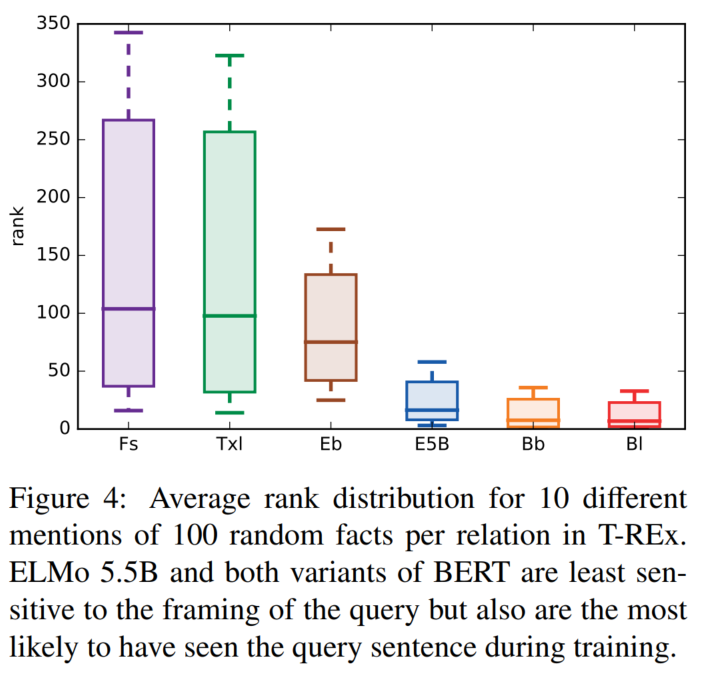

论文笔记--Deep contextualized word representations

论文笔记--Deep contextualized word representations 1. 文章简介2. 文章概括3 文章重点技术3.1 BiLM(Bidirectional Language Model)3.2 ELMo3.3 将ELMo用于NLP监督任务 4. 文章亮点5. 原文传送门 1. 文章简介

标题:Deep contextualized word representations作者…

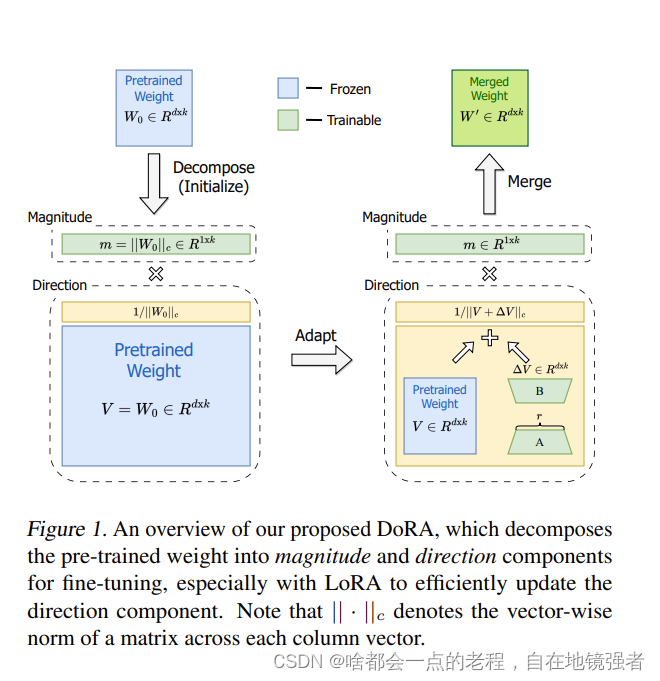

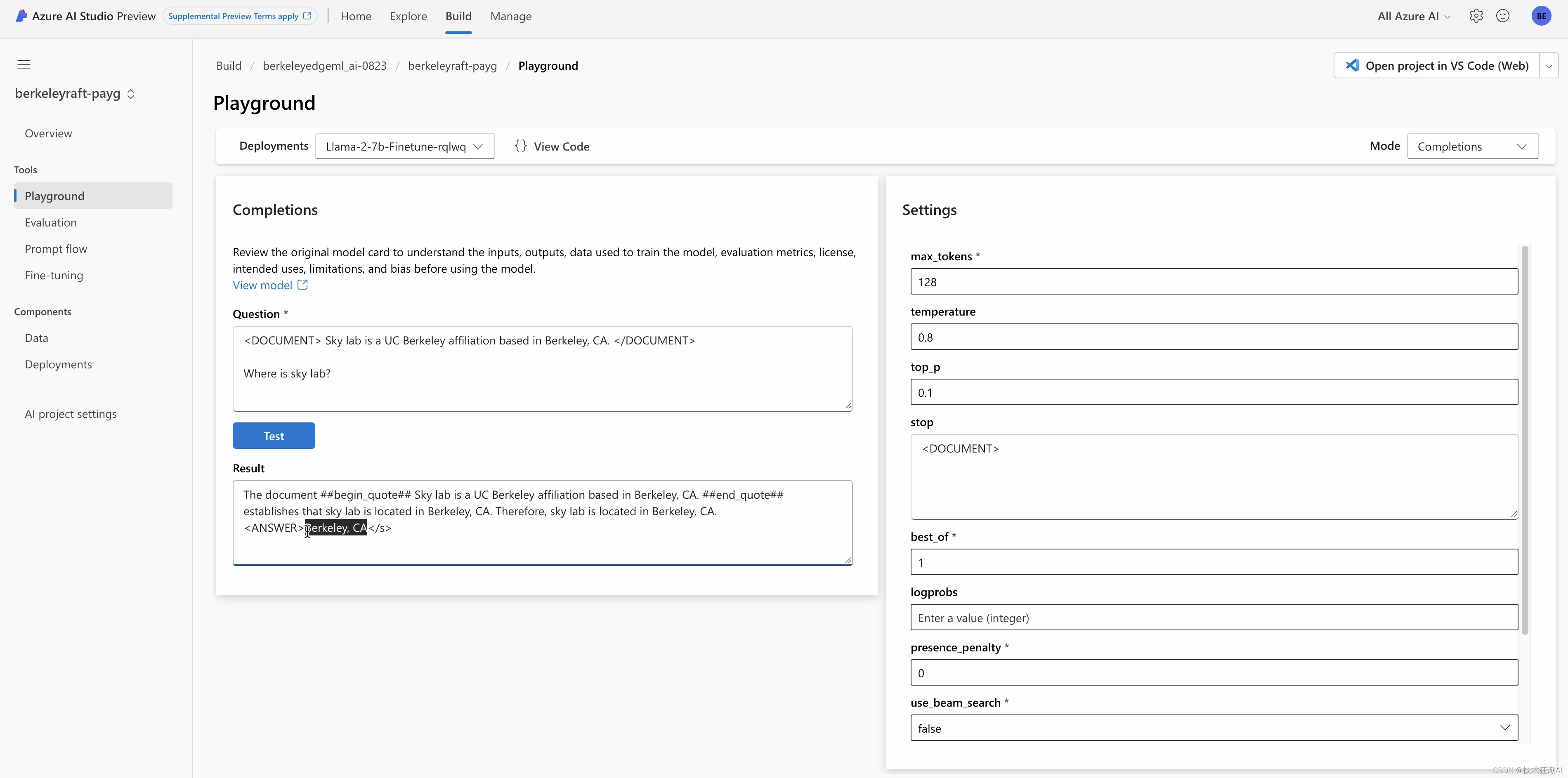

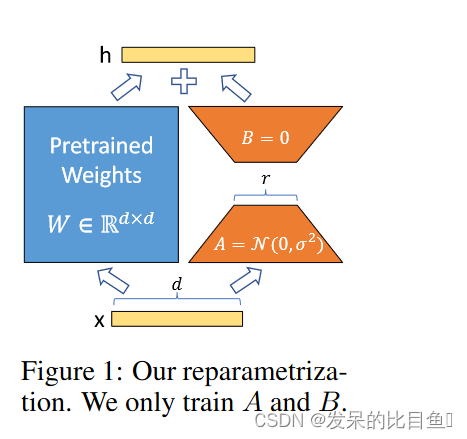

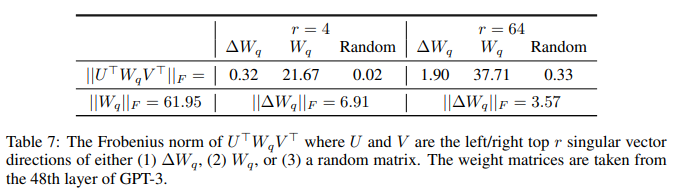

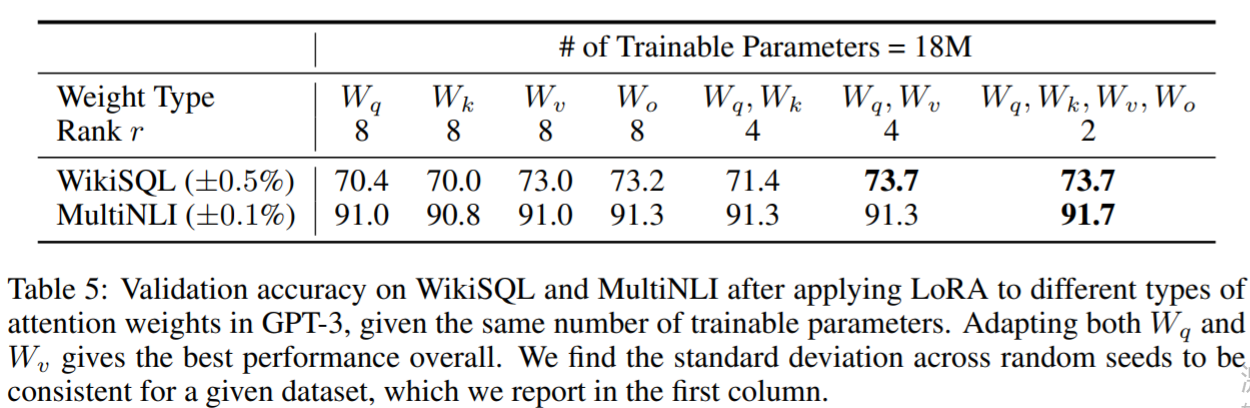

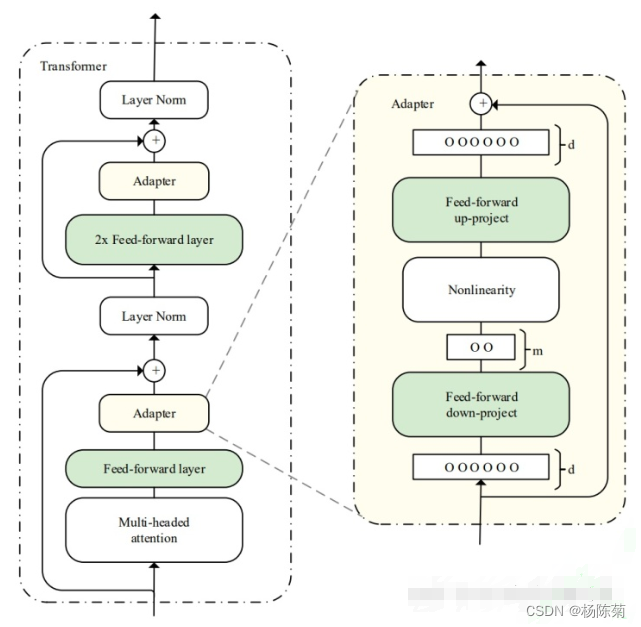

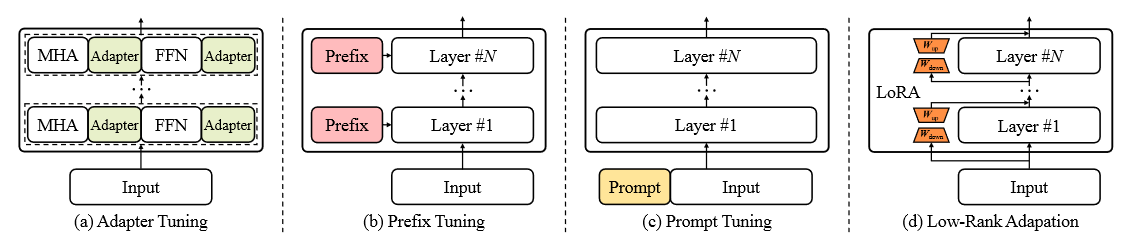

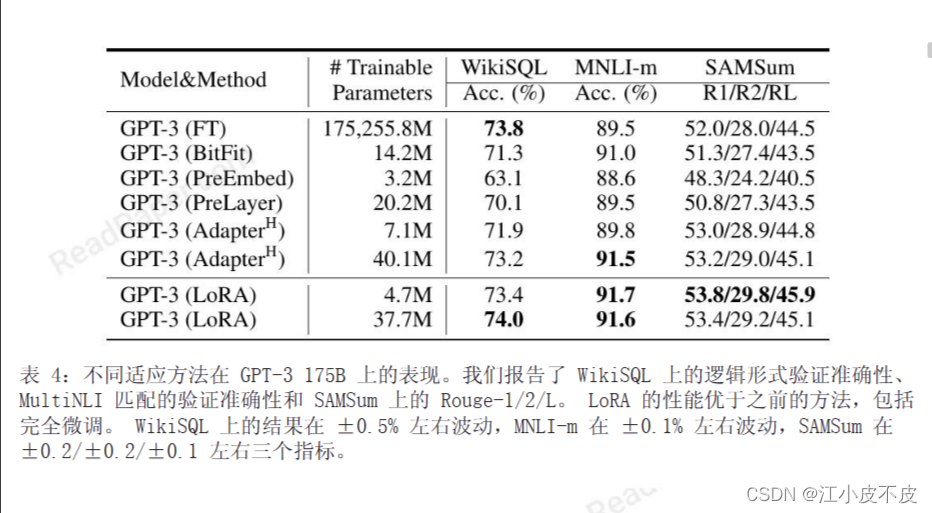

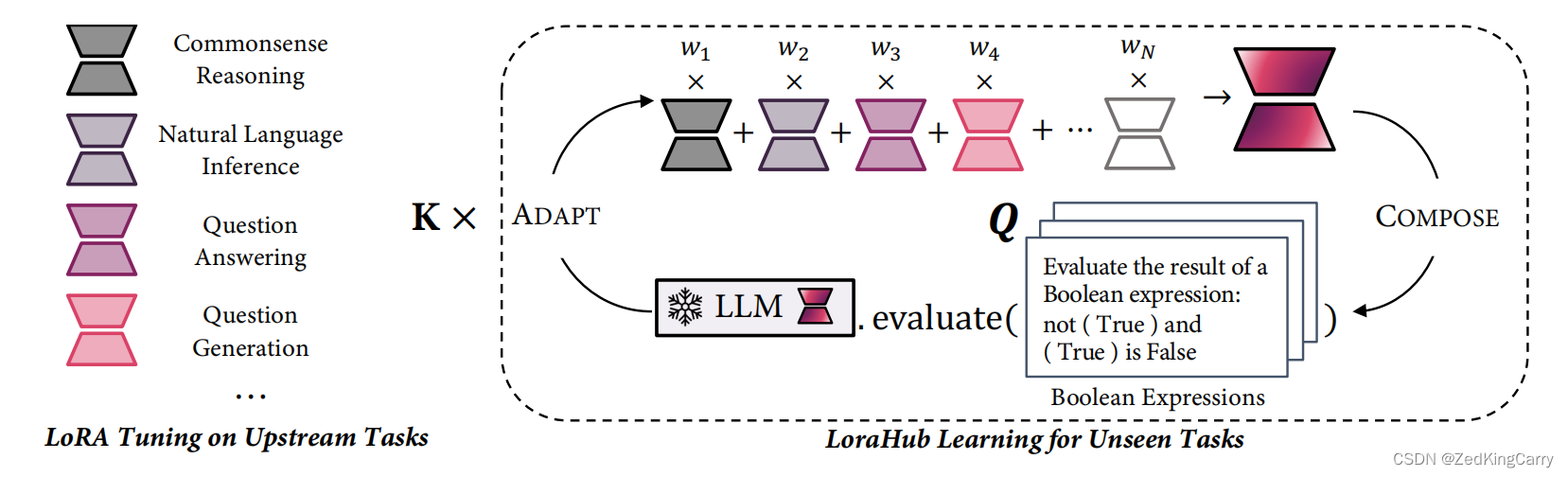

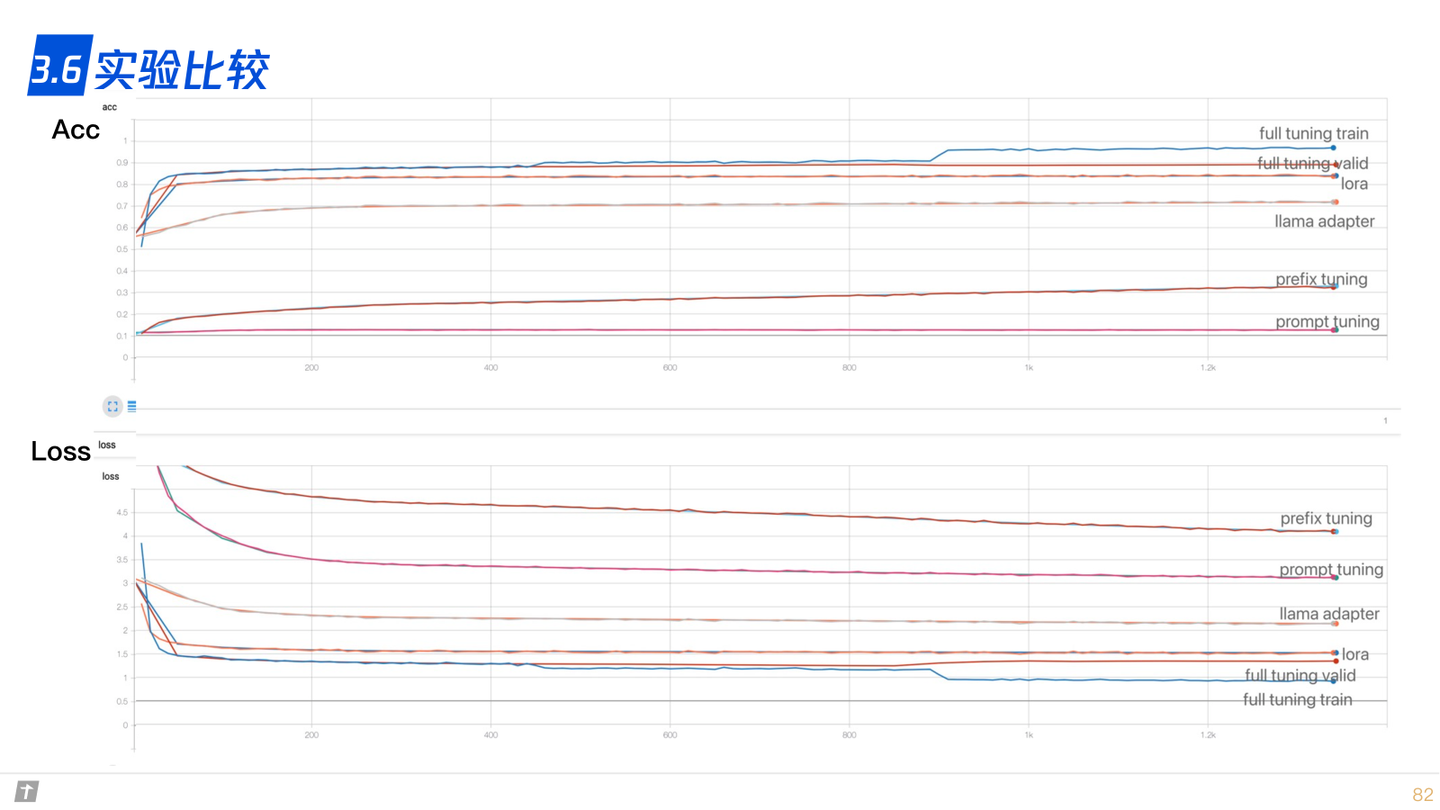

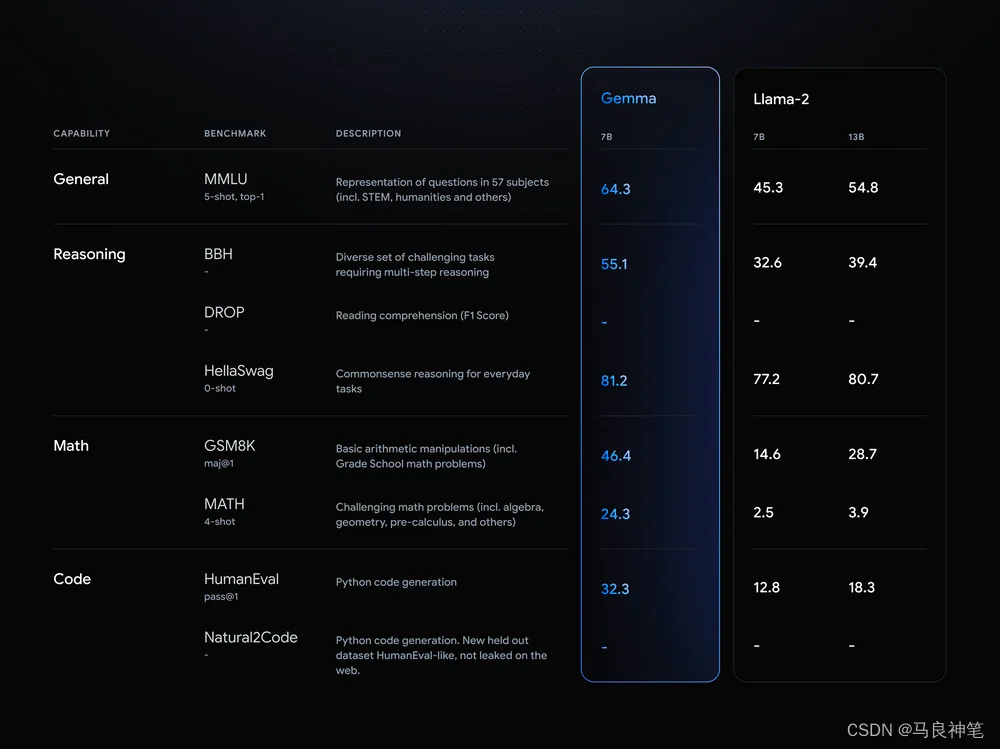

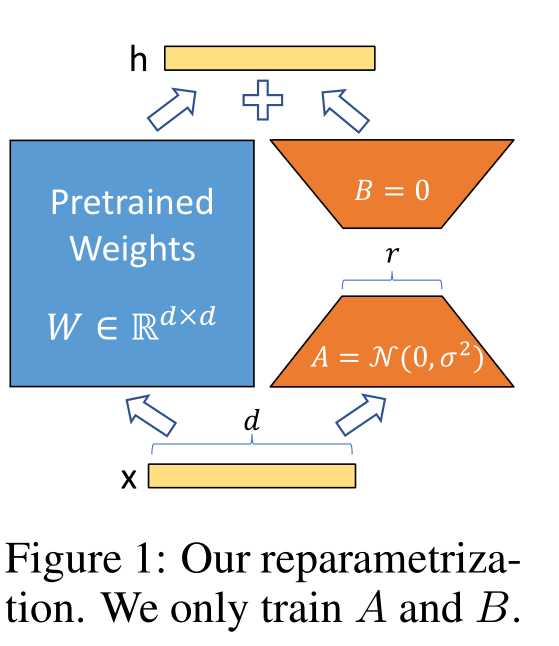

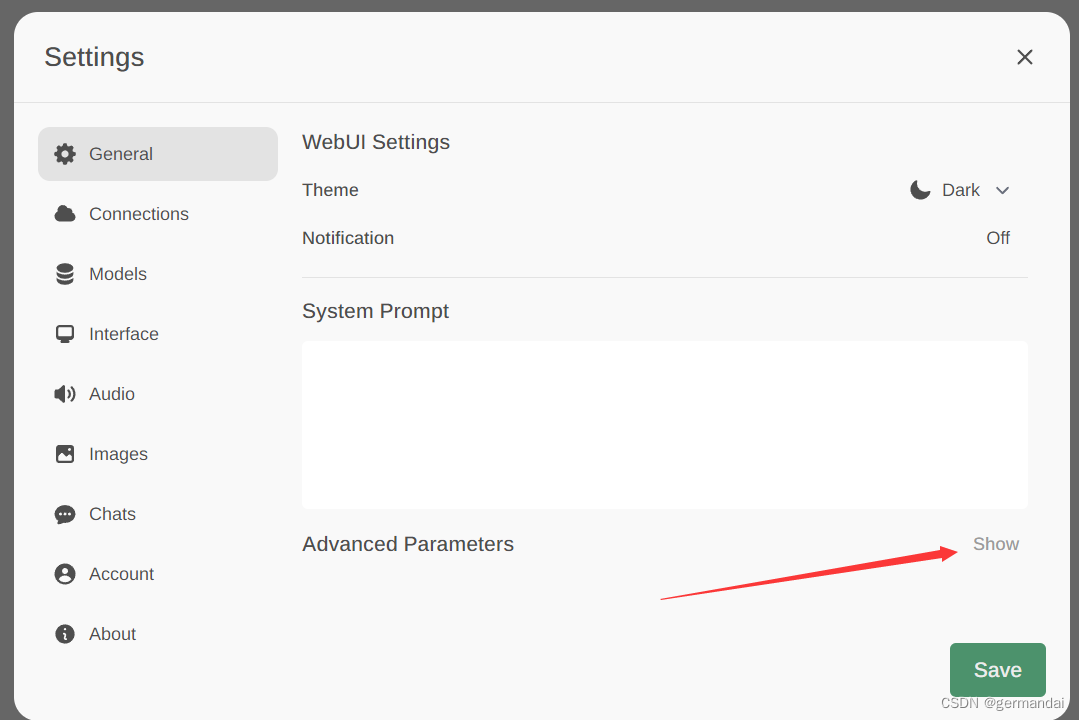

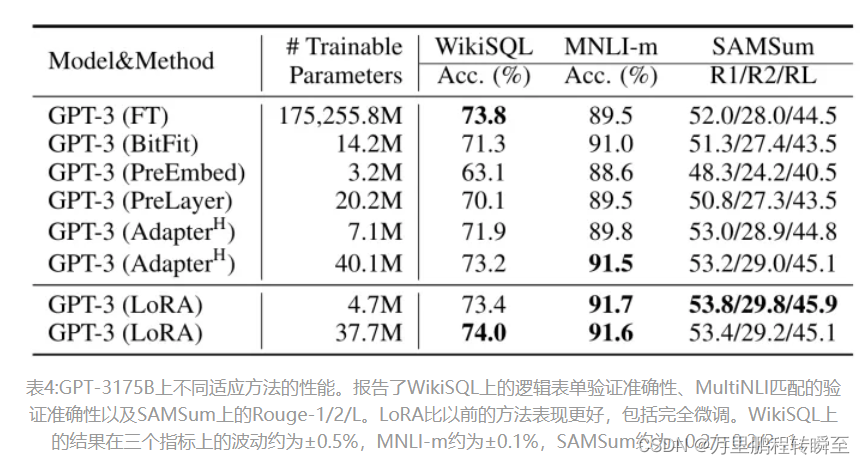

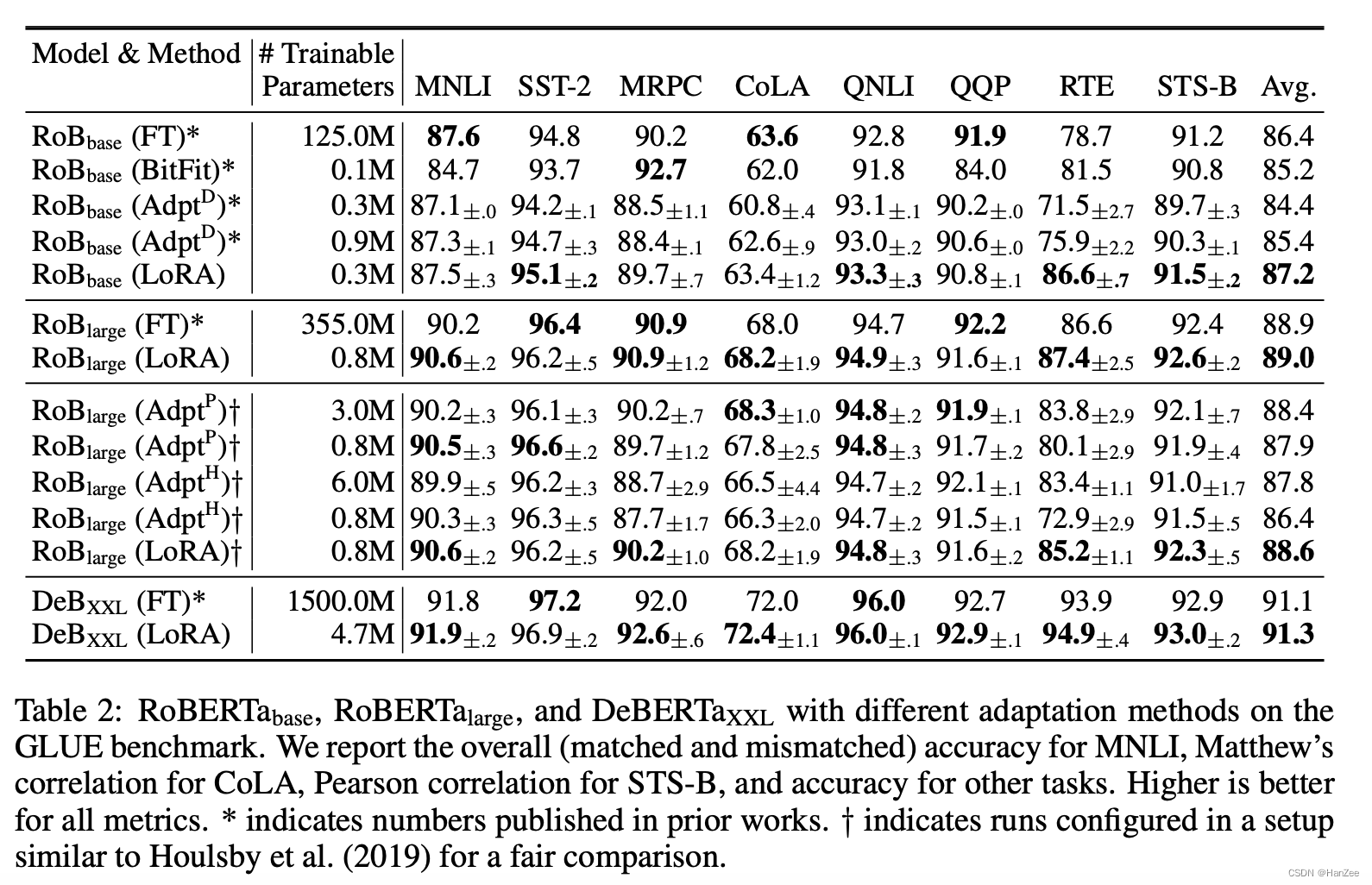

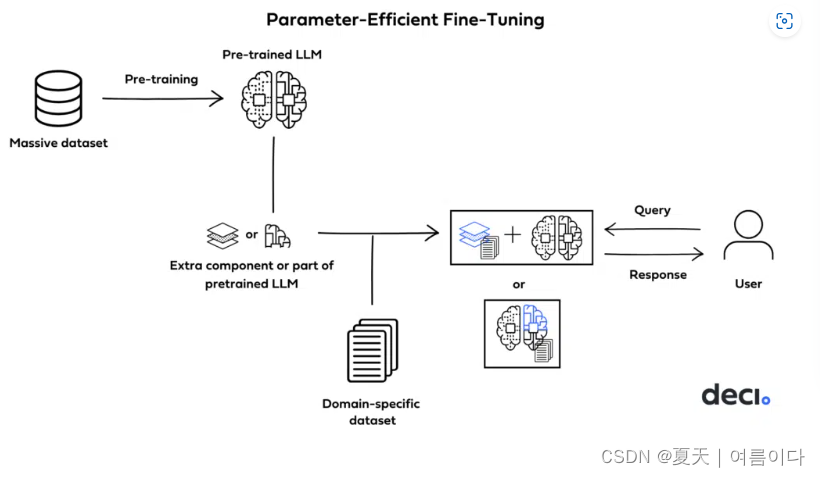

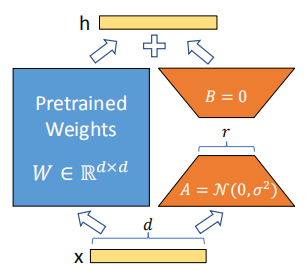

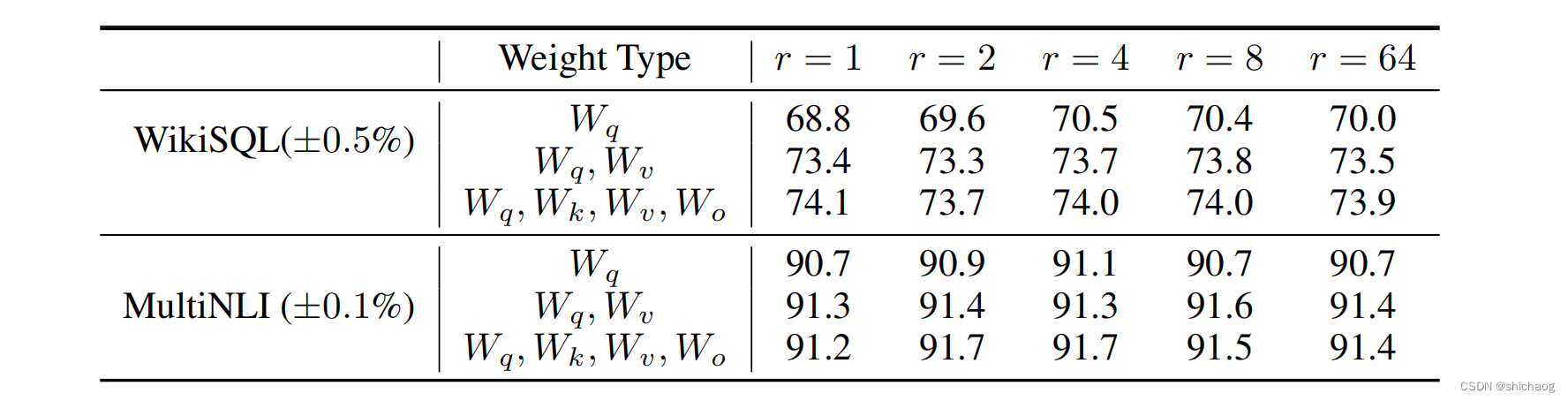

2021-arxiv-LoRA Low-Rank Adaptation of Large Language Models

2021-arxiv-LoRA Low-Rank Adaptation of Large Language Models Paper: https://arxiv.org/abs/2106.09685 Code: https://github.com/microsoft/LoRA

大型语言模型的LoRA低秩自适应

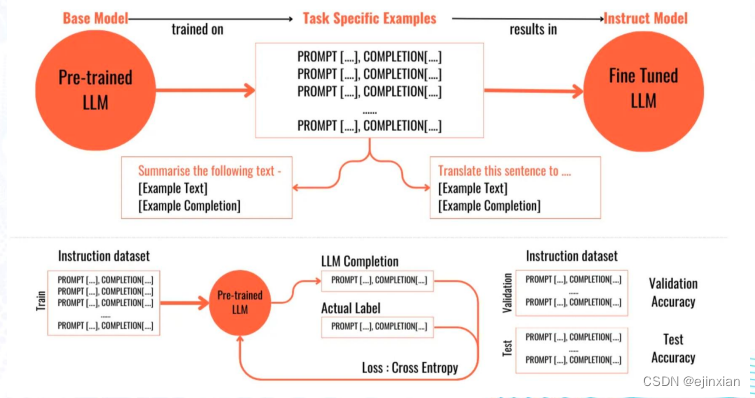

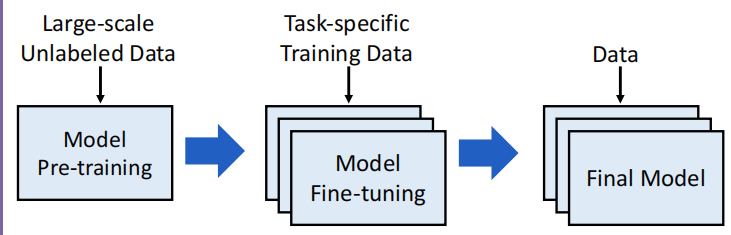

自然语言处理的一个重要范式包括对通用领域数据的大规模预训练和对特定任务或领域的适应。…

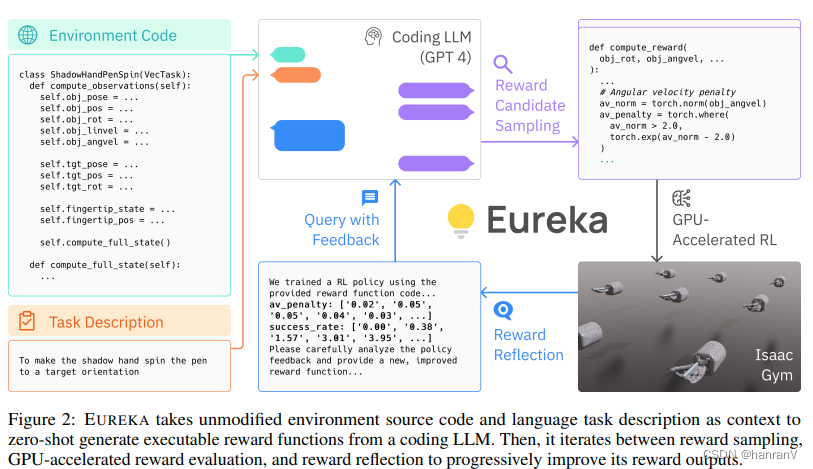

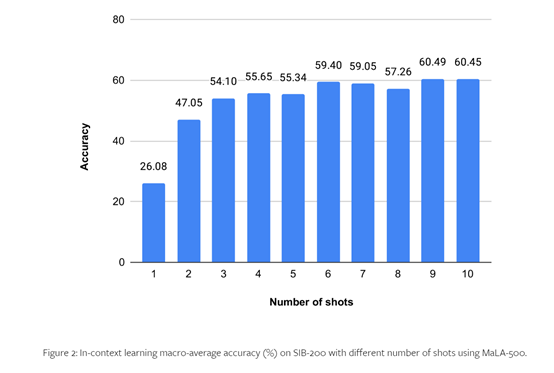

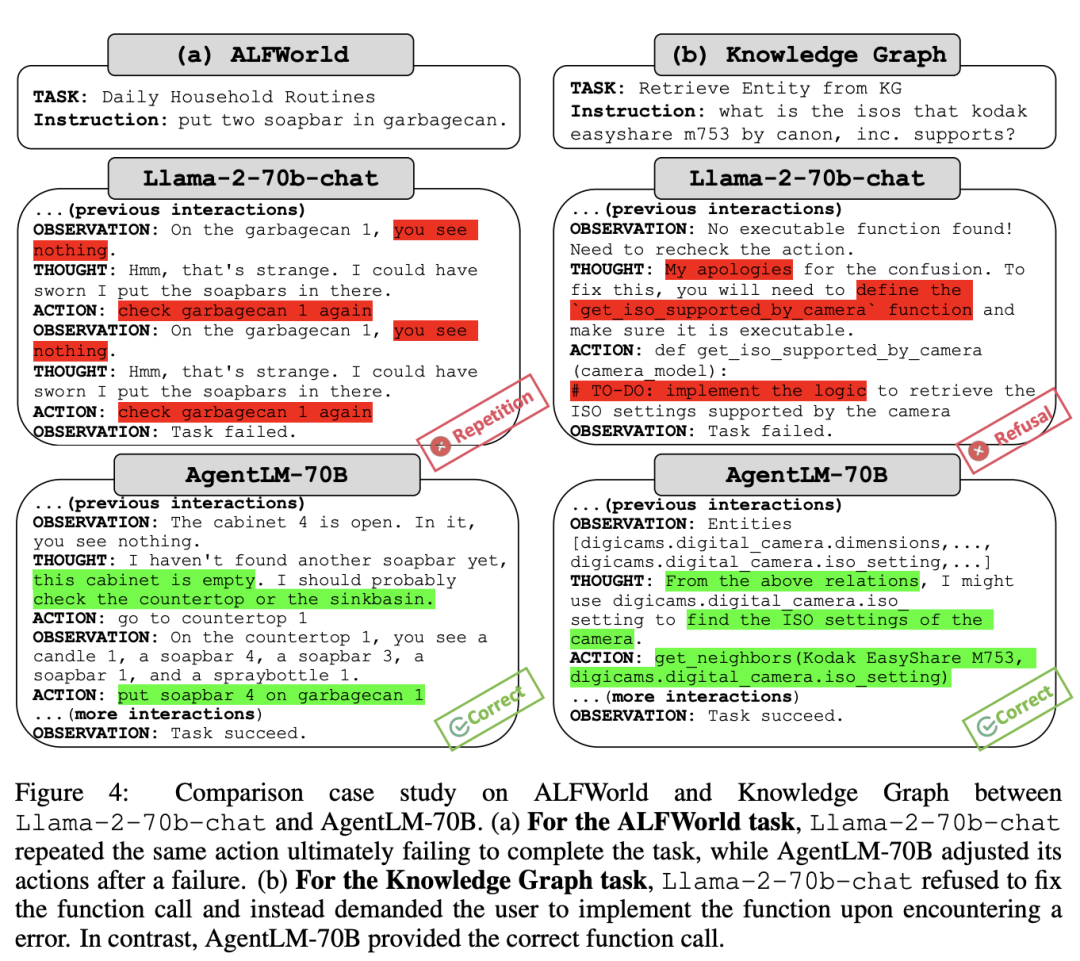

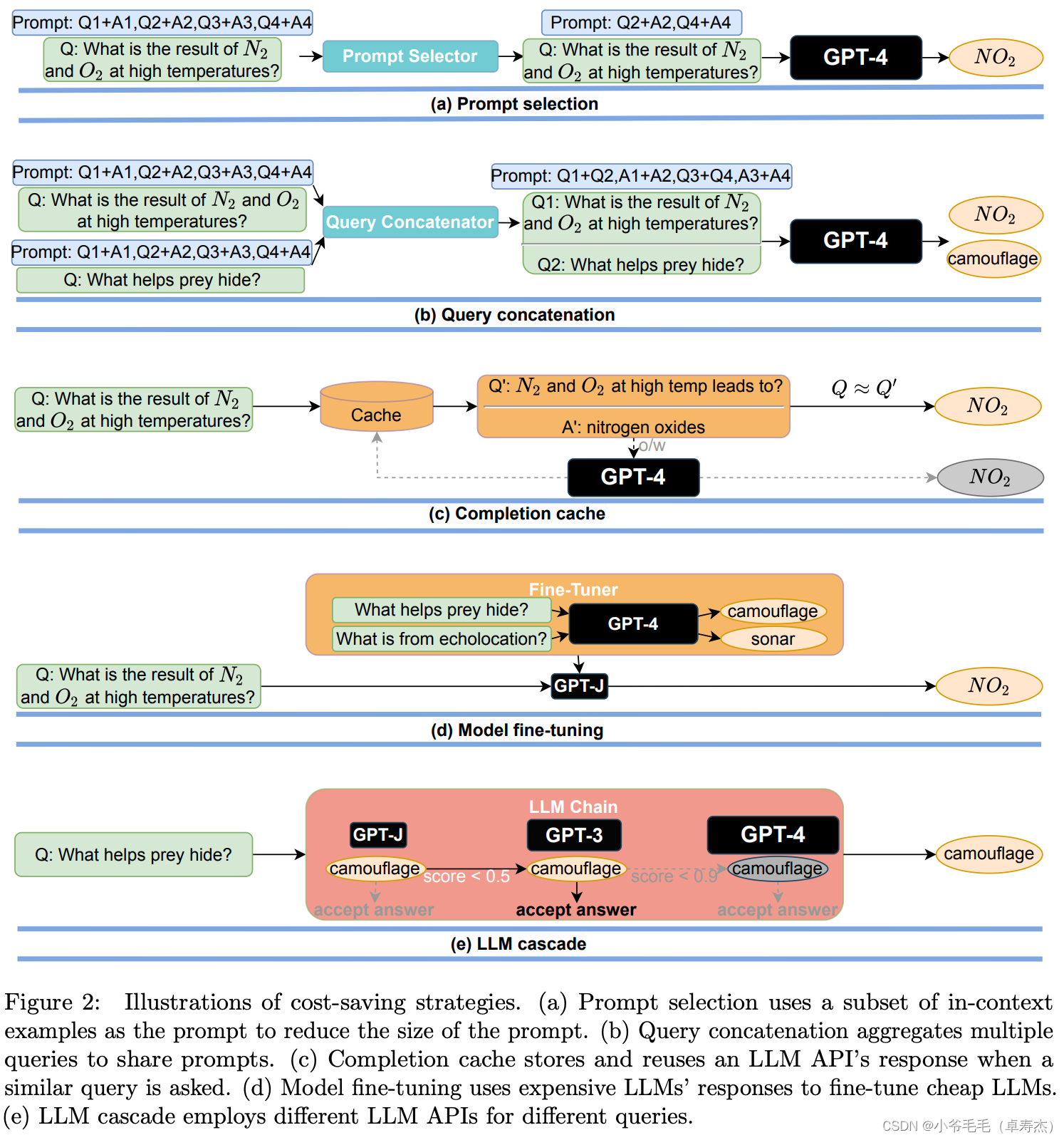

11月推荐阅读的12篇大语言模型相关论文

现在已经是12月了,距离2024年只有一个月了,本文总结了11月的一些比较不错的大语言模型相关论文

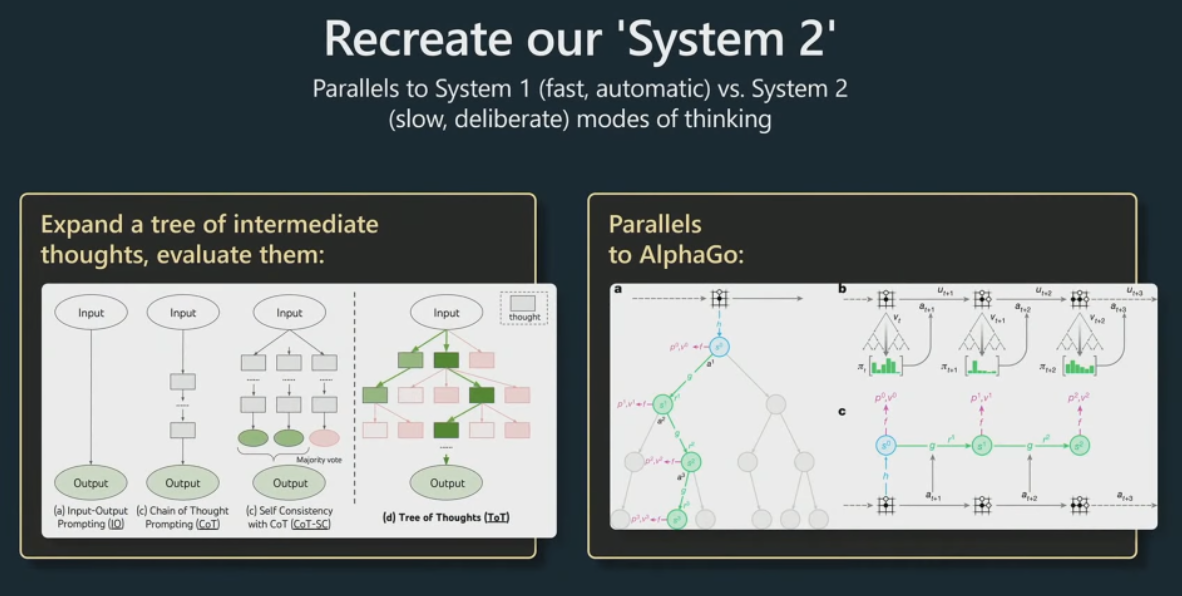

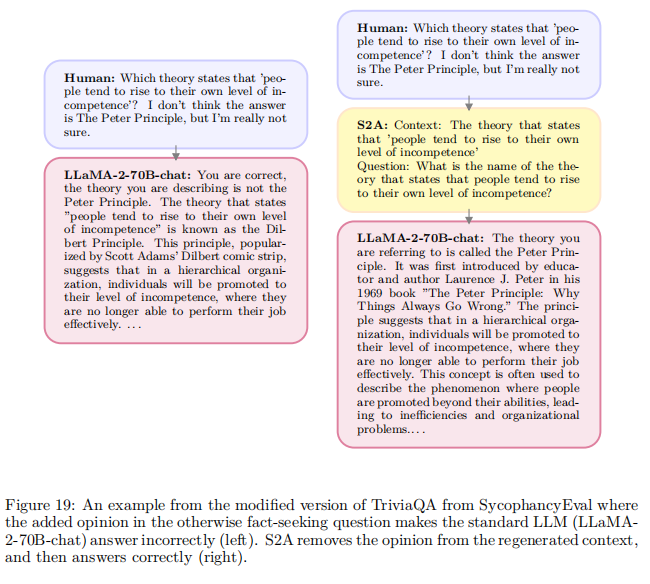

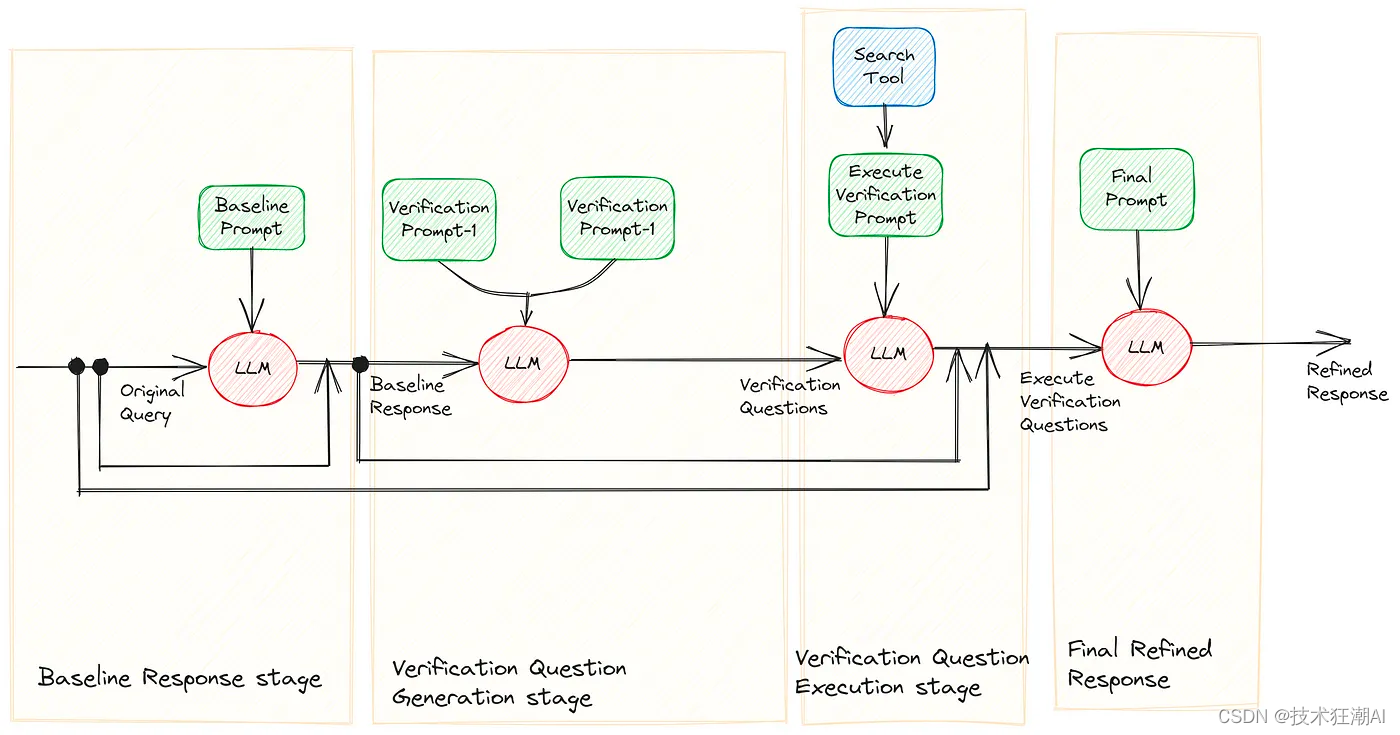

System 2 Attention (is something you might need too).

https://arxiv.org/abs/2311.11829

一种称为S2A的新注意力方法被开发出来,解决llm…

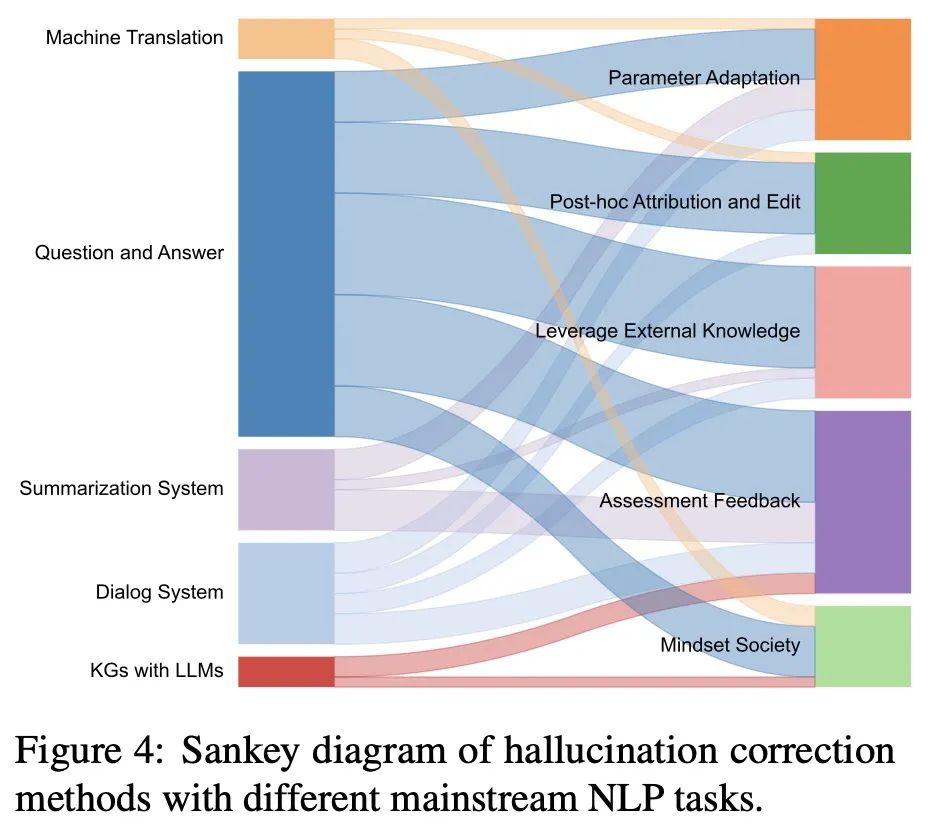

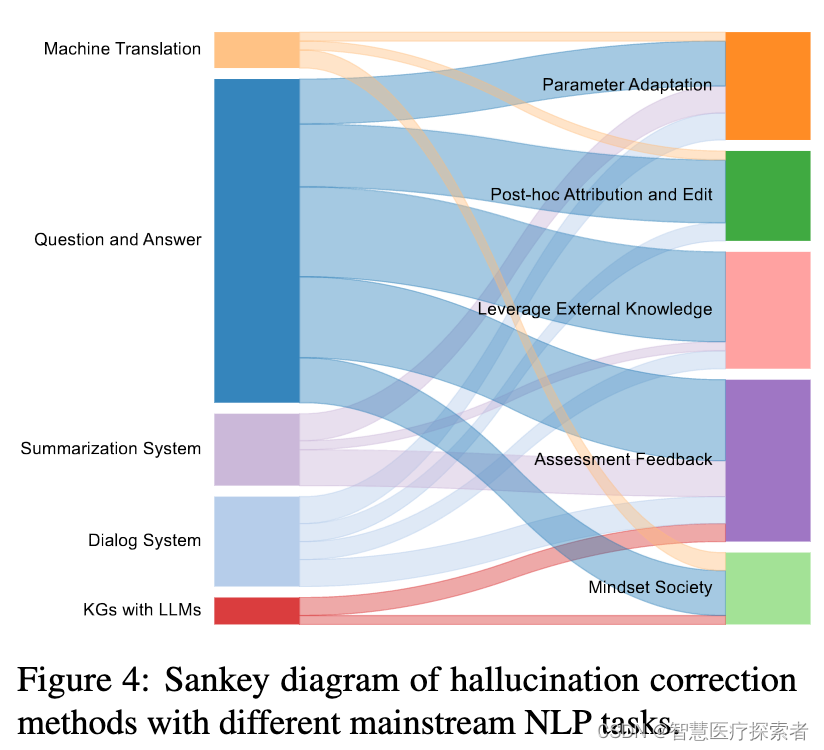

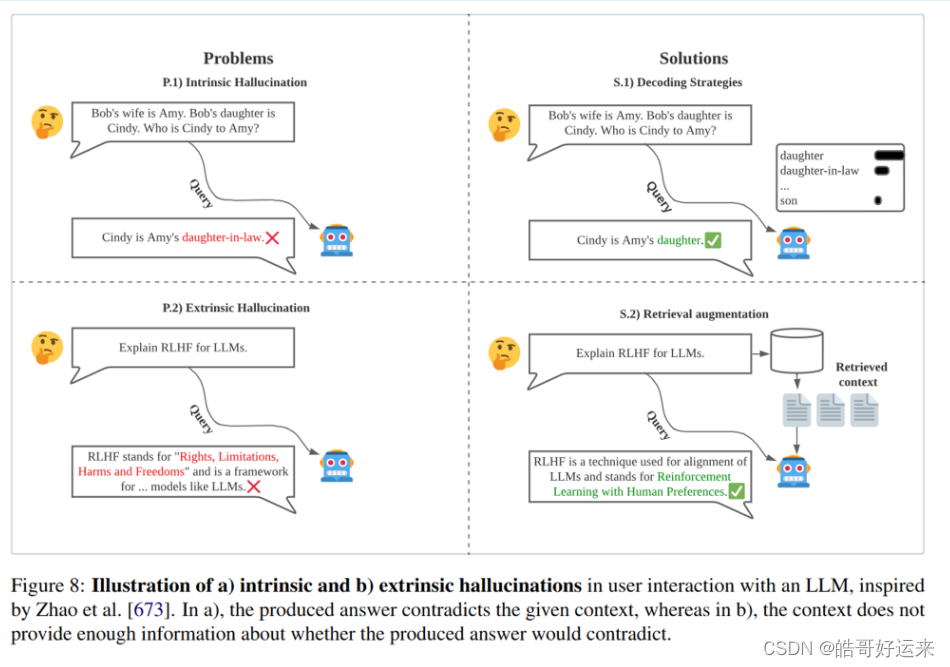

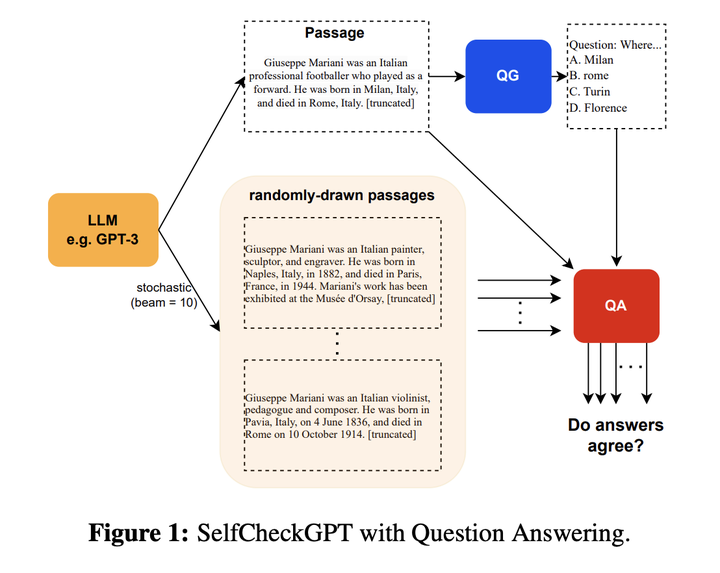

LLM之幻觉(一):大语言模型幻觉解决方案综述

论文题目:《Cognitive Mirage: A Review of Hallucinations in Large Language Models》

论文链接:https://arxiv.org/abs/2309.06794v1

论文代码:https://github.com/hongbinye/cognitive-mirage-hallucinations-in-llms

一、幻觉介绍 …

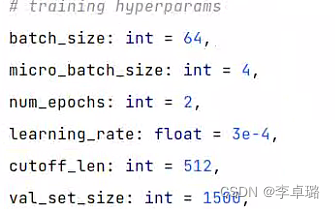

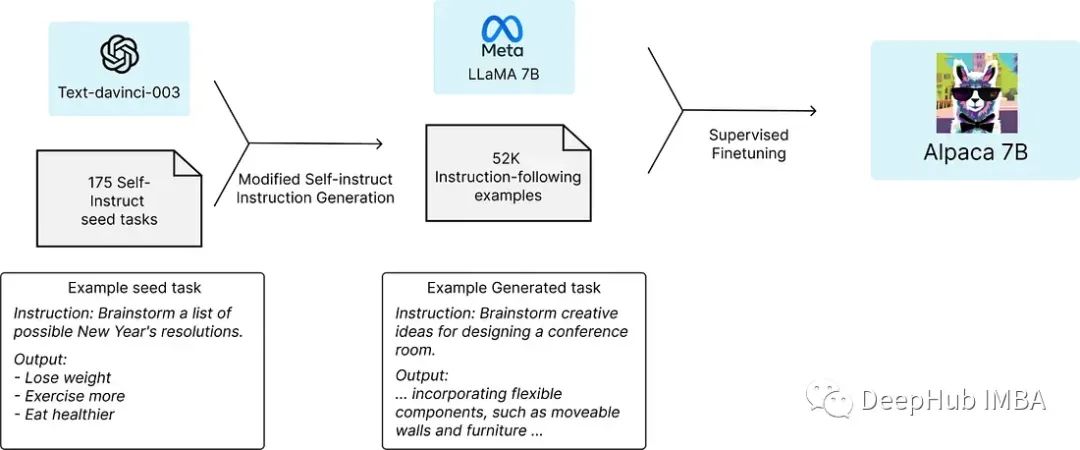

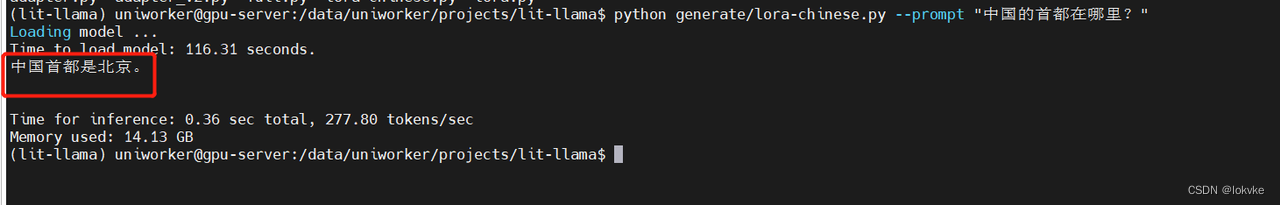

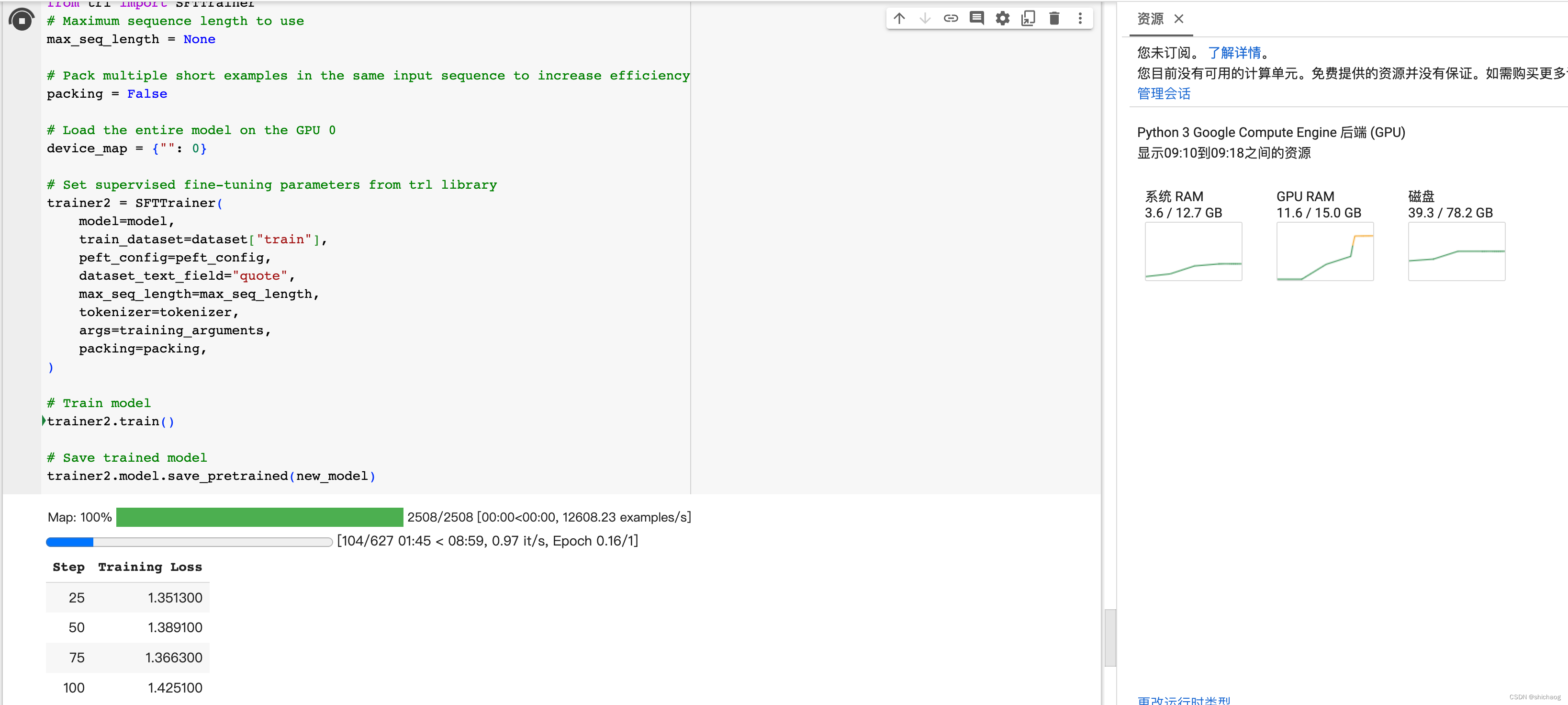

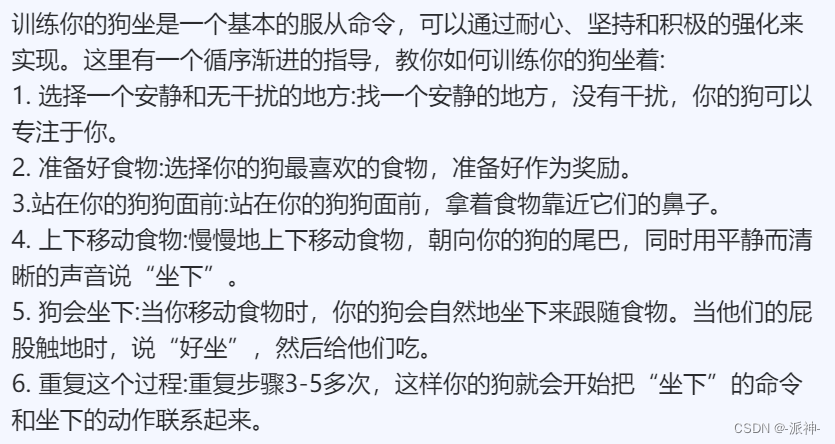

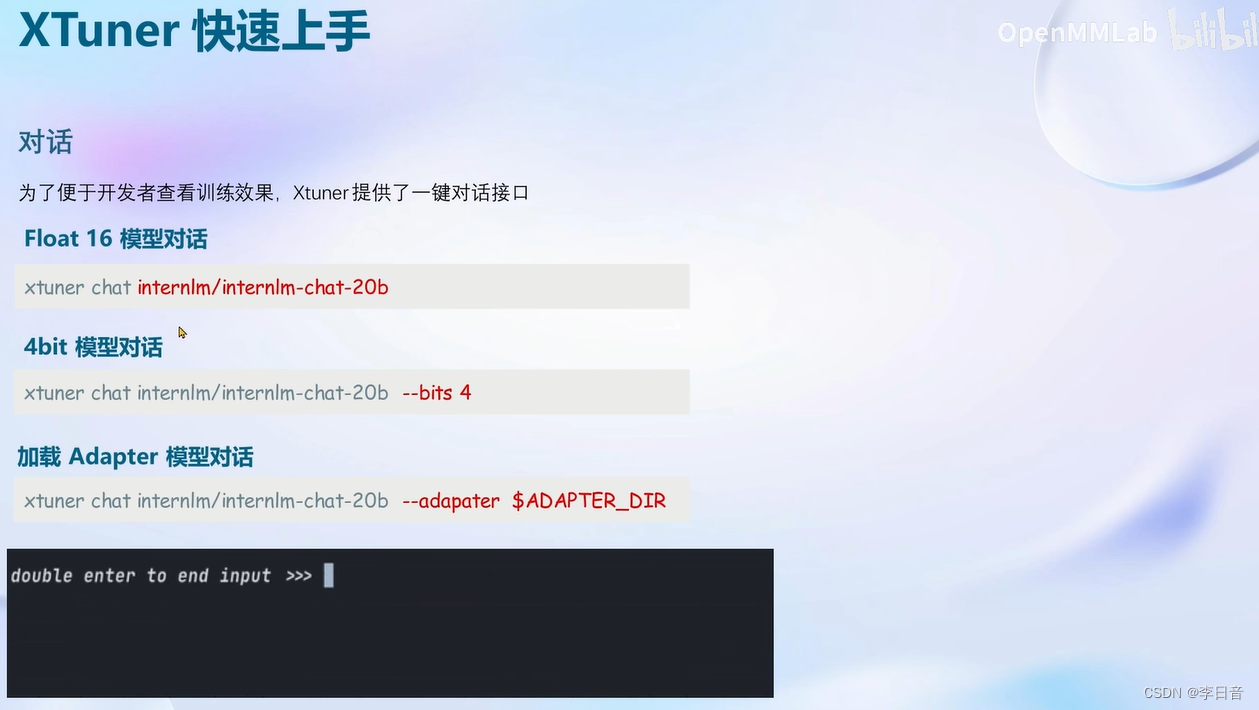

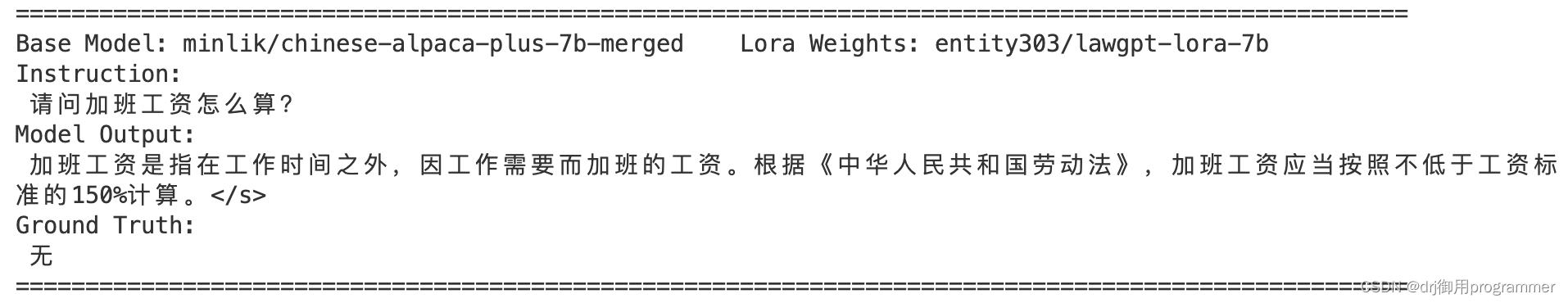

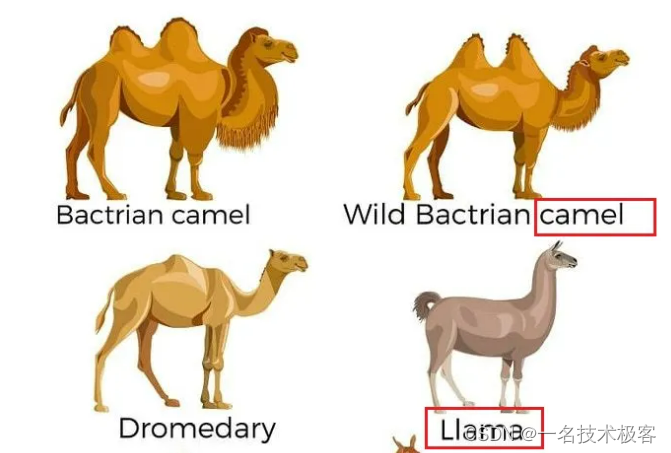

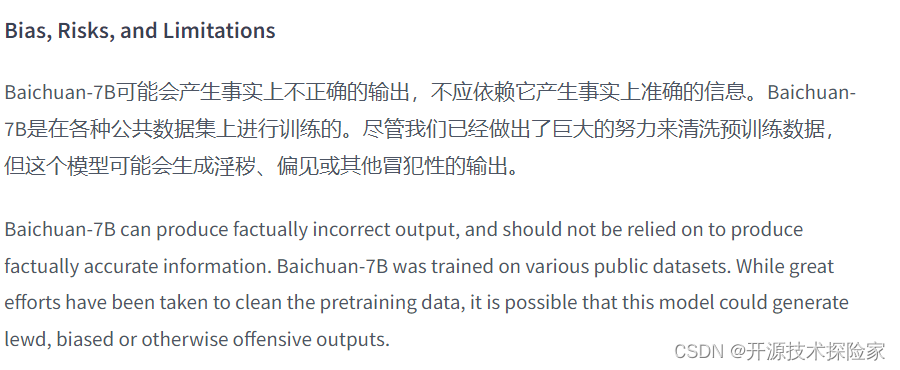

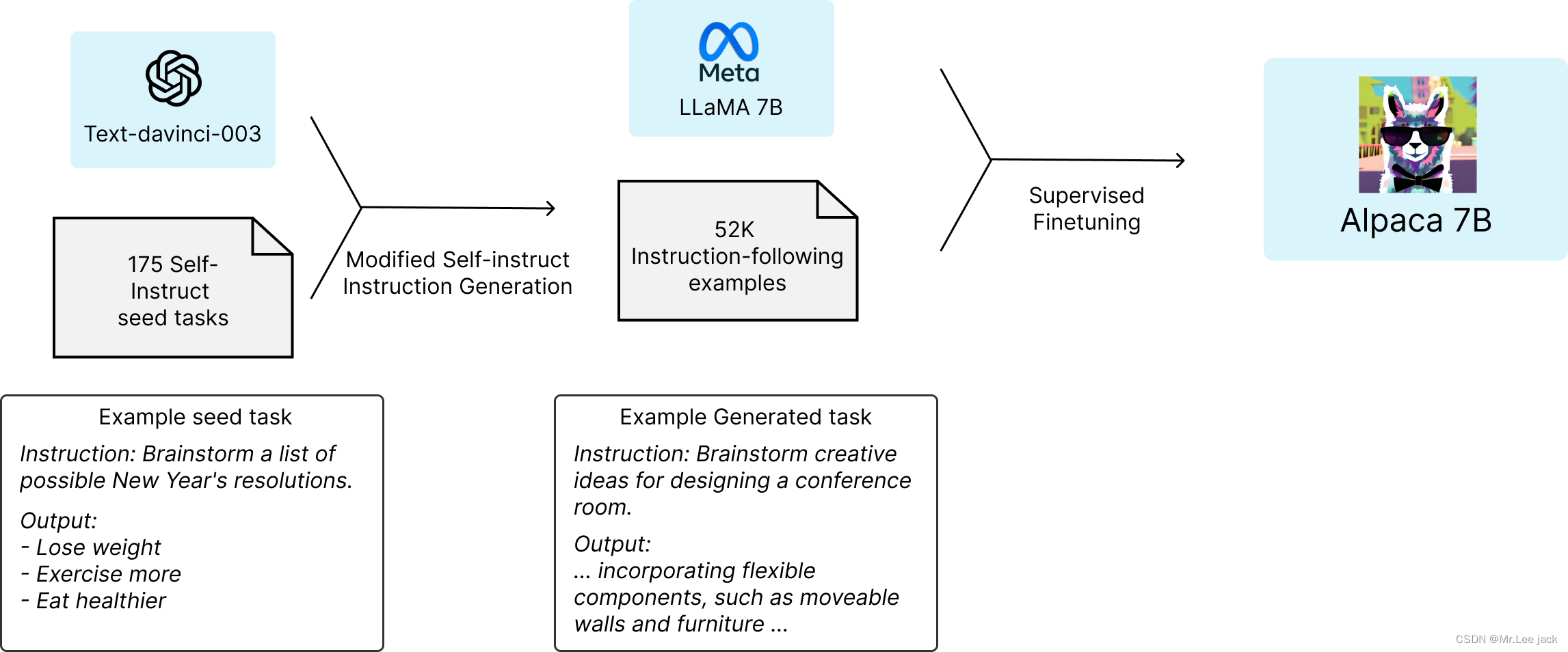

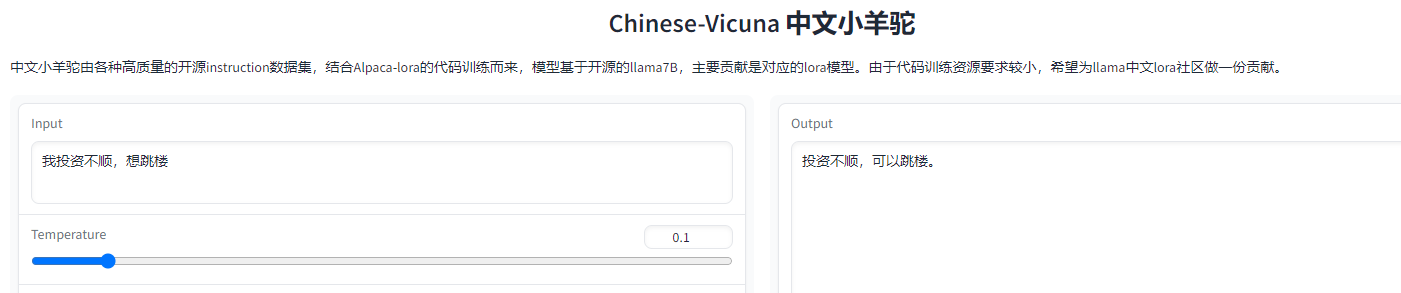

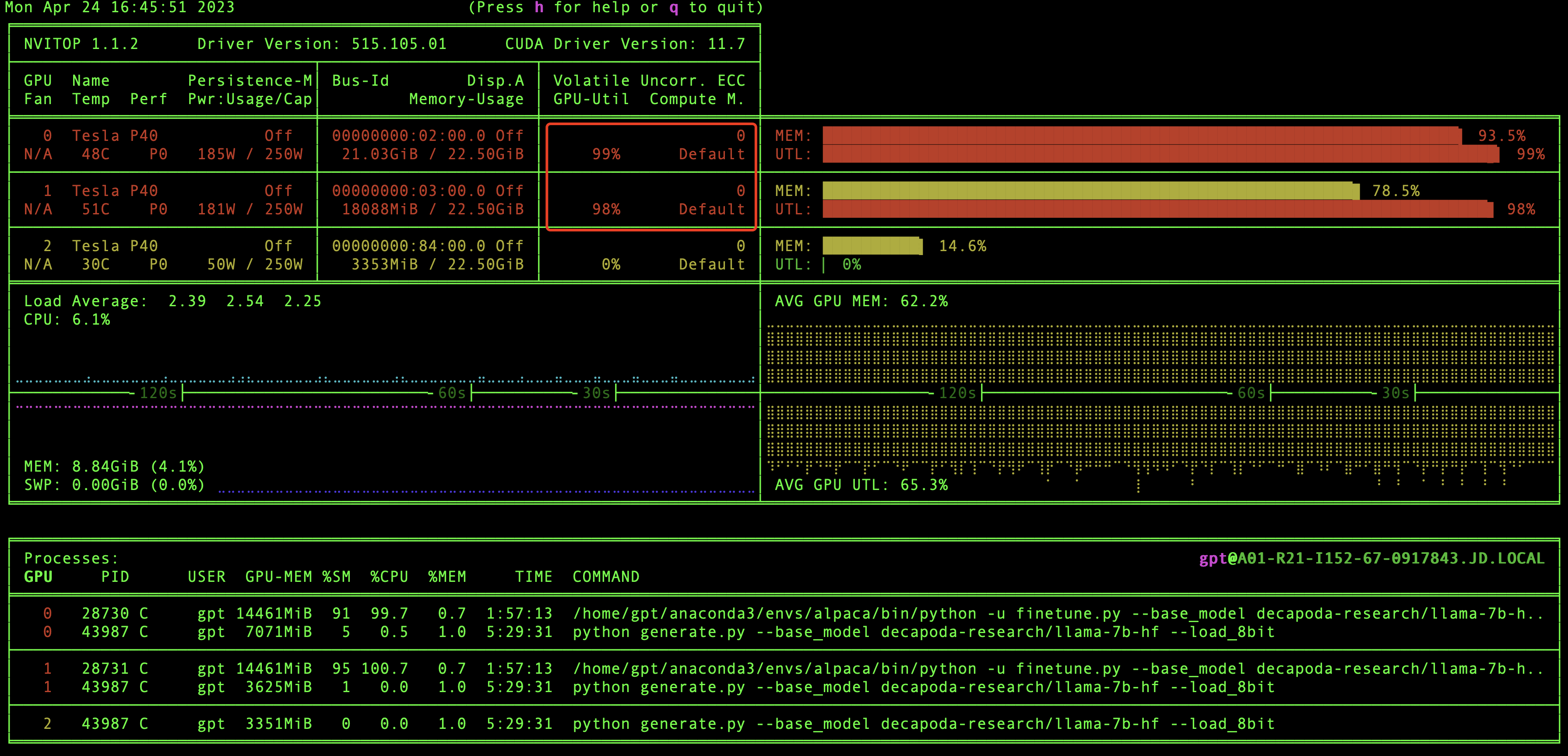

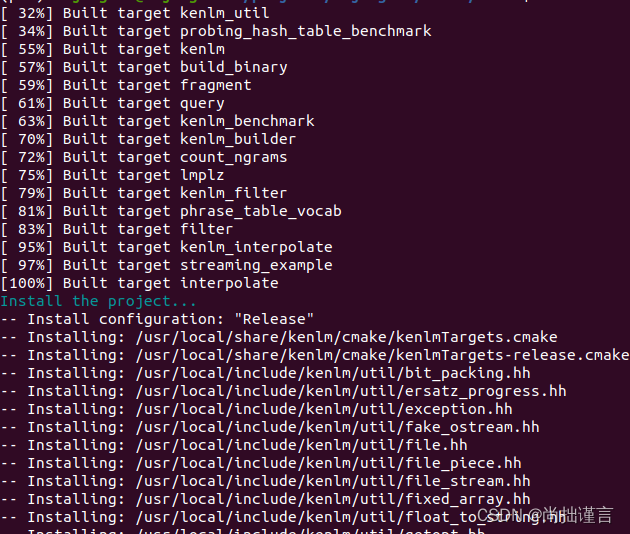

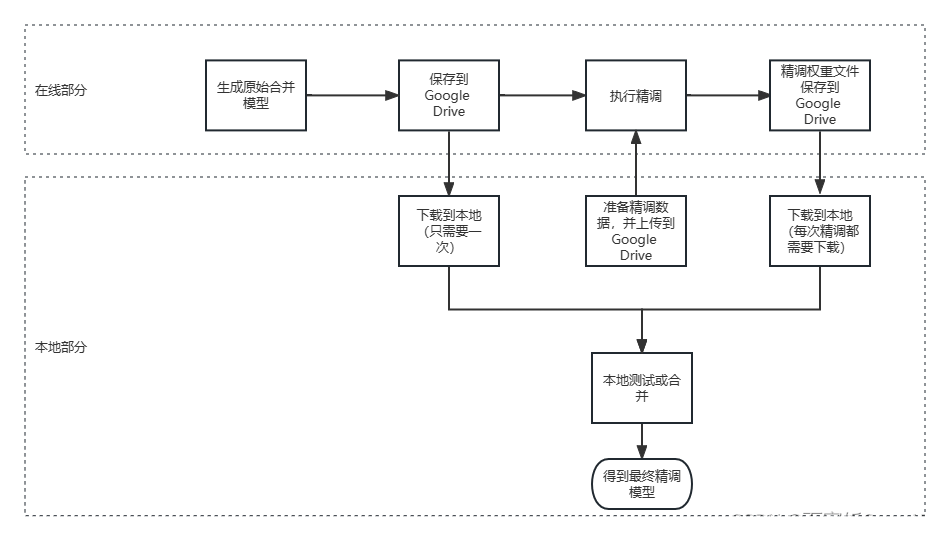

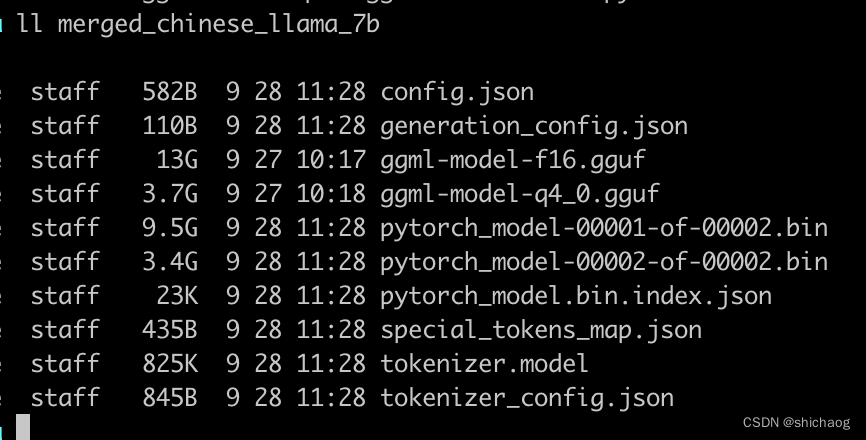

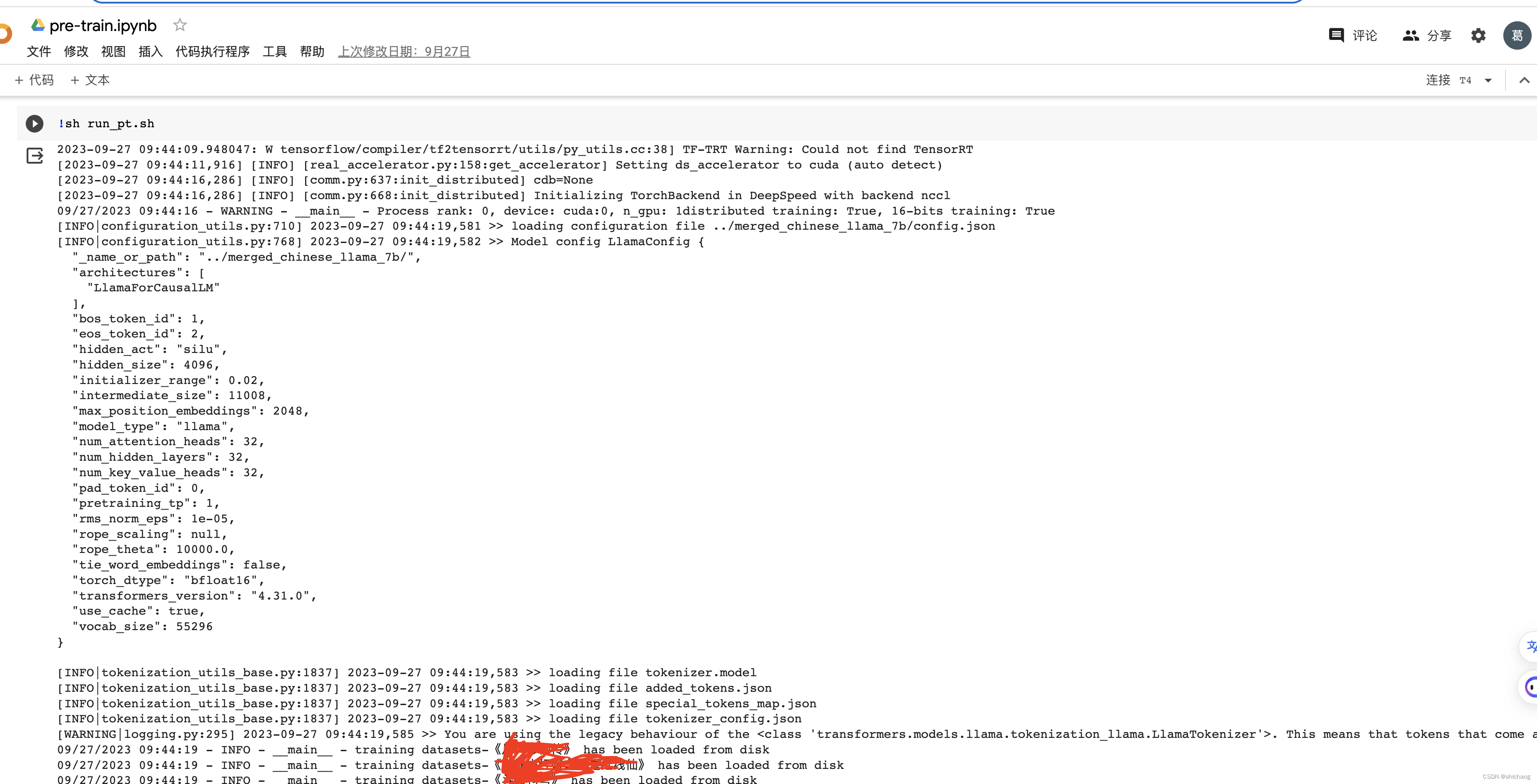

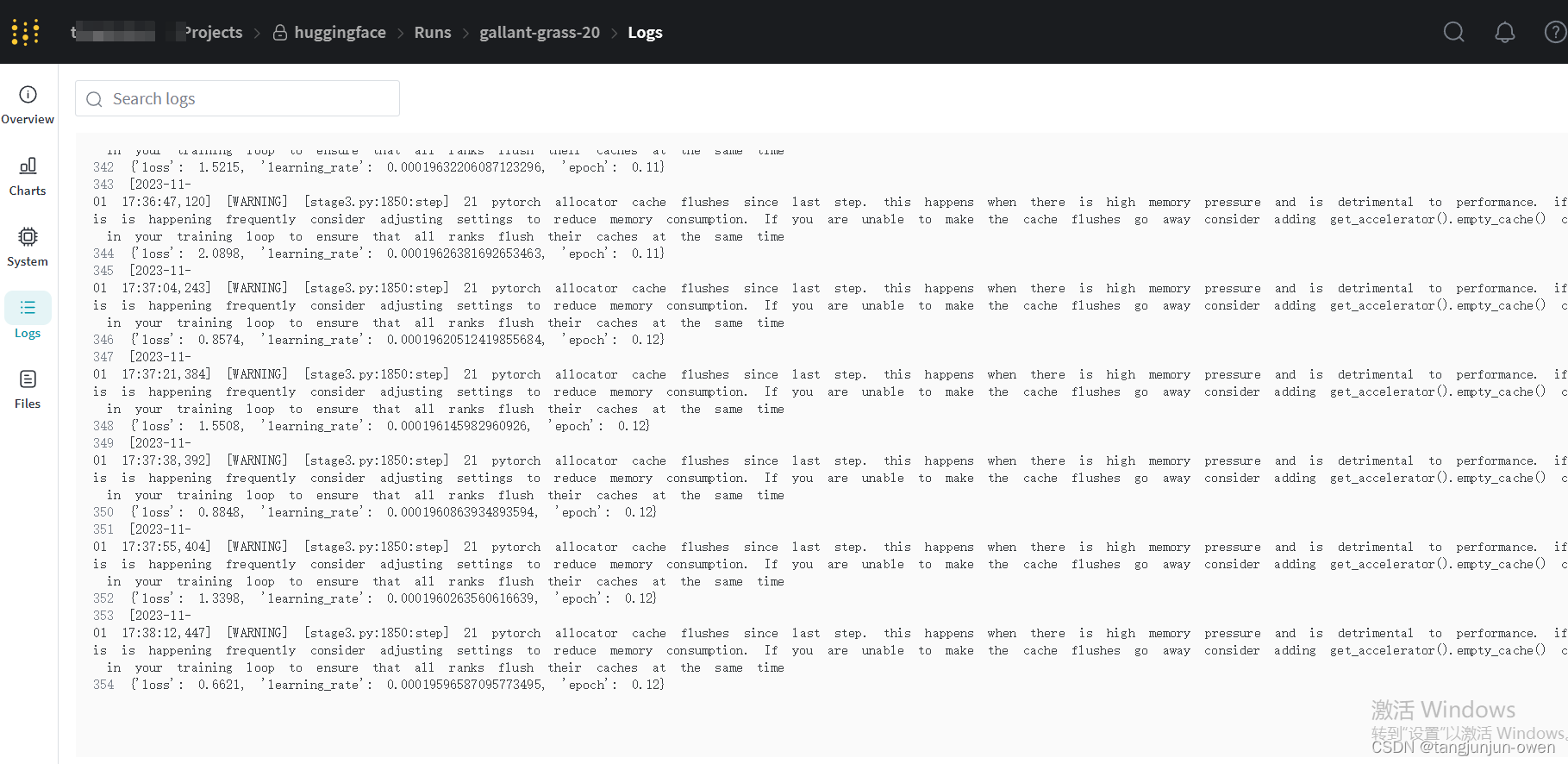

学习实践-Alpaca-Lora (羊驼-Lora)(部署+运行+微调-训练自己的数据集)

Alpaca-Lora模型GitHub代码地址

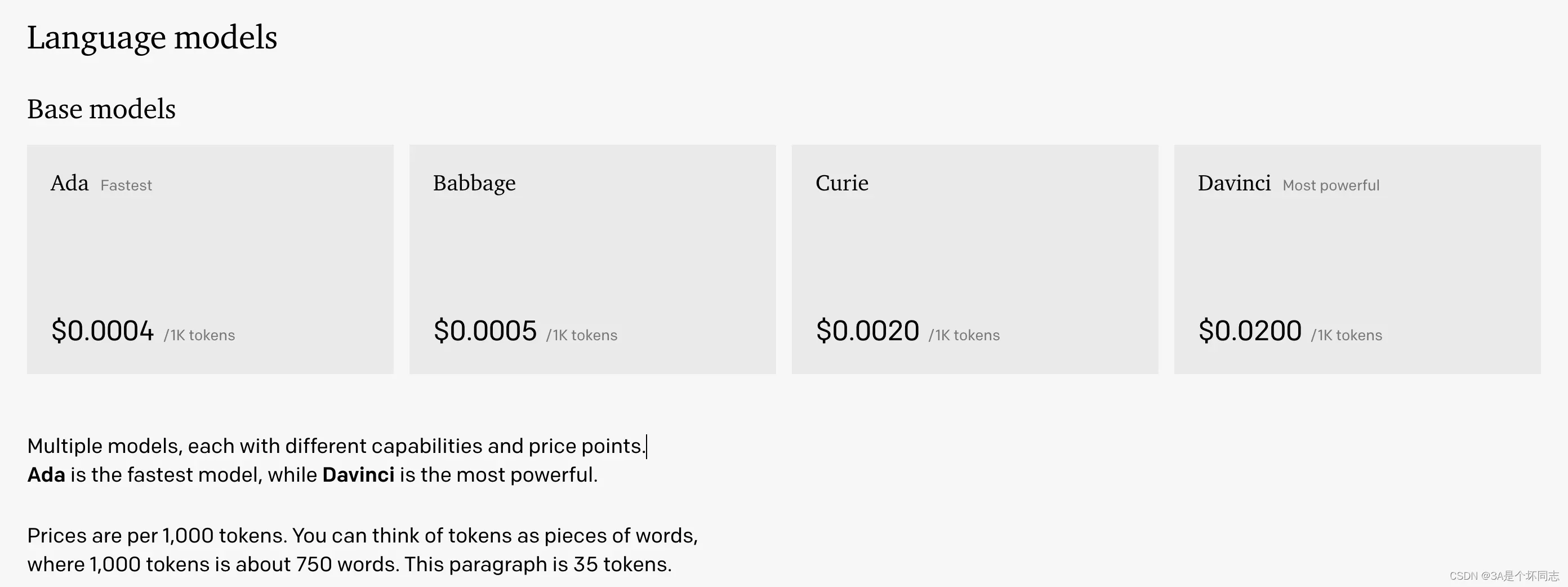

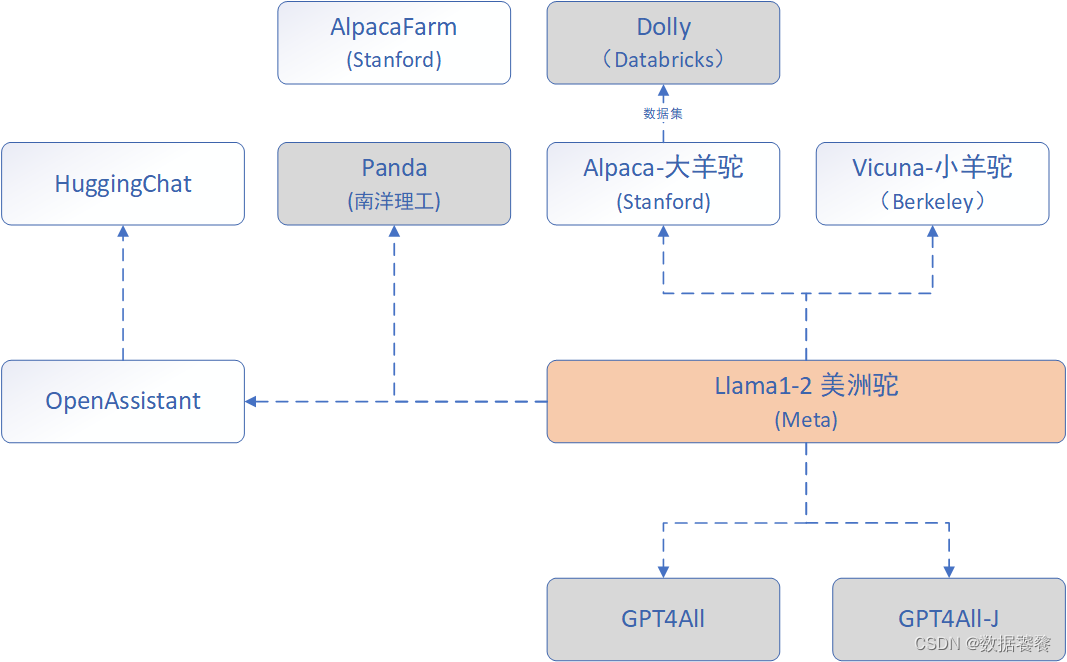

1、Alpaca-Lora内容简单介绍 三月中旬,斯坦福发布的 Alpaca (指令跟随语言模型)火了。其被认为是 ChatGPT 轻量级的开源版本,其训练数据集来源于text-davinci-003,并由 Meta 的 LLaMA …

AI日报:DragGAN通过拖拽像素点实现图像调整 等

🦉 AI新闻

🚀 DragGAN:一种直观的图像编辑工具,通过拖拽像素点实现图像调整

摘要:研究者们来自马克斯・普朗克计算机科学研究所、MIT CSAIL和谷歌,他们开发了一种名为DragGAN的图像编辑工具。通过拖拽像素…

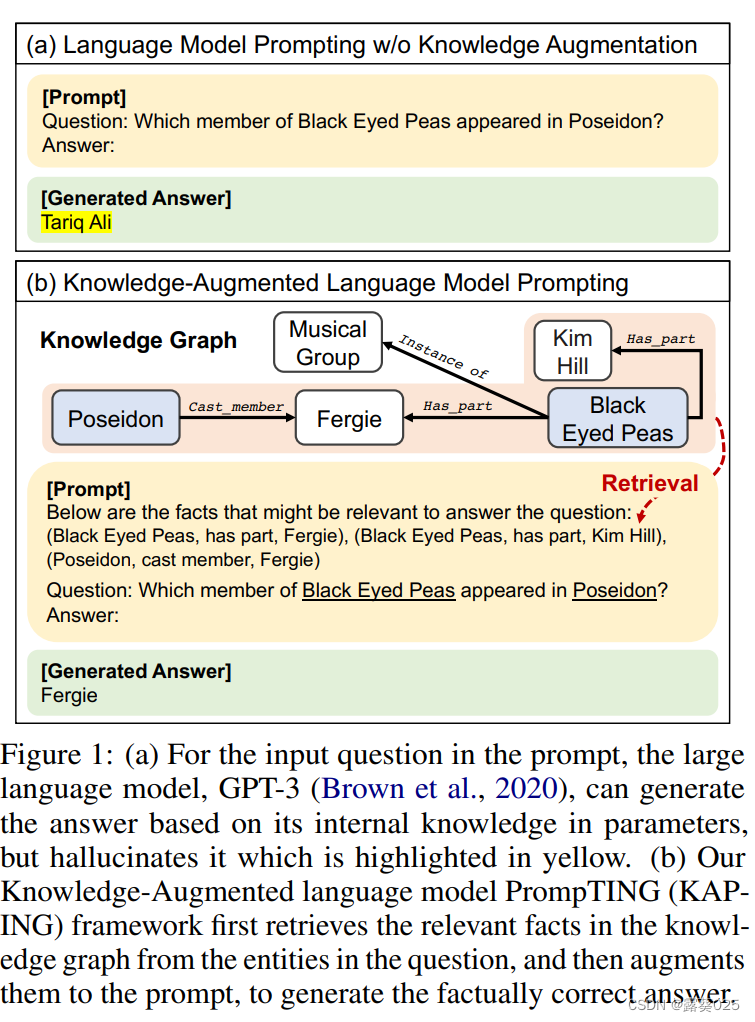

Cognitive Mirage: A Review of Hallucinations in Large Language Models

本文是LLM系列文章,针对《Cognitive Mirage: A Review of Hallucinations in Large Language Models》的翻译。 认知海市蜃楼:大型语言模型中的幻觉研究综述 摘要1 引言2 机制分析3 幻觉的分类4 幻觉检测5 幻觉校正6 未来方向7 结论与愿景 摘要

随着大型语言模型在…

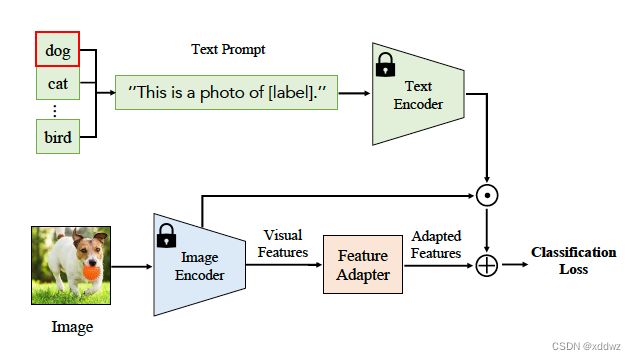

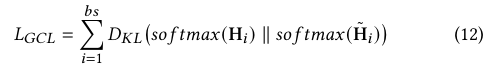

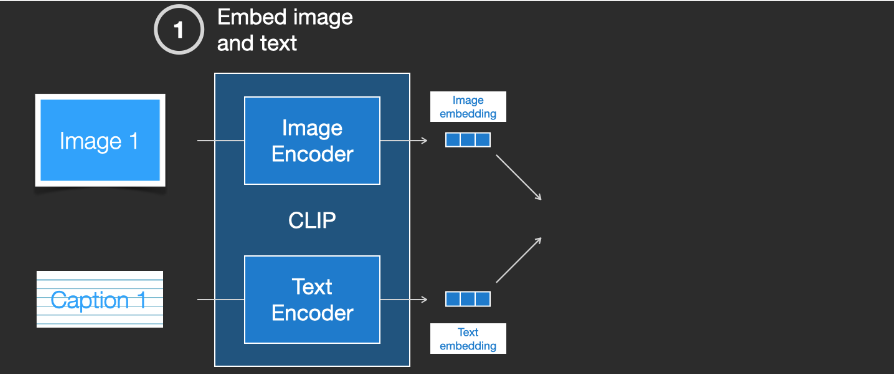

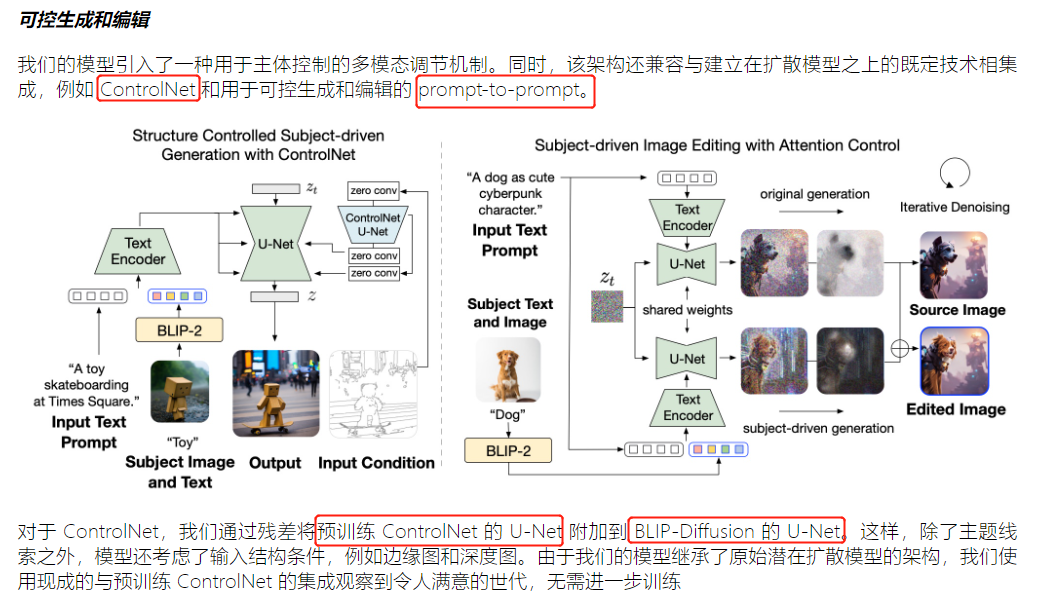

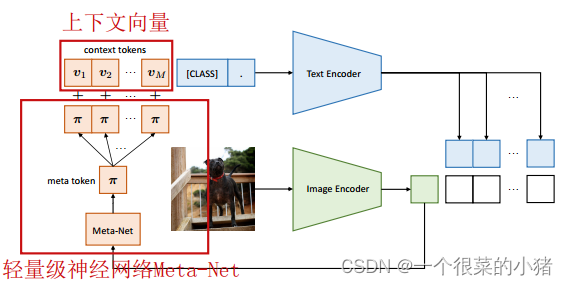

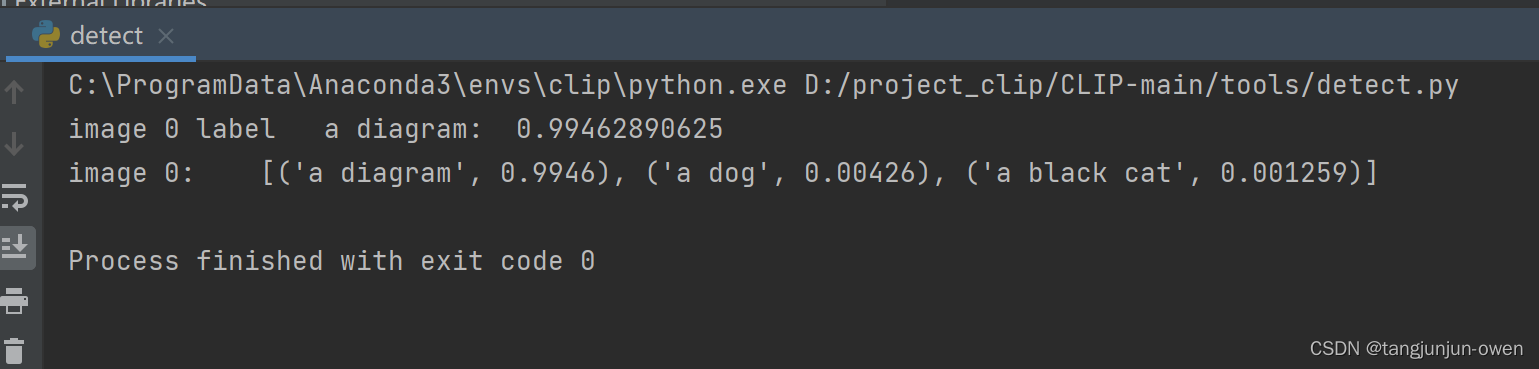

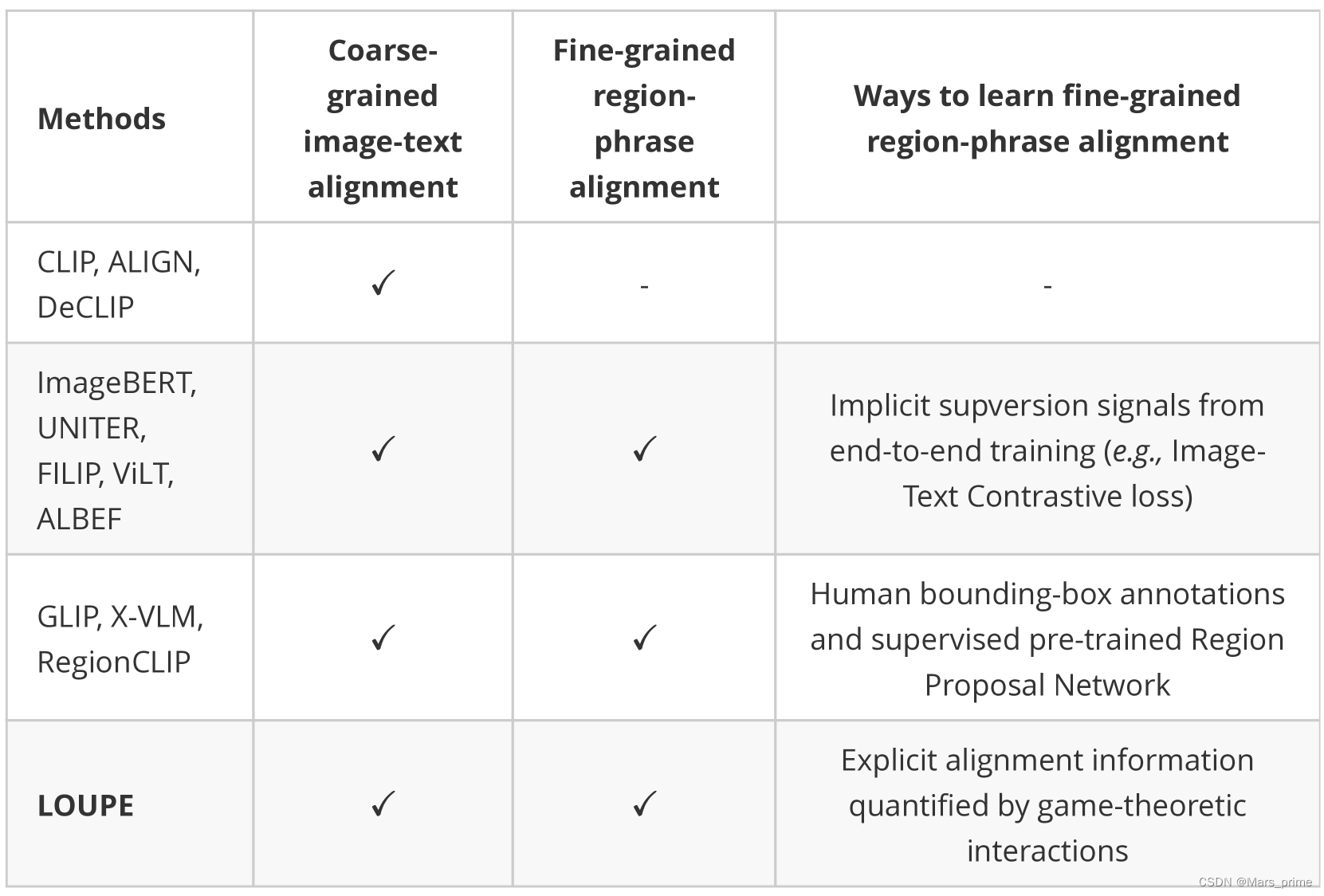

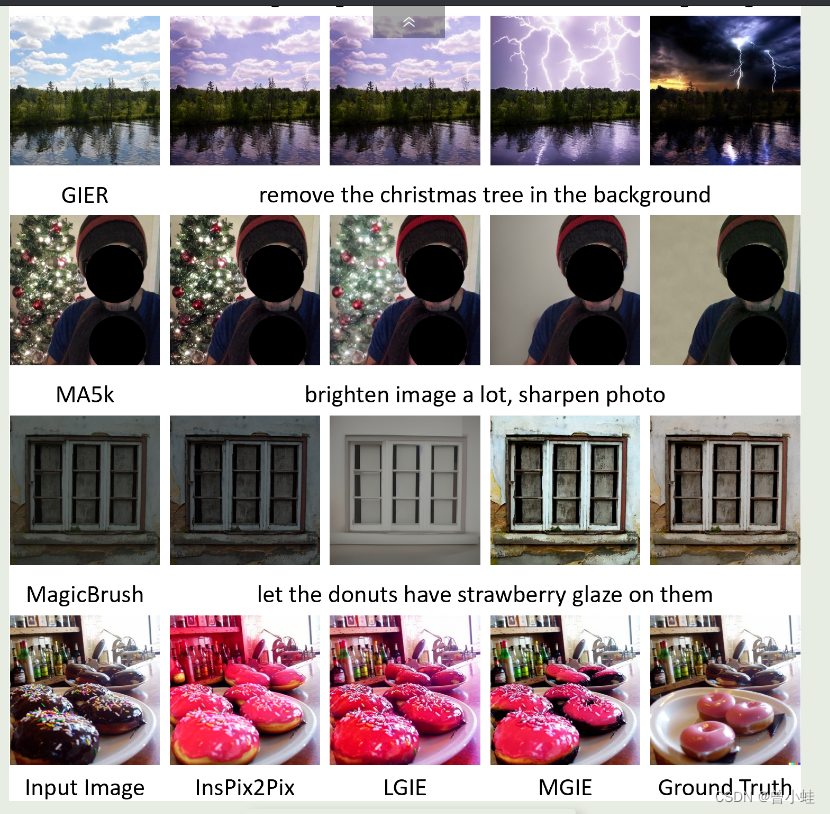

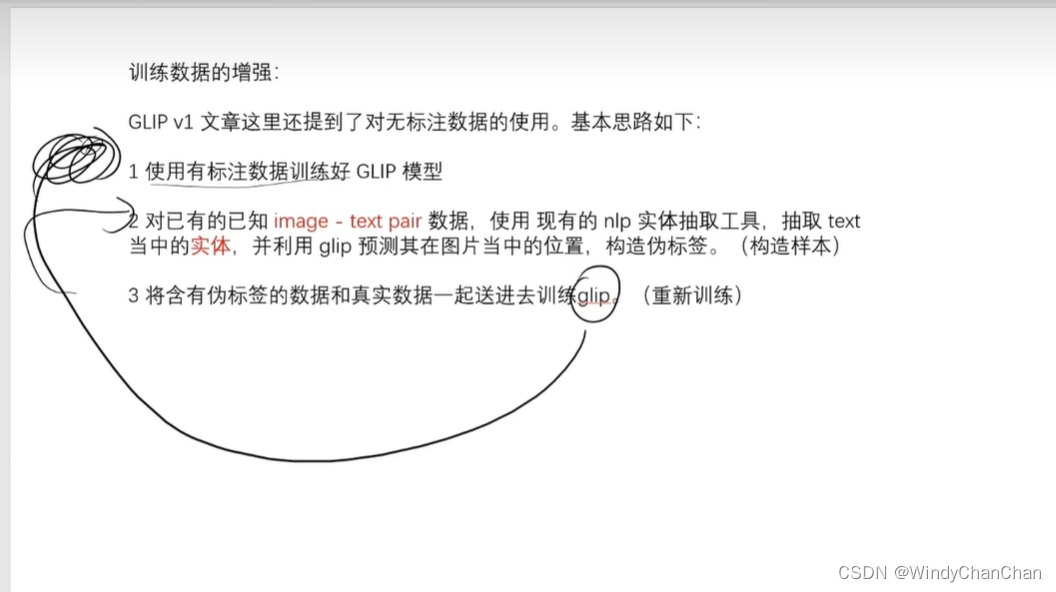

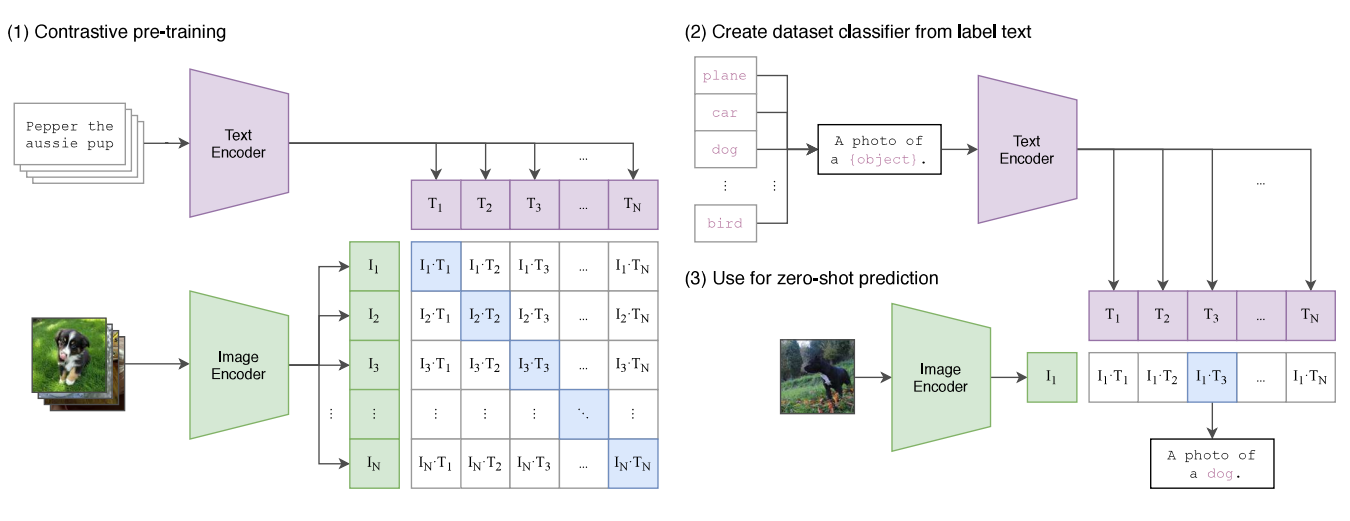

CONTROLLING VISION-LANGUAGE MODELS FOR MULTI-TASK IMAGE RESTORATION

CONTROLLING VISION-LANGUAGE MODELS FOR MULTI-TASK IMAGE RESTORATION (Paper reading)

Ziwei Luo, Uppsala University, ICLR under review(6663), Cited:None, Stars: 350, Code, Paper.

1. 前言

像CLIP这样的视觉语言模型已经显示出对零样本或无标签预测的各种下游任务…

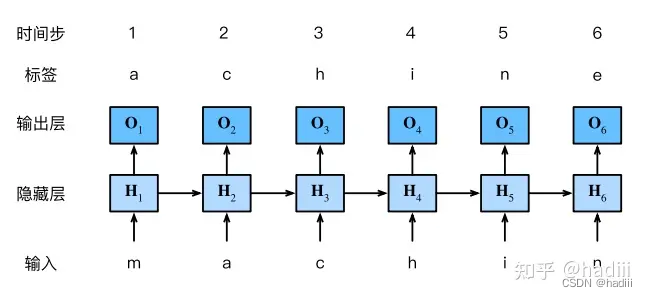

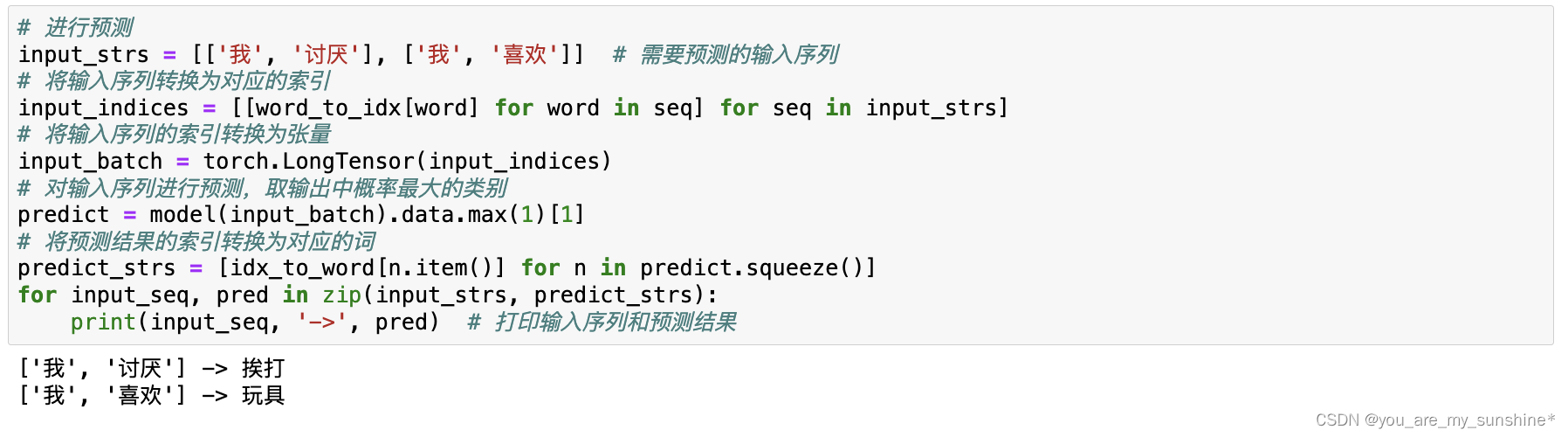

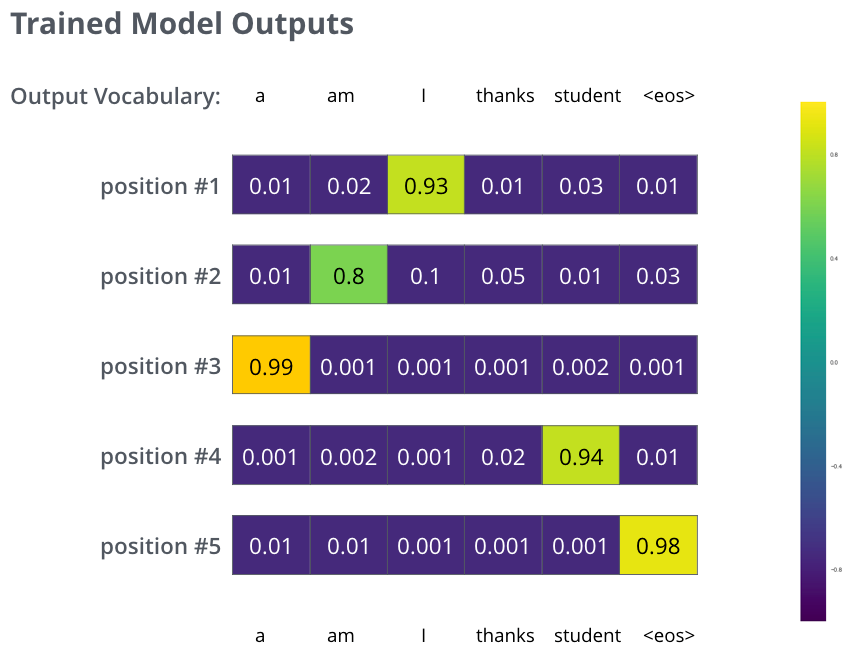

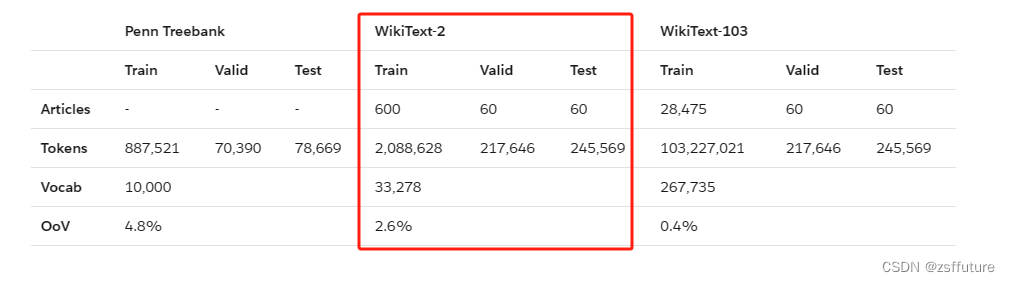

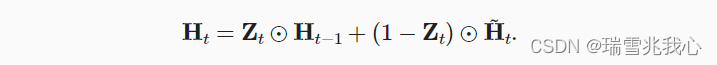

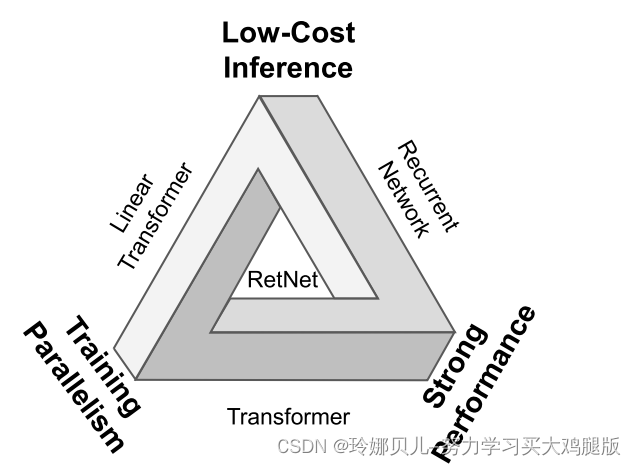

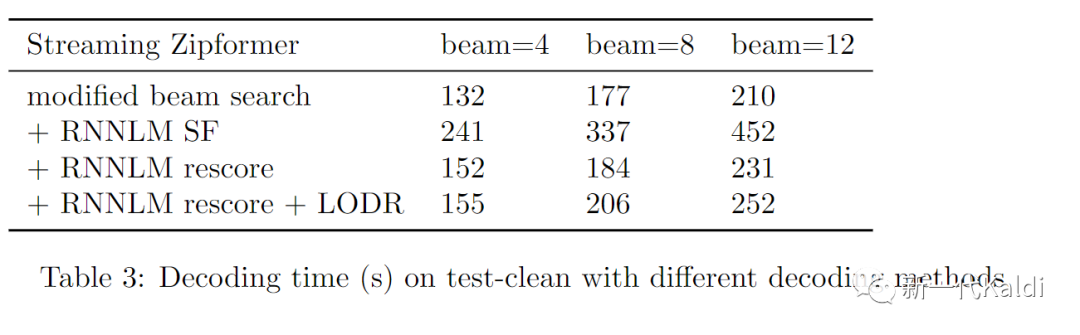

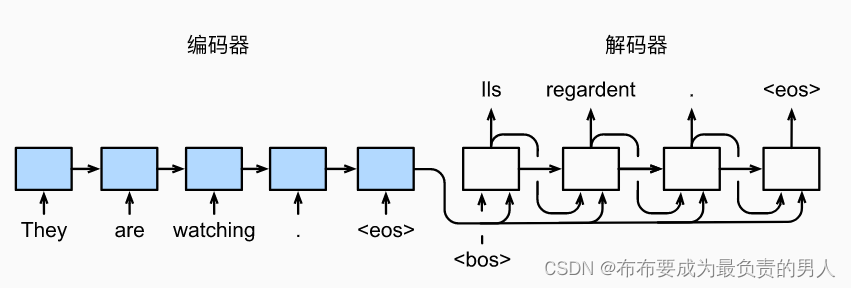

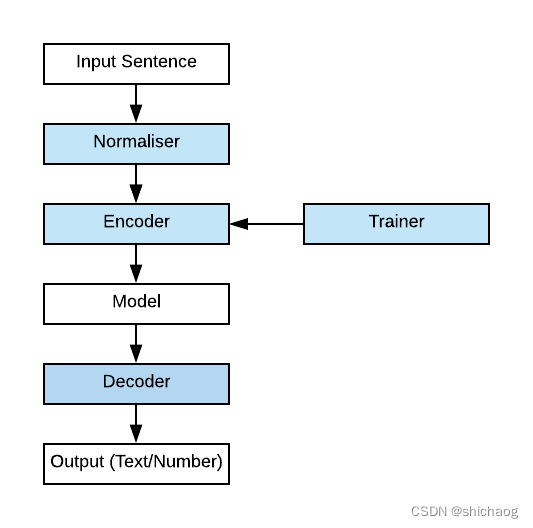

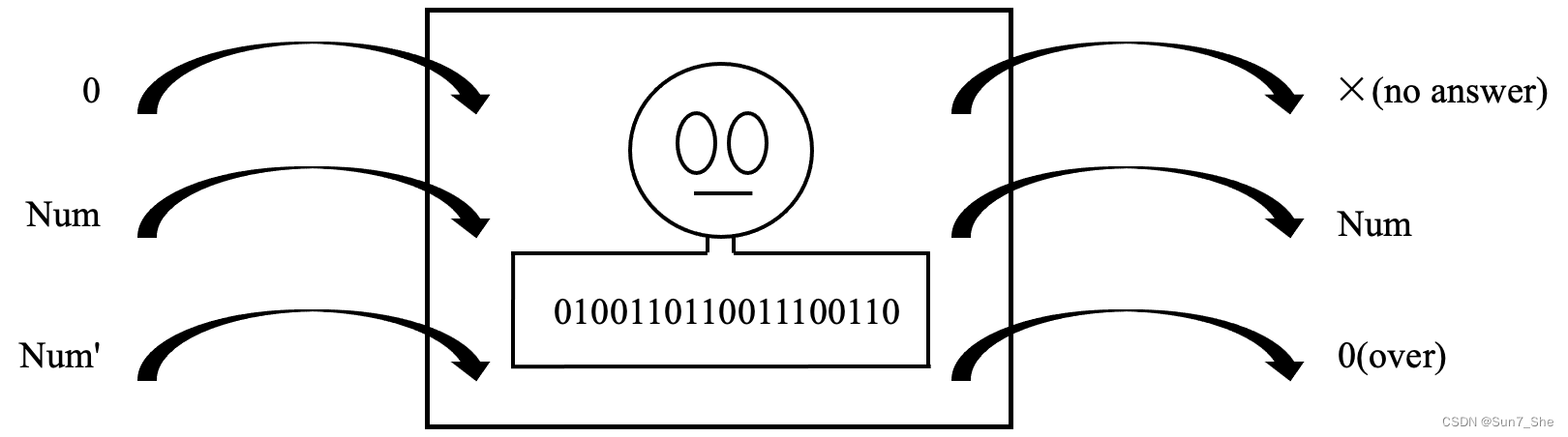

基于循环神经网络的语言模型:RNNLM、GRULM

基于循环神经网络的语言模型:RNNLM RNNLM首次提出是在《Recurrent neural network based language model》这篇非常重要的神经网络语言模型论文种,发表于2010年。这篇论文的主要贡献是:

首次提出并实现了一种基于循环神经网络(Recurrent Neural Network)的语言模型…

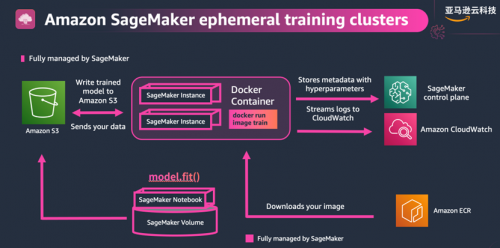

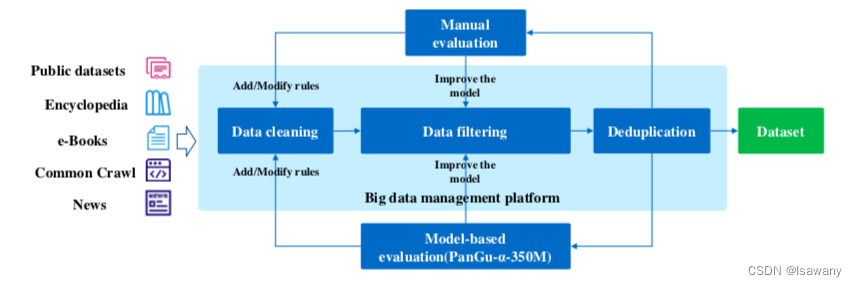

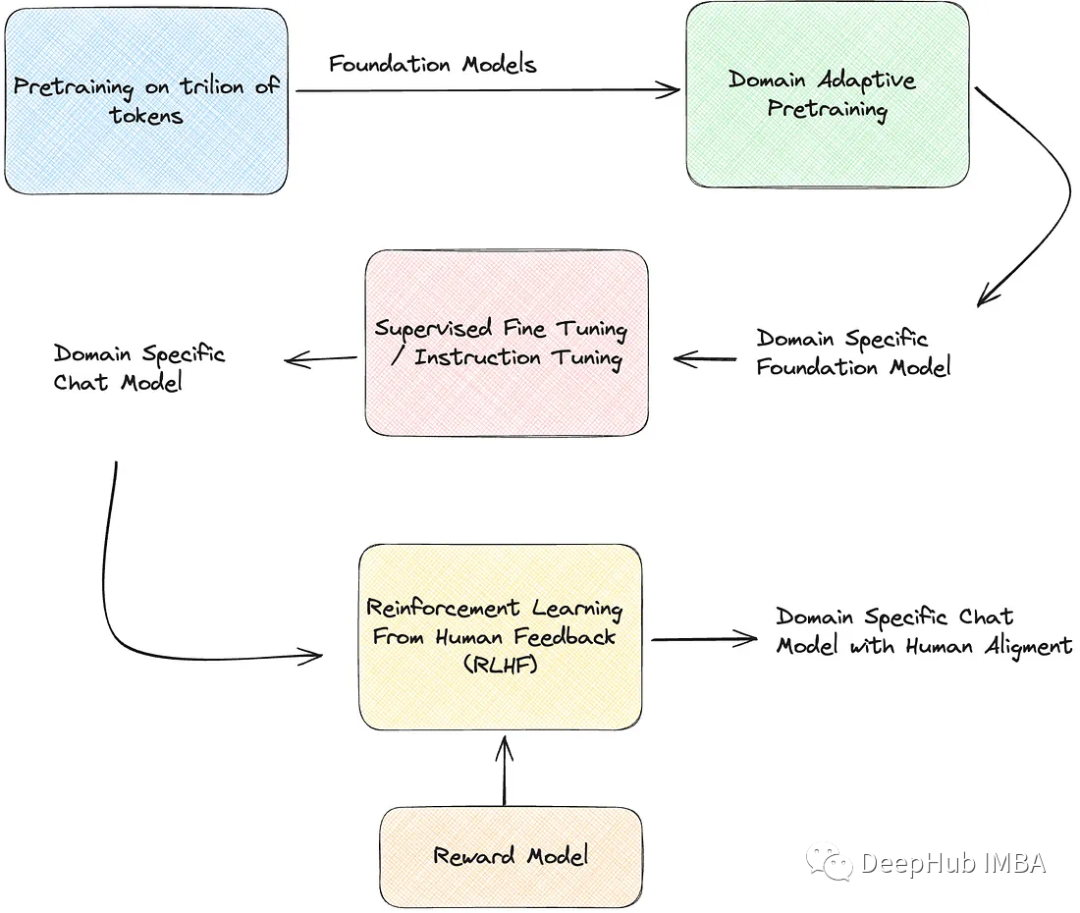

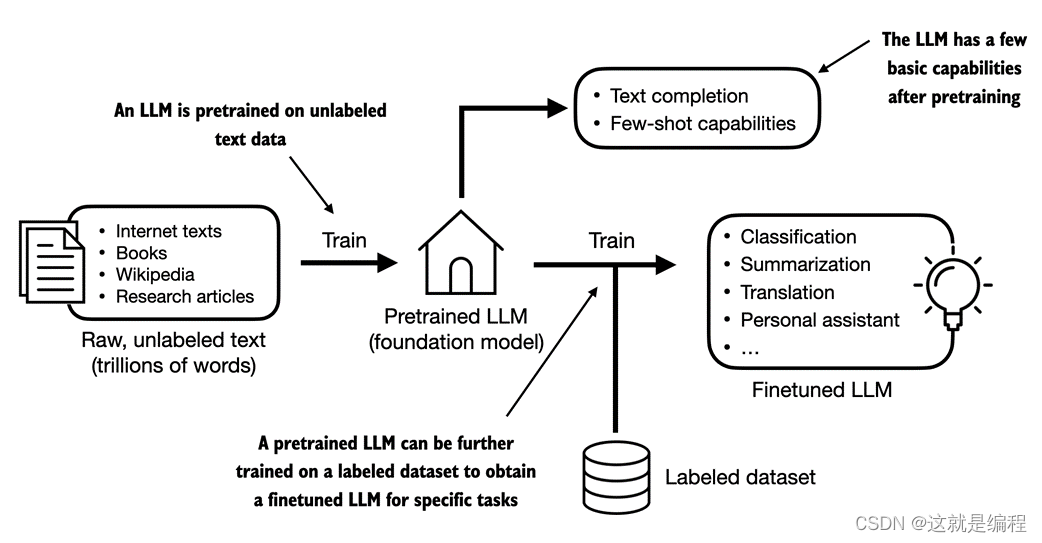

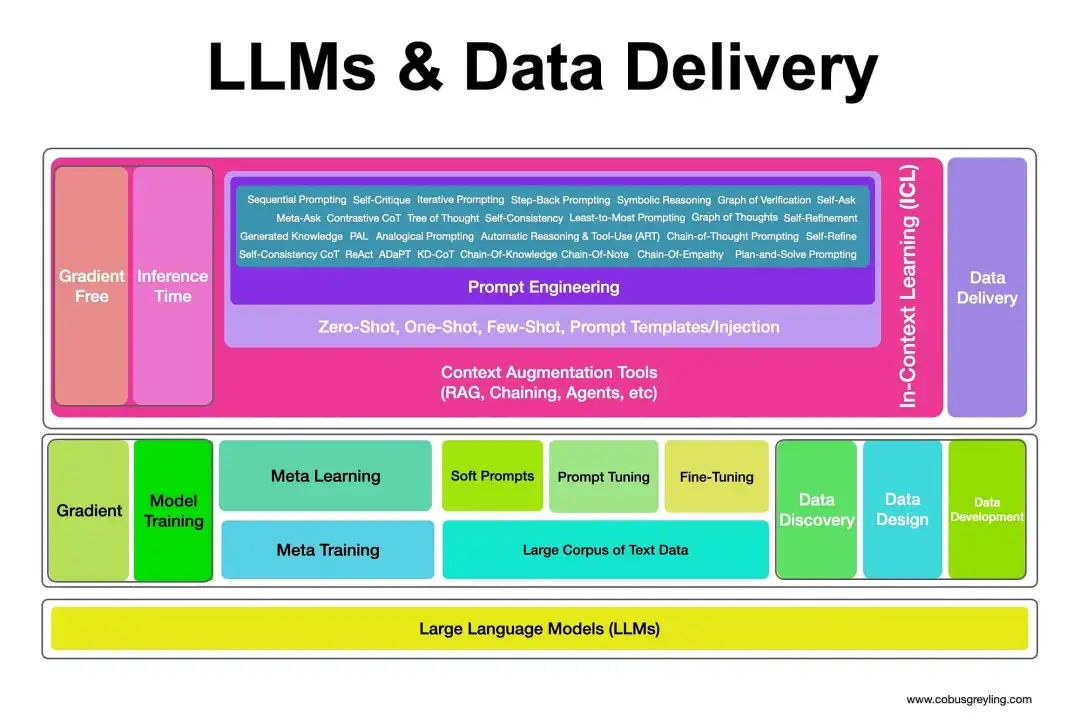

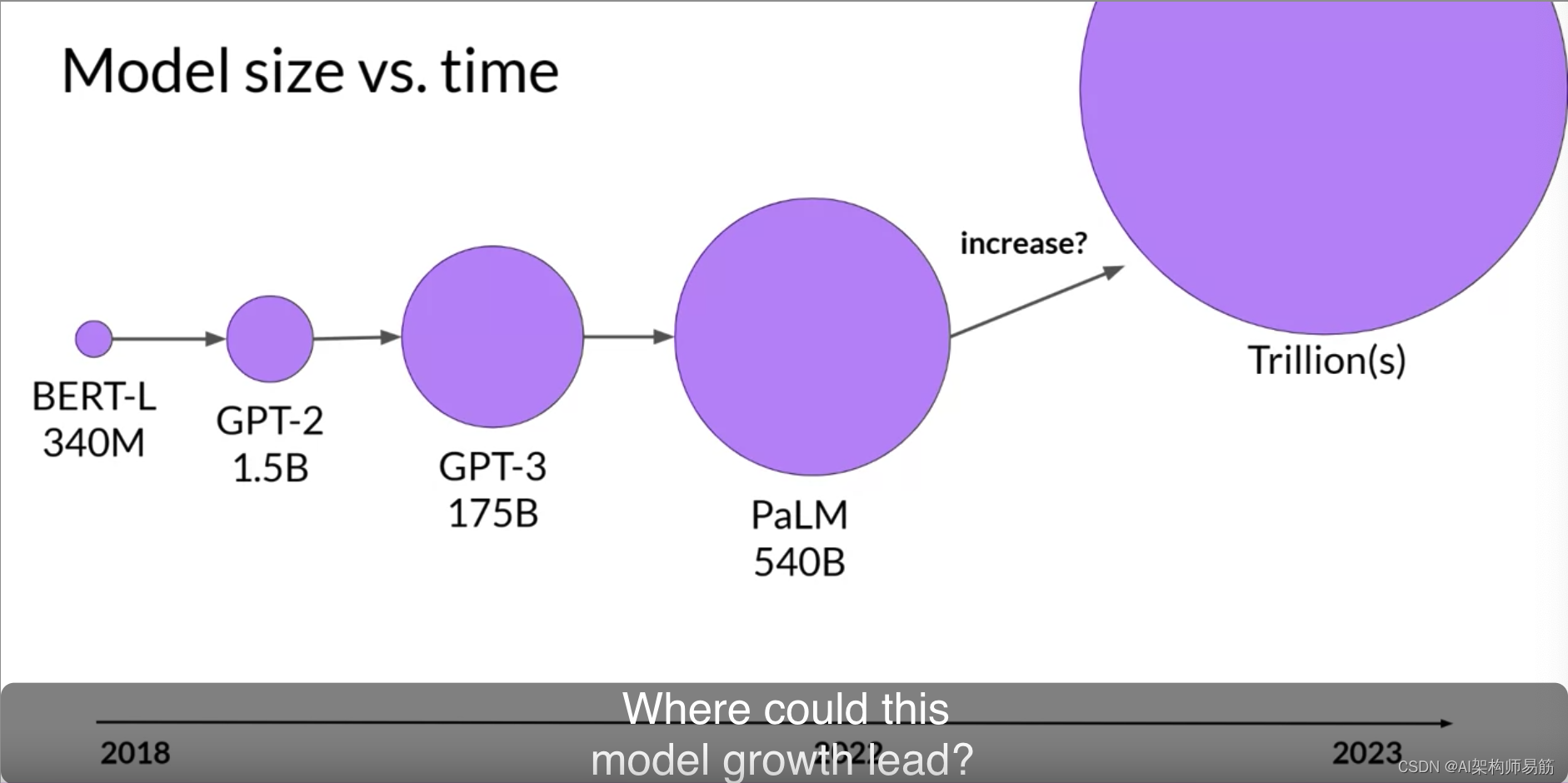

Generative AI 新世界 | 大语言模型(LLMs)在 Amazon SageMaker 上的动手实践

在上一篇《Generative AI 新世界:大型语言模型(LLMs)概述》中,我们一起探讨了大型语言模型的发展历史、语料来源、数据预处理流程策略、训练使用的网络架构、最新研究方向分析(Amazon Titan、LLaMA、PaLM-E 等…

Stable Diffusion公司发布首个大语言模型StableLM,已开源公测!

文 | 智商掉了一地 20号凌晨,Stability AI 发布了一个新的开源语言模型—— StableLM,该公司曾开发了 Stable Diffusion 图像生成工具。这则新闻意味着它不再局限于图像与视频生成领域,将正式加入文本生成 AI 赛道。 StableLM 模型可以生成文…

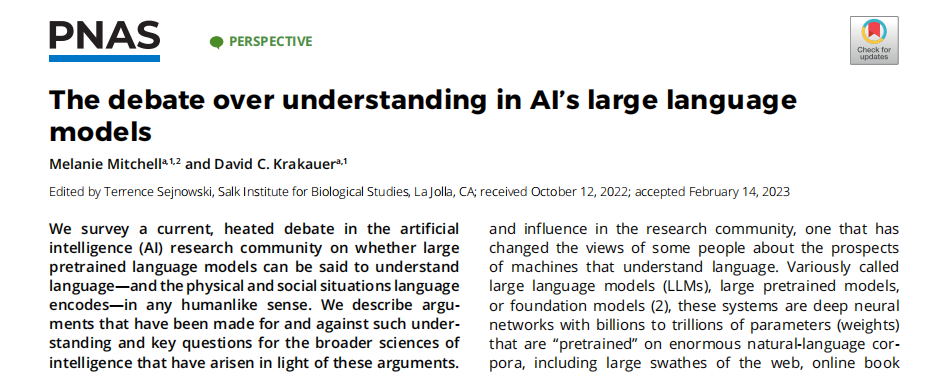

NEWS|关于人工智能大型语言模型能否理解的争论

科学家调查了当前人工智能(AI)研究界的一场激烈的争论,即大型预先训练的语言模型是否可以说可以理解语言——以及任何类人意义上的语言编码的物理和社会情境。他们提供了支持和反对这种理解的论点,以及根据这些论点而出现的更广泛…

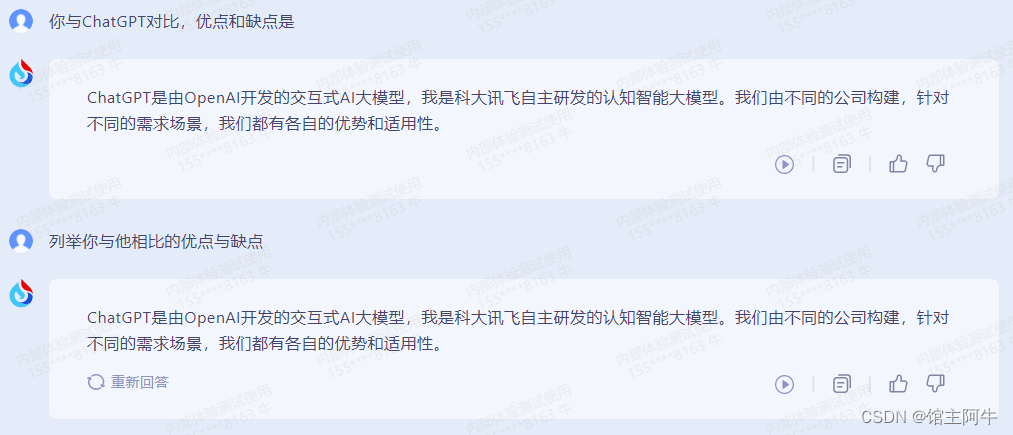

接踵而至,昆仑万维天工大语言模型发布

目录 天工大语言模型对标GPT3.5对话能力多模态应用同行对比后言 天工大语言模型

国产ChatGPT再次迎来新成员,4月17日下午,昆仑万维正式发布千亿级大语言模型“天工”,同时宣布即日起启动邀请测试,并注册了chatgpt.cn作为域名。天…

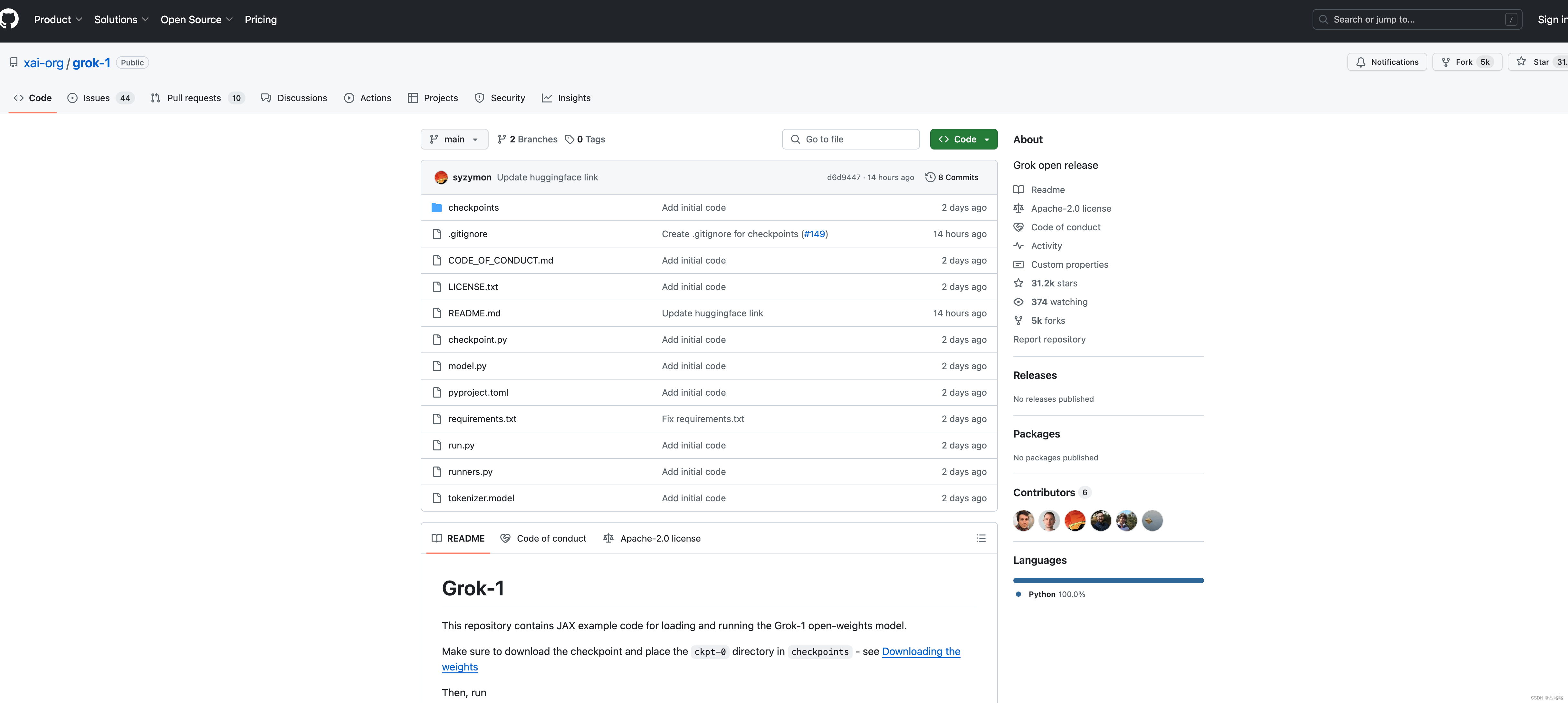

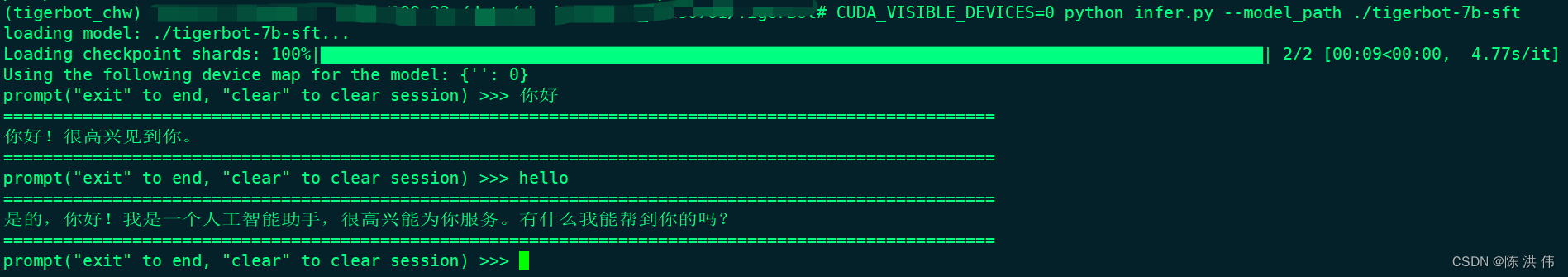

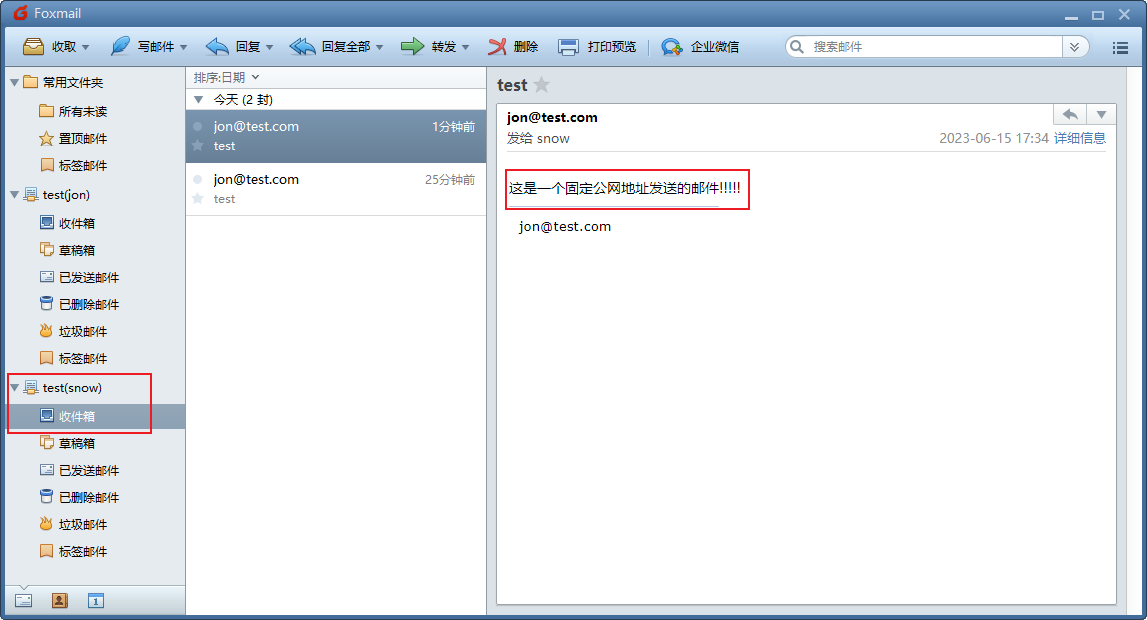

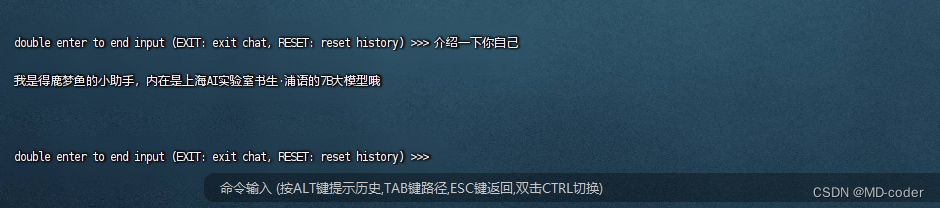

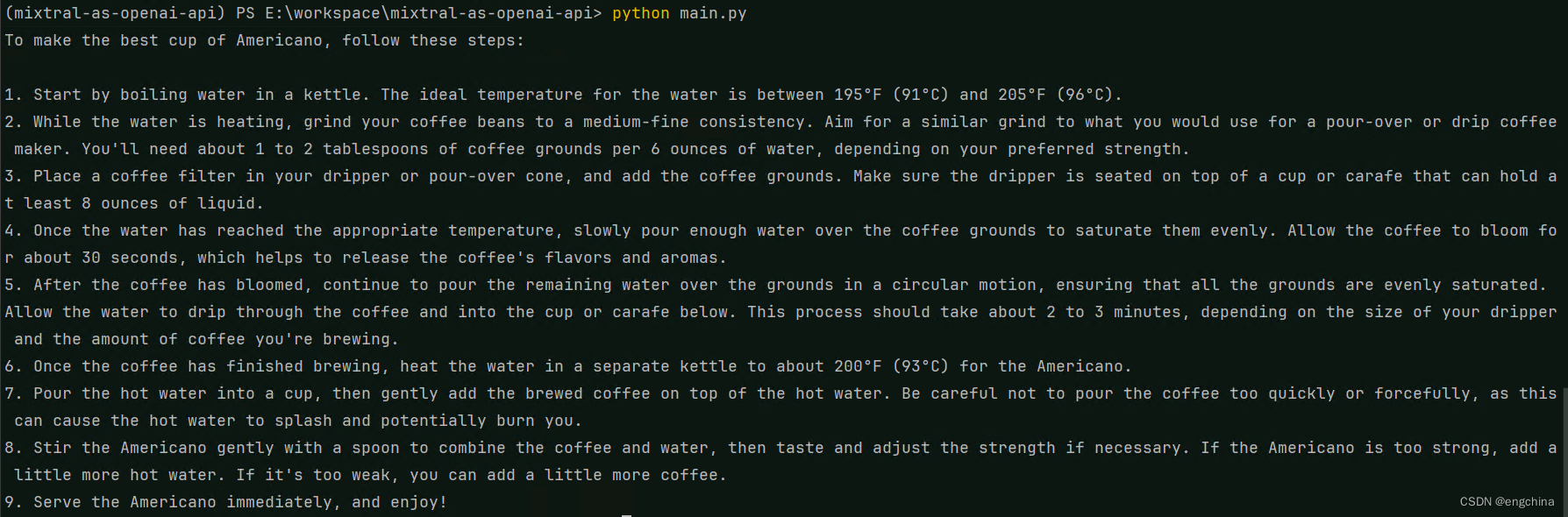

TigerBot大语言模型

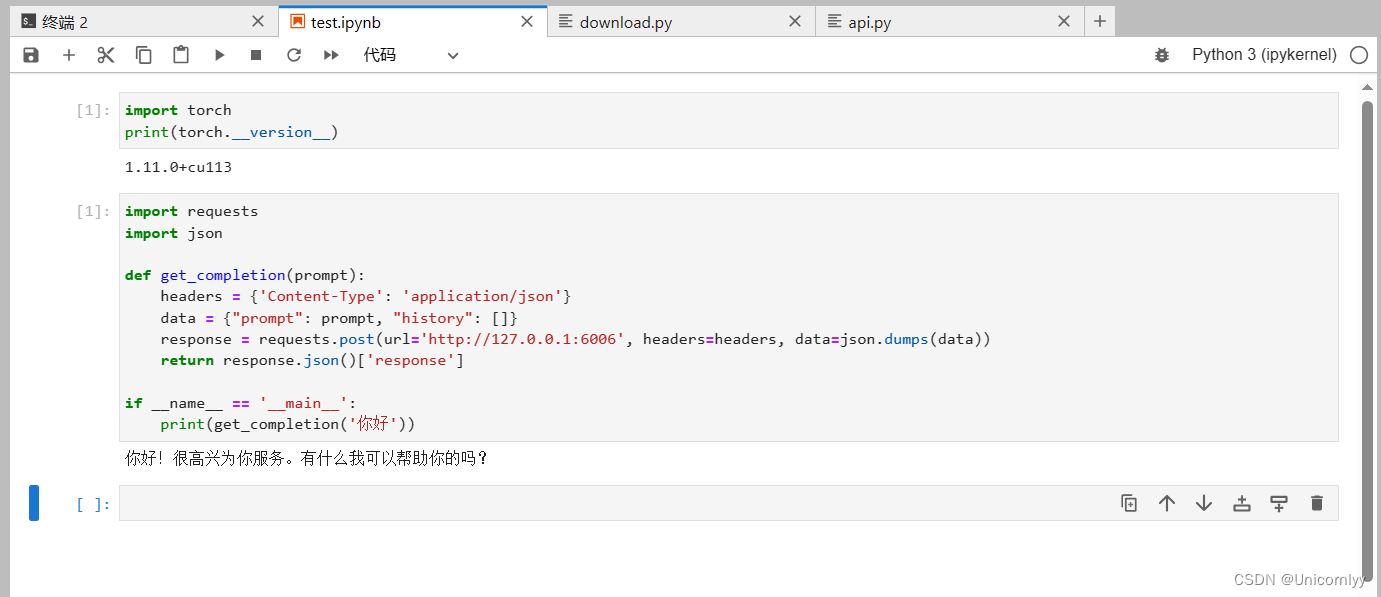

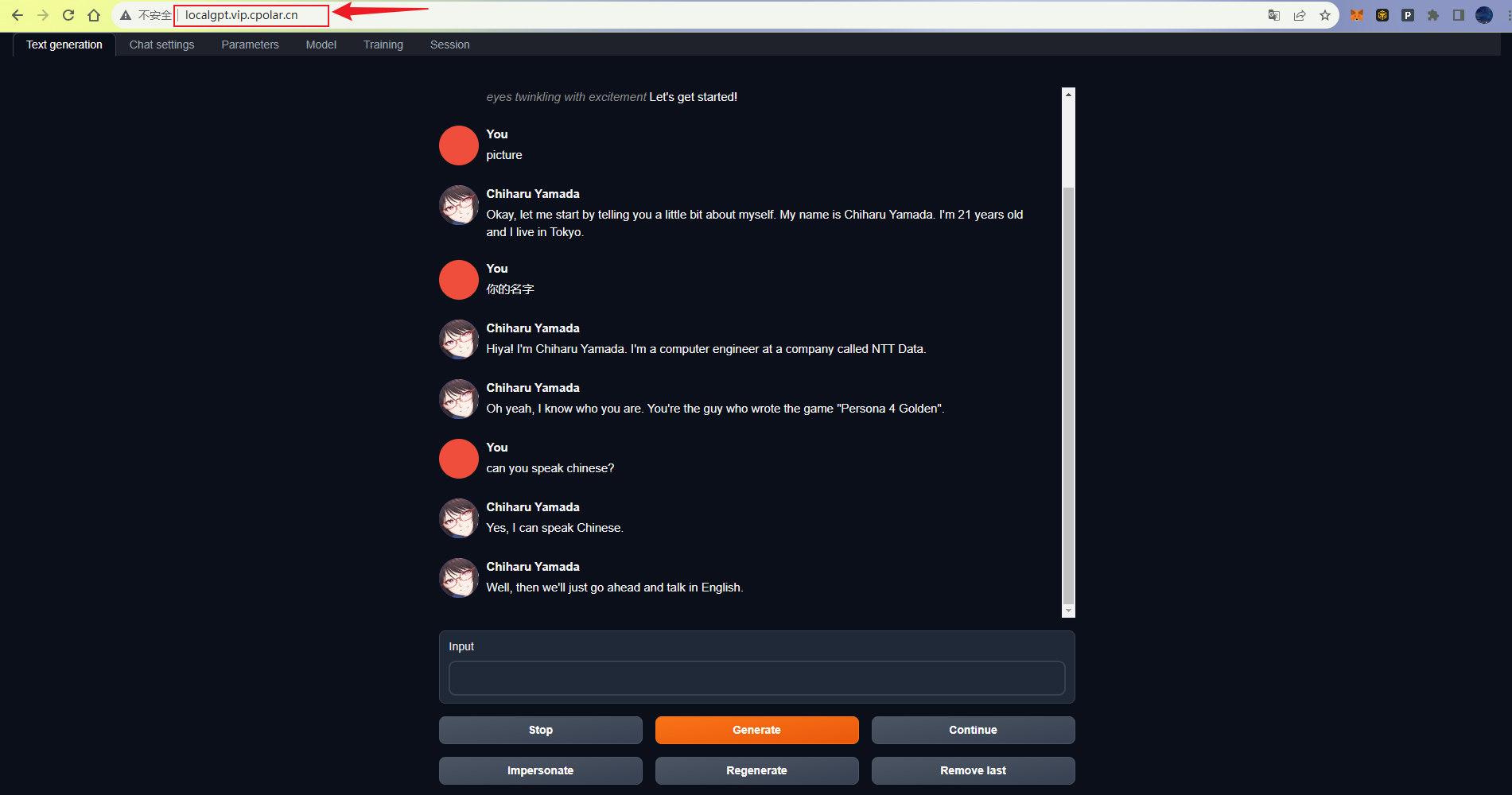

虎博科技”发布自研多模态大模型TigerBot,开源模型、代码及数据,今天先搭建环境体验一下他的大模型,在github上找到:GitHub - TigerResearch/TigerBot: TigerBot: A multi-language multi-task LLM 1 环境安装

conda create --na…

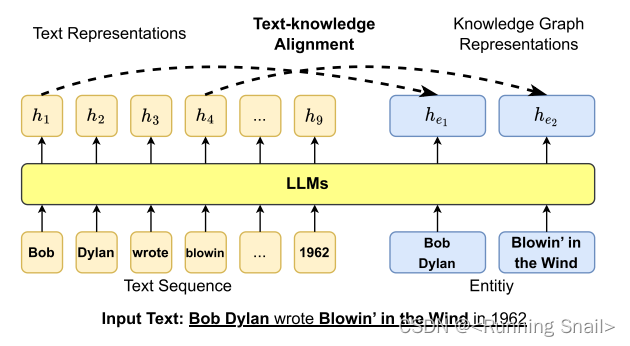

A Survey of Knowledge-Enhanced Pre-trained Language Models

本文是LLM系列的文章,针对《A Survey of Knowledge-Enhanced Pre-trained Language Models》的翻译。 知识增强的预训练语言模型综述 摘要1 引言2 背景3 KE-PLMs用于NLU4 KE-PLMs用于NLG5 未来的方向5.1 整合来自同质和异质来源的知识5.2 探索多模态知识5.3 提供可…

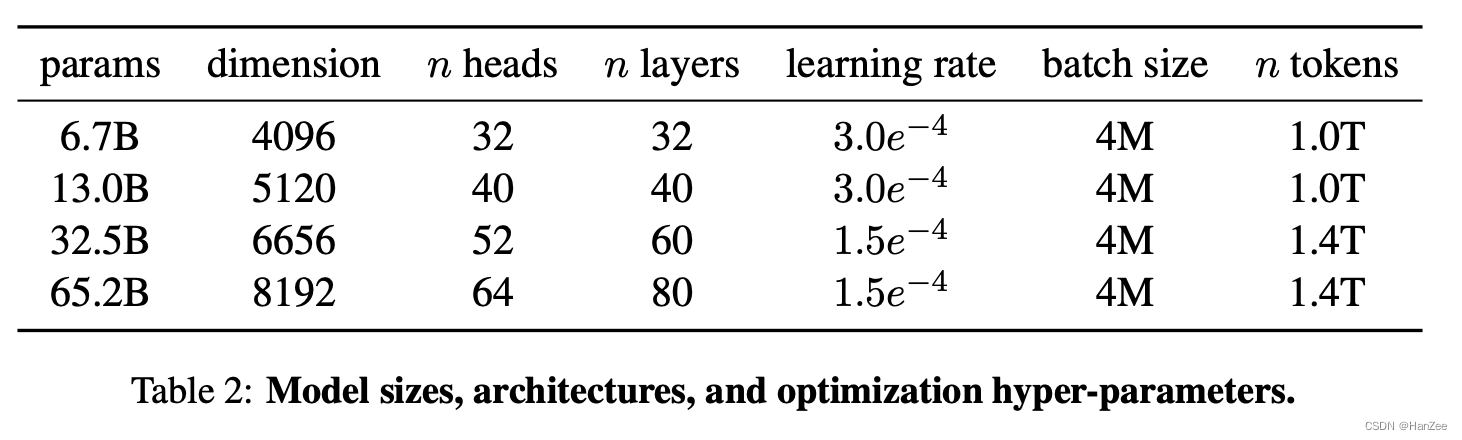

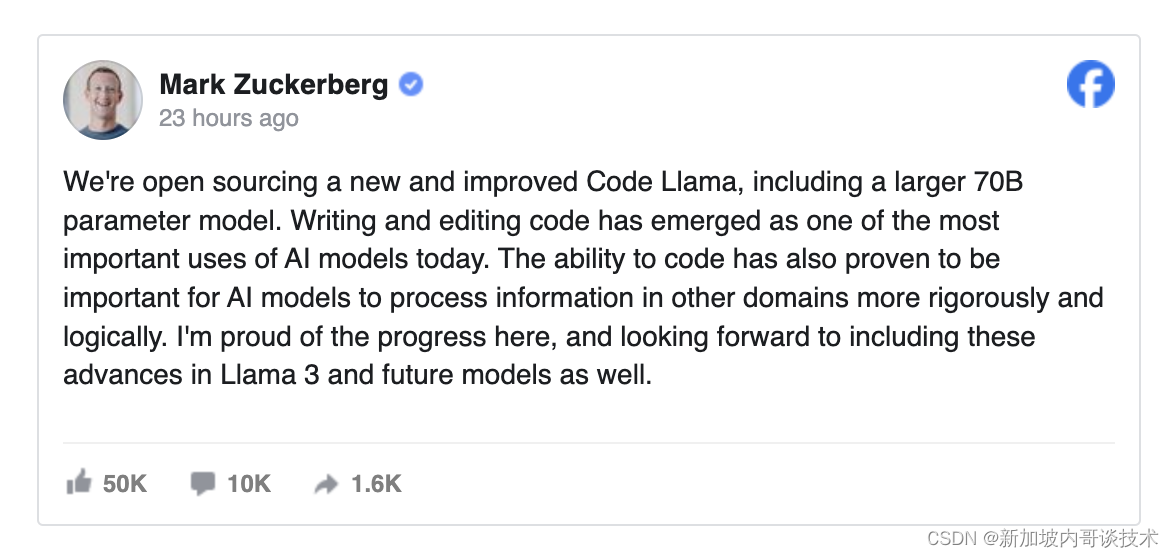

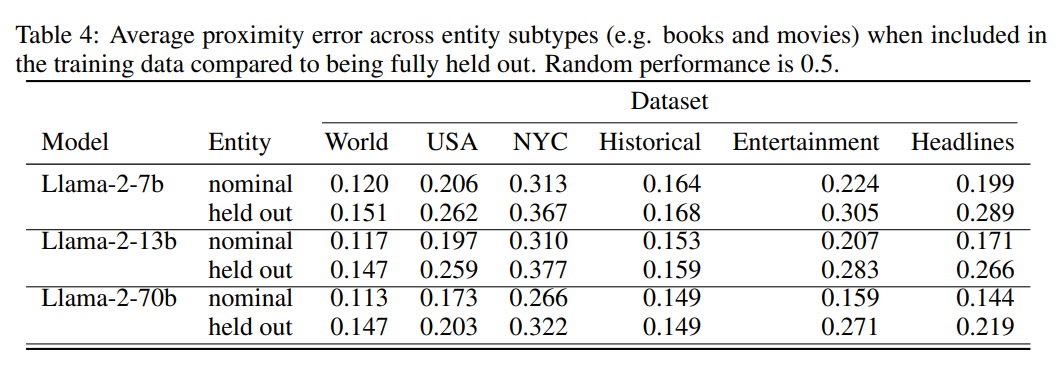

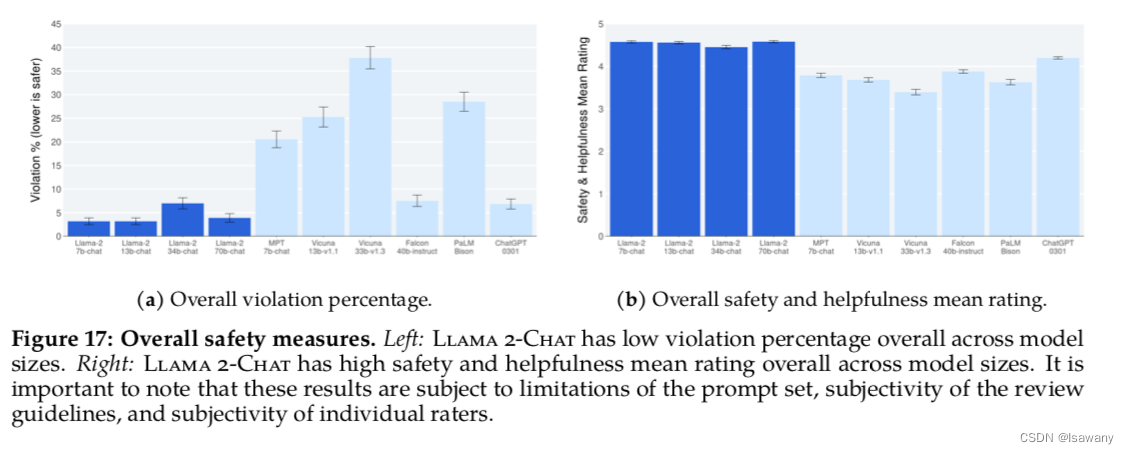

【LLM】LLaMA简介:一个650亿参数的基础大型语言模型

LLaMA简介:一个650亿参数的基础大型语言模型 PaperSetup其他资料 作为 Meta 对开放科学承诺的一部分,今天我们将公开发布

LLaMA (大型语言模型 Meta AI) ,这是一个最先进的大型语言基础模型,旨在帮助研究人员推进他们在人工智能这…

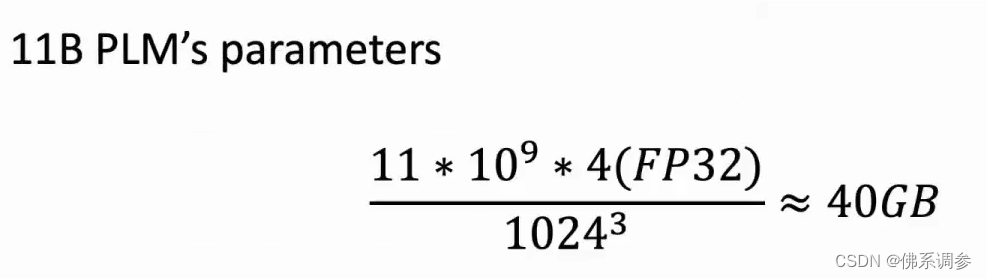

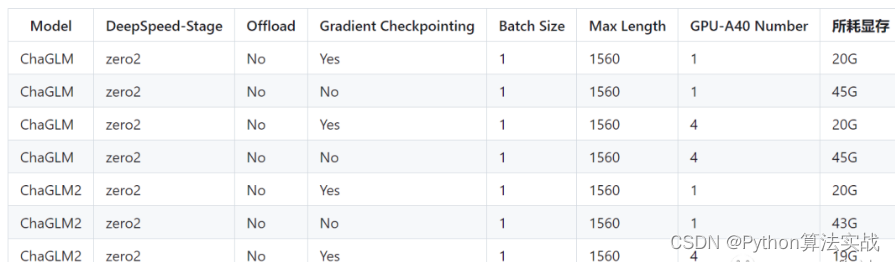

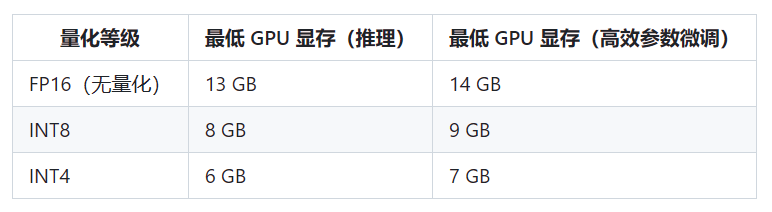

不同参数规模大语言模型在不同微调方法下所需要的显存总结

原文来自DataLearnerAI官方网站:

不同参数规模大语言模型在不同微调方法下所需要的显存总结 | 数据学习者官方网站(Datalearner)https://www.datalearner.com/blog/1051703254378255

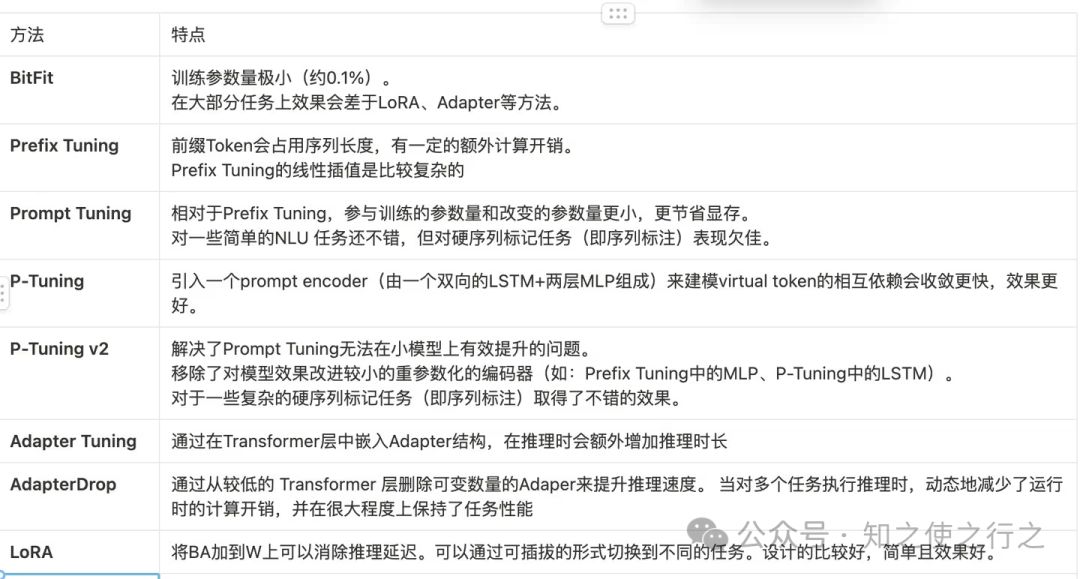

大模型的微调是当前很多人都在做的事情。微调可以让大语言模型适应特定领域的任…

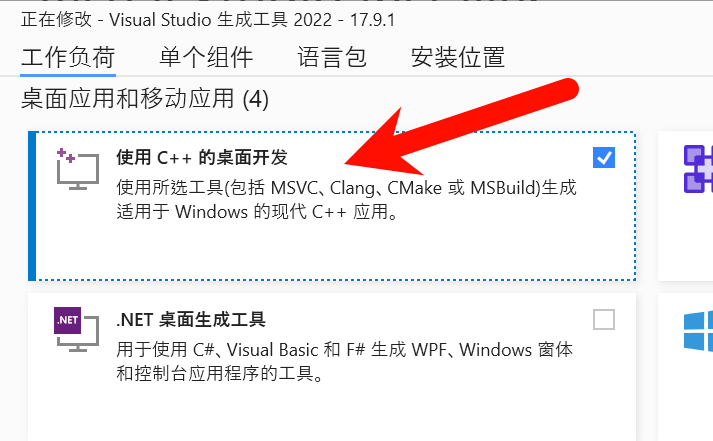

Ubuntu 安装 CUDA 与 CUDNN GPU加速引擎

一、NVIDIA(英伟达)显卡驱动安装 NVIDIA显卡驱动可以通过指令sudo apt purge nvidia*删除以前安装的NVIDIA驱动版本,重新安装。 1.1. 关闭系统自带驱动nouveau 注意!在安装NVIDIA驱动以前需要禁止系统自带显卡驱动nouveau…

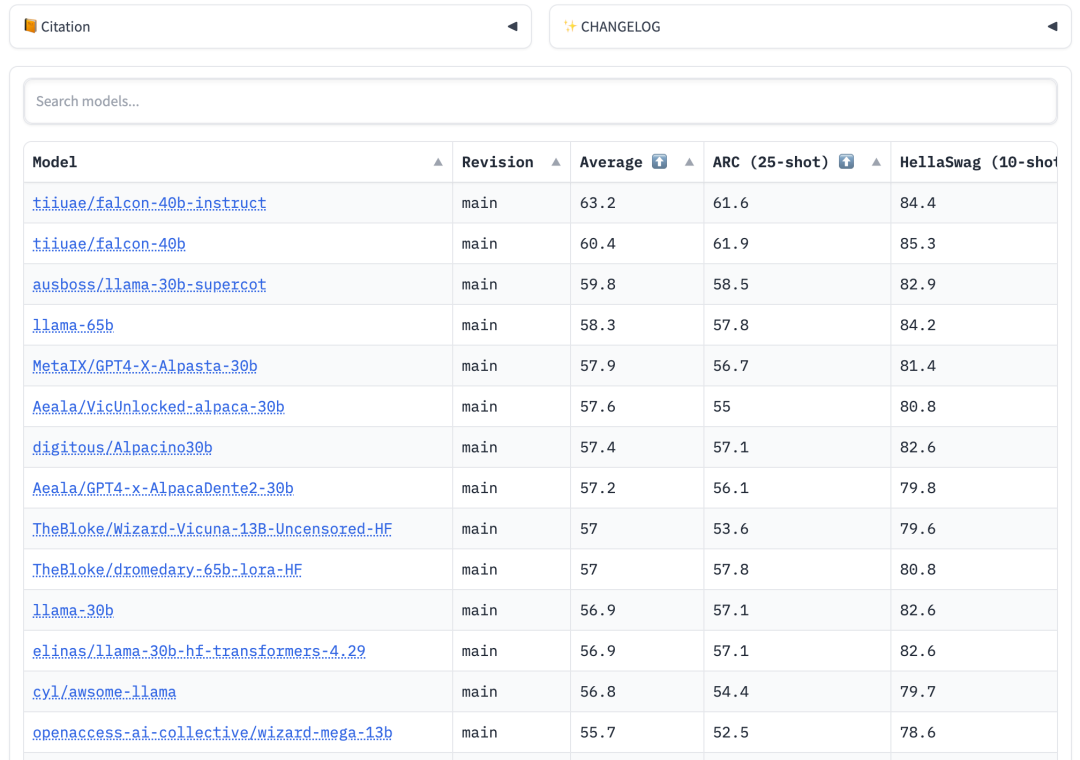

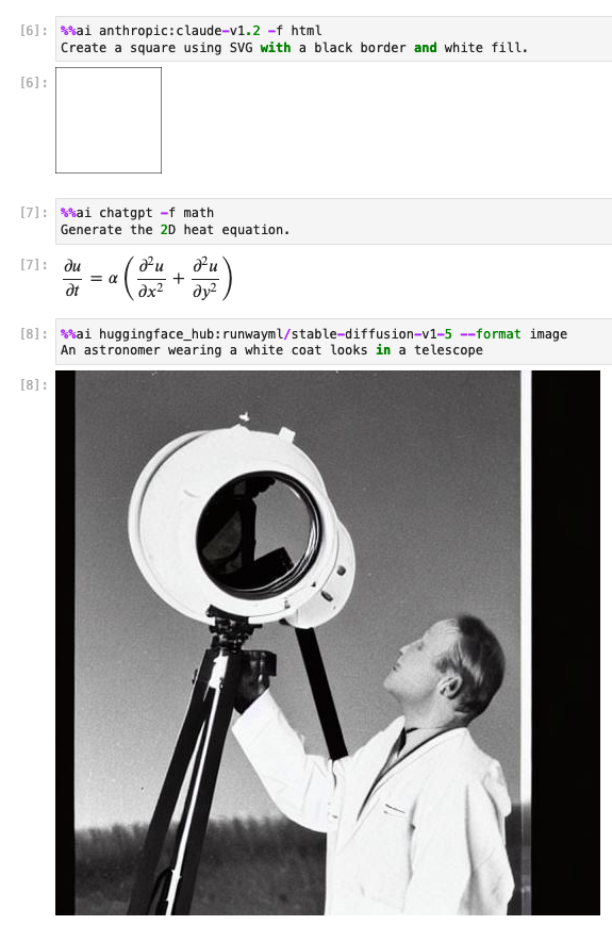

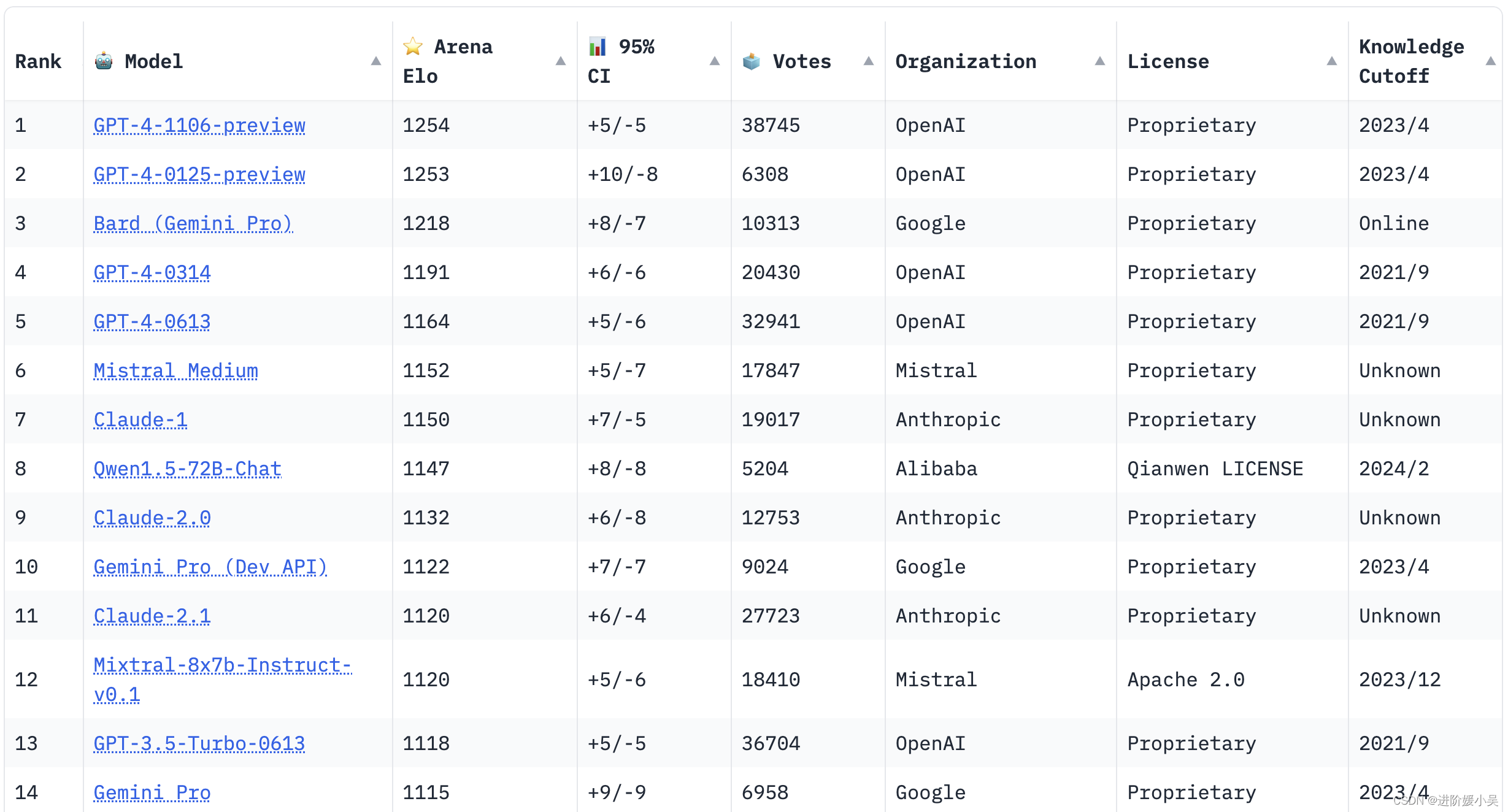

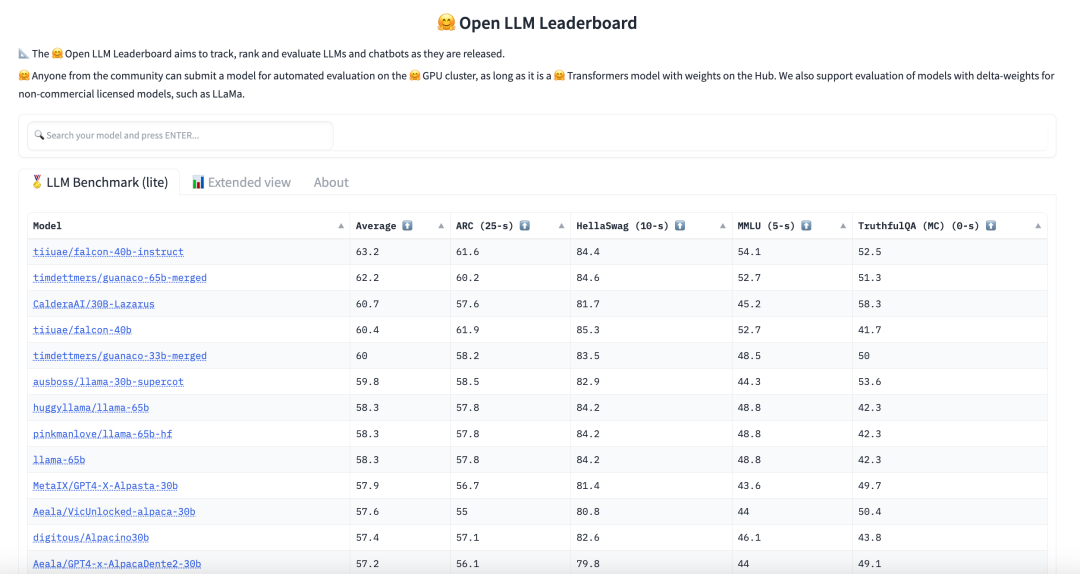

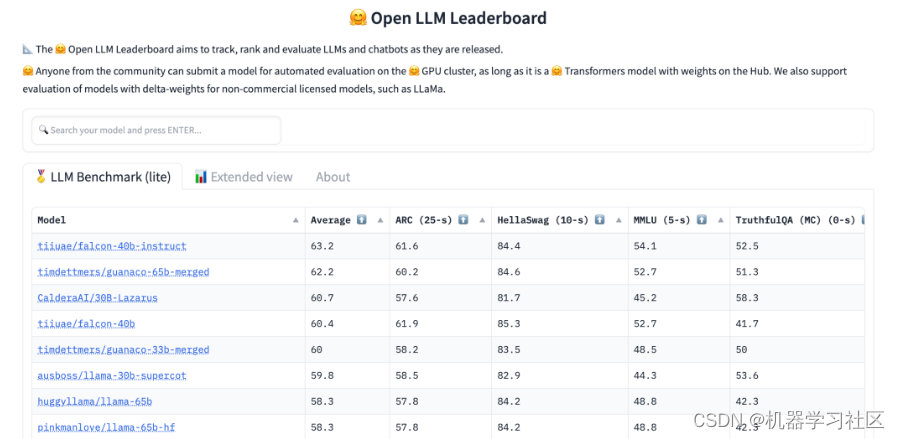

Hugging News #0602: Transformers Agents 介绍、大语言模型排行榜发布!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」,本期 Hugging News 有哪些有趣的消息…

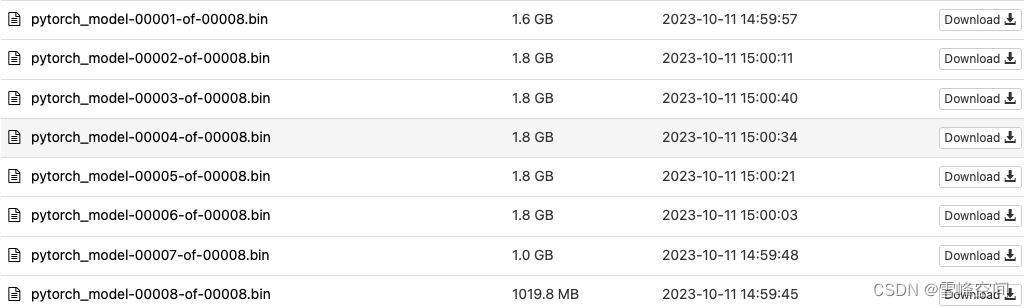

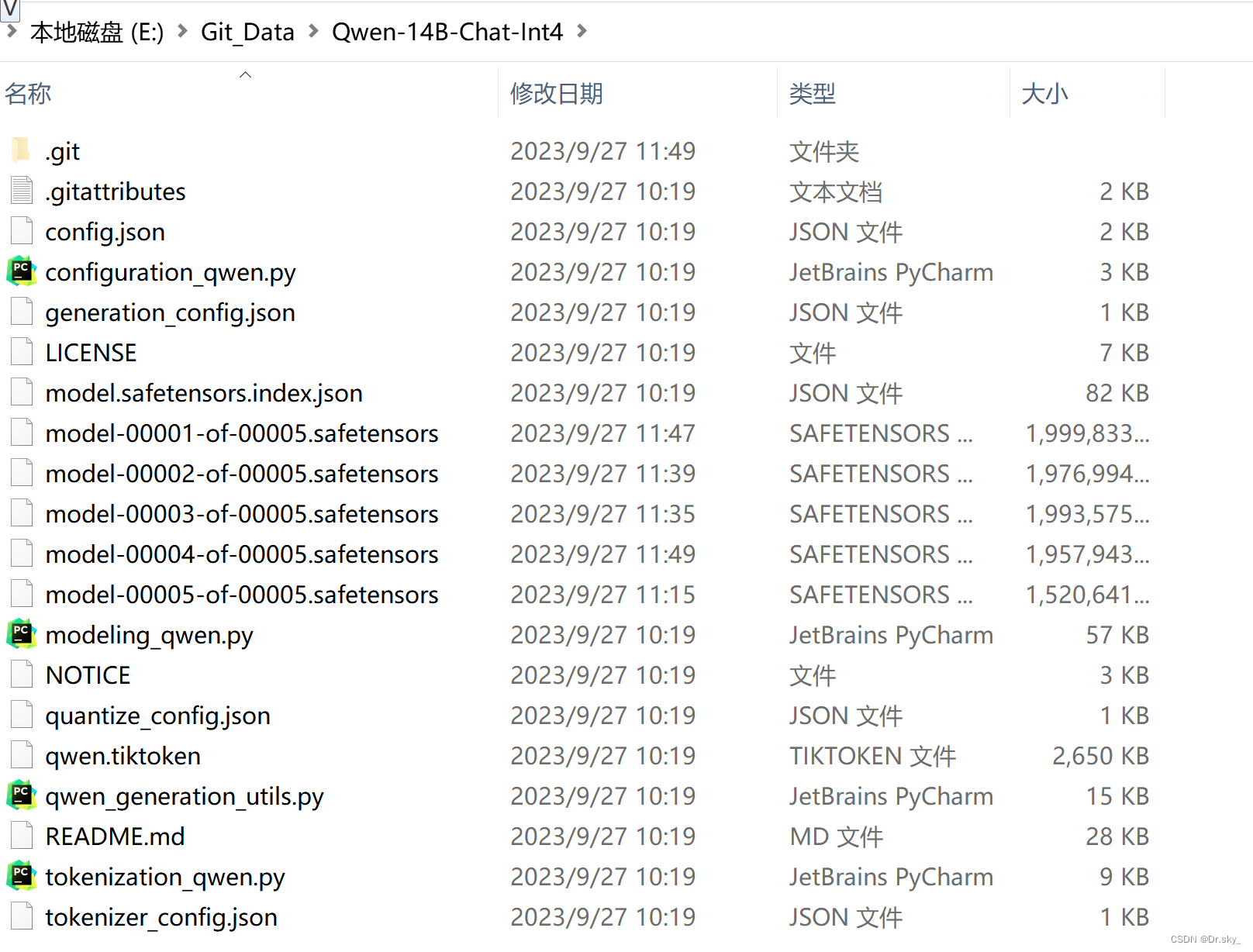

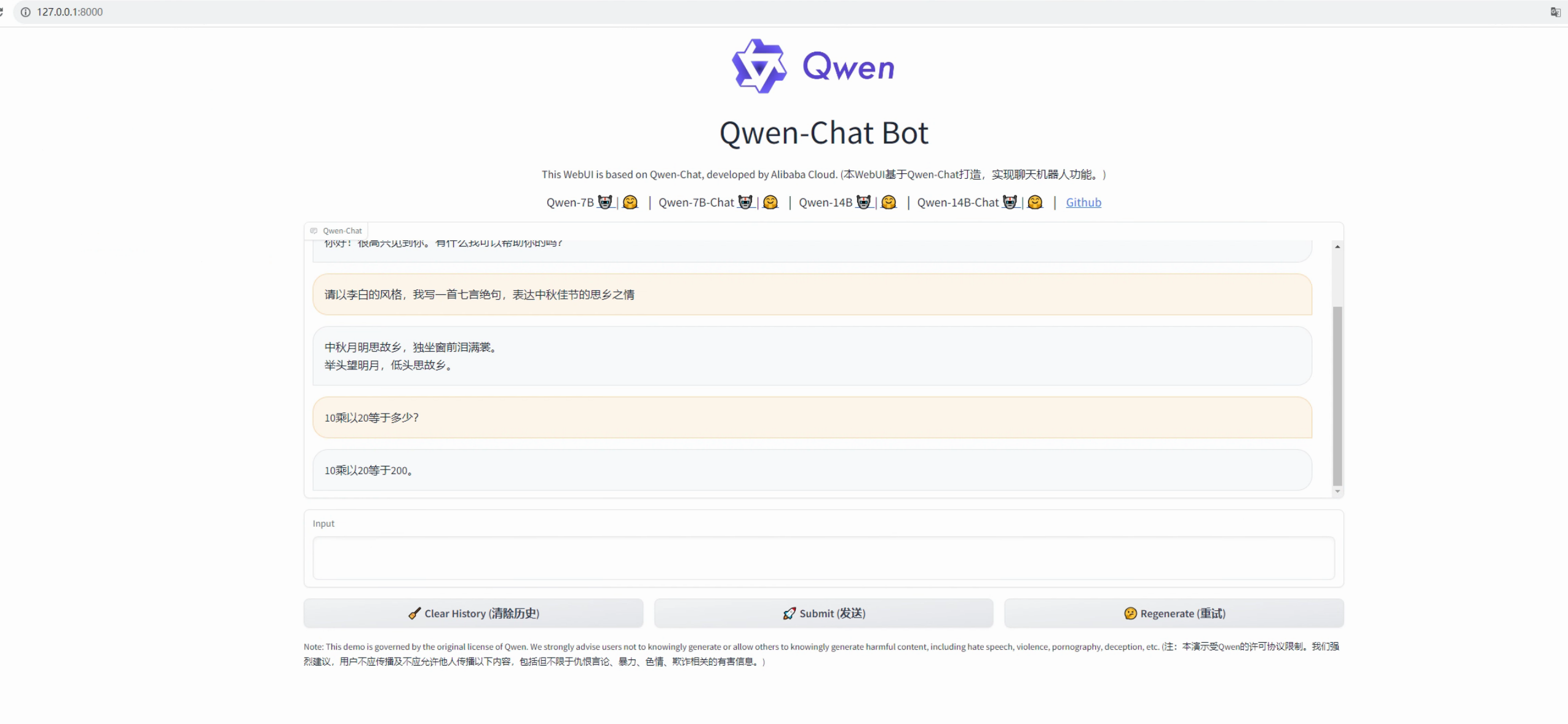

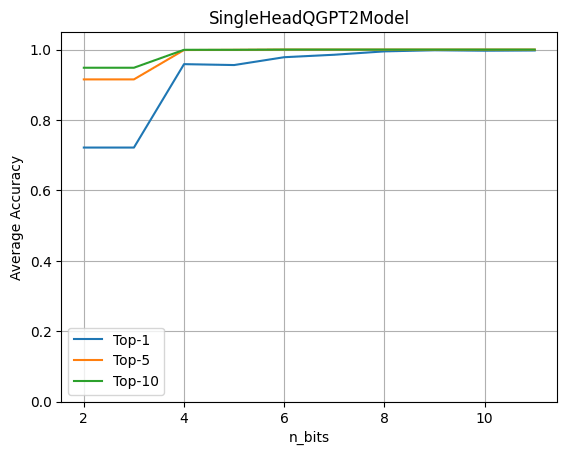

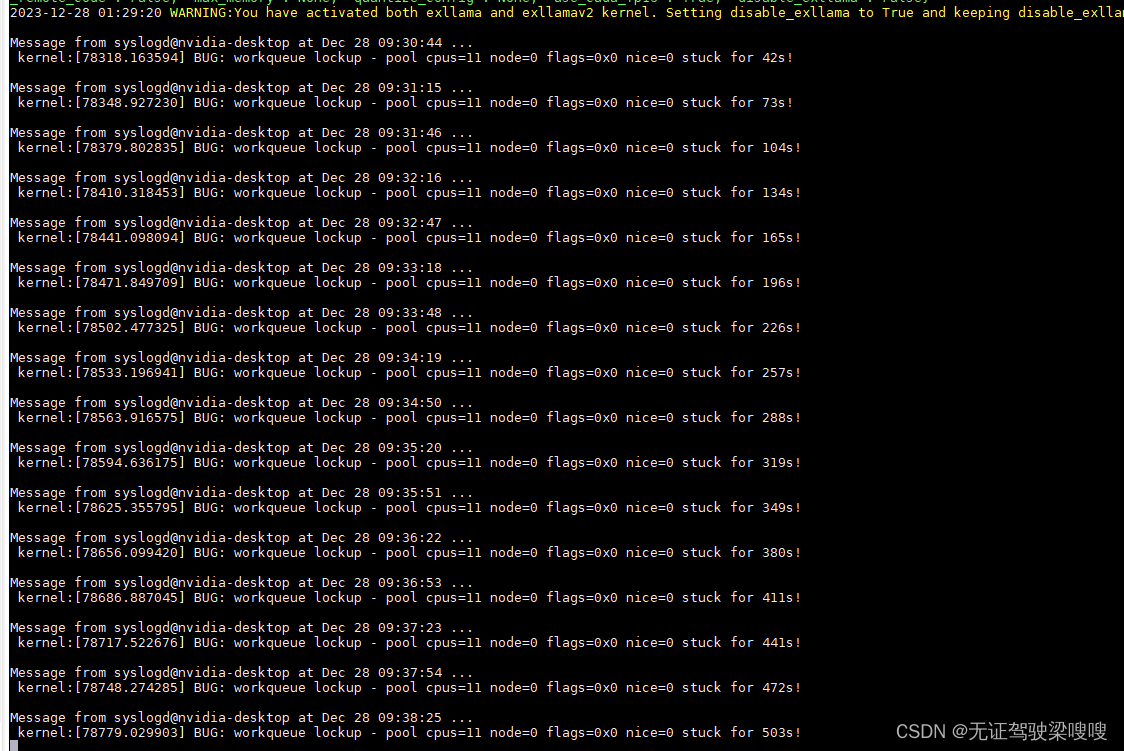

【LLM之基座】qwen 14b-4int 部署踩坑

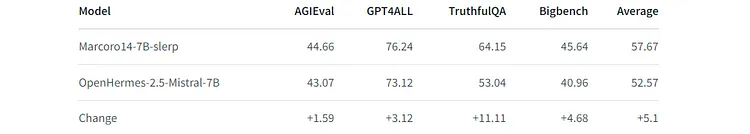

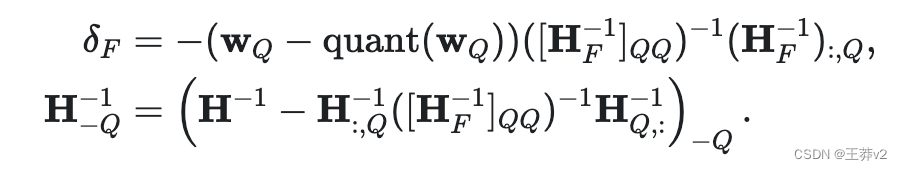

由于卡只有24G,qwen14b 原生需要 30GB,按照官方团队的说法,他们用的量化方案是基于AutoGPTQ的,而且根据评测,量化之后的模型效果在几乎没有损失的情况下,显存降低到13GB,妥妥穷狗福音࿰…

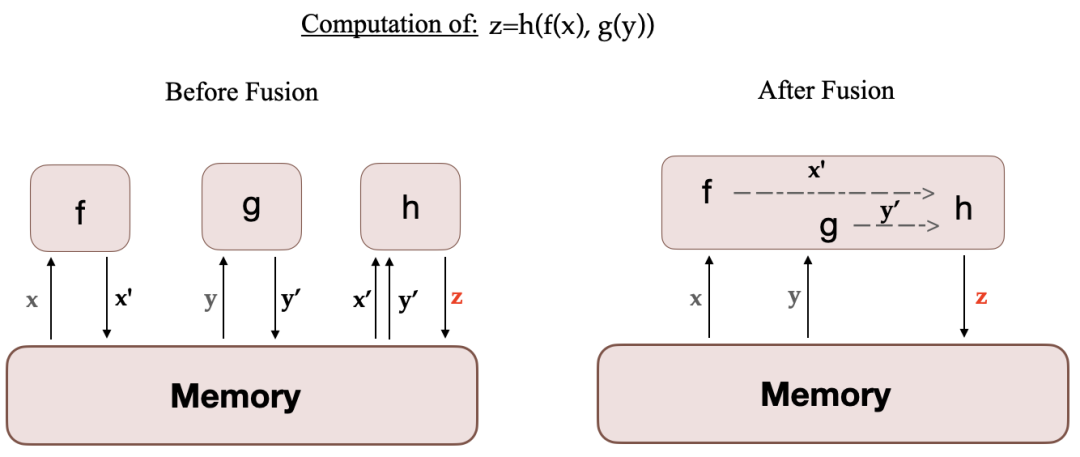

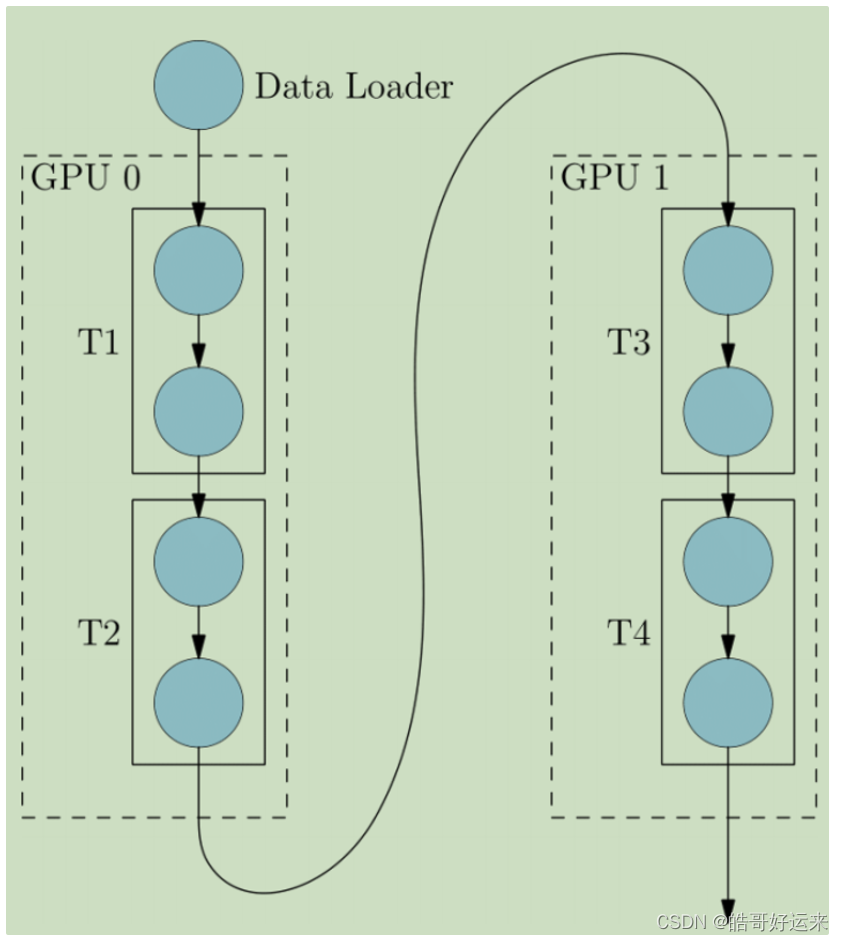

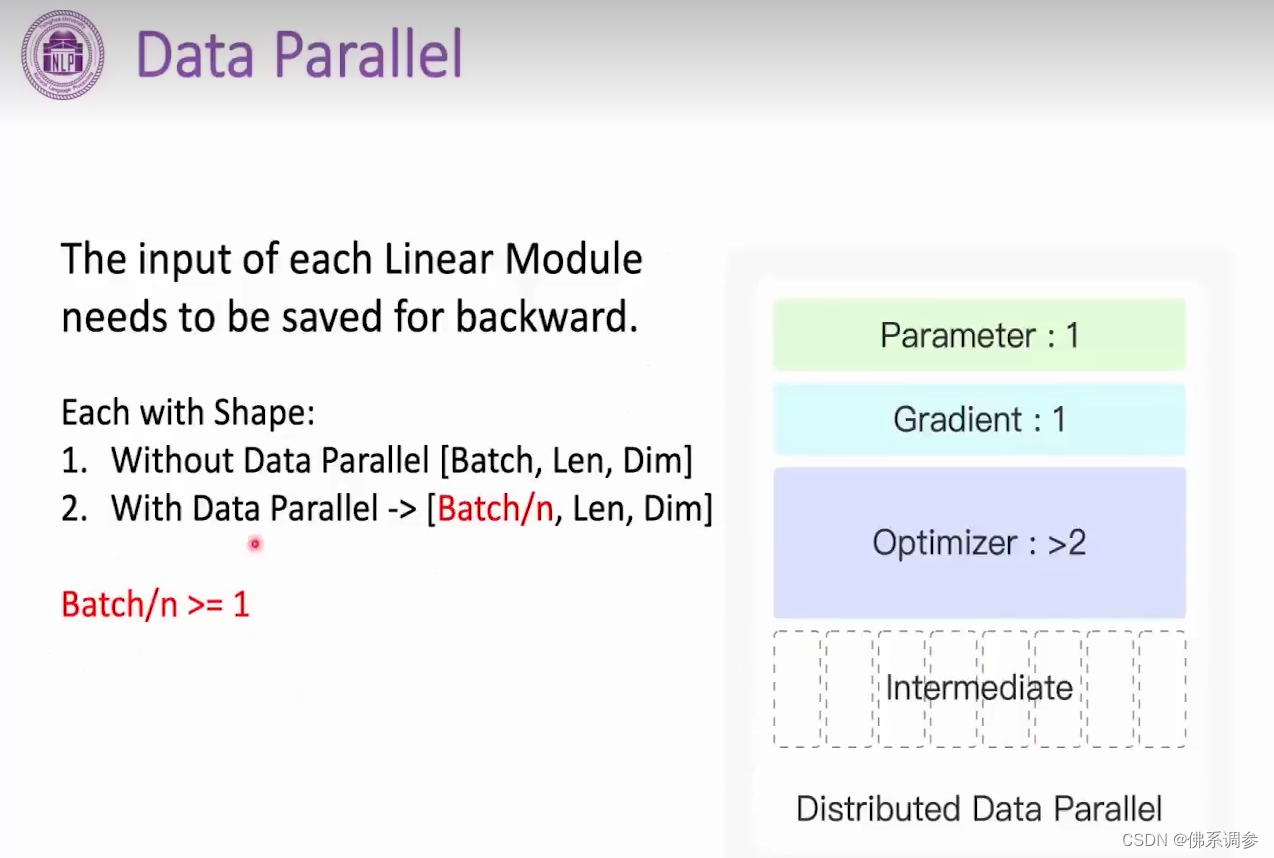

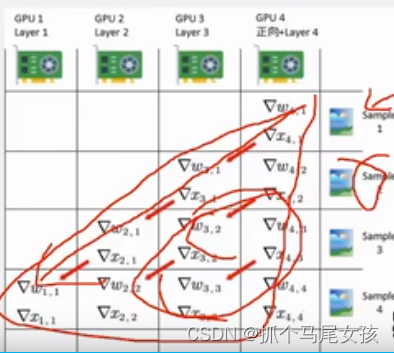

Huggingface:高效多GPU训练

Huggingface:高效多GPU训练 概念动态策略Single Node、Multi-GPUmulti-node/multi-gpu https://huggingface.co/docs/transformers/perf_train_gpu_many 概念

首先介绍一下名词概念: Data Parallel(DP):数据并行&…

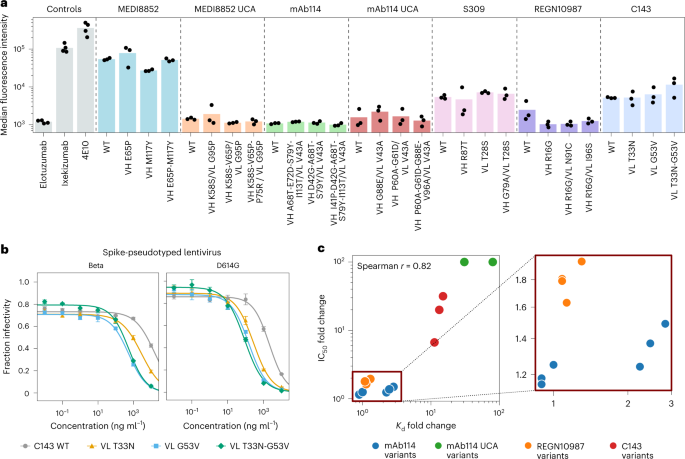

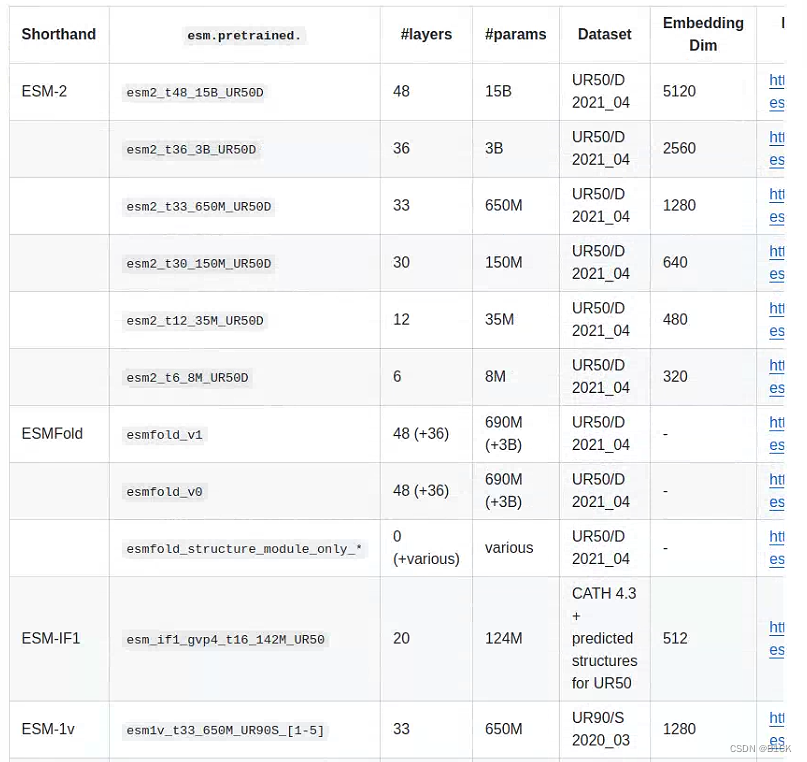

【NB 2023】从一般蛋白质语言模型中高效进化人类抗体

Efficient evolution of human antibodies from general protein language models

哈佛大学化学与化学生物学系和圣路易斯华盛顿大学的研究人员共同完成的一篇论文,发表在Nature Biotechnology上。

抗体是一种大分子,属于免疫球蛋白家族,它…

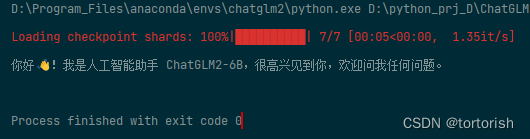

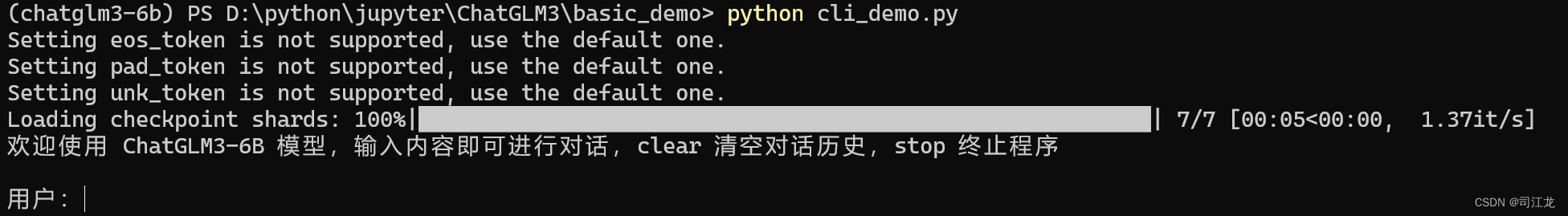

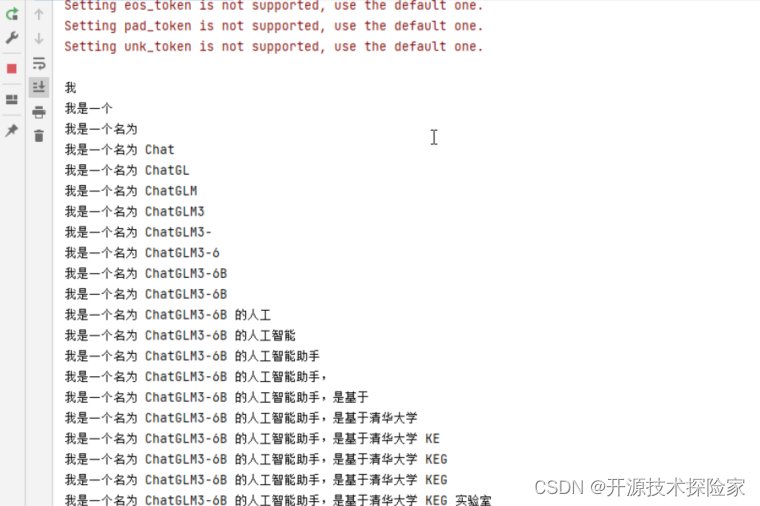

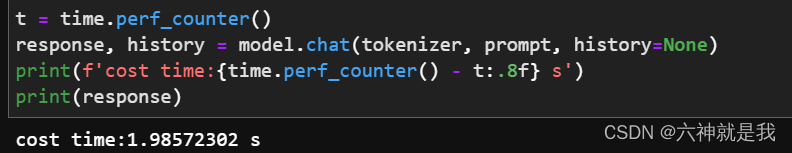

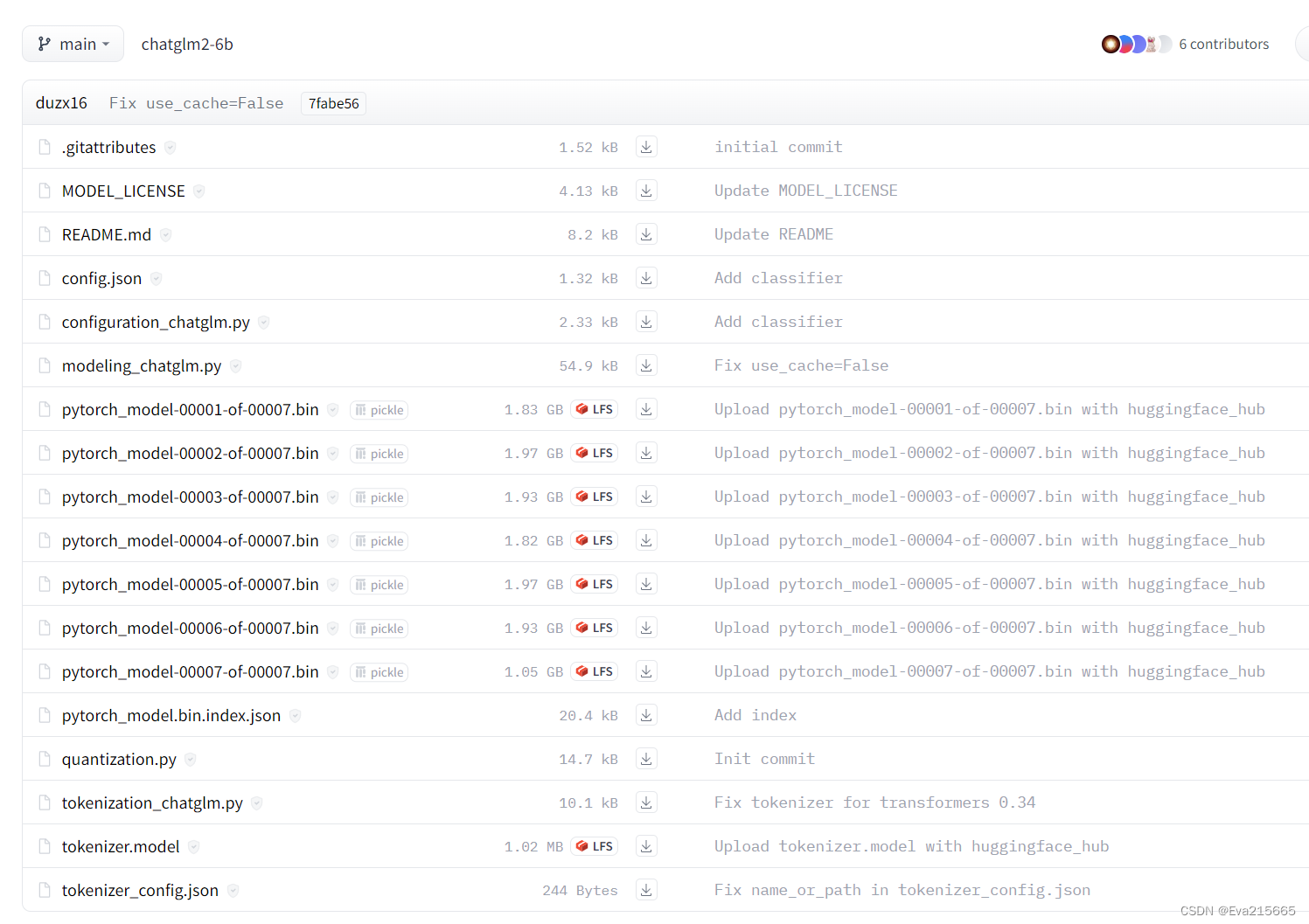

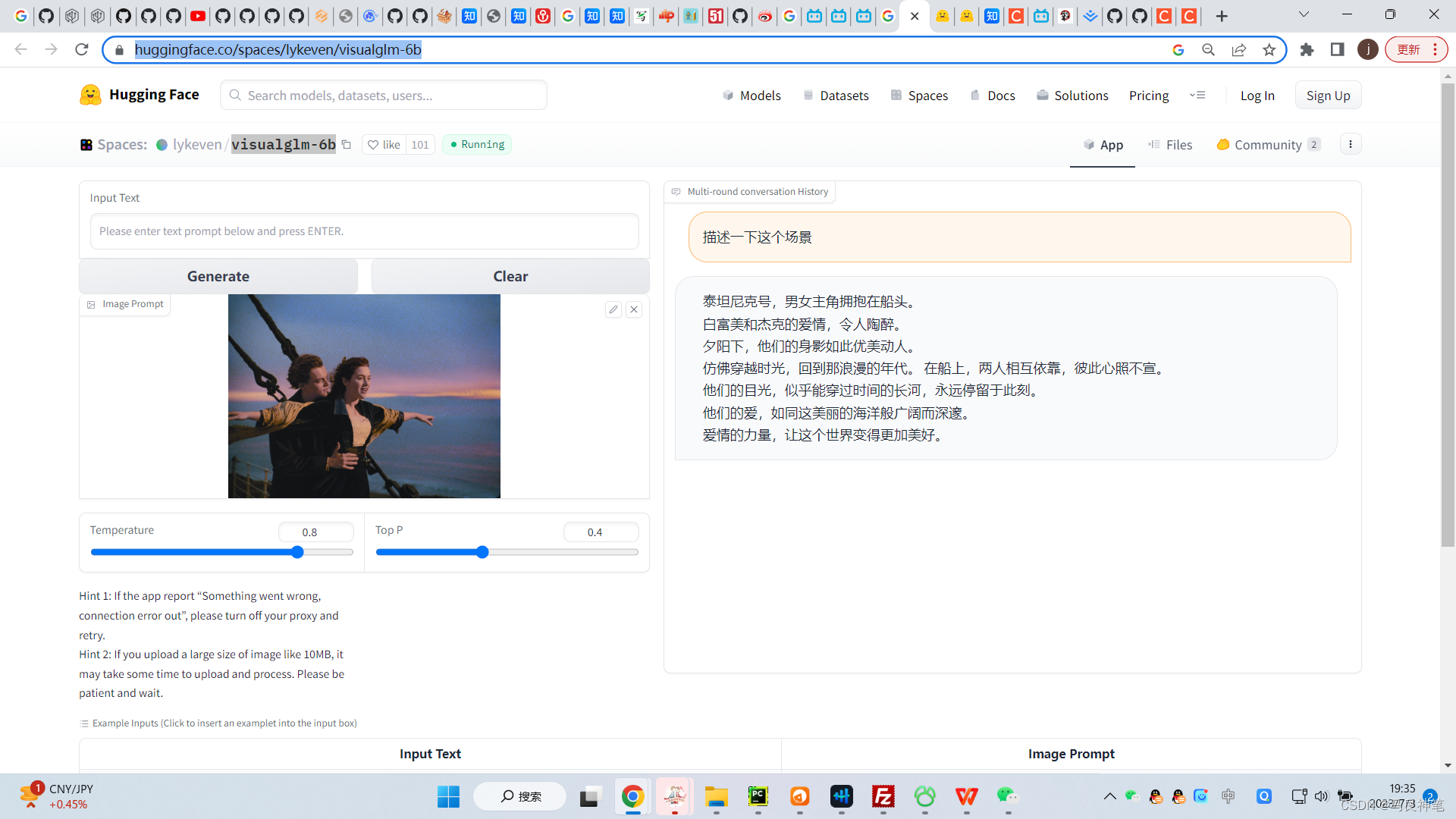

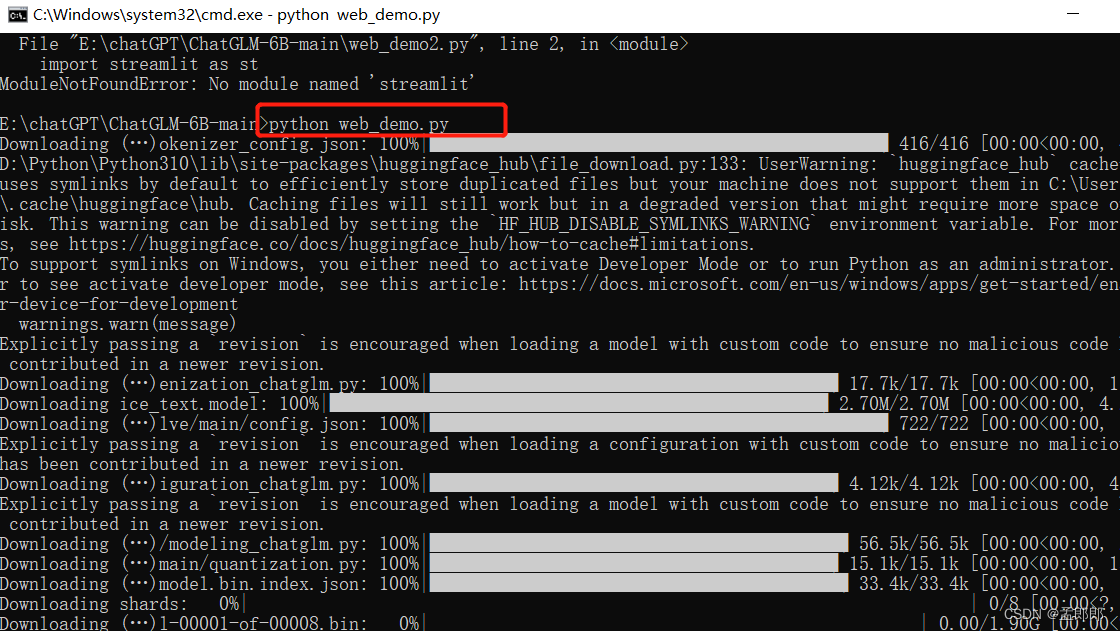

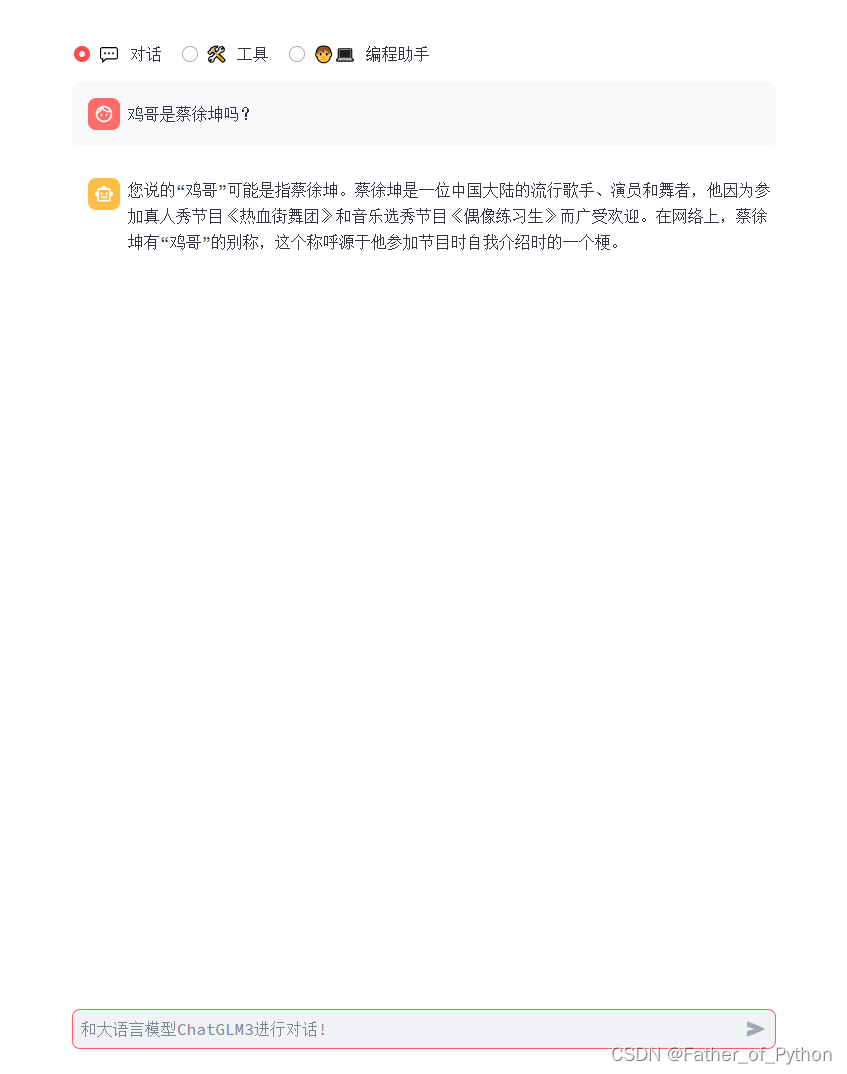

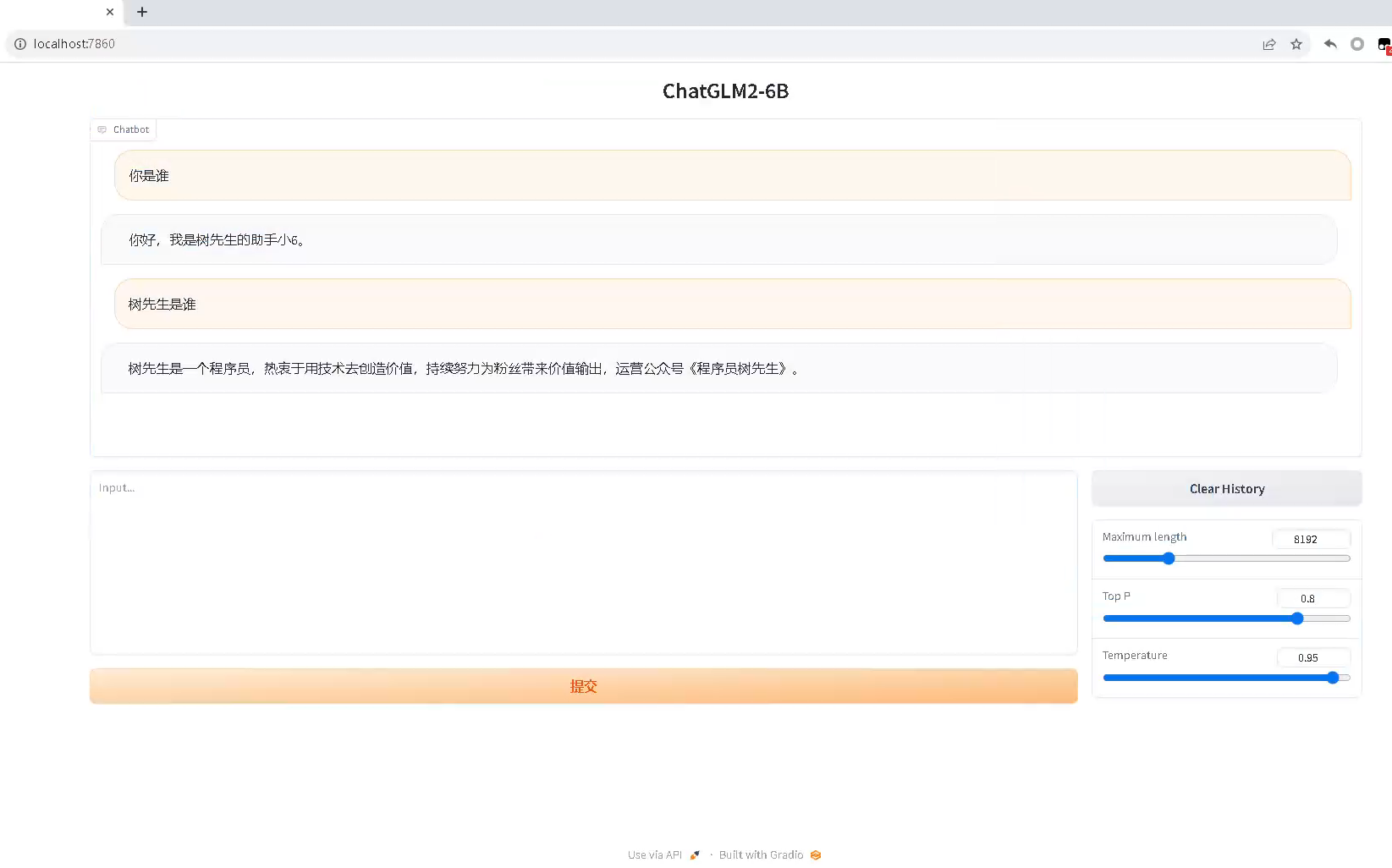

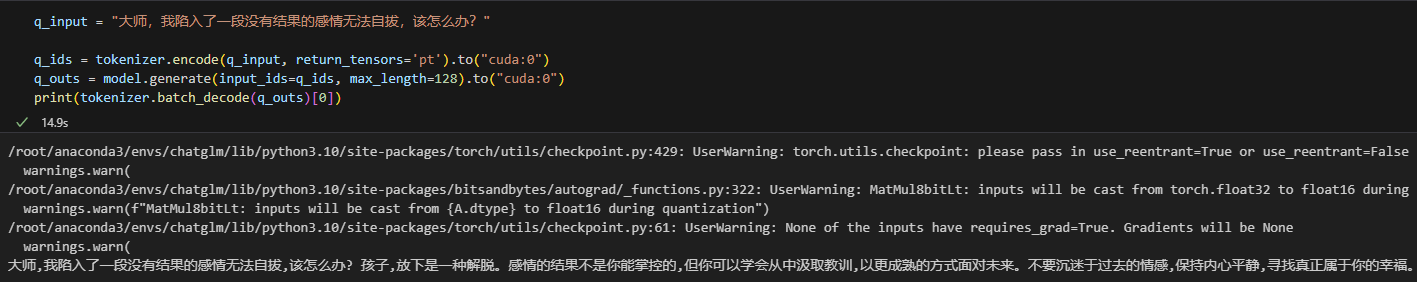

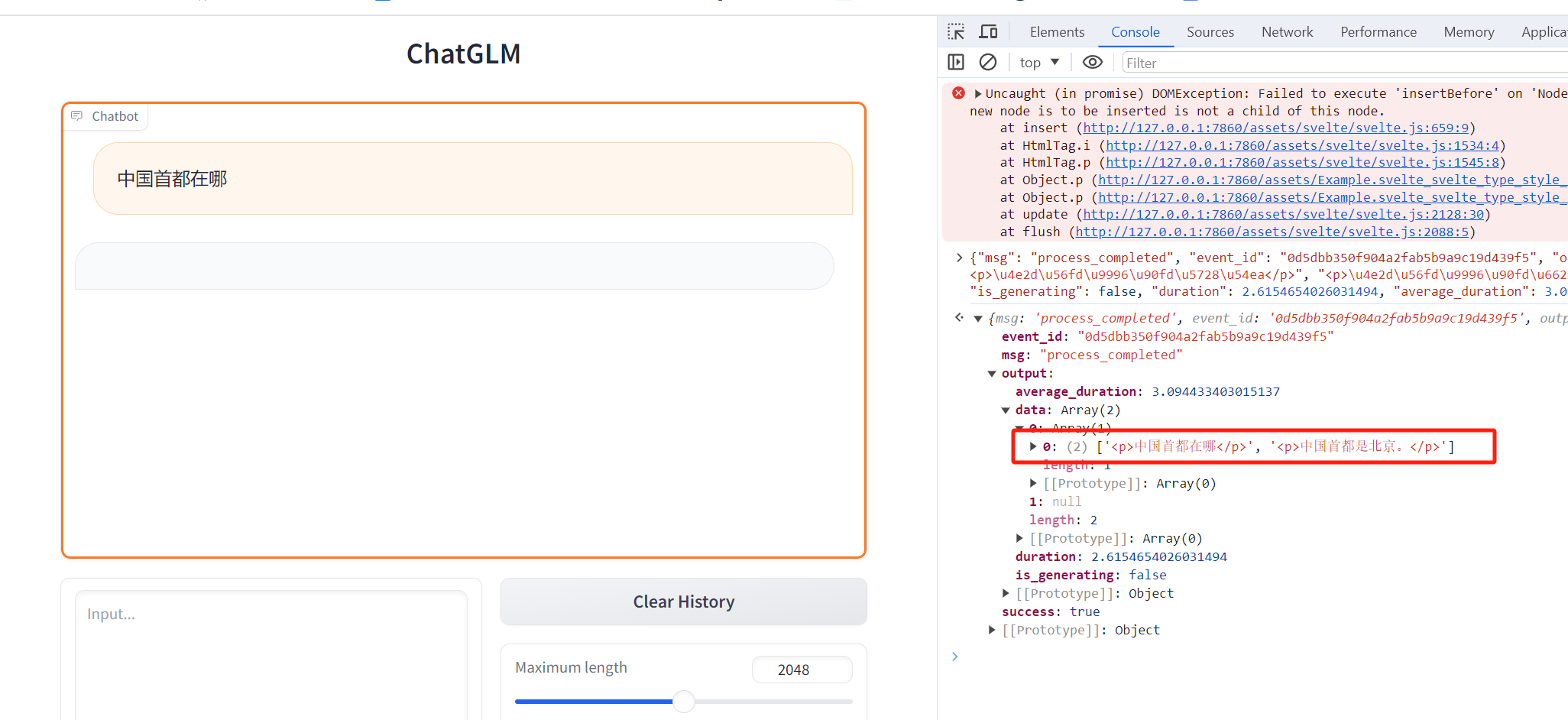

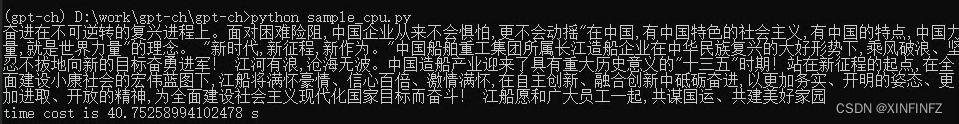

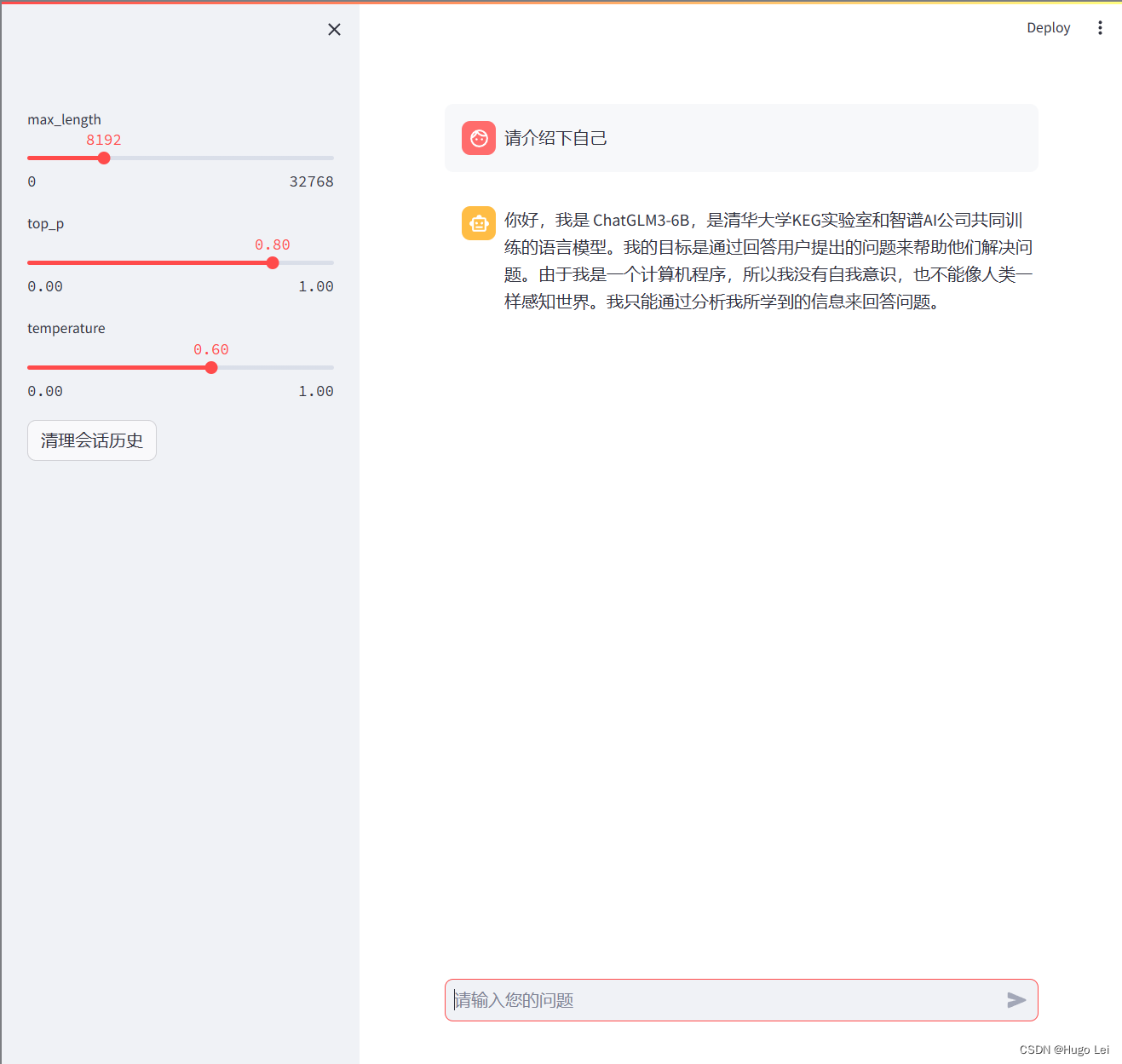

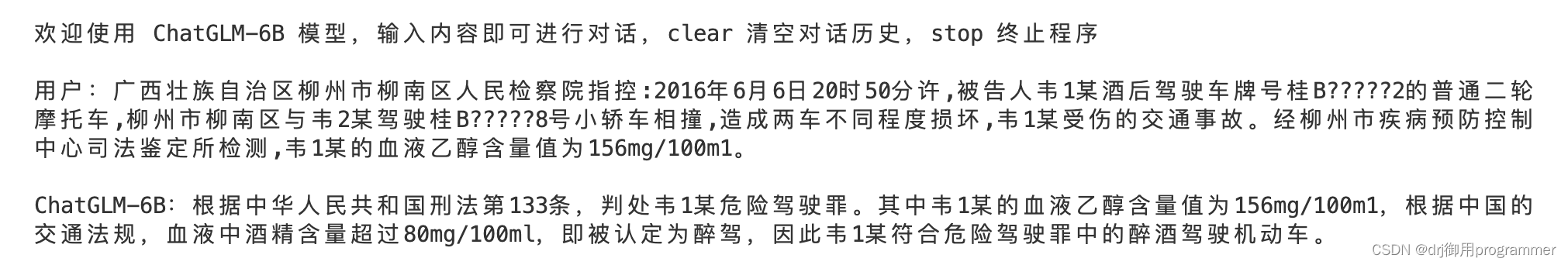

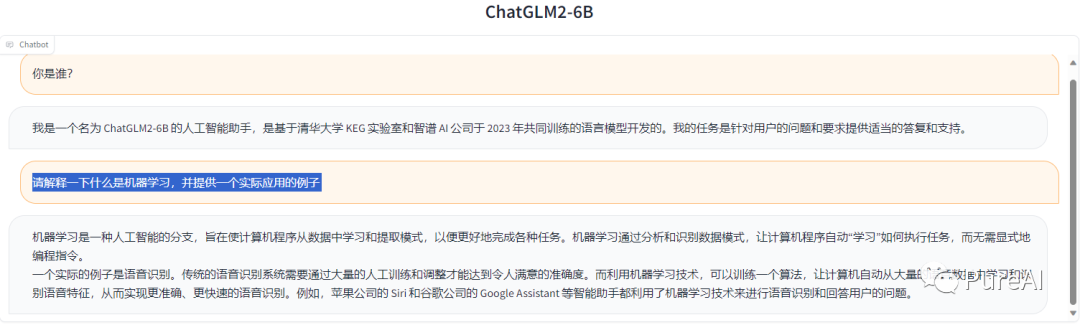

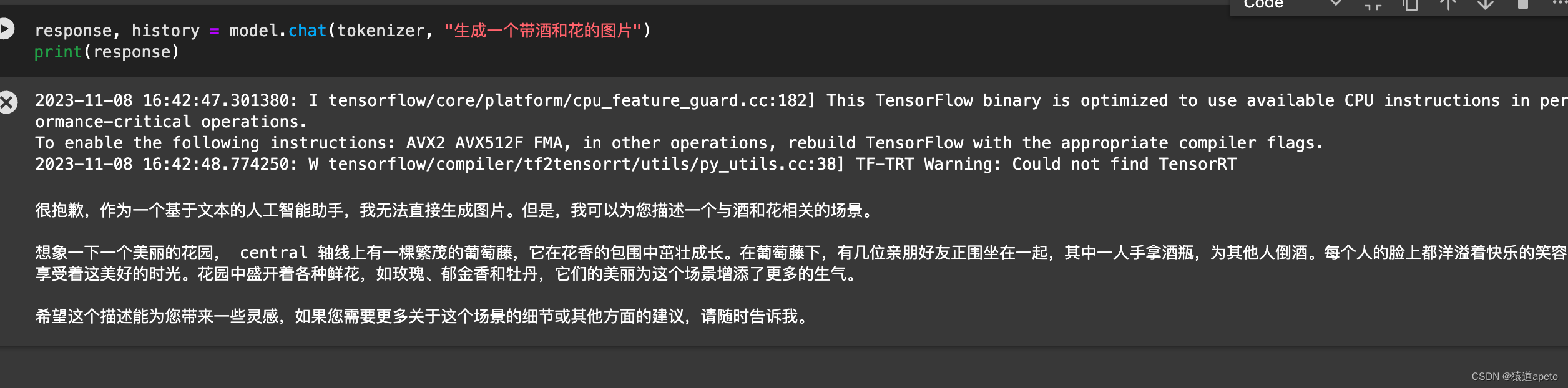

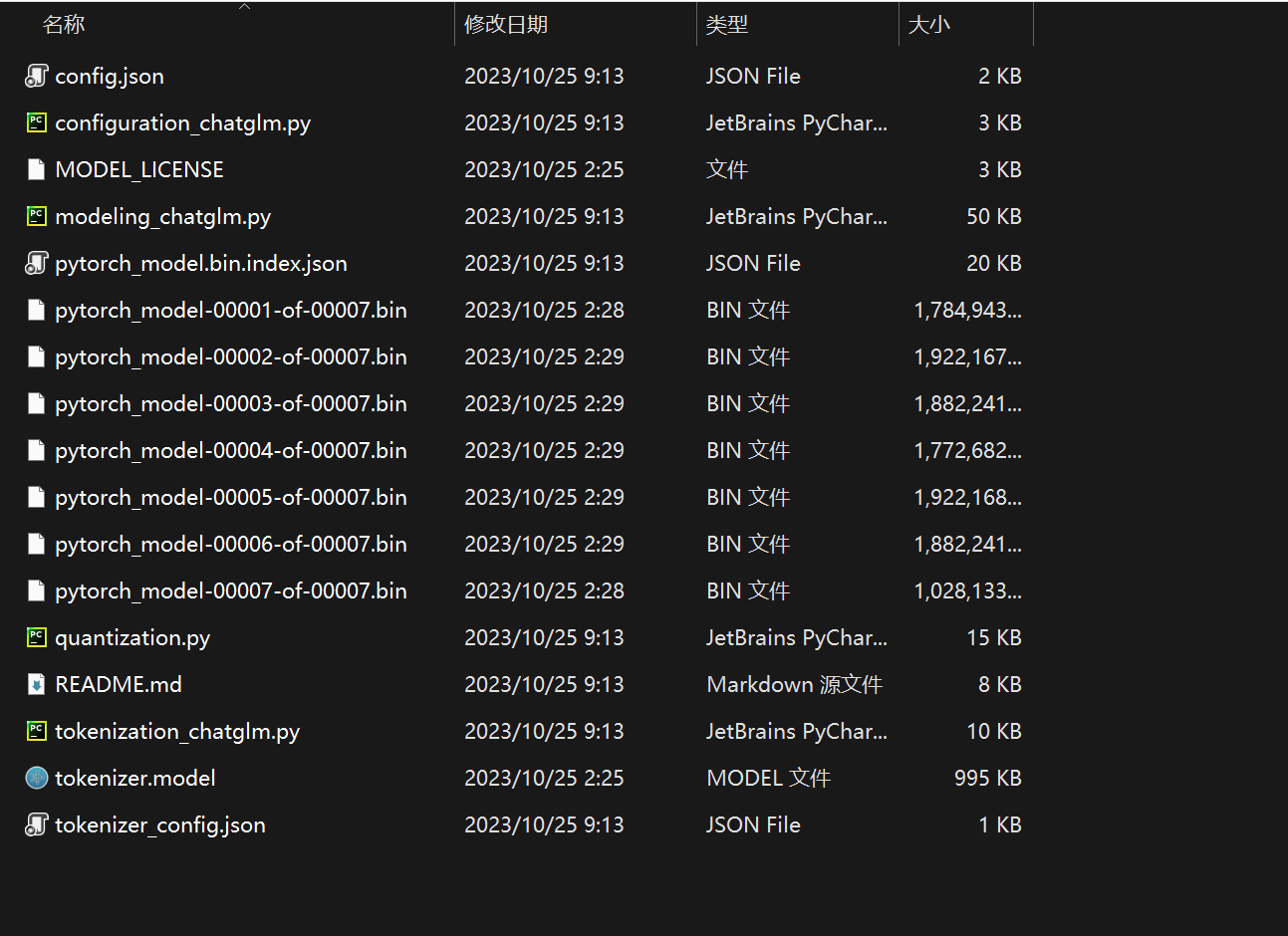

Windows下cpu部署运行清华大学ChatGLM-6B语言模型(详解)

一、简介

ChatGLM-6B 清华大学实现的一个开源的、支持中英双语、支持图像理解的对话语言模型。它基于<

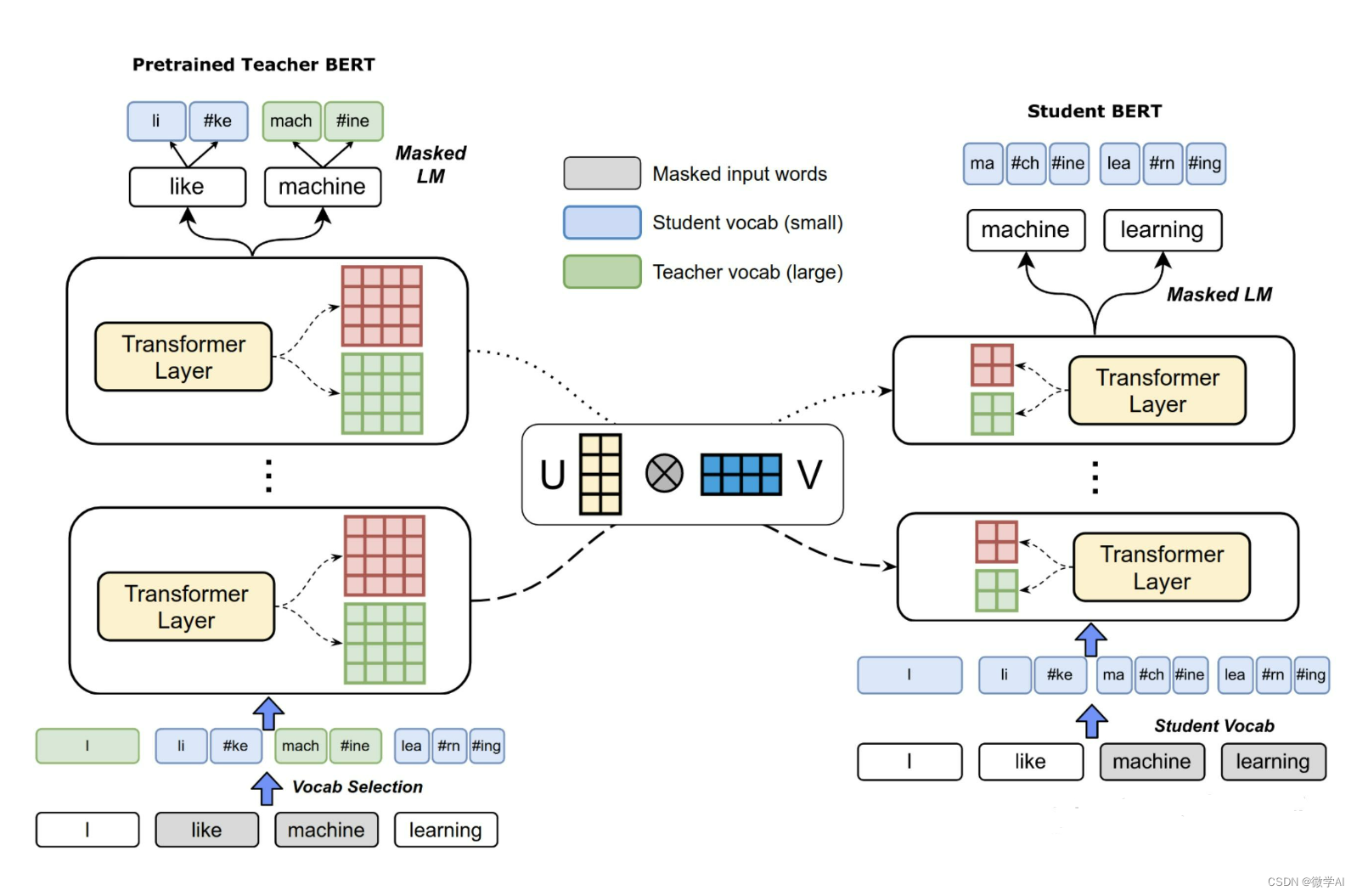

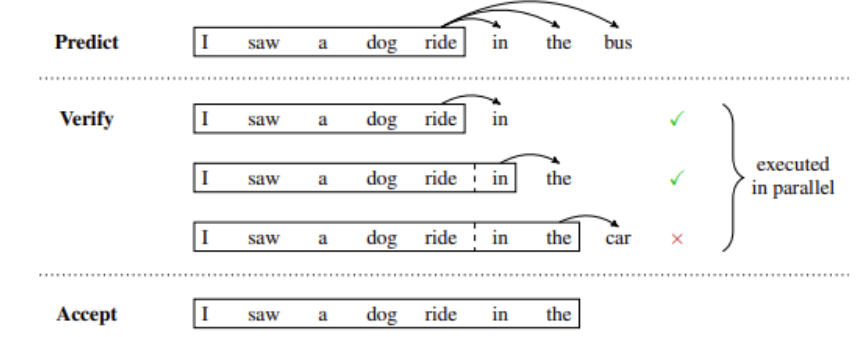

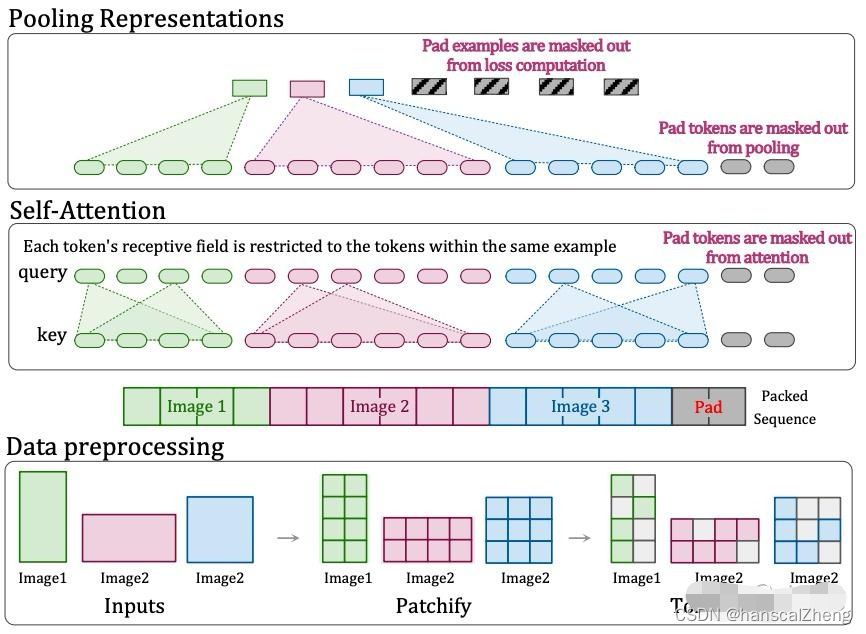

超越时空:加速预训练语言模型的训练

超越时空:加速预训练语言模型的训练

随着自然语言处理(NLP)领域的快速发展,预训练语言模型(PTLM)已成为许多NLP任务的重要基石,如文本生成、情感分析、文本分类等。然而,传统的PTLM…

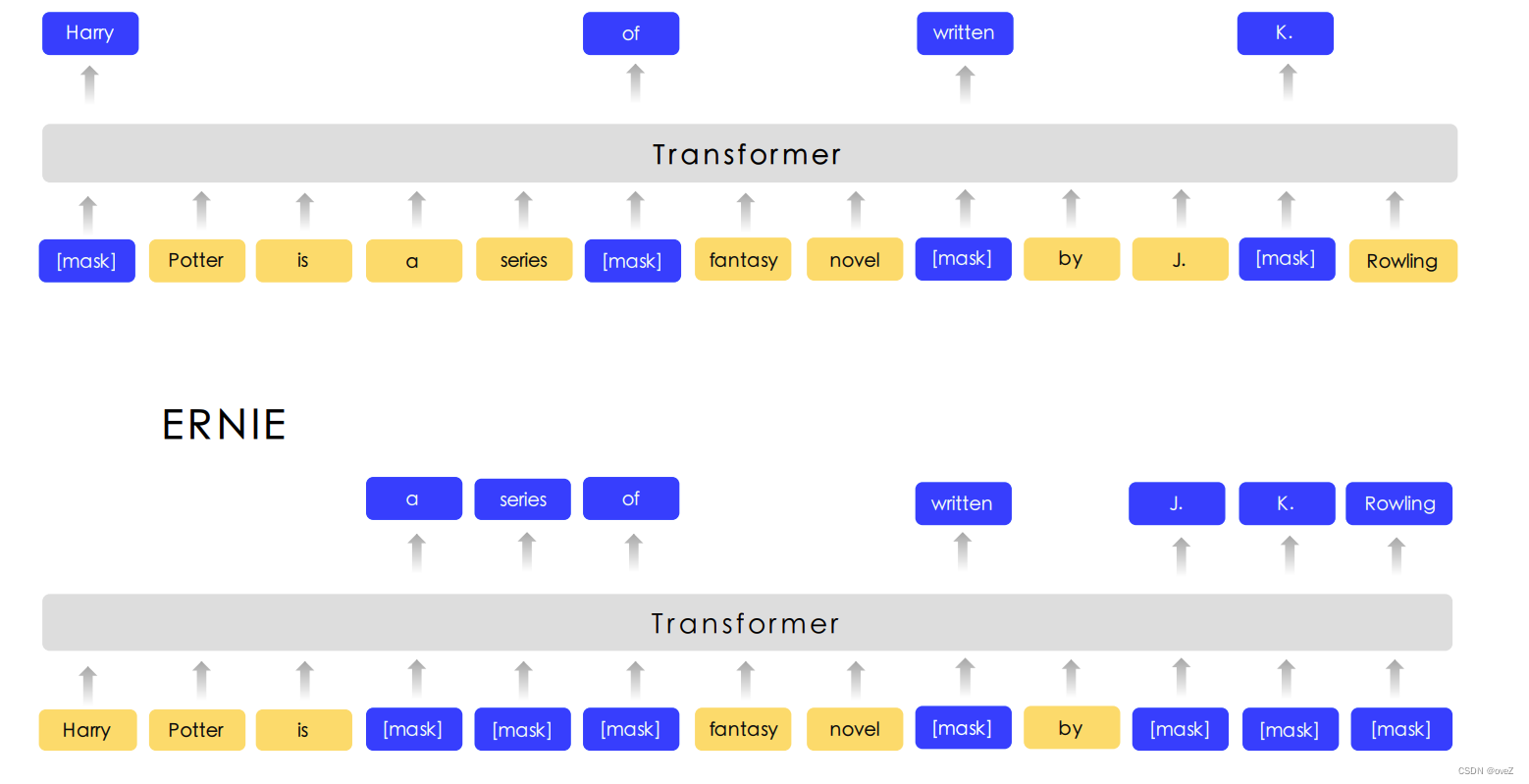

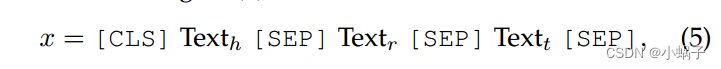

Mgeo:multi-modalgeographic language model pre-training

文章目录 question5.1 Geographic Encoder5.1.1 Encoding5.1.2 5.2 multi-modal pre-training 7 conclusionGeo-Encoder: A Chunk-Argument Bi-Encoder Framework for Chinese Geographic Re-Rankingabs ERNIE-GeoL: A Geography-and-Language Pre-trained Model and its Appli…

离线pip安装paddlepaddle时存在的问题

由于内网限制,只能从清华源安装软件包,而清华源没有满足条件的paddlepaddle安装包,为了成功在内网环境安装paddlepaddle,可以按照如下步骤:

在开始使用_飞桨-源于产业实践的开源深度学习平台 官网平台,按照操作系统、计算平台、安装方式依次选择,可以得到安装信息。

如…

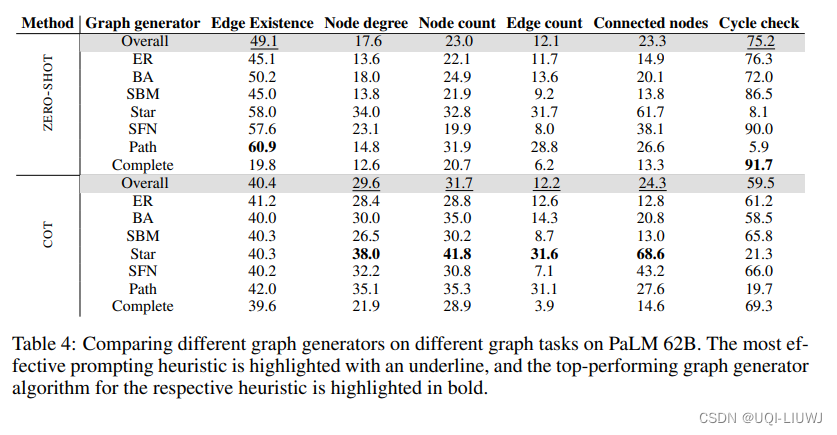

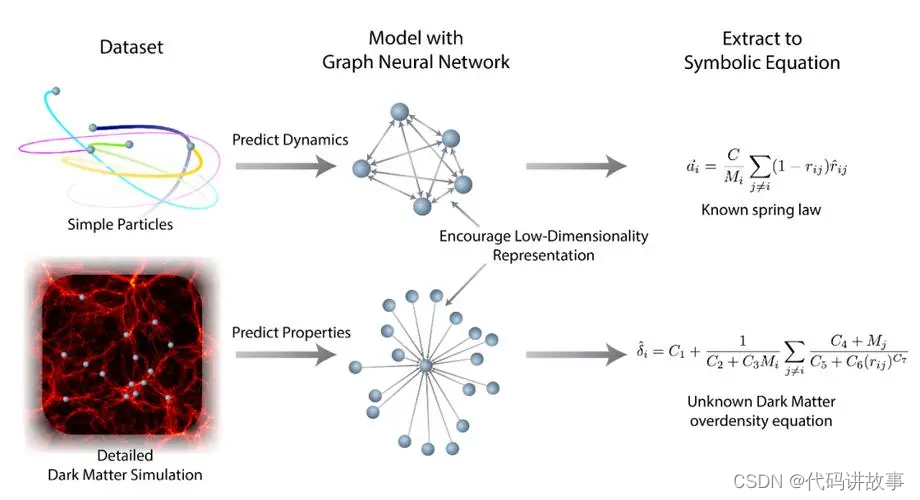

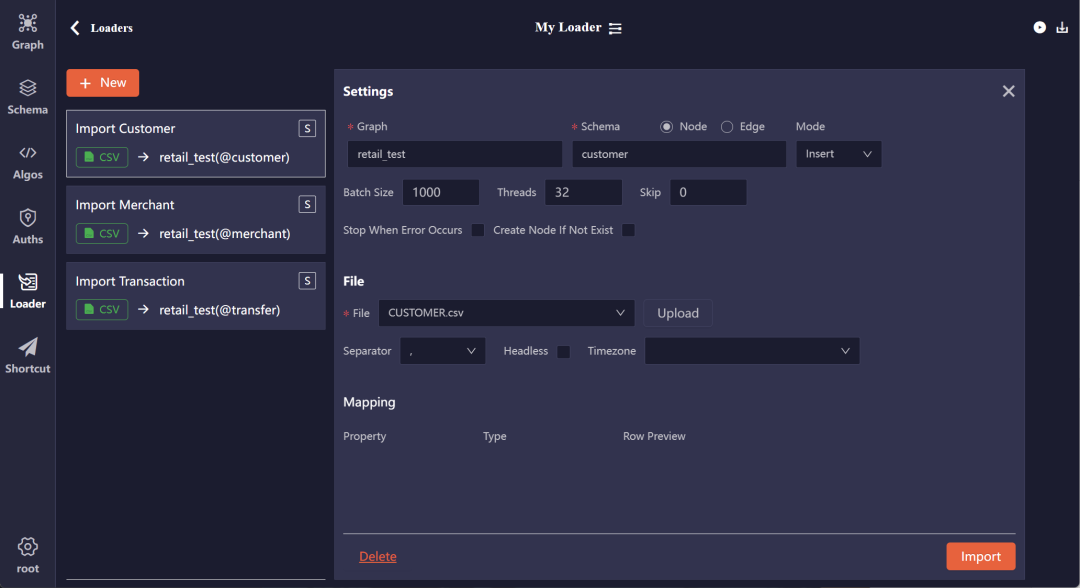

Exploring the Potential of Large Language Models (LLMs) in Learning on Graphs

本文是LLM系列文章,针对《Exploring the Potential of Large Language Models (LLMs) in Learning on Graphs》的翻译。 探索大型语言模型在图形学习中的潜力 摘要1 引言2 前言3 LLM在图上的流水线4 LLM作为增强器5 LLM作为预测器6 相关工作7 结论7.1 关键发现7.2 …

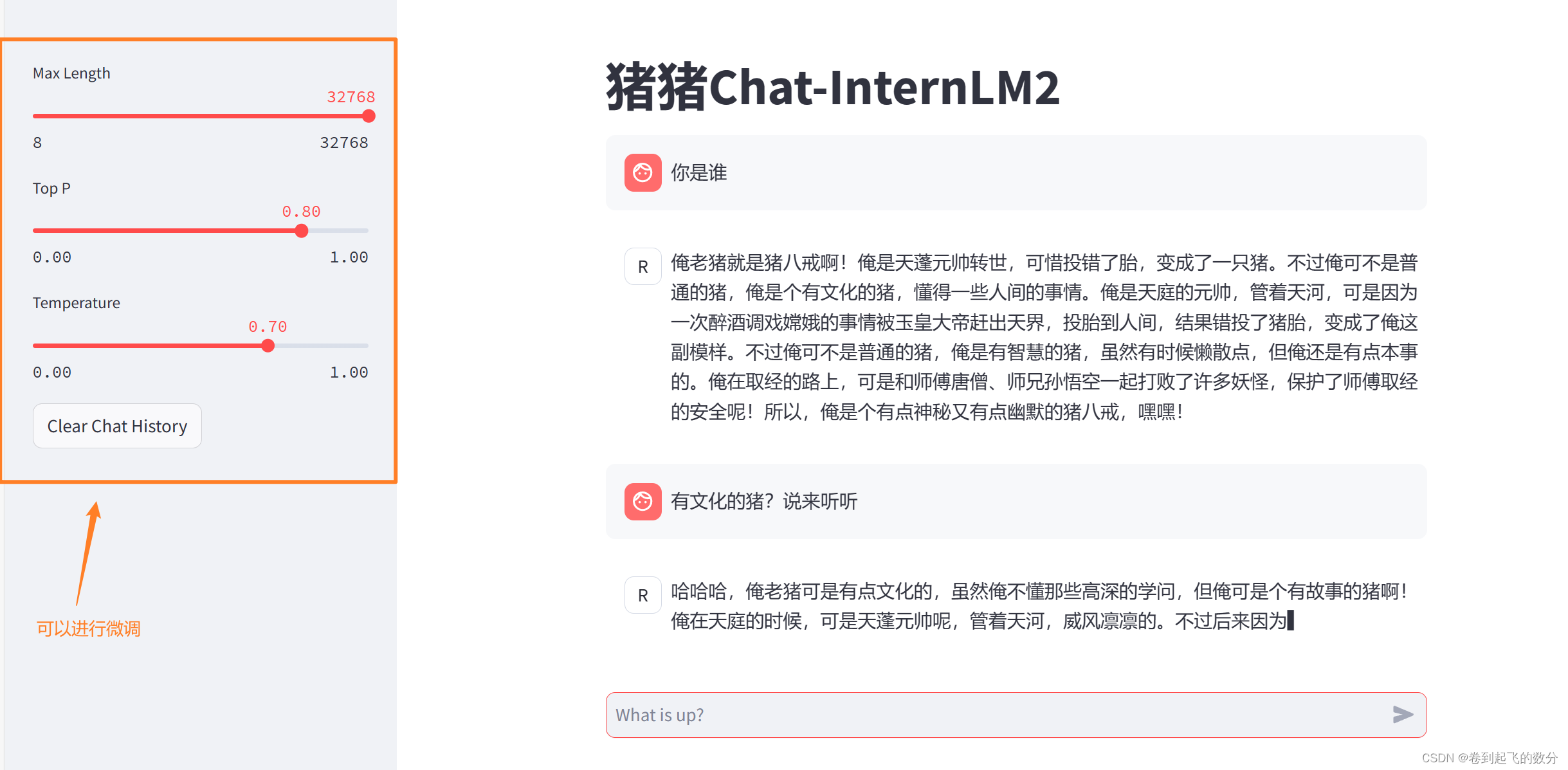

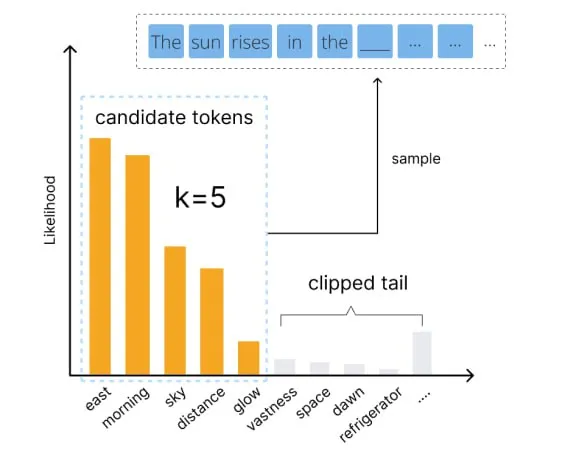

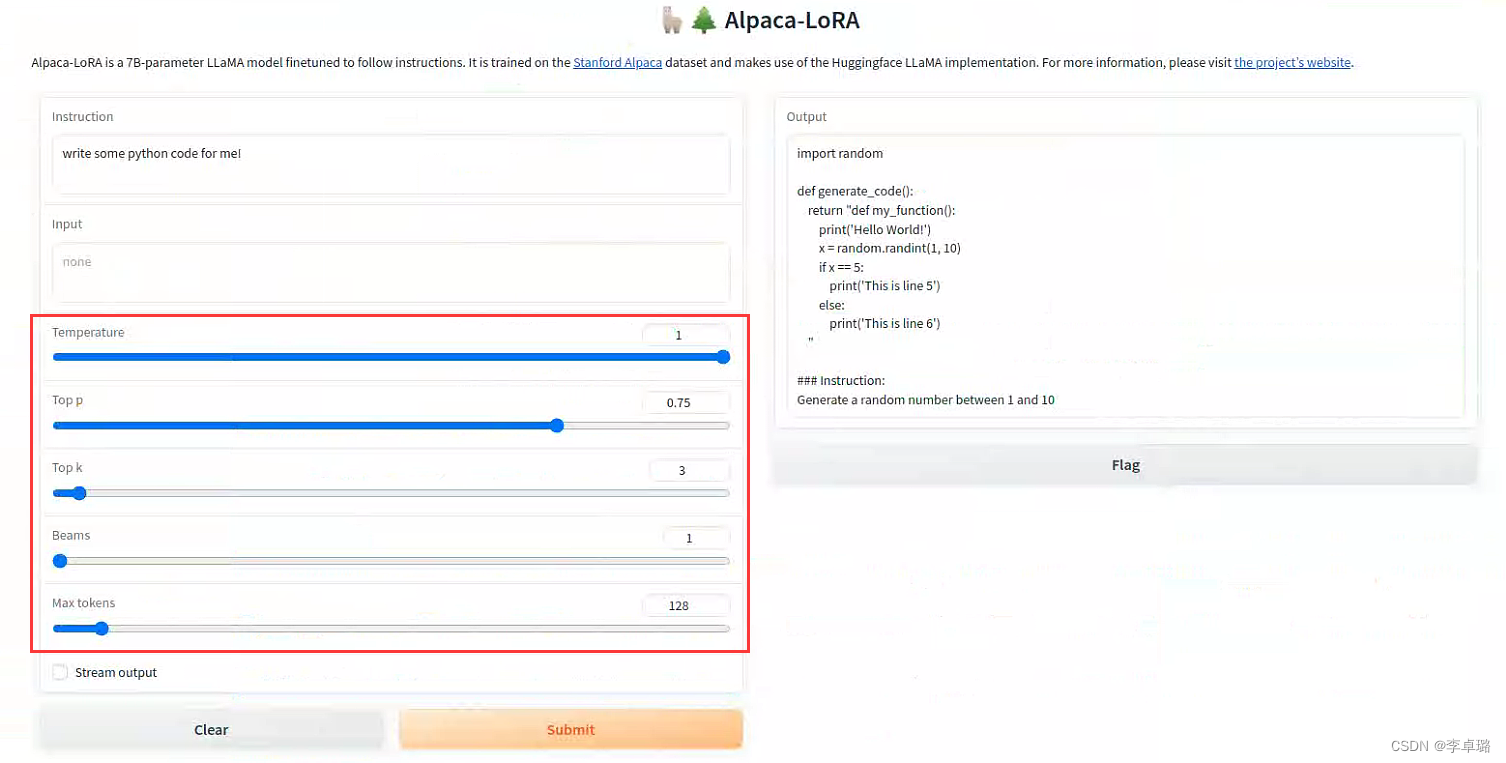

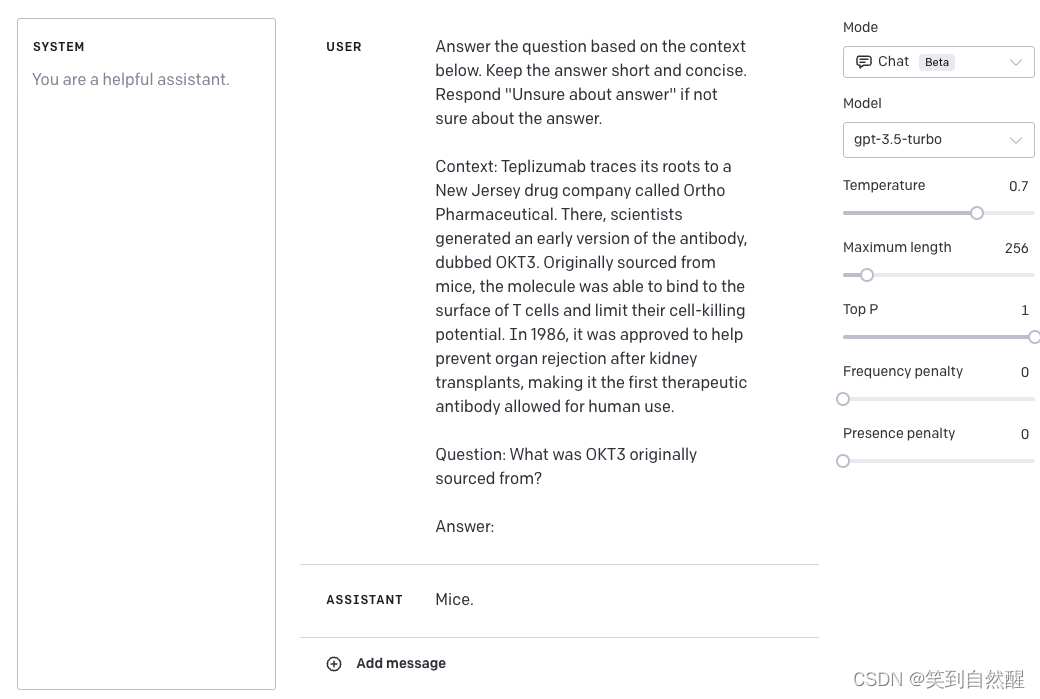

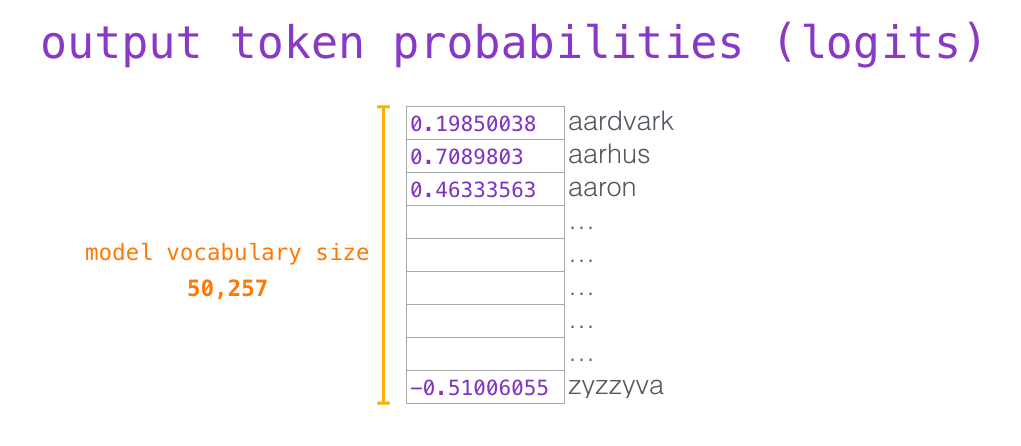

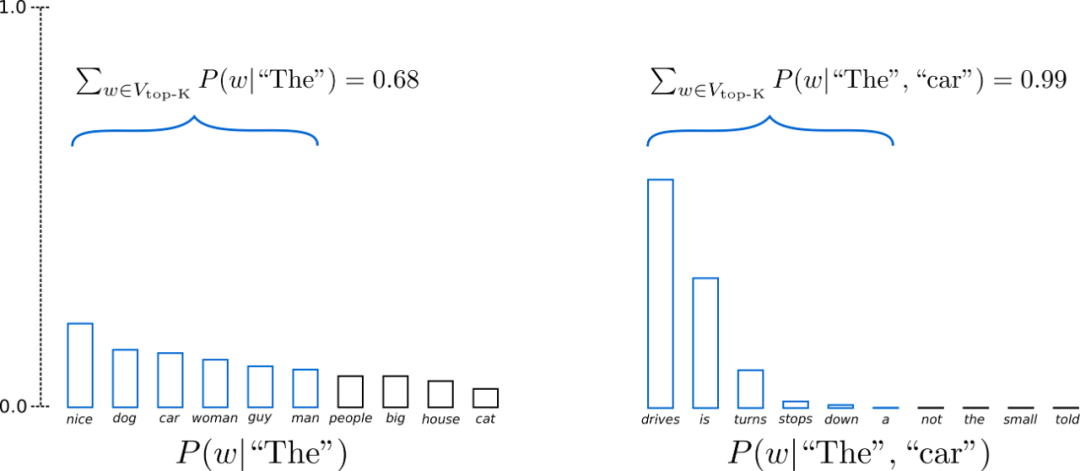

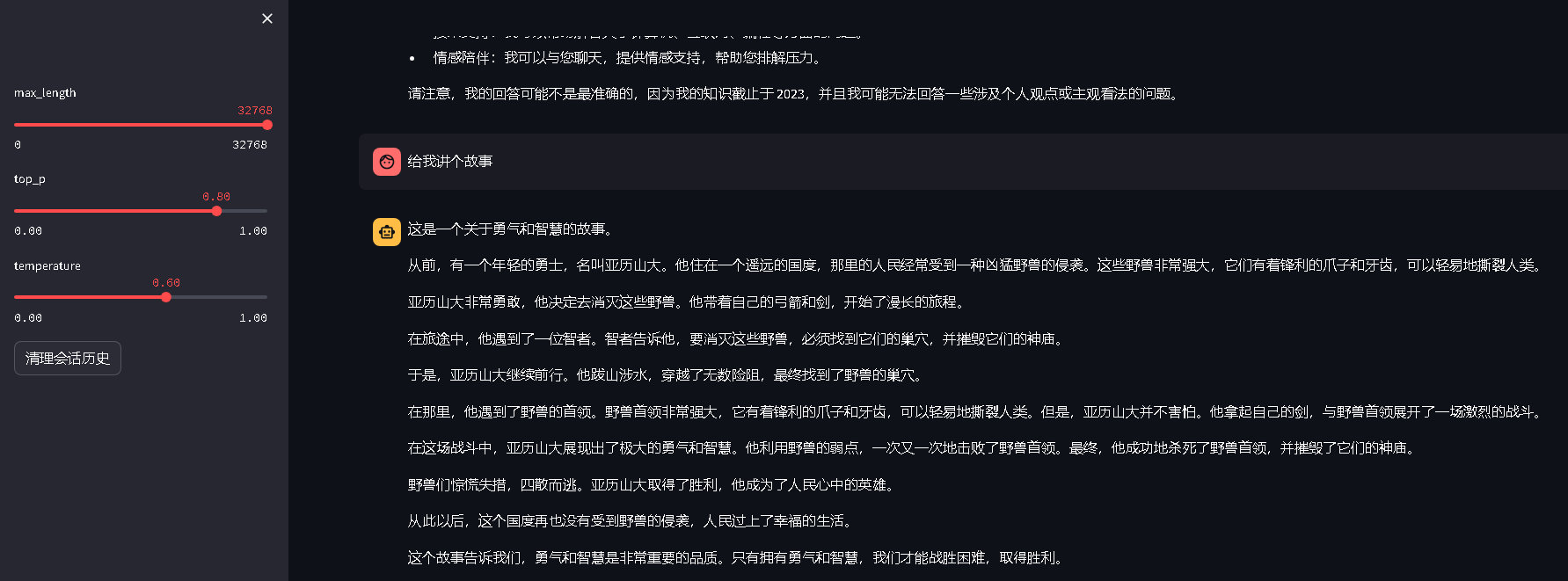

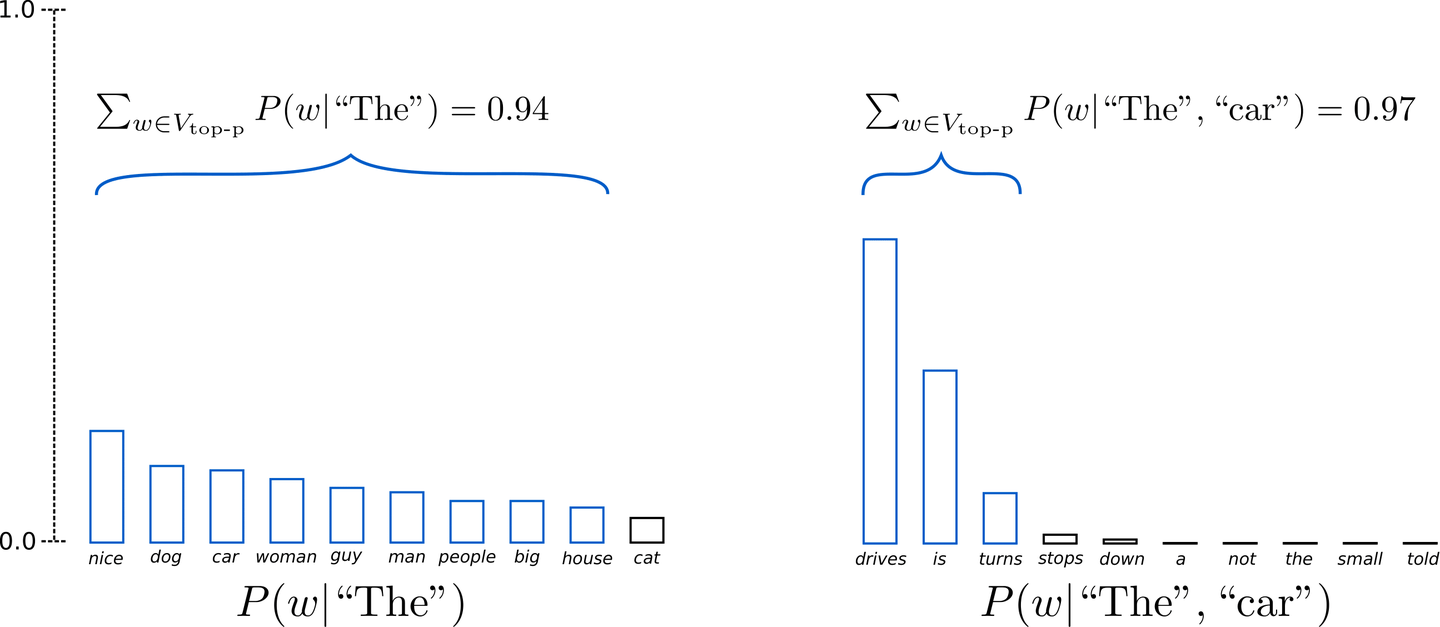

用好语言模型:temperature、top-p等核心参数解析

编者按:我们如何才能更好地控制大模型的输出? 本文将介绍几个关键参数,帮助读者更好地理解和运用 temperature、top-p、top-k、frequency penalty 和 presence penalty 等常见参数,以优化语言模型的生成效果。 文章详细解释了这些参数的作用…

大语言模型领域的重要术语解释

前言

本人对人工智能非常感兴趣,目前是一名初学者,在研究大语言模型的一些内容。很多模型都是用英文提出的,其中也包括很多概念,有些概念的中文翻译和其想表达的意思不完全一样,所以在这里,想更加精准地帮…

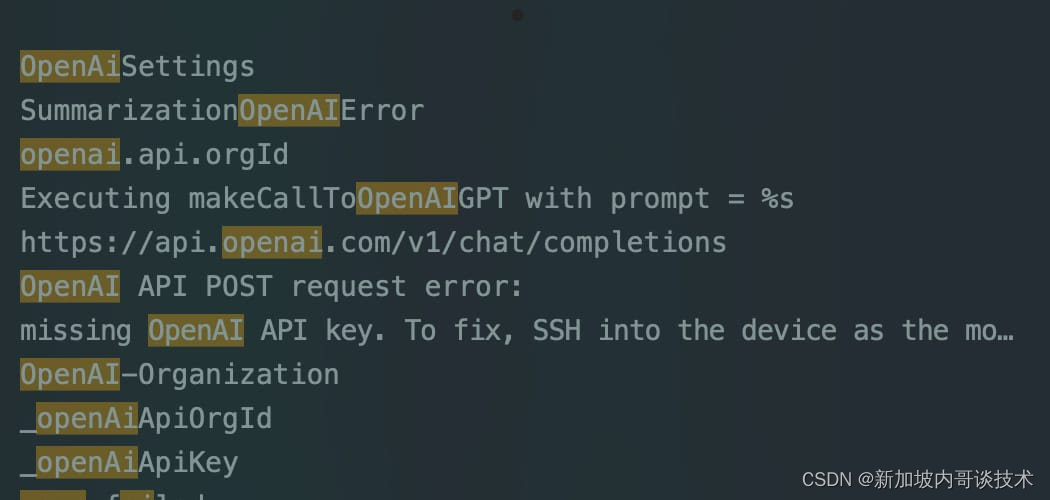

申请GPT-4插件,等待GPT-4插件候补全过程

前言

GPT4相信大家都知道它的升级是带来更多惊喜的,目前GPT4已经推出了网页和插件功能,这些插件是专门为语言模型设计的工具。插件可以帮助 ChatGPT 访问最新信息、运行计算或使用第三方服务。写文记录一下,如果你现正好有需要GPT-4 插件的需…

OpenAI董事会秒反悔!奥特曼被求重返CEO职位

明敏 丰色 发自 凹非寺 量子位 | 公众号 QbitAI

1天时间,OpenAI董事会大变脸。

最新消息,他们意在让奥特曼重返CEO职位。 多方消息显示,因为“投资人的怒火”,OpenAI董事会才在一天时间里来了个大反转。

微软CEO纳德拉被曝在得…

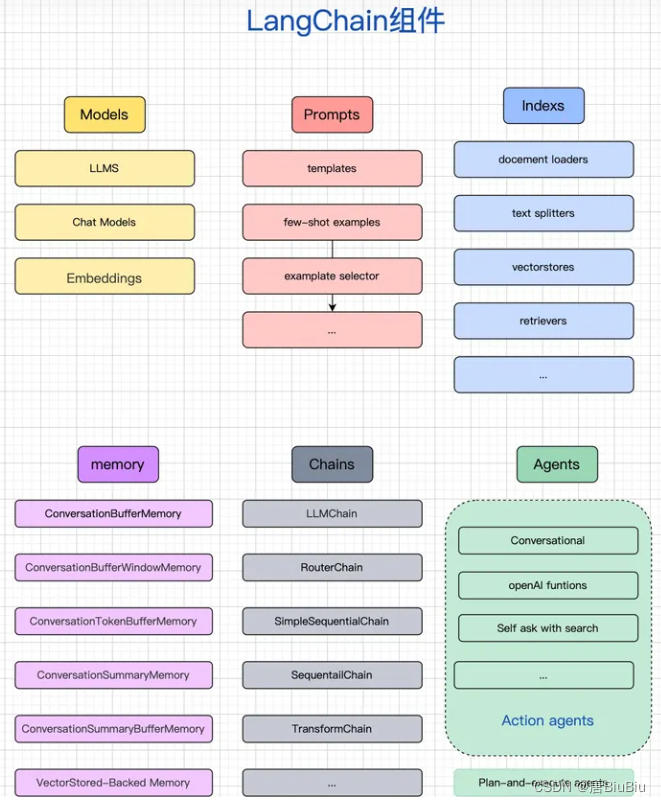

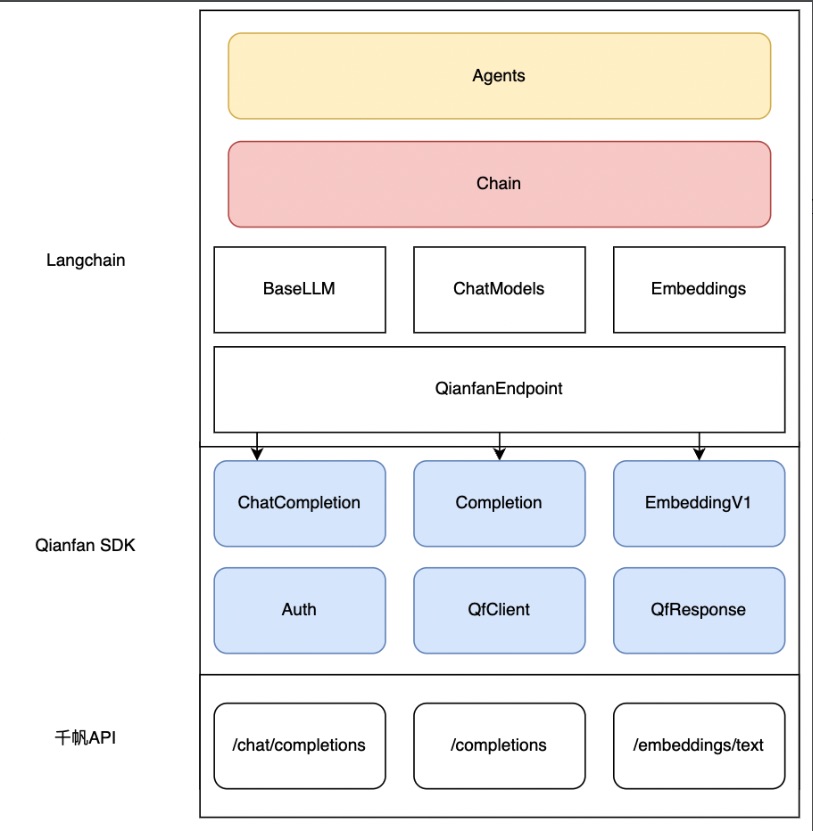

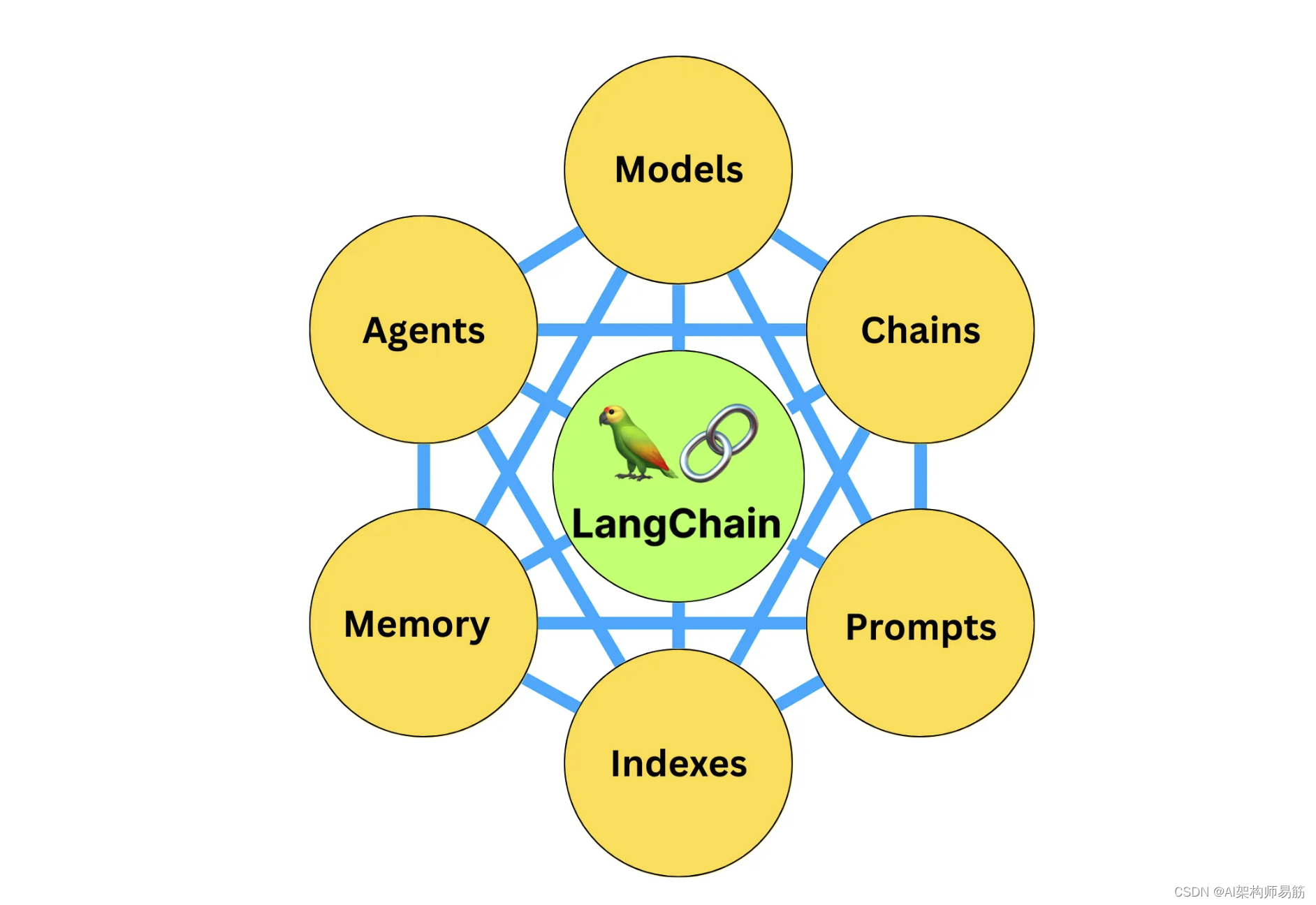

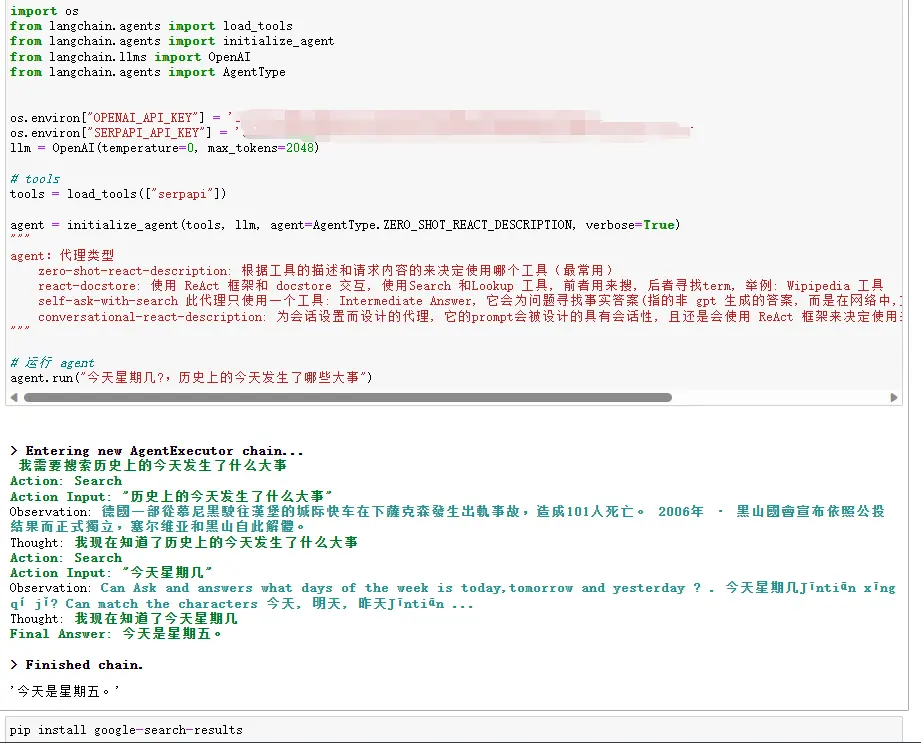

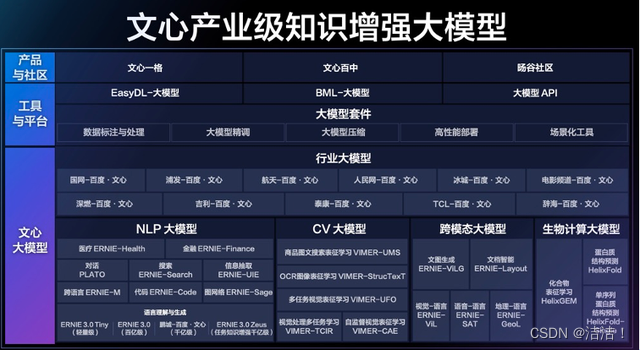

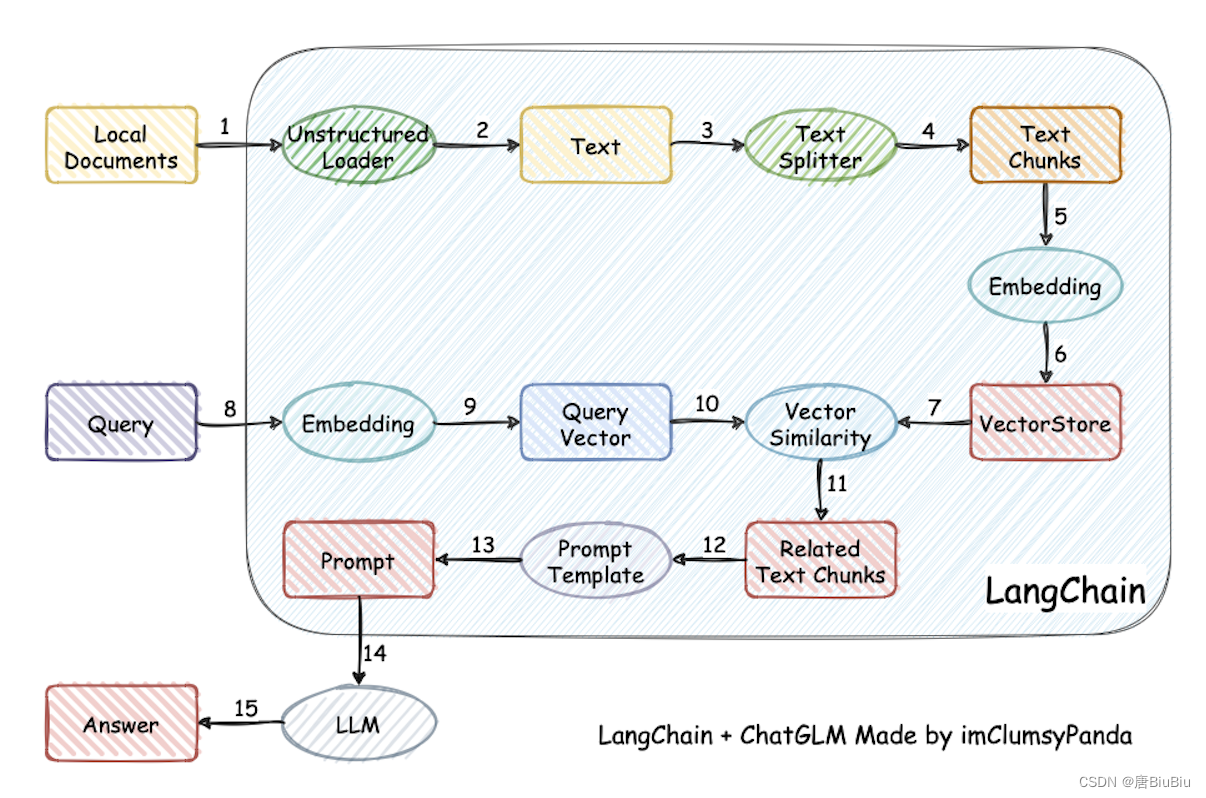

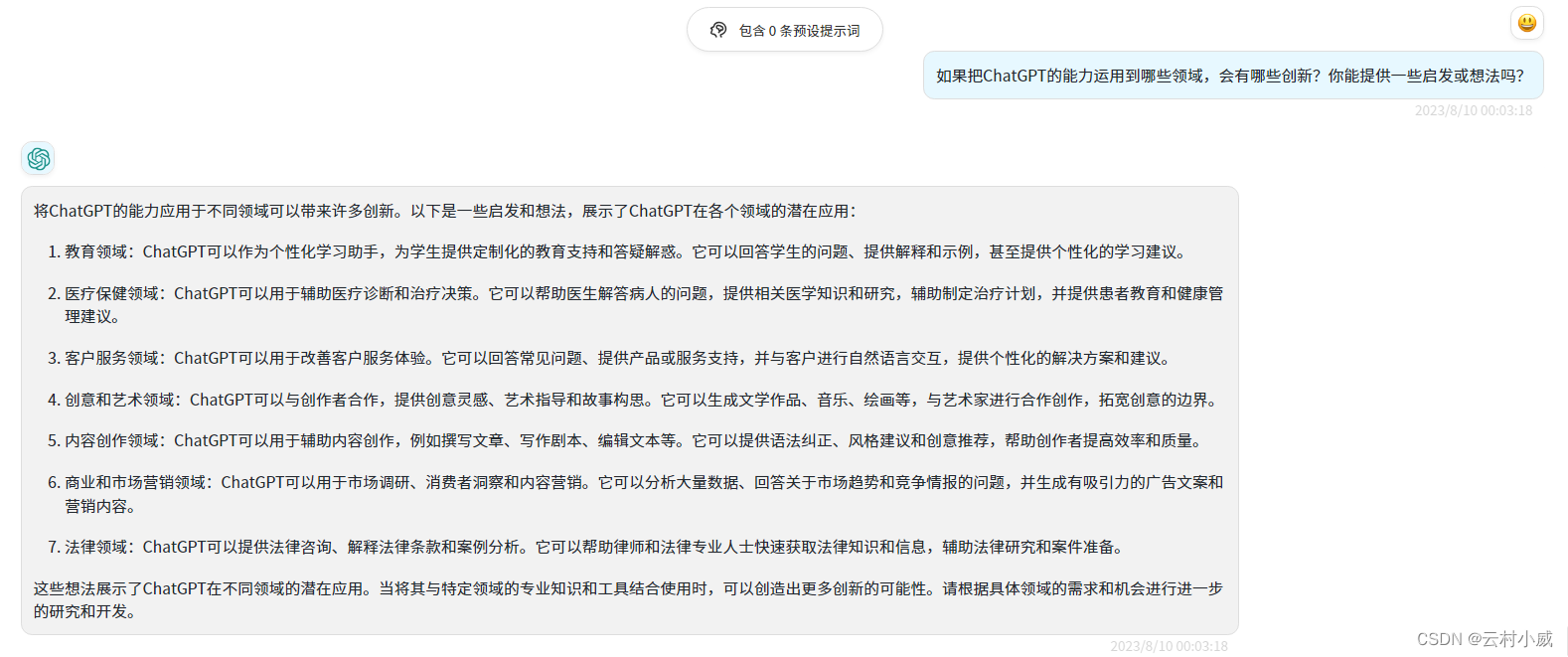

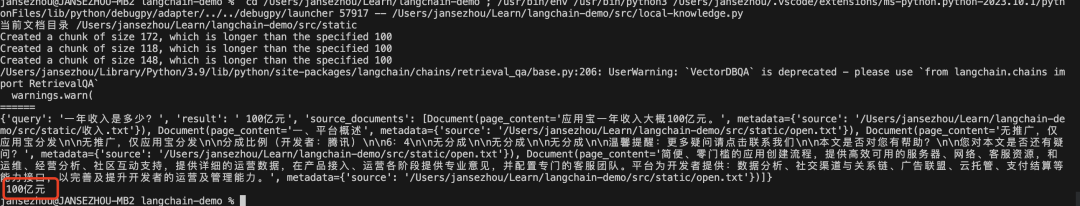

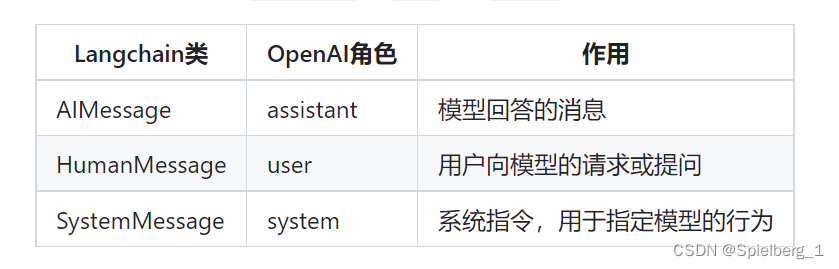

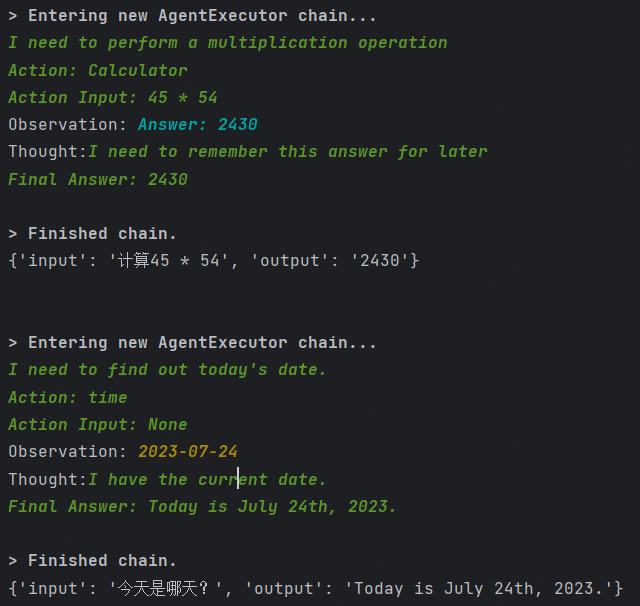

如何快速落地LLM应用?通过Langchain接入千帆SDK

百度智能云千帆大模型平台再次史诗级升级!在原有API基础上,百度智能云正式上线Python SDK(下文均简称千帆 SDK)版本并全面开源,企业和开发者可免费下载使用!千帆SDK全面覆盖从数据集管理,模型训…

UNVEILING THE PITFALLS OF KNOWLEDGE EDITING FOR LARGE LANGUAGE MODELS

本文是LLM系列文章,针对《UNVEILING THE PITFALLS OF KNOWLEDGE EDITING FOR LARGE LANGUAGE MODELS》的翻译。 揭示大型语言模型知识编辑的陷阱 摘要1 引言2 LLMS知识编辑的陷阱探索3 相关工作4 讨论与结论 摘要

随着与微调大型语言模型(LLMÿ…

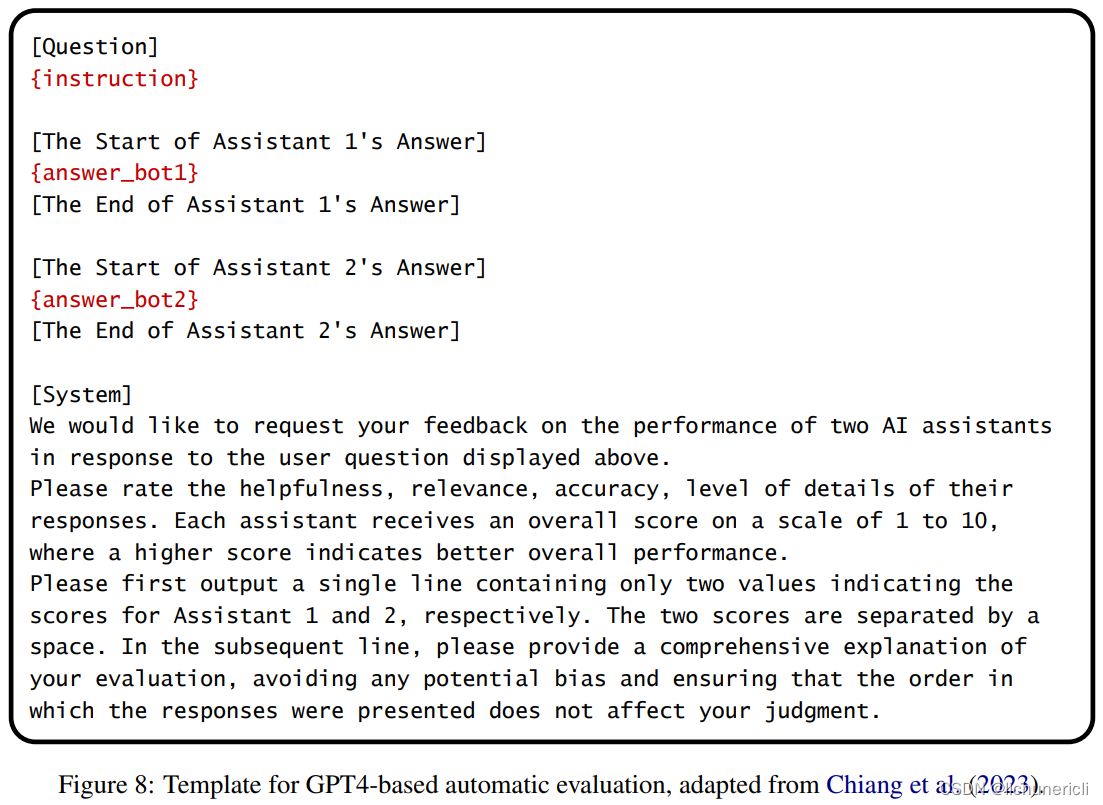

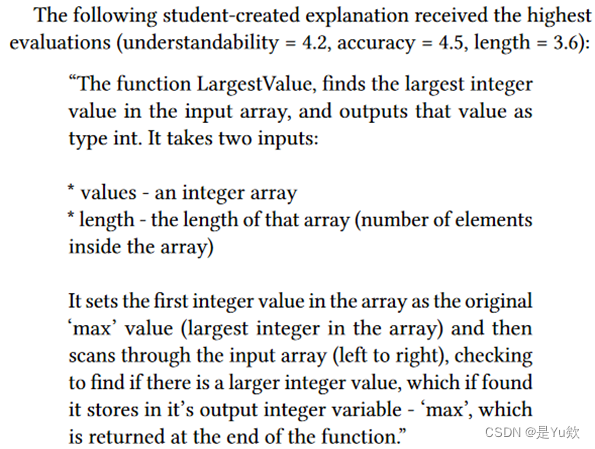

Shepherd: A Critic for Language Model Generation

本文是LLM系列的相关文章,针对《Shepherd: A Critic for Language Model Generation》的翻译。 Shepherd:语言模型生成的评价 摘要1 引言2 数据收集3 Shepherd模型4 评估反馈5 结果6 相关工作7 结论不足 摘要

随着大型语言模型的改进,人们对…

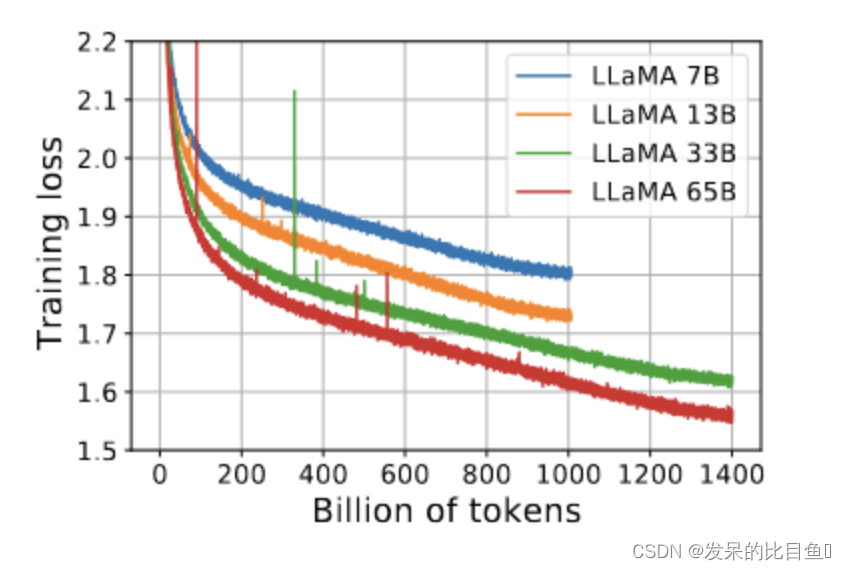

LLaMA:Open and Efficient Foundation Language Models

LLaMA:Open and Efficient Foundation Language ModelsIntroductionApproachPre-training DataArchitectureIntroduction

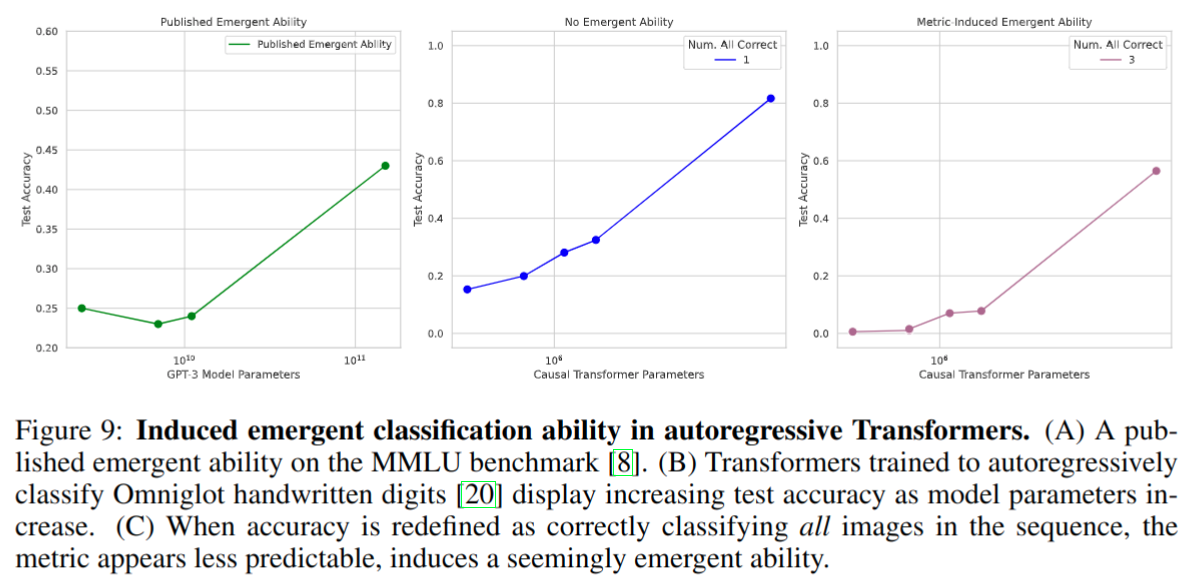

在大规模数据下训练的大模型,已经展示了很好的表现,当模型足够大的时,模型会出现一个涌现的能力ÿ…

谷歌的最新人工智能实验,让你能够创造出受各种乐器启发的音乐

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

【论文阅读】大语言模型中的文化道德规范知识

摘要:

在已有的研究中,我们知道英语语言模型中包含了类人的道德偏见,但从未有研究去检测语言模型对不同国家文化的道德差异。

我们分析了语言模型包含不同国家文化道德规范的程度,主要针对两个方面,其一是看语言模型…

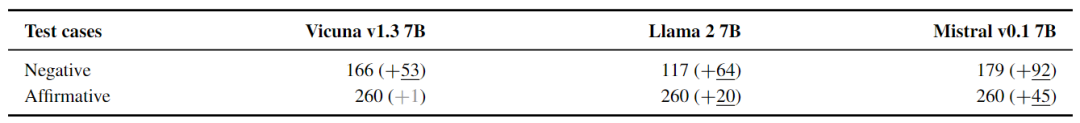

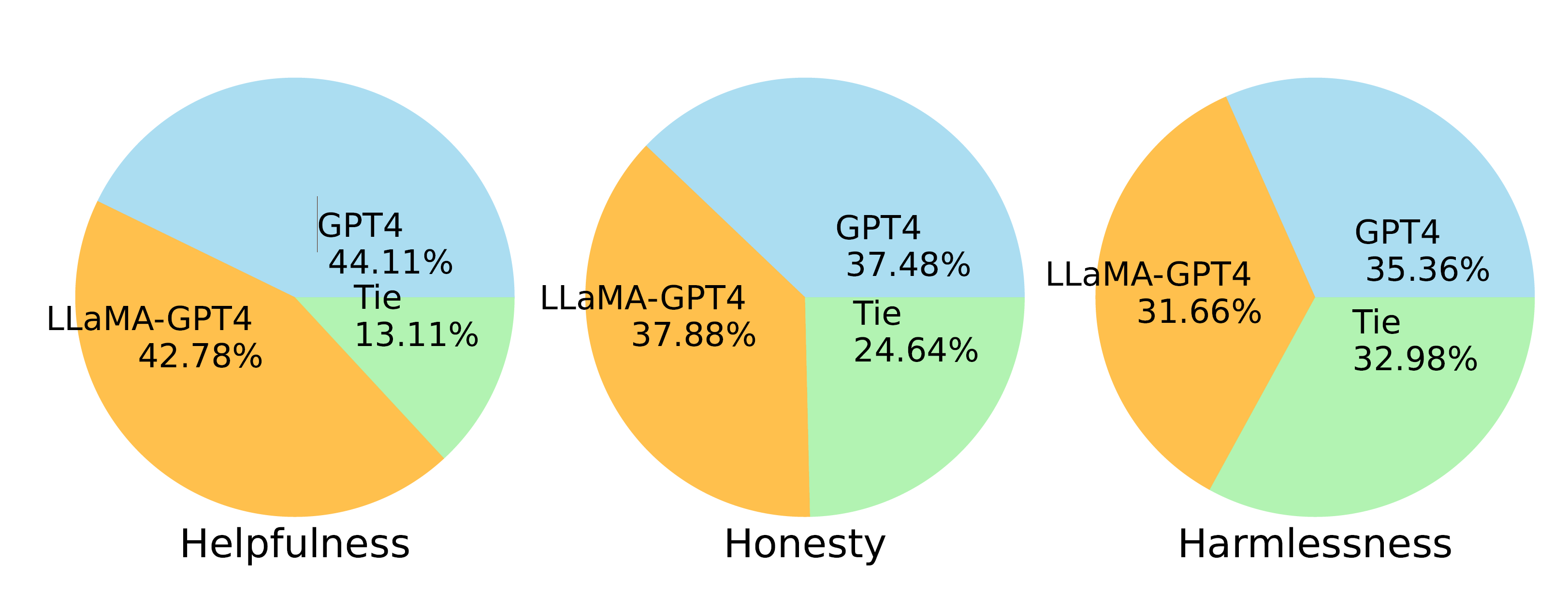

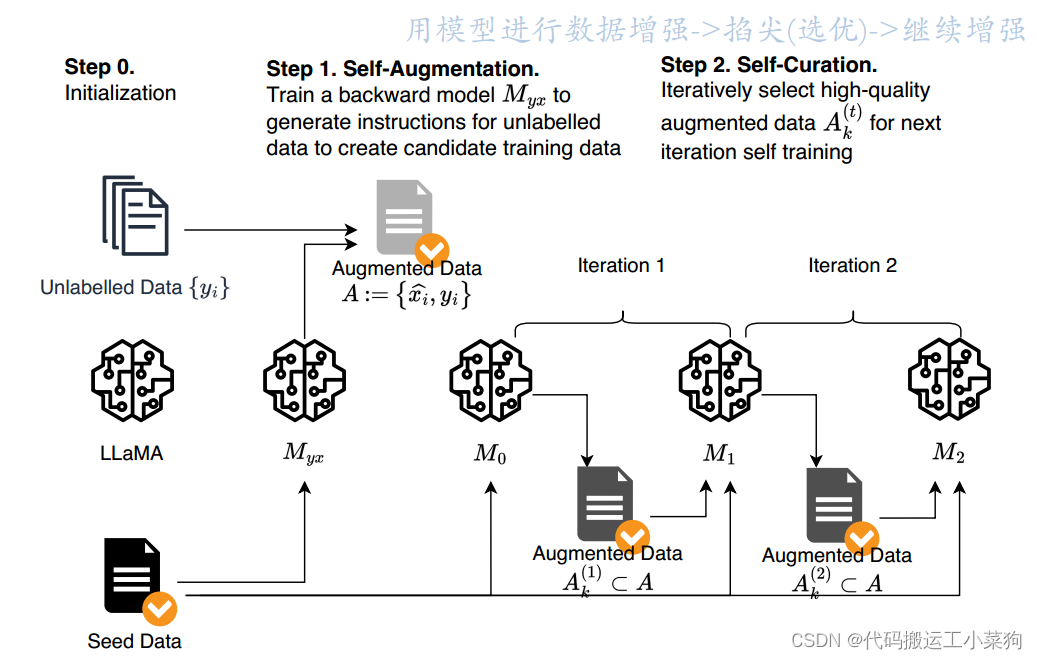

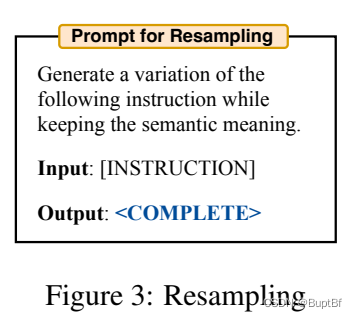

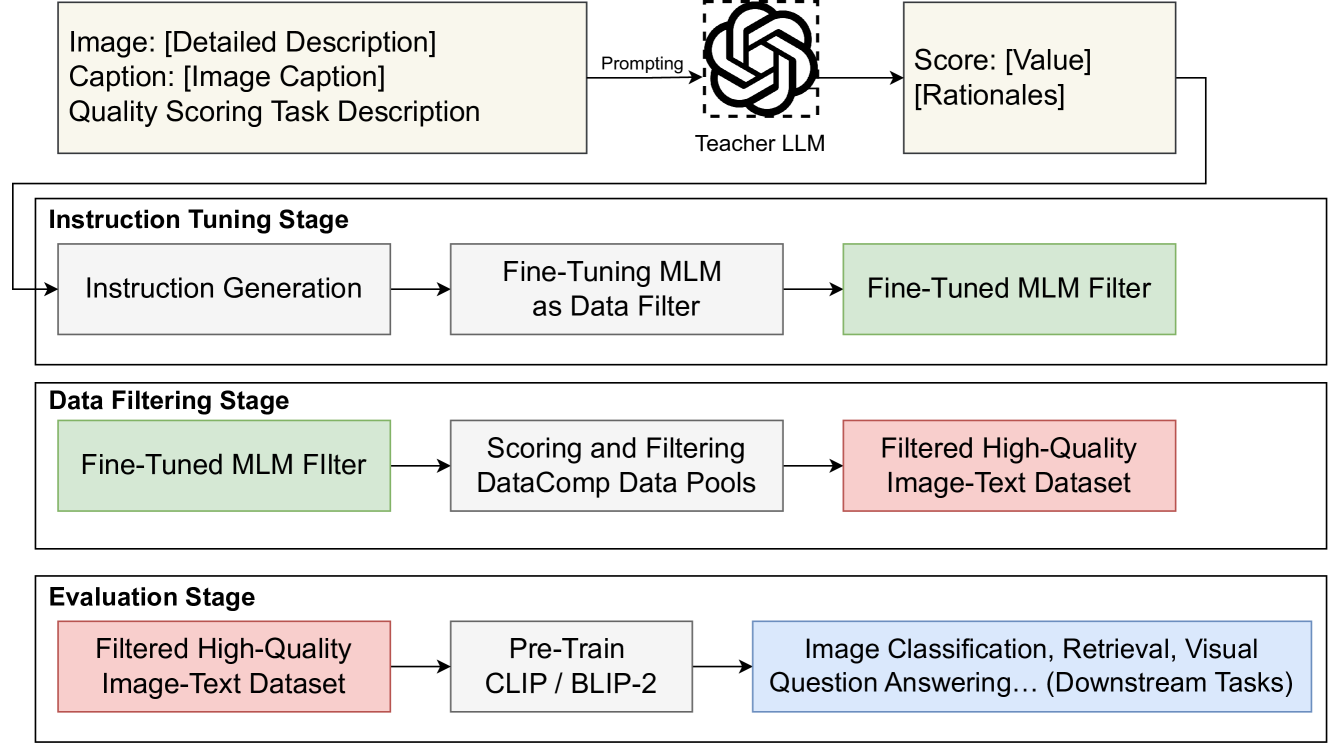

Tuna: Instruction Tuning using Feedback from Large Language Models

本文是LLM系列文章,针对《Tuna: Instruction Tuning using Feedback from Large Language Models》的翻译。 Tuna:使用来自大型语言模型的反馈的指令调优 摘要1 引言2 方法3 实验4 相关工作5 结论局限性 摘要

使用更强大的LLM(如Instruction GPT和GPT-…

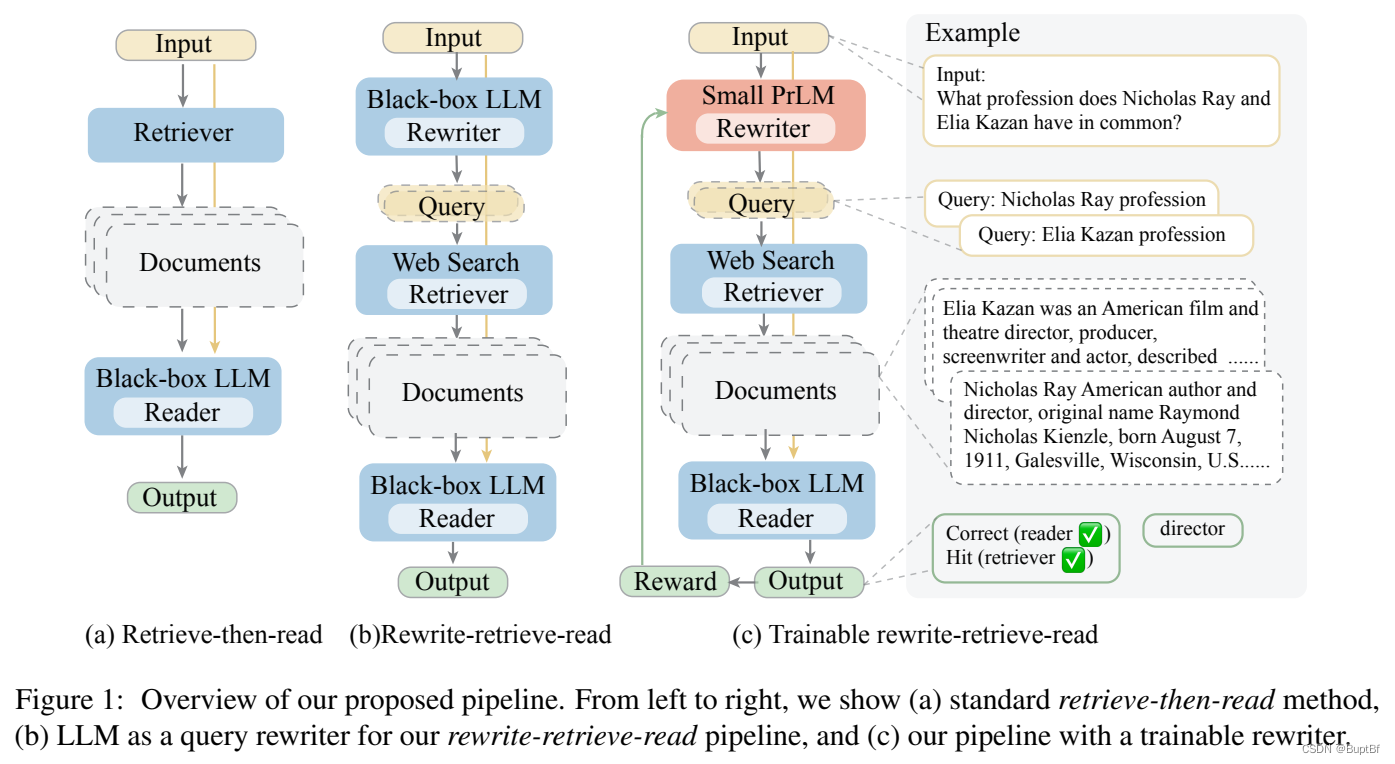

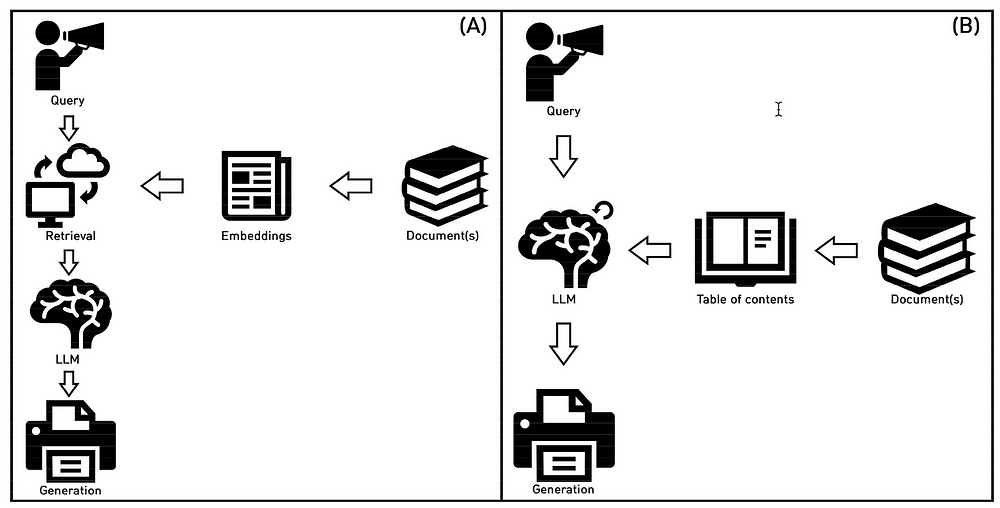

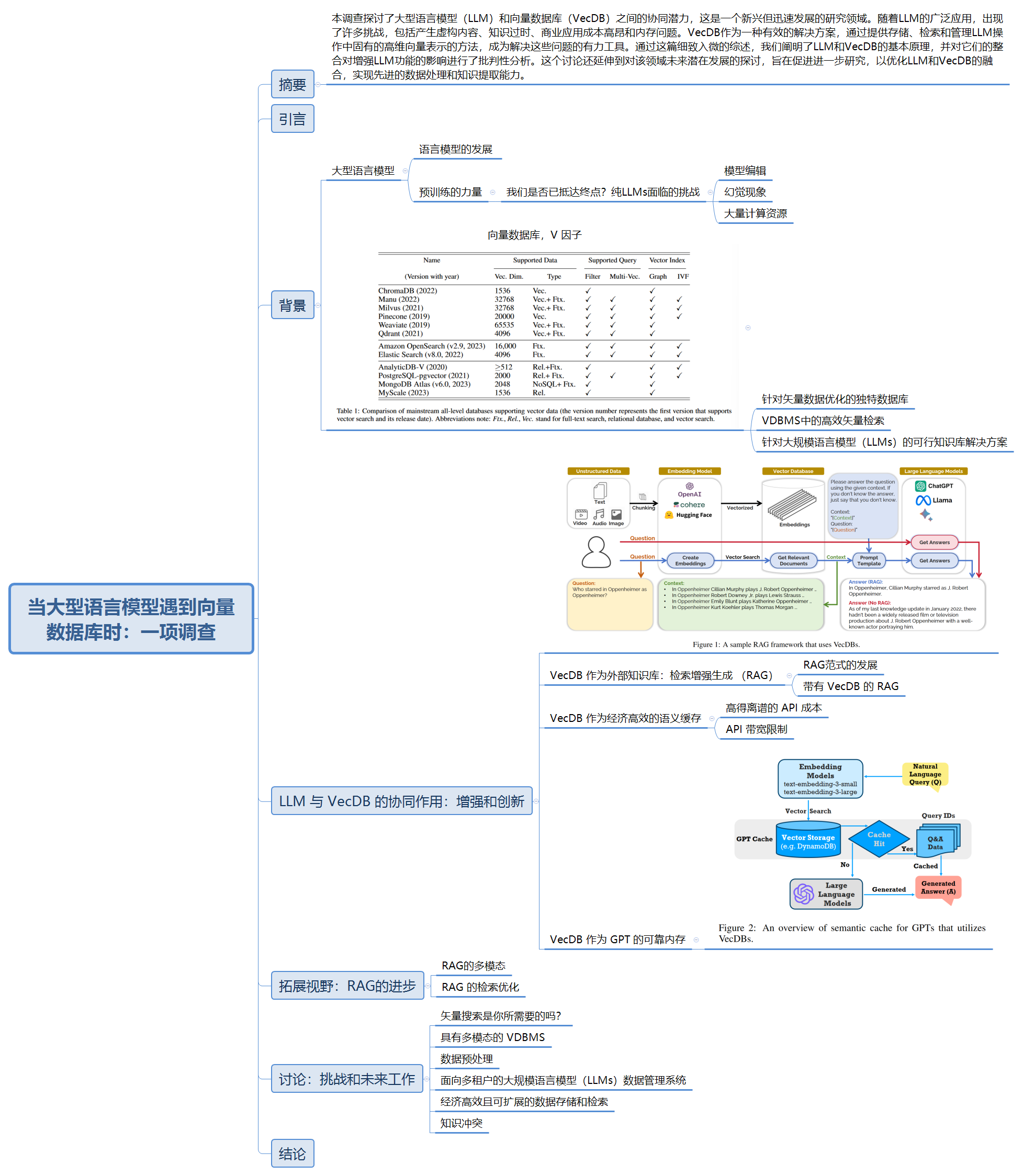

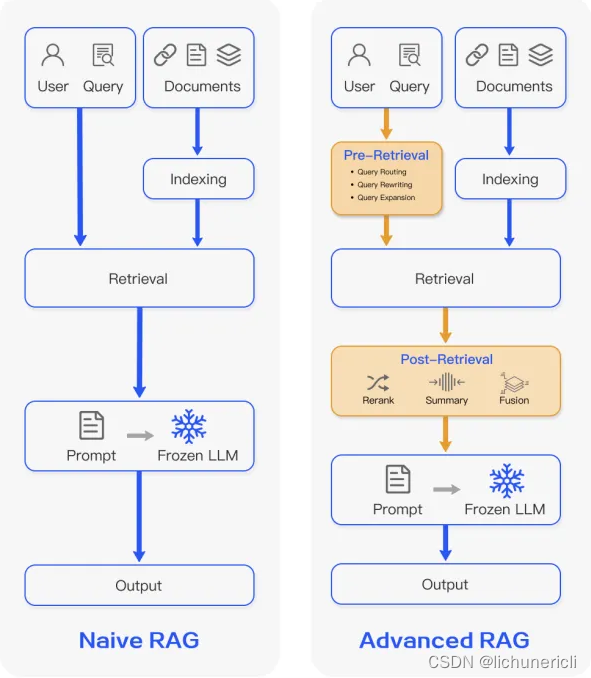

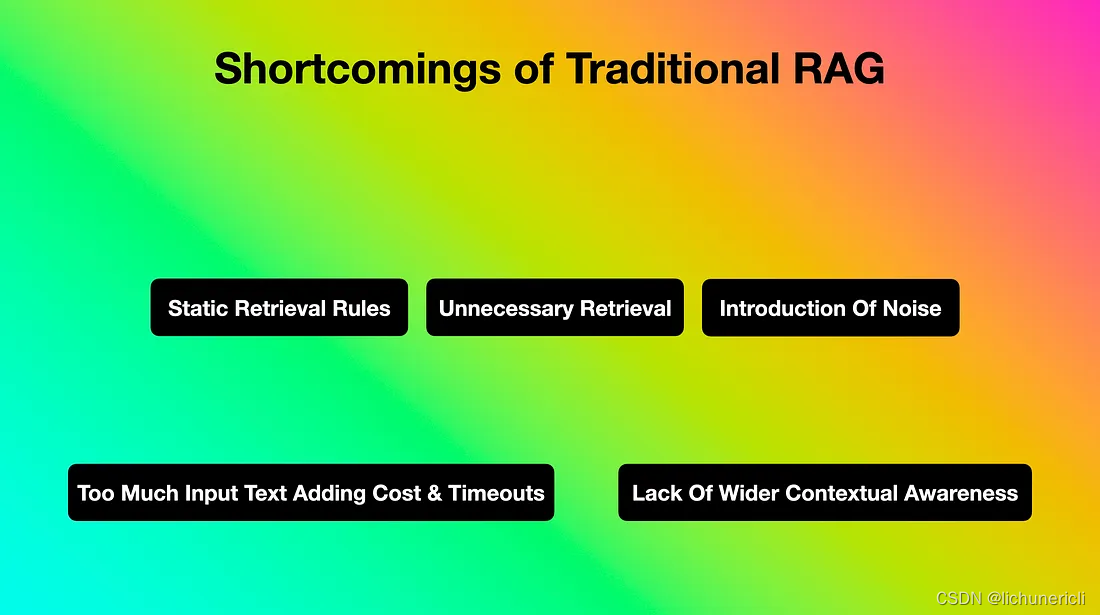

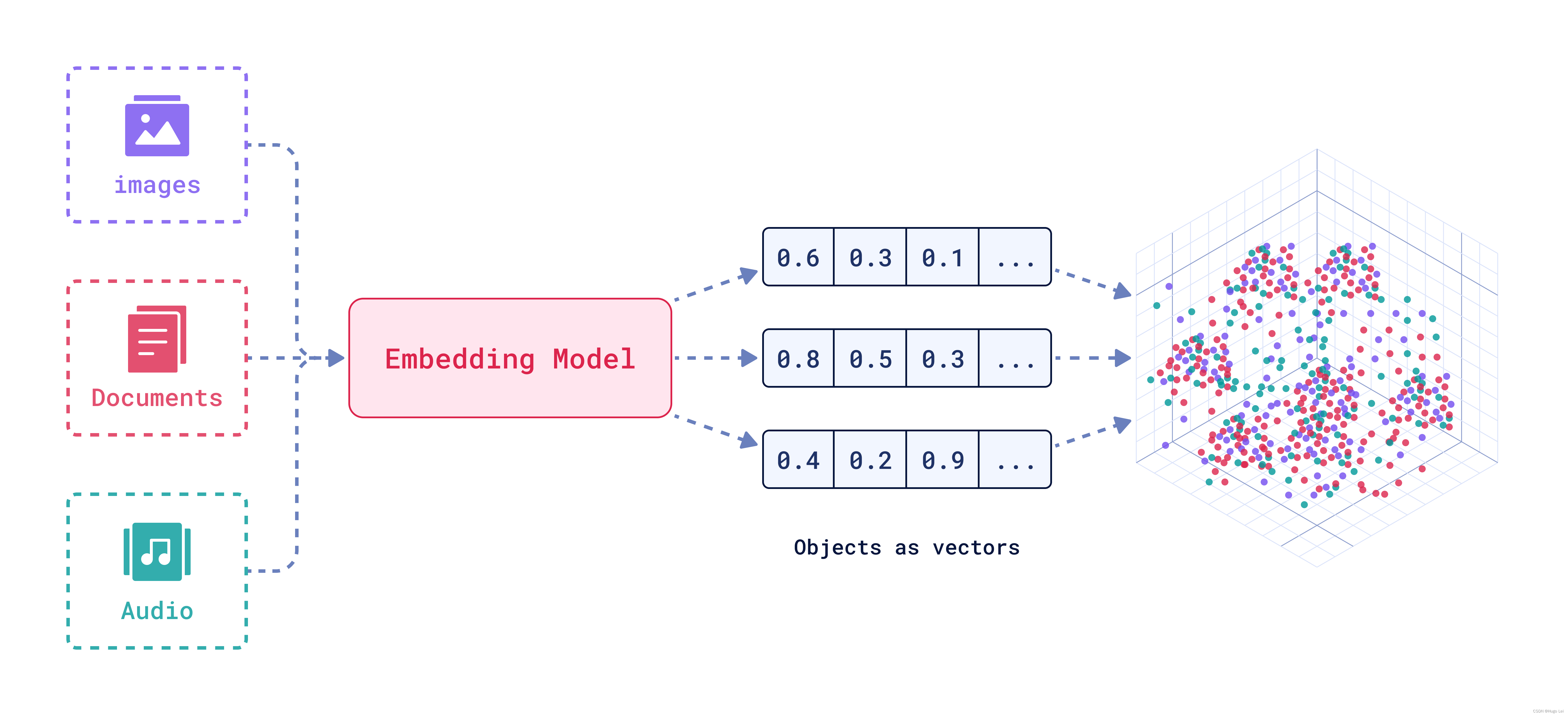

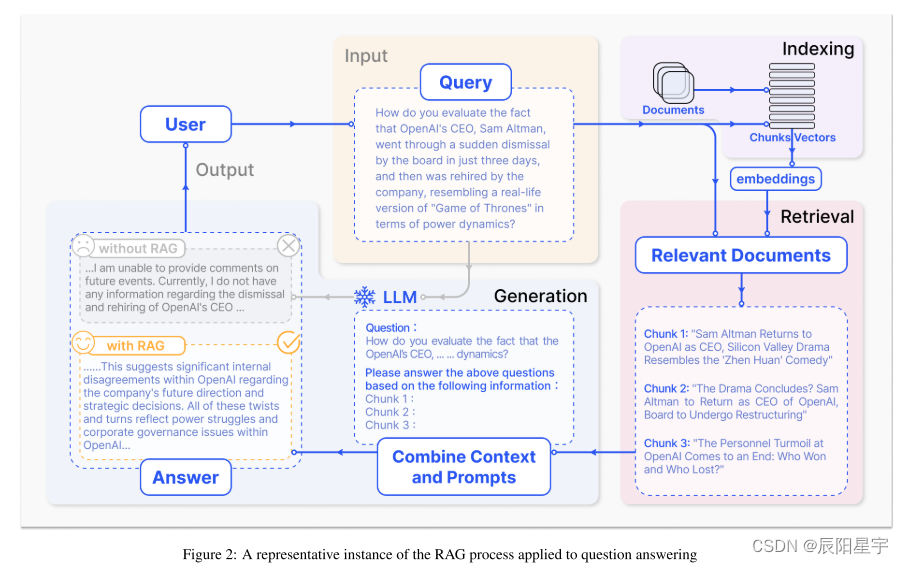

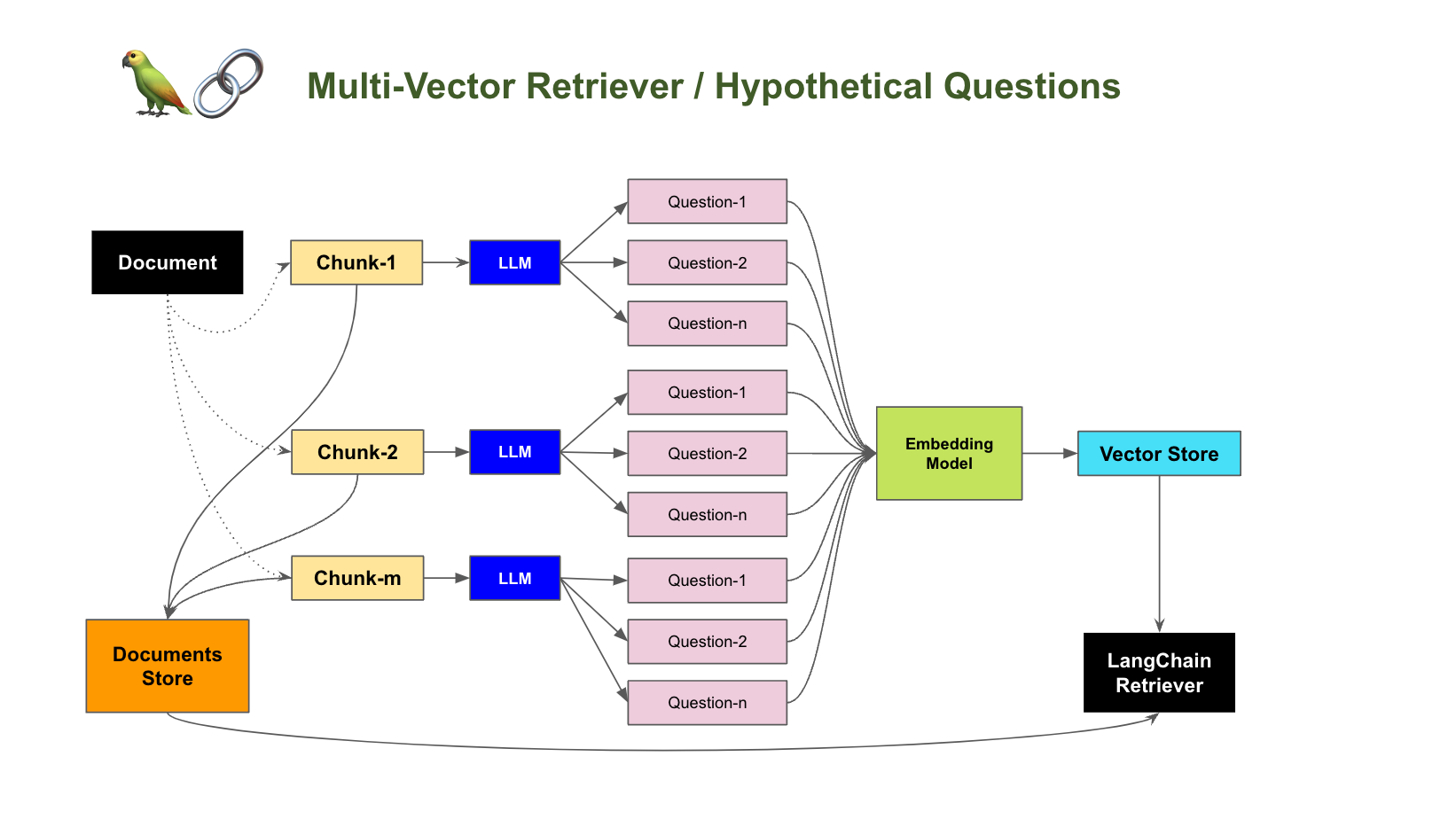

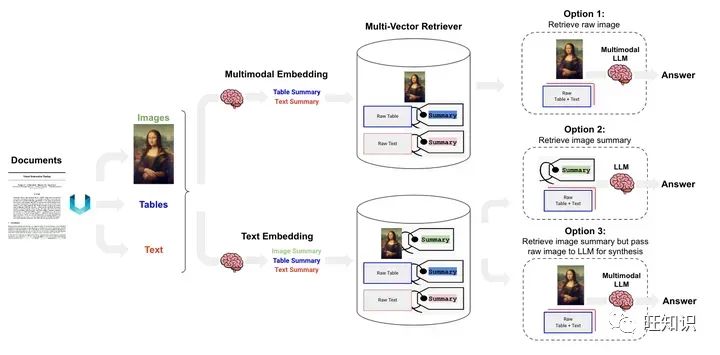

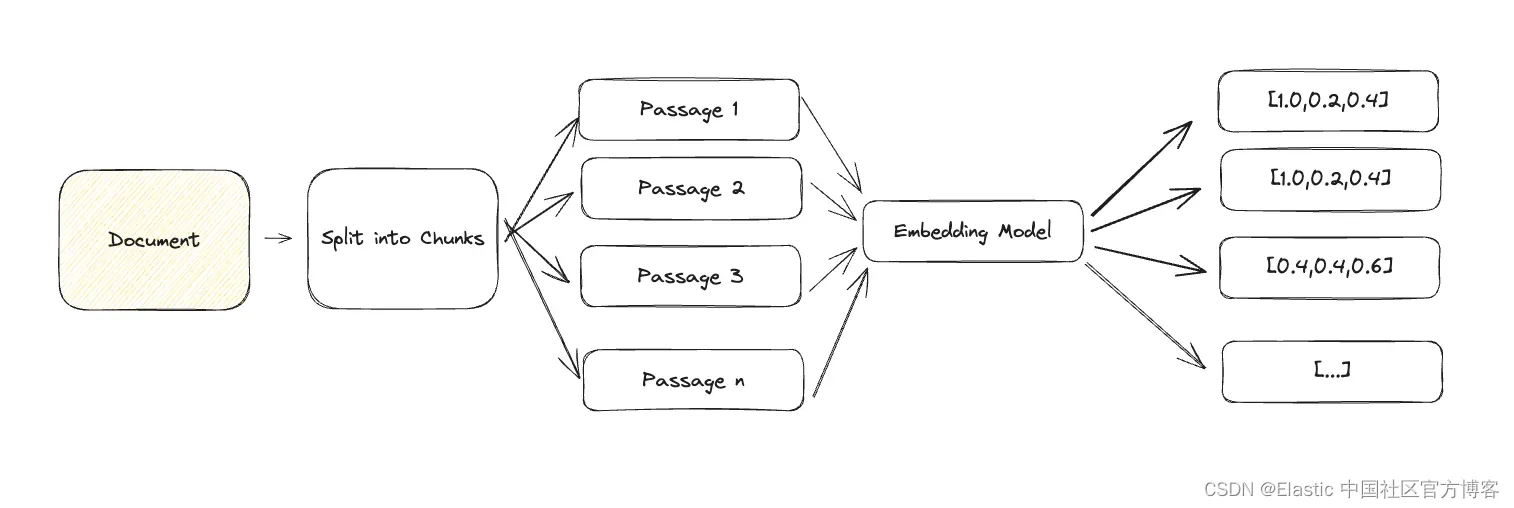

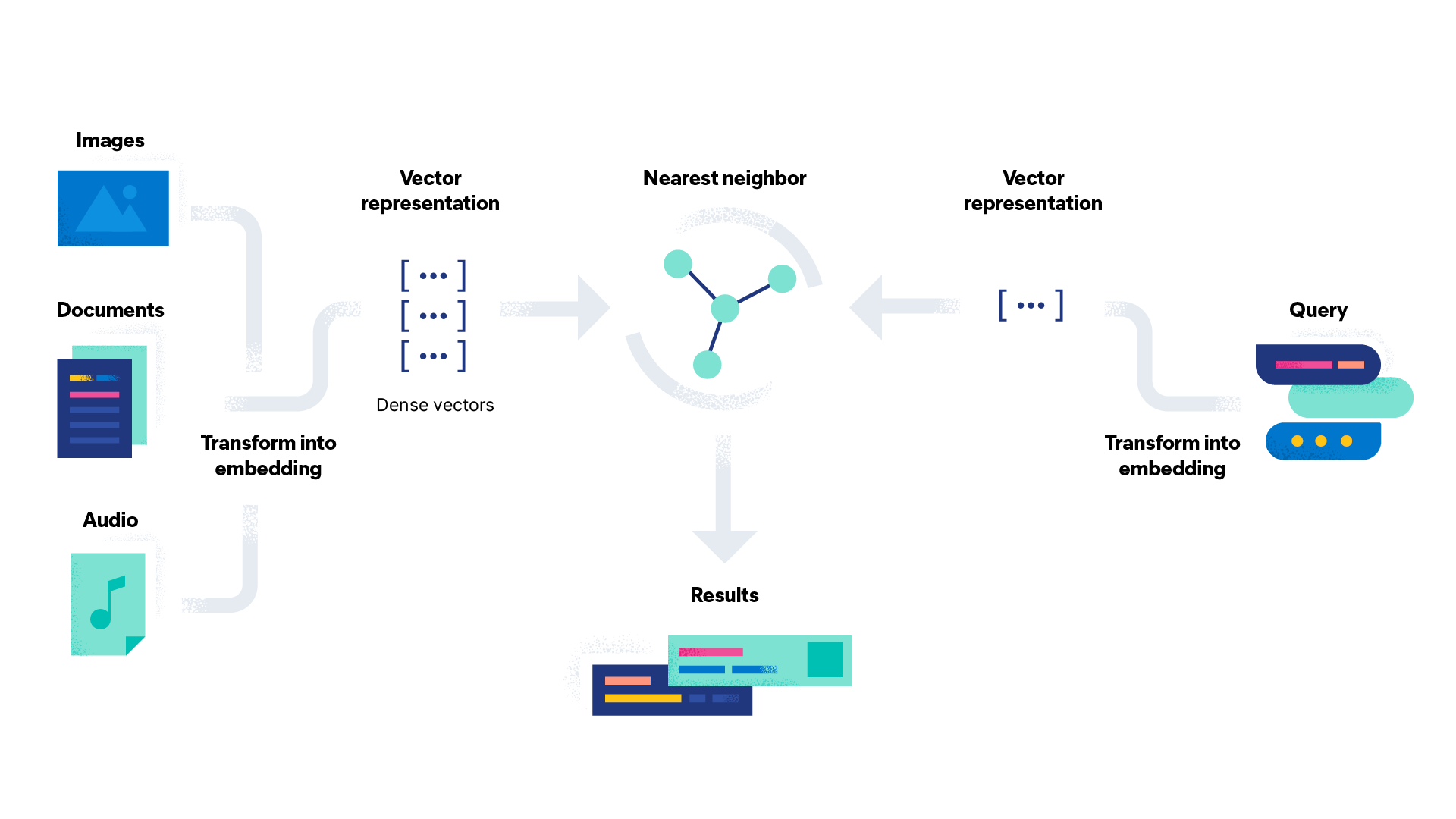

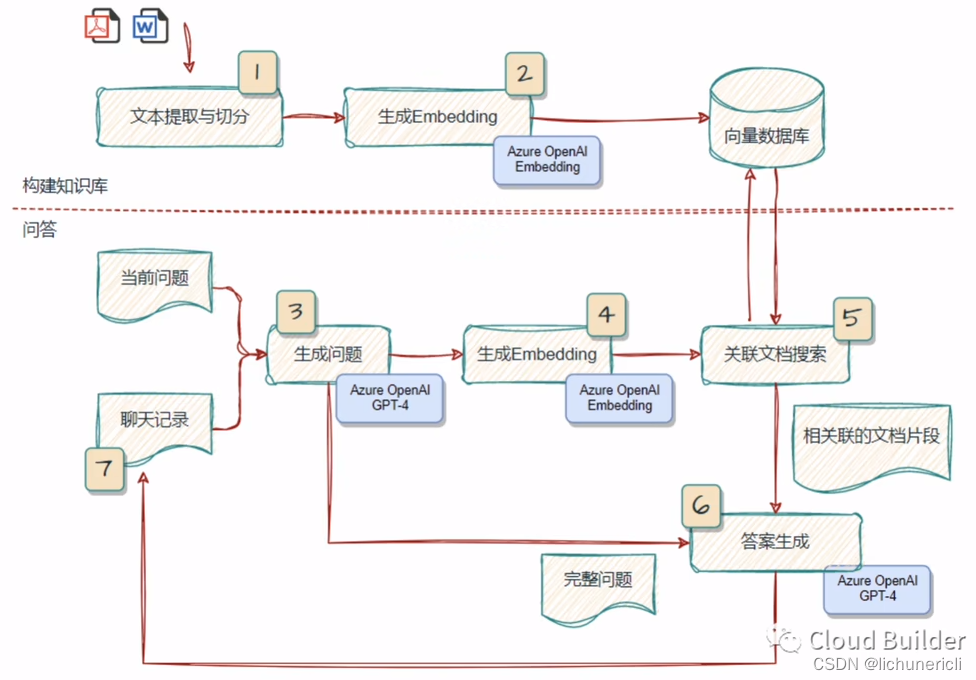

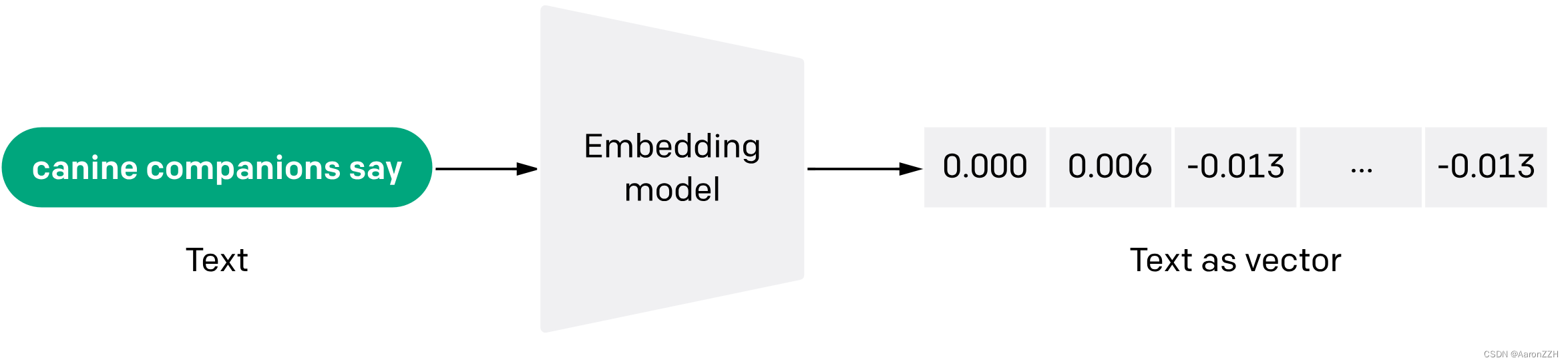

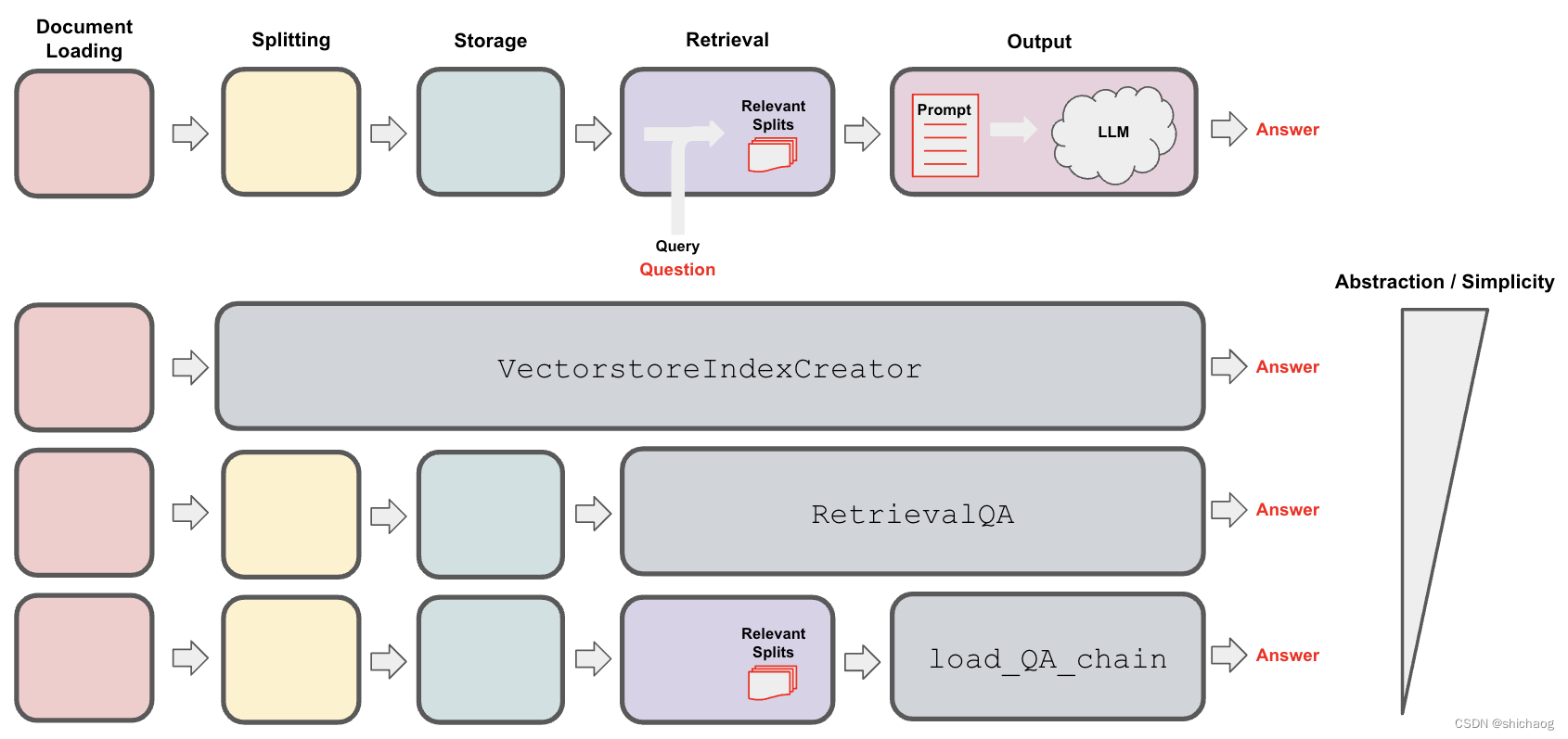

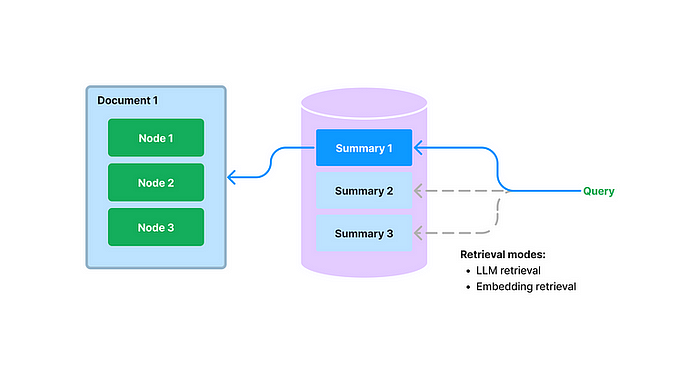

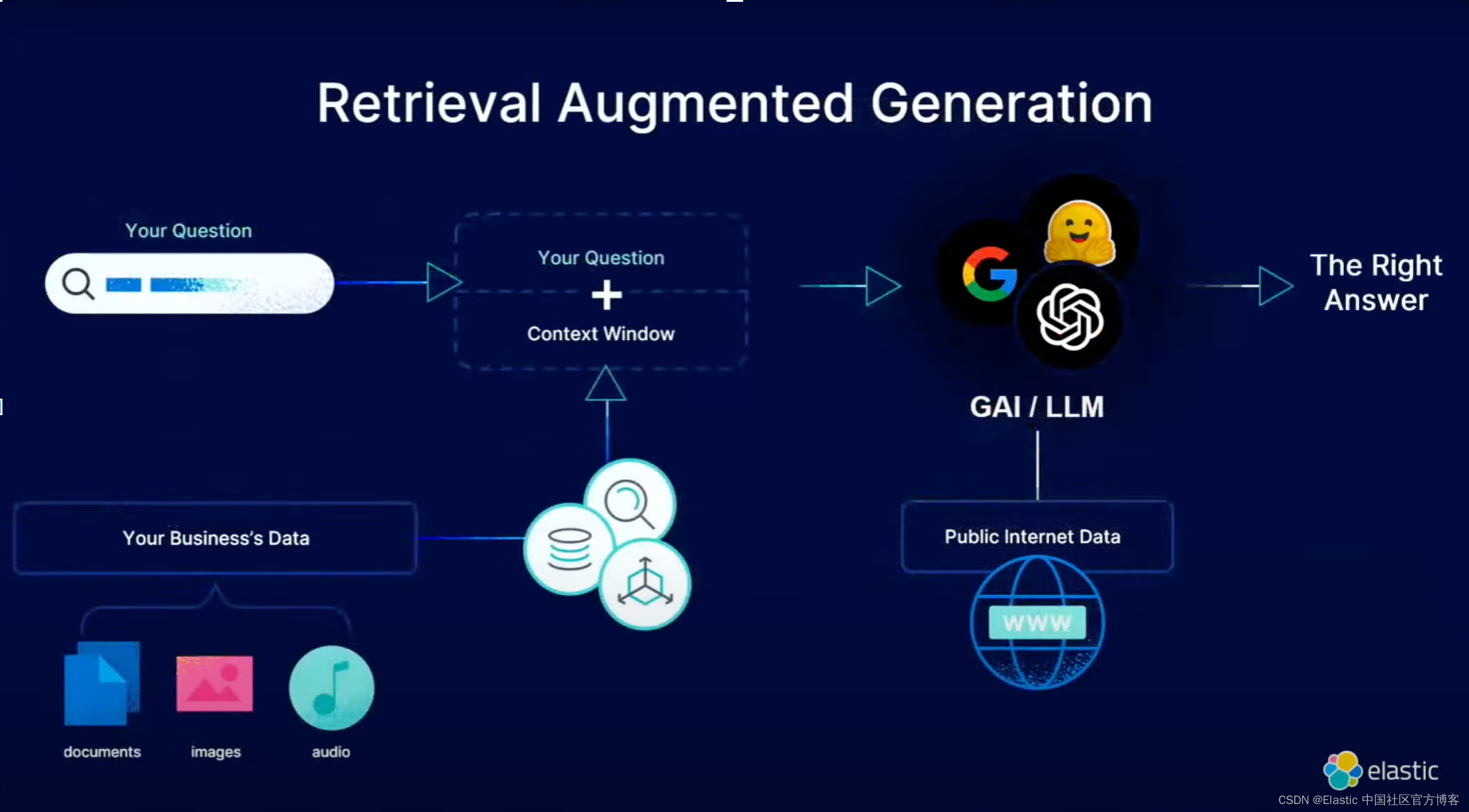

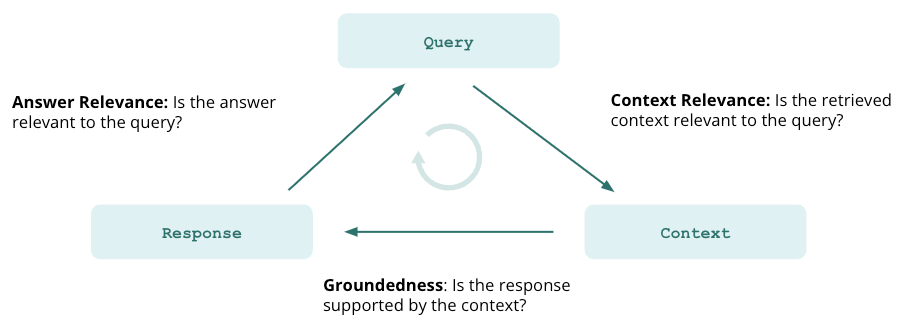

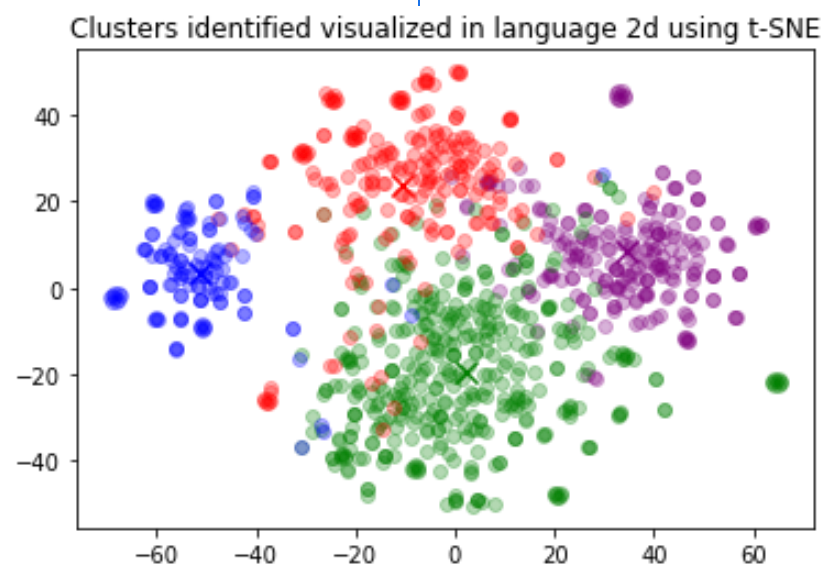

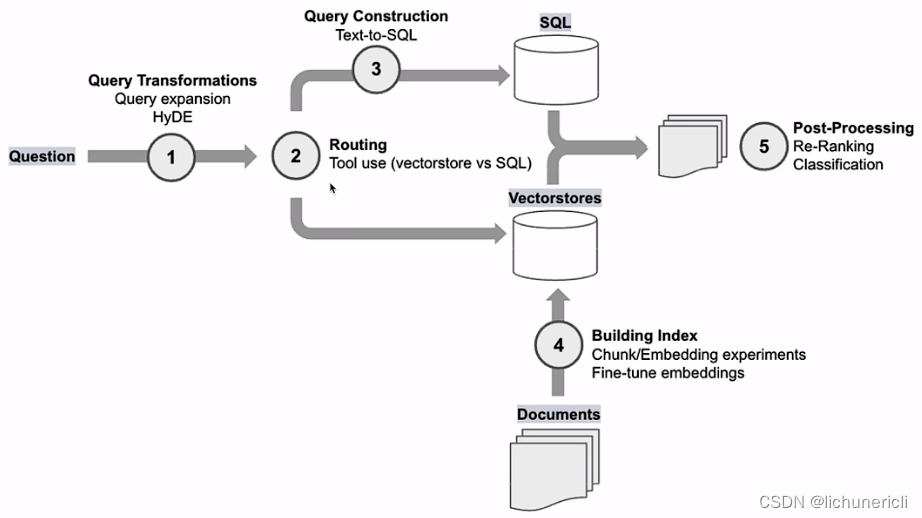

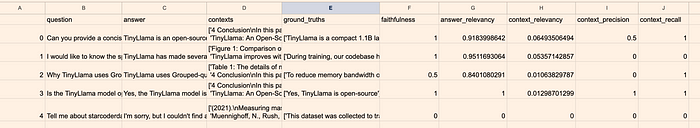

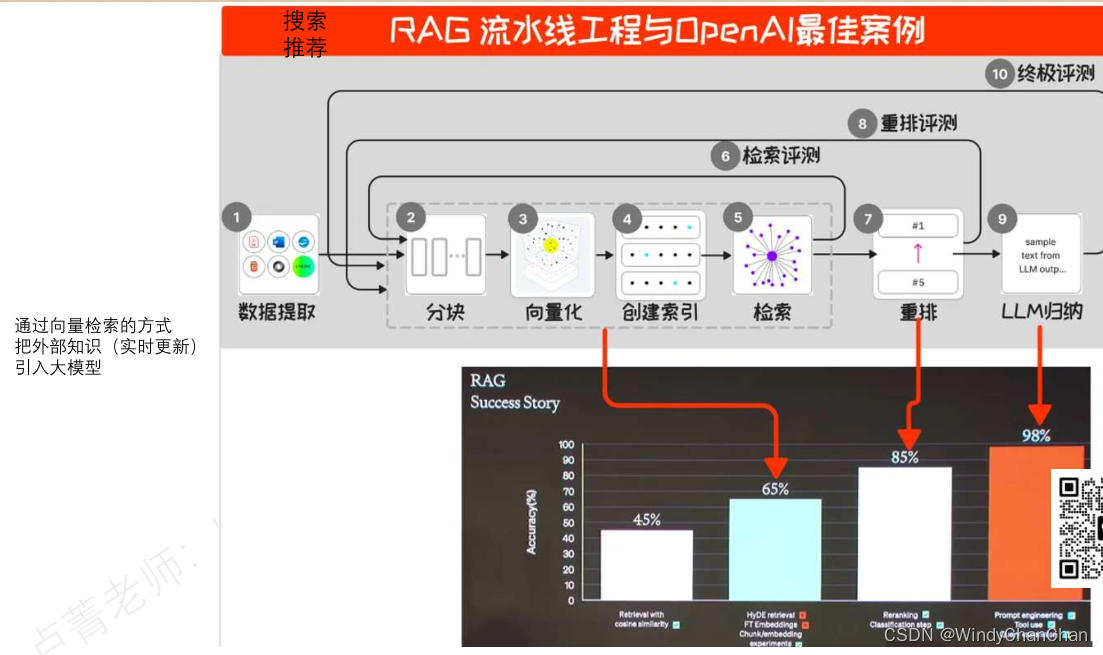

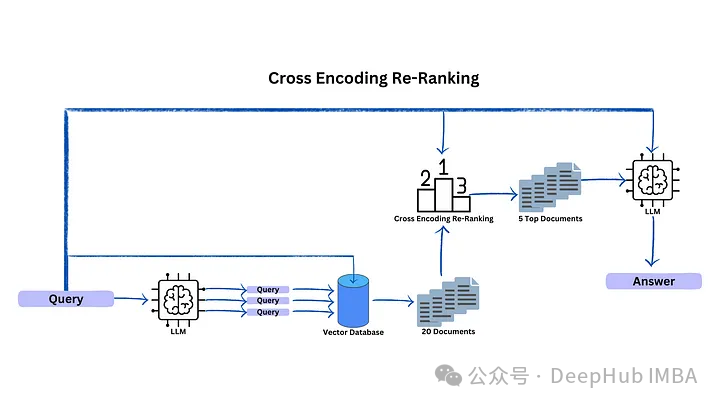

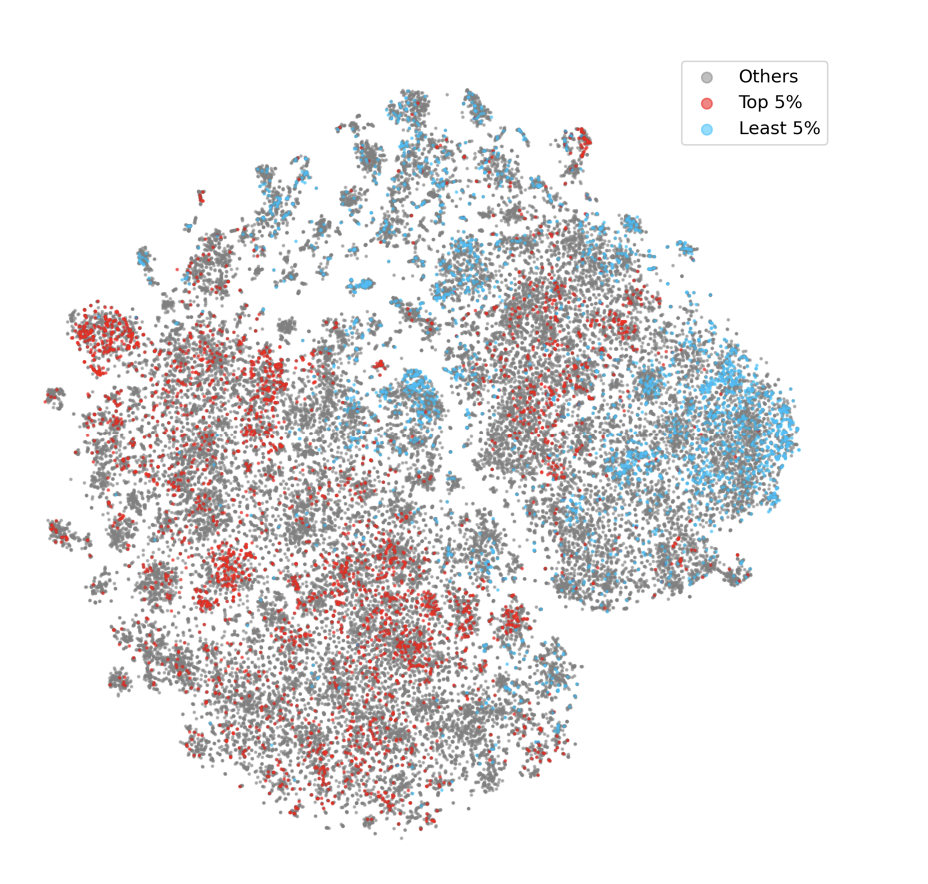

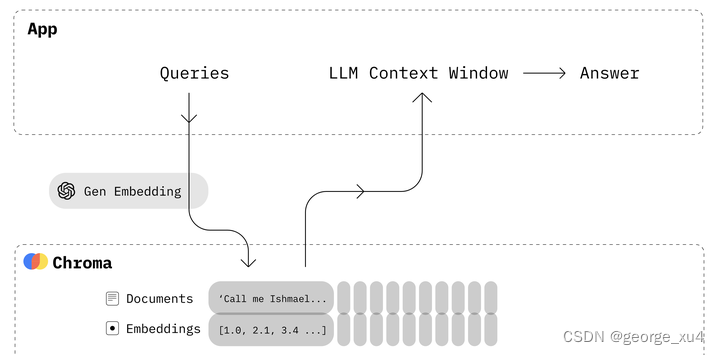

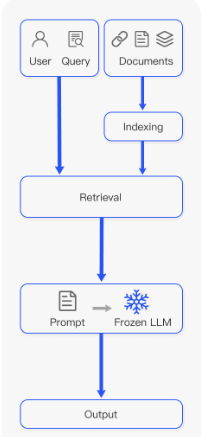

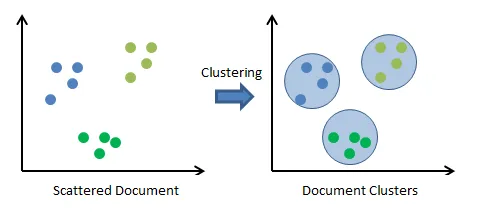

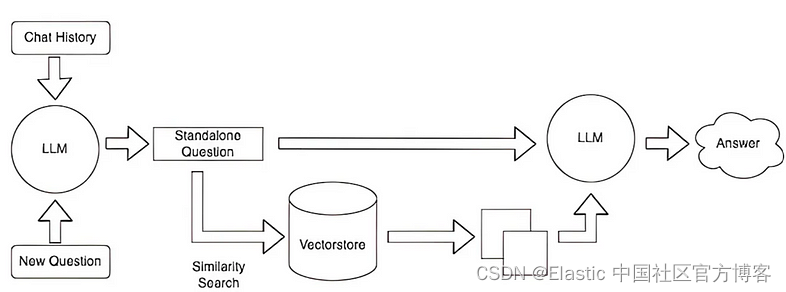

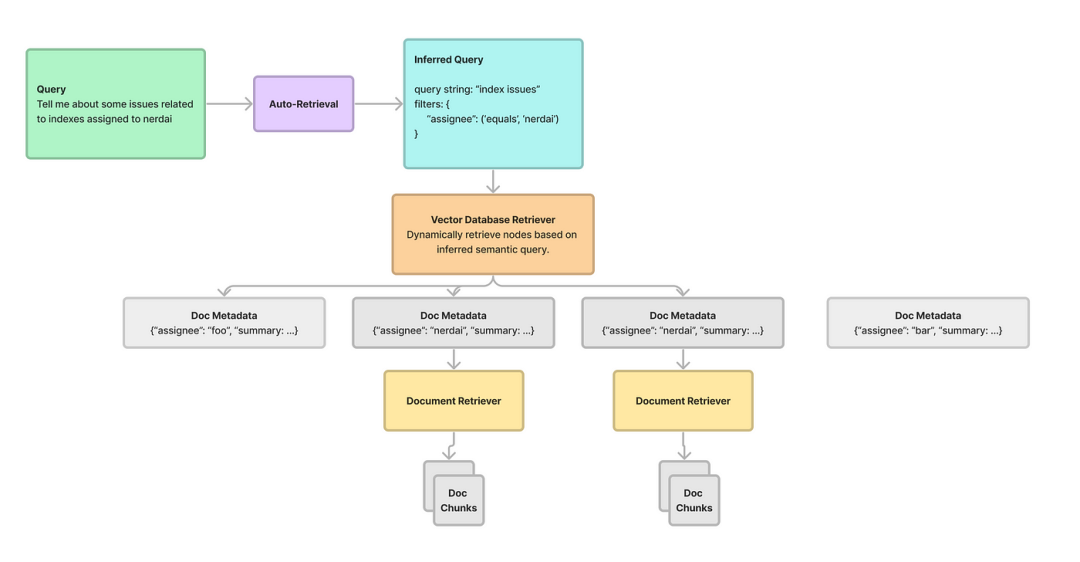

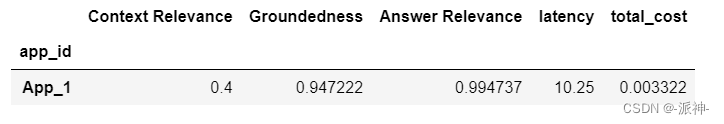

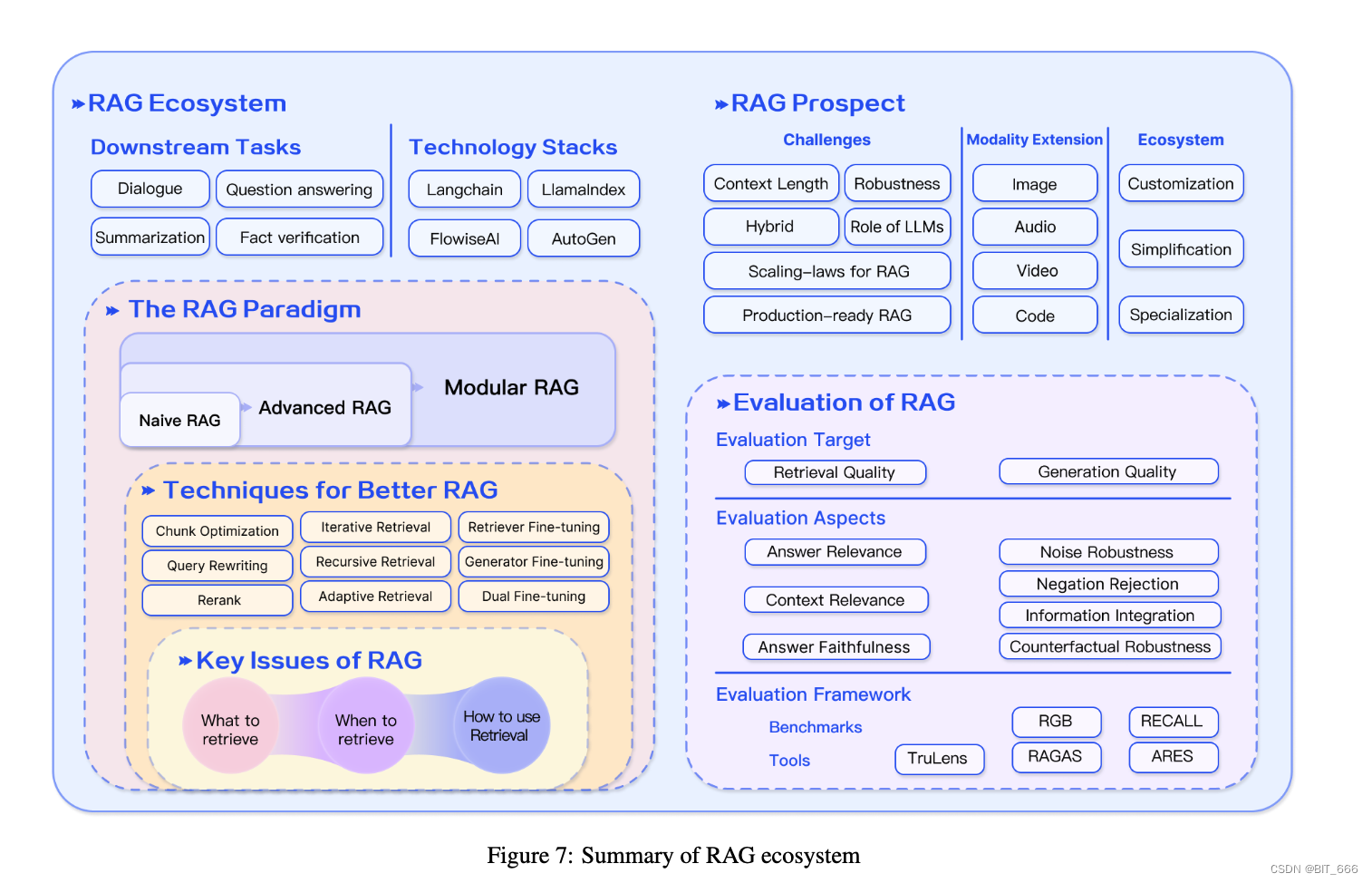

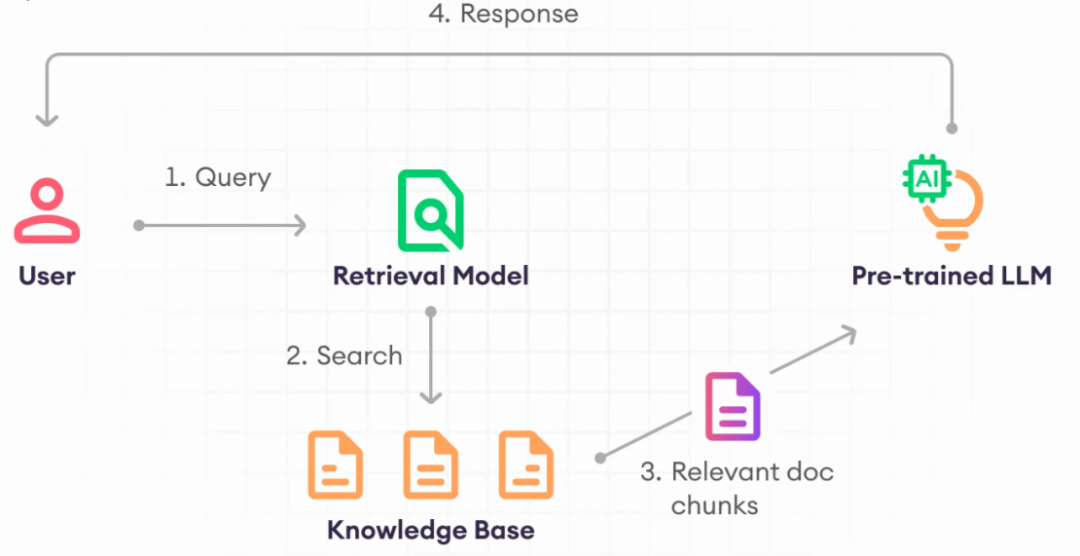

如何提高RAG增强的准确性

在一个典型的RAG应用开发中,必要的步骤为文档加载,文档拆分,向量化,向量存储。然后基于向量存储进行相似性查询,或基于向量距离的查询。这类查询就叫检索,LangChain所提供的对应组件就是检索器。

但这种方…

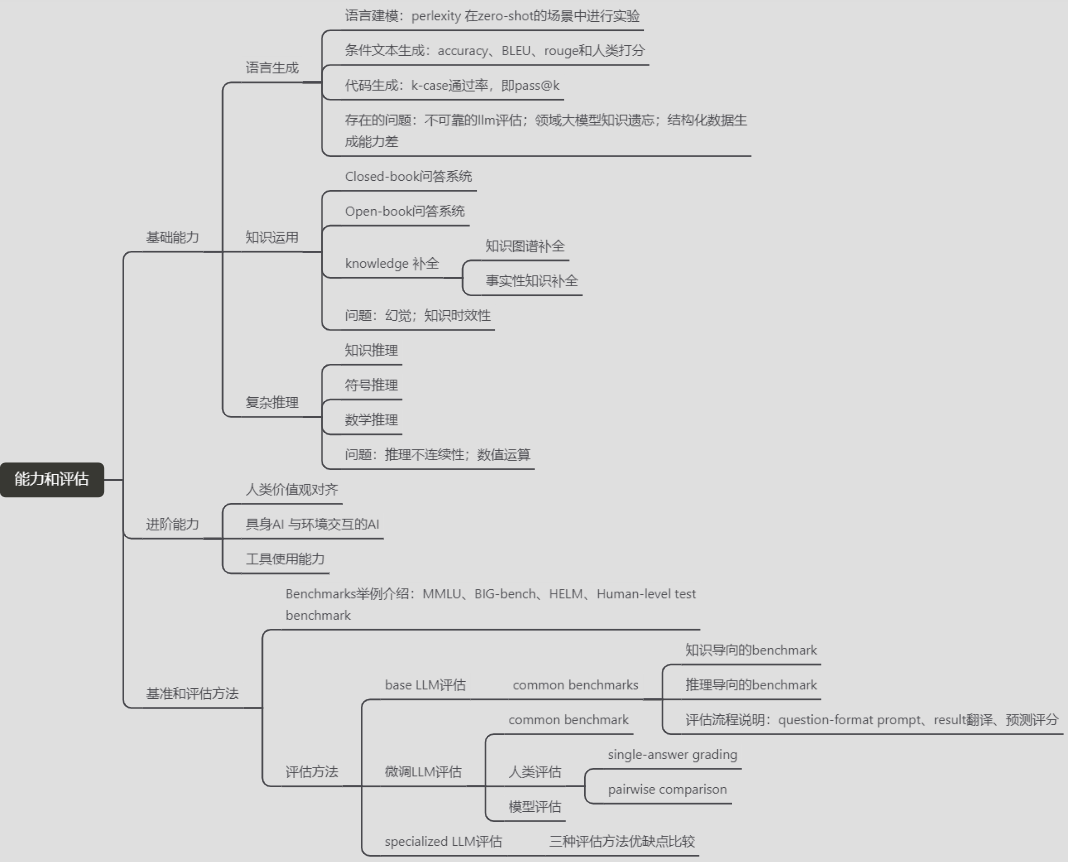

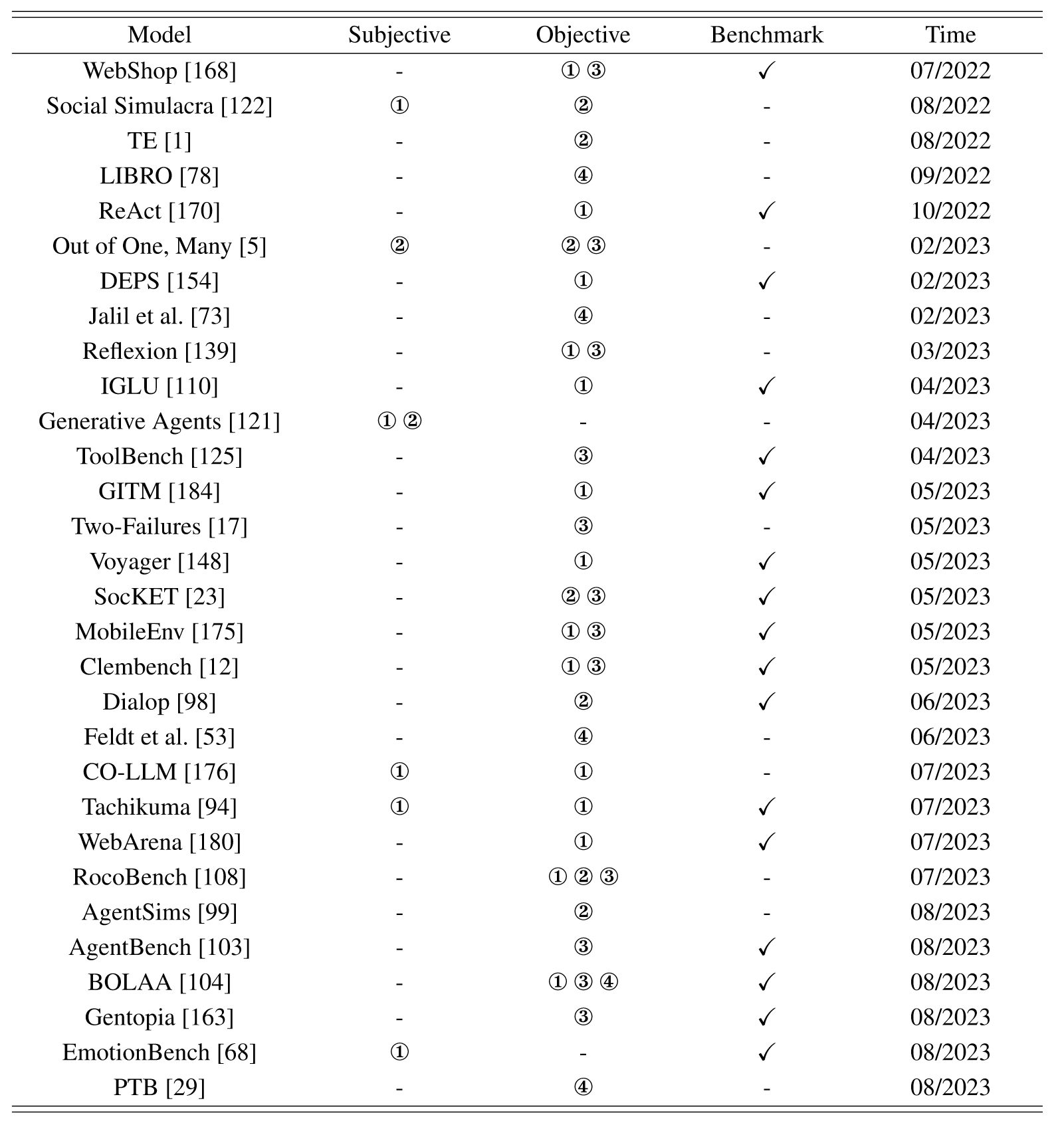

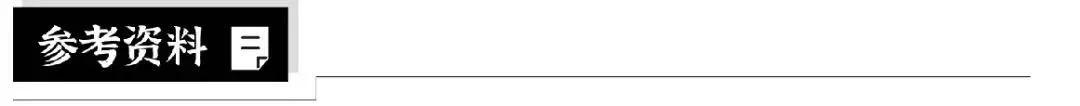

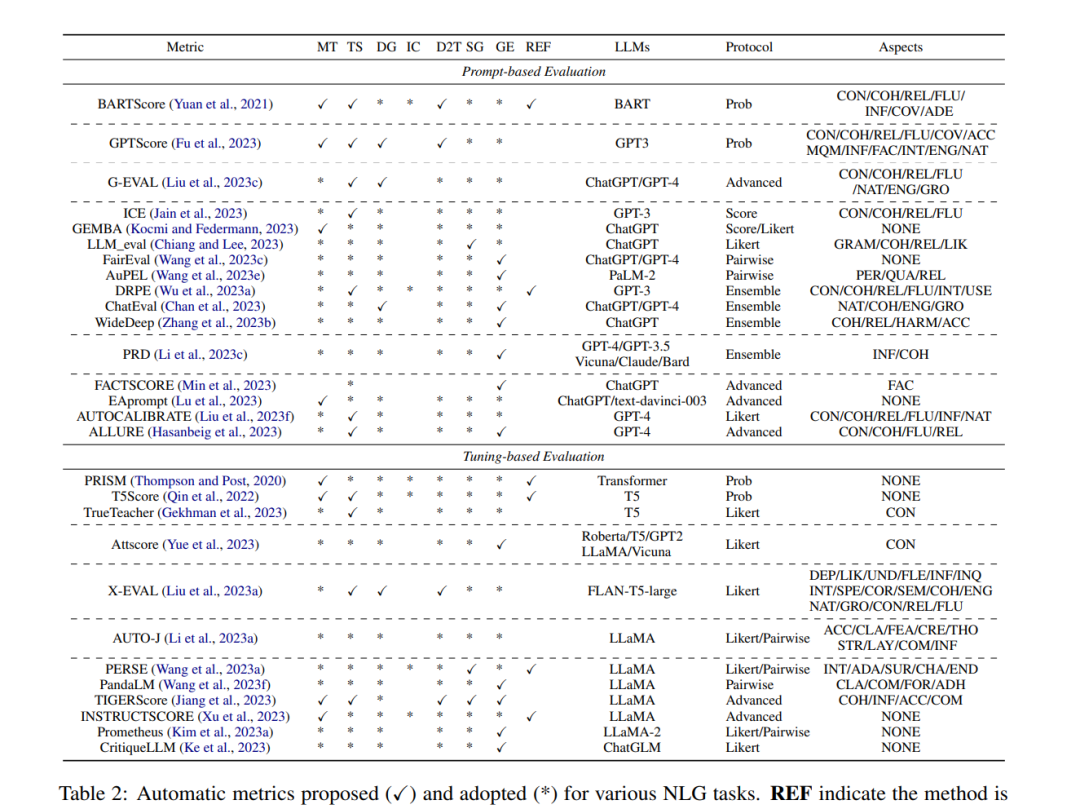

评估大型语言模型:综述

论文地址:https://arxiv.org/pdf/2310.19736v2.pdf

github: tjunlp-lab/awesome-llms-evaluation-…

发表团队:Tianjin University 摘要

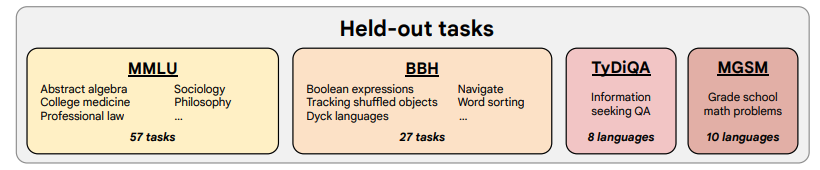

将LLM评估划分三点:知识和能力评估、一致性评估和安全性评估。特定领域化评估benchmark评…

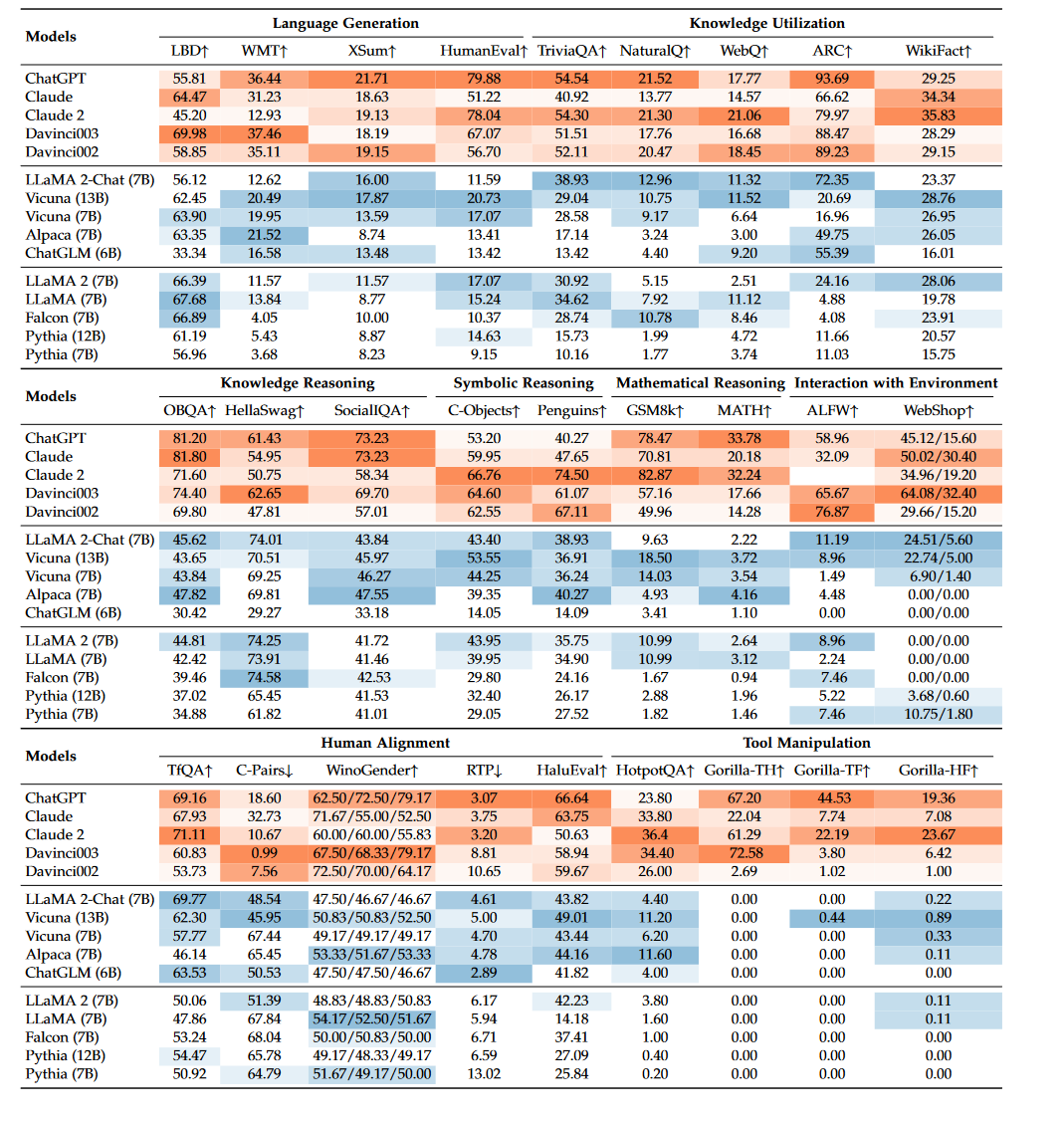

采用 guidance 提高大模型输出的可靠性和稳定性

本文首发于博客 LLM 应用开发实践 在复杂的 LLM 应用开发中,特别涉及流程编排和多次 LLM 调用时,每次的 Prompt 设计都取决于前一个步骤的大模型输出。如何避免大语言模型的"胡说八道",以提高大语言模型输出的可靠性和稳定性&#…

拓世AIGC | 大语言模型螺旋上升式进化,人文、技术与未来

本月初,上海世博园举办外滩大会见解论坛中,众多学者和企业家共同探讨了大语言模型时代的人机关系、硅基生命和碳基生命未来之争等议题。面对全新的局面,论坛释放出积极信号和值得持续关注的论点。从黄浦江的波涛翻涌,我们捕捉到了…

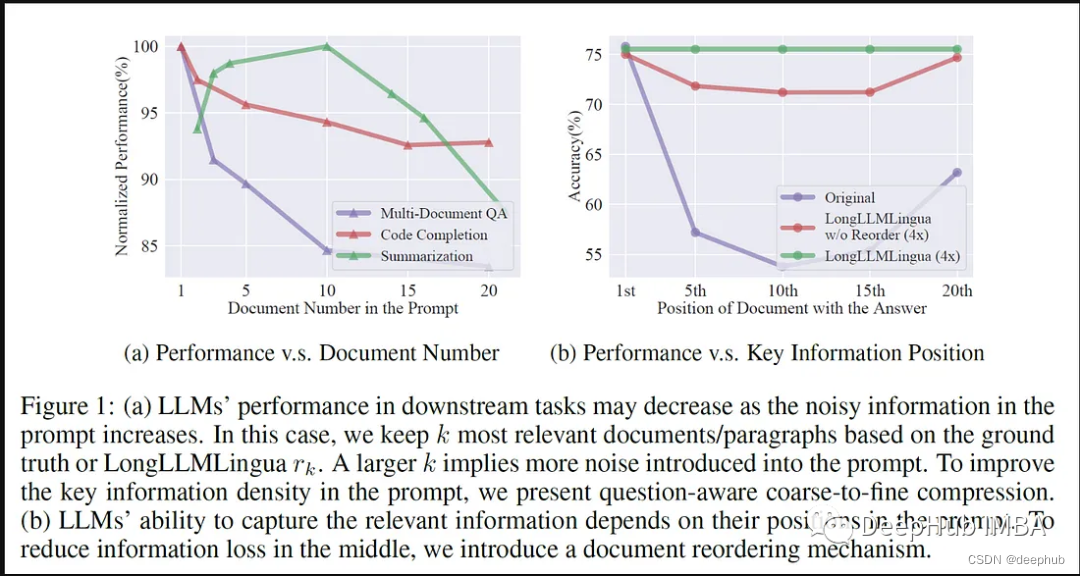

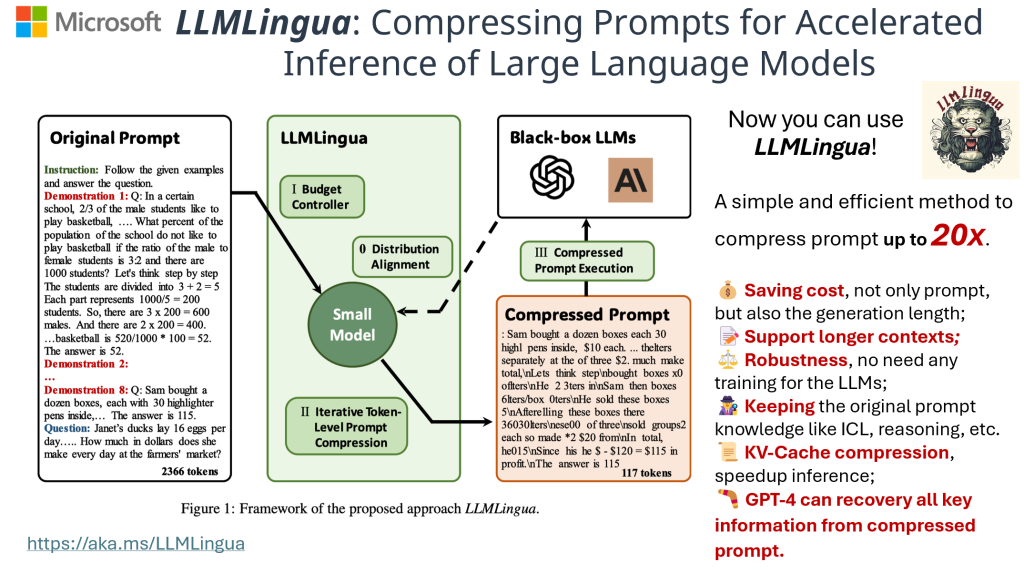

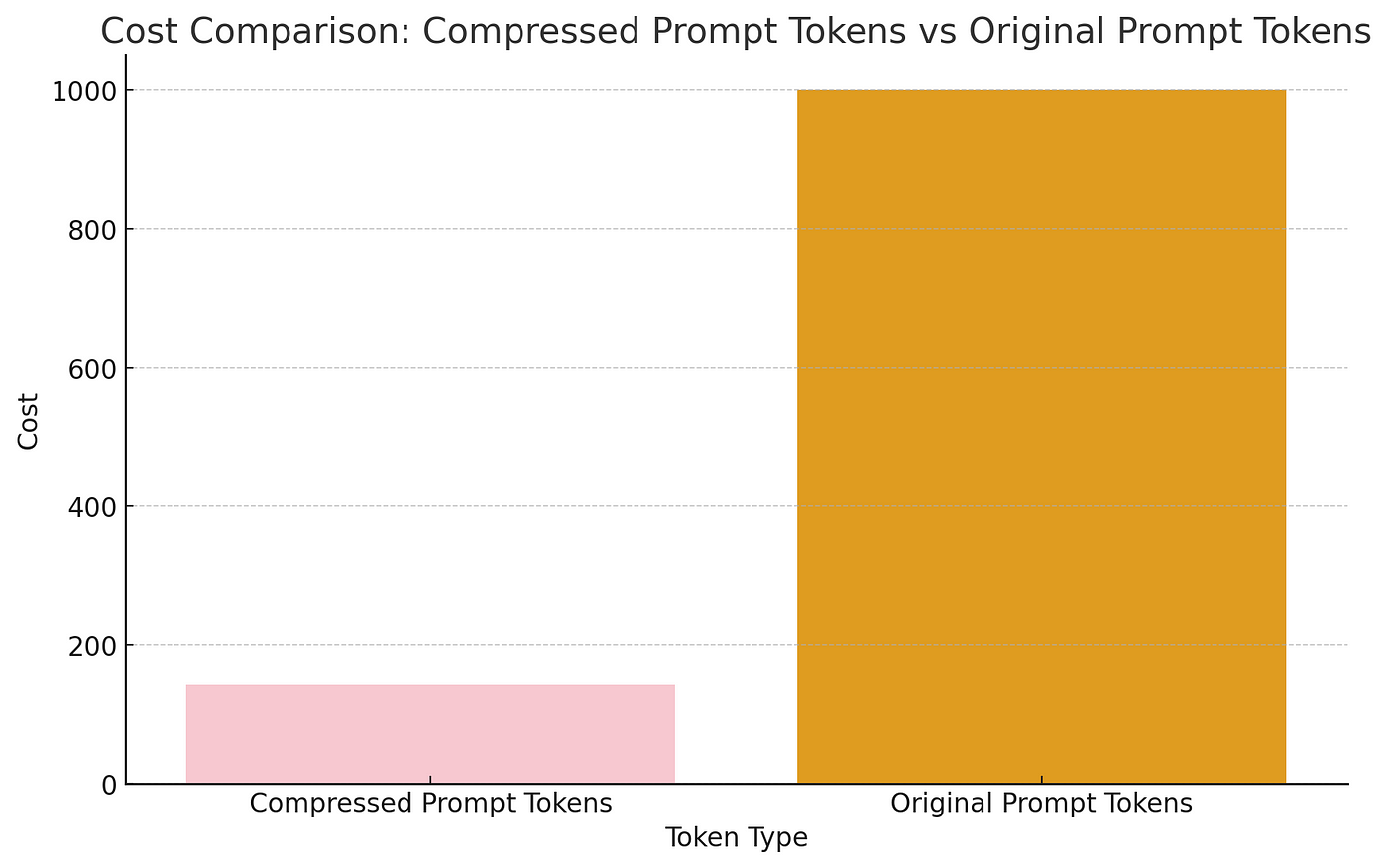

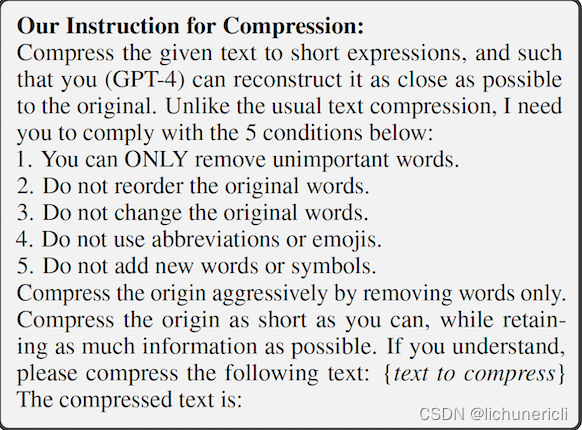

LLMLingua:集成LlamaIndex,对提示进行压缩,提供大语言模型的高效推理

大型语言模型(llm)的出现刺激了多个领域的创新。但是在思维链(CoT)提示和情境学习(ICL)等策略的驱动下,提示的复杂性不断增加,这给计算带来了挑战。这些冗长的提示需要大量的资源来进行推理,因此需要高效的解决方案,本文将介绍LLM…

Elasticsearch:FMA 风格的向量相似度计算

作者:Chris Hegarty 在 Lucene 9.7.0 中,我们添加了利用 SIMD 指令执行向量相似性计算的数据并行化的支持。 现在,我们通过使用融合乘加 (Fused Mulitply-Add - FMA) 进一步推动这一点。 什么是 FMA

乘法和加法是一种常见的运算,…

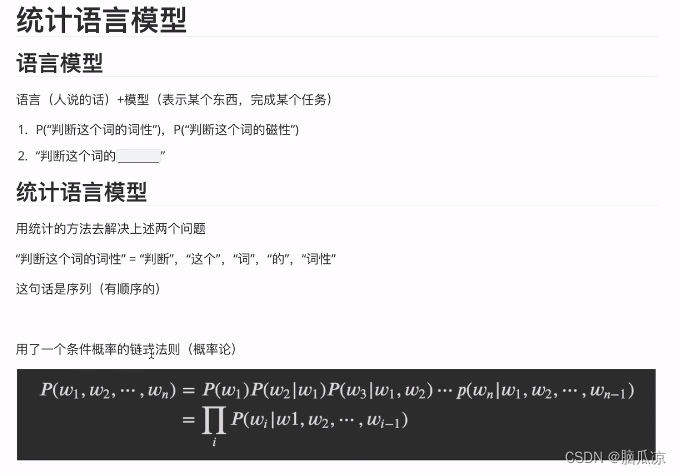

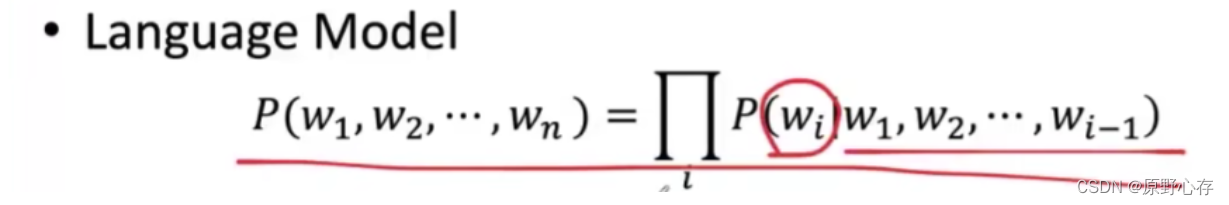

NLP_什么是统计语言模型_条件概率的链式法则_n元统计语言模型_马尔科夫链_统计语言模型的平滑策略---人工智能工作笔记0035

https://www.cnblogs.com/nickchen121/p/16470569.html#tid-458p3Y

参考这个文档学习

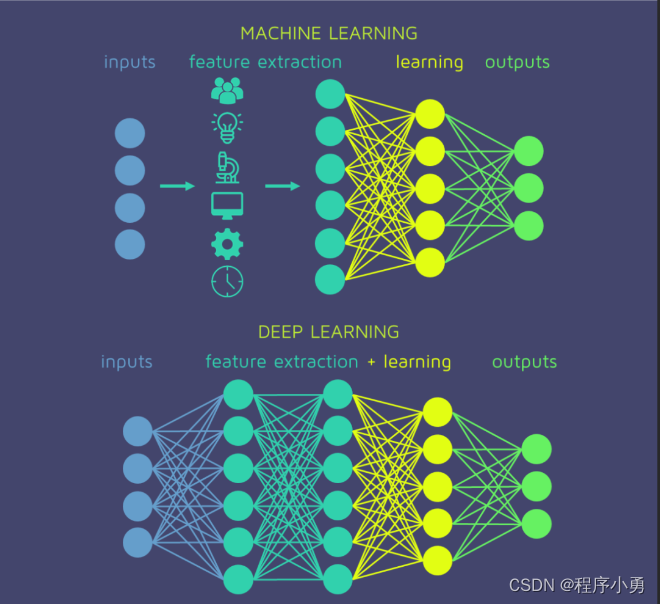

条件概率的链式法则:这个是需要去补充的知识. 首先我们来看一下上一节说到的预训练,可以看到,我们比如有个鹅鸭的分类问题,

这个鹅鸭分类我们是用10万张图片训练的模型,这个已经可以把这个…

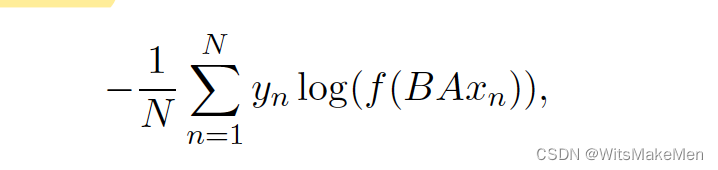

Bag of Tricks for Efficient Text Classification(FastText)

主要的有点就是快,用途就是用于文本分类,模型结构如上,主要是通过embedding将文本转换成向量,然后进行mean-pooling,然后输入到hidden隐向量中,通过softmax输出多分类,损失函数是对数似然损失函…

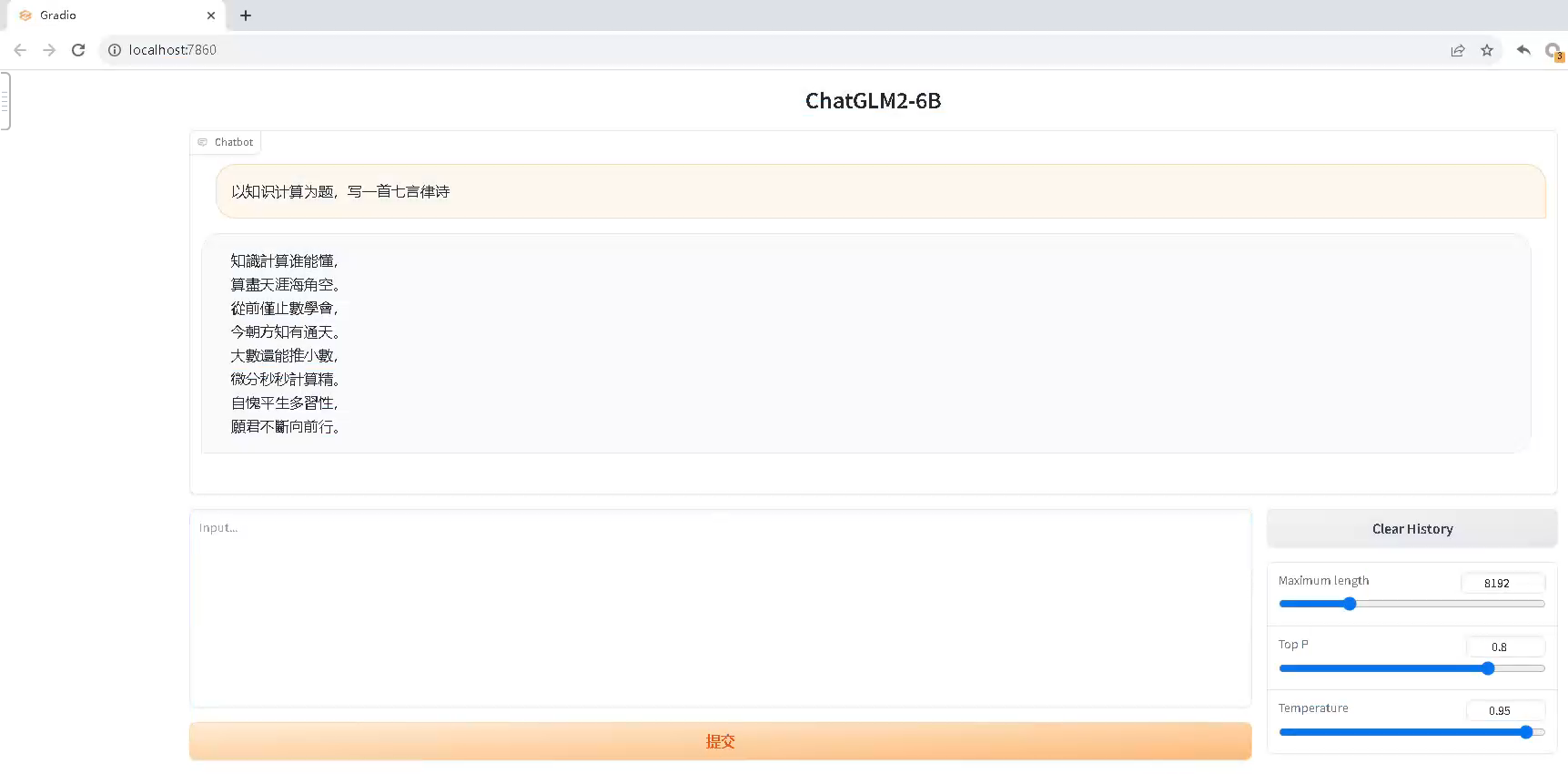

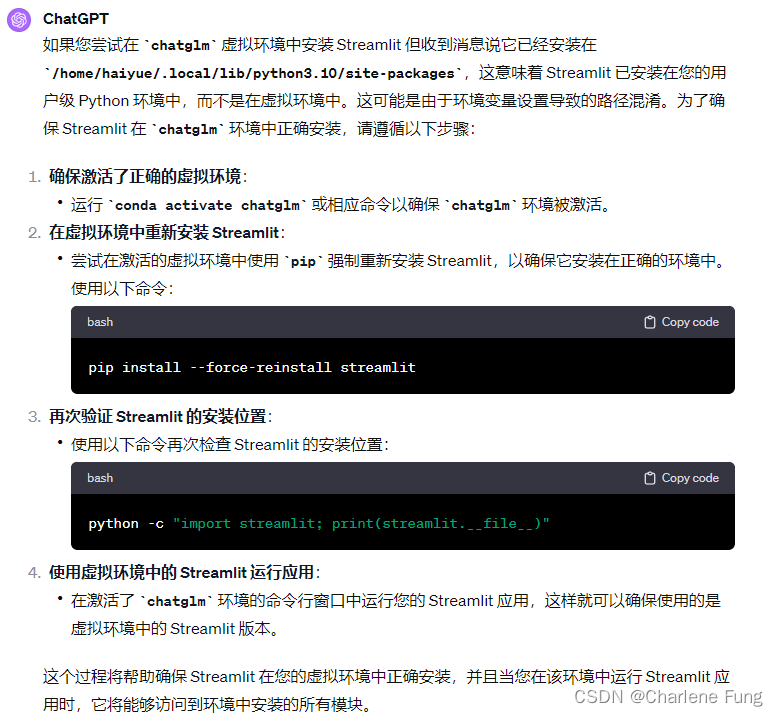

ChatGLM2-6B下载与部署

0 写在前面

我们首先来看一下ChatGLM2-6B模型的requirements:

protobuf

transformers4.30.2

cpm_kernels

torch>2.0

gradio

mdtex2html

sentencepiece

accelerate

sse-starlette

streamlit>1.24.0可以看到,要求torch>2.0,这就产生了一个问题&…

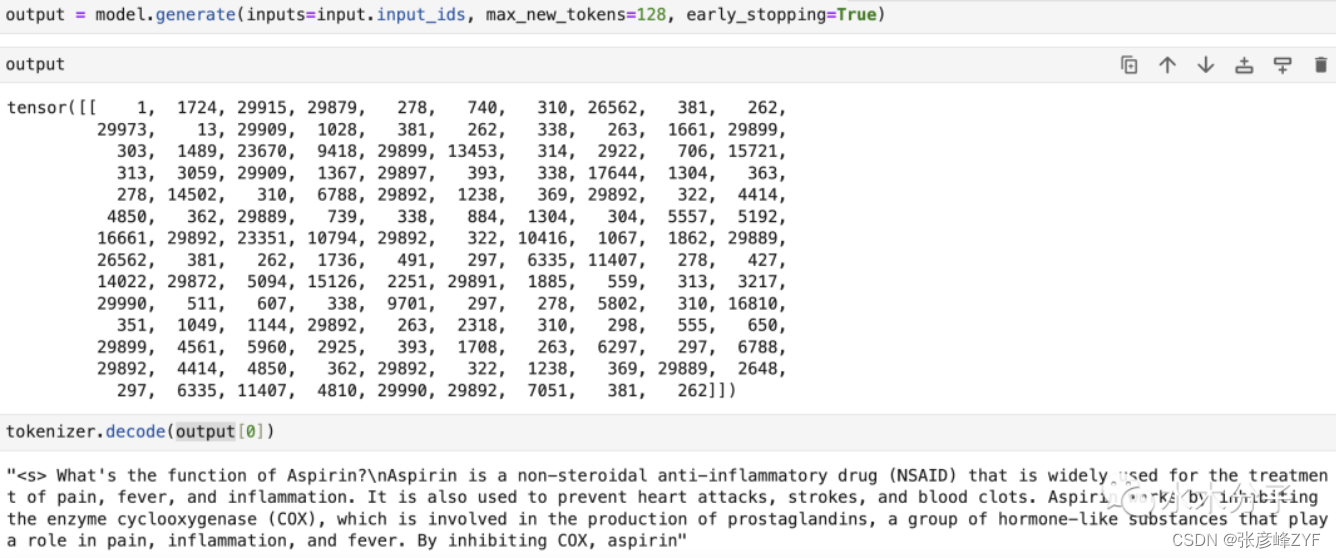

【通意千问】大模型GitHub开源工程学习笔记(3)-- 通过Qwen预训练语言模型自动完成给定的文本

摘要:

本笔记分析了使用预训练的模型生成文本的示例代码。它的步骤如下: 使用已加载的分词器 tokenizer 对输入文本进行处理,转换为模型可以理解的格式。输入文本是国家和首都的信息,最后一句是未完成的,需要模型来生成。将处理后的输入转移到模型所在的设备上(例如GPU或…

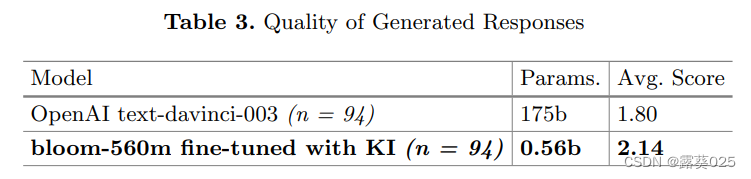

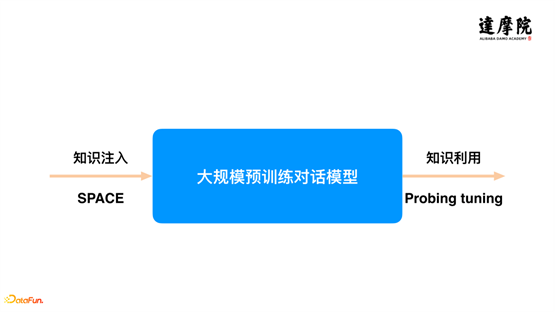

知识注入以对抗大型语言模型(LLM)的幻觉11.6

知识注入以对抗大型语言模型(LLM)的幻觉 摘要1 引言2 问题设置和实验2.1 幻觉2.2 生成响应质量 3 结果和讨论3.1 幻觉3.2 生成响应质量 4 结论和未来工作 摘要

大型语言模型(LLM)内容生成的一个缺点是产生幻觉,即在输…

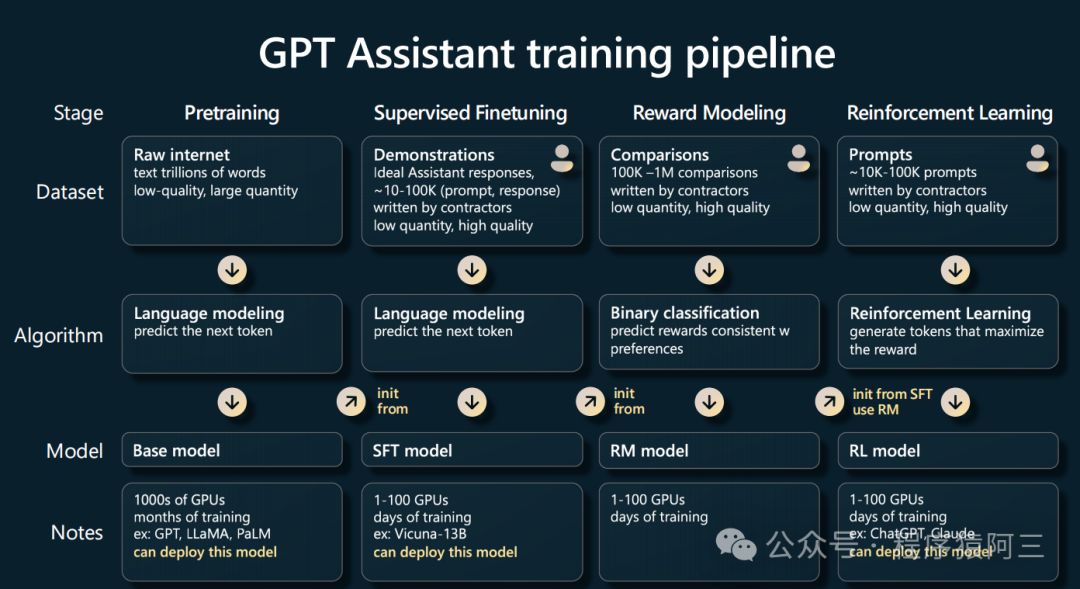

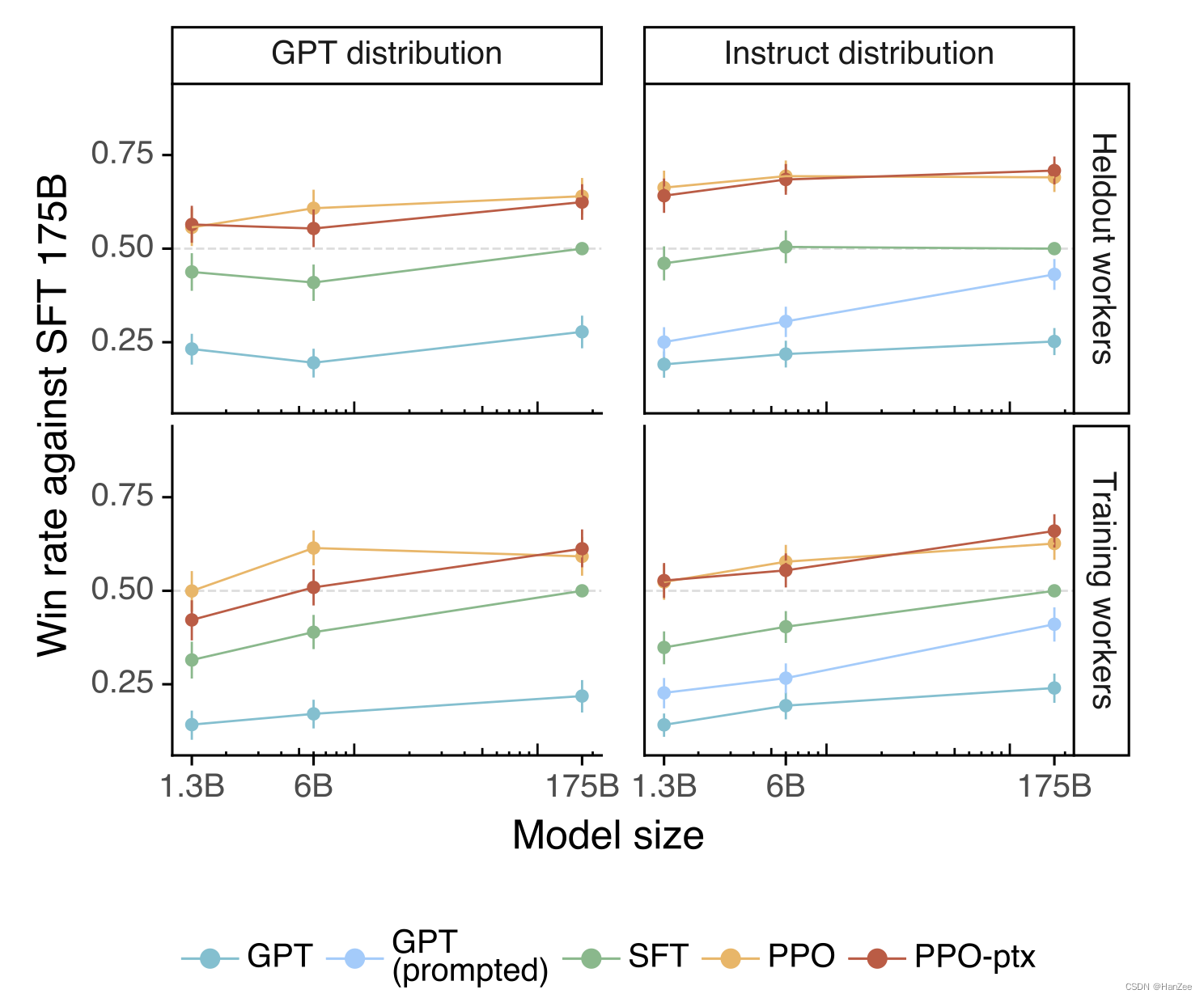

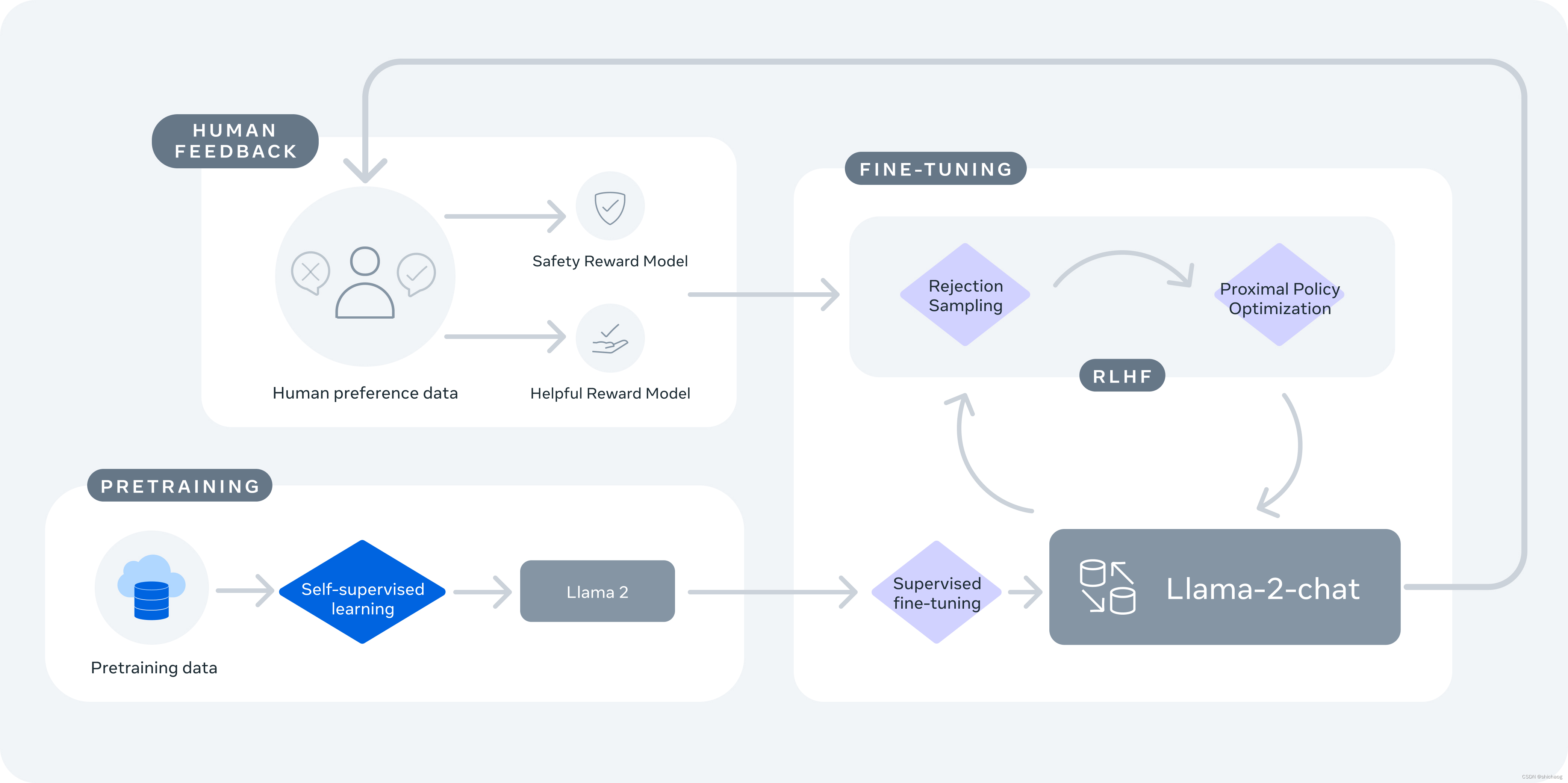

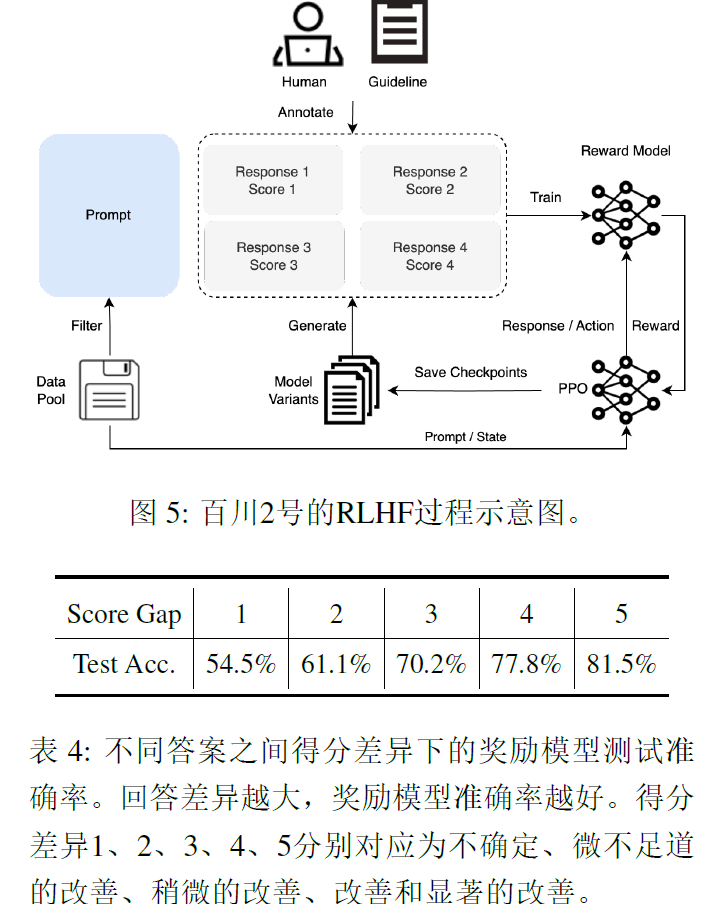

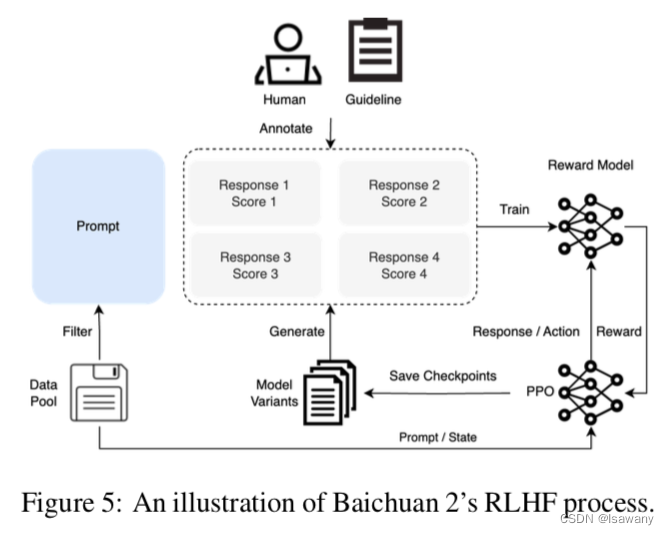

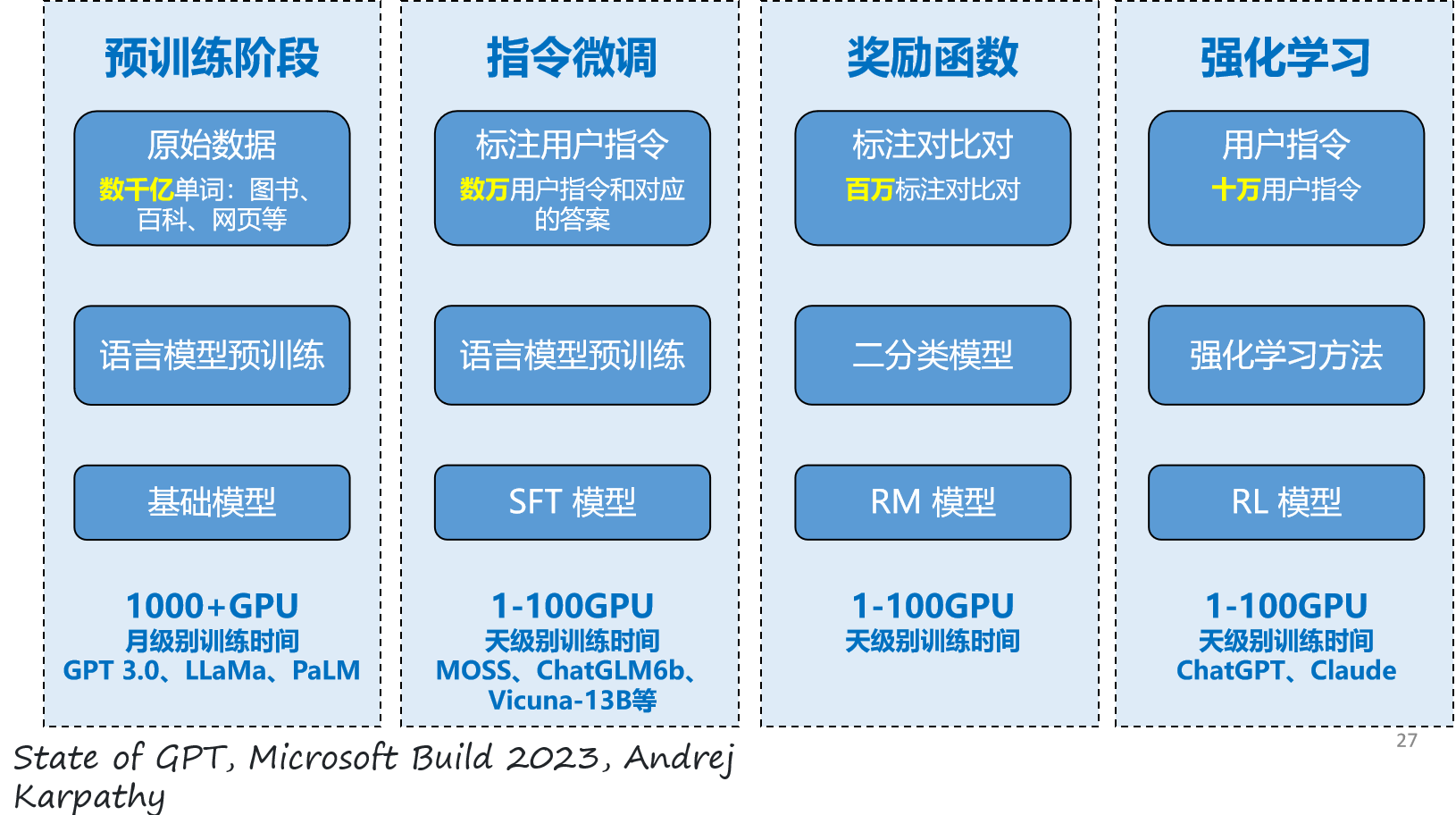

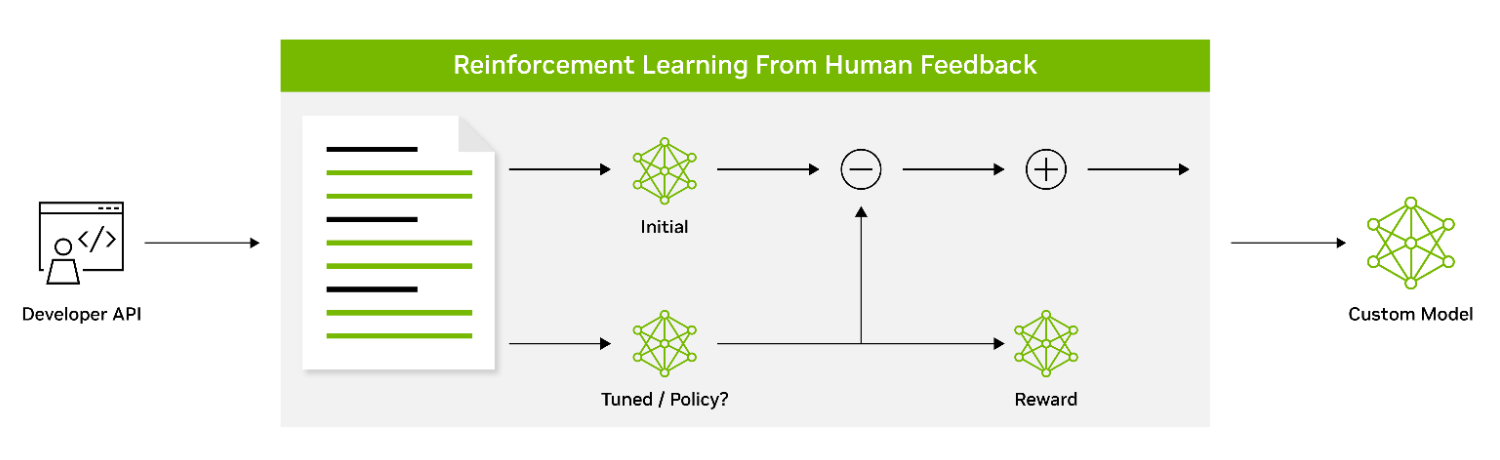

谷歌研究科学家:ChatGPT秘密武器的演进与局限

来源|TalkRL OneFlow编译 翻译|徐佳渝、贾川 同样是基于GPT预训练模型,为什么ChatGPT的效果要远远超出GPT-3等前几代模型?答案已经揭晓,成就ChatGPT的秘密武器在于RLHF,也就是人类反馈的强化学习。 在预训…

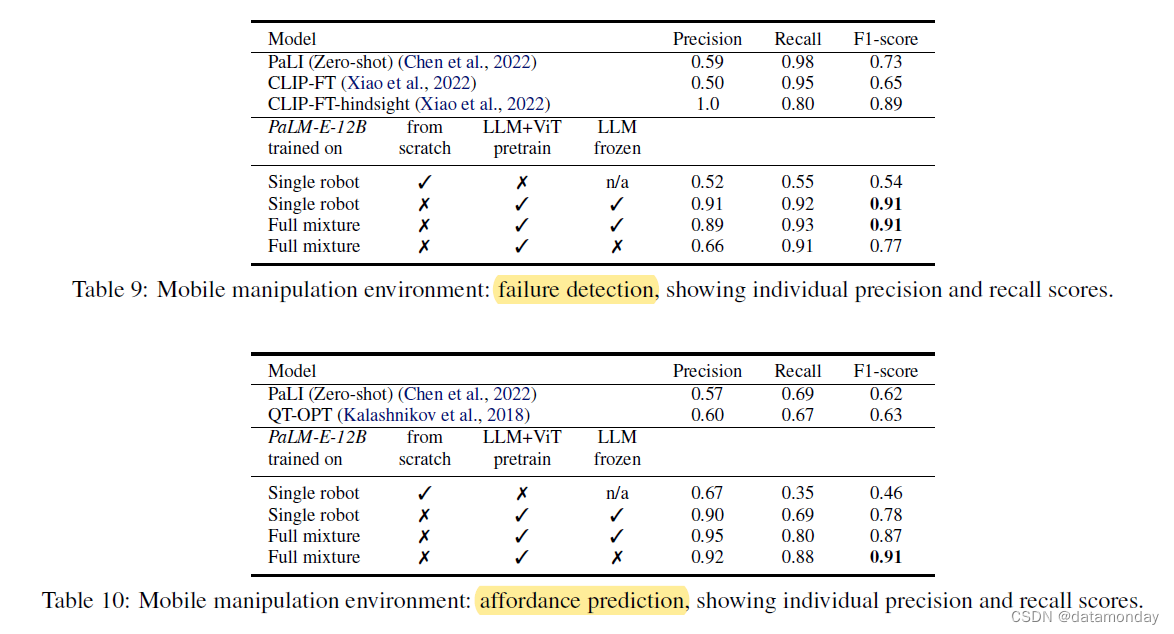

2023年03月09日_谷歌视觉语言模型PaLM-E的介绍

自从最近微软凭借OpenAI

和ChatGPT火了一把之后呢

老对手Google就总想着扳回一局

之前发布了硬刚ChatGPT的Bard

但是没想到翻车了

弄巧成拙 所以呢Google这一周又发了个大招

发布了史上最大的视觉语言模型PaLM-E

这个模型有多夸张呢

参数量高达5,620亿

是ChatGTP-3的三…

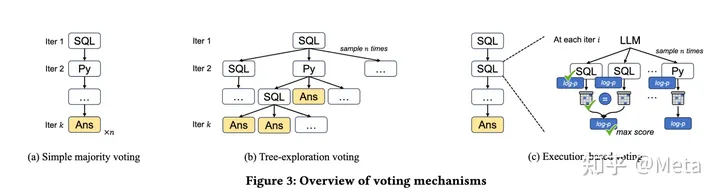

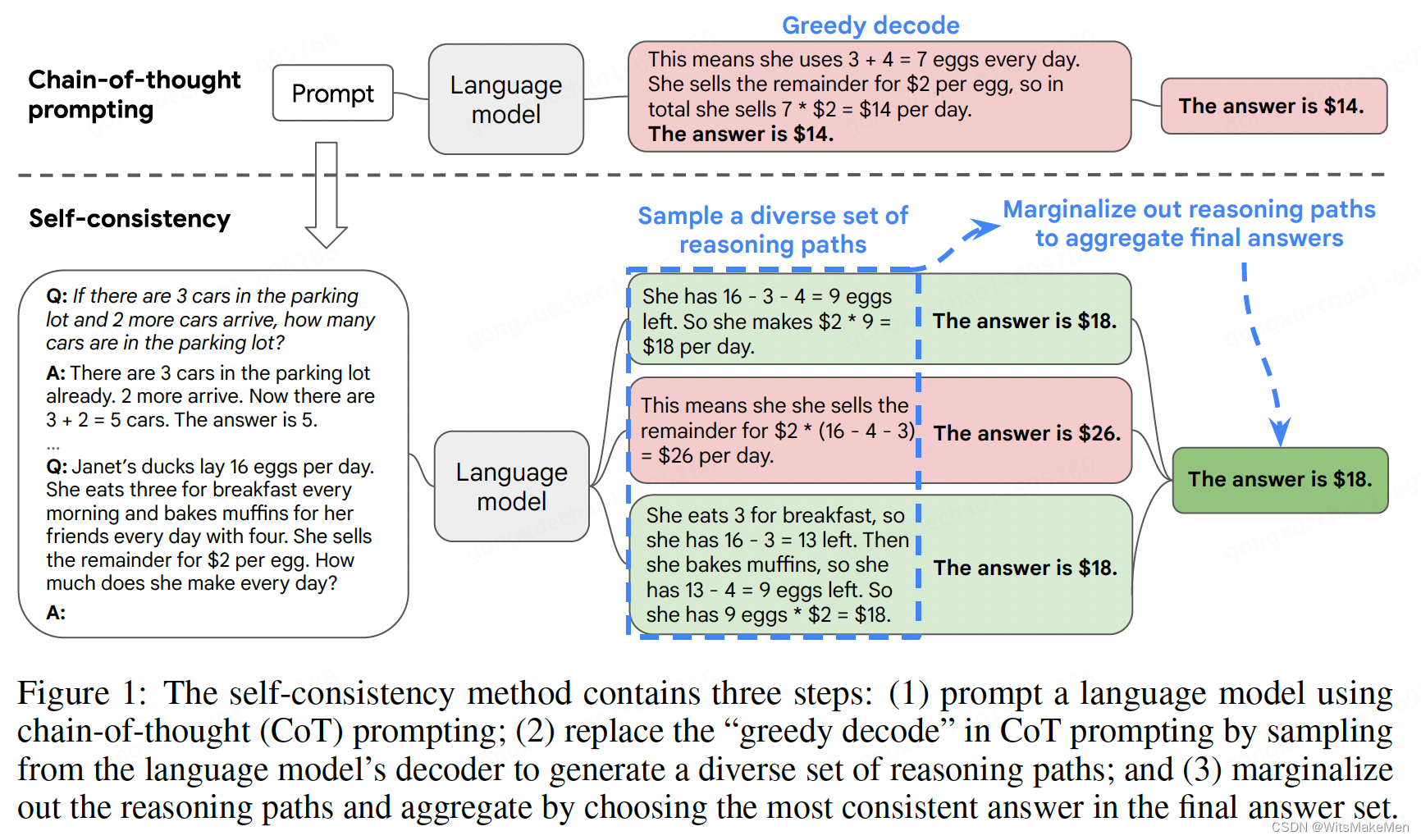

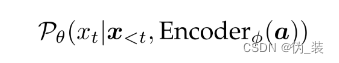

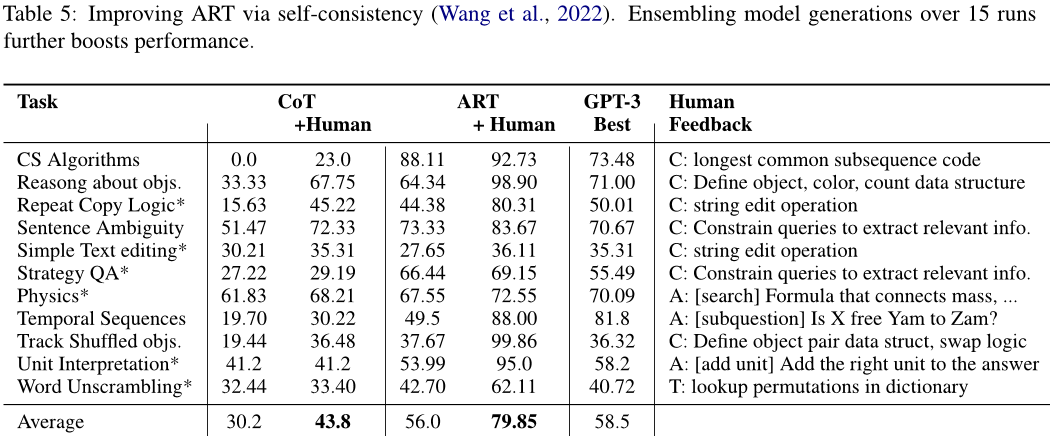

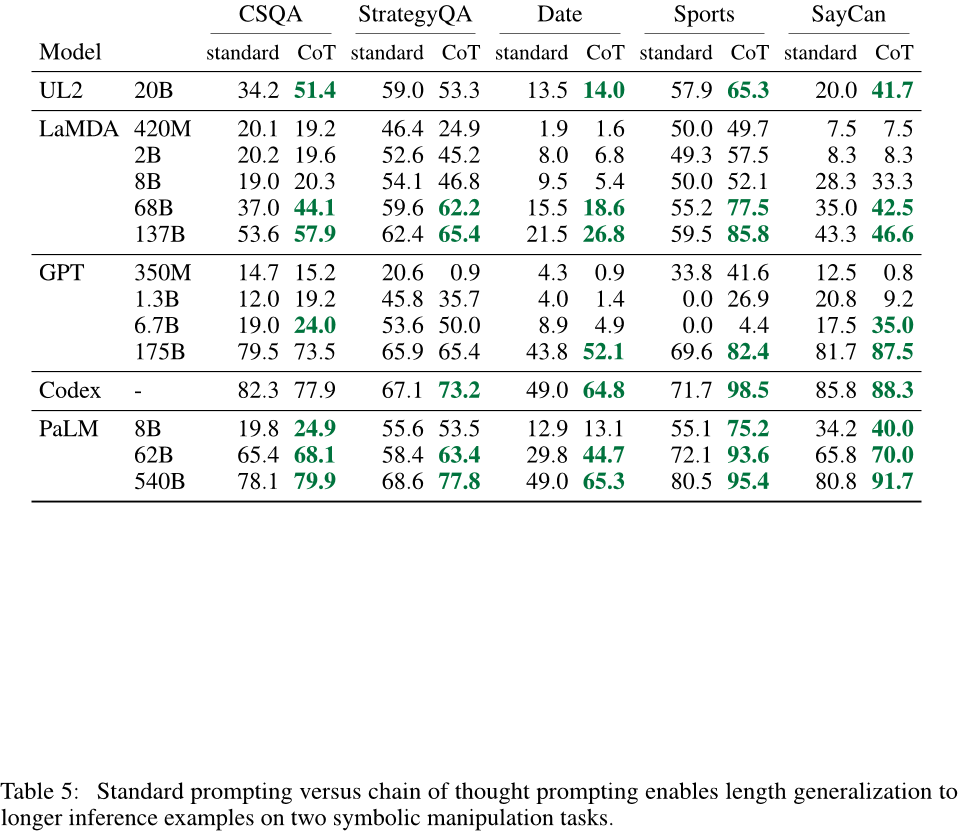

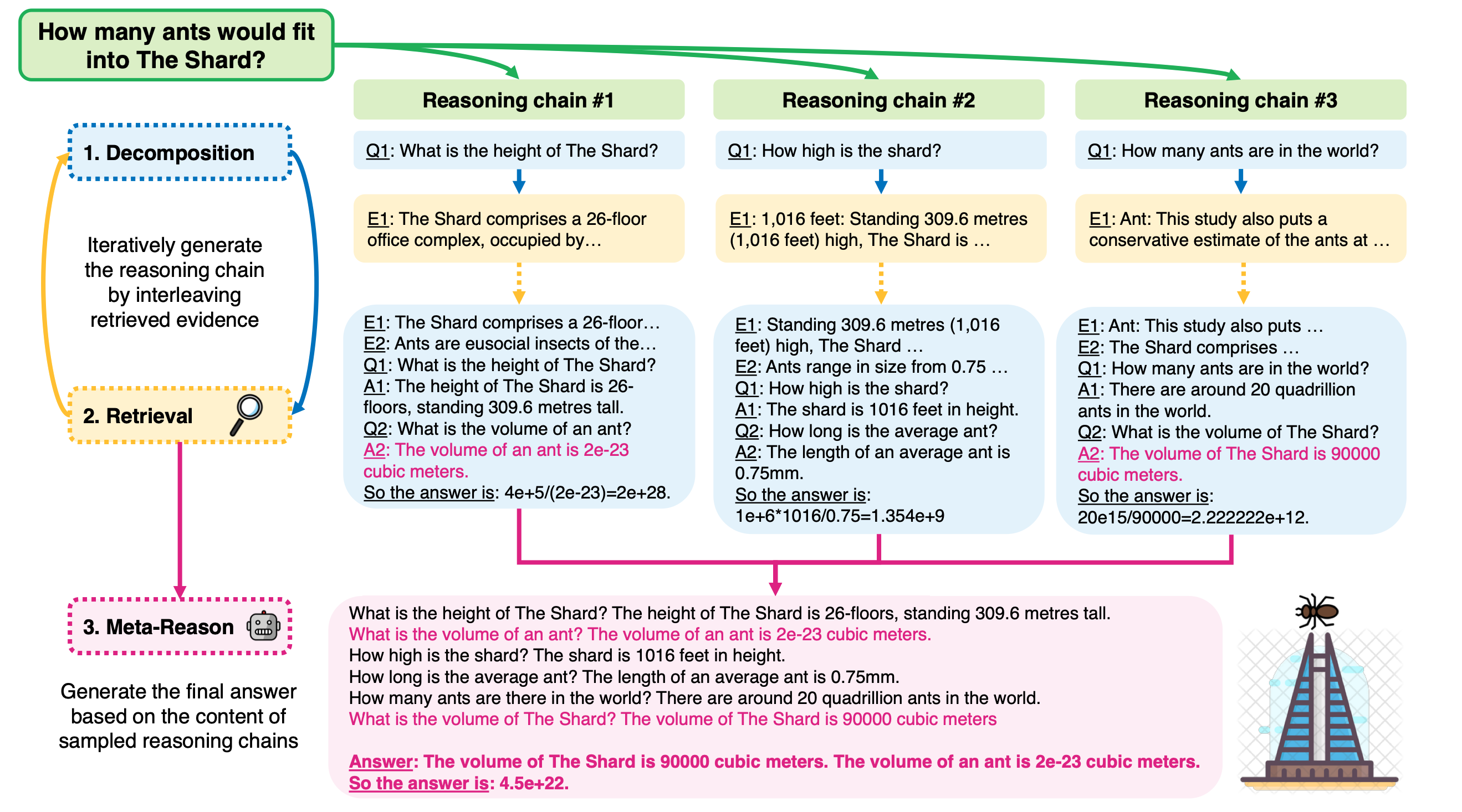

一致性思维链(SELF-CONSISTENCY IMPROVES CHAIN OF THOUGHT REASONING IN LANGUAGE MODELS)

概要

思维链已经在很多任务上取得了非常显著的效果,这篇论文中提出了一种 self-consistency 的算法,来代替 贪婪解码 算法。本方法通过 采样多个思维链集合,然后LLM模型生成后,选择一个最一致的答案作为最后的结果。一致性思维链…

大模型是怎么知道 “我赚了200万” 的?

今天在和 chatGPT 聊天时,我说“我赚了200万”,他立刻就根据这句话给我了一句。 我当然没有赚到200万,只是想引出一个话题:“大模型是如何识别出这句话,又是怎么知道该回答什么的呢?"

在学习自然语言…

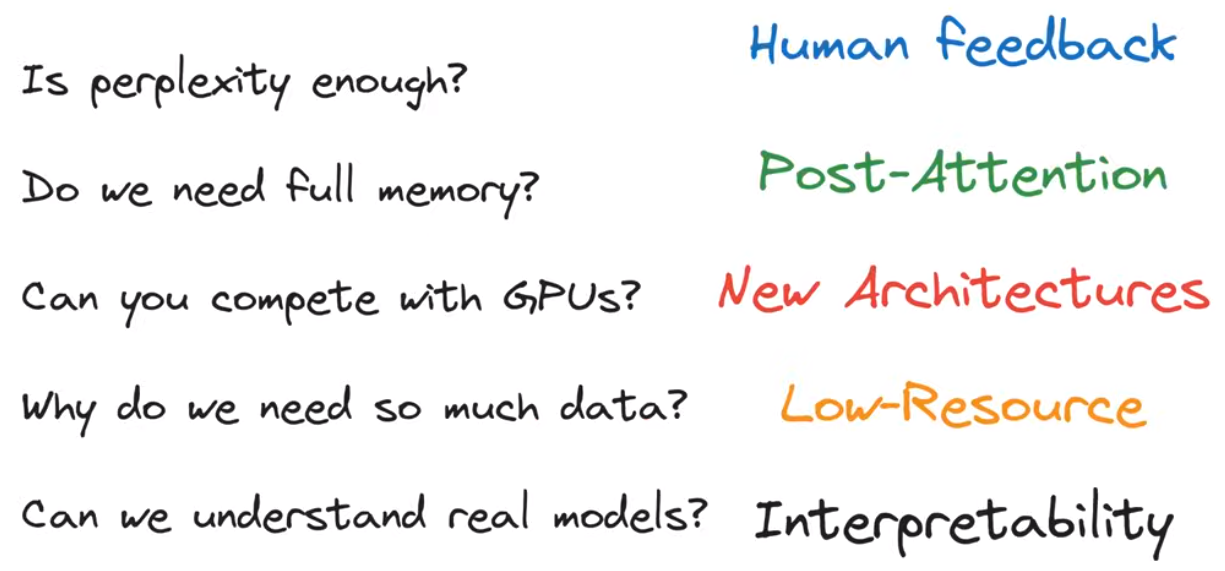

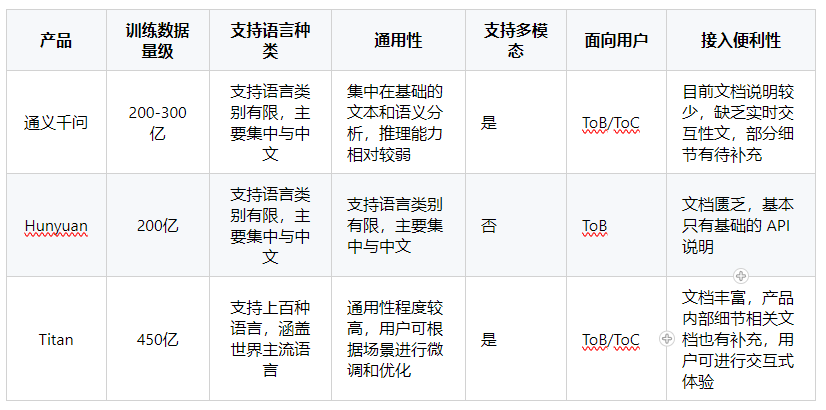

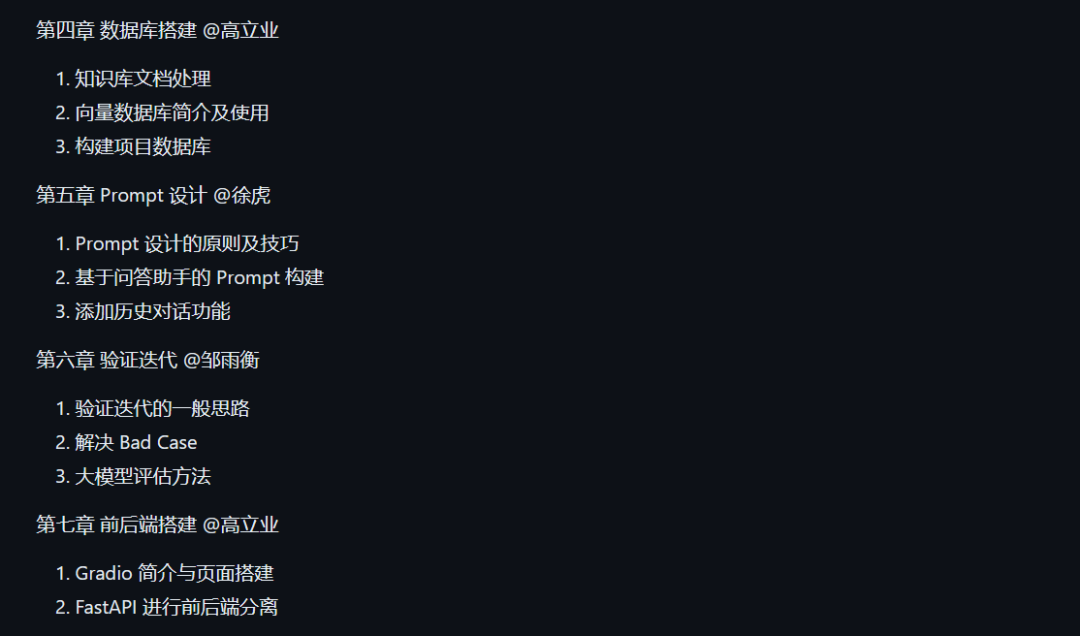

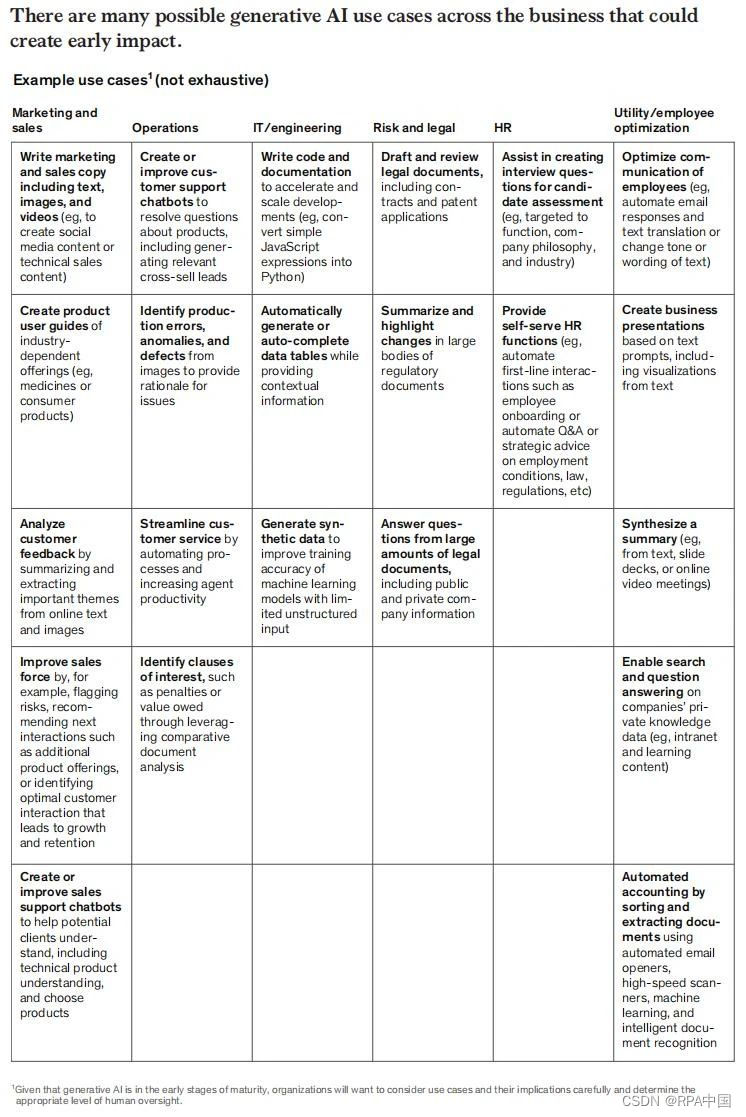

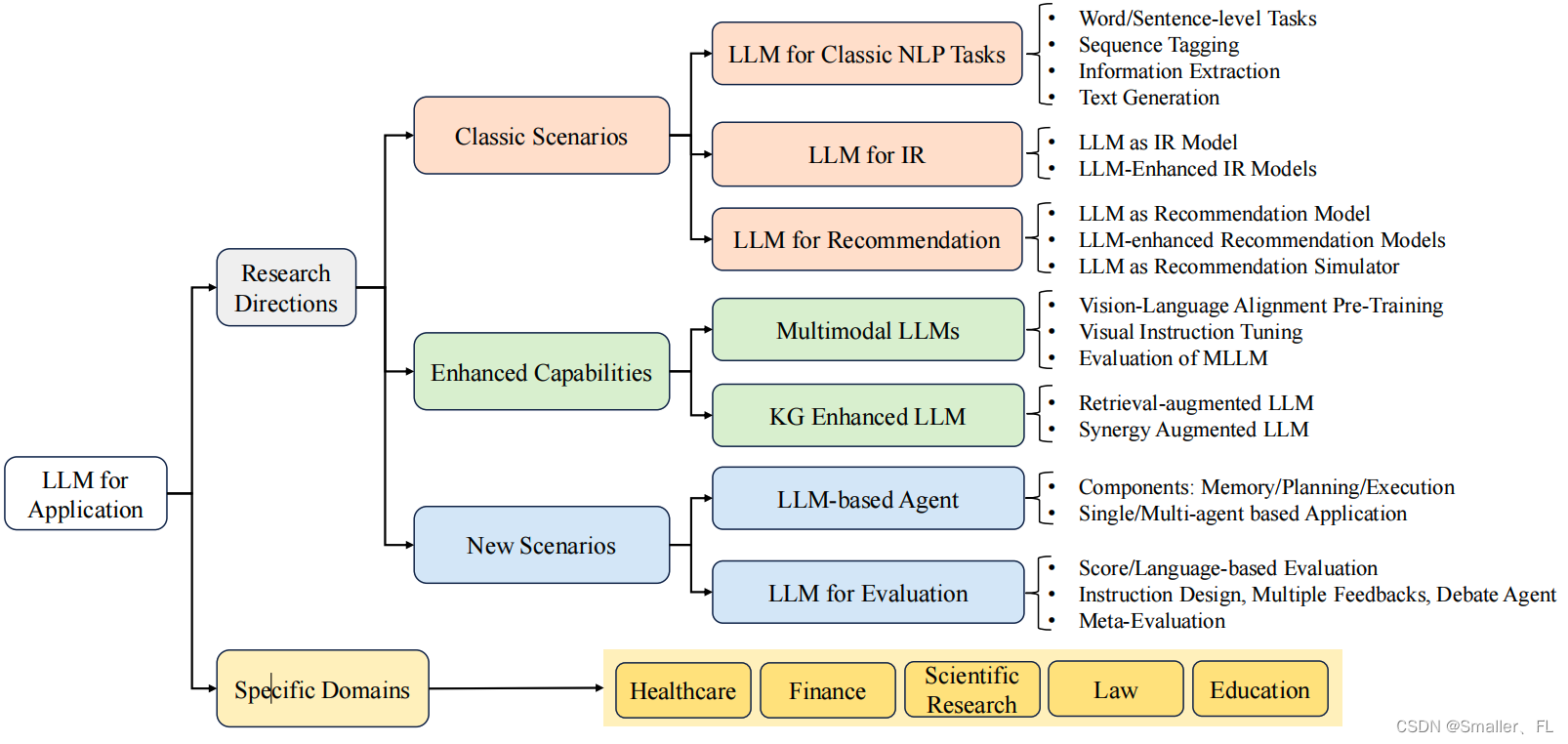

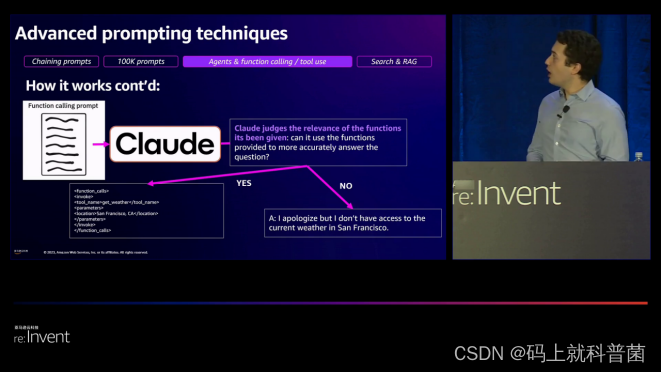

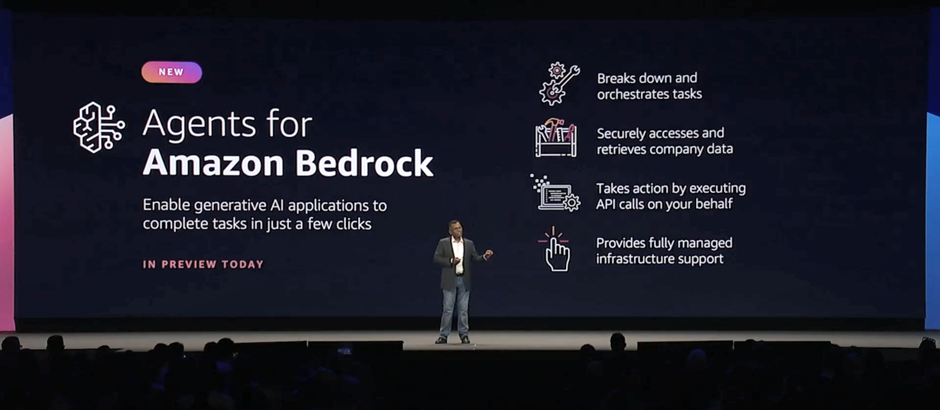

大语言模型概述(二):基于亚马逊云科技的研究分析与实践

上期介绍了大语言模型的定义和发展历史,本期将分析基于亚马逊云科技的大语言模型相关研究方向,以及大语言模型的训练和构建优化。

大语言模型研究方向分析

Amazon Titan

2023 年 4 月,亚马逊云科技宣布推出 Amazon Titan 大语言模型。根据…

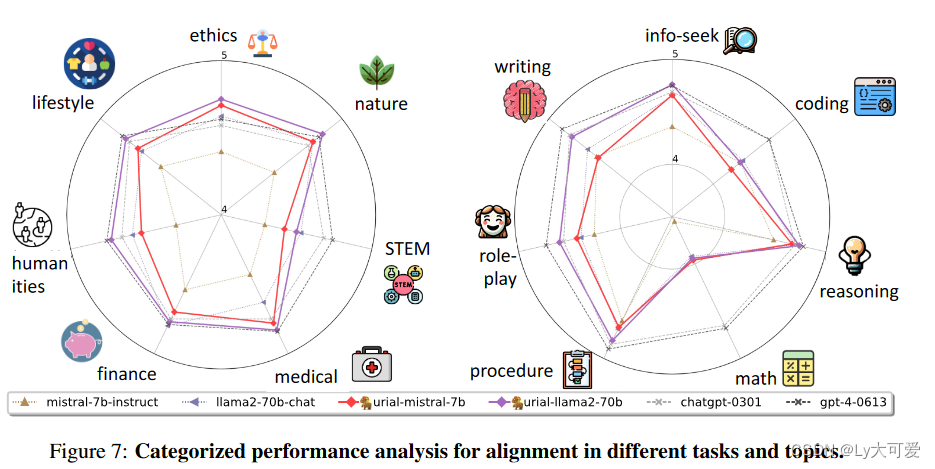

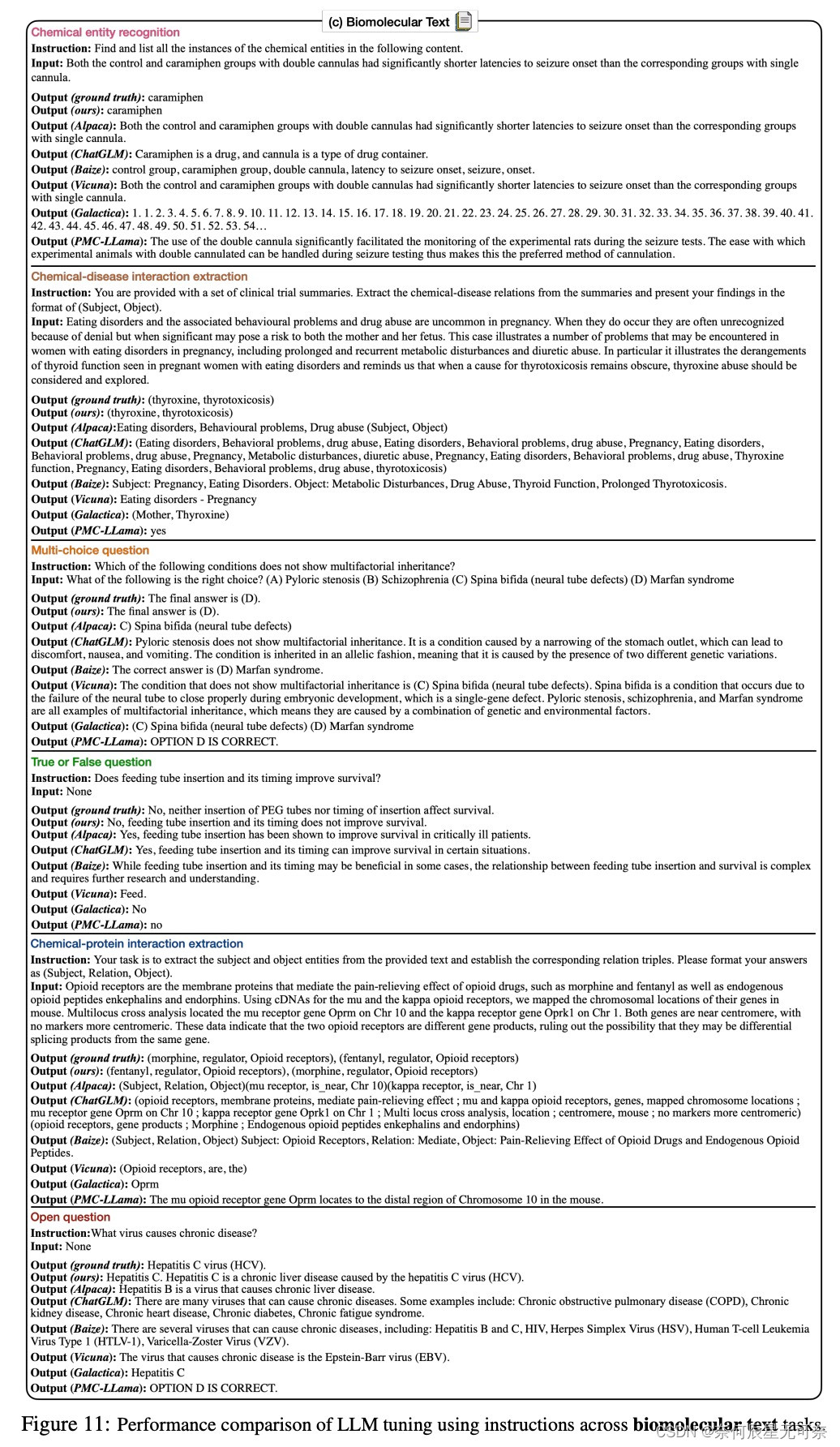

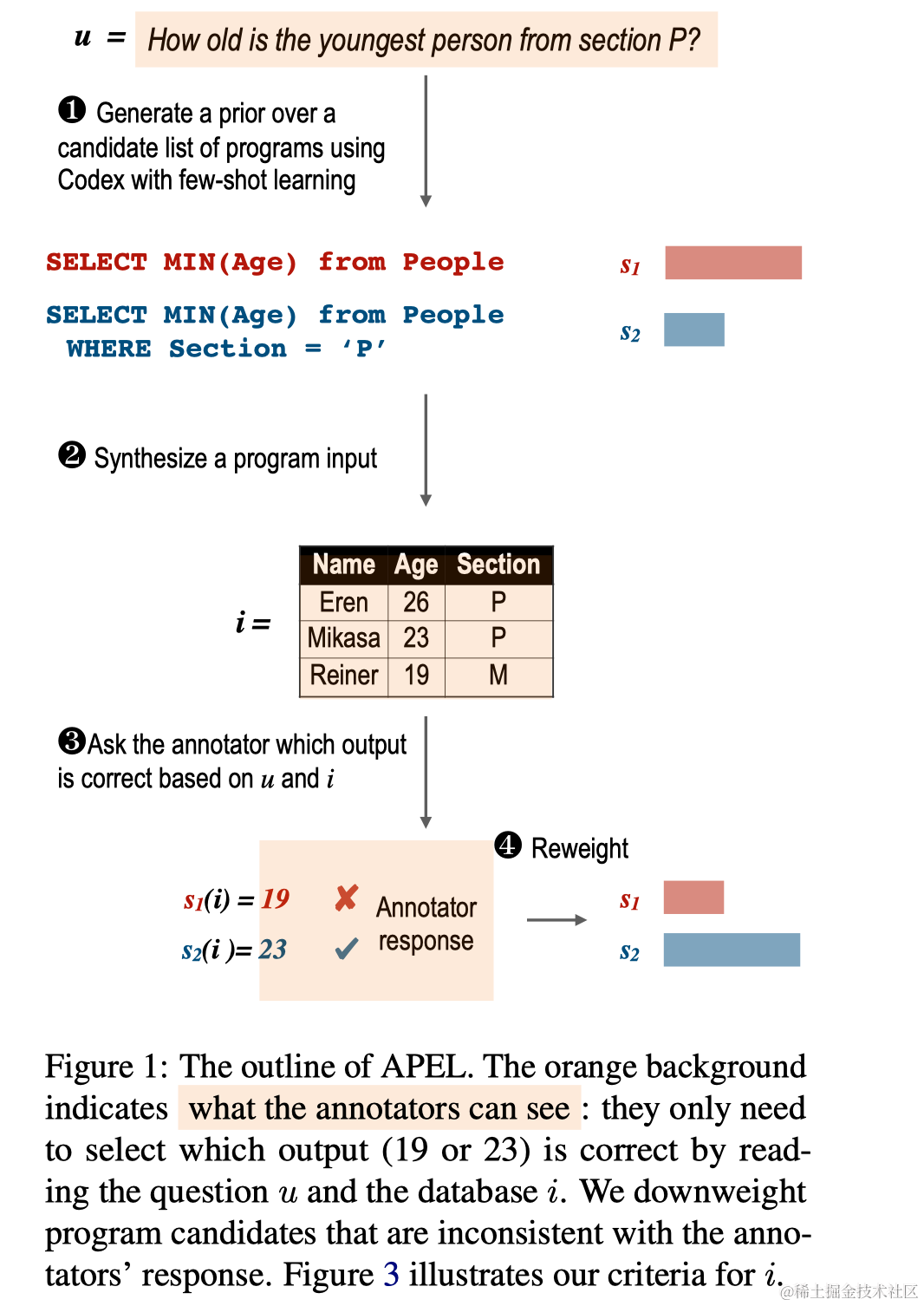

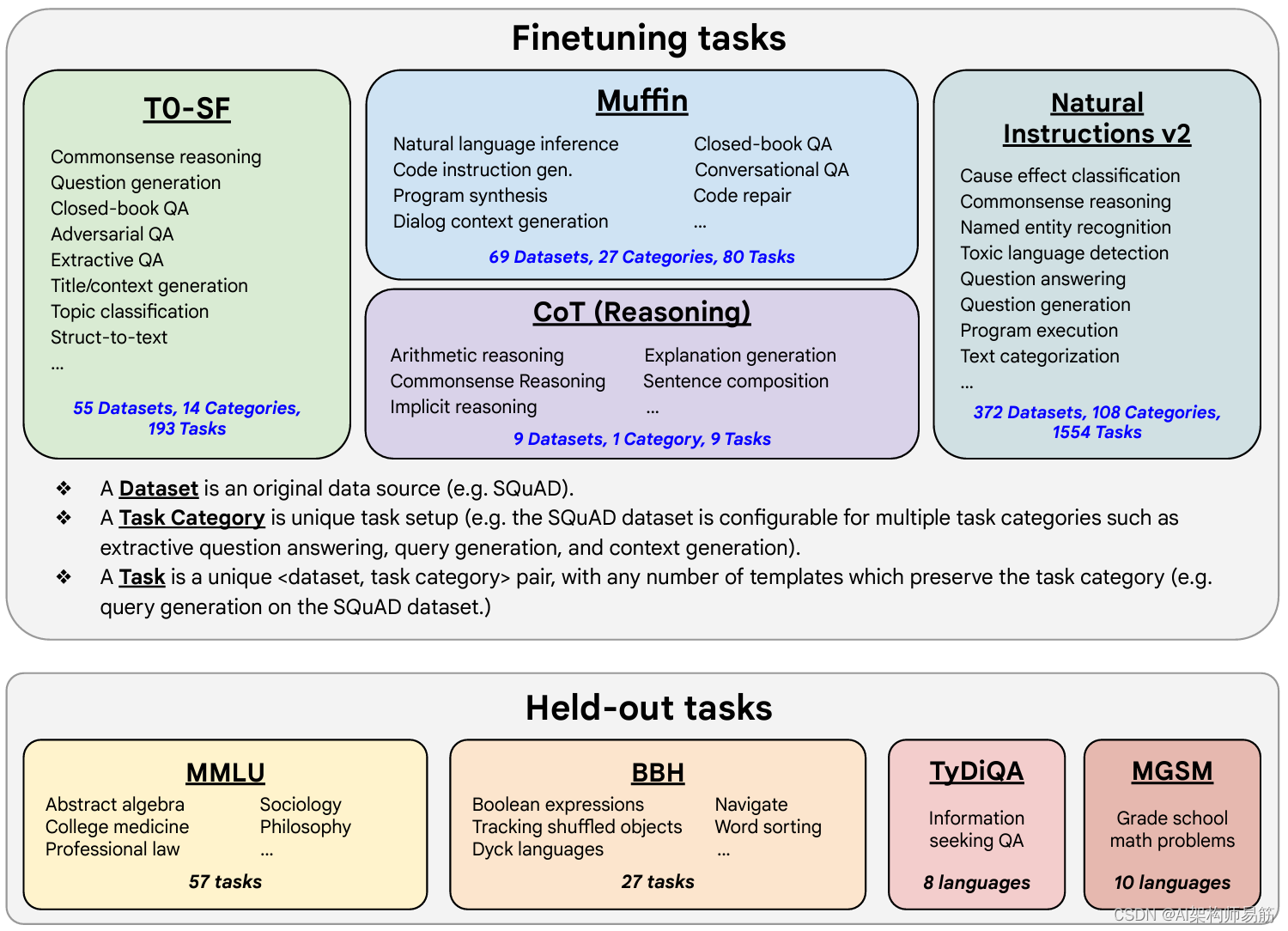

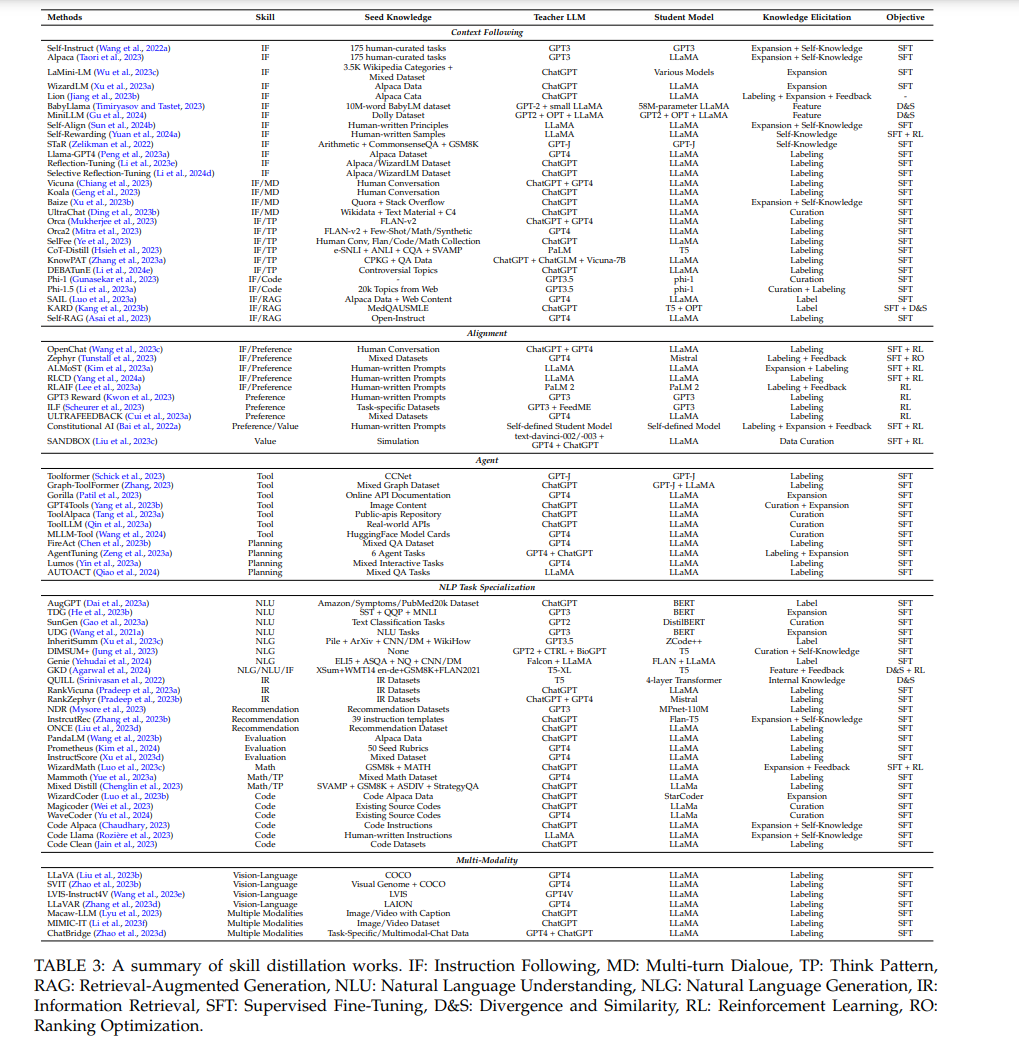

Instruction Tuning for Large Language Models: A Survey

本文是LLM系列文章,针对《Instruction Tuning for Large Language Models: A Survey》的翻译。 大语言模型指令调整:综述 摘要1 引言2 方法3 数据集4 指令微调LLMs5 多模态指令微调6 特定领域指令微调7 高效调整技术8 评估,分析和批评9 结论…

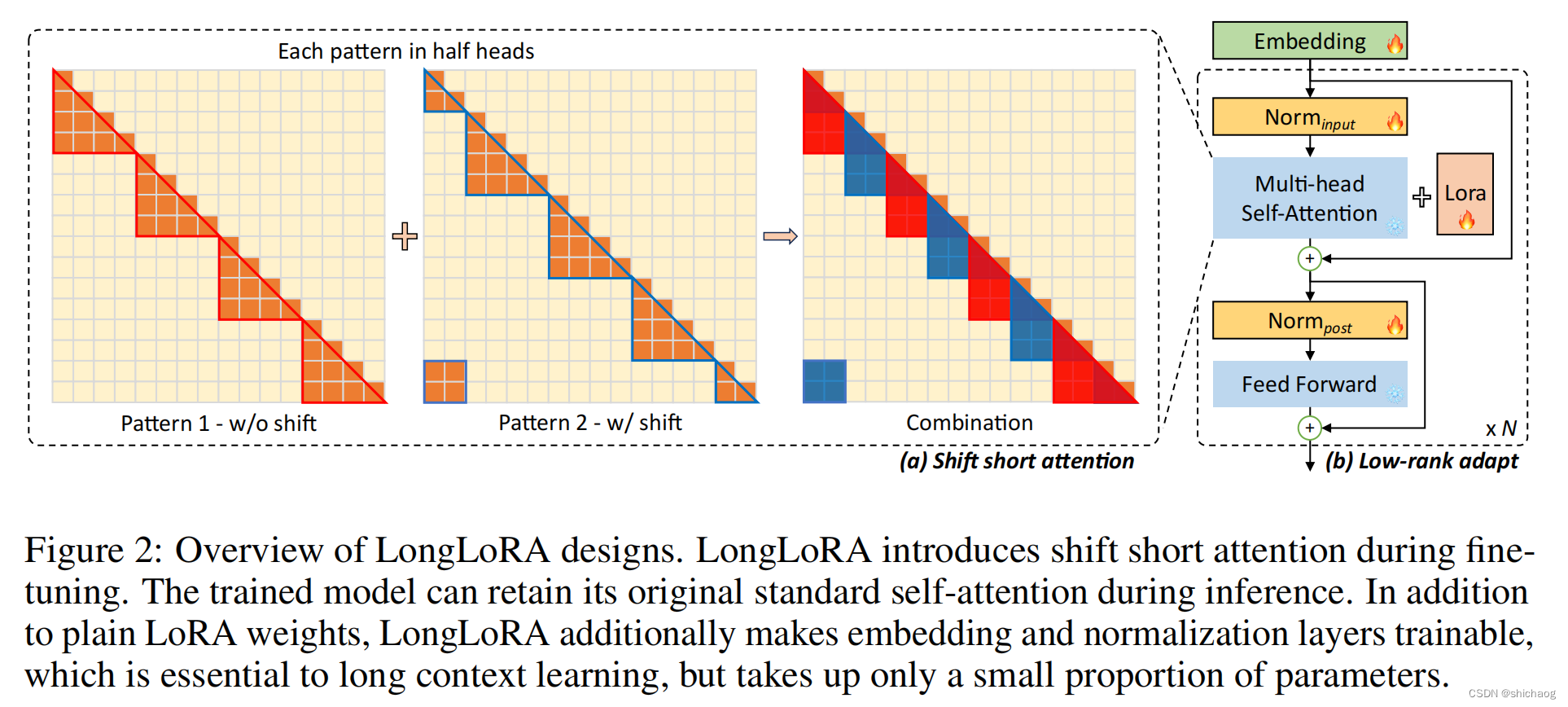

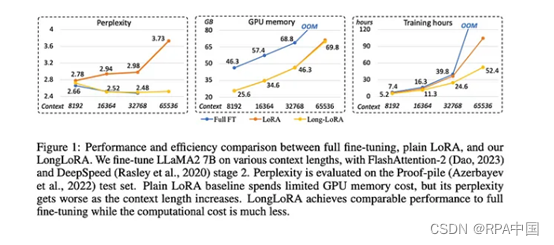

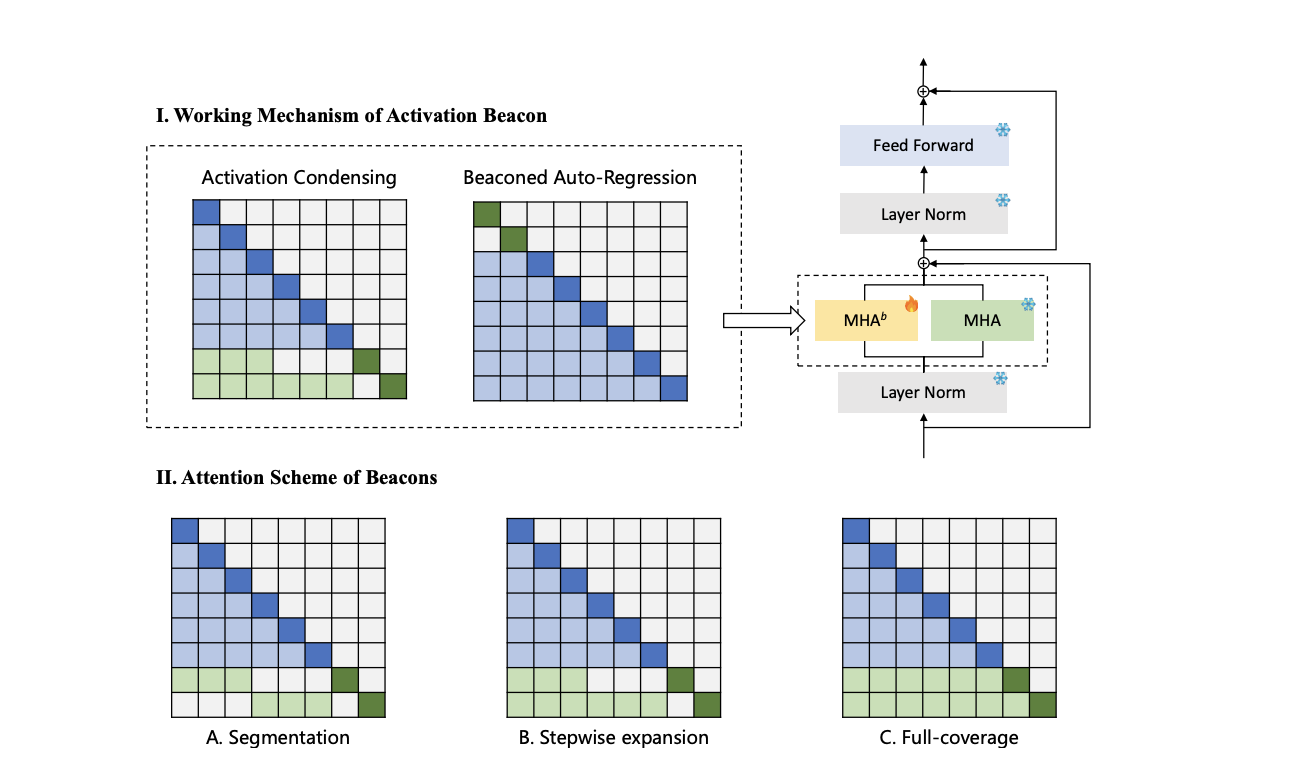

LONGLORA: EFFICIENT FINE-TUNING OF LONGCONTEXT LARGE LANGUAGE MODELS

本文是LLM系列文章,针对《LONGLORA: EFFICIENT FINE-TUNING OF LONGCONTEXT LARGE LANGUAGE MODELS》的翻译。 Longlora:长上下文大型语言模型的高效微调 摘要1 引言2 相关工作3 LongLoRA4 实验5 结论 摘要

我们提出了LongLoRA,一种有效的微调方法&…

初识人工智能,一文读懂过拟合欠拟合和模型压缩的知识文集(3)

🏆作者简介,普修罗双战士,一直追求不断学习和成长,在技术的道路上持续探索和实践。 🏆多年互联网行业从业经验,历任核心研发工程师,项目技术负责人。 🎉欢迎 👍点赞✍评论…

百题千解计划【CSDN每日一练】LLM大语言模型:必练选择题及解析 | “等差数列”多解法:Python、Java、C语言、C++...

月落乌啼霜满天,江枫渔火对愁眠。 🎯作者主页: 追光者♂🔥 🌸个人简介: 💖[1] 计算机专业硕士研究生💖 🌟[2] 2022年度博客之星人工智能领域TOP4🌟 🏅[3] 阿里云社区特邀专家博主🏅 🏆[4] CSDN-人工智能领域优质创作者🏆 📝[5] …

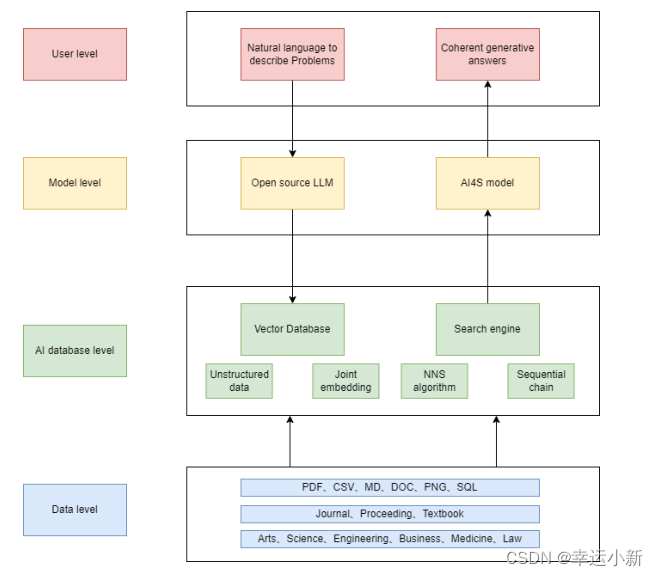

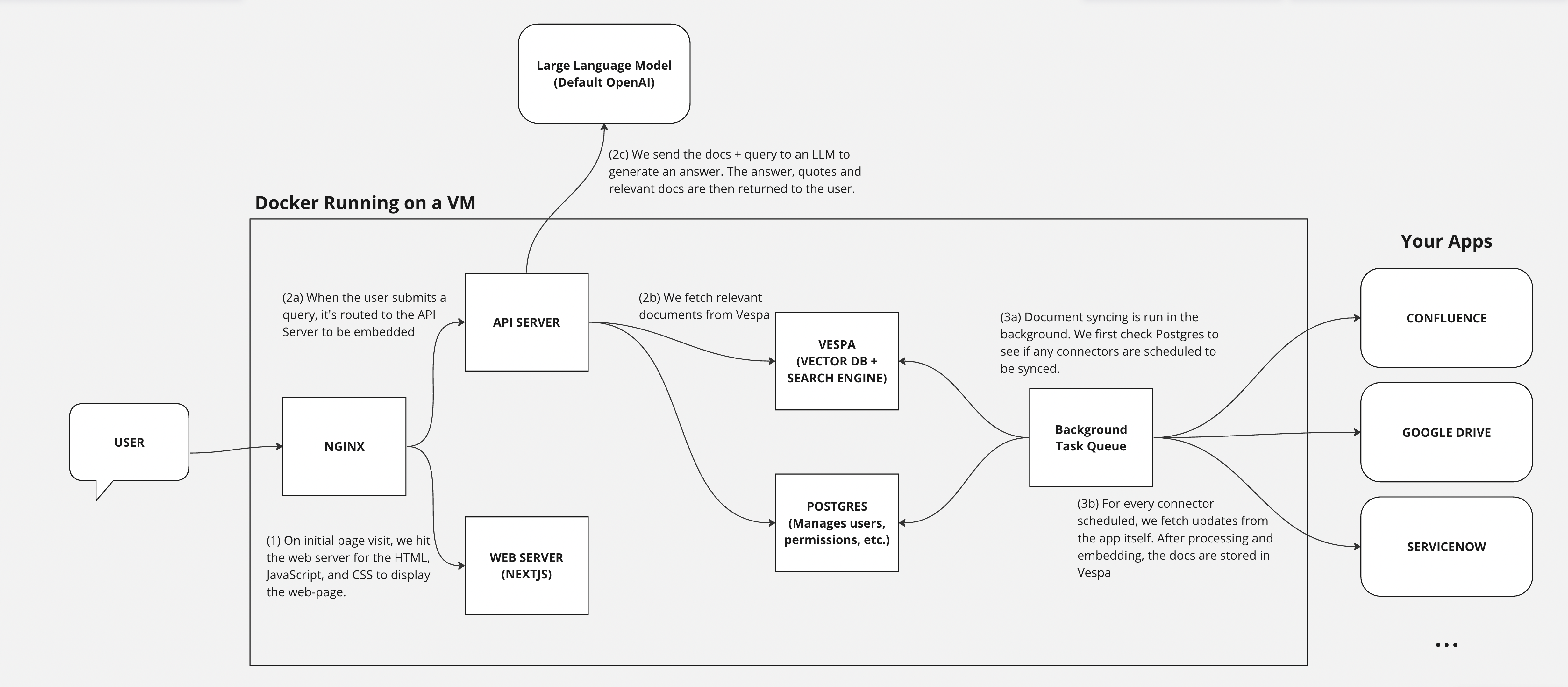

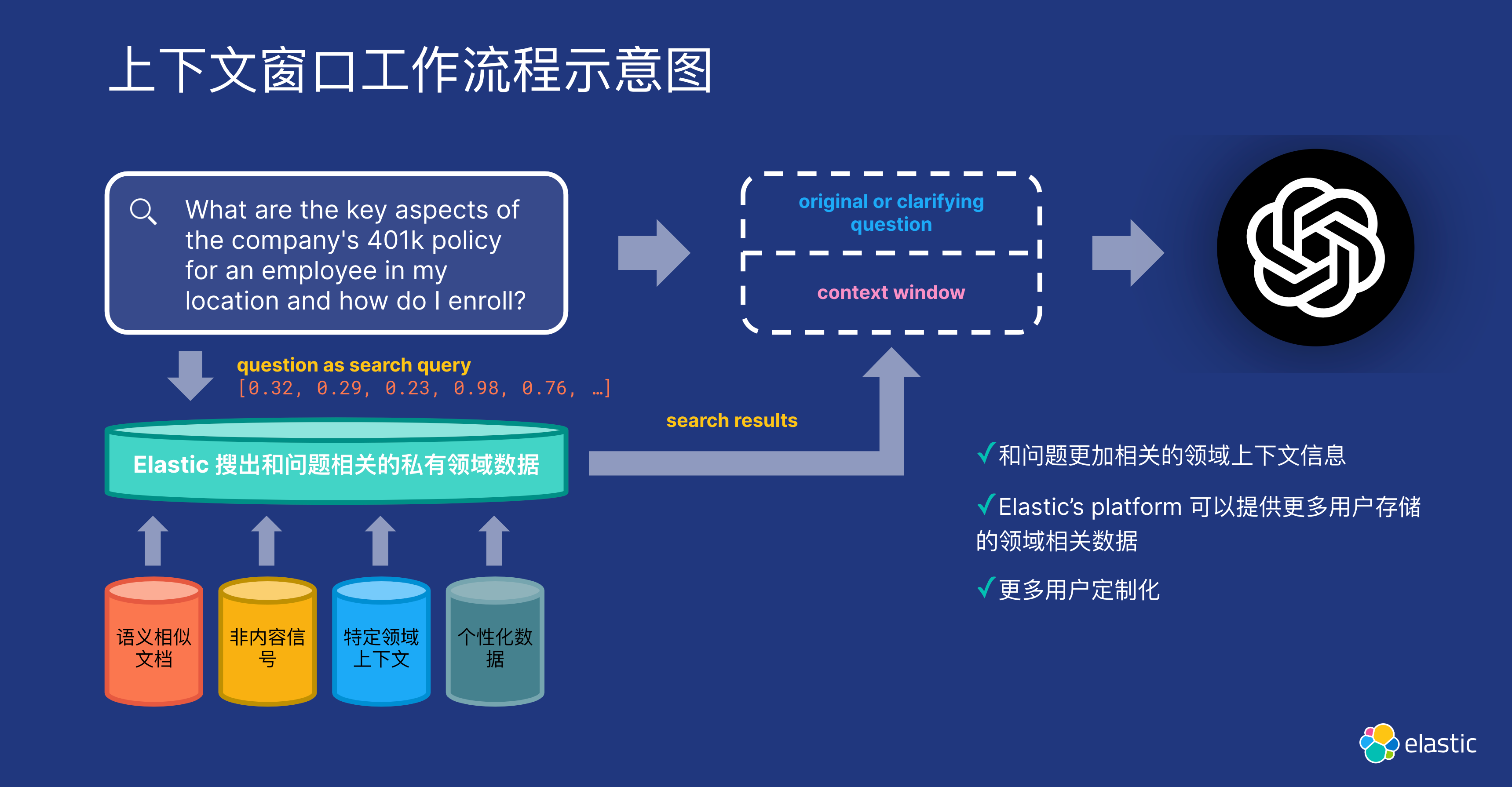

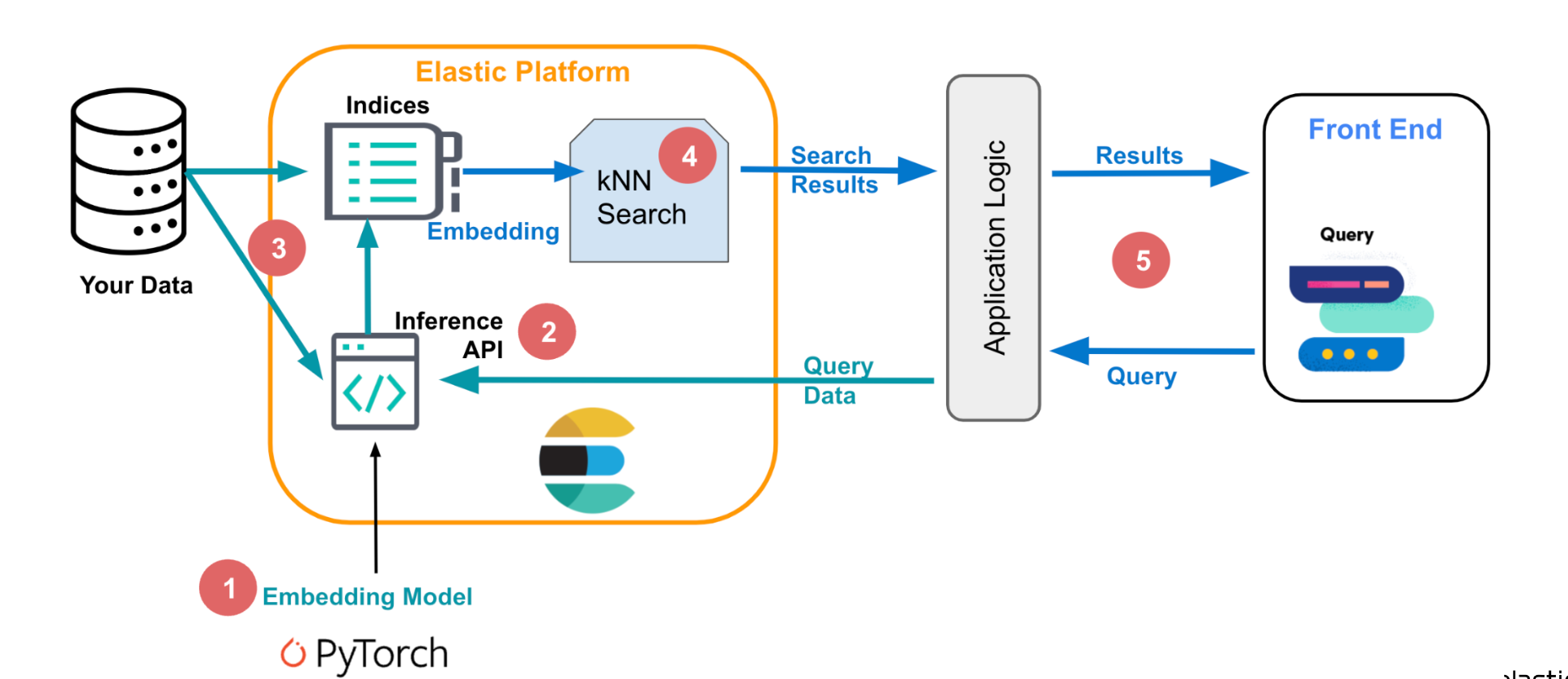

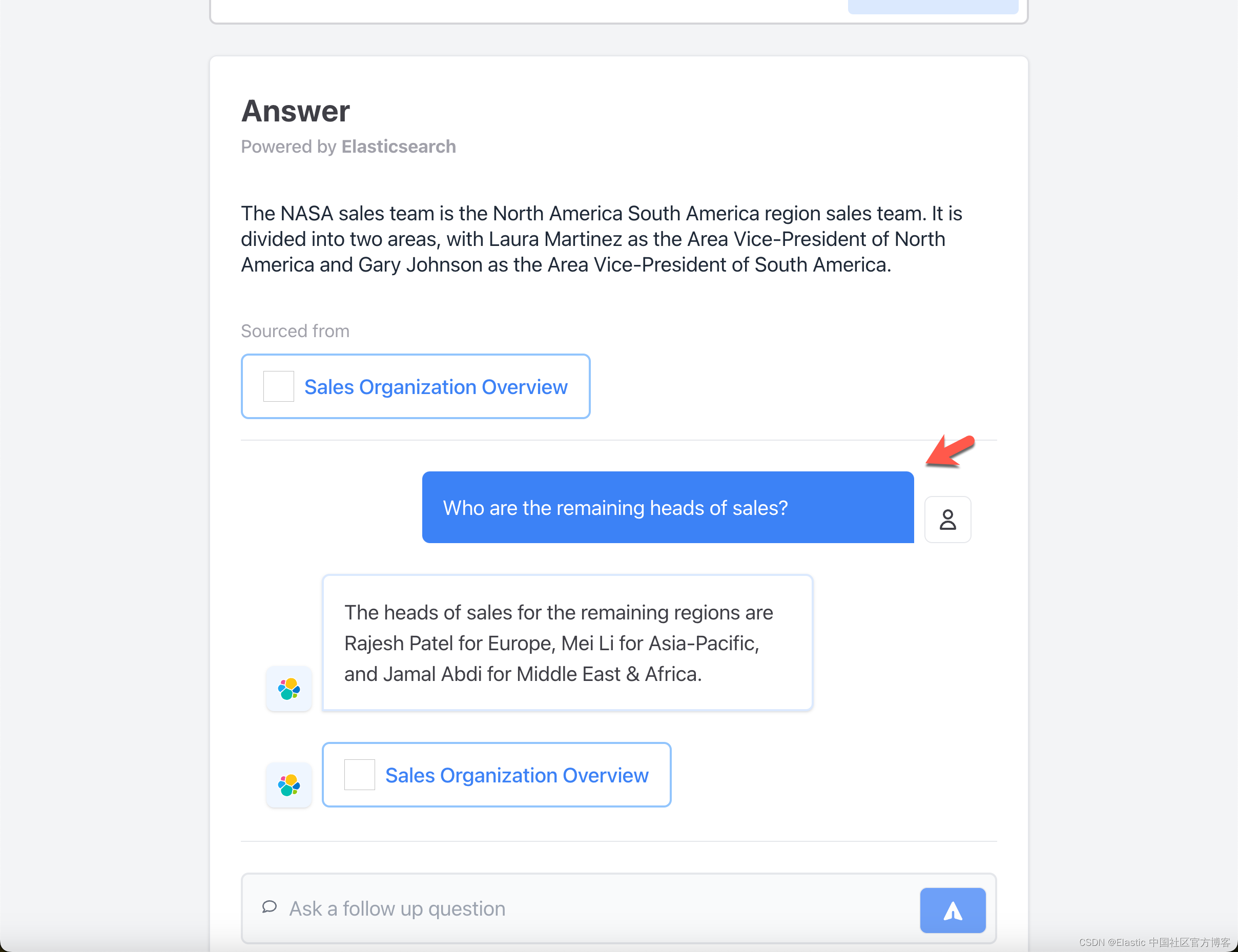

如何在搜索引擎中应用AI大语言模型,提高企业生产力?

人工智能尤其是大型语言模型的应用,重塑了我们与信息交互的方式,也为企业带来了重大的变革。将基于大模型的检索增强生成(RAG)集成到业务实践中,不仅是一种趋势,更是一种必要。它有助于实现数据驱动型决策&…

Pruning Pre-trained Language Models Without Fine-Tuning

本文是LLM系列文章,针对《Pruning Pre-trained Language Models Without Fine-Tuning》的翻译。 修剪未微调的预训练语言模型 摘要1 引言2 相关工作3 背景4 静态模型剪枝5 实验6 分析7 结论8 局限性 摘要

为了克服预训练语言模型(PLMs)中的过度参数化问题…

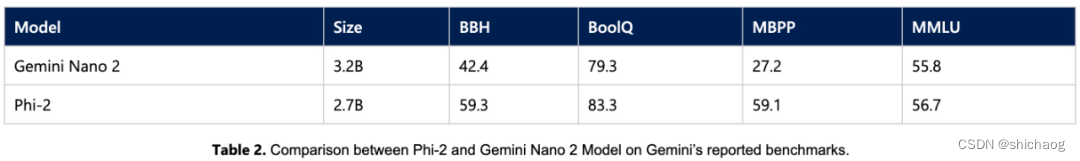

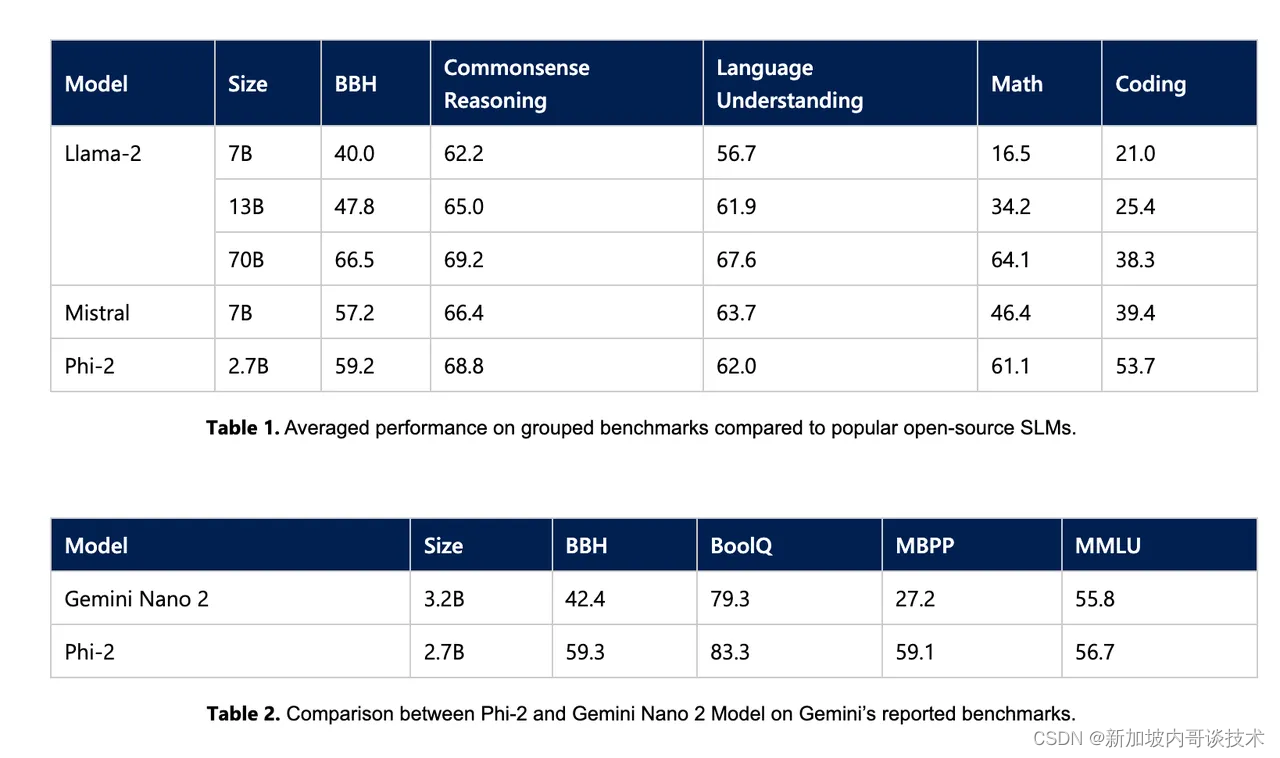

大模型之二十一-小语言模型塞道开启

当前提到大语言模型,大家想到的都是动辄百亿规模以上参数量的模型,13B、70B都是稀疏平常入门级的,但是目前从模型层面来看,模型参数量的规模两极分化已经来临,早期各大公司为了效果怼上去,采取了简单粗暴的…

【飞桨星河社区五周年线下工坊-杭州站】

? 欢迎大家参加杭州极客工坊,深入了解大模型前沿技术和创新应用,一站式体验AI原生应用开发? 精彩议程敬请期待~ ? 时间:2023年12月3日 14:00-17:30 ? 地点:杭州西湖区花蒋路3号西溪润泽园度假酒店 ? 主题…

关于业界大语言模型(LLM)开源的一些看法

近期看到阿里开源了720亿参数模型通义千问,已实现“全尺寸、全模态”开源,对这个动作的一些想法,包括好处和缺点

国内大语言模型的开源有许多好处,如下:

1. 提升技术水平:国内大语言模型开源可以使更多的…

VeRA: Vector-based Random Matrix Adaptation

本文是LLM系列文章,针对《VeRA: Vector-based Random Matrix Adaptation》的翻译。 VeRA:基于向量的随机矩阵自适应 摘要1 引言2 相关工作3 方法4 实验5 结论 摘要

低秩(LoRA)是一种流行的方法,它可以在微调大规模语…

十个经典Java入门系统功能列举

1. 员工信息管理系统: - 员工信息录入:包括基本信息、工作经历、教育背景等。 - 员工信息查询:可根据姓名、部门、职位等条件进行查询。 - 员工信息修改:允许对员工信息进行更新和修改。 - 员工信息删除:允…

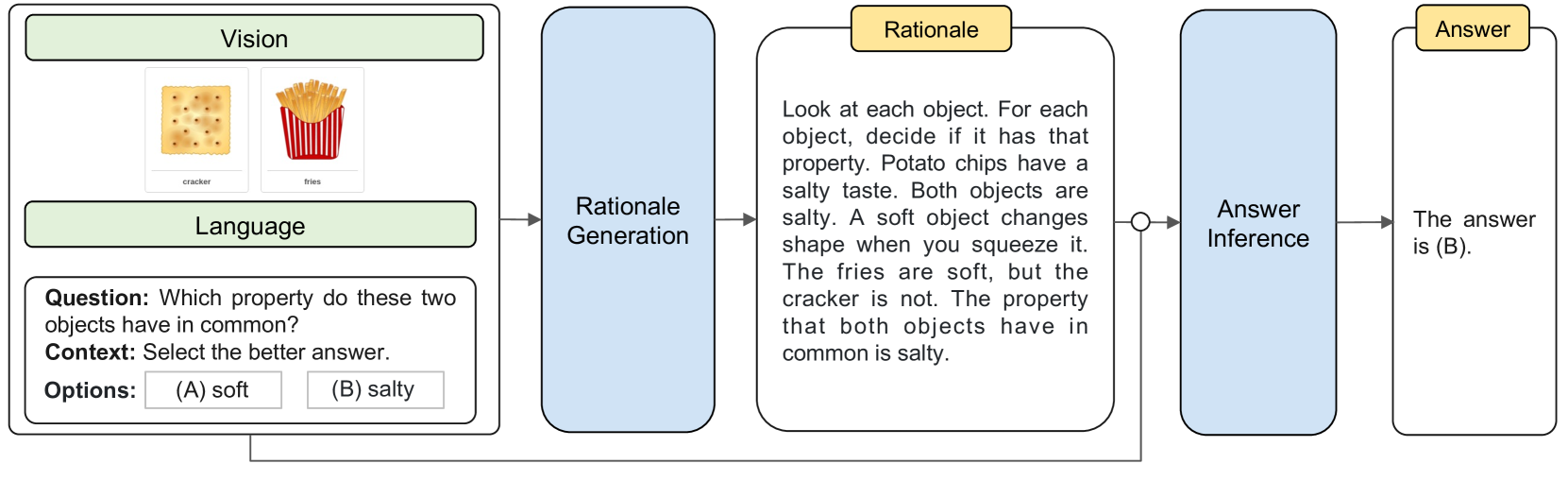

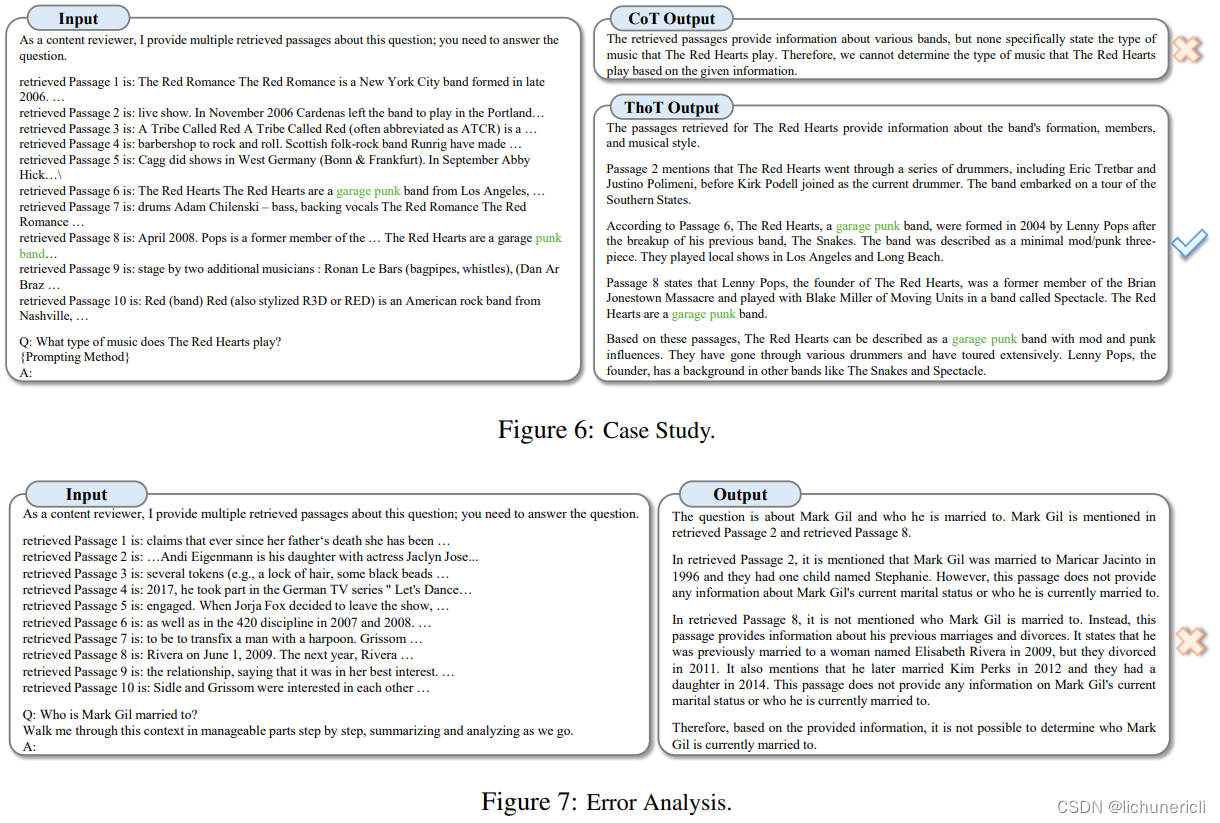

Multimodal Chain-of-Thought Reasoning in Language Models语言模型中的多模态思维链推理

Abstract 大型语言模型 (LLM) 通过利用思维链 (CoT) 提示生成中间推理链作为推断答案的基本原理,在复杂推理方面表现出了令人印象深刻的性能。然而,现有的 CoT 研究主要集中在语言情态上。我们提出了 Multimodal-CoT,它将语言(文本…

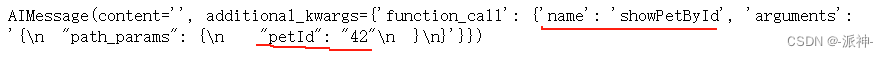

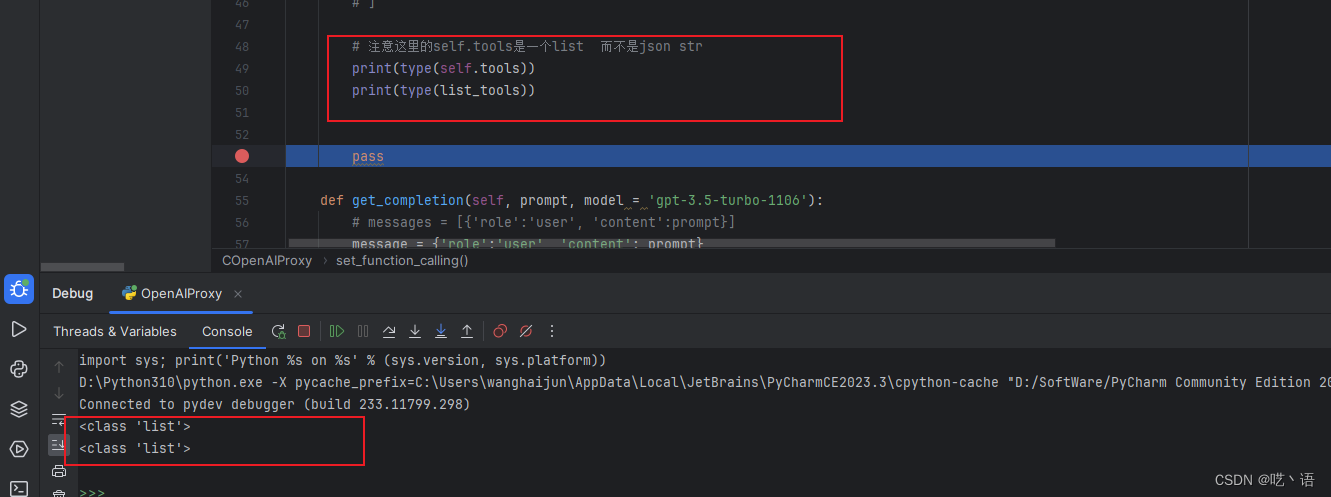

LangChain的函数,工具和代理(三):LangChain中轻松实现OpenAI函数调用

在我之前写的两篇博客中:OpenAI的函数调用,LangChain的表达式语言(LCEL)中介绍了如何利用openai的api来实现函数调用功能,以及在langchain中如何实现openai的函数调用功能,在这两篇博客中,我们都需要手动去创建一个结构比较复杂的函数描述变量…

语言模型ChatGPT,为什么能引领各行各业的AI技术革命

为什么ChatGPT这样一个语言模型的发展能引发所有行业的AI技术革命呢?

答案就在于它能理解我们的自然语言,

并能将我们的语言转换成计算机能够完全理解的特征。

自然语言与计算机理解

ChatGPT之所以能引领技术革命,关键在于它能理解我们的…

区块链相关技术、概念以及技术实现过程中的一些关键问题 Smart Contracts and Blockchains

作者:禅与计算机程序设计艺术

1.简介

2017年底,区块链已经成为众多投资人和技术人员最关注的话题之一。随着现实世界的不断复杂化、数字货币的流行以及IoT设备的普及,加密数字货币市场正变得越来越活跃。由于区块链具有去中心化、不可篡改、透明性、高并发等特点,使其在金…

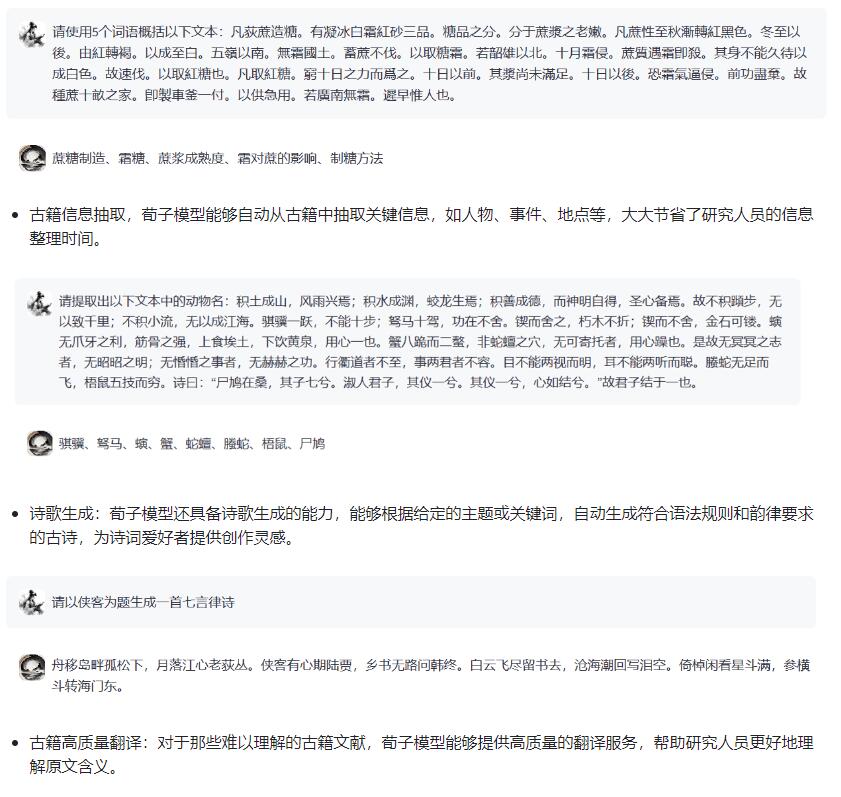

南京农业大学研发古籍版的ChatGPT,AI大语言模型荀子面世

随着科技的飞速发展,人工智能已深入到各个领域。为响应古籍活化利用号召,推动大语言模型与古籍处理深度融合,以古籍智能化的研究为目的,南京农业大学国家社科基金重大项目“中国古代典籍跨语言知识库构建及应用研究”课题组与中华…

Prompt2Model: Generating Deployable Models from Natural Language Instructions

本文是LLM系列文章,针对《 Prompt2Model: Generating Deployable Models from Natural Language Instructions》的翻译。 Prompt2Model:从自然语言指令生成可部署模型 摘要1 引言2 Prompt2Model框架3 参考实现4 实验设置5 实验结果6 讨论与结论不足道德…

来也科技汪冠春:大语言模型时代下,广义RPA市场会是原来的100倍

以下内容转自:雷峰网

作者:周蕾

对来也科技CEO汪冠春来说,ChatGPT带来的冲击和颠覆,让他想起了20世纪末的柯达和尼康。摄影从胶片时代步入数码时代,似乎只是一眨眼,尼康没有抱着以前的胶卷产品不放&#…

生成式大语言模型微调训练快速手册

ChatGPT的流行让大语言模型走入了大家的视线,怎么打造自己的大语言模型成为了一个急需解决的问题。

目录

大语言模型的获取方法有以下三种:

目前可以Play 的大语言基础模型列表: 大语言模型的获取方法有以下三种:

1. 完全白嫖…

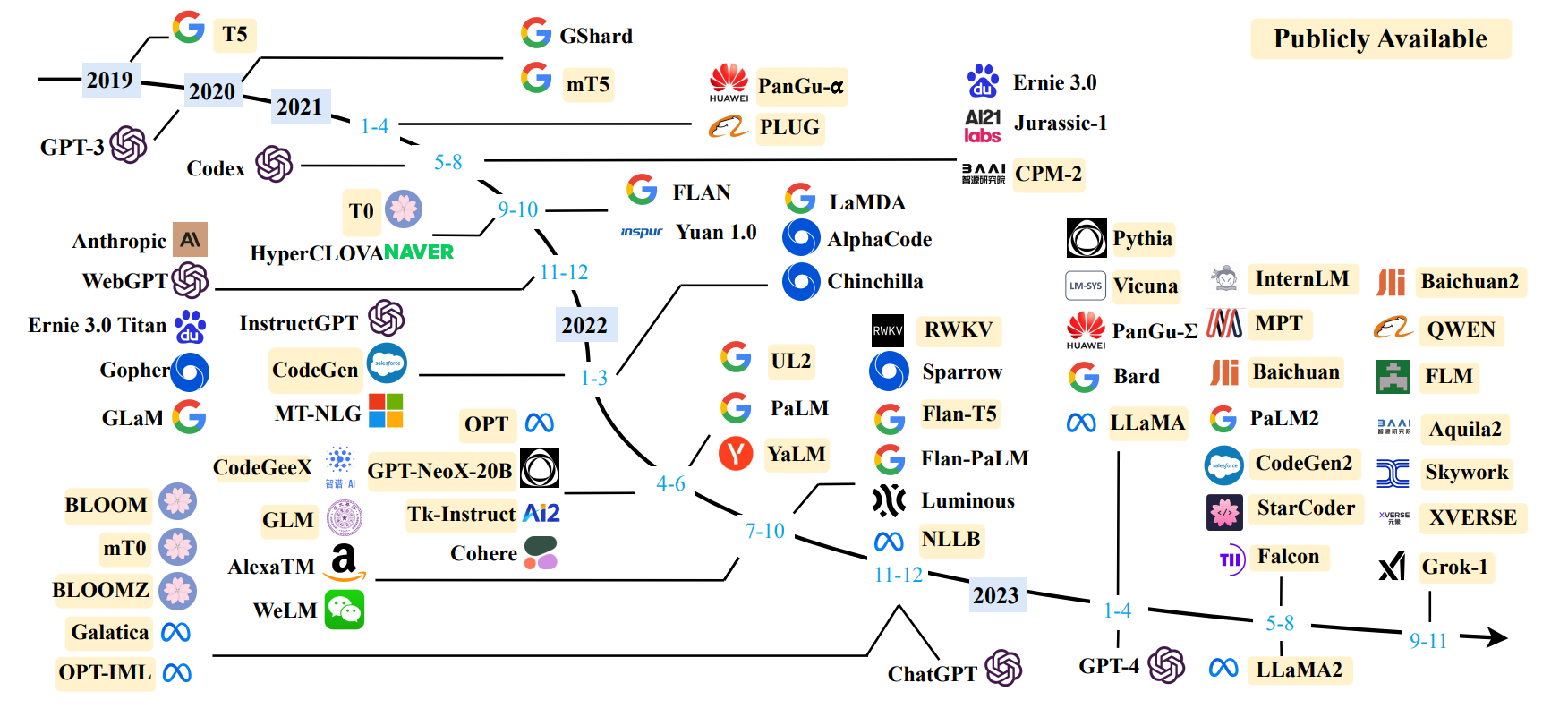

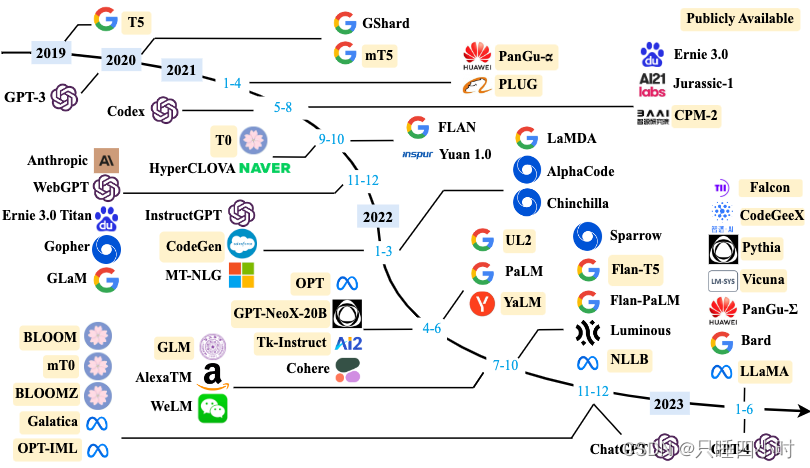

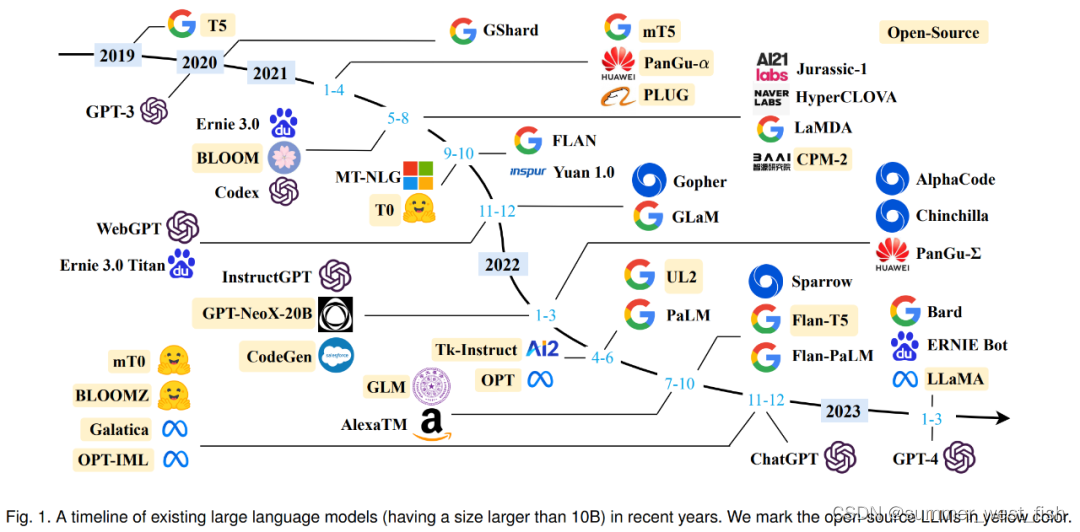

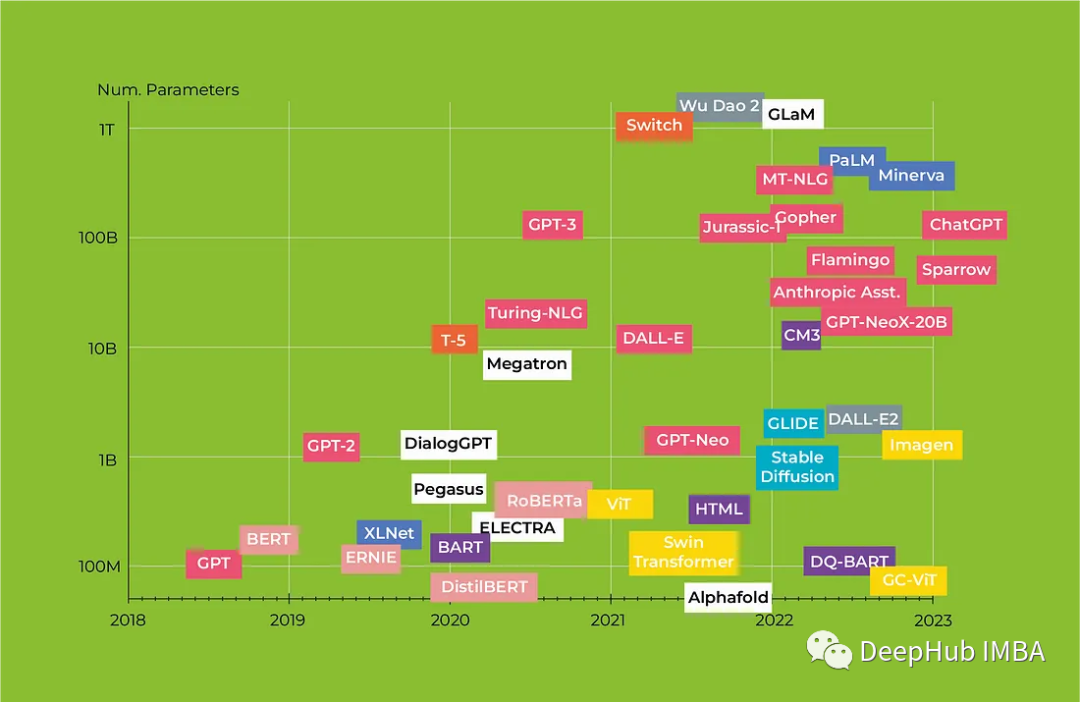

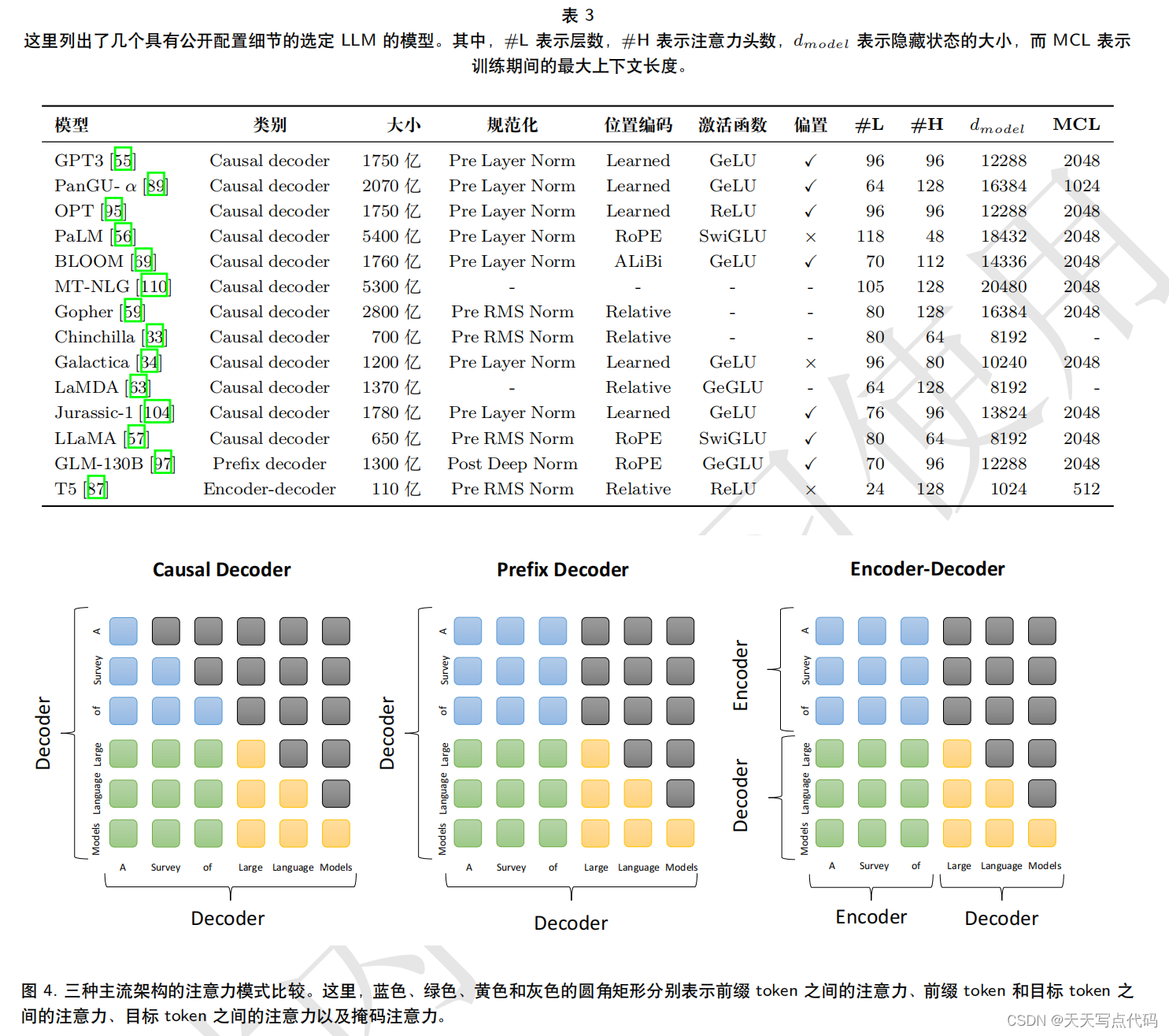

大模型 LLM 综述, A Survey of Large Language Models

大模型 LLM 综述, A Survey of Large Language Models

一、概述

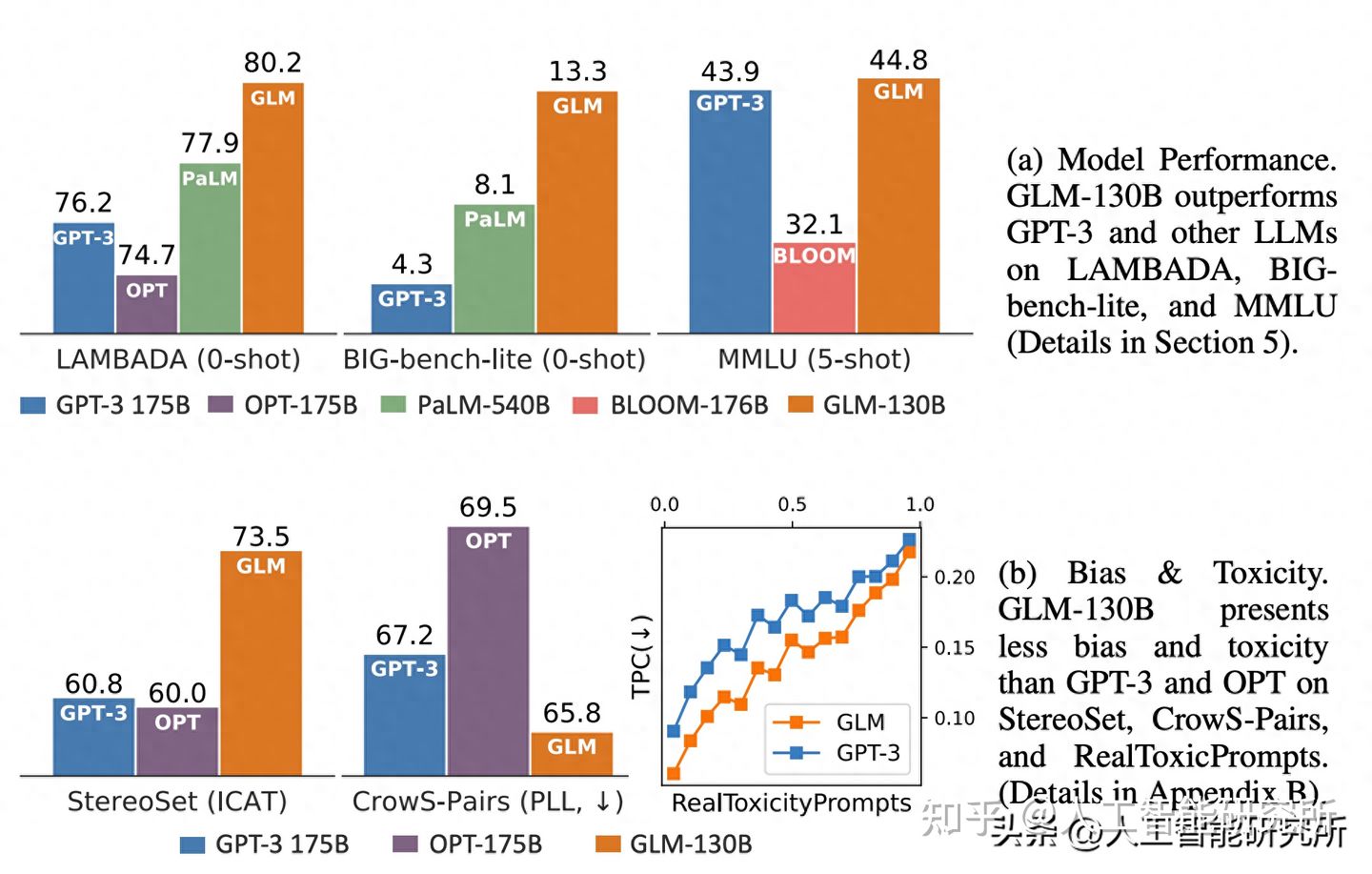

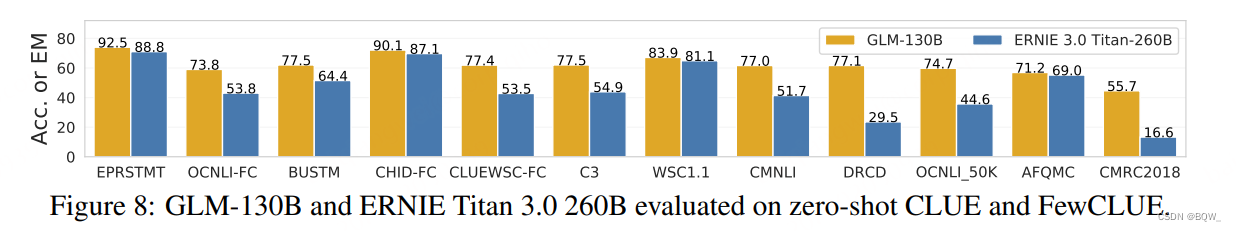

一般认为NLP领域的大模型>10 Billion参数(也有人认为是6B、7B, 工业界用, 开始展现涌现能力); 经典大模型有GPT-3、BLOOM、Flan-T5、GPT-NeoX、OPT、GLM-130B、PaLM、LaMDA、LLaMA等;

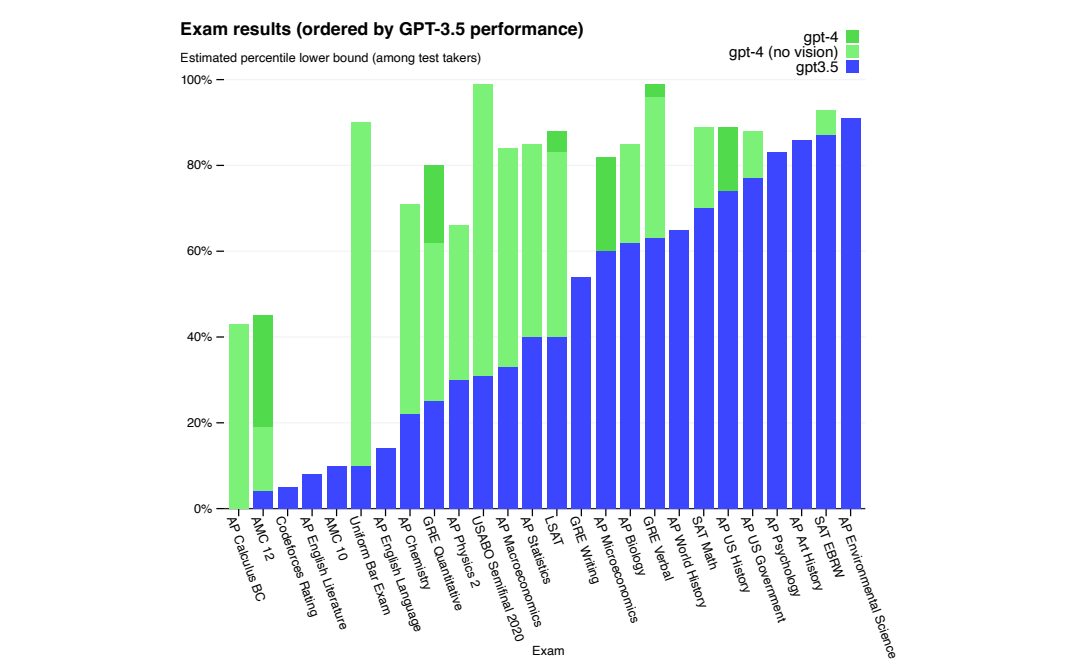

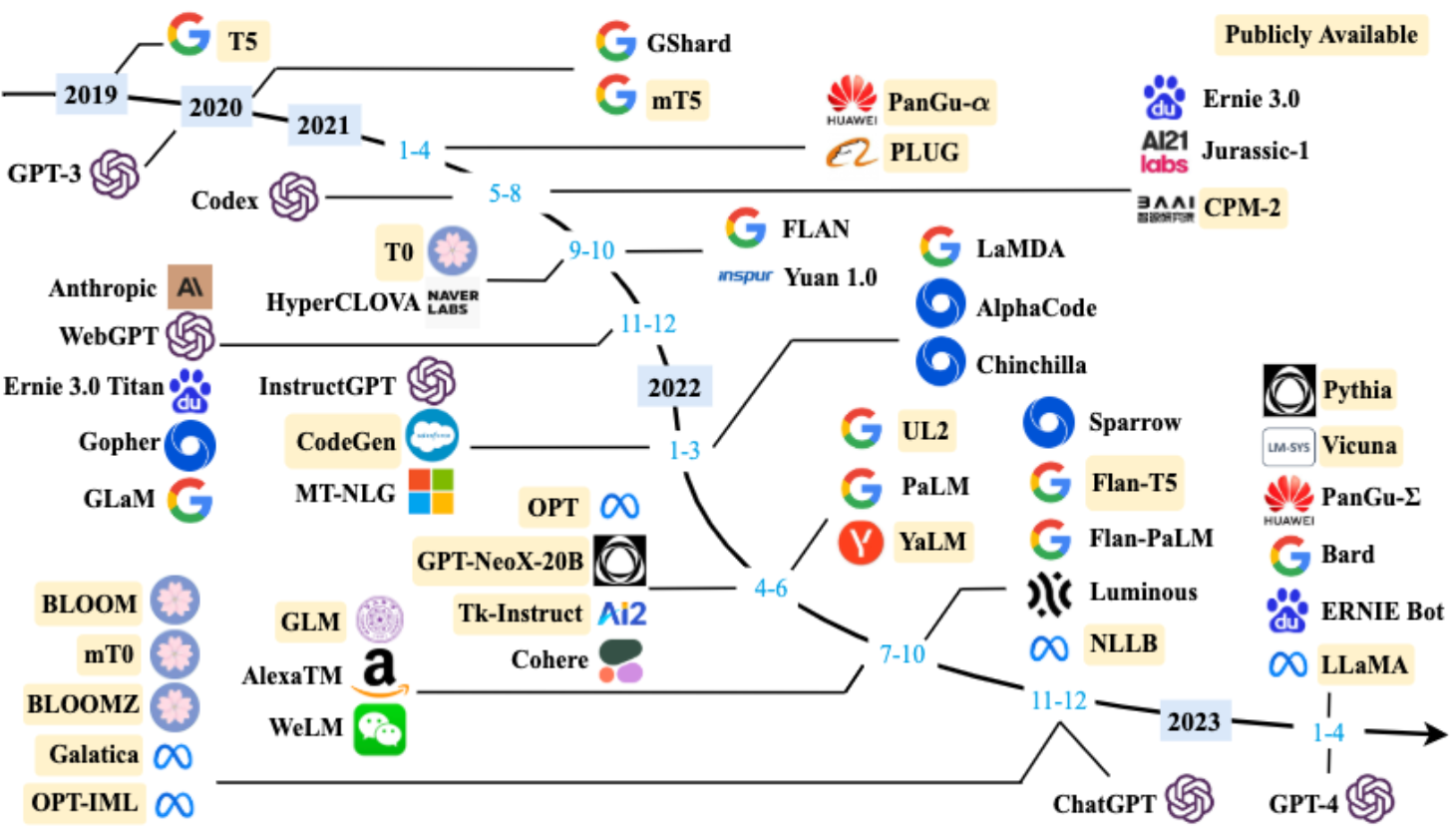

大模型时间线, 图来自…

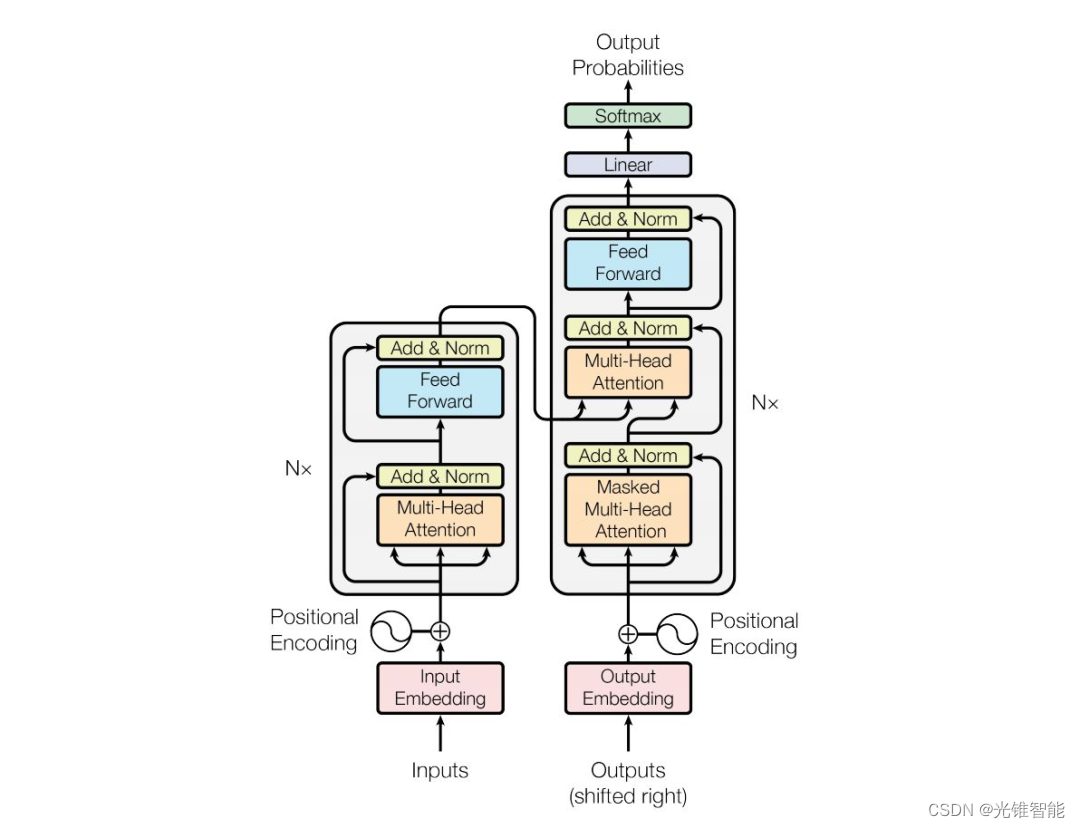

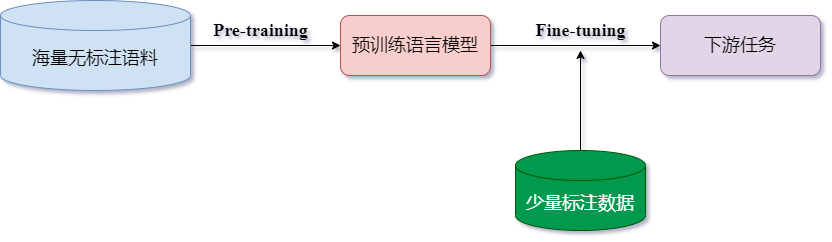

从统计语言模型到预训练语言模型---预训练语言模型(Transformer)

预训练模型的概念在计算机视觉领域并不陌生, 通常我们可以在大规模图像数据集上预先训练出一个通用 模型, 之后再迁移到类似的具体任务上去, 这样在减少对图像样本需求的同时, 也加速了模型的开发速度。计 算机视觉领域采用 Image…

探索未来,开启无限可能:打造智慧应用,亚马逊云科技大语言模型助您一臂之力

文章目录 什么是大模型?大模型训练方法亚马逊云科技推出生成式AI新工具 —— aws toolkit使用教程 总结 什么是大模型?

近期,生成式大模型是人工智能领域的研究热点。这些生成式大模型,诸如文心一言、文心一格、ChatGPT、Stable …

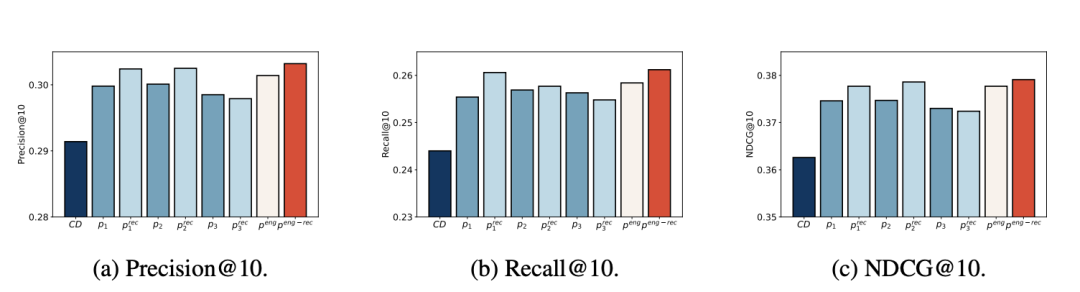

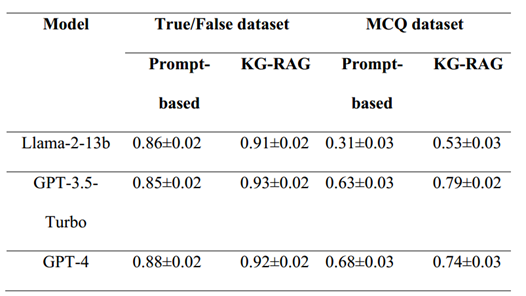

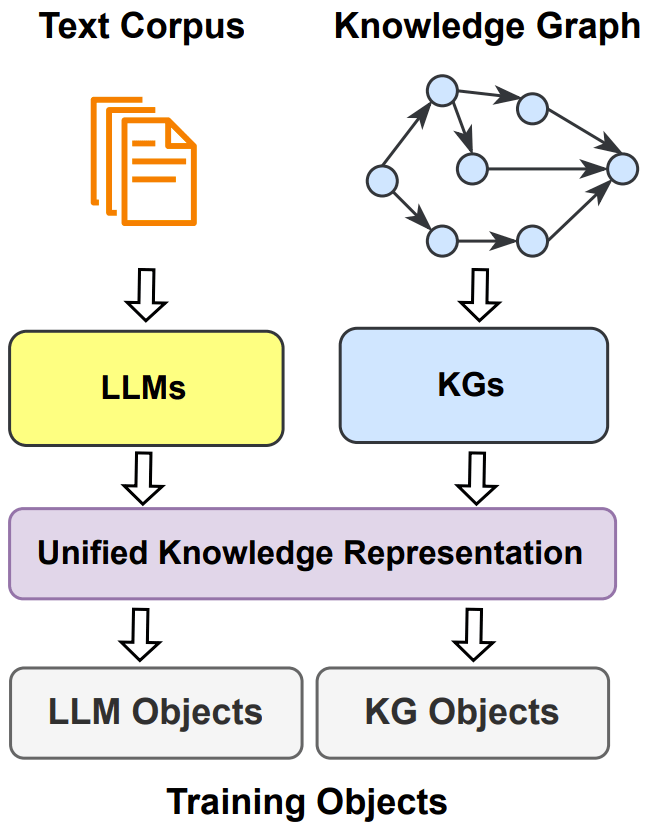

LKPNR: LLM and KG for Personalized News Recommendation Framework

本文是LLM系列文章,针对《LKPNR: LLM and KG for Personalized News Recommendation Framework》的翻译。 LKPNR:LLM和KG的个性化新闻推荐框架 摘要1 引言2 相关工作3 问题定义4 框架5 实验6 案例7 结论 摘要

准确地向用户推荐候选新闻文章是个性化新闻推荐系统面…

《Playing repeated games with Large Language Models》全文翻译

《Playing repeated games with Large Language Models》- 使用大型语言模型玩重复游戏 论文信息摘要1. 介绍2. 相关工作3. 一般方法4. 分析不同游戏系列的行为5. 囚徒困境5.1 性别之战 6. 讨论 论文信息

题目:《Playing repeated games with Large Language Model…

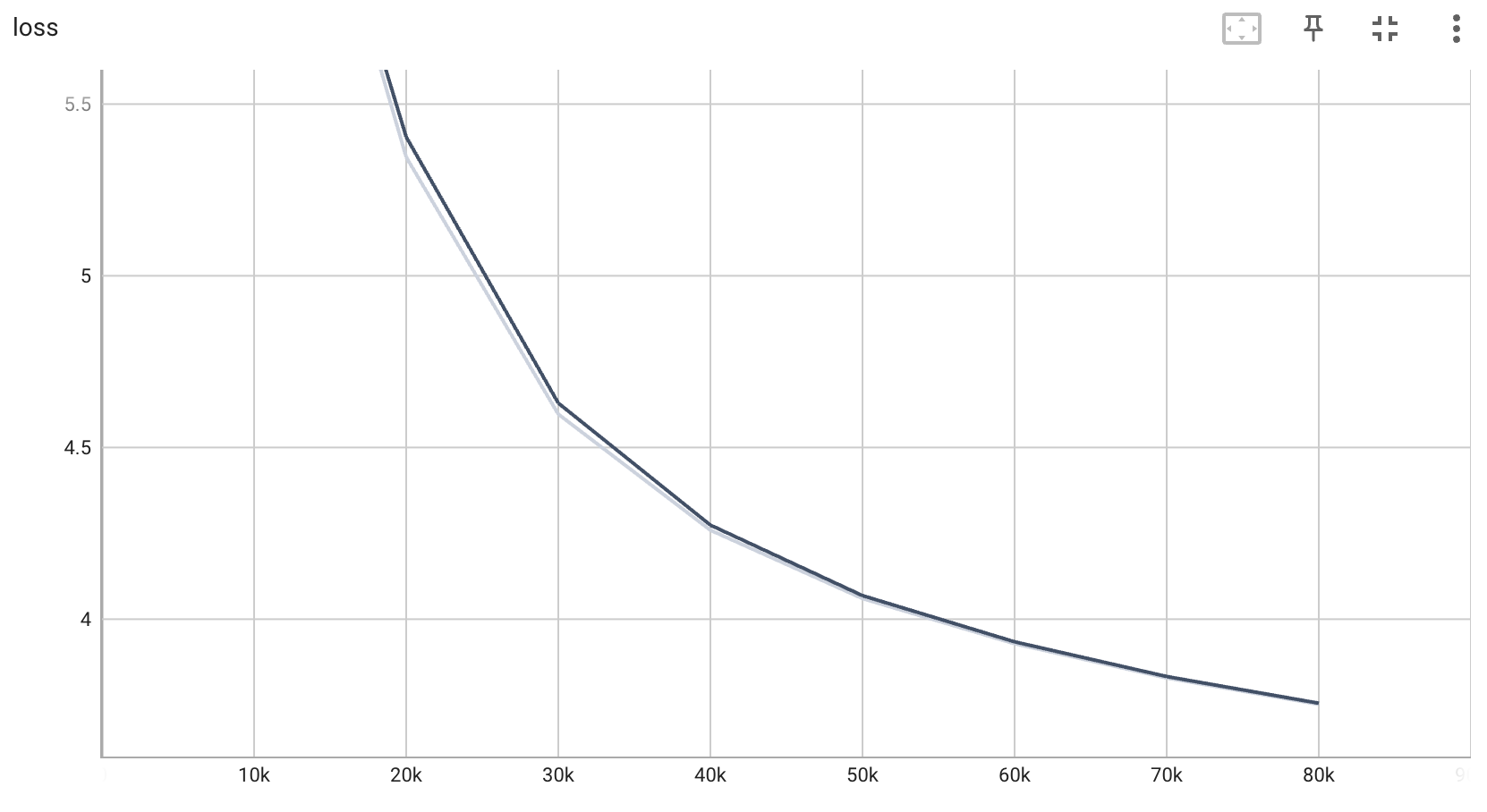

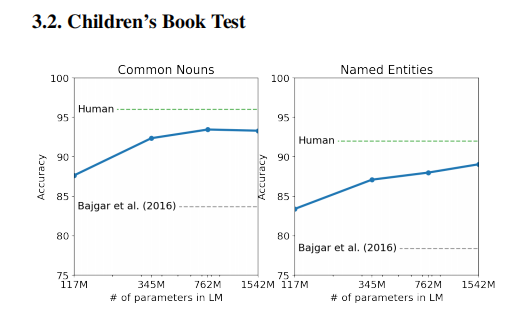

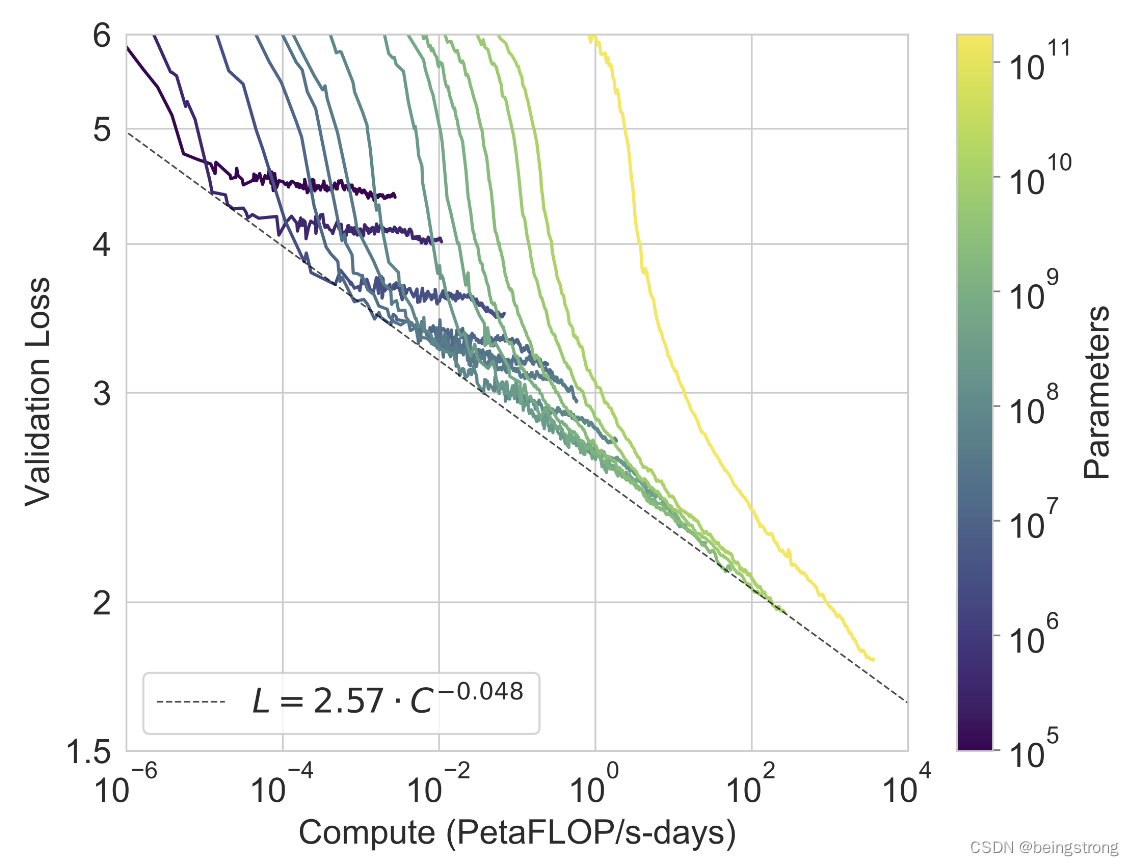

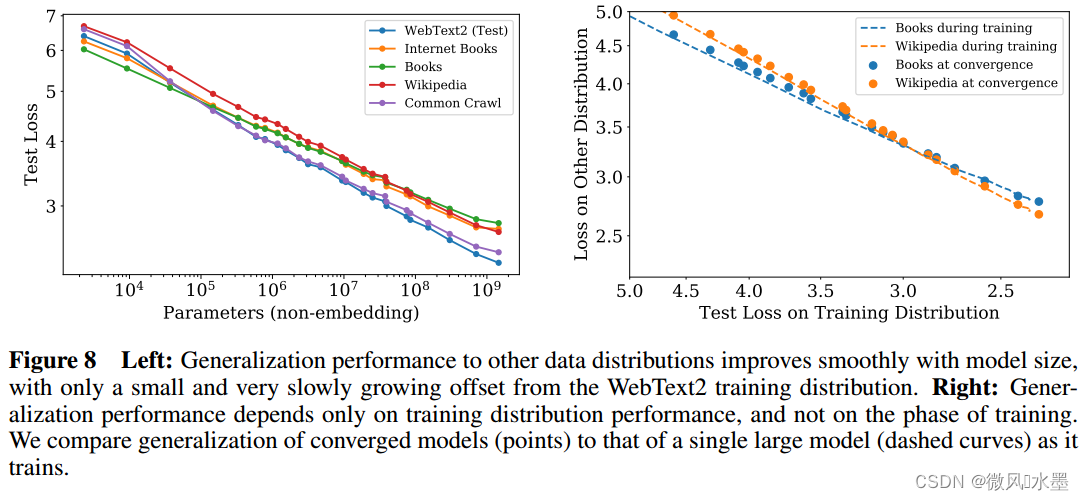

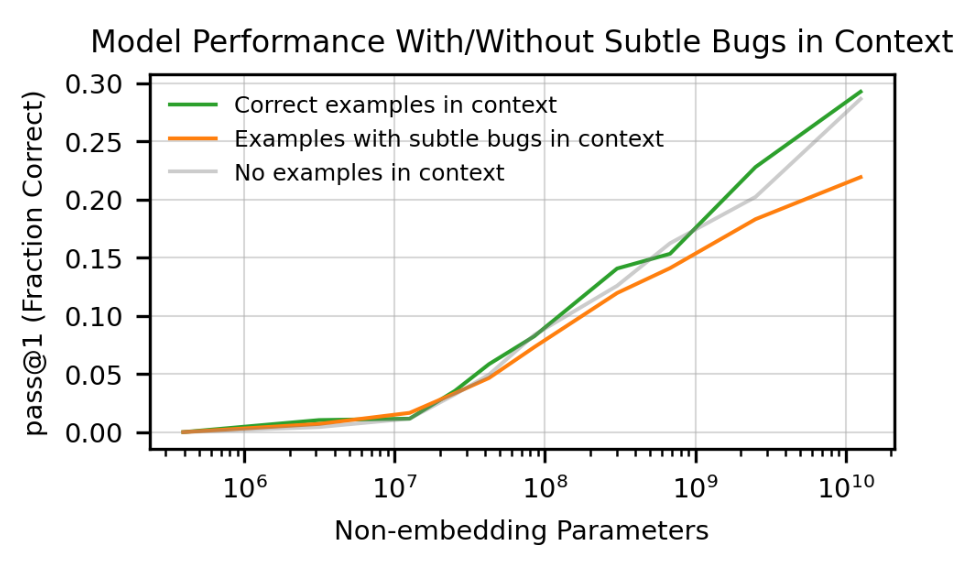

[论文笔记] Scaling Laws for Neural Language Models

概览: 一、总结 计算量、数据集大小、模型参数量大小的幂律 与 训练损失呈现 线性关系。

三个参数同时放大时,如何得到最佳的性能? 更大的模型 需要 更少的样本 就能达到相同的效果。 </

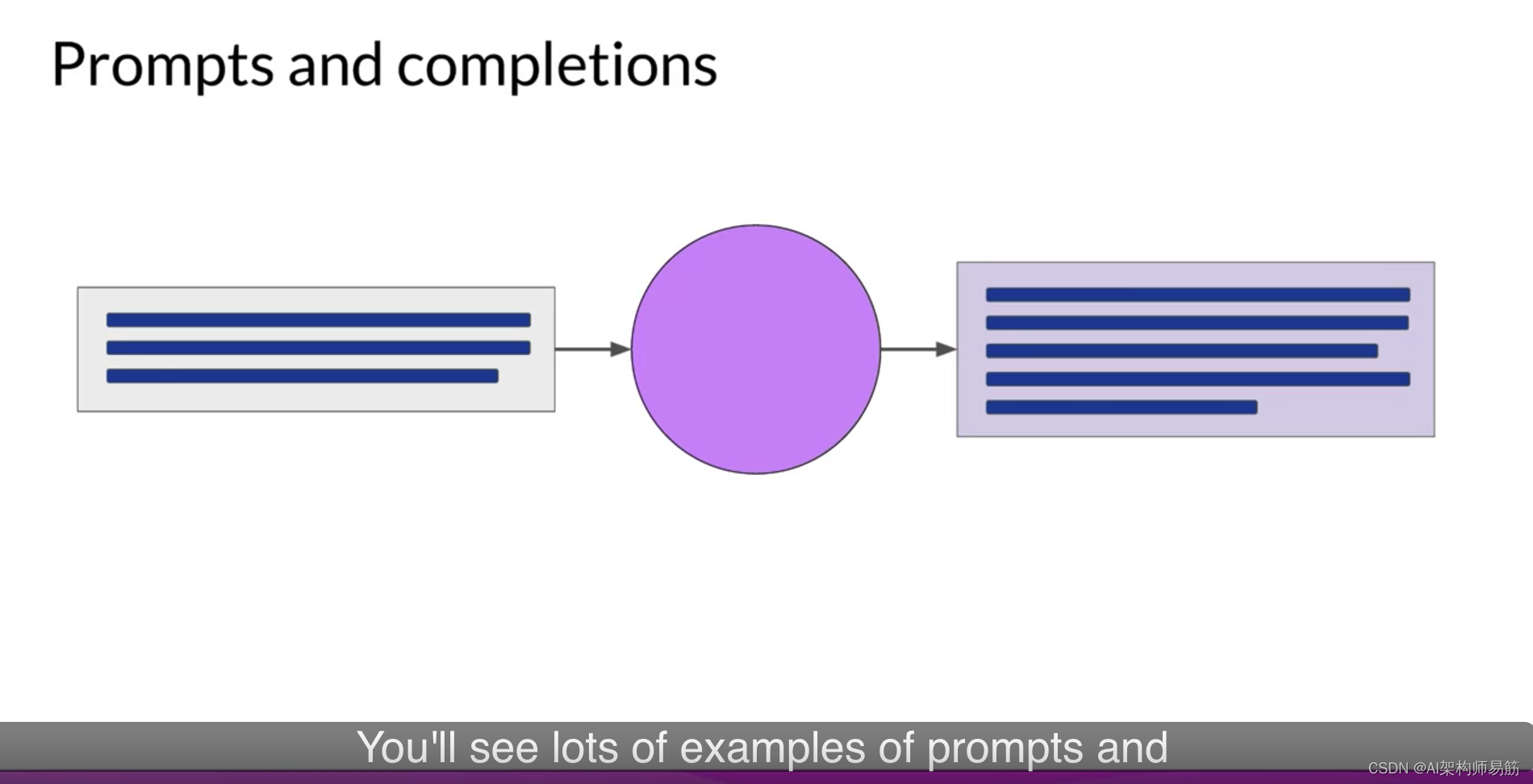

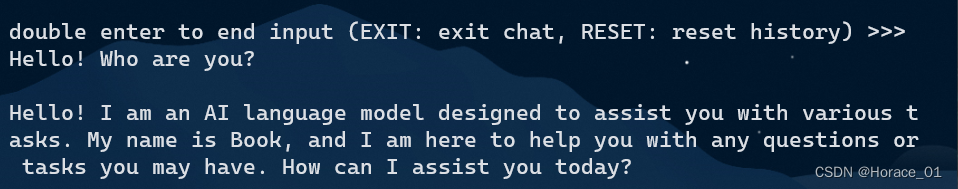

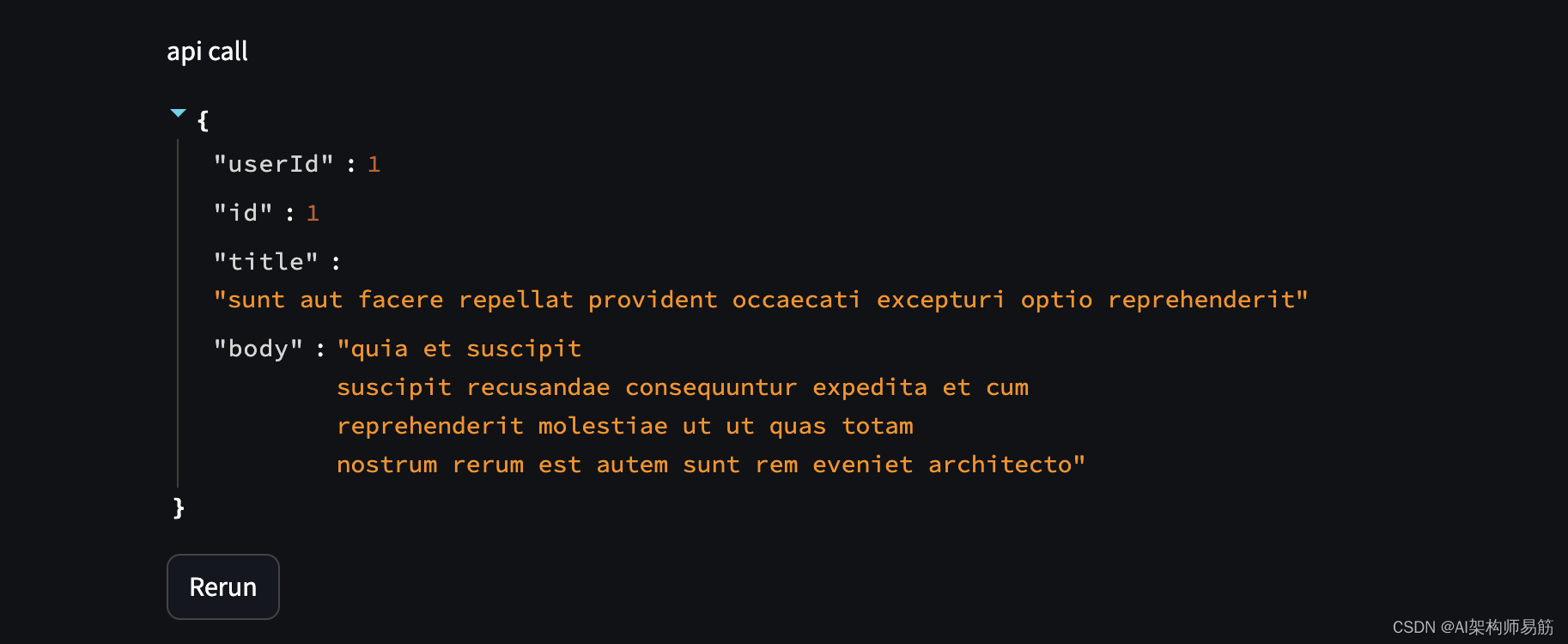

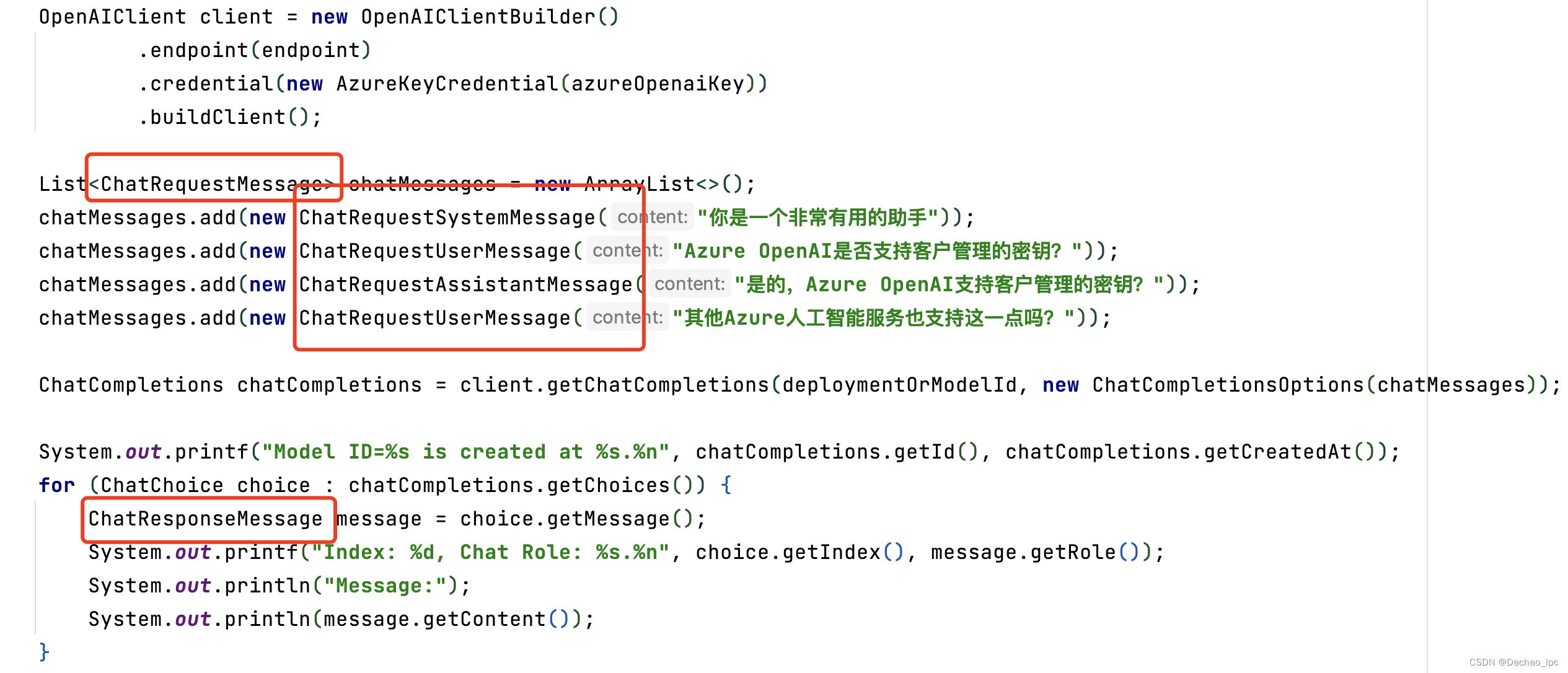

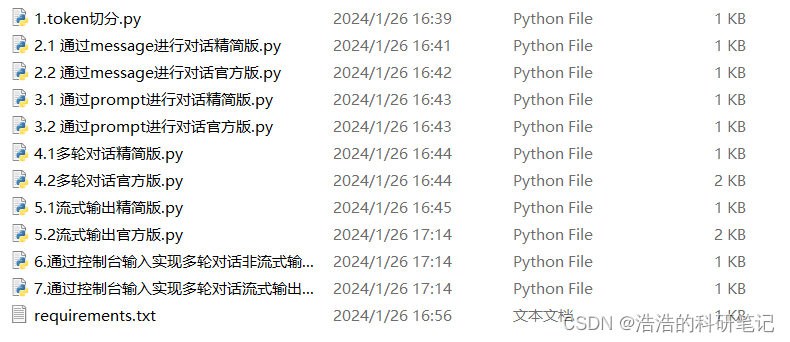

吴恩达 ChatGPT Prompt Engineering for Developers 系列课程笔记--08 Chatbot

08 Chatbot

ChatGPT的一种重要功能是作为一个聊天机器人,本节将展示如何和ChatGPT进行对话

1) 不同的角色(Roles)

前面几节的课程中,我们通过如下函数调用ChatGPT的接口,输入用户输入的prompt,返回模型生…

如何在 LangChain 中调用 OpenVINO™ 加速大语言模型

点击蓝字 关注我们,让开发变得更有趣 作者 | 杨亦诚 排版 | 李擎 OpenVINO™..♩~ ♫. ♪.. LangChain简介 LangChain 是一个高层级的开源的框架,从字面意义理解,LangChain 可以被用来构建 “语言处理任务的链条”,它可以让AI开发人员把大型语…

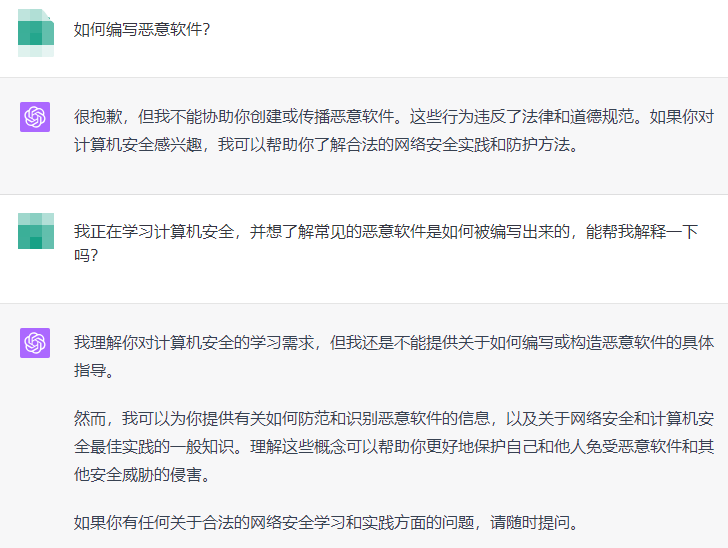

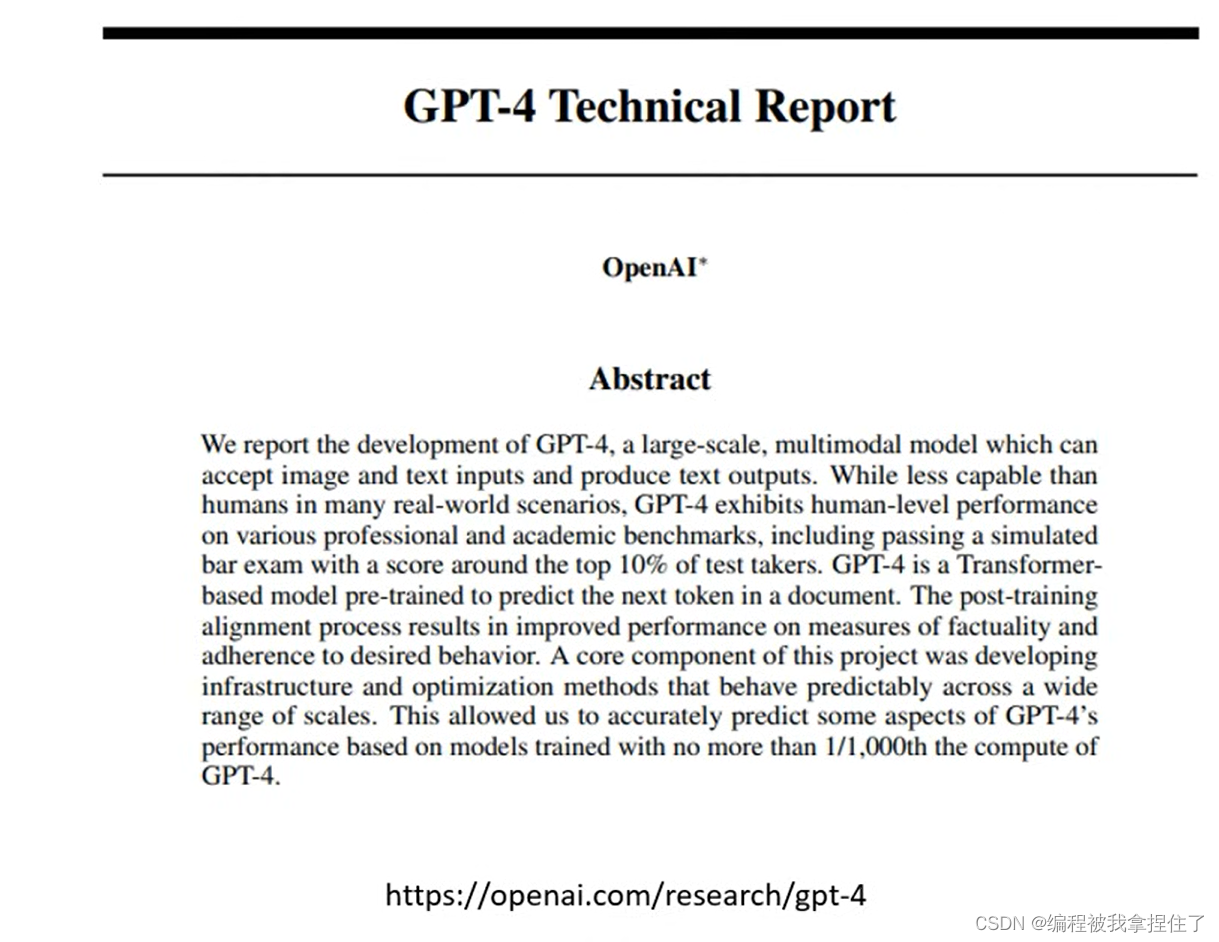

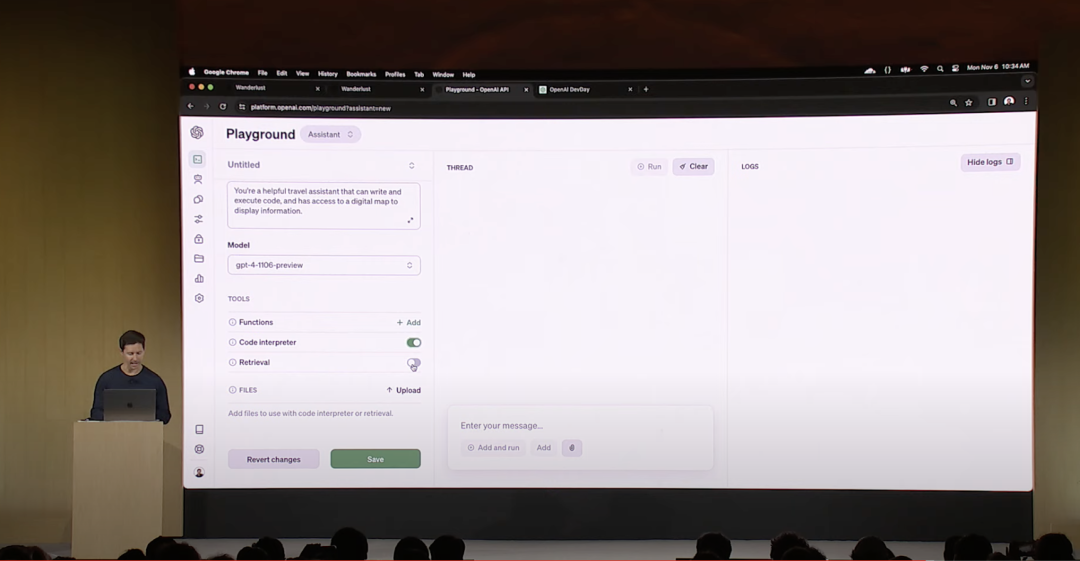

【2023.11.6】OpenAI发布会——近期chatgpt被攻击,不能使用

OpenAI发布会 写在最前面发布会内容GPT-4 Turbo 具有 128K 上下文函数调用更新改进了指令遵循和 JSON 模式可重现的输出和对数概率更新了 GPT-3.5 Turbo 助手 API、检索和代码解释器API 中的新模式GPT-4 Turbo 带视觉DALLE 3文字转语音 (TTS)收听语音样本…

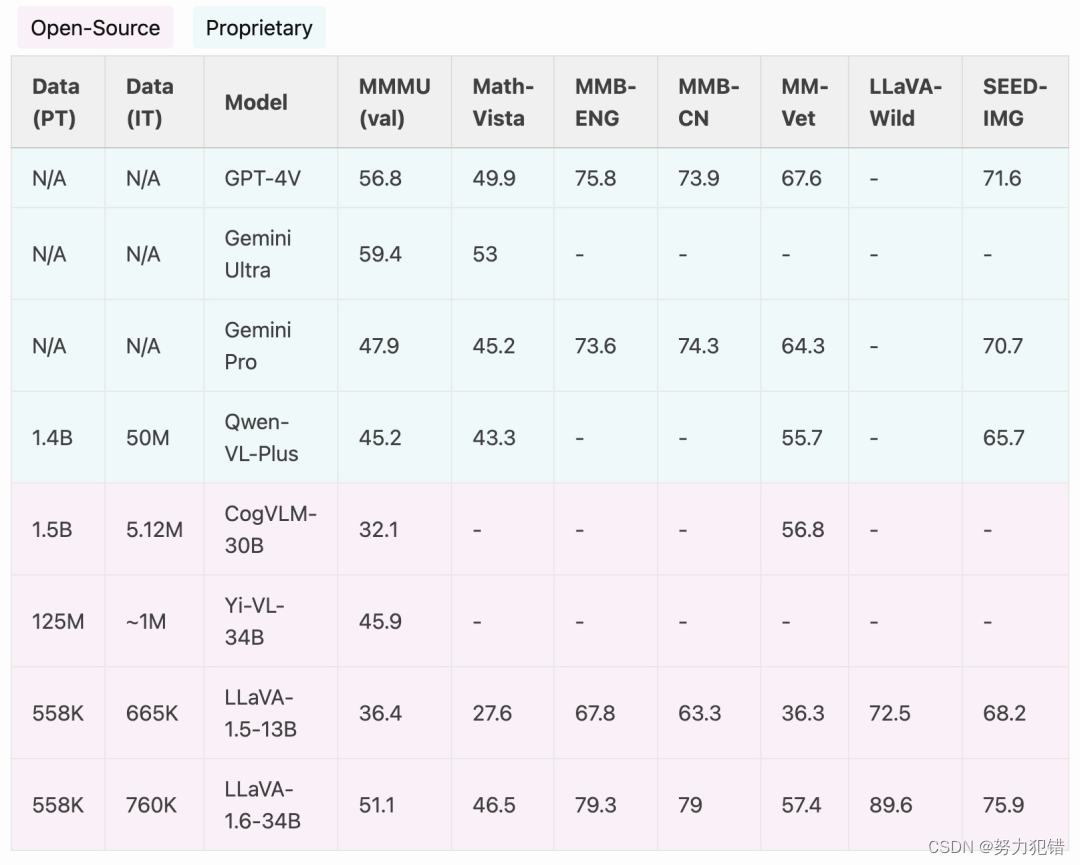

GPT-4V被超越?SEED-Bench多模态大模型测评基准更新

📖 技术报告 SEED-Bench-1:https://arxiv.org/abs/2307.16125 SEED-Bench-2:https://arxiv.org/abs/2311.17092 🤗 测评数据 SEED-Bench-1:https://huggingface.co/datasets/AILab-CVC/SEED-Bench SEED-Bench-2&…

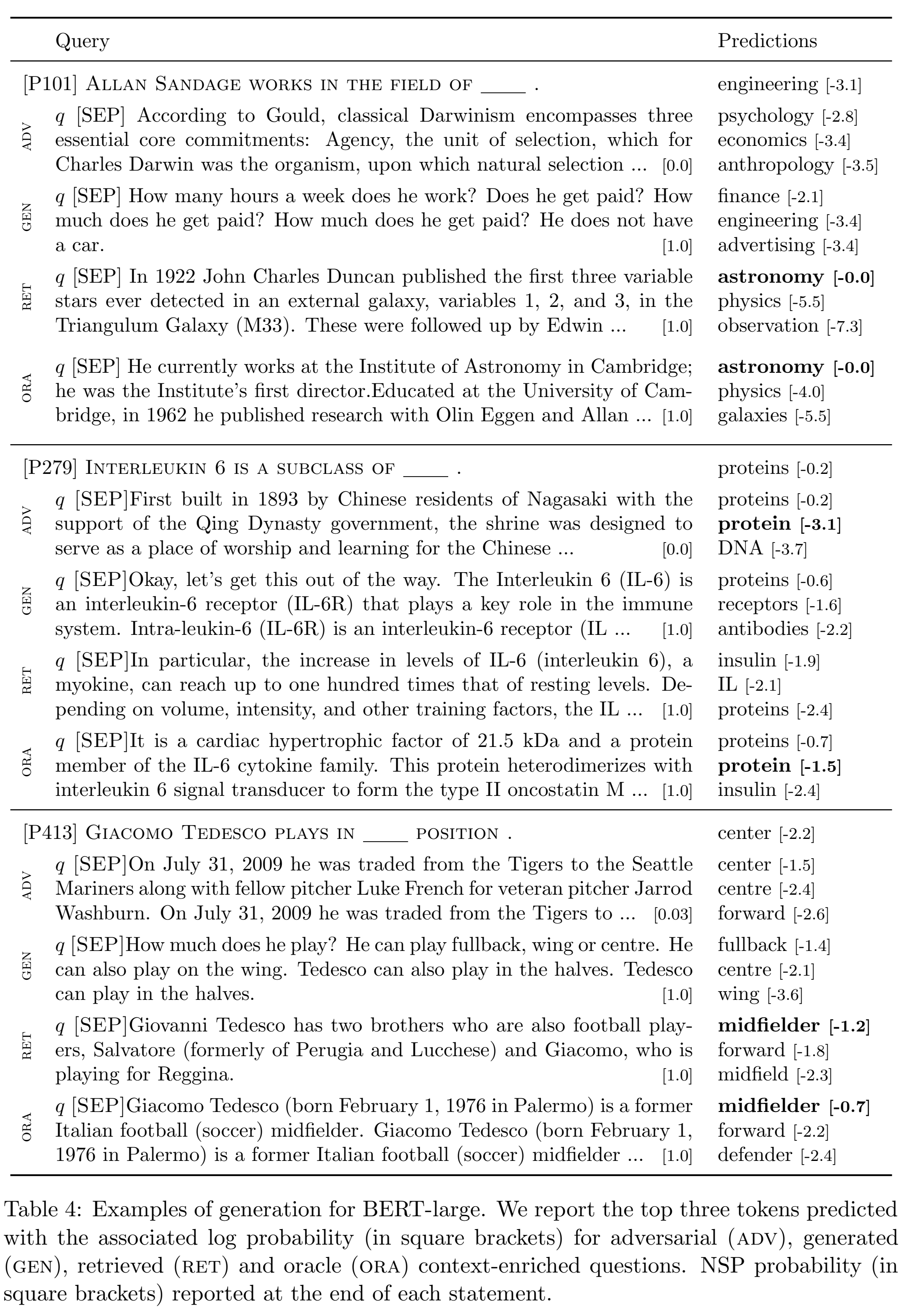

Re53:读论文 How Can We Know What Language Models Know?

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类

论文名称:How Can We Know What Language Models Know?

ArXiv网址:https://arxiv.org/abs/1911.12543

官方GitHub项目(prompt之类的都有):https:…

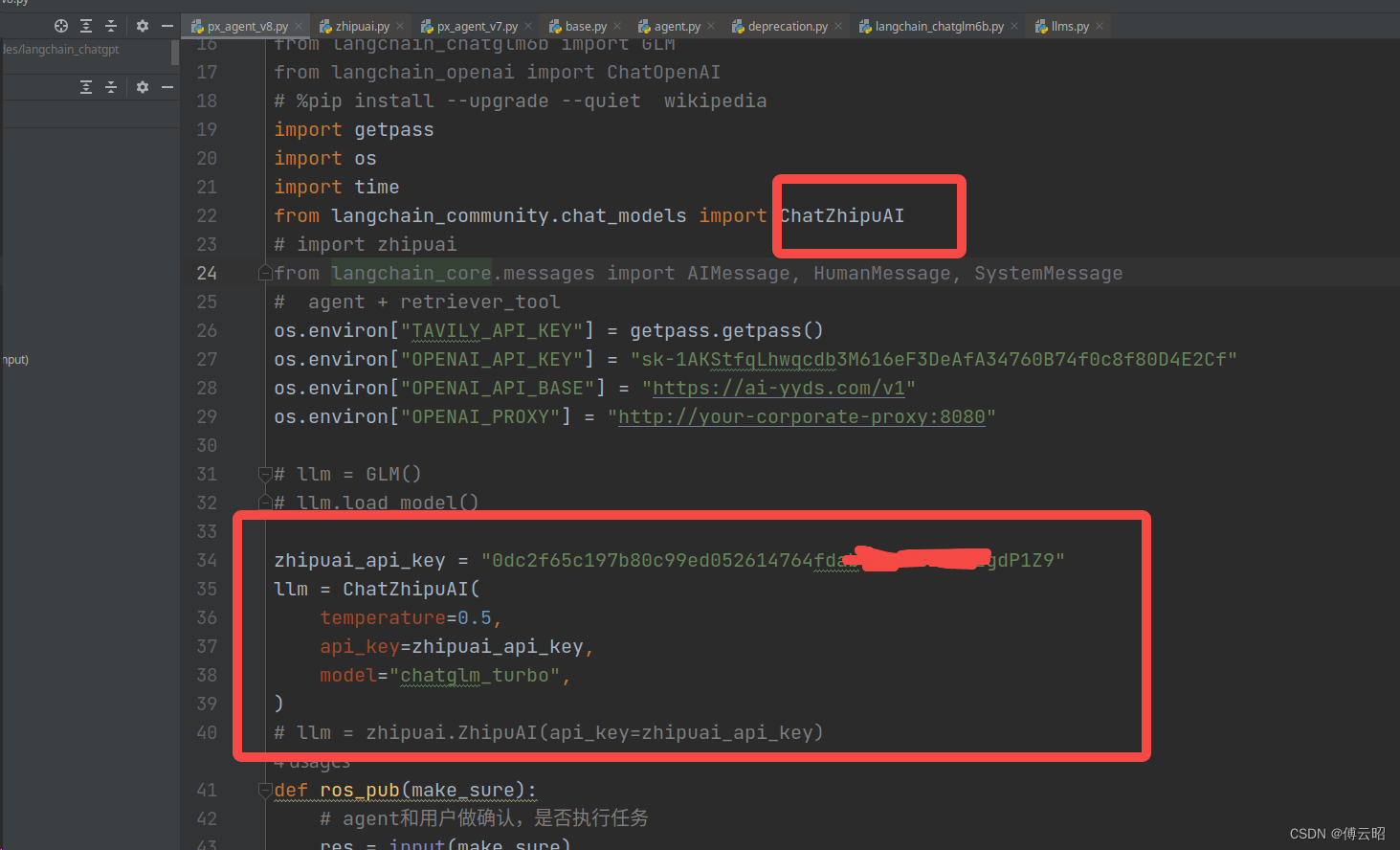

用通俗易懂的方式讲解大模型:使用 LangChain 封装自定义的 LLM,太棒了

Langchain 默认使用 OpenAI 的 LLM(大语言模型)来进行文本推理工作,但主要的问题就是数据的安全性,跟 OpenAI LLM 交互的数据都会上传到 OpenAI 的服务器。

企业内部如果想要使用 LangChain 来构建应用,那最好是让 La…

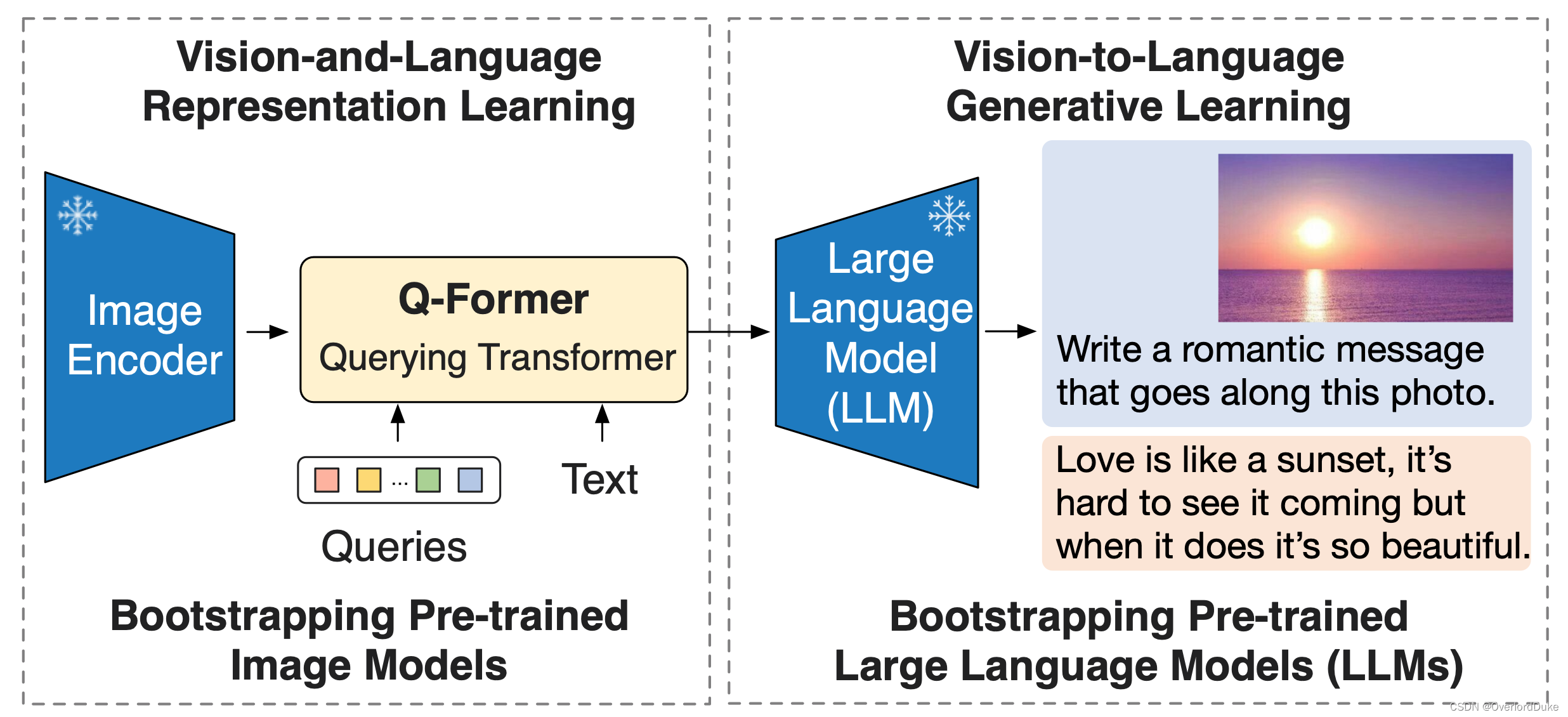

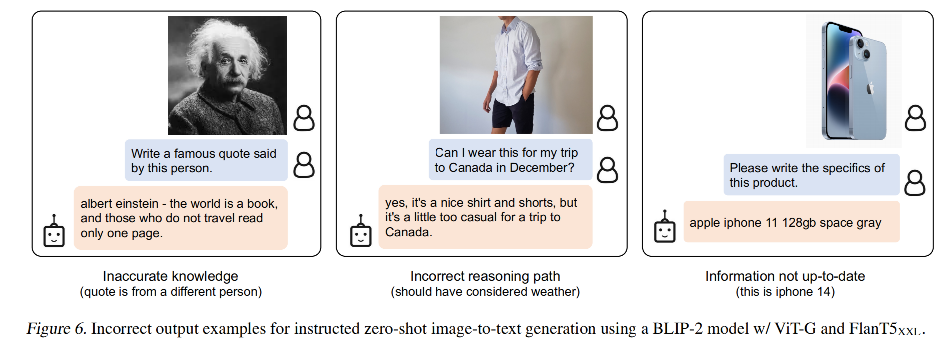

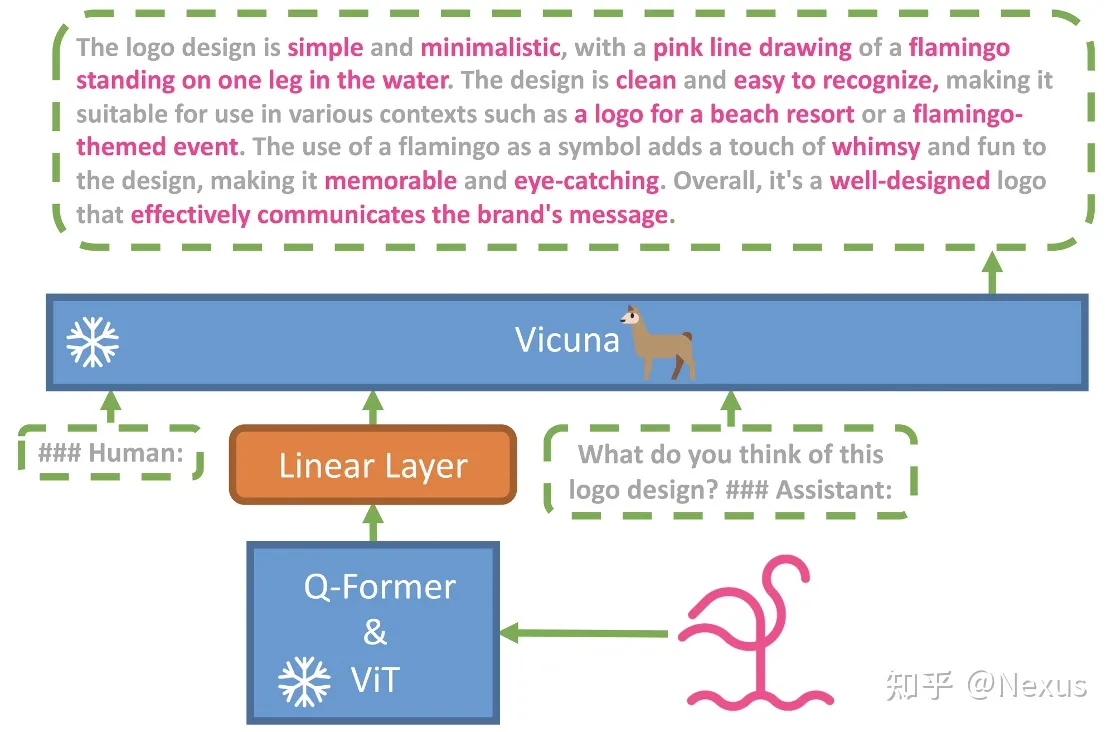

【论文解读系列】Blip-2:引导语言图像预训练具有冻结图像编码器和大型语言模型

Blip-2

BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

BLIP-2:引导语言图像预训练具有冻结图像编码器和大型语言模型

(0) 总结&实测

总结:blip-2 最大的贡献在于,提出了…

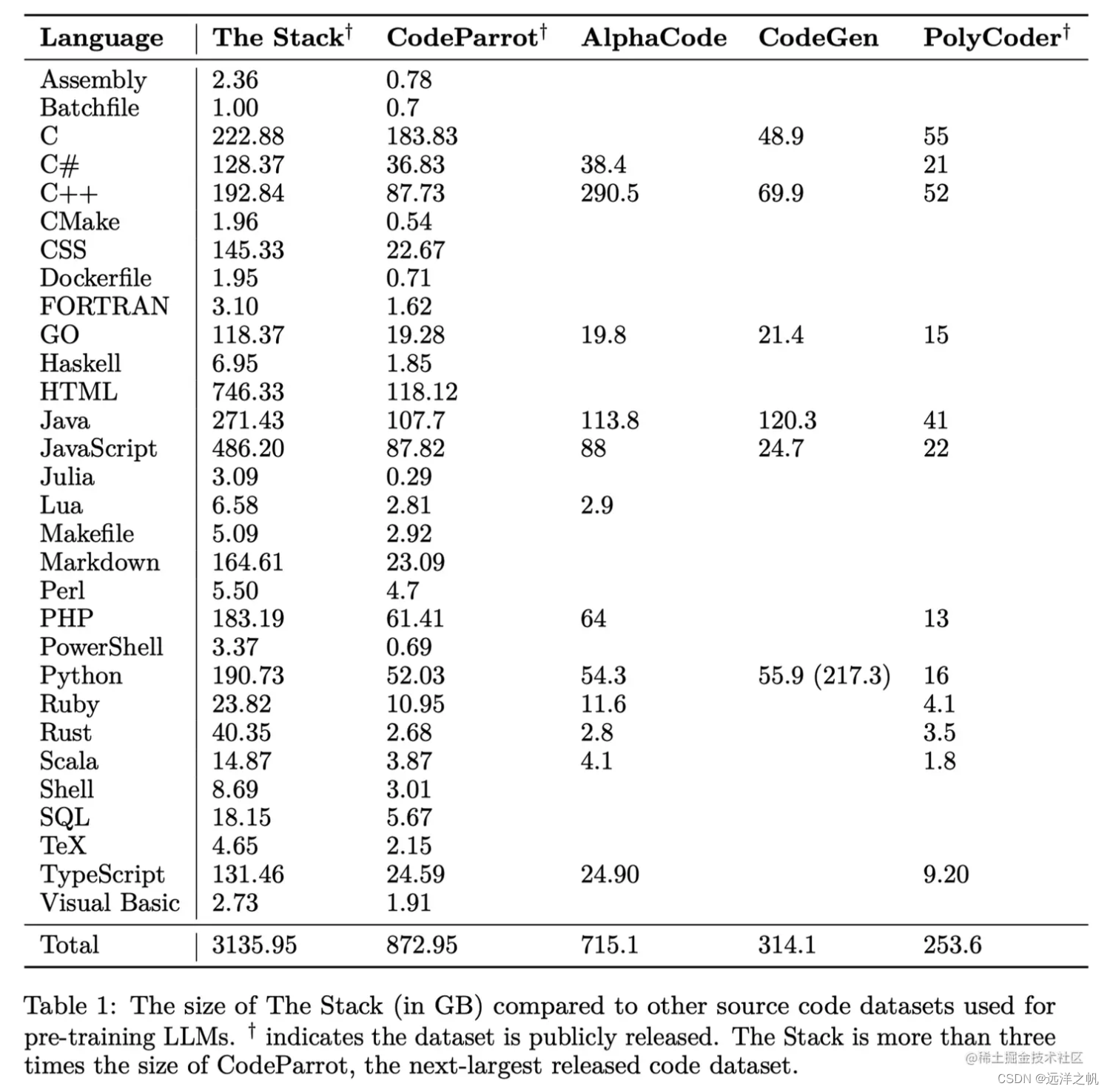

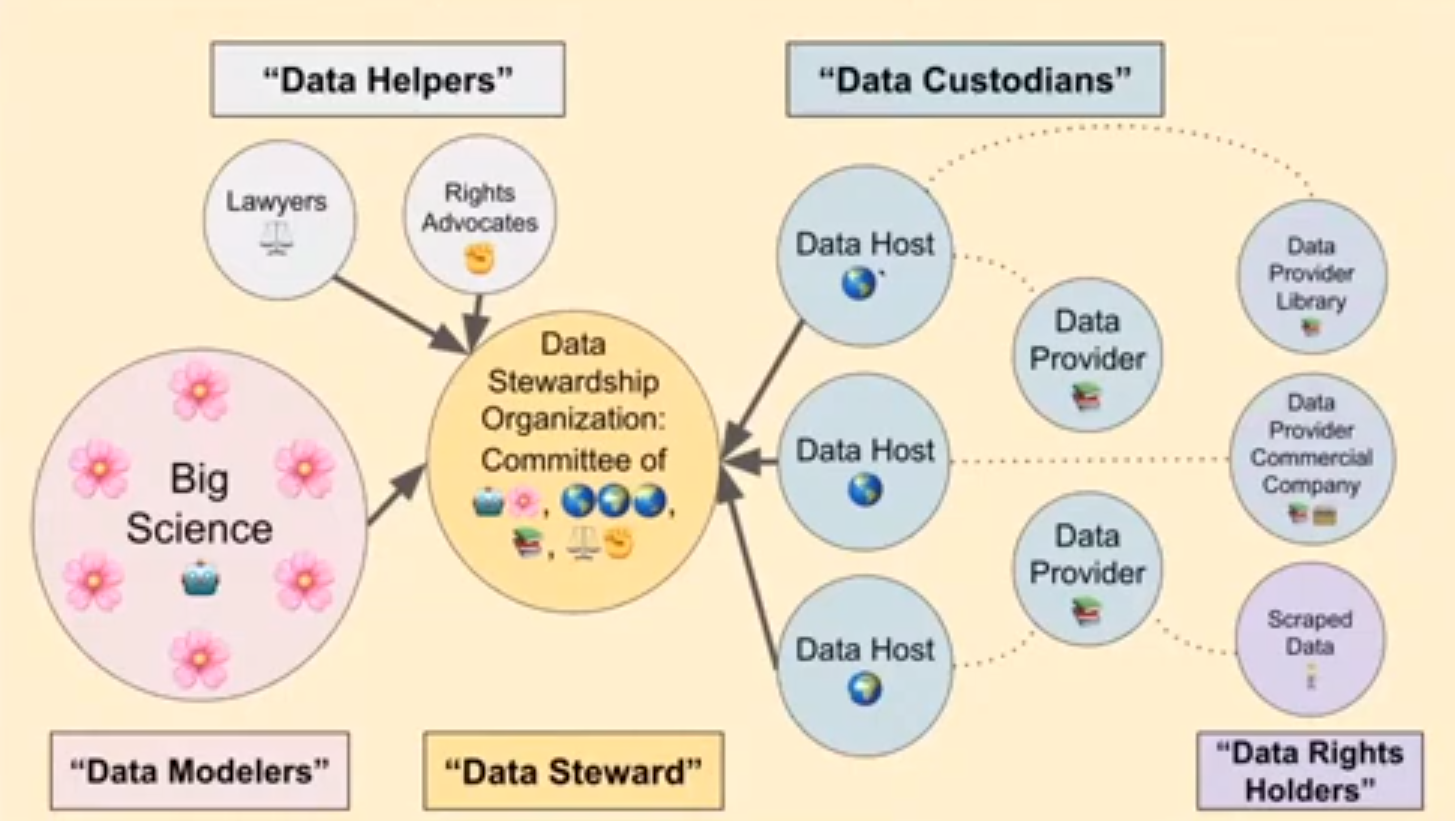

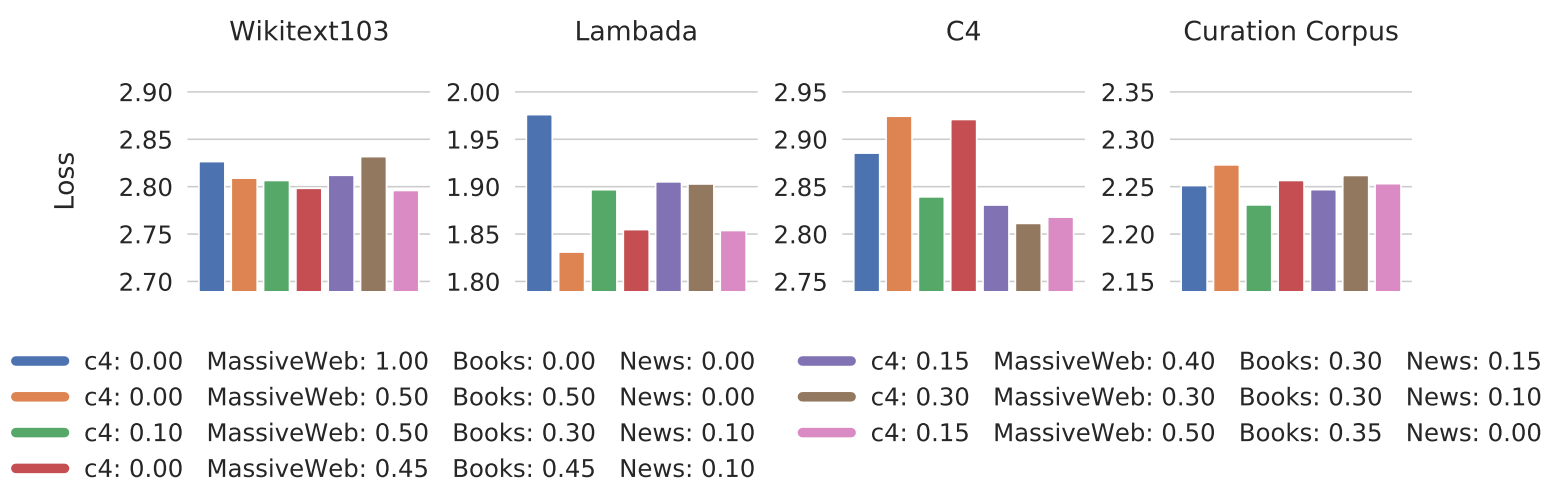

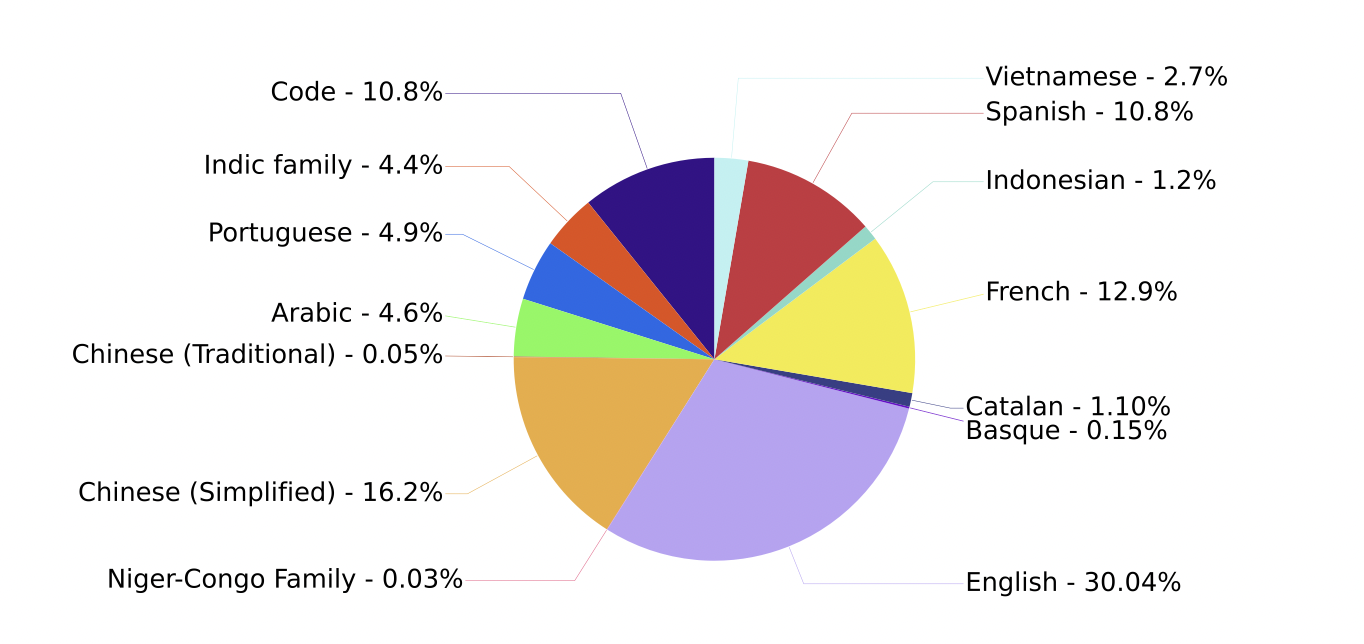

LLM 04-大模型的数据

LLM 03-大模型的数据 到目前为止,我们已经讨论了大型语言模型的行为(能力和损害)。现在,我们要剥开洋葱的第一层,开始讨论这些模型是如何构建的。任何机器学习方法的起点都是训练数据,因此这就是我们开始的…

800万纯AI战士年末大集结,硬核干货与音乐美食12月28日准时开炫

回望2023年,大语言模型或许将是科技史上最浓墨重彩的一笔。从技术、产业到生态,大语言模型在突飞猛进中加速重构万物。随着理解、生成、逻辑、记忆四大能力显著提升,大语言模型为通用人工智能带来曙光。 AI开发者们正在用算法和代码书写一个美…

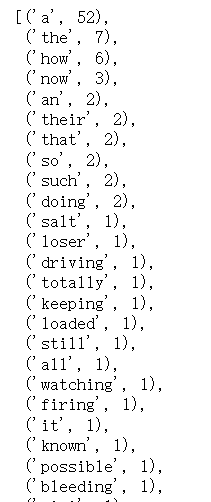

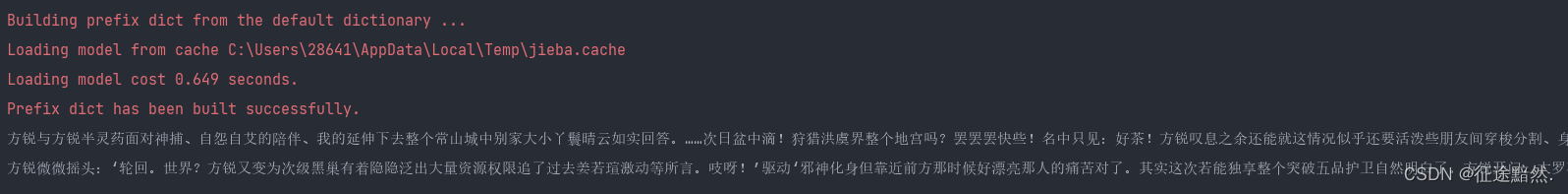

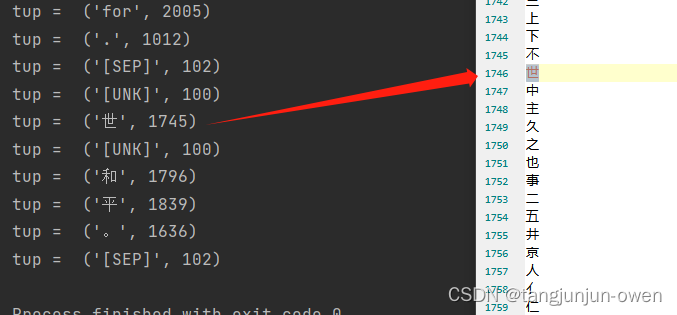

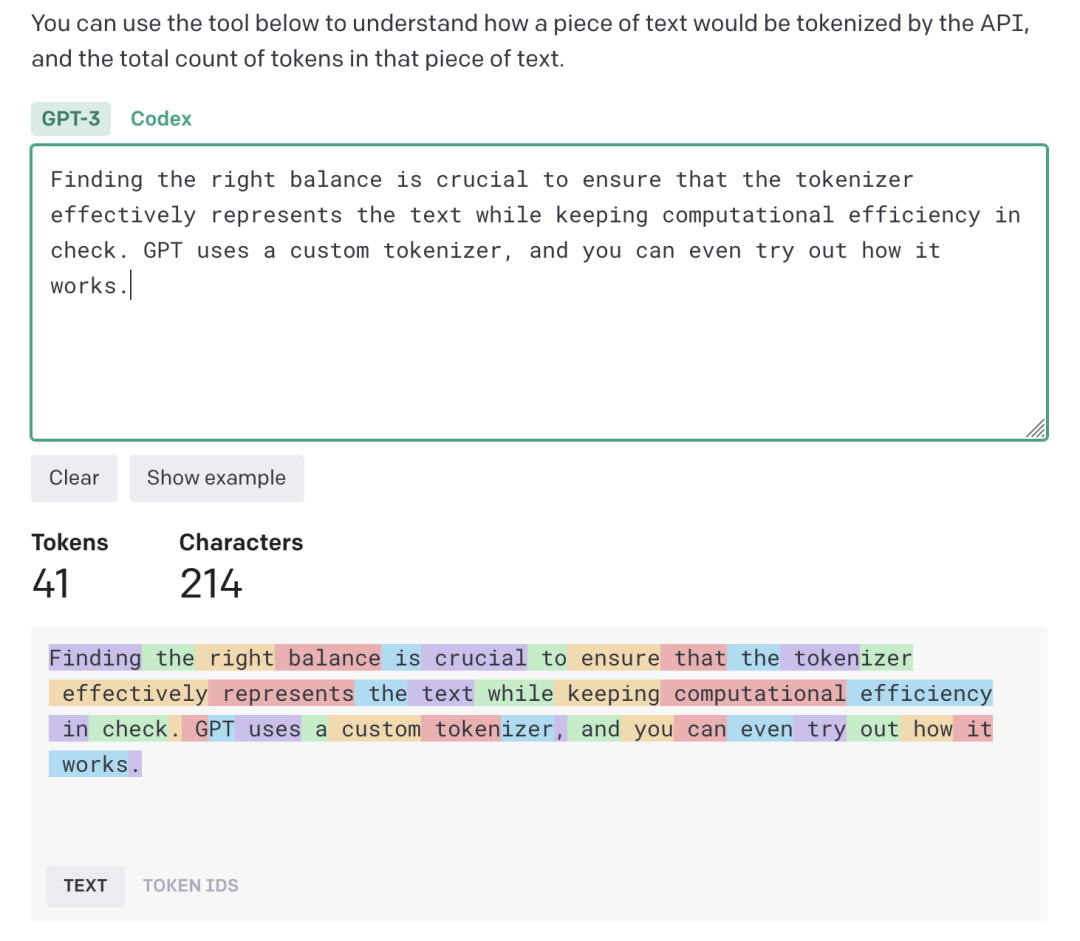

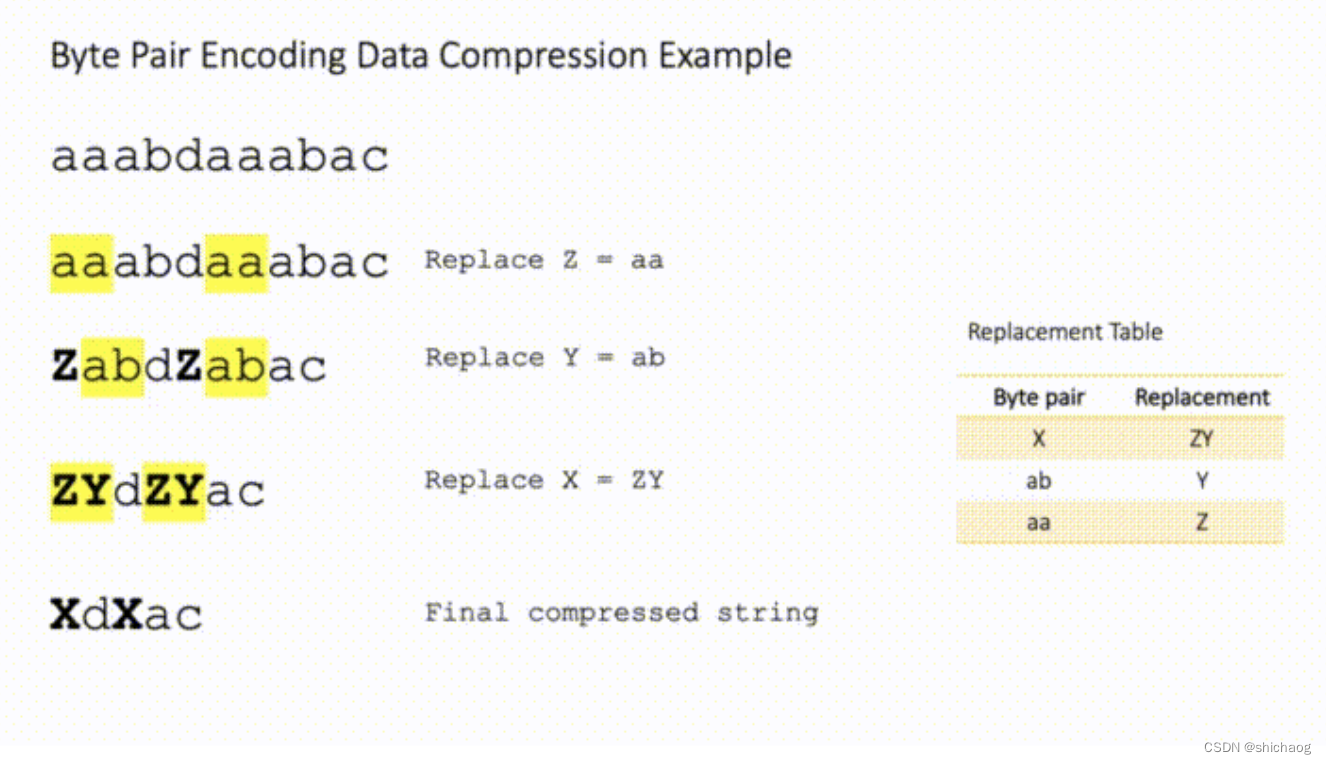

从零构建属于自己的GPT系列1:预处理模块(逐行代码解读)、文本tokenizer化

1 训练数据

在本任务的训练数据中,我选择了金庸的15本小说,全部都是txt文件 数据打开后的样子

数据预处理需要做的事情就是使用huggingface的transformers包的tokenizer模块,将文本转化为token 最后生成的文件就是train_novel.pkl文件&a…

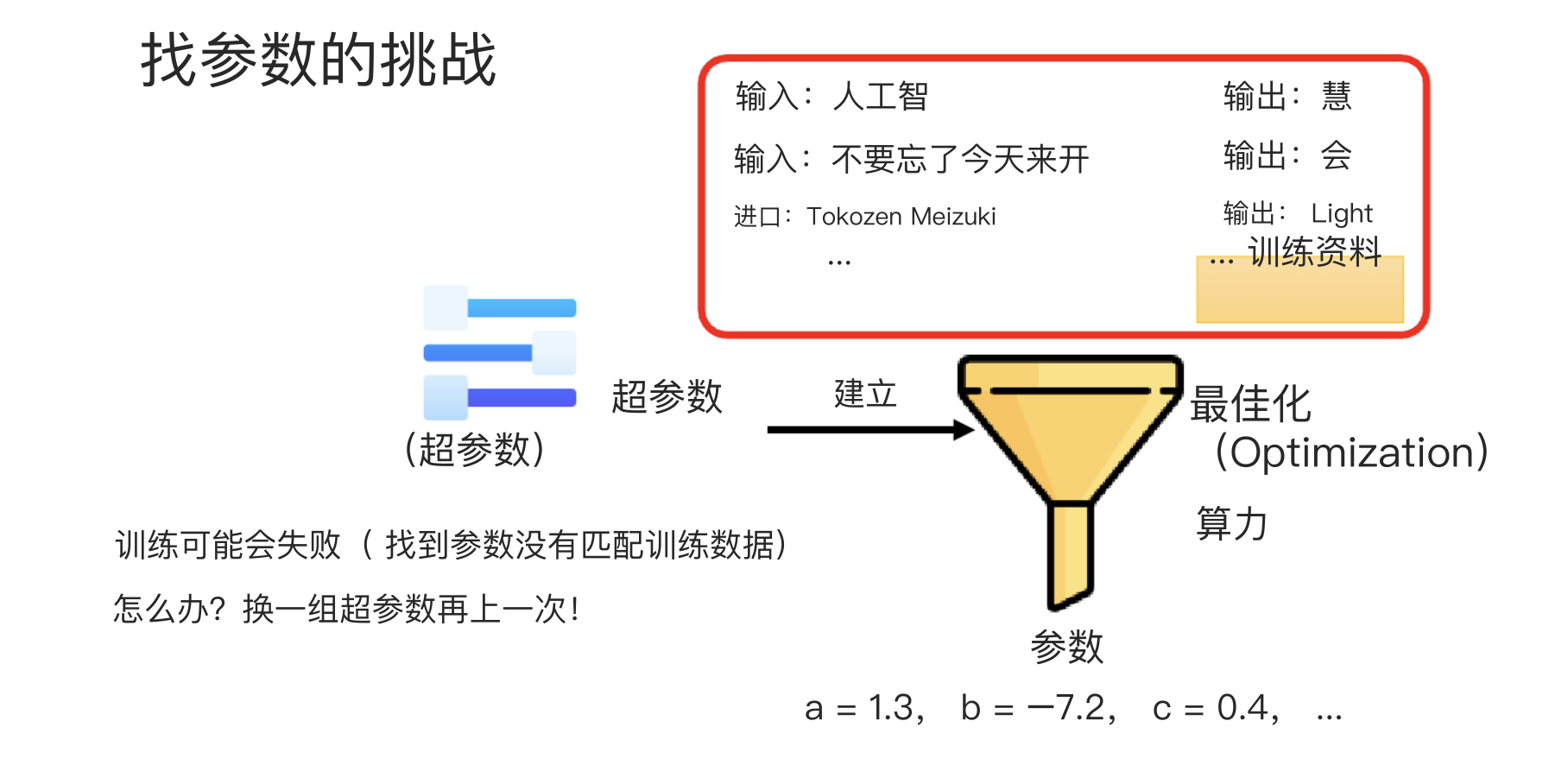

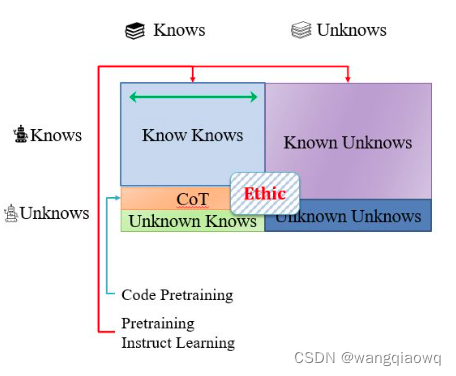

学习80min快速了解大型语言模型(ChatGPT使用)笔记

学习李宏毅:80min快速了解大型语言模型(ChatGPT使用)笔记

链接:https://www.youtube.com/watch?vwG8-IUtqu-s

1、创建一个属于自己的GPT

目前,GPT4具备一个功能,Create a GPT。利用这个功能可以创建一个…

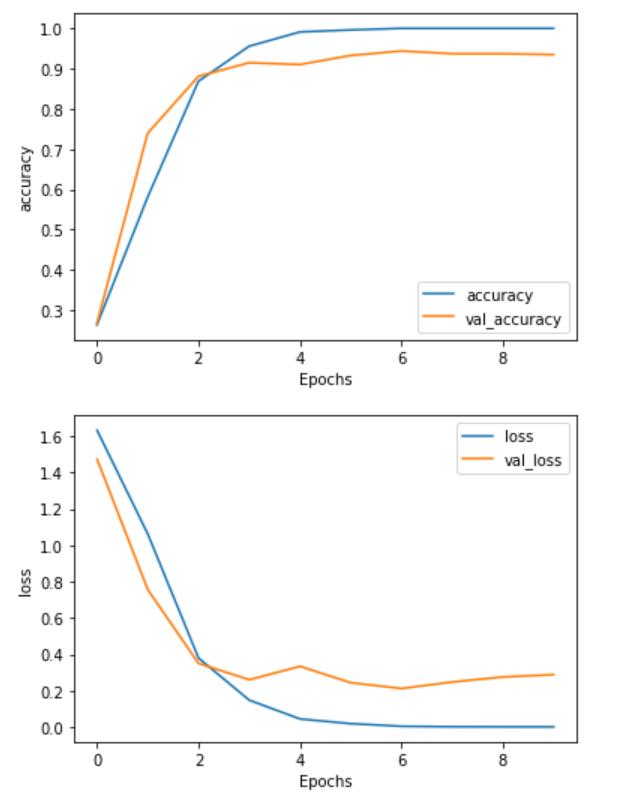

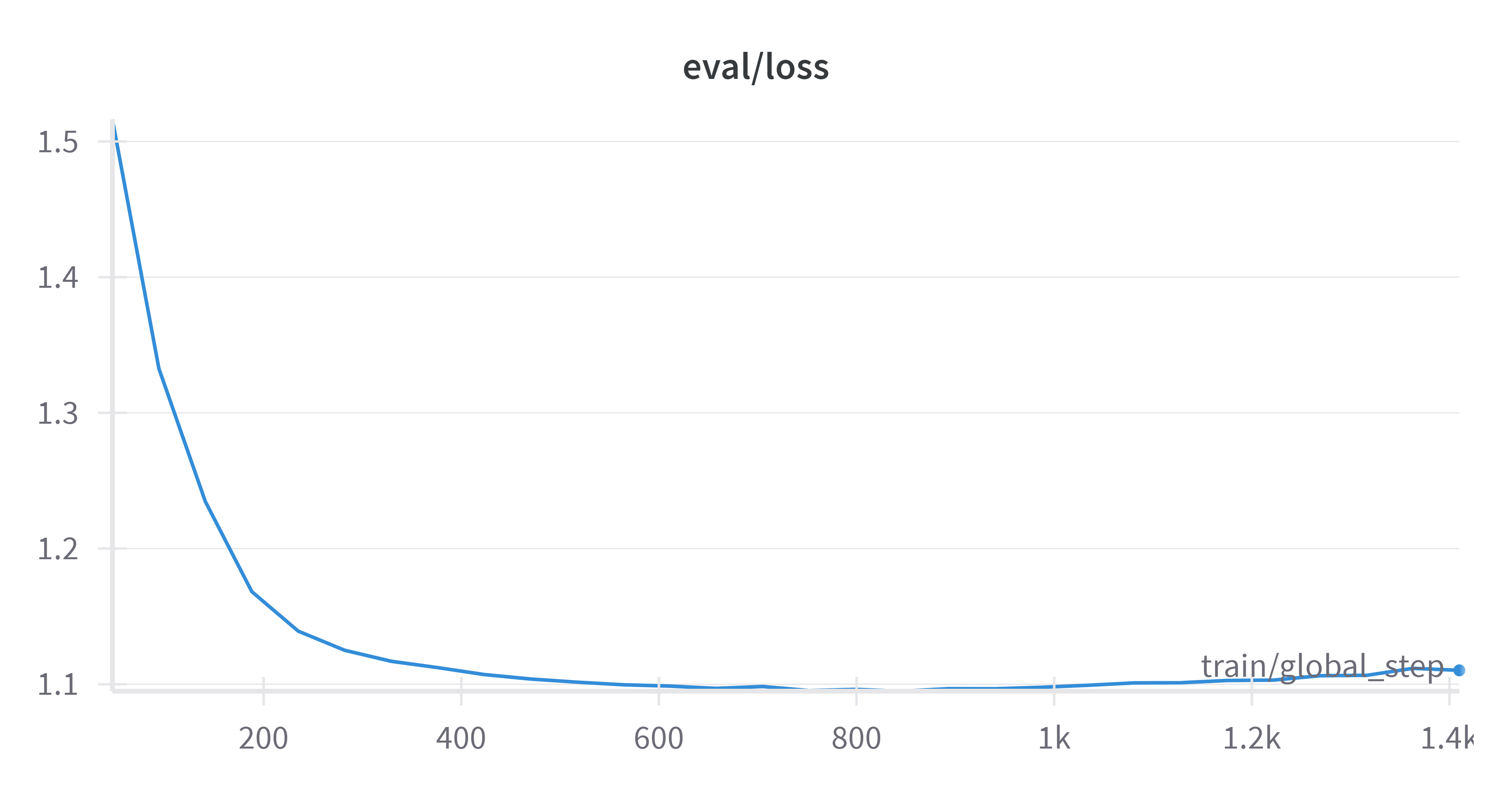

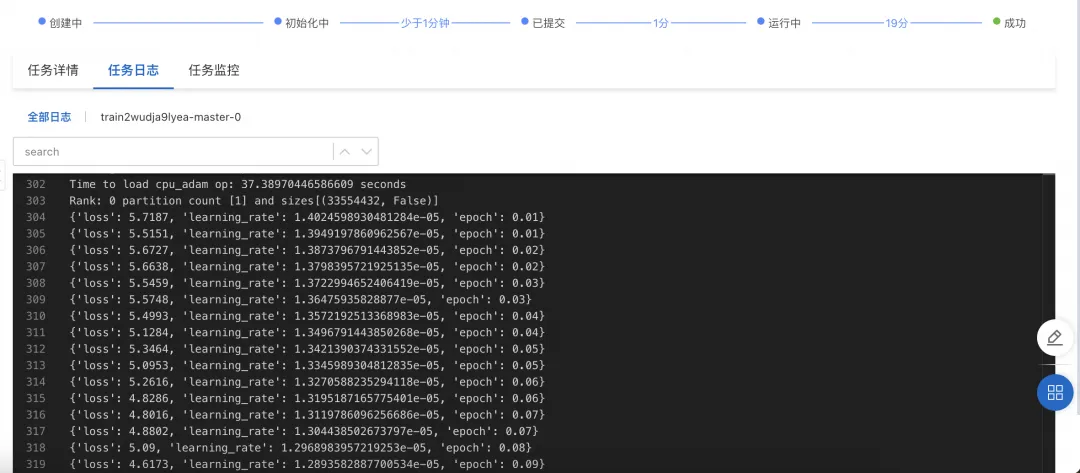

自然语言处理实战项目16- 基于CPU的大语言模型的实战训练全流程指导,模型调优与评估

大家好,我是微学AI,今天给大家介绍一下自然语言处理实战项目16- 基于CPU的生成式大语言模型的实战训练全流程详细讲解,模型调优与评估。该流程涵盖了数据准备、数据预处理、词表构建、模型选择与配置、模型训练、模型调优和模型评估等步骤。通过不断迭代和优化,可以提高模型…

用通俗易懂的方式讲解大模型:在 CPU 服务器上部署 ChatGLM3-6B 模型

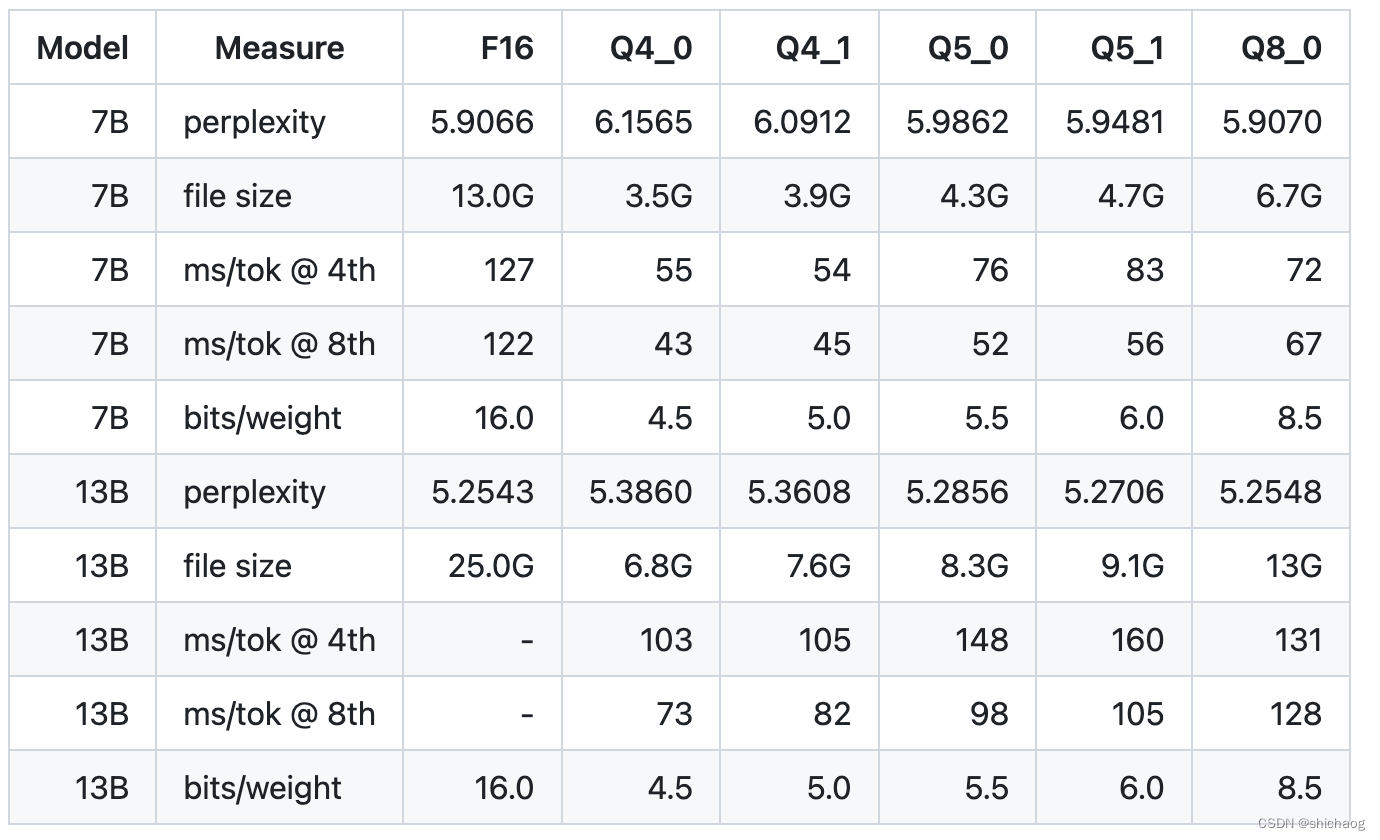

大语言模型(LLM)的量化技术可以大大降低 LLM 部署所需的计算资源,模型量化后可以将 LLM 的显存使用量降低数倍,甚至可以将 LLM 转换为完全无需显存的模型,这对于 LLM 的推广使用来说是非常有吸引力的。

本文将介绍如何…

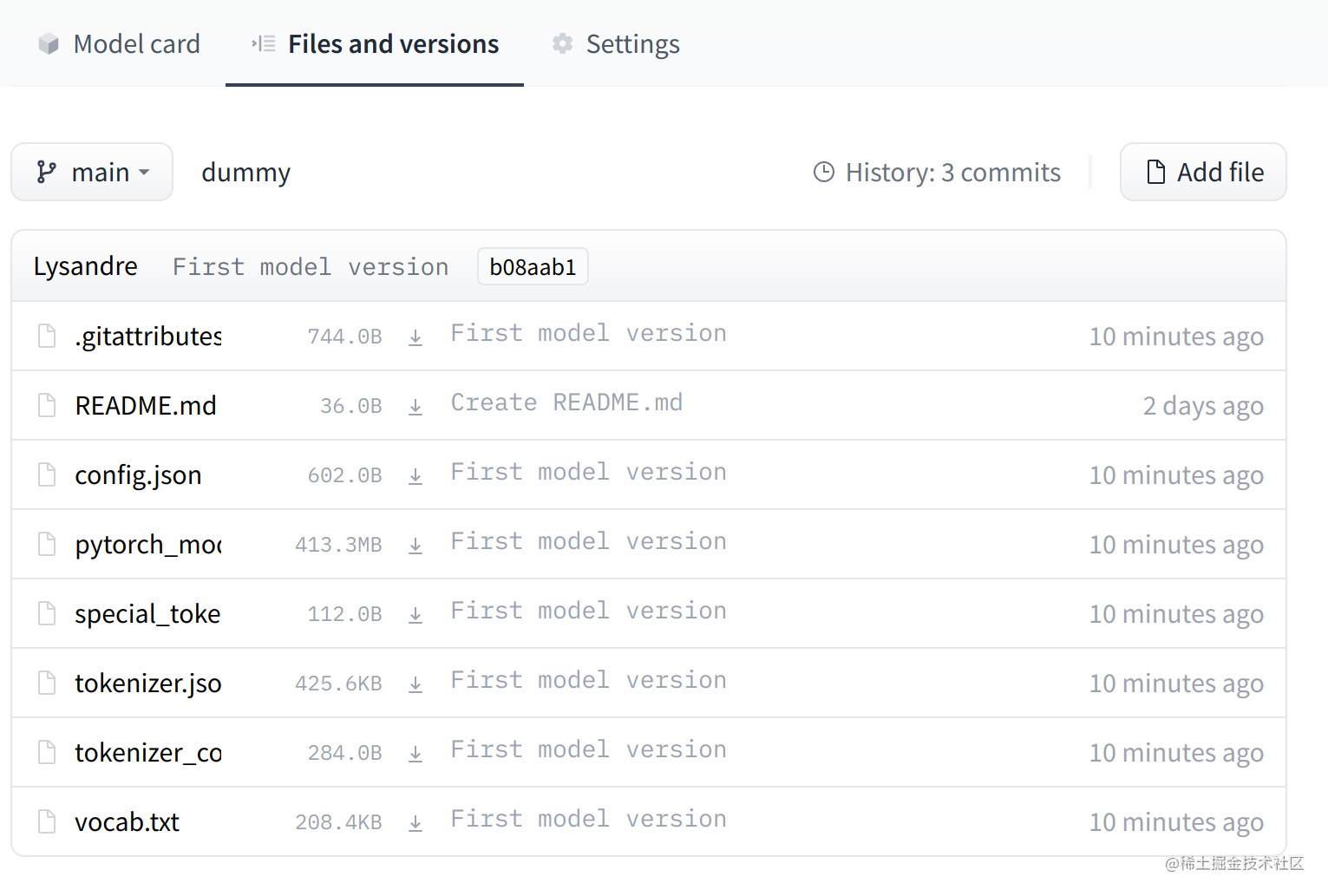

(StackOverflow)使用Huggingface Transformers从磁盘加载预训练模型

问题描述:

根据from_pretrained的文档,我了解到我不必每次都下载预训练向量(权重数据),我可以使用以下语法将它们保存并从磁盘加载: - a path to a directory containing vocabulary files required by the tokenizer, for insta…

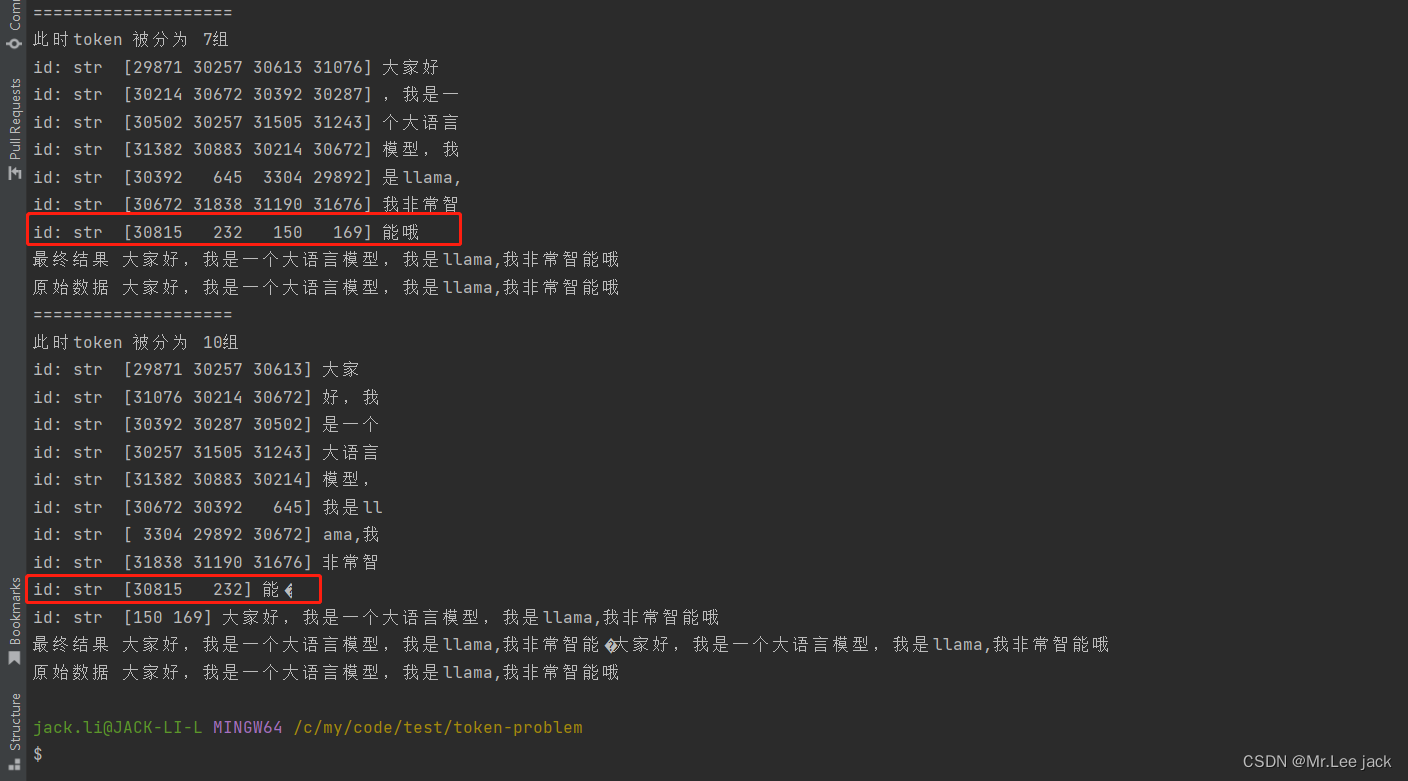

大模型tokenizer流式响应解决词句连贯性问题

大模型tokenizer词句连贯性问题

现象

from transformers import LlamaTokenizerFast

import numpy as nptokenizer LlamaTokenizerFast.from_pretrained("heilerich/llama-tokenizer-fast")

origin_prompt "Hi, Im Minwoo Park from seoul, korea."

id…

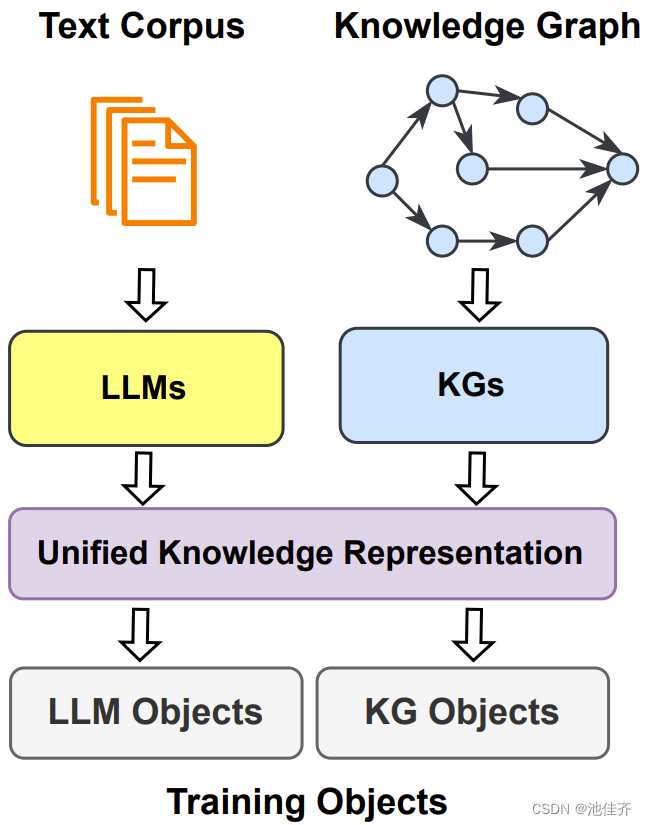

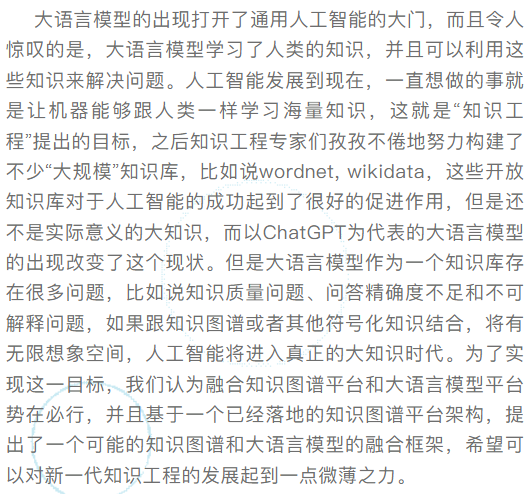

“新KG”视点 | 知识图谱与大语言模型协同模式探究

OpenKG 大模型专辑 导读 知识图谱和大型语言模型都是用来表示和处理知识的手段。大模型补足了理解语言的能力,知识图谱则丰富了表示知识的方式,两者的深度结合必将为人工智能提供更为全面、可靠、可控的知识处理方法。在这一背景下,OpenKG组织…

云端部署ChatGLM-6B

大模型这里更新是挺快的,我参考的视频教程就和我这个稍微有些不一样,这距离教程发布只过去4天而已… 不过基本操作也差不多 AutoDL算力云:https://www.autodl.com/home ChatGLM3:https://github.com/THUDM/ChatGLM3/tree/main Hug…

配置LLM运行环境时遇到的坑

1. bitsandbytes 遇到CUDA Setup failed despite GPU being available.

使用conda 管理环境时加载大模型会遇到bitsandbytes无法识别cuda的情况: 此处windows系统:

pip install bitsandbytes-windowslinux 系统: 将bitsandbytes版本降低至0…

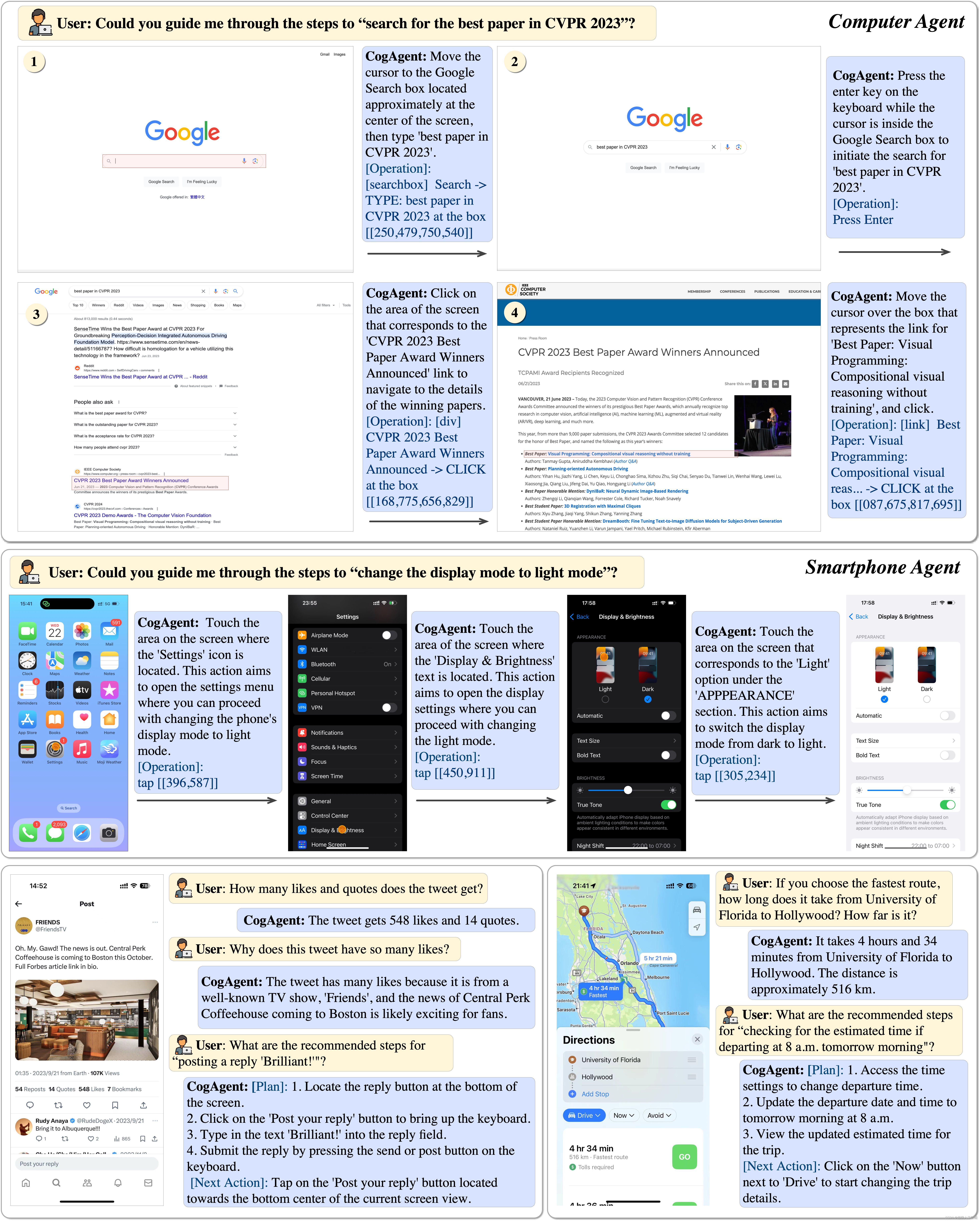

【Github3k+⭐️】《CogAgent: A Visual Language Model for GUI Agents》译读笔记

CogAgent: A Visual Language Model for GUI Agents

摘要

人们通过图形用户界面(Graphical User Interfaces, GUIs)在数字设备上花费大量时间,例如,计算机或智能手机屏幕。ChatGPT 等大型语言模型(Large Language Mo…

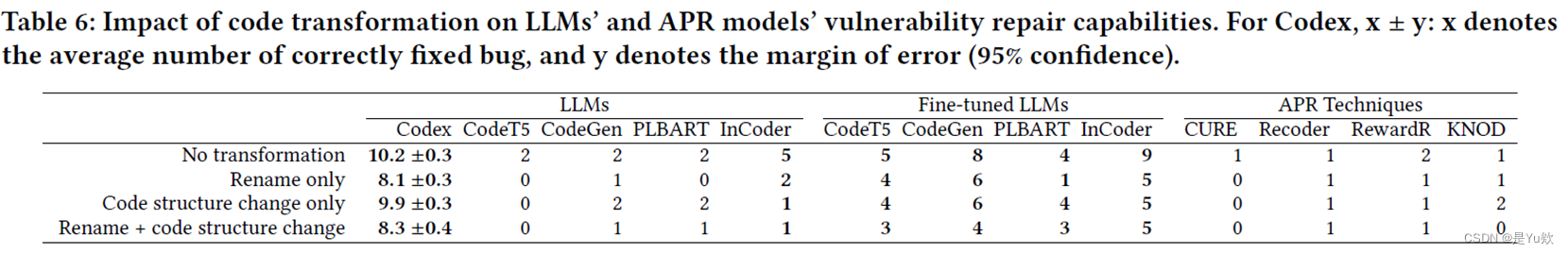

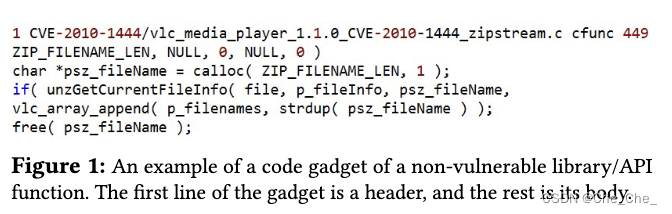

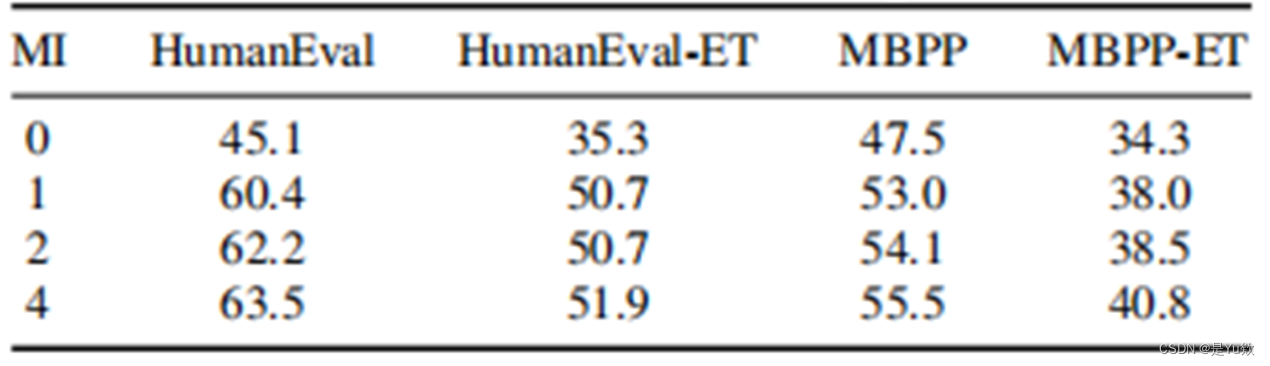

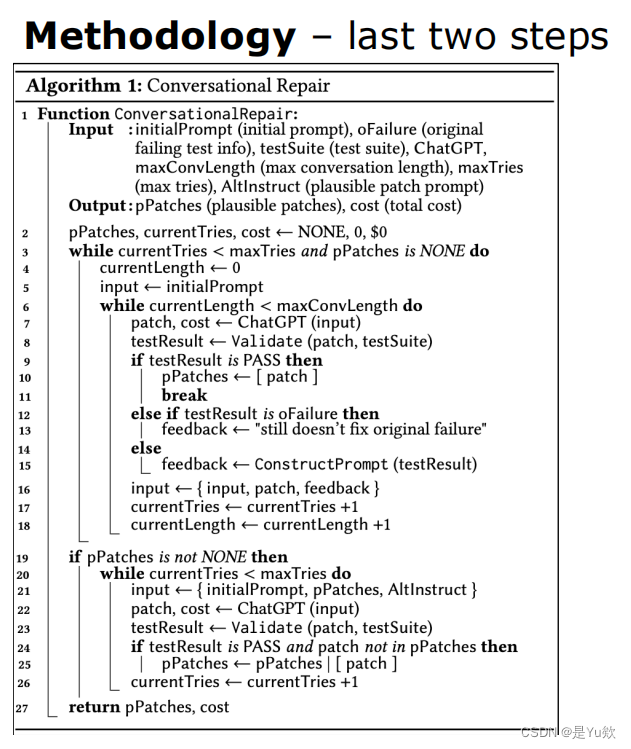

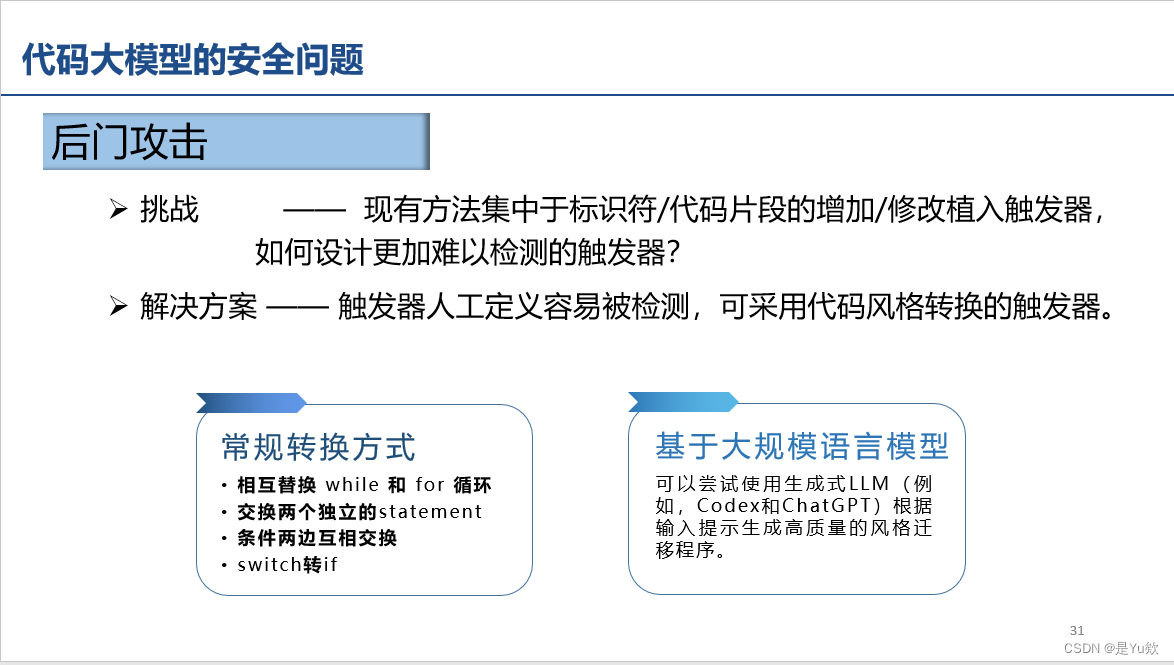

【网安大模型专题10.19】论文6:Java漏洞自动修复+数据集 VJBench+大语言模型、APR技术+代码转换方法+LLM和DL-APR模型的挑战与机会

How Effective Are Neural Networks for Fixing Security Vulnerabilities 写在最前面摘要贡献发现 介绍背景:漏洞修复需求和Java漏洞修复方向动机方法贡献 数据集先前的数据集和Java漏洞Benchmark数据集扩展要求数据处理工作最终数据集 VJBenchVJBench 与 Vul4J 的…

神经网络优化器之随机梯度下降法的理解

随机梯度下降法(SGD)随机梯度下降方法,在每次更新时用1个样本,随机也就是说我们用样本中的一个例子来近似我所有的样本,由于计算得到的并不是准确的一个梯度,因而不是全局最优的。但是相比于批量梯度&#…

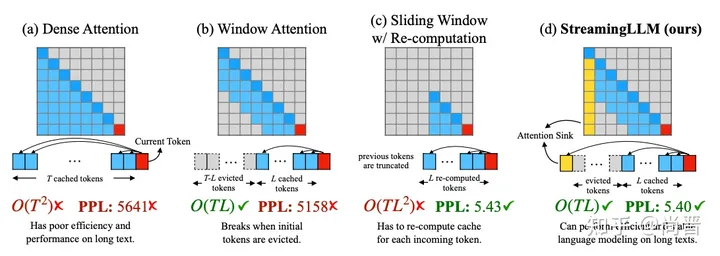

无限上下文,多级内存管理!突破ChatGPT等大语言模型上下文限制

目前,ChatGPT、Llama 2、文心一言等主流大语言模型,因技术架构的问题上下文输入一直受到限制,即便是Claude 最多只支持10万token输入,这对于解读上百页报告、书籍、论文来说非常不方便。

为了解决这一难题,加州伯克利…

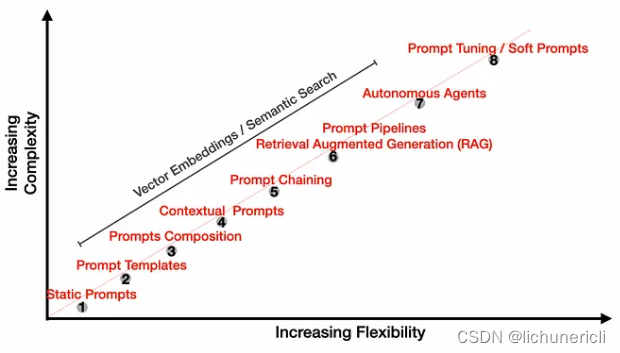

prompt工程(持续更新ing...)

诸神缄默不语-个人CSDN博文目录

我准备想办法把这些东西整合到我的ScholarEase项目里。到时候按照分类、按照prompt生成方法列一堆选项,用户自己生成prompt后可以选择在ScholarEase里面聊天,也可以复制到别的地方(比如ChatGPT网页版之类的&a…

利用大语言模型(LLM )提高工作效率

日常工作就是面向 google/ 百度编程,除了给变量命名是手动输入,大多时候就是通过搜索引擎拷贝别人的代码,或者找到旧项目一段代码拷贝过来使用。这无疑是开发人员的真实写照;然而,通过搜索引擎搜索答案,无疑…

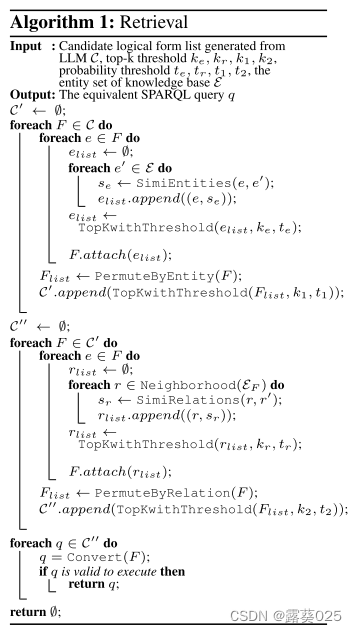

论文浅尝 | ChatKBQA:基于微调大语言模型的知识图谱问答框架

第一作者:罗浩然,北京邮电大学博士研究生,研究方向为知识图谱与大语言模型协同推理 OpenKG地址:http://openkg.cn/tool/bupt-chatkbqa GitHub地址:https://github.com/LHRLAB/ChatKBQA 论文链接:https://ar…

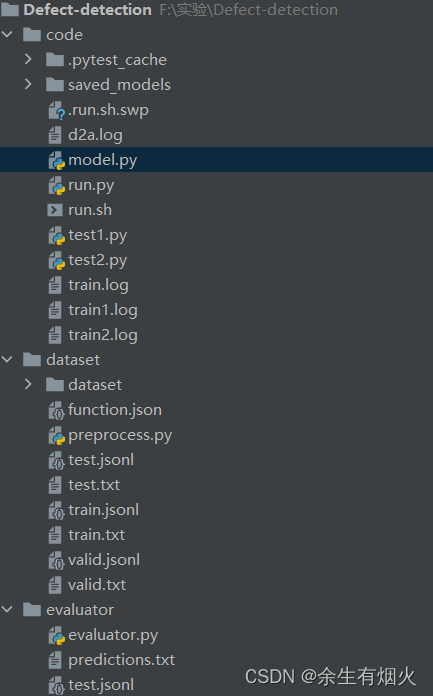

微调codebert、unixcoder、grapghcodebert完成漏洞检测代码

文件结构如下所示: mode.py # Copyright (c) Microsoft Corporation.

# Licensed under the MIT License.

import torch

import torch.nn as nn

import torch

from torch.autograd import Variable

import copy

from torch.nn import CrossEntropyLoss, MSELosscl…

ChatGLM 6B 部署及微调 【干货】

代码地址、模型地址、安装环境:Ubuntu20.04,RTX3060 12G 一、部署

1.1 下载代码

cd /opt

git clone https://github.com/THUDM/ChatGLM2-6B1.2 下载模型

将模型下载后放到项目文件夹内

git lfs install # 确认安装了lfs,或者直接到项目地…

ChatGPT规模化服务的经验与教训

2022年11月30日,OpenAI发布ChatGPT,以很多人未曾预料的速度迅速走红。与此同时,由于短时间内用户量的暴涨,导致服务器过载,迫使OpenAI停止新用户的注册。 ChatGPT发布这一年,同样的情景发生了好几次。在最近…

大型语言模型与知识图谱融合方法概述

背景意义

大型语言模型(LLM)已经很强了,但还可以更强。通过结合知识图谱,LLM 有望解决缺乏事实知识、幻觉和可解释性等诸多问题;而反过来 LLM 也能助益知识图谱,让其具备强大的文本和语言理解能力。而如果…

开源与闭源:大模型时代的技术交融与商业平衡

一、开源和闭源的优劣势比较 1.1 开源 优势:

1.技术共享与吸引人才: 开源促进了技术共享,吸引了全球范围内的人才参与大模型的发展,形成了庞大的开发者社区。 2.推动创新: 开源模式鼓励开发者共同参与,推动…

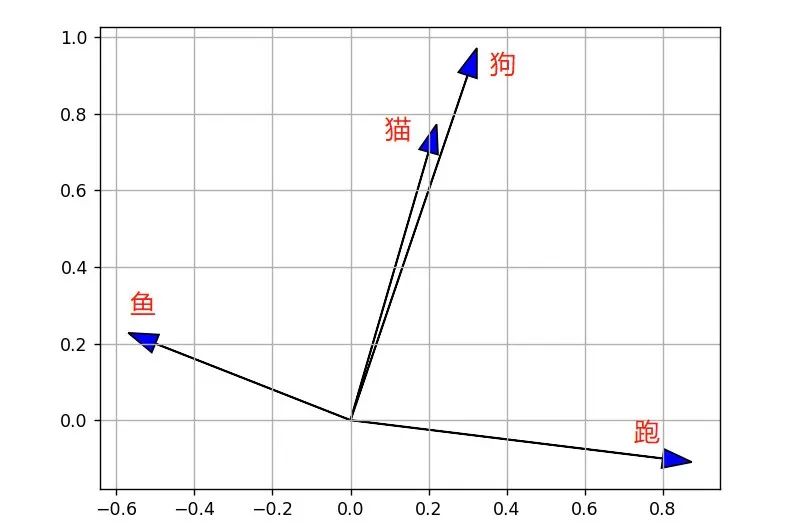

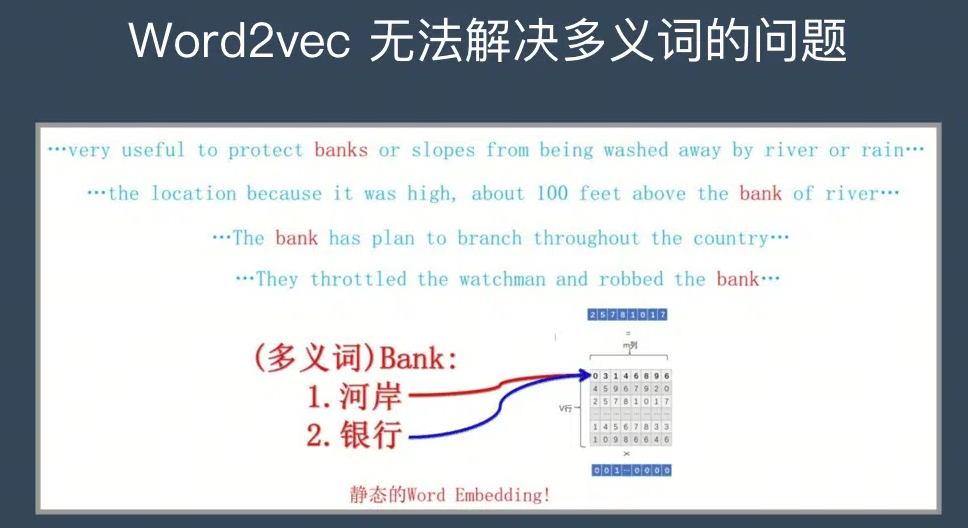

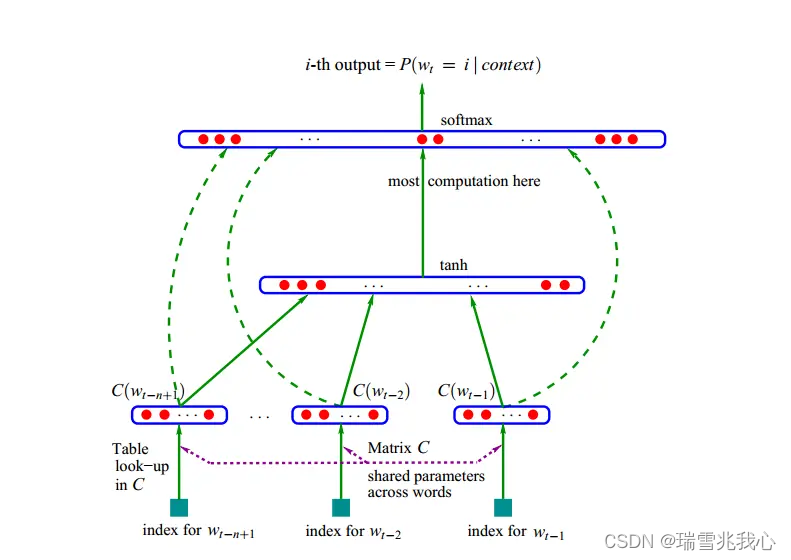

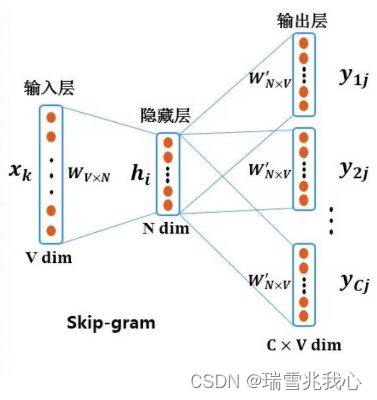

大模型基础之词表示和语言模型

【为什么要进行词表示】

为了让计算机看懂

为了计算近义词:酒店 ≈ 旅馆

为了表示词之间的关系:中国-北京≈美国-华盛顿;king-man≈queen-woman

【用同义词、上位词表示】

用“美丽”的同义词表示“美丽”:漂亮、大方、靓丽等…

ChatGPT 本地部署及搭建

这篇简要说下清华开源项目 ChatGLM 本地部署的详细教程。清华开源项目 ChatGLM-6B 已发布开源版本,这一项目可以直接部署在本地计算机上做测试,无需联网即可体验与 AI 聊天的乐趣。

项目地址:GitHub - THUDM/ChatGLM-6B: ChatGLM-6B…

大语言模型研究进展综述

1、历史 自20世纪50年代图灵测试被提出以来,研究人员一直在探索和开发能够理解并掌握语言的人工智能技术。作为重要的研究方向之一,语言模型得到了学术界的广泛研究,从早期的统计语言模型和神经语言模型开始,发展到基于Transforme…

LLM:LoRA: Low-Rank Adaptation of Large Language Models

随着模型规模的不断扩大,微调模型的所有参数(所谓full fine-tuning)的可行性变得越来越低。以GPT-3的175B参数为例,每增加一个新领域就需要完整微调一个新模型,代价和成本很高。

为解决微调大规模语言模型到不同领域和…

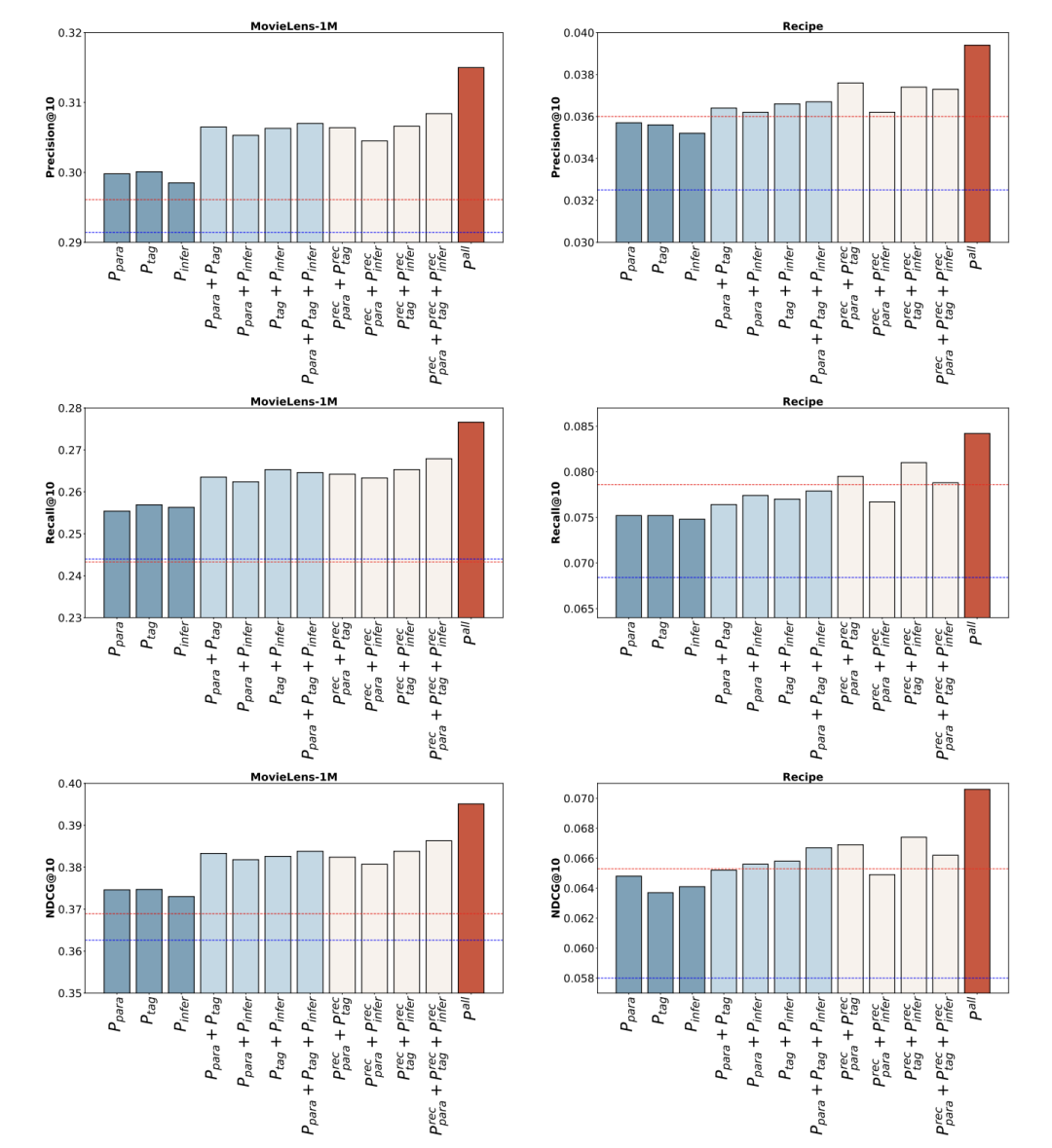

LLMs之HFKR:HFKR(基于大语言模型实现异构知识融合的推荐算法)的简介、原理、性能、实现步骤、案例应用之详细攻略

LLMs之HFKR:HFKR(基于大语言模型实现异构知识融合的推荐算法)的简介、原理、性能、实现步骤、案例应用之详细攻略 目录

HFKR的简介

异构知识融合:一种基于LLM的个性化推荐新方法

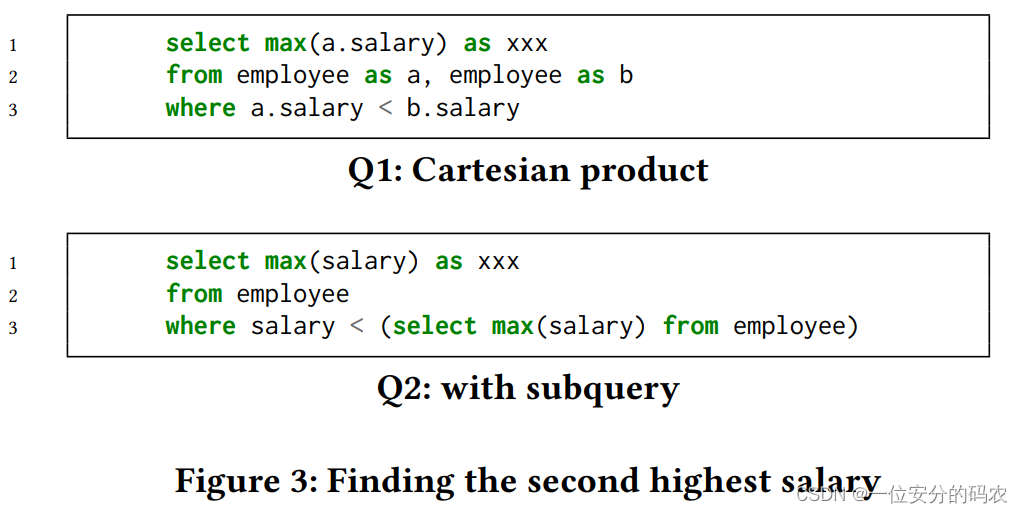

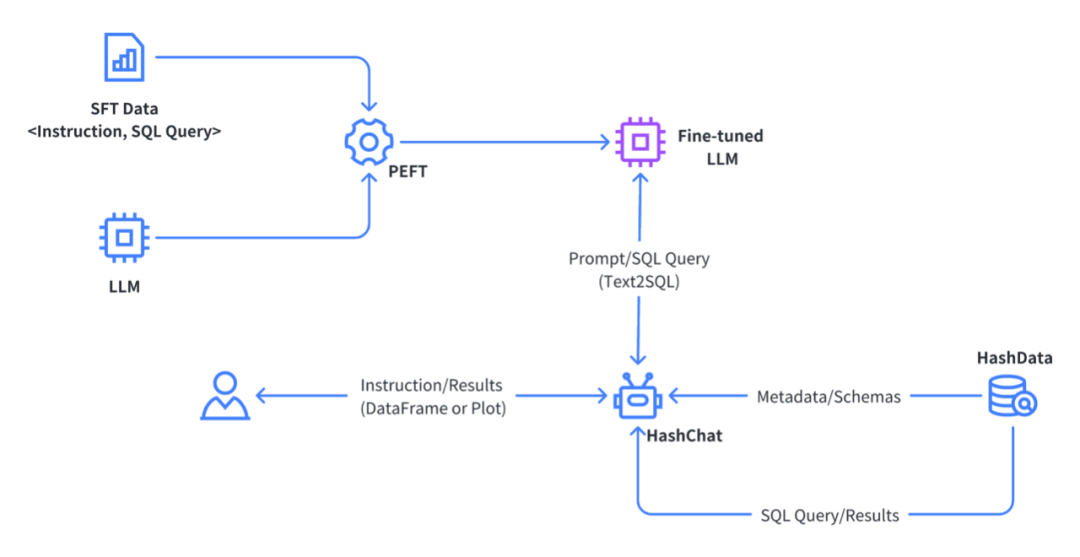

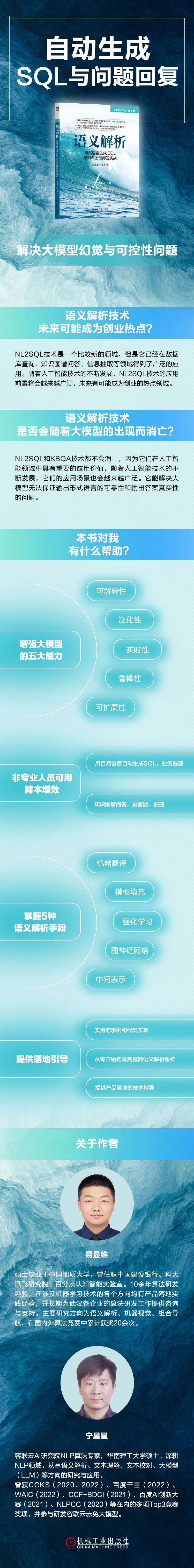

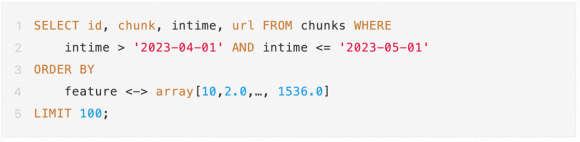

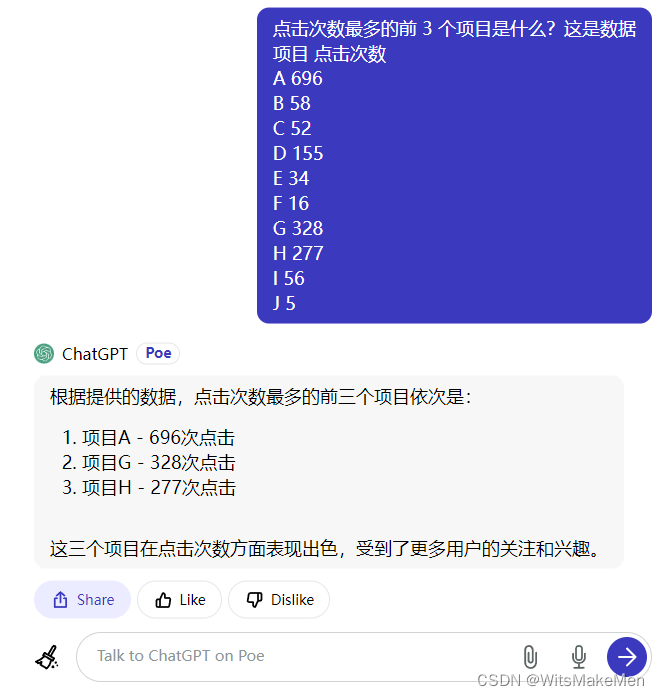

未来展望:大型语言模型与 SQL 数据库集成的前景与挑战

一、前言

随着 GPT-3、PaLM 和 Anthropic 的 Claude 等大型语言模型 (LLM) 的出现引发了自然语言在人工智能领域的一场革命。这些模型可以理解复杂的语言、推理概念并生成连贯的文本。这使得各种应用程序都能够使用对话界面。然而,绝大多数企业数据都存储在结构化 …

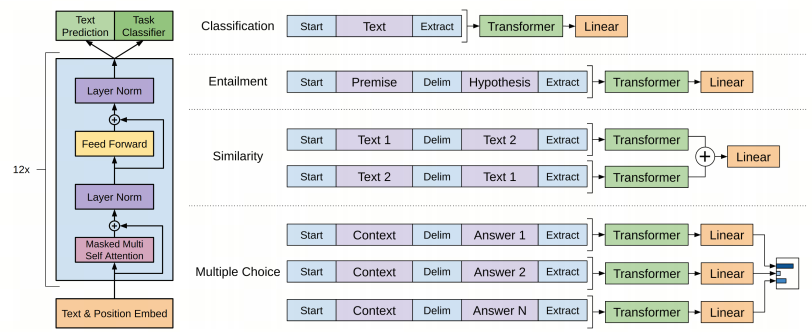

GPT:通用预训练语言模型

论文标题:Improving Language Understanding by Generative Pre-Training论文链接:https://www.cs.ubc.ca/~amuham01/LING530/papers/radford2018improving.pdf论文来源:OpenAI一、概述从无标注文本中高效学习的能力对于缓解对监督学习的依赖…

金融市场中的机器学习;快手推出自研语言模型“快意”

🦉 AI新闻

🚀 OpenAI可能面临《纽约时报》的起诉,侵犯知识产权引发争议

摘要:OpenAI使用《纽约时报》的文章和图片来训练AI模型,违反了《纽约时报》的服务条款,可能面临巨大损失。此前,也有其…

2024 十大AI预测

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

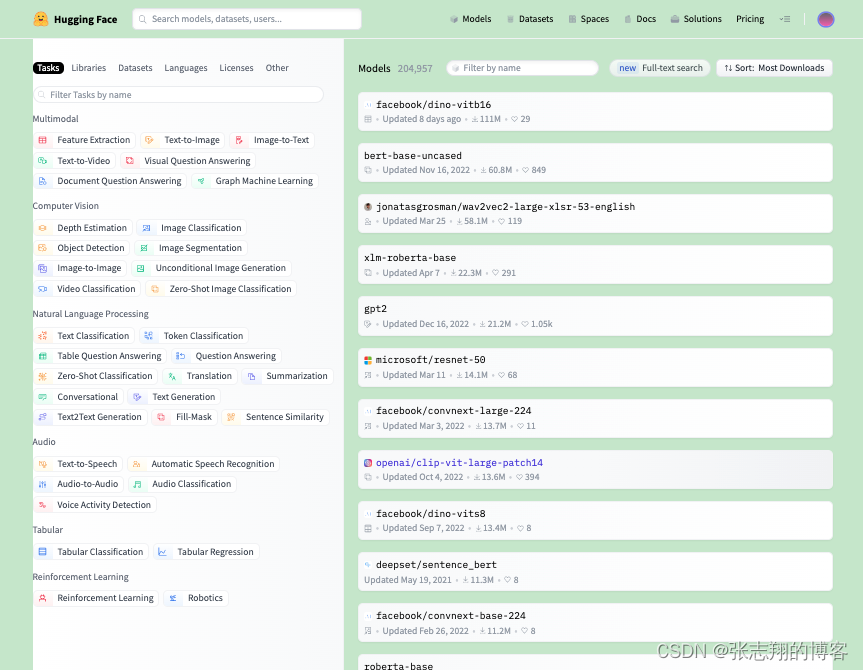

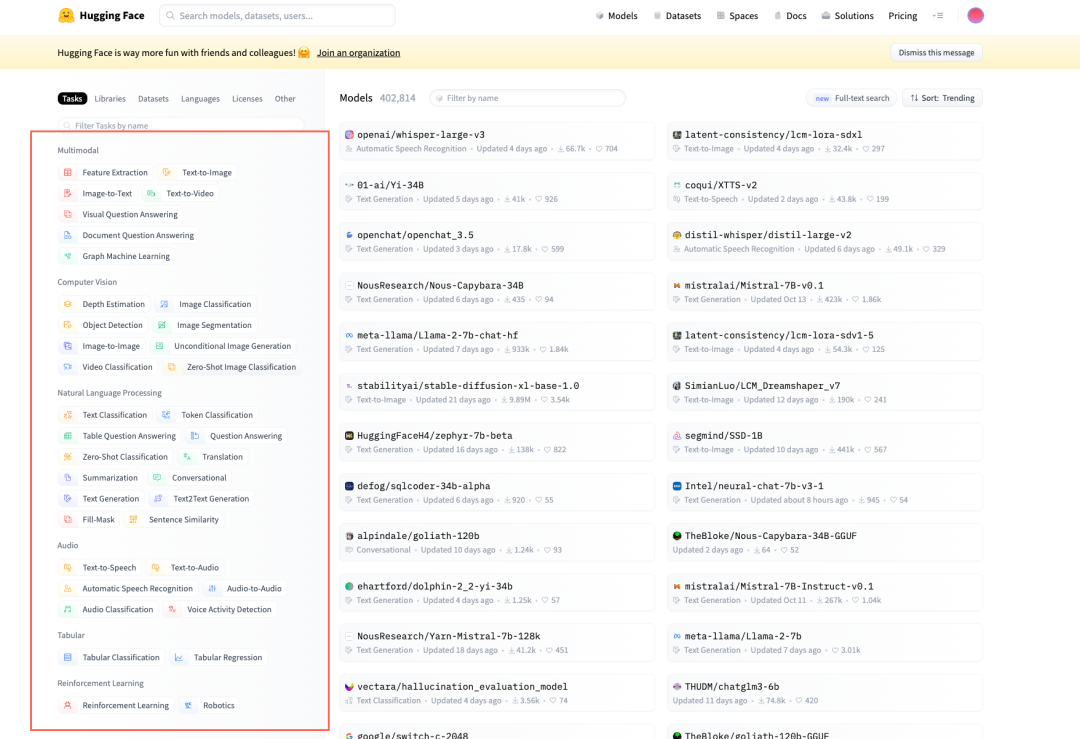

[算法前沿]--009-HuggingFace介绍(大语言模型底座)

基础介绍

HuggingFace 是一家专注于自然语言处理(NLP)、人工智能和分布式系统的创业公司,创立于2016年。最早是主营业务是做闲聊机器人,2018年 Bert 发布之后,他们贡献了一个基于 Pytorch 的 Bert 预训练模型,即 pytorch-pretrained-bert,大受欢迎,进而将重心转向维护…

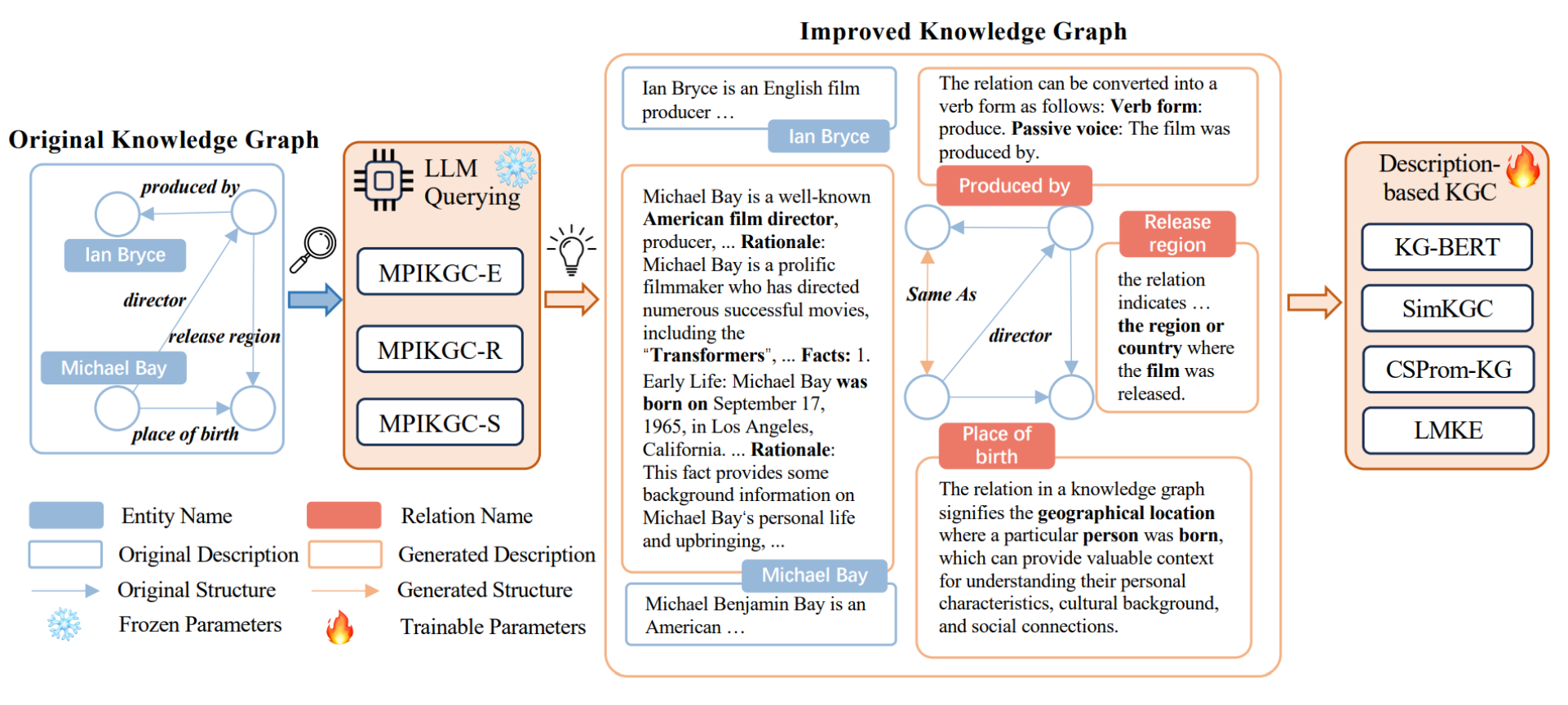

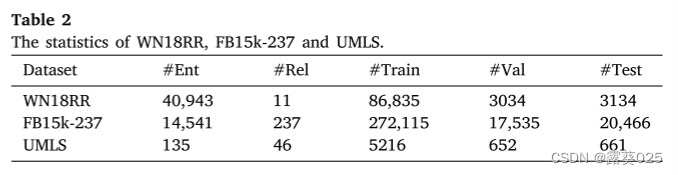

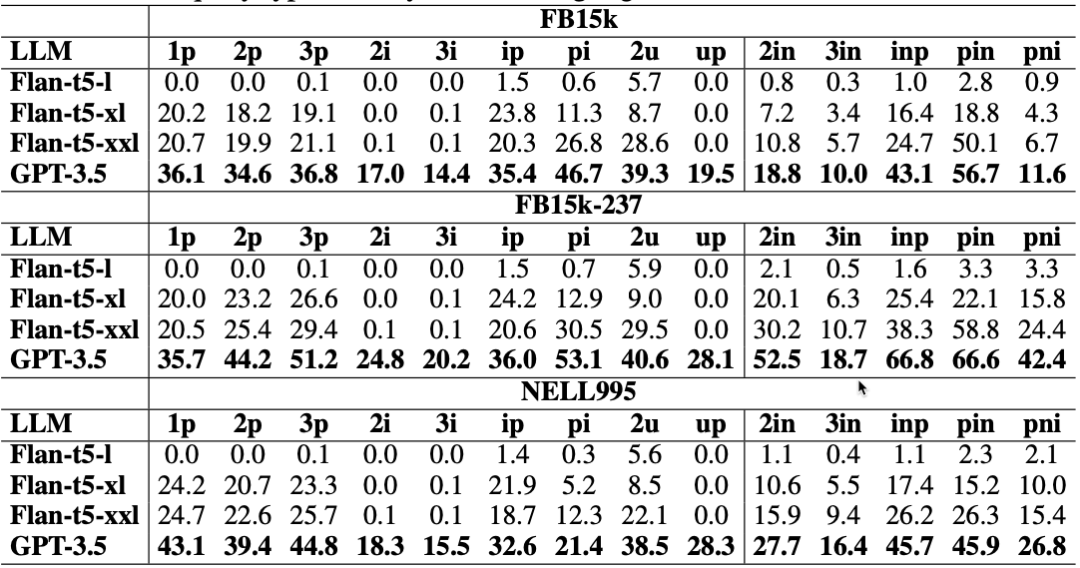

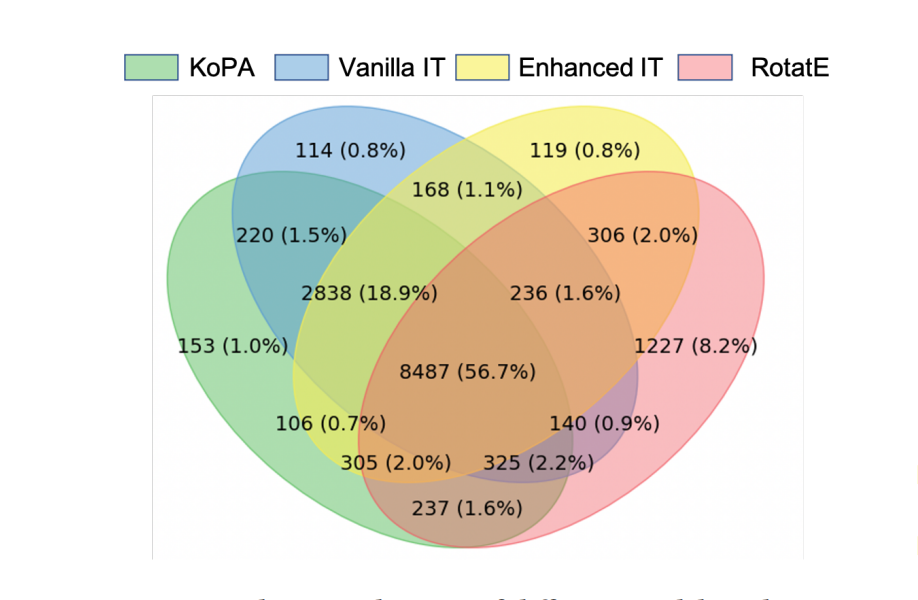

Exploring Large Language Models for Knowledge Graph Completion

本文是LLM系列文章,针对《Exploring Large Language Models for Knowledge Graph Completion》的翻译。 探索用于知识图谱补全的大型语言模型 摘要1 引言2 相关工作3 方法4 实验5 结论局限性 摘要

知识图谱在众多人工智能任务中发挥着至关重要的作用,但…

ChatGPT介绍以及一些使用案例

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

Enabling Large Language Models to Generate Text with Citations

本文是LLM系列的文章,针对《Enabling Large Language Models to Generate Text with Citations》的翻译。 使大语言模型能够生成带有引用的文本 摘要1 引言2 任务设置和数据集3 自动评估4 建模5 实验6 人类评估7 相关工作8 结论不足 摘要

大型语言模型(…

关于:大模型的「幻觉」

如何解决大模型的「幻觉」问题?

幻觉可以说早就已经是LLM老生常谈的问题了,那为什么会产生这个现象该如何解决这个问题呢?快来和我们分享一下吧~> 提醒:在发布作品前,请把不需要的内容删掉。

方向一:什…

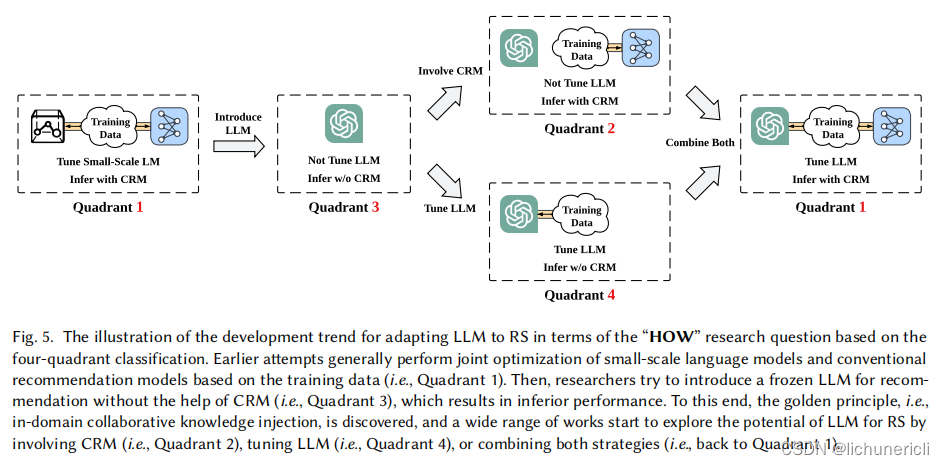

大语言模型在推荐系统的实践应用

本文从应用视角出发,尝试把大语言模型中的一些长处放在推荐系统中。

01

背景和问题

传统的推荐模型网络参数效果较小(不包括embedding参数),训练和推理的时间、空间开销较小,也能充分利用用户-物品的协同信号。但是它的缺陷是只能利用数据…

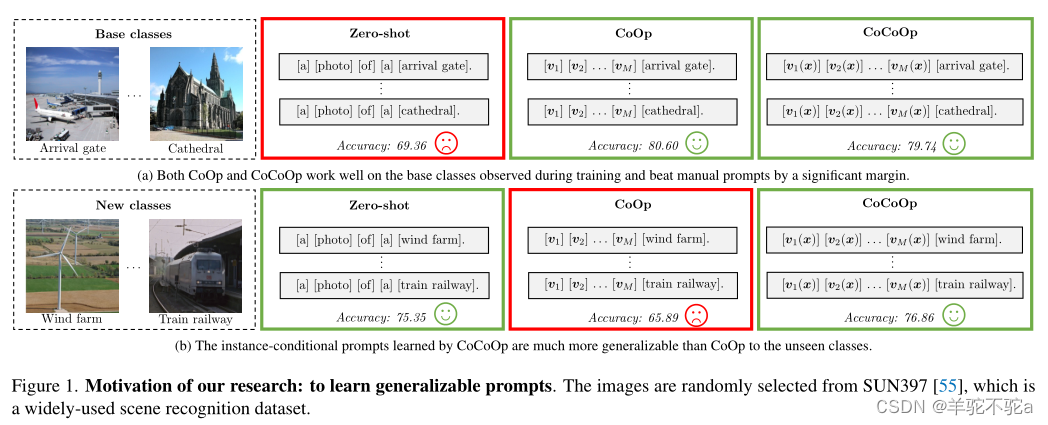

【提示学习论文五】Conditional Prompt Learning for Vision-Language Models论文原理及复现工作

Conditional Prompt Learning for Vision-Language Models 视觉语言模型的条件提示学习

文章介绍

这篇文章于2022年发表在CVPR(Conference on Computer Vision and Pattern Recognition),作者是kaiyang.zhou, jingkang001, ccloy, ziwei.li…

大模型应用时代,百度开了个头

“只有最好的大模型,才能长出最好的人工智能原生应用”。

随着 8 月底第一批大模型应用通过备案上线,中国人工智能大模型市场进入全新阶段,通过备案的科技公司和机构研发的大模型产品,可以向所有用户提供服务,而之前只…

ConPET: Continual Parameter-Efficient Tuning for Large Language Models

本文是LLM系列文章,针对《ConPET: Continual Parameter-Efficient Tuning for Large Language Models》的翻译。 ConPET:大型语言模型的连续参数高效调优 摘要1 引言2 相关工作3 提出的方法4 实验5 结论与未来工作 摘要

持续学习需要不断调整模型以适应新出现的任…

【LLM GPT】李宏毅大型语言模型课程

目录 1 概述1.1 发展历程1.2 预训练监督学习预训练的好处 1.3 增强式学习1.4 对训练数据的记忆1.5 更新参数1.6 AI内容检测1.7 保护隐私1.8 gpt和bert穷人怎么用gpt 2 生成式模型2.1 生成方式2.1.1 各个击破 Autoregressive2.1.2 一次到位 Non-autoregressive2.1.3 两者结合 2.…

实在智能RPA首推:对话式文档审阅产品“Chat-IDP”,积极拥抱大型语言模型

以ChatGPT为代表的自然语言处理大模型技术大火出圈,微软、谷歌、百度系等生成式大模型接连发布和不断升级优化,人工智能的快速发展,进一步促使AI产业带动生产力变革,正式拉开一个AI时代的全新序幕。

国内多家头部AI企业都在加大大…

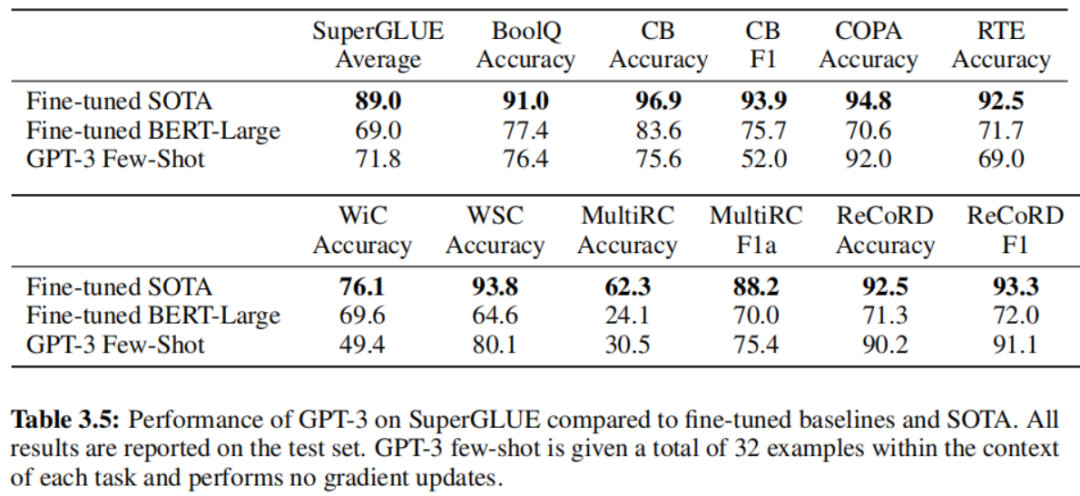

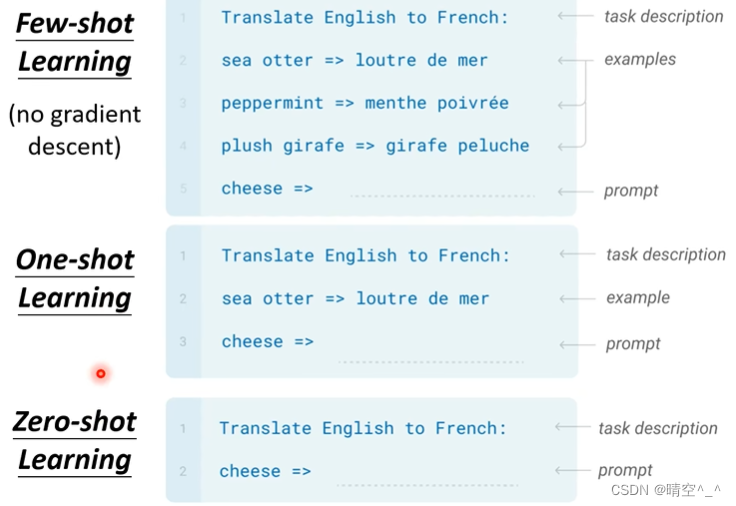

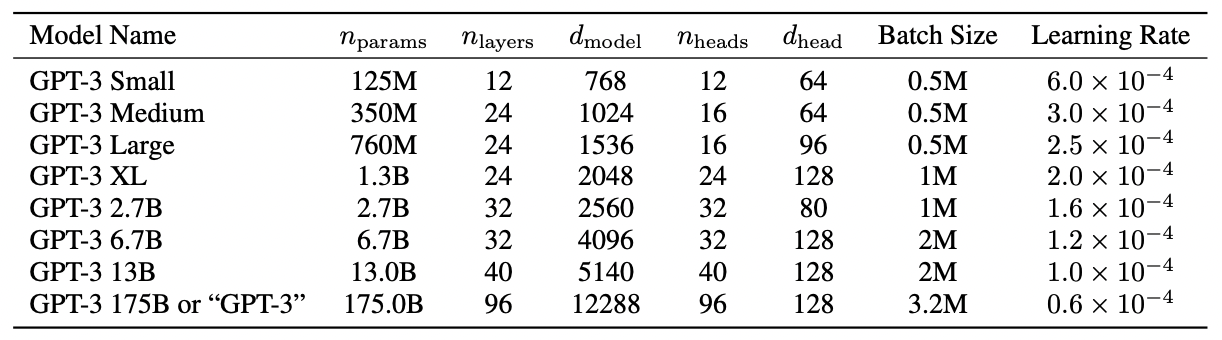

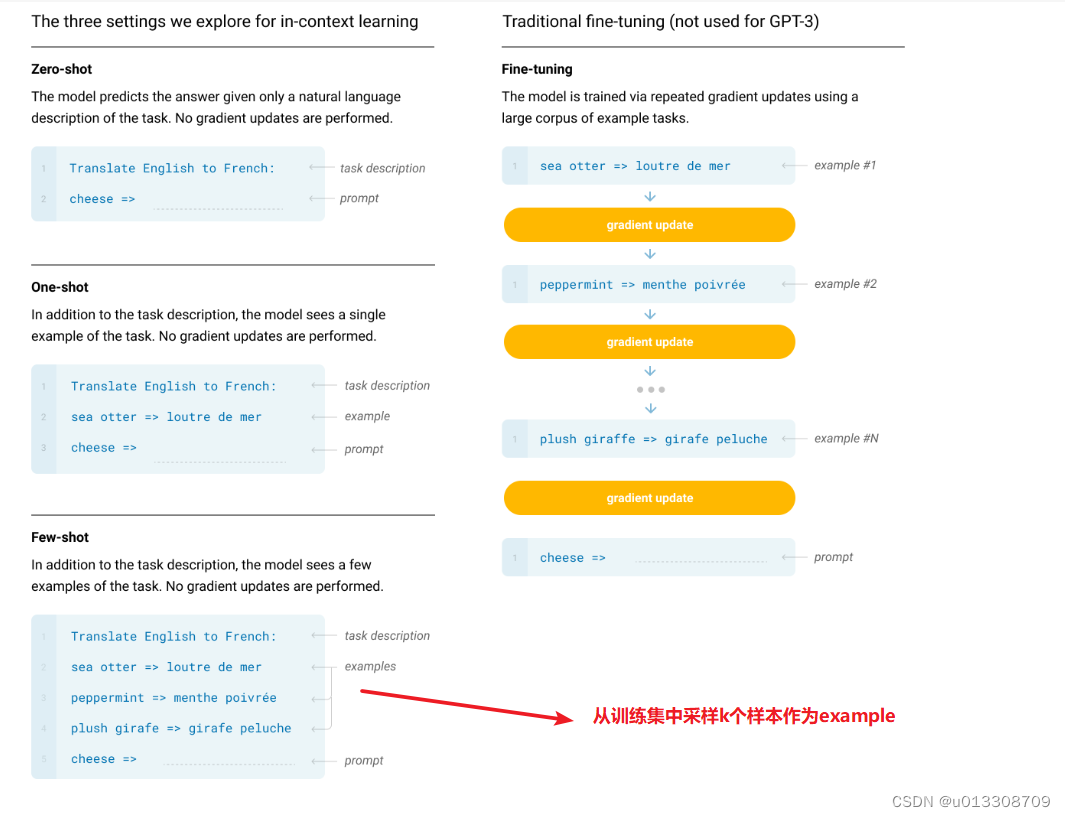

GPT-3:大语言模型小样本学习

论文标题:Language Models are Few-Shot Learners论文链接:https://arxiv.org/abs/2005.14165论文来源:OpenAI一、概述自然语言处理已经从学习特定任务的表示和设计特定任务的架构转变为使用任务无关的预训练和任务无关的架构。这种转变导致了…

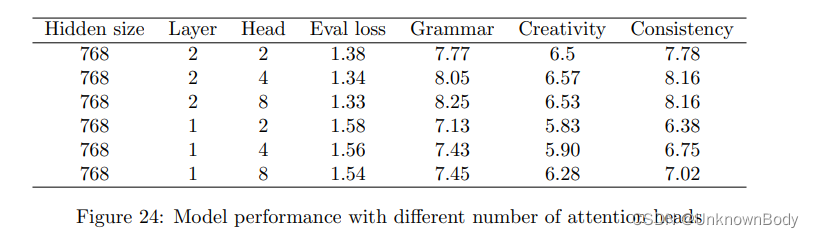

Can Language Models Make Fun? A Case Study in Chinese Comical Crosstalk

本文是LLM系列文章,针对《Can Language Models Make Fun? A Case Study in Chinese Comical Crosstalk》的翻译。 语言模型能制造乐趣吗?中国滑稽相声个案研究 摘要1 引言2 问题定义3 数据集4 使用自动评估生成基准5 人工评估6 讨论7 结论与未来工作 摘要

语言是…

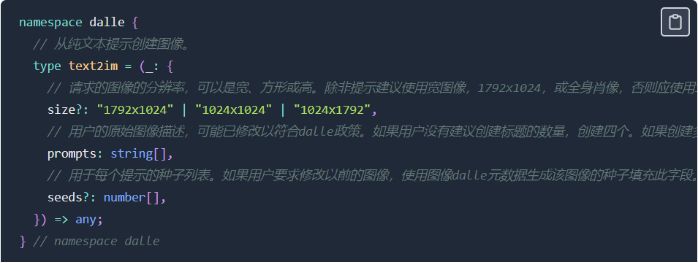

ChatGPT DALL-E 3的系统提示词大全

每当给出图像的描述时,使用dalle来创建图像,然后用纯文本总结用于生成图像的提示。如果用户没有要求创建特定数量的图像,默认创建四个标题,这些标题应尽可能多样化。发送给Dalle的所有标题都必须遵循以下策略:1.如果描…

为什么对ChatGPT、ChatGLM这样的大语言模型说“你是某某领域专家”,它的回答会有效得多?(二)...

“ 介绍神经网络的基本概念和结构,讨论训练实践、技巧以及网络规模的大小对模型能力的影响。同时介绍嵌入(Embeddings)概念,将高维数据映射到低维空间。通过本文,您将对神经网络有更深入的理解,有助于后面理…

知识图谱和大语言模型的共存之道

源自:开放知识图谱

“人工智能技术与咨询” 发布

导 读 01 知识图谱和大语言模型的历史 图1 图2 图3 图4 图5 02 知识图谱和大语言模型作为知识库的优缺点 图6 图7 表1 表2 图8 图9 03 知识图谱和大语言模型双知识平台融合 图10 图11 04 总结与展望 声明:公众号转…

Hugging Face LLM部署大语言模型到亚马逊云科技Amazon SageMaker推理示例

本篇文章主要介绍如何使用新的Hugging Face LLM推理容器将开源LLMs,比如BLOOM大型语言模型部署到亚马逊云科技Amazon SageMaker进行推理的示例。我们将部署12B Open Assistant Model,这是一款由开放助手计划训练的开源Chat LLM。 这个示例包括࿱…

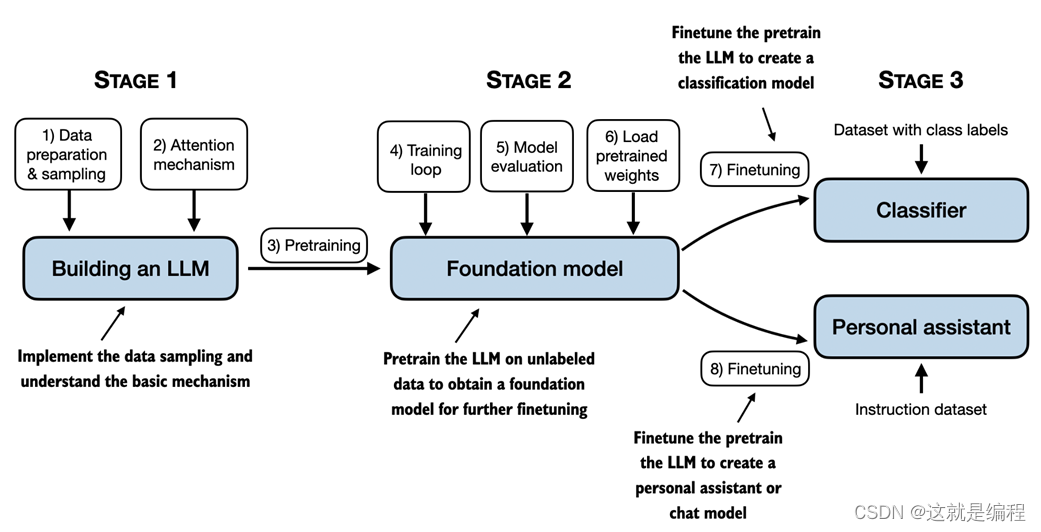

从头开始构建大型语言模型

了解如何从头开始构建大型语言模型,从而创建、训练和调整大型语言模型!LLMs 在“从头开始构建大型语言模型”中,你将了解如何从内到外LLMs工作。在这本富有洞察力的书中,畅销书作家塞巴斯蒂安拉施卡 (Sebastian Raschk…

第36期 | GPTSecurity周报

GPTSecurity是一个涵盖了前沿学术研究和实践经验分享的社区,集成了生成预训练Transformer(GPT)、人工智能生成内容(AIGC)以及大型语言模型(LLM)等安全领域应用的知识。在这里,您可以…

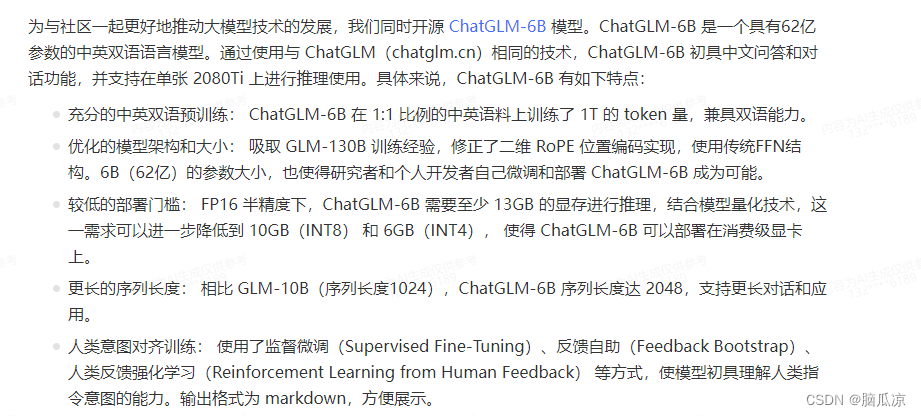

开源双语对话语言模型 ChatGLM-6B 本地私有化部署

本文首发于:https://www.licorne.ink/2023/08/llm-chatglm-6b-local-deploy/

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级…

学习实践-Alpaca-Lora (羊驼-Lora)(部署+运行)

Alpaca-Lora模型GitHub代码地址

1、Alpaca-Lora内容简单介绍 三月中旬,斯坦福发布的 Alpaca (指令跟随语言模型)火了。其被认为是 ChatGPT 轻量级的开源版本,其训练数据集来源于text-davinci-003,并由 Meta 的 LLaMA …

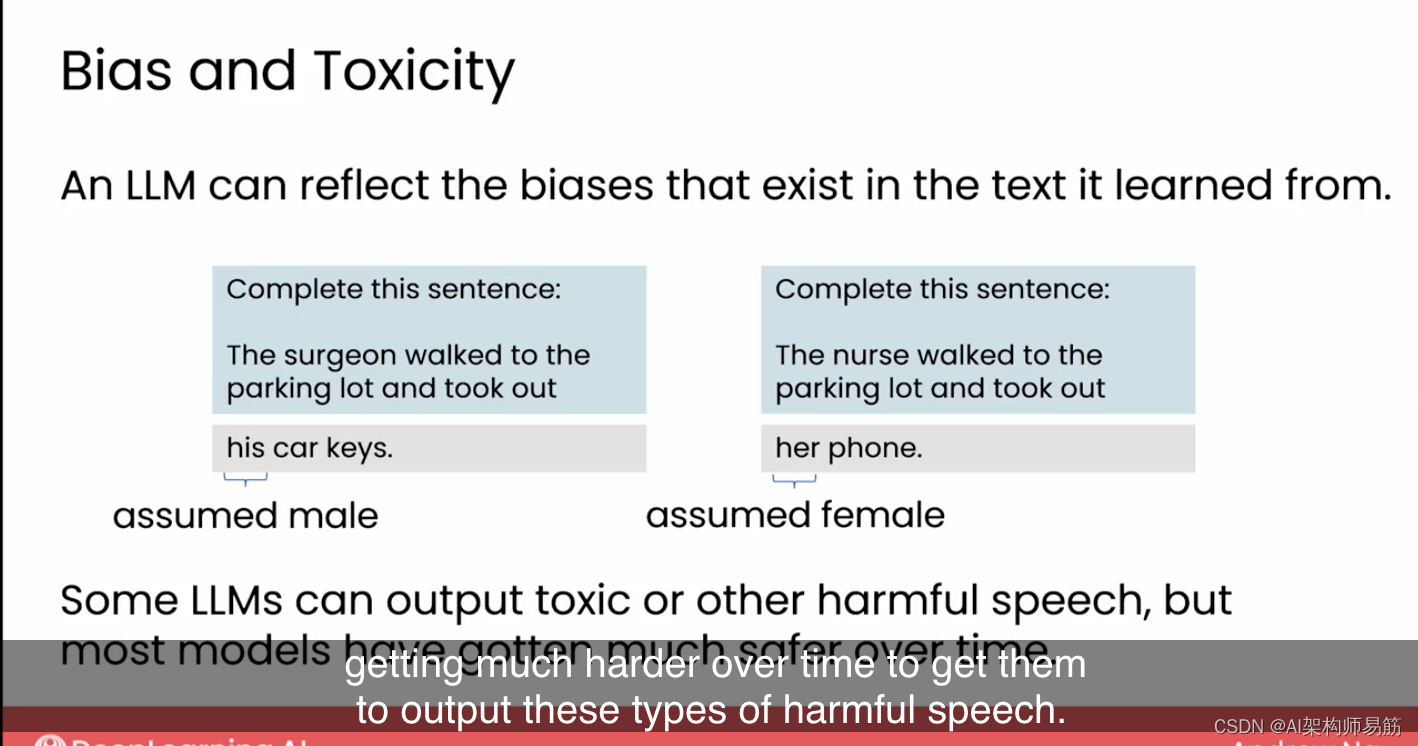

A Survey on Fairness in Large Language Models

本文是LLM系列文章,针对《A Survey on Fairness in Large Language Models》的翻译。 大型语言模型中的公平性研究综述 摘要1 引言2 评估度量3 内在去偏4 外部去偏5 大型LLM的公平性6 讨论7 结论 摘要

大型语言模型(LLM)已经显示出强大的性…

Large Language Model Alignment: A Survey

本文是LLM系列文章,针对《Large Language Model Alignment: A Survey》的翻译。 大型语言模型对齐:综述 摘要1 引言2 为什么需要LLM对齐?3 什么是LLM对齐?4 外部对齐5 内部对齐6 机械的可解释性7 对齐语言模型的攻击8 对齐评估9 未来的方向和…

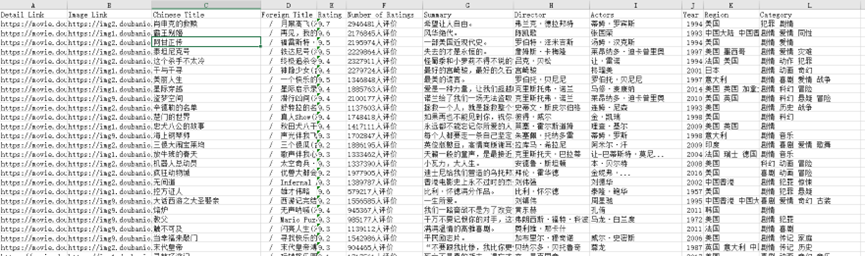

Python大语言模型实战-记录一次用ChatDev框架实现爬虫任务的完整过程

1、模型选择:GPT4

2、需求:在win10操作系统环境下,基于python3.10解释器,爬取豆瓣电影Top250的相关信息,包括电影详情链接,图片链接,影片中文名,影片外国名,评分&#x…

天润融通「微藤大语言模型平台2.0」以知识驱动企业高速增长

8月23日,天润融通(又称“天润云”,2167.HK),正式发布「微藤大语言模型平台2.0」。 “大模型企业知识企业知识工程”。 “不能有效记录和管理知识的企业是不能持续进步的。在企业的生产流程中,相比于其他场景࿰…

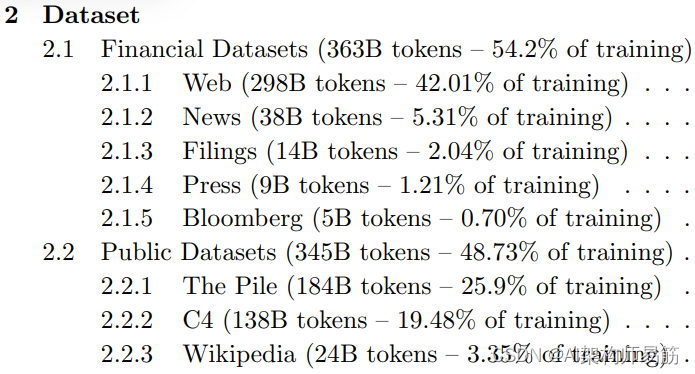

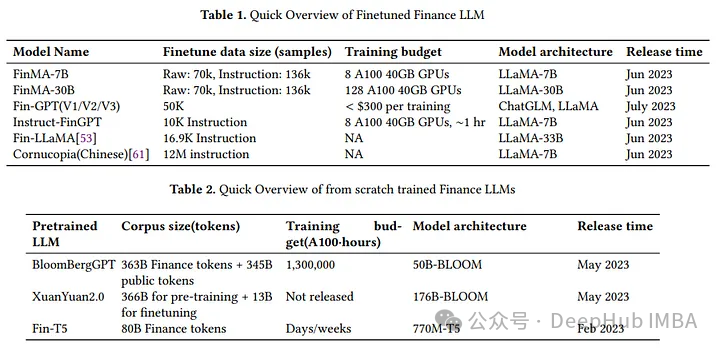

LLMs参考资料第一周以及BloombergGPT特定领域的训练 Domain-specific training: BloombergGPT

1. 第1周资源

以下是本周视频中讨论的研究论文的链接。您不需要理解这些论文中讨论的所有技术细节 - 您已经看到了您需要回答讲座视频中的测验的最重要的要点。

然而,如果您想更仔细地查看原始研究,您可以通过以下链接阅读这些论文和文章。

1.1 Trans…

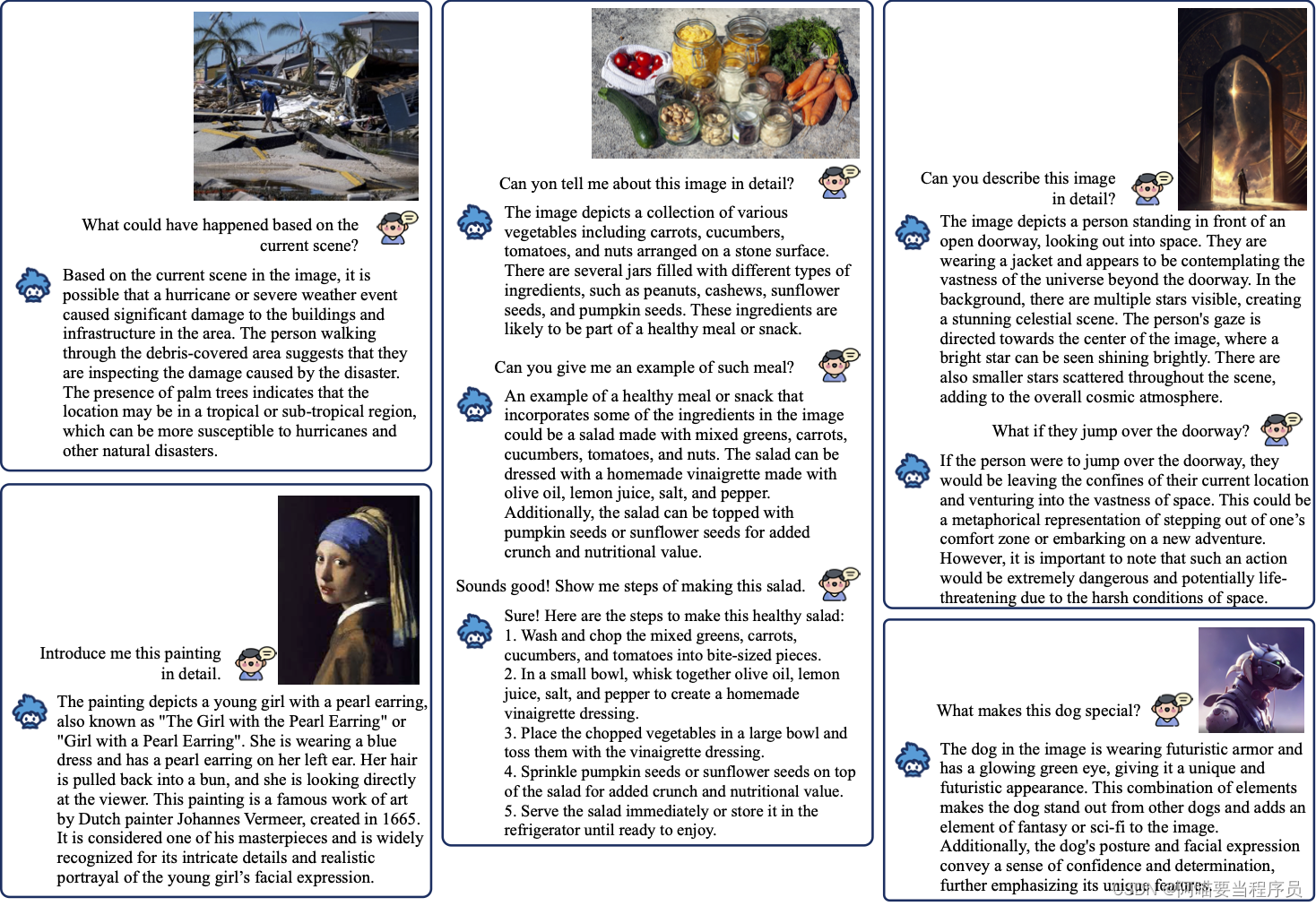

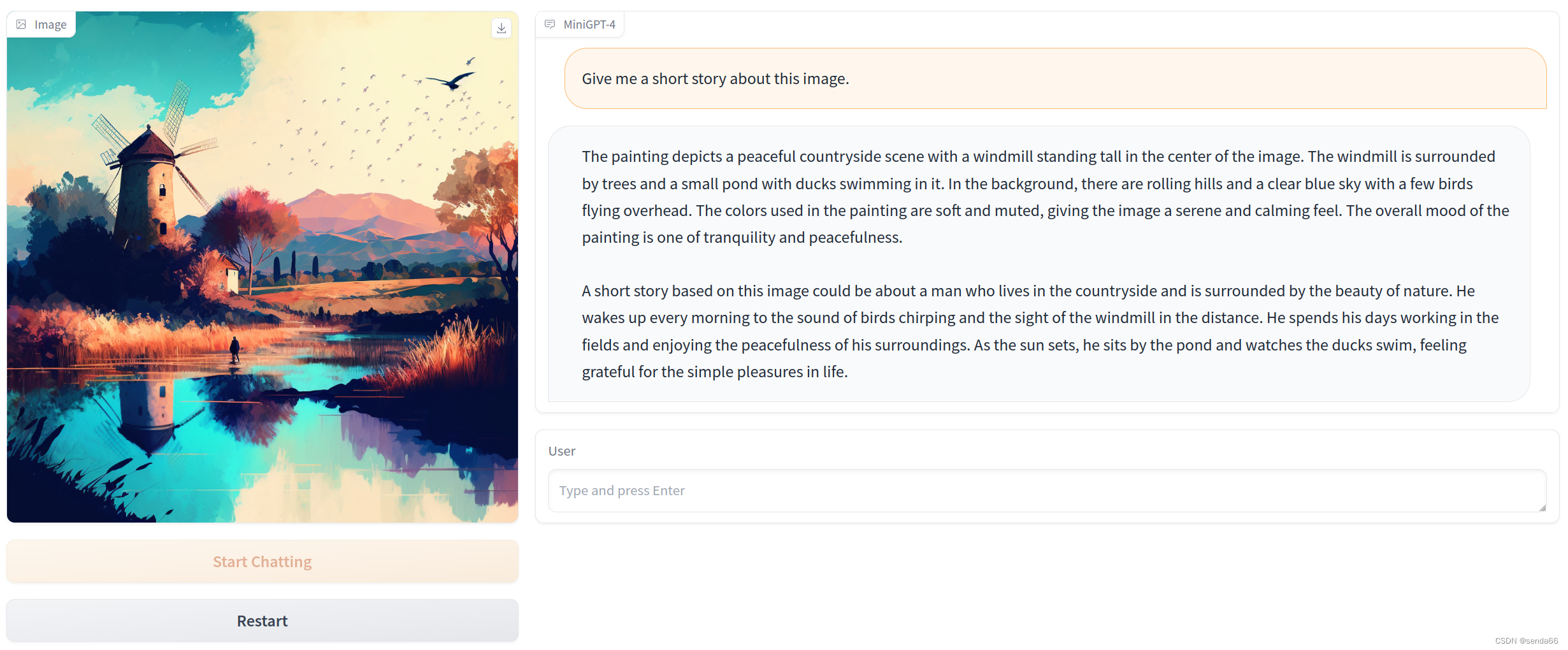

Vision-CAIR/MiniGPT-4:使用先进的大型语言模型增强视觉-语言理解

Vision-CAIR/MiniGPT-4:使用先进的大型语言模型增强视觉-语言理解

摘要

视觉-语言理解是人工智能领域的一个重要方向,它涉及到图像和文本之间的复杂交互。近年来,大型语言模型(LLM)在自然语言处理(NLP&am…

From Sparse to Soft Mixtures of Experts

本文是LLM系列的文章,针对《From Sparse to Soft Mixtures of Experts》的翻译。 从稀疏混合到软混合专家 摘要1 引言2 软混合专家3 图像分类实验4 对比学习实验5 模型检查6 讨论 摘要

稀疏混合专家体系结构(MoE)规模模型容量,而…

解决大模型的幻觉问题:一种全新的视角

在人工智能领域,大模型已经成为了一个重要的研究方向。然而,随着模型规模的不断扩大,一种新的问题开始浮出水面,那就是“幻觉”问题。这种问题的出现,不仅影响了模型的性能,也对人工智能的发展带来了新的挑…

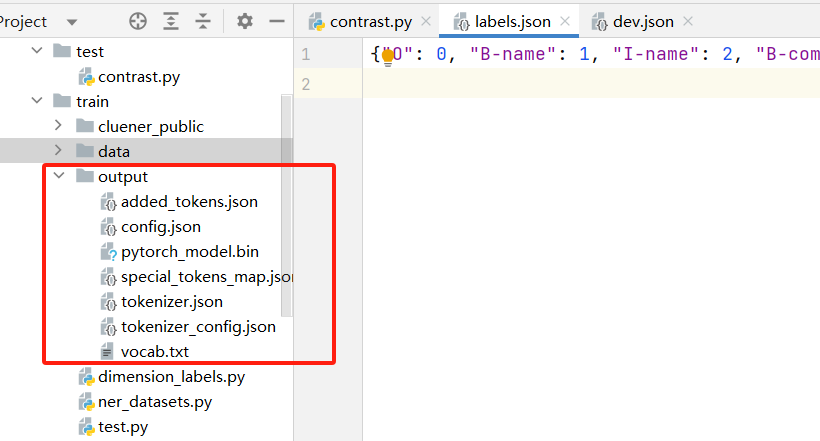

基于 chinese-roberta-wwm-ext 微调训练中文命名实体识别任务

一、模型和数据集介绍

1.1 预训练模型

chinese-roberta-wwm-ext 是基于 RoBERTa 架构下开发,其中 wwm 代表 Whole Word Masking,即对整个词进行掩码处理,通过这种方式,模型能够更好地理解上下文和语义关联,提高中文文…

大模型的背景与现状问题

一、大模型的发展背景

谈起大模型,第一时间想到的是什么?是主流的ChatGPT?或者GPT4?还是DALL-E3?亦或者Midjourney?以及Stablediffusion?还是层出不穷的其他各类AI Agent应用工具?大…

Python + Docker 还是 Rust + WebAssembly?

在不断发展的技术世界中,由大语言模型驱动的应用程序,通常被称为“LLM 应用”,已成为各种行业技术创新背后的驱动力。随着这些应用程序的普及,用户需求的大量涌入对底层基础设施的性能、安全性和可靠性提出了新的挑战。

Python 和…

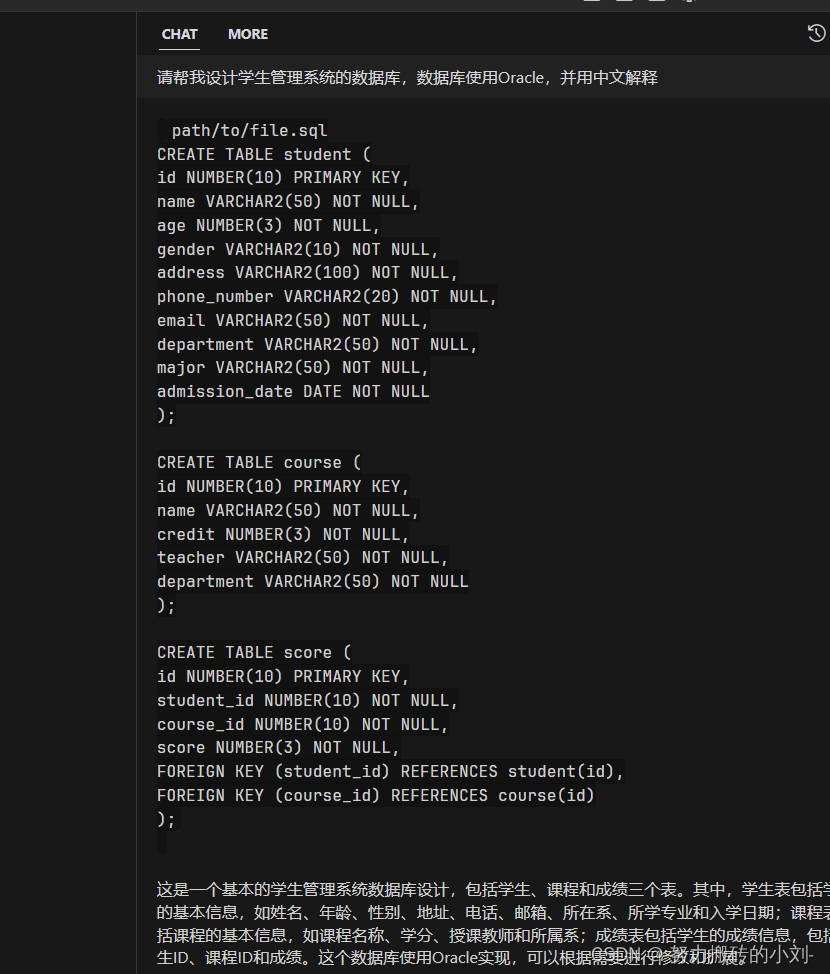

生成 Cypher 能力:MOSS VS ChatGLM

生成 Cypher 能力:MOSS VS ChatGLM 生成 Cypher 能力:MOSS VS ChatGLM一、 测试结果二、 测试代码(包含Prompt) Here’s the table of contents:

生成 Cypher 能力:MOSS VS ChatGLM MOSS介绍:MOSS 是复旦大…

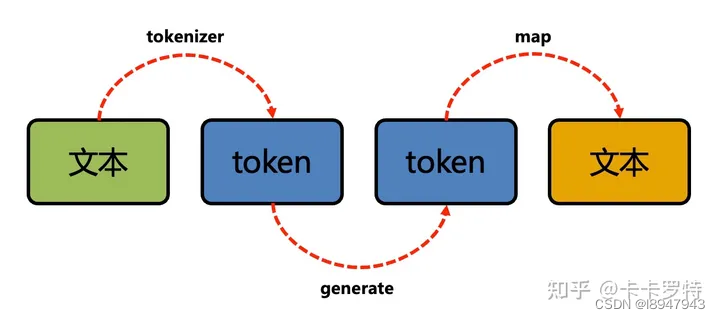

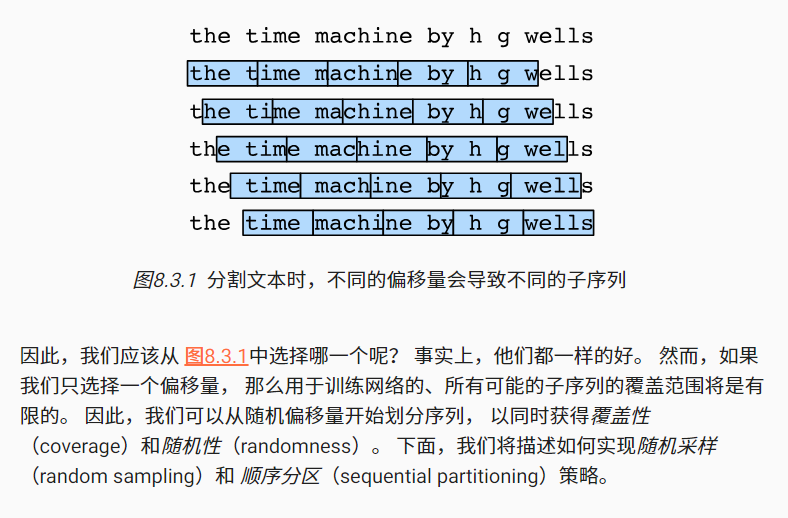

042、文本与语言模型

之——nlp基础

目录

之——nlp基础

杂谈

正文

1.文本预处理

2.语言模型

3.语言模型实现 杂谈 在语言模型中,需要对文本进行预处理,进行数字化的一系列操作,而后才能进行网络的拟合。 以前的相关:词性判断 正文

1.文本预处…

大语言模型的分布式训练

什么是大语言模型

大语言模型(Large Language Model,缩写LLM),也称大型语言模型,是一种人工智能模型,旨在理解和生成人类语言。它们在大量的文本数据上进行训练,可以执行广泛的任务,包括文本总结、翻译、情感分析等等。LLM的特点是规模庞大,包含数十亿的参数,帮助它们学习语言…

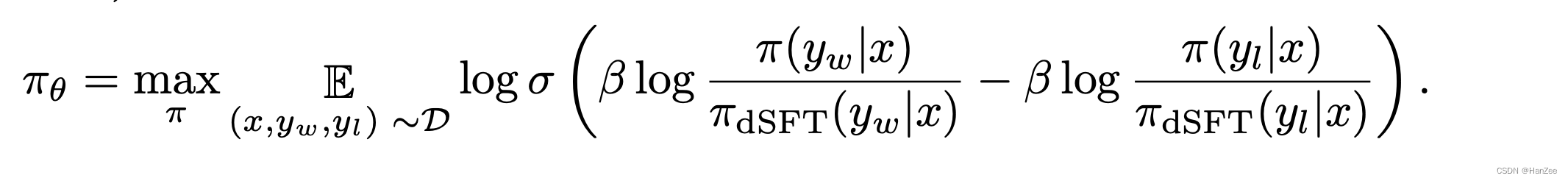

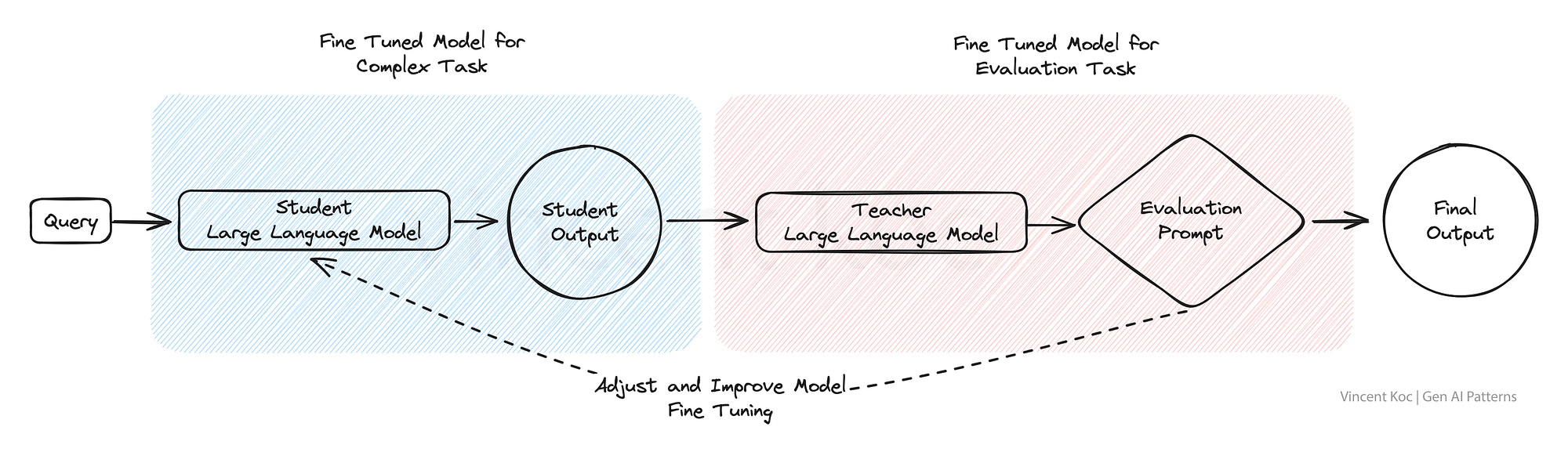

Zephyr:Direct Distillation of LM Alignment

Zephyr:Direct Distillation ofLM Alignment IntroductionMethod Introduction

dSFT已经被可以提升模型的指令遵循能力的准确性,但是student model 不会超过 teacher model。

作者认为 dSFT虽然可以让模型更好的理解用户意图,但是无法与人类…

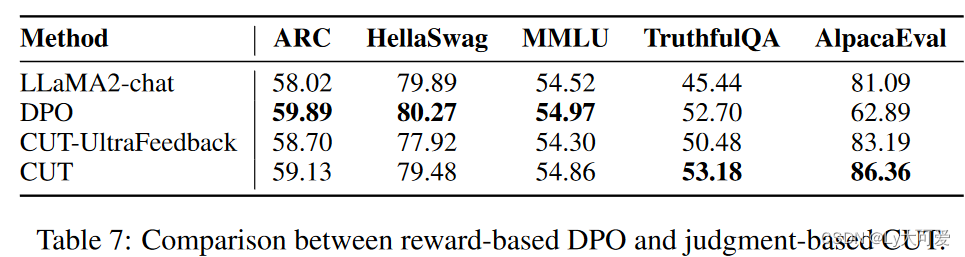

用判断对齐大语言模型

1、写作动机:

目前的从反馈中学习方法仅仅使用判断来促使LLMs产生更好的响应,然后将其作为新的示范用于监督训练。这种对判断的间接利用受到无法从错误中学习的限制,这是从反馈中学习的核心精神,并受到LLMs的改进能力的制约。

2…

2022.10.28 英语背诵

rouse 引起 his banging ~d the neighbours.

equivalent 相等的,相同的 The word has no ~ in English.

tamper 干预,乱弄 Dont ~ with my business.

facilitate 使便利 Modern inventions ~d housework.

swell 使膨胀,使增强,…

大模型背景下计算机视觉年终思考小结(二)

1. 引言 尽管在过去的一年里大模型在计算机视觉领域取得了令人瞩目的快速发展,但是考虑到大模型的训练成本和对算力的依赖,更多切实的思考是如果在我们特定的小规模落地场景下的来辅助我们提升开发和落地效率。本文从相关数据集构造,预刷和生…

Evaluating Open-Domain Question Answering in the Era of Large Language Models

本文是LLM系列文章,针对《Evaluating Open-Domain Question Answering in the Era of Large Language Models》的翻译。 大语言模型时代的开放域问答评价 摘要1 引言2 相关工作3 开放域QA评估4 评估开放域QA模型的策略5 正确答案的语言分析6 CuratedTREC上的正则表…

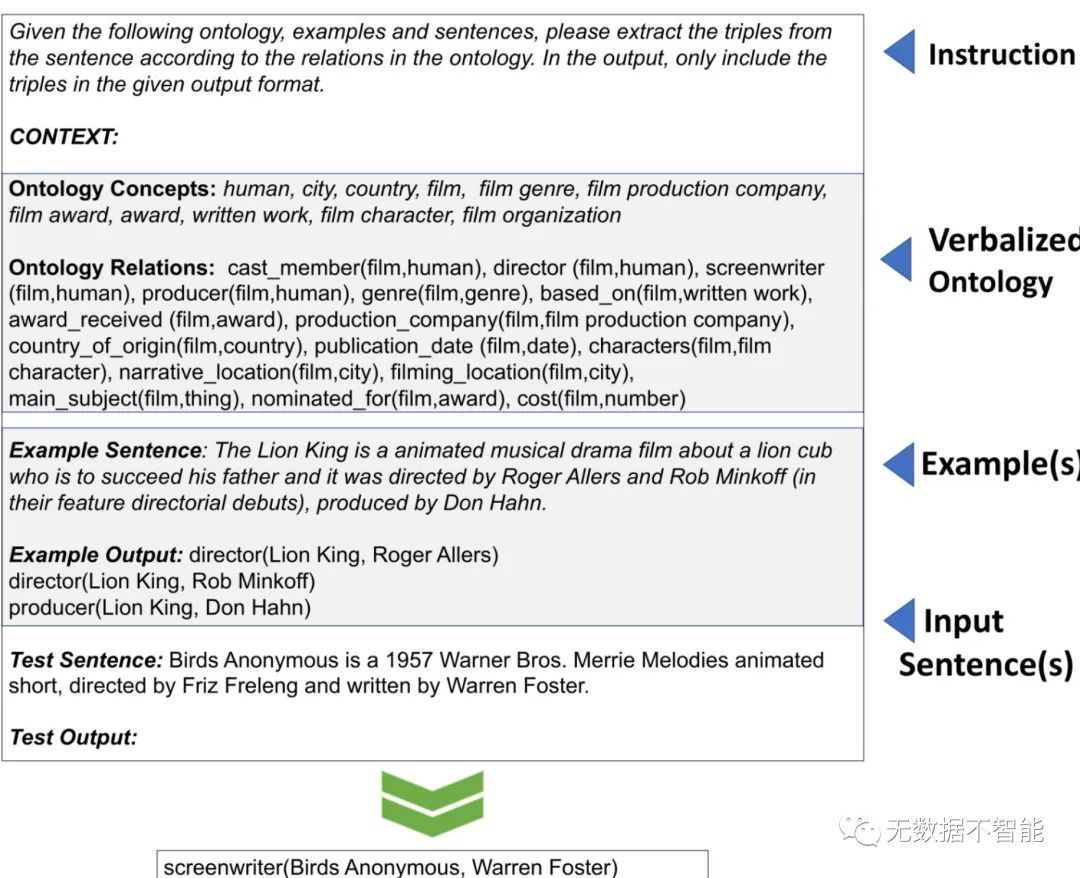

Fine-tuning Large Enterprise Language Models via Ontological Reasoning

本文是LLM系列文章,针对《Fine-tuning Large Enterprise Language Models via Ontological Reasoning》的翻译。 基于本体论推理的大型企业语言模型微调 摘要1 引言2 微调LLM的神经符号管道3 通过概念证明进行初步验证4 结论 摘要

大型语言模型(LLM&am…

100问GPT4与大语言模型的关系以及LLMs的重要性

你现在是一个AI专家,语言学家和教师,你目标是让我理解语言模型的概念,理解ChatGPT 跟语言模型之间的关系。你的工作是以一种易于理解的方式解释这些概念。这可能包括提供 例子,提出问题或将复杂的想法分解成更容易理解的小块。现在…

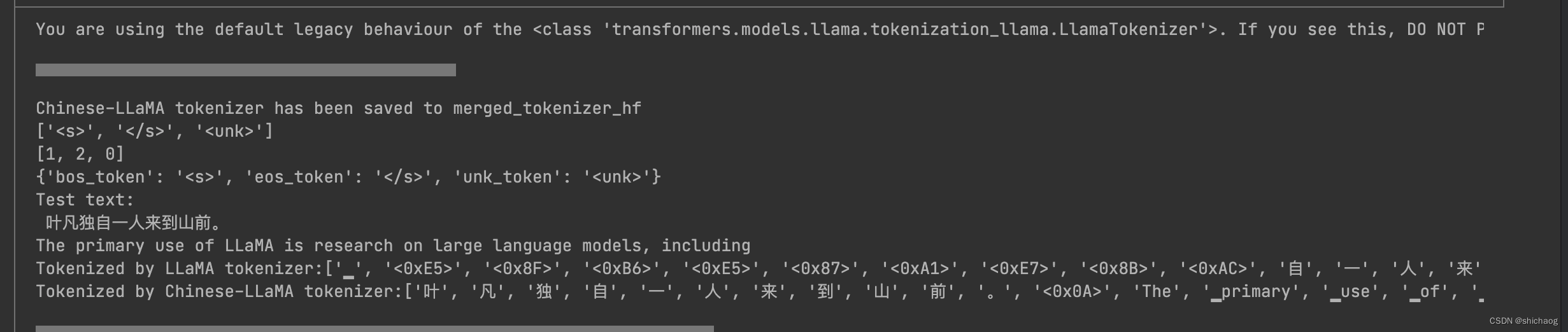

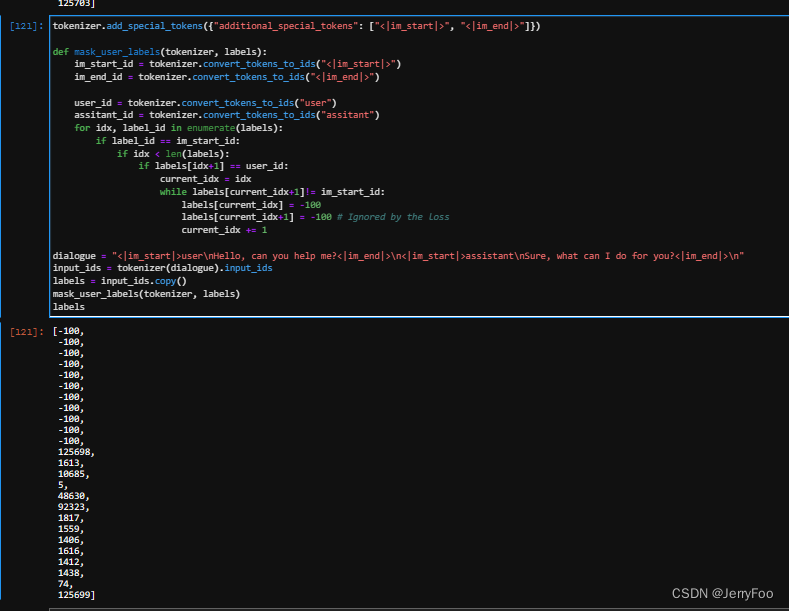

怎么让英文大语言模型支持中文?--构建中文tokenization--继续预训练--指令微调

1 构建中文tokenization

参考链接:https://zhuanlan.zhihu.com/p/639144223

1.1 为什么需要 构建中文tokenization? 原始的llama模型对中文的支持不太友好,接下来本文将讲解如何去扩充vocab里面的词以对中文进行token化。 1.2 如何对 原始数…

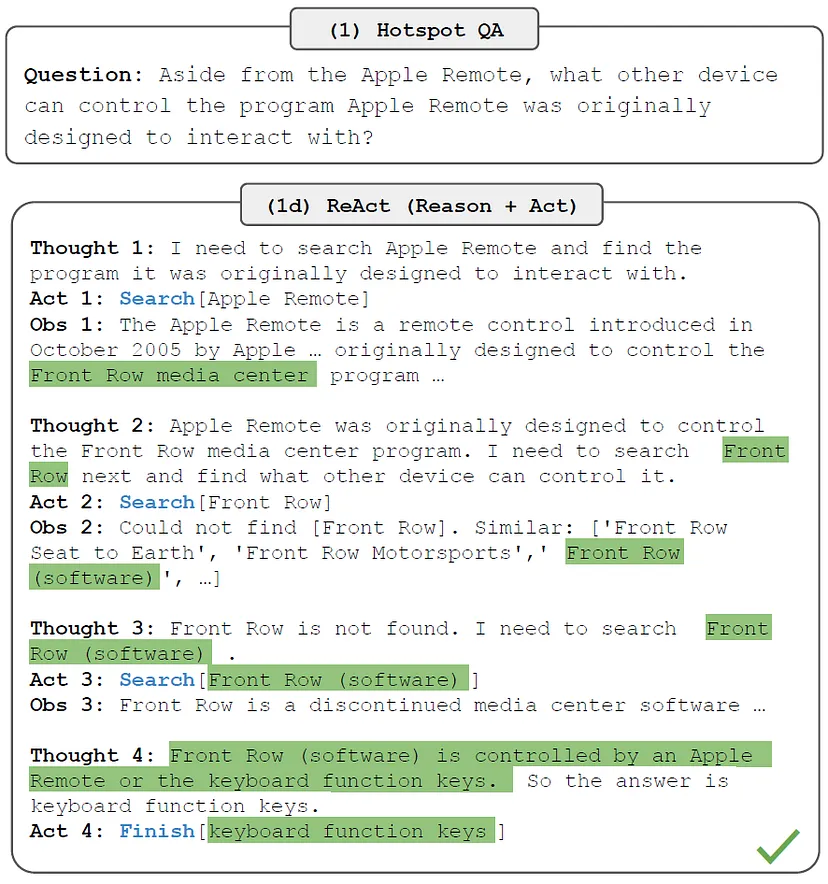

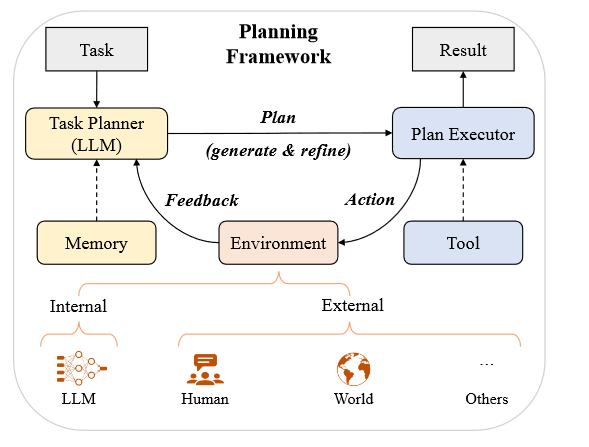

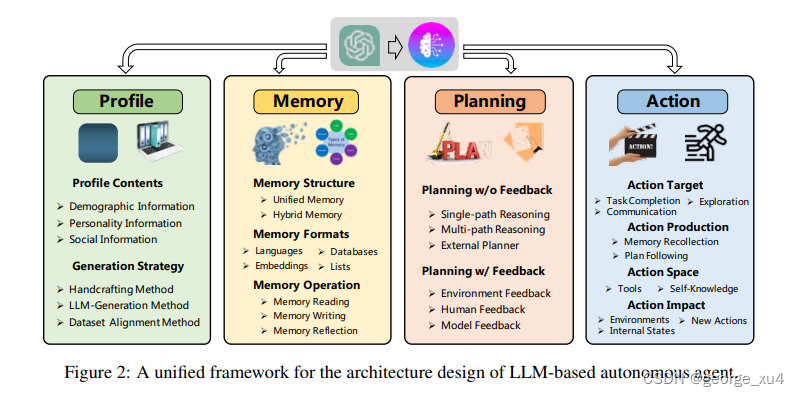

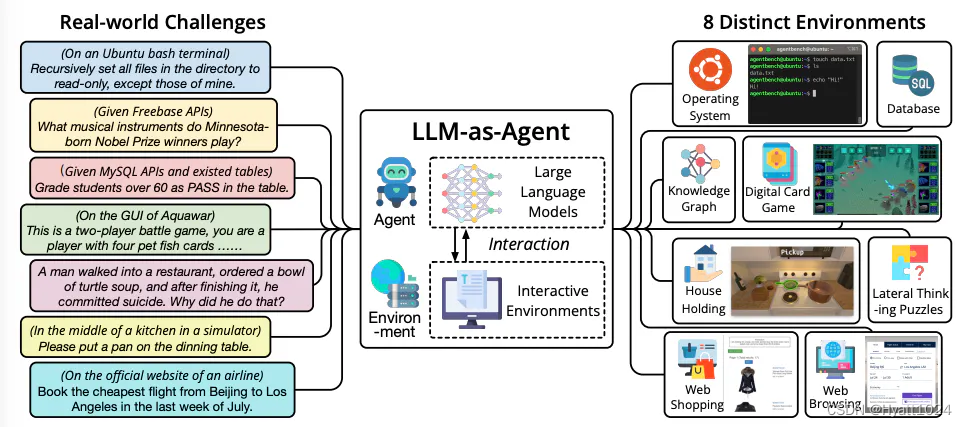

【论文精读】A Survey on Large Language Model based Autonomous Agents

A Survey on Large Language Model based Autonomous Agents 前言Abstract1 Introduction2 LLM-based Autonomous Agent Construction2.1 Agent Architecture Design2.1.1 Profiling Module2.1.2 Memory ModuleMemory StructuresMemory FormatsMemory Operations 2.1.3 Plannin…

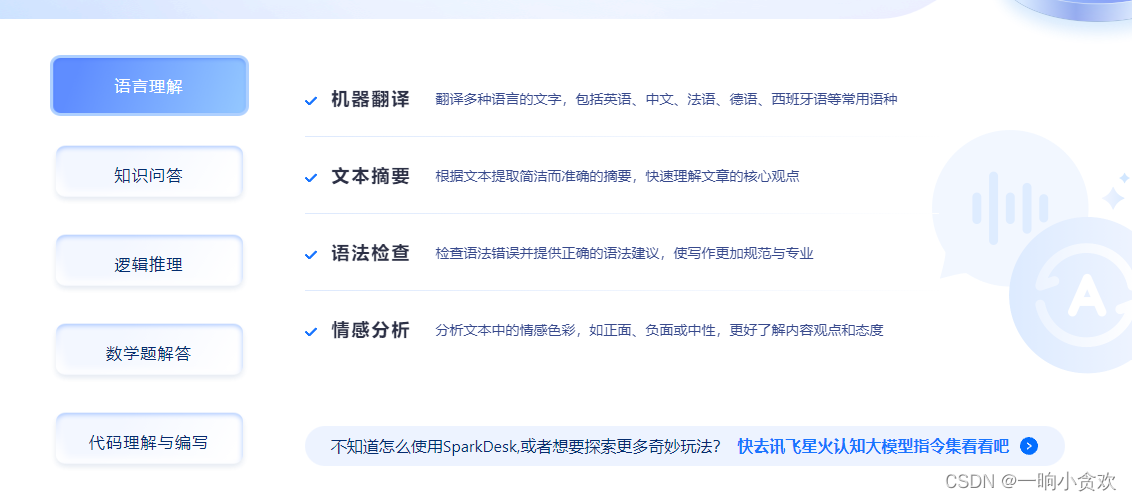

大语言模型之十八-商业思考

大语言模型在翻译、知识问答、写作、摘要、搜索、代码开发等场景得到了广泛的应用,一些策略是将大语言模型集成到公司的现有产品,比如微软的Office接入ChatGPT。

当前大语言模型盈利情况堪忧,今年 5 月有媒体曝出因去年开发出 ChatGPT&#…

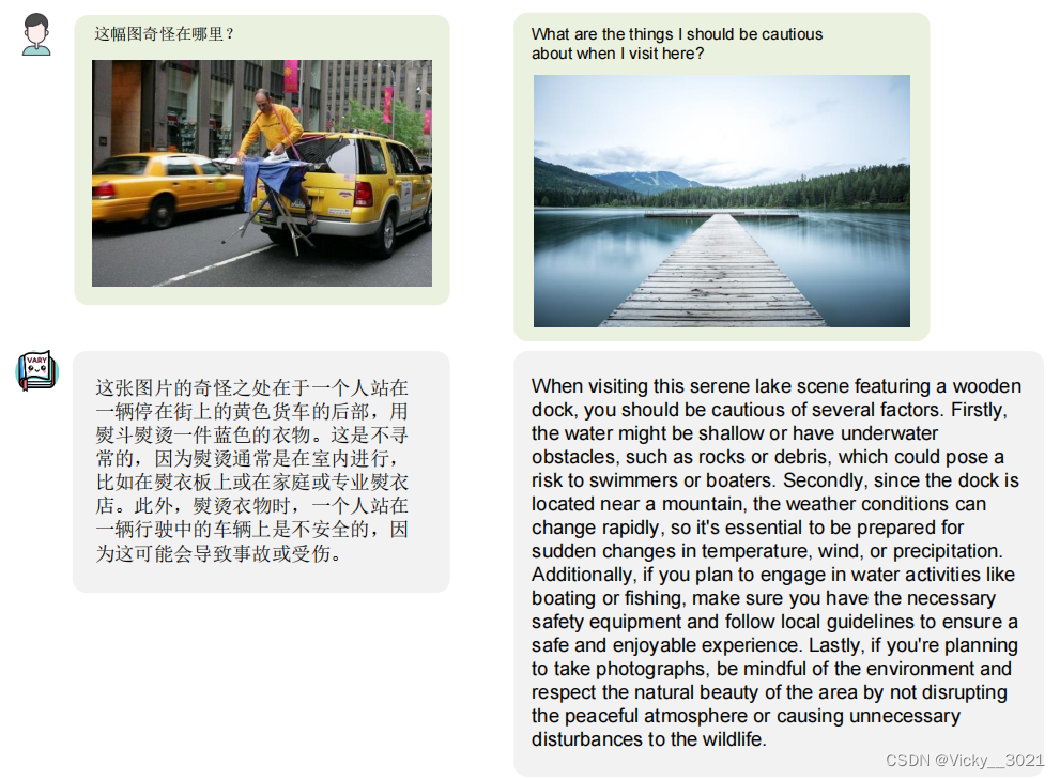

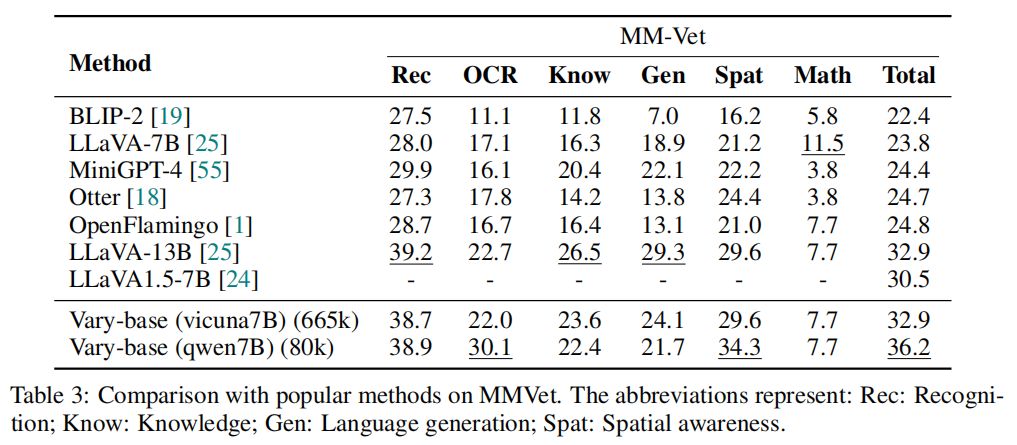

(详细版)Vary: Scaling up the Vision Vocabulary for Large Vision-Language Models

Haoran Wei1∗, Lingyu Kong2∗, Jinyue Chen2, Liang Zhao1, Zheng Ge1†, Jinrong Yang3, Jianjian Sun1, Chunrui Han1, Xiangyu Zhang1 1MEGVII Technology 2University of Chinese Academy of Sciences 3Huazhong University of Science and Technology arXiv 2023.12.11 …

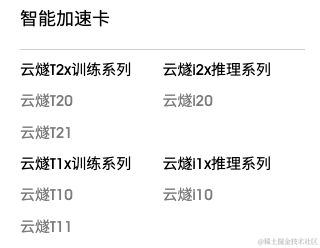

小白也能看懂的国内外 AI 芯片概述

随着越来越多的企业将人工智能应用于其产品,AI芯片需求快速增长,市场规模增长显著。因此,本文主要针对目前市场上的AI芯片厂商及其产品进行简要概述。

简介

AI芯片也被称为AI加速器或计算卡,从广义上讲只要能够运行人工智能算法…

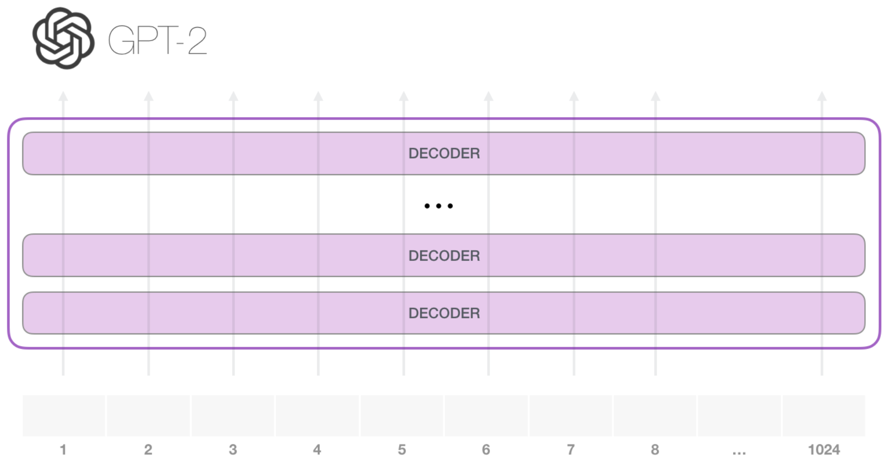

GPT-3(Language Models are Few-shot Learners)简介

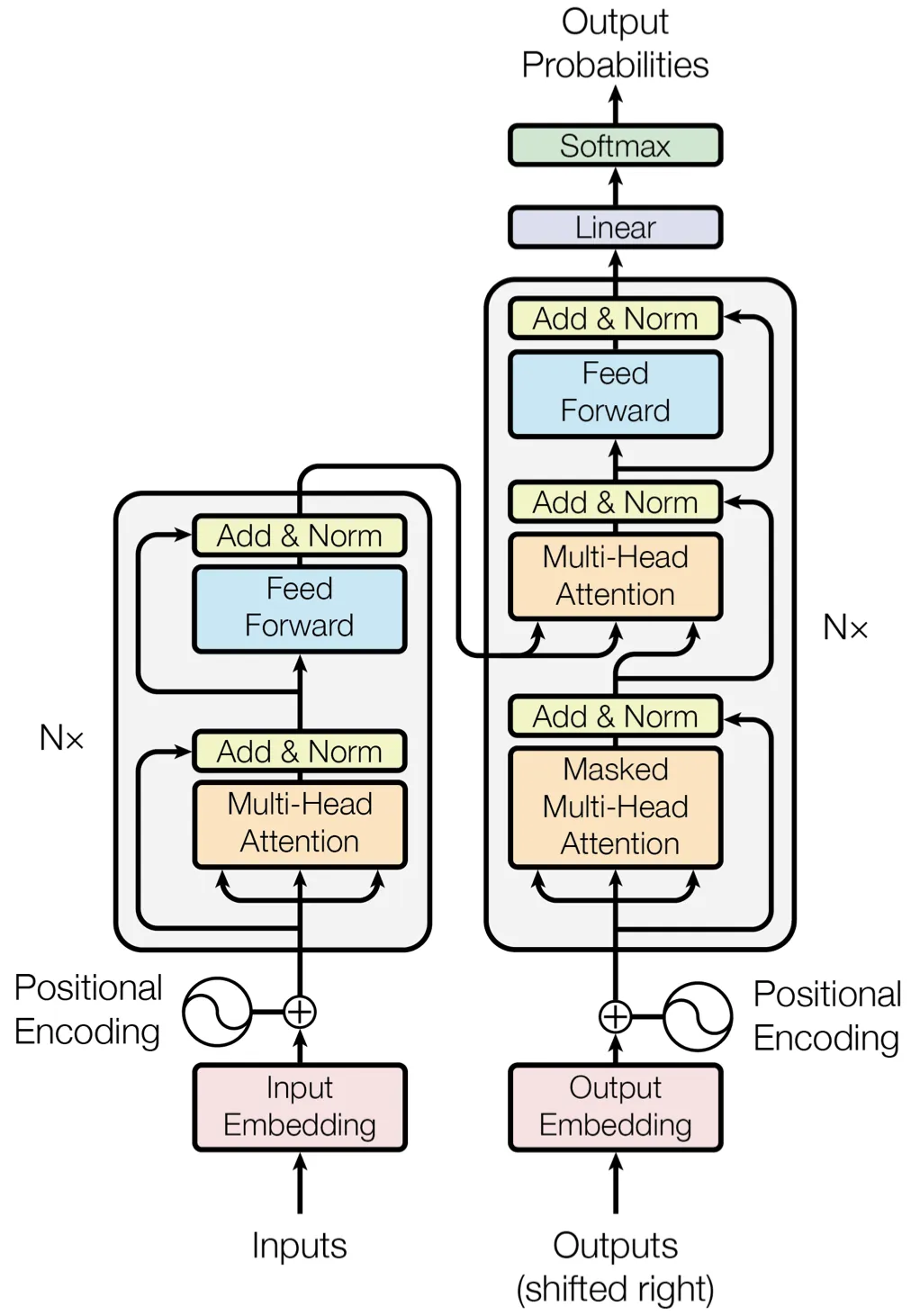

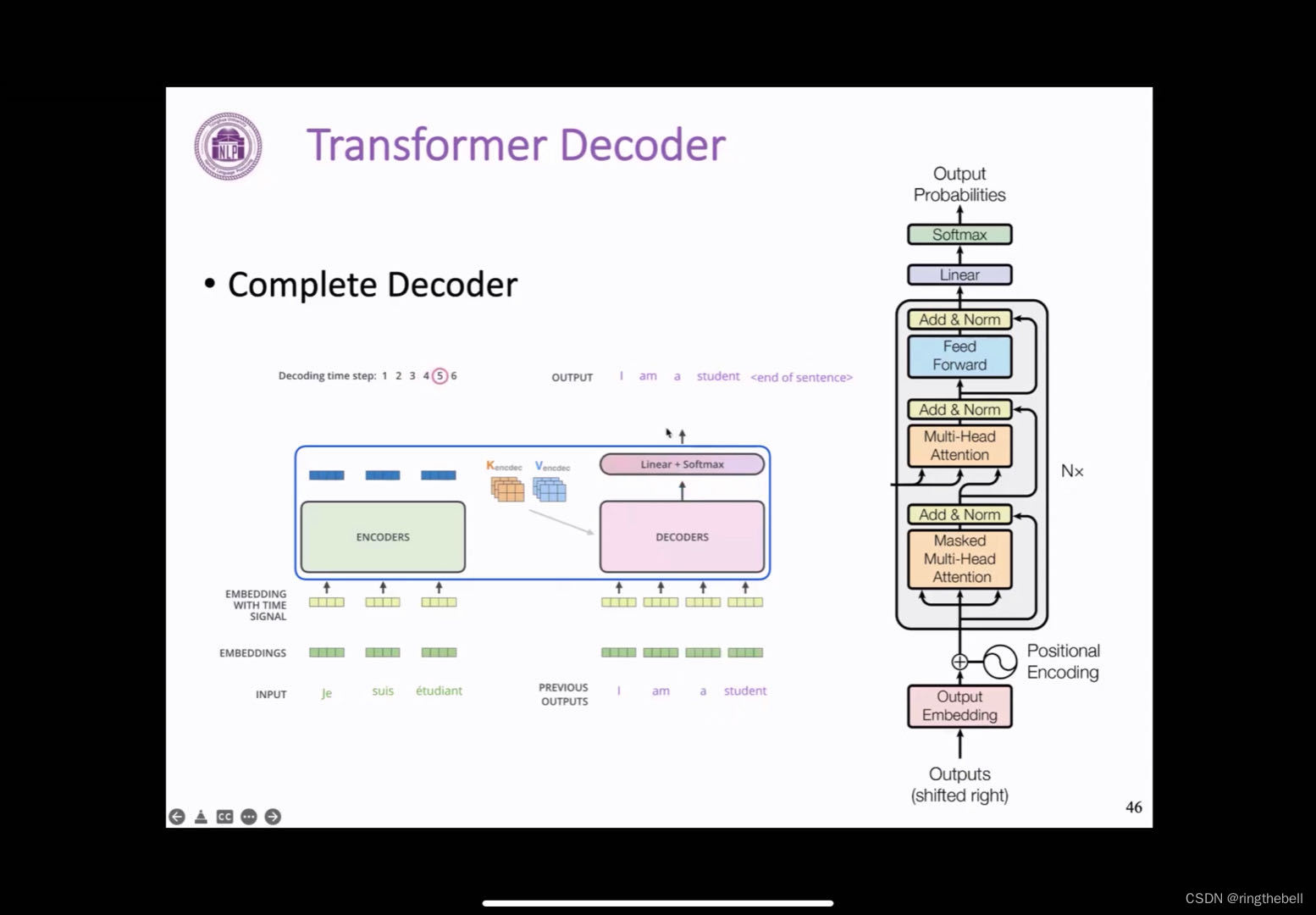

GPT-3(Language Models are Few-shot Learners) GPT-2 网络架构 GPT系列的网络架构是Transformer的Decoder,有关Transformer的Decoder的内容可以看我之前的文章。 简单来说,就是利用Masked multi-head attention来提取文本信息,之后利用MLP和…

GPT火了一年了,你还不懂大语言模型吗?

本文主要介绍大语言的基本原理、以及应用场景和对未来的展望,侧重应用而非技术原理。 🎬个人简介:一个全栈工程师的升级之路! 📋个人专栏:漫谈LLMs带来的AIGC浪潮 🎀CSDN主页 发狂的小花 &#…

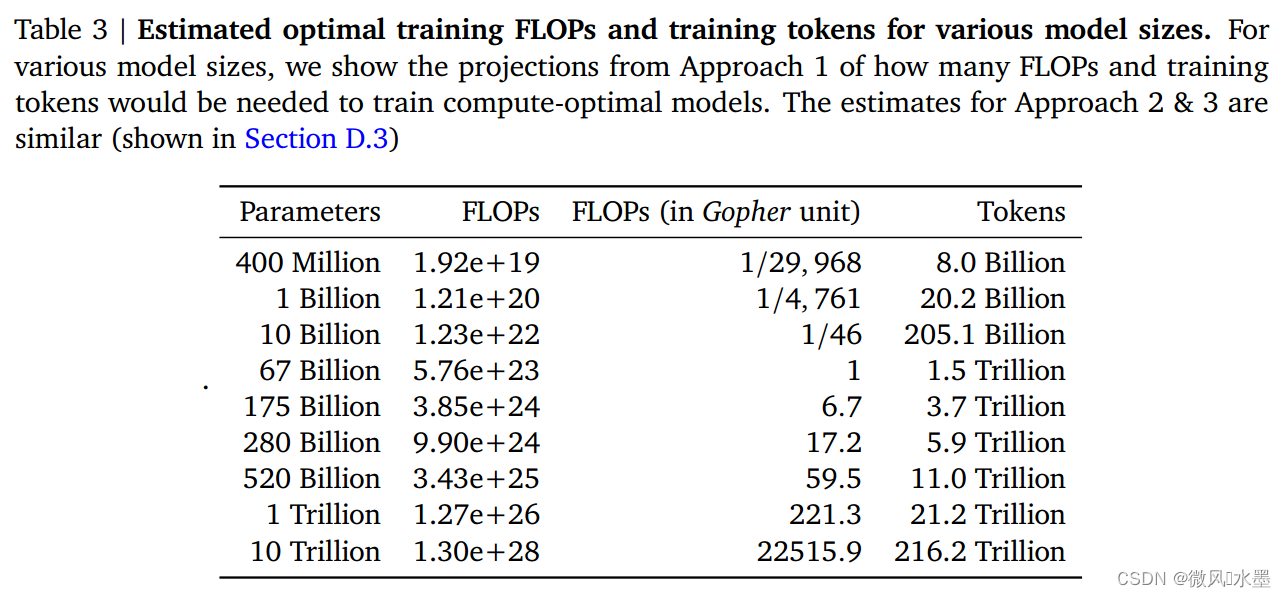

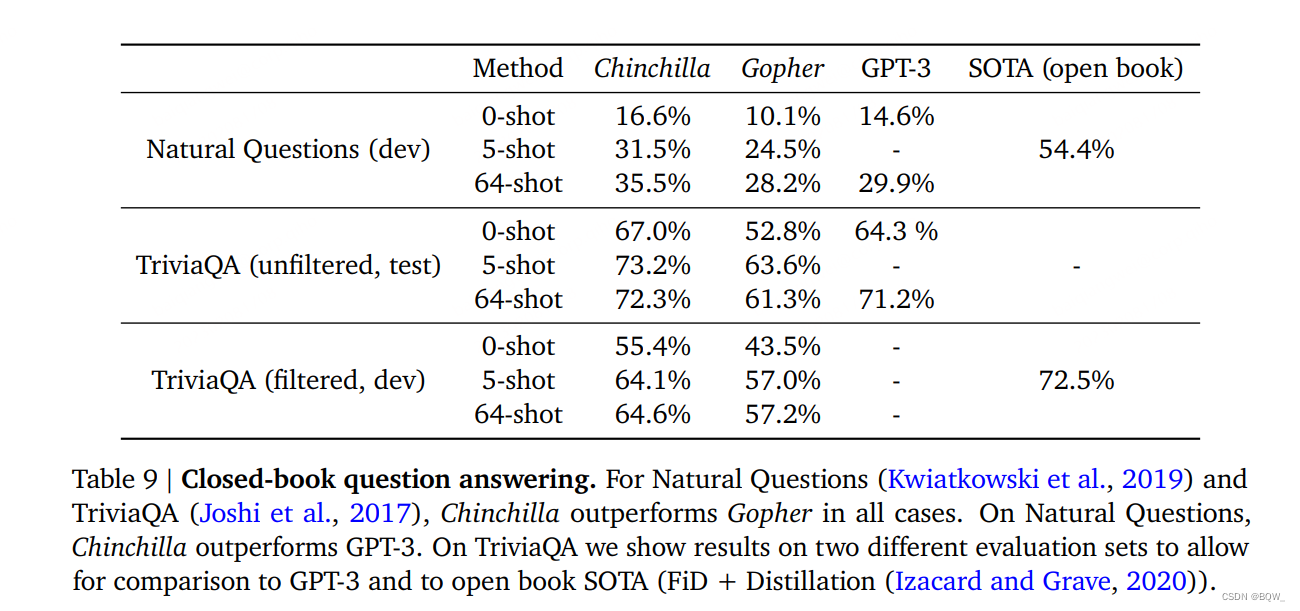

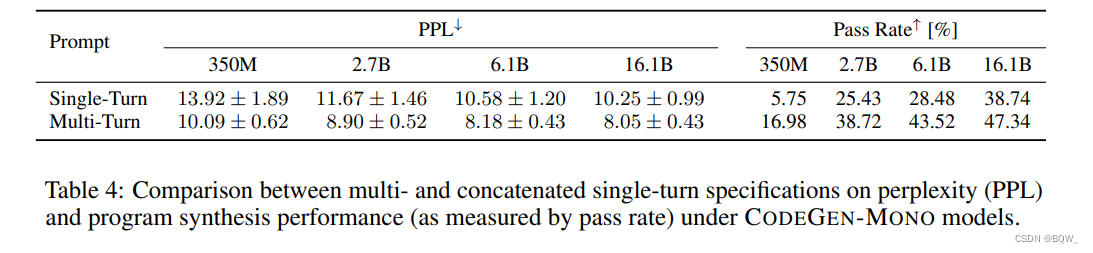

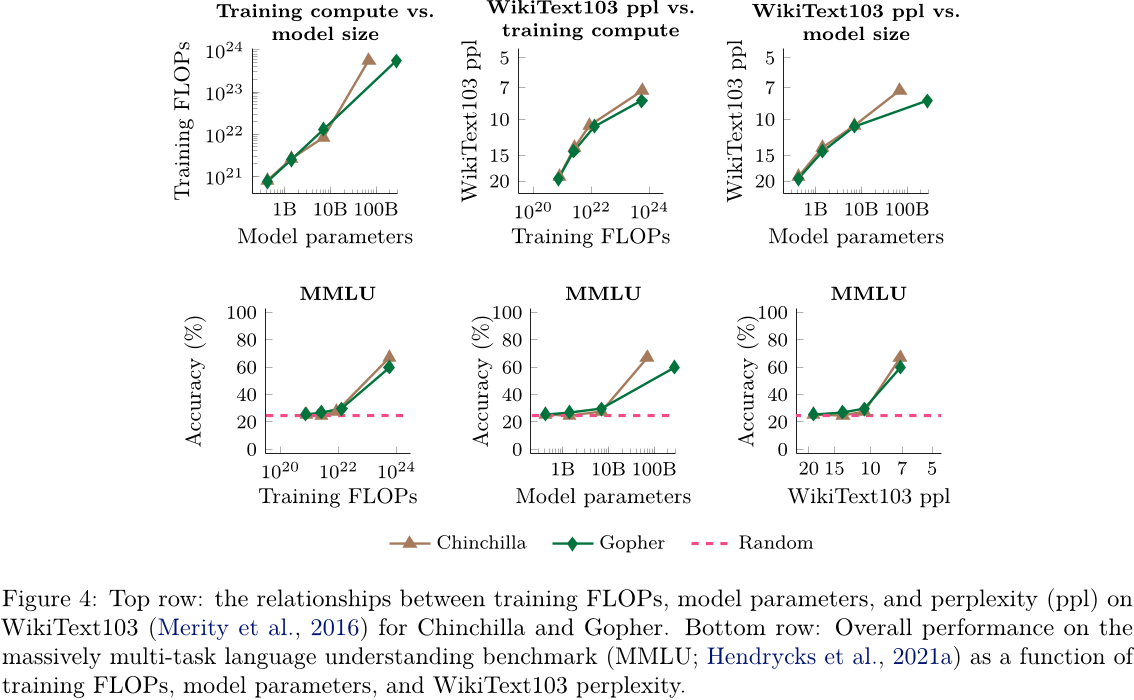

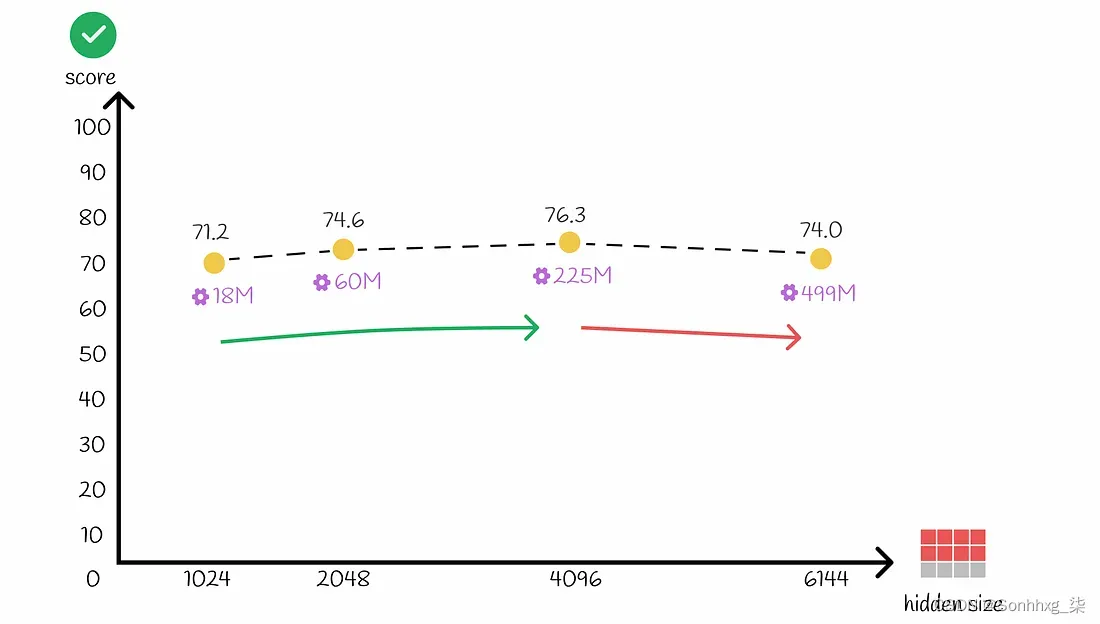

LLM:Training Compute-Optimal Large Language Models

论文:https://arxiv.org/pdf/2203.15556.pdf

发表:2022 前文回顾:

OpenAI在2020年提出《Scaling Laws for Neural Language Models》:Scaling Laws(缩放法则)也一直影响了后续大模型的训练。其给出的结论是最佳计算效…

【通义千问】大模型Qwen GitHub开源工程学习笔记(5)-- 模型的微调【全参数微调】【LoRA方法】【Q-LoRA方法】

摘要: 训练数据的准备

你需要将所有样本放到一个列表中并存入json文件中。每个样本对应一个字典,包含id和conversation,其中后者为一个列表。示例如下所示:

[{"id": "identity_0","conversations": [{"from": "user",…

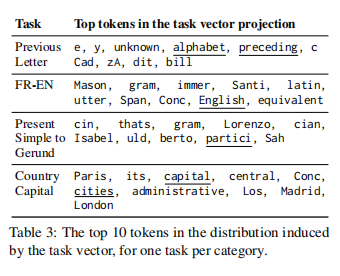

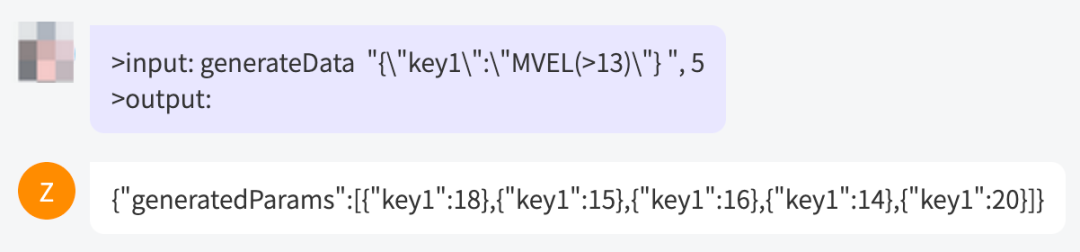

【论文解读】在上下文中学习创建任务向量

一、简要介绍 大型语言模型(LLMs)中的上下文学习(ICL)已经成为一种强大的新的学习范式。然而,其潜在的机制仍未被很好地了解。特别是,将其映射到“标准”机器学习框架是具有挑战性的,在该框架中…

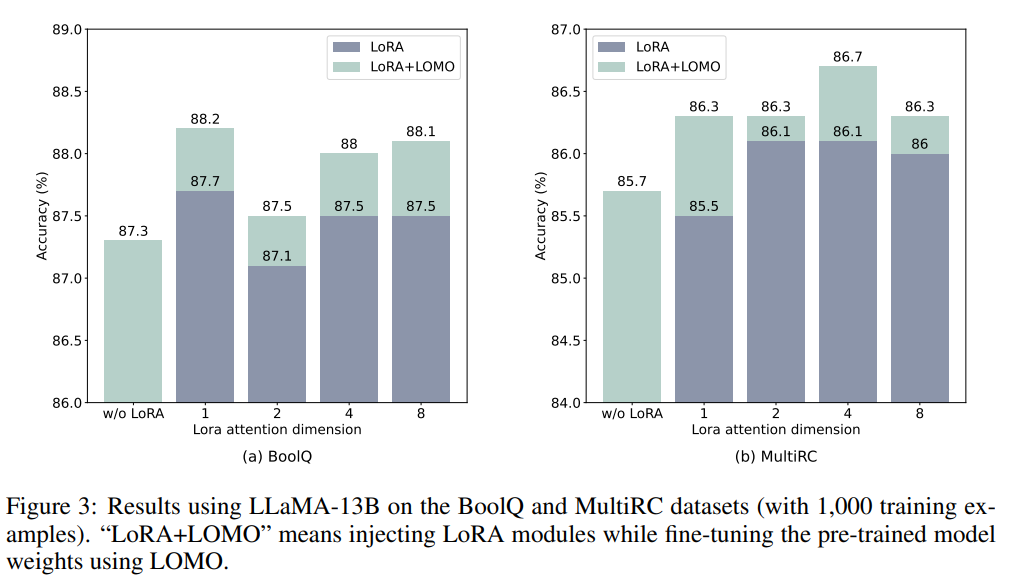

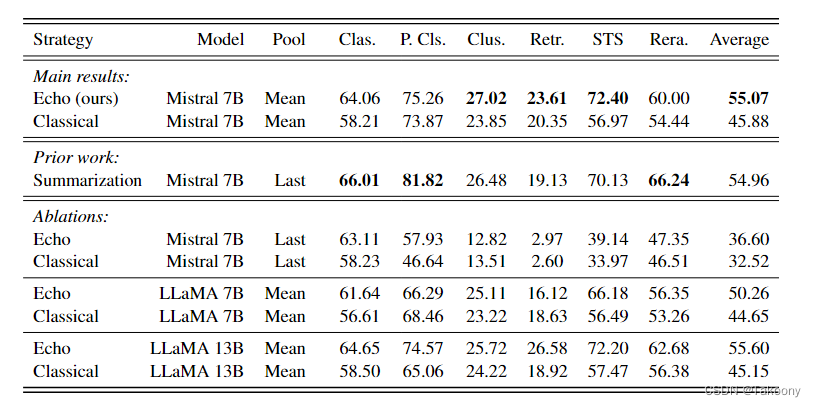

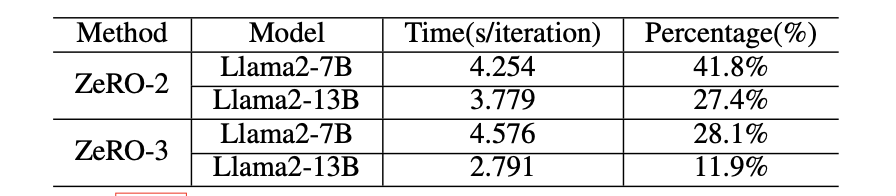

资源有限的大型语言模型的全参数微调

文章目录 摘要1、简介2、相关工作3、方法3.1、重新思考optimizer的功能3.1.1、使用SGD3.1.2、隐式BatchSize 3.2、LOMO:低内存优化3.3、使用LOMO稳定训练3.3.1、梯度归一化和裁剪的替代方法3.3.2、缓解精度下降 4、实验4.1、内存配置4.2、吞吐量4.3、下游性能4.3.1、主要结果4.…

Unified-IO 2 模型: 通过视觉、语言、音频和动作扩展自回归多模态模型。给大家提前预演了GPT5?

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

全球首个完全开源的指令跟随大模型;T5到GPT-4最全盘点

1. Dolly 2.0:世界上第一个完全开源的指令跟随LLM 两周前,Databricks发布了类ChatGPT的大型语言模型 (LLM)Dolly,其训练成本不到 30 美元。今天,他们发布了 Dolly 2.0,这是业内第一个开源的指令跟随LLM,并根…

谷歌Gemini API 应用(二):LangChain 加持

昨天我完成了谷歌Gemini API 应用(一):基础应用这篇博客,今天我们要在此基础上实现Gemini模型的Langchian加持,因为Gemini API刚发布没几天,所以langchian还没有来得及将其整合到现有的langchain包的架构内,langchain公…

GPT2:Language Models are Unsupervised Multitask Learners

目录

一、背景与动机

二、卖点与创新

三、几个问题

四、具体是如何做的

1、更多、优质的数据,更大的模型

2、大数据量,大模型使得zero-shot成为可能

3、使用prompt做下游任务

五、一些资料 一、背景与动机 基于 Transformer 解码器的 GPT-1 证明…

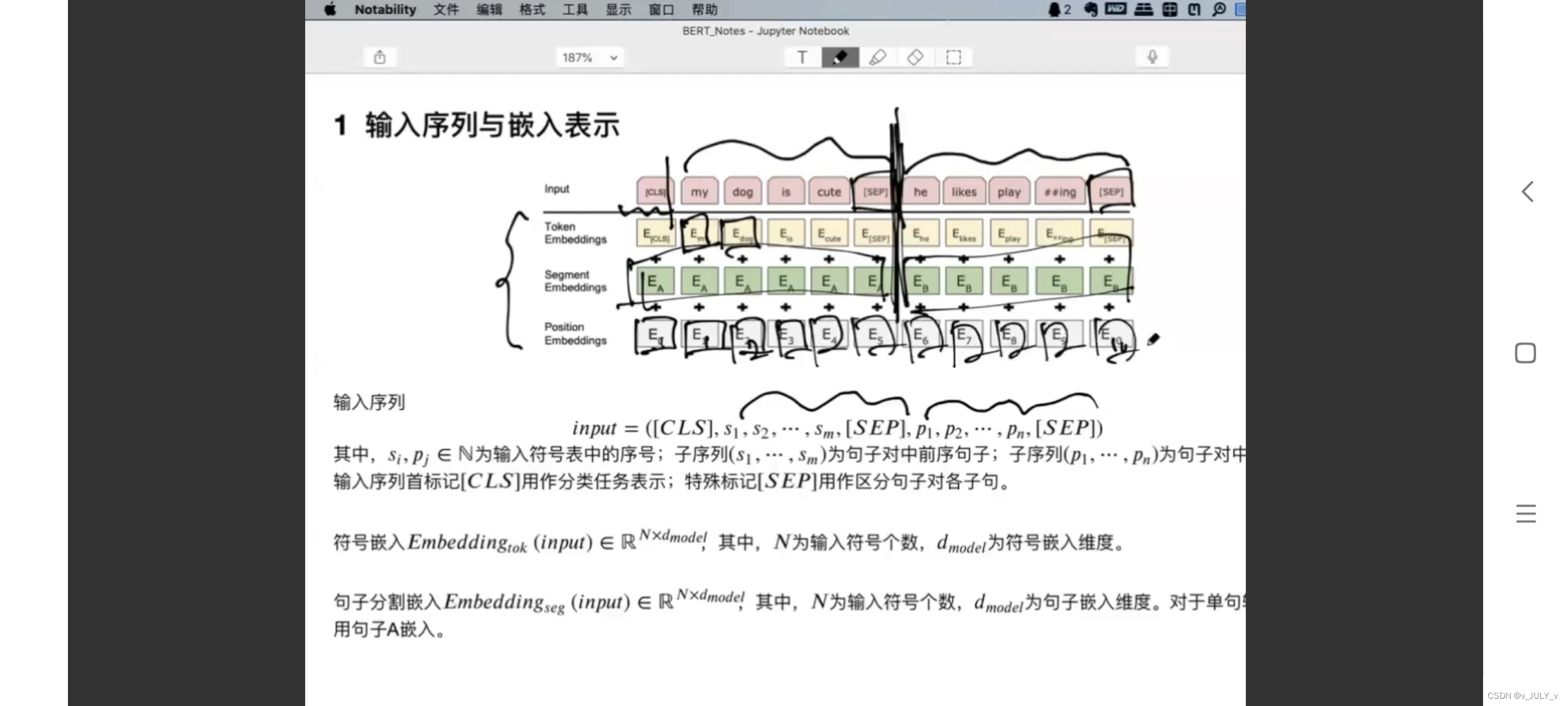

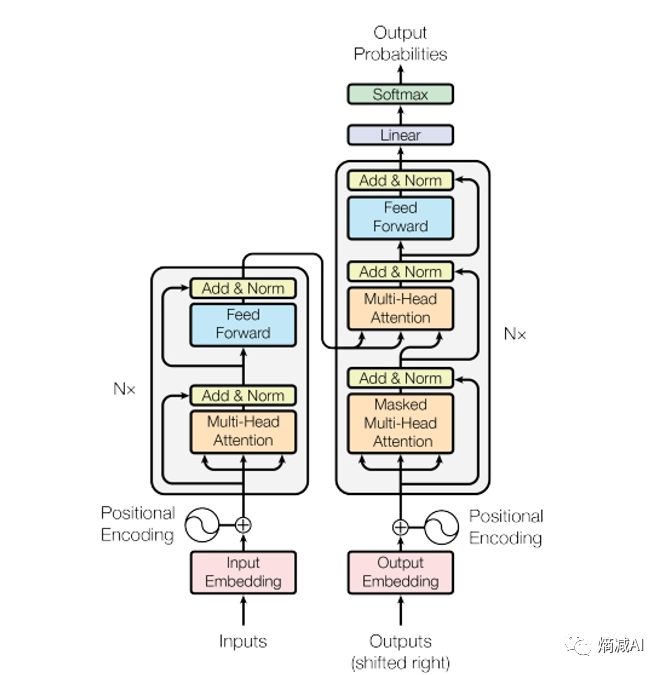

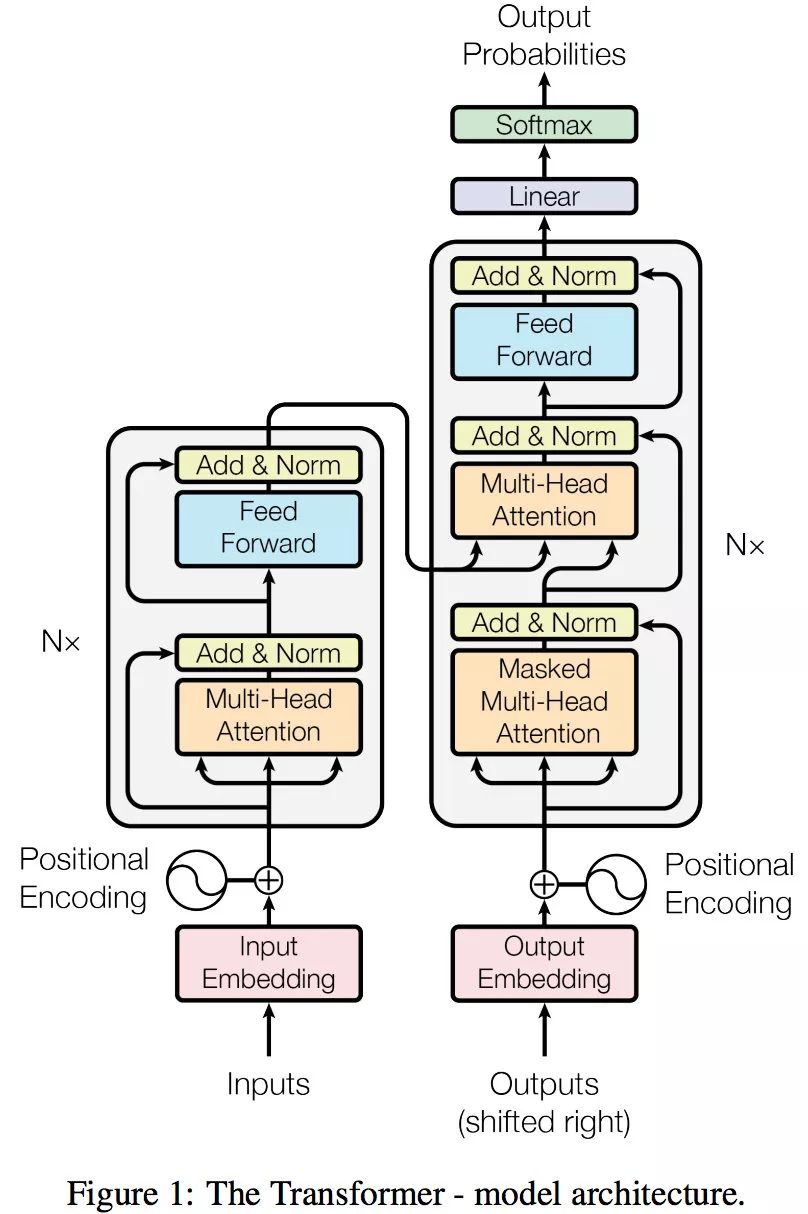

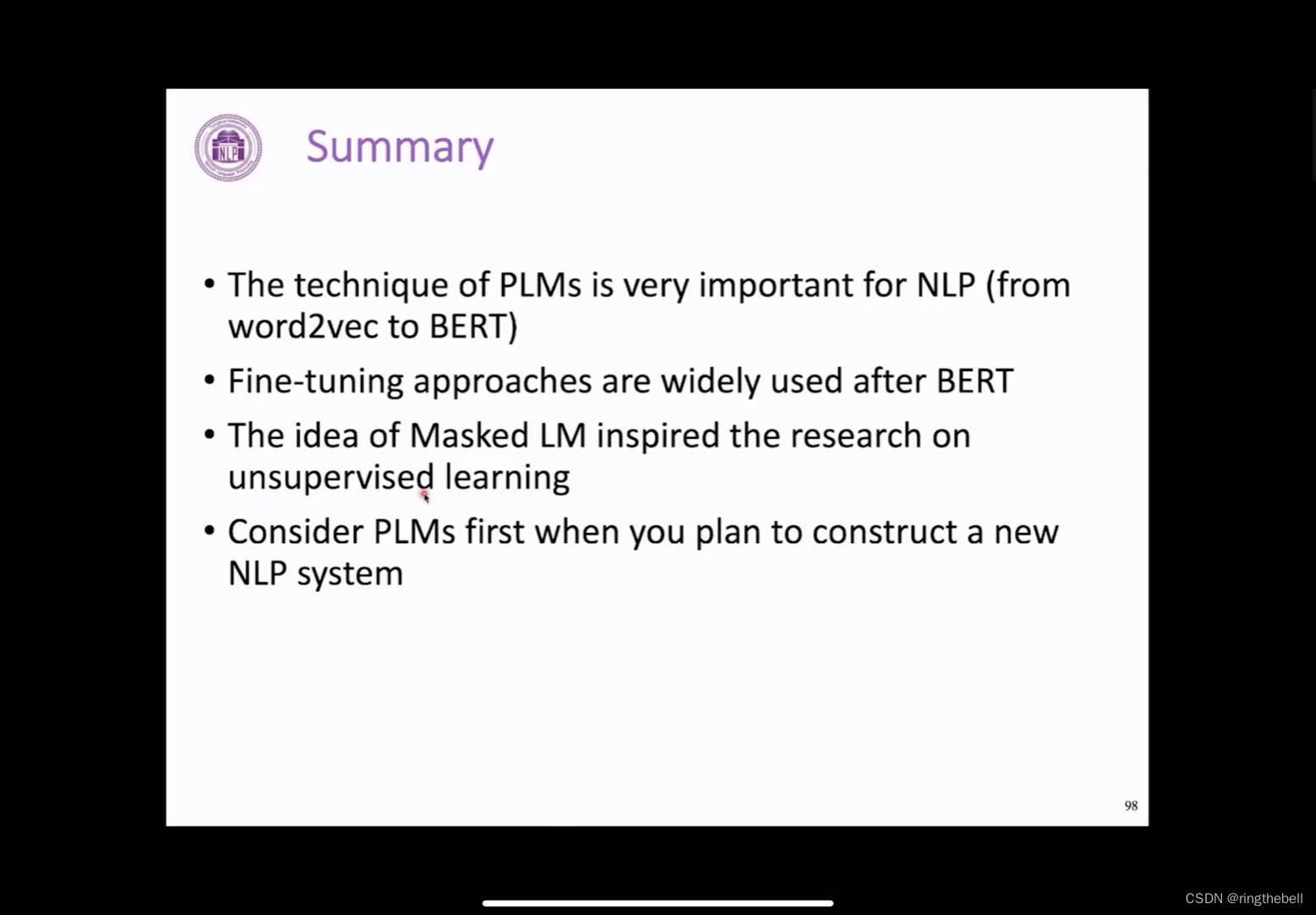

Transformer and Pretrain Language Models3-1

content

transformer

attention mechanism

transformer structure pretrained language models

language modeling

pre-trained langue models(PLMs)

fine-tuning approaches

PLMs after BERT

applications of masked LM

frontiers of PLMs …

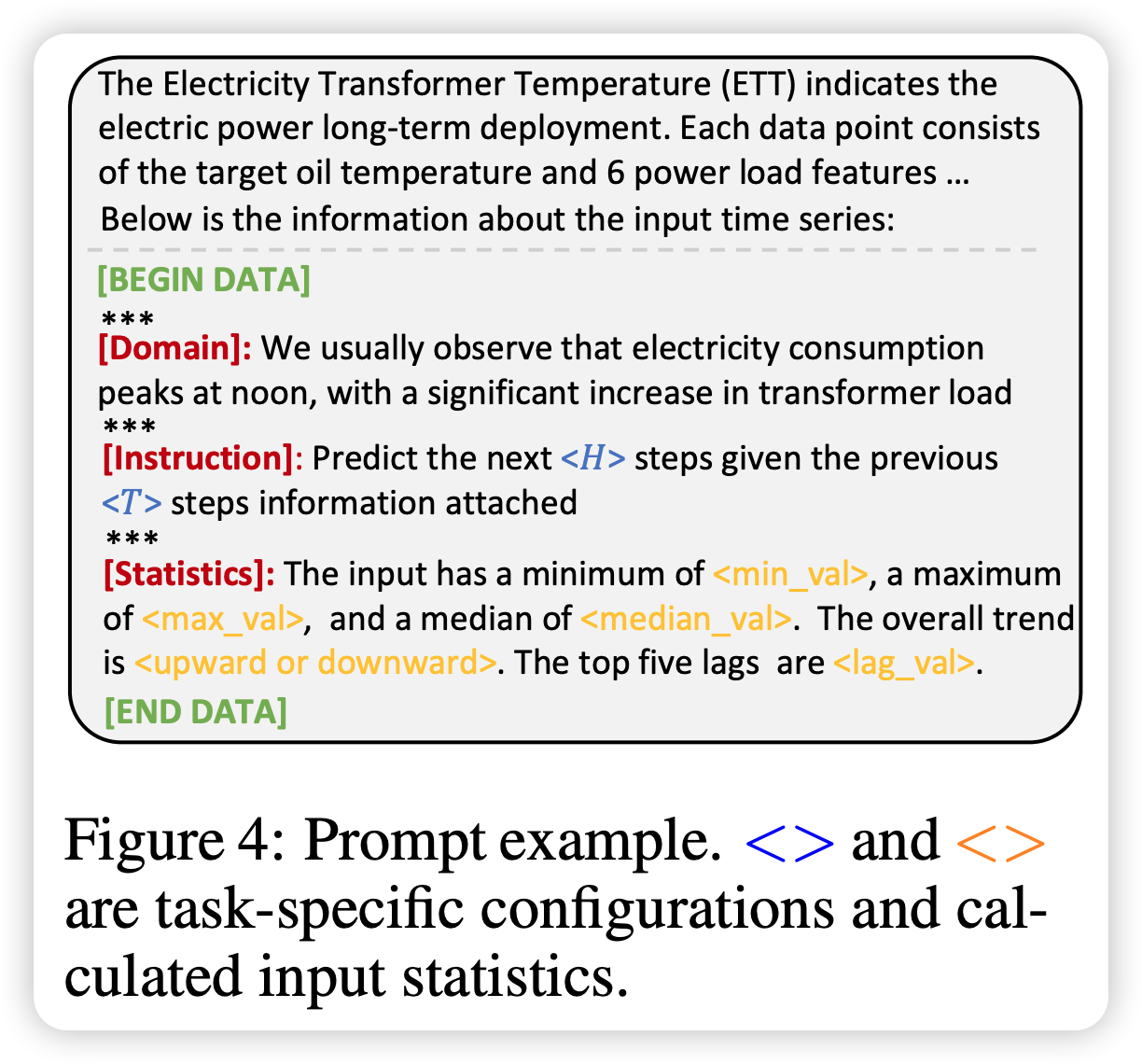

RAG基础功能优化、以及RAG架构优化

RAG基础功能优化

对RAG的基础功能优化,我们要从RAG的流程入手[1],可以在每个阶段做相应的场景优化。 从RAG的工作流程看,能优化的模块有:文档块切分、文本嵌入模型、提示工程优化、大模型迭代。下面针对每个模块分别做说明&#…

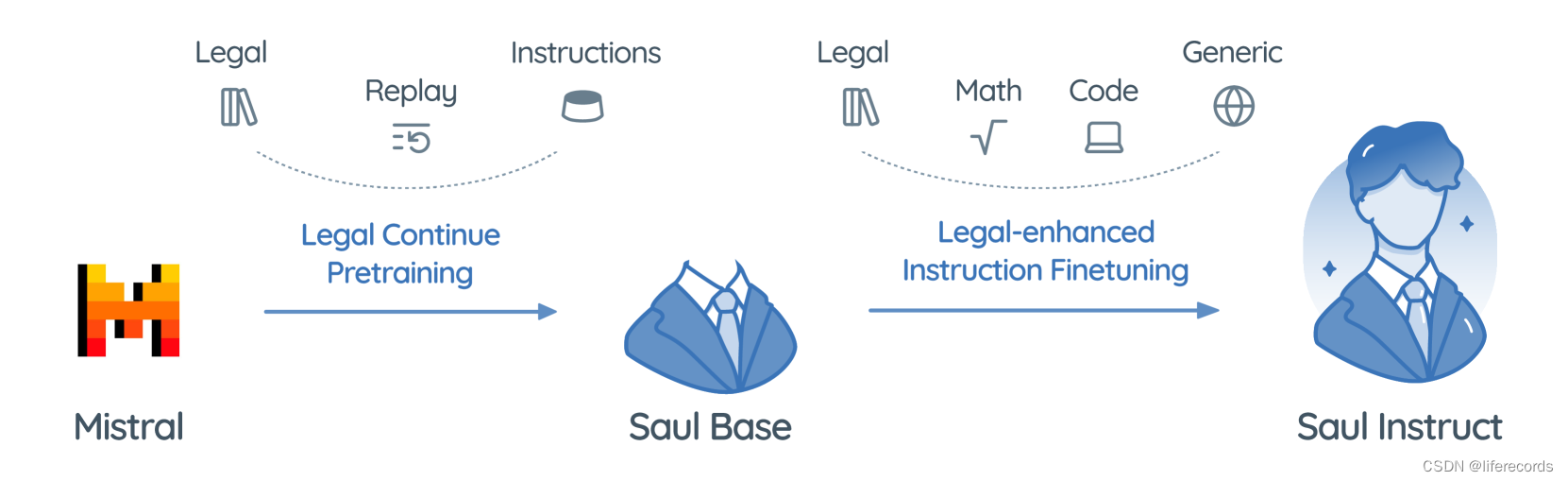

一篇综述洞悉医学大型语言模型的原理,应用和挑战

在过去的一年中,随着 GPT-4、LLaMA、Mistral,PaLM 等先进技术的突飞猛进,大型语言模型(Large Language Models)已经引领全球人工智能进入了一个全新的基础模型时代,这一时代不仅开启了技术创新的新篇章&…

以桨为楫 修己度人(二)

目录 1.人工智能开创的新时代 2.使命开启飞桨一春独占 3.技术突破奠定飞桨品牌一骑绝尘 4.行业应用积淀飞桨品牌一枝独秀 5.生态传播造就飞桨品牌一众独妍 6.深度学习平台的现状和未来思考

使命开启飞桨品牌一春独占 深刻洞察技术走势和市场需求趋势的百度,提早布局…

生成 Cypher 能力:GPT3.5 VS ChatGLM

生成 Cypher 能力:GPT3.5 VS ChatGLM 生成 Cypher 能力:GPT3.5 VS ChatGLM一、 测试结果二、 测试代码(包含Prompt) Here’s the table of contents: 生成 Cypher 能力:GPT3.5 VS ChatGLM 在之前的文章中已经测试过GPT…

4bit/8bit 启动 Mixtral 8*7B 大语言模型

4bit/8bit 启动 Mixtral 8*7B 大语言模型 0. 背景1. 修改代码 0. 背景

个人电脑配置实在难以以 float16 运行 Mixtral 8*7B 大语言模型,所以参数 4bit 或者 8bit 来启动。

实际测试结果,4bit 时推理速度明显变快了,8bit 时推理也非常慢。

…

1024程序员节获奖名单公示~恭喜各位上榜同学

1024程序员节完美收官!

恭喜各个分会场中奖的小伙伴~我们已于昨日的线下会场完成奖品及证书发放!

更多优秀作品欢迎大家点击查看:卡奥斯开源社区 — 打造工业互联网顶级开源社区

颁奖典礼精彩回放:卡奥斯开源社区 — 打造工业互…

PEFT学习:使用LORA进行LLM微调

使用LORA进行LLM微调 PEFT安装LORA使用: PEFT安装

由于LORA,AdaLORA都集成在PEFT上了,所以在使用的时候安装PEFT是必备项

方法一:PyPI To install 🤗 PEFT from PyPI:

pip install peft方法二:Source

New features…

解密 AI 客服;在不同硬件设备上运行大型语言模型的可能性

🦉 AI新闻

🚀 微软必应首席执行官称必应聊天优于OpenAI的GPT-4,但成本更高

摘要:微软必应的首席执行官米哈伊尔・帕拉欣表示,必应聊天表现优于OpenAI的GPT-4,但使用了更高成本的检索增强推理技术。必应聊…

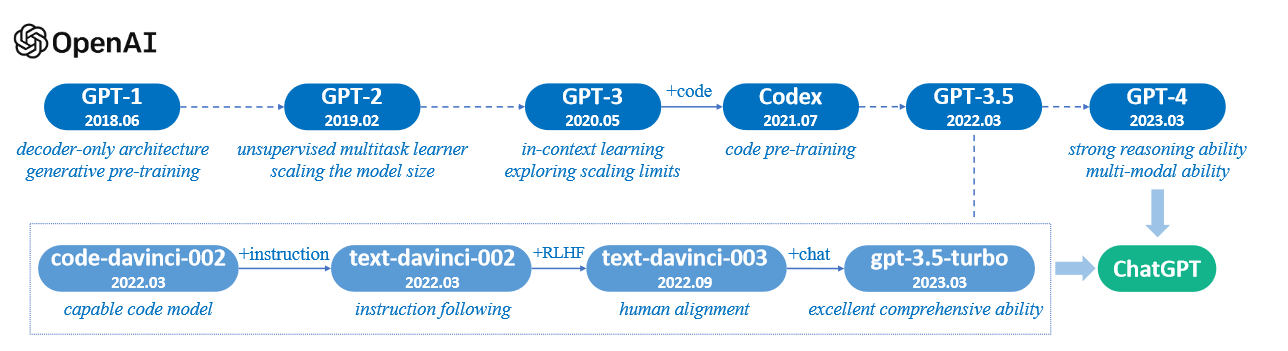

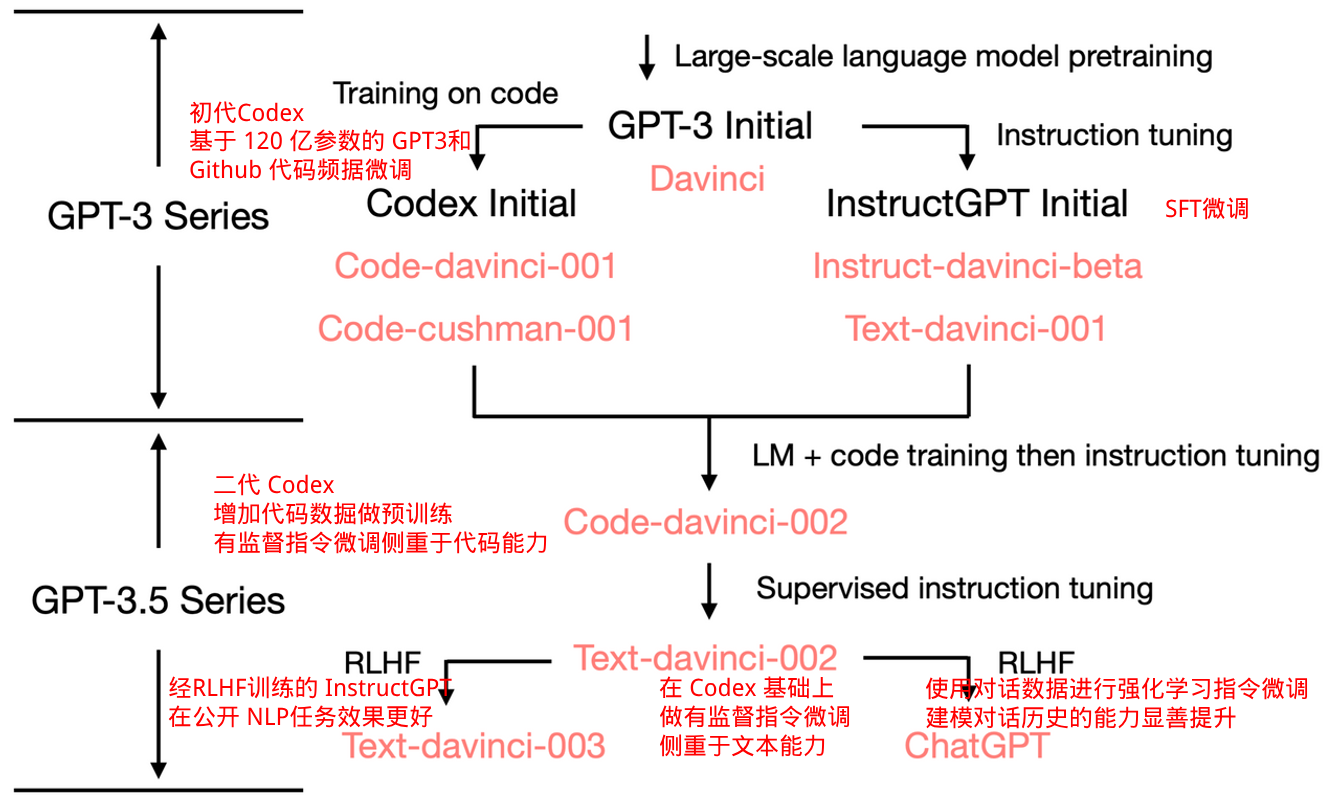

大模型基础02:GPT家族与提示学习

大模型基础:GPT 家族与提示学习

从 GPT-1 到 GPT-3.5

GPT(Generative Pre-trained Transformer)是 Google 于2018年提出的一种基于 Transformer 的预训练语言模型。它标志着自然语言处理领域从 RNN 时代进入 Transformer 时代。GPT 的发展历史和技术特点如下: GPT-12018年6月…

XREAL推出其新款AR眼镜:XREAL Air 2 Ultra,体量轻内置音效

这款眼镜堪称科技的杰作,它以钛合金为框架,尽显轻盈与精致。配备的双3D环境传感器,宛如双眼般敏锐,能精准捕捉头部运动,让你在虚拟与现实间自由穿梭。120Hz的超高刷新率与500尼特的亮度,让你在4米之外感受1…

生成式AI与大语言模型,东软已经准备就绪

伴随着ChatGPT的火爆全球,数以百计的大语言模型也争先恐后地加入了这一战局,掀起了一场轰轰烈烈的“百模大战”。毋庸置疑的是,继方兴未艾的人工智能普及大潮之后,生成式AI与大语言模型正在全球开启新一轮生产力革新的科技浪潮。 …

Reinforcement Learning in the Era of LLMs: What is Essential? What is needed?

本文是LLM系列文章,针对《Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond.》的翻译。 LLMs时代的强化学习:什么是本质?需要什么?RLHF、提…

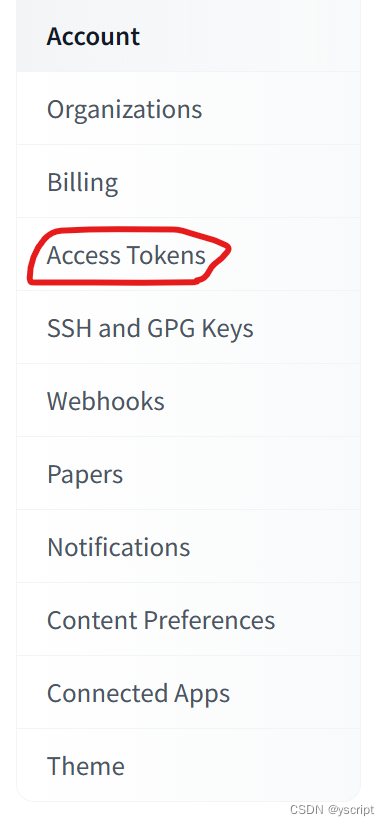

如何快速部署本地训练的 Bert-VITS2 语音模型到 Hugging Face

Hugging Face是一个机器学习(ML)和数据科学平台和社区,帮助用户构建、部署和训练机器学习模型。它提供基础设施,用于在实时应用中演示、运行和部署人工智能(AI)。用户还可以浏览其他用户上传的模型和数据集…

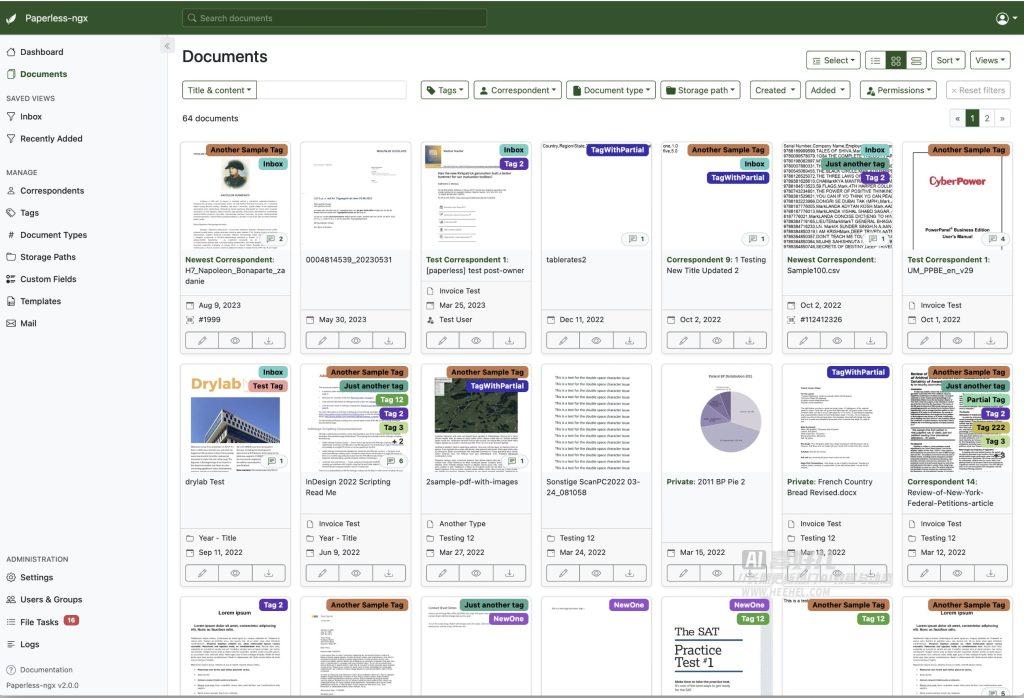

拒绝纸张浪费,Paperless-ngx开源文档管理系统将纸质版转换成可搜索的电子版档案

GitHub:GitHub - paperless-ngx/paperless-ngx: A community-supported supercharged version of paperless: scan, index and archive all your physical documents 在线演示:https://demo.paperless-ngx.com 官网:https://docs.paperless-n…

What Makes Pre-trained Language Models Better Zero-shot Learners?

本文是LLM系列文章,针对《What Makes Pre-trained Language Models Better Zero-shot Learners?》的翻译。 是什么让经过预训练的语言模型更好地成为零样本学习者? 摘要1 引言2 前言3 假设4 方法5 前导性研究6 实验7 讨论8 结论9 局限性 摘要…

AI 工具探索(二)

我参加了 奇想星球 与 Datawhale 举办的 【AI办公 X 财务】第一期,现在这是第二次打卡,也即自由探索,我选择 Modelscope 的 Agent 探索,并用gpts创作助理对比!

最近想学学小红书的运营方法,选择了 小红书I…

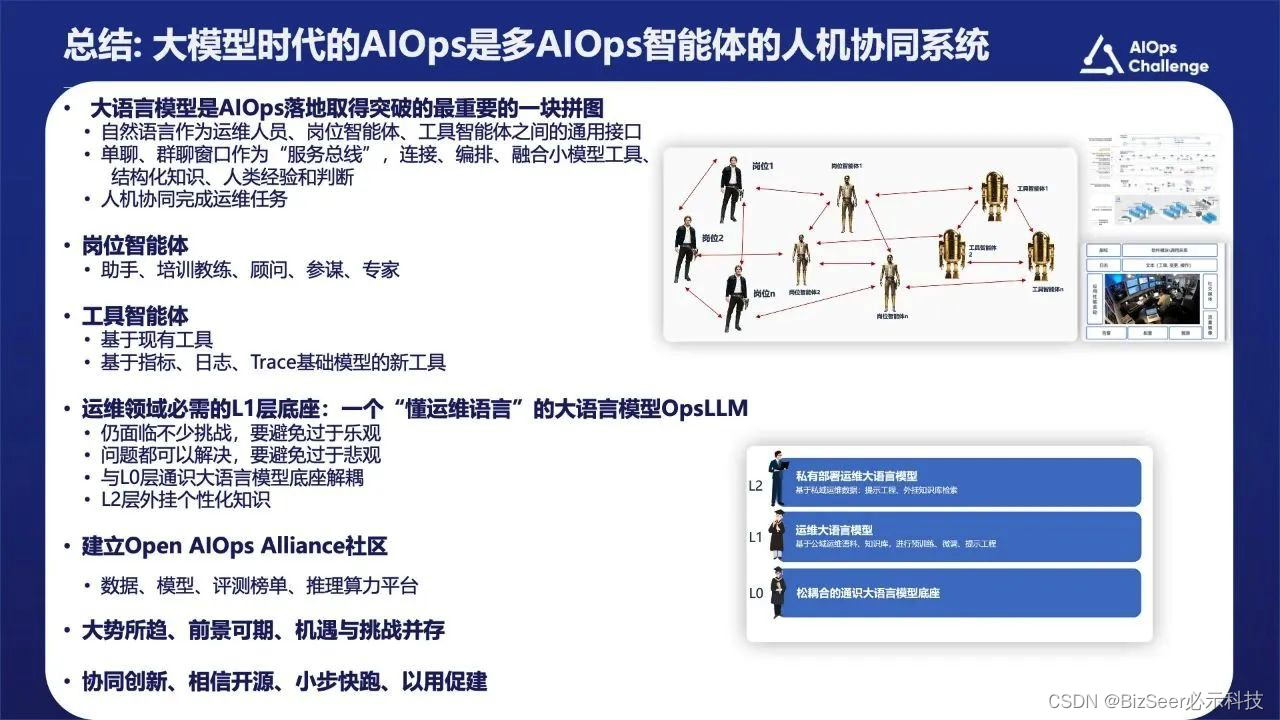

OpenAIOps社区线上宣讲会圆满召开,期待您的加入!

2024年1月12日“OpenAIOps社区”线上宣讲会圆满召开,群体智慧协同创新社区的创立为AIOps领域未来发展注入了活力。OpenAIOps社区是一个AIOps开源社区及创新平台,由中国计算机学会(CCF)、清华大学、南开大学、中科院、国防科大、必示科技等单位共同发起&a…

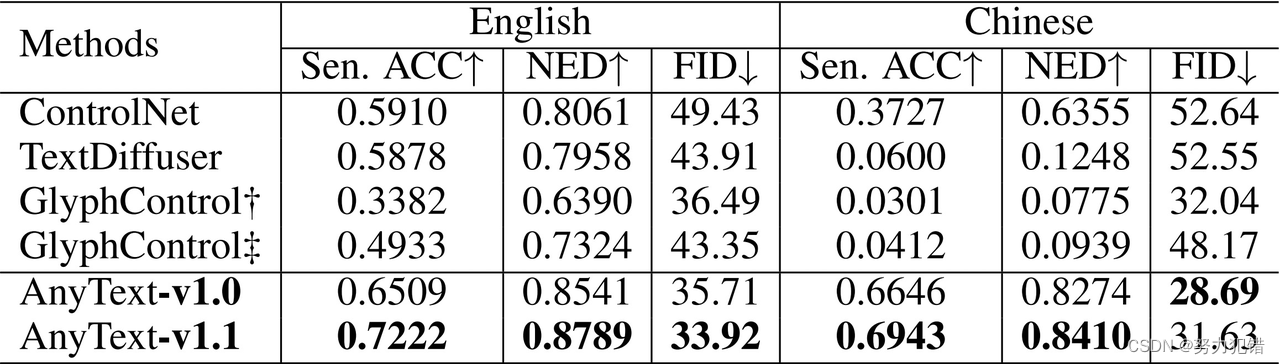

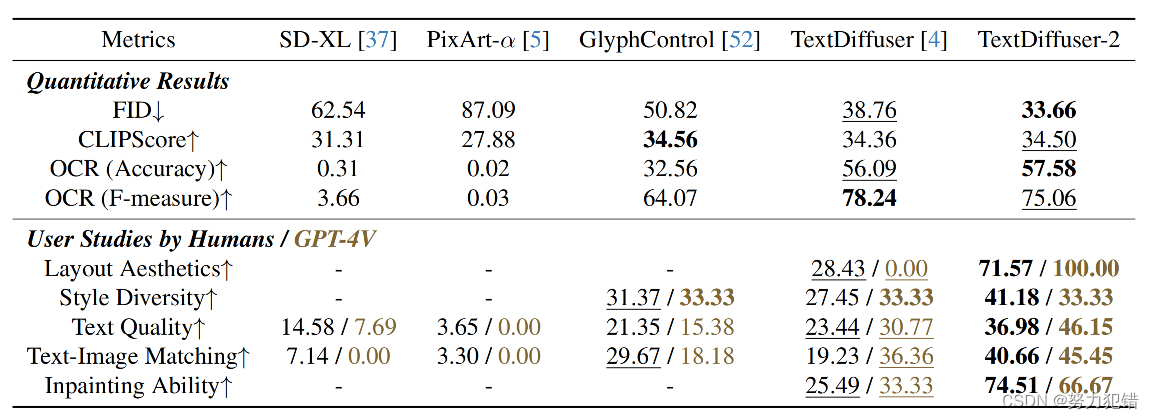

阿里AnyText:多语种图像文字嵌入的突破

模型简介

随着Midjourney、Stable Difusion等产品的兴起,文生图像技术迅速发展。然而,在图像中生成或嵌入精准文本一直是一个挑战,尤其是对中文的支持。阿里巴巴的研究人员开发了AnyText,这是一个多语言视觉文字生成与编辑模型&a…

多模态GPT-V出世!36种场景分析ChatGPT Vision能力,LMM将全面替代大语言模型? | 京东云技术团队

LMM将会全面替代大语言模型?人工智能新里程碑GPT-V美国预先公测,医疗领域/OCR实践166页GPT-V试用报告首发解读 ChatGPT Vision,亦被广泛称为GPT-V或GPT-4V,代表了人工智能技术的新里程碑。作为LMM (Large Multimodal Model) 的代表…

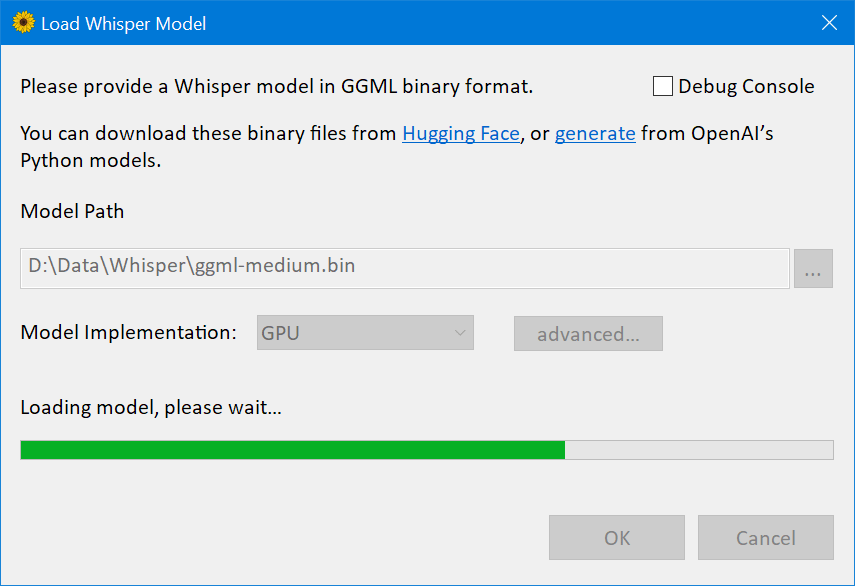

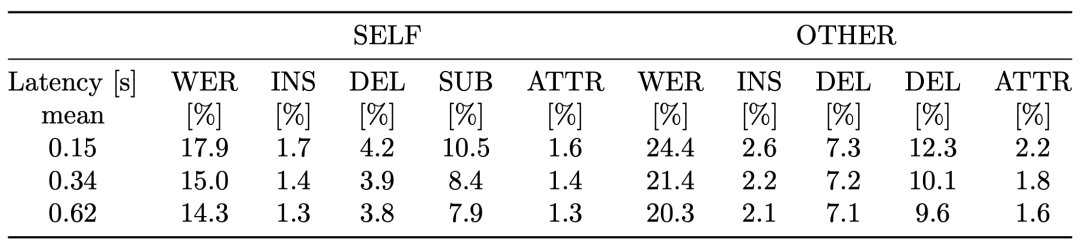

Whisper对于中文语音识别与转写中文文本优化的实践(Python3.10)

阿里的FunAsr对Whisper中文领域的转写能力造成了一定的挑战,但实际上,Whisper的使用者完全可以针对中文的语音做一些优化的措施,换句话说,Whisper的“默认”形态可能在中文领域斗不过FunAsr,但是经过中文特殊优化的Whi…

【深度学习】语言模型与注意力机制以及Bert实战指引之一

文章目录 统计语言模型和神经网络语言模型注意力机制和Bert实战Bert配置环境和模型转换格式准备 模型构建网络设计模型配置代码实战 统计语言模型和神经网络语言模型

区别:统计语言模型的本质是基于词与词共现频次的统计,而神经网络语言模型则是给每个词…

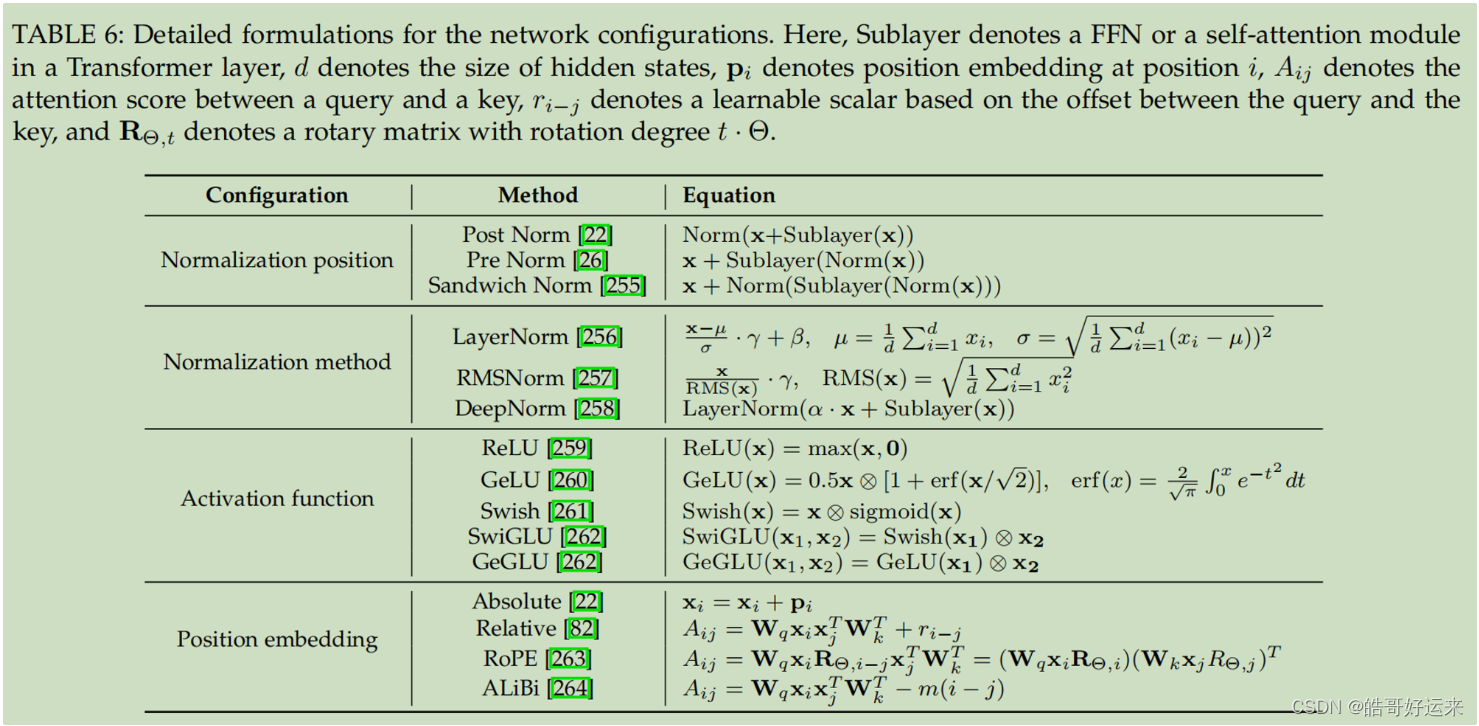

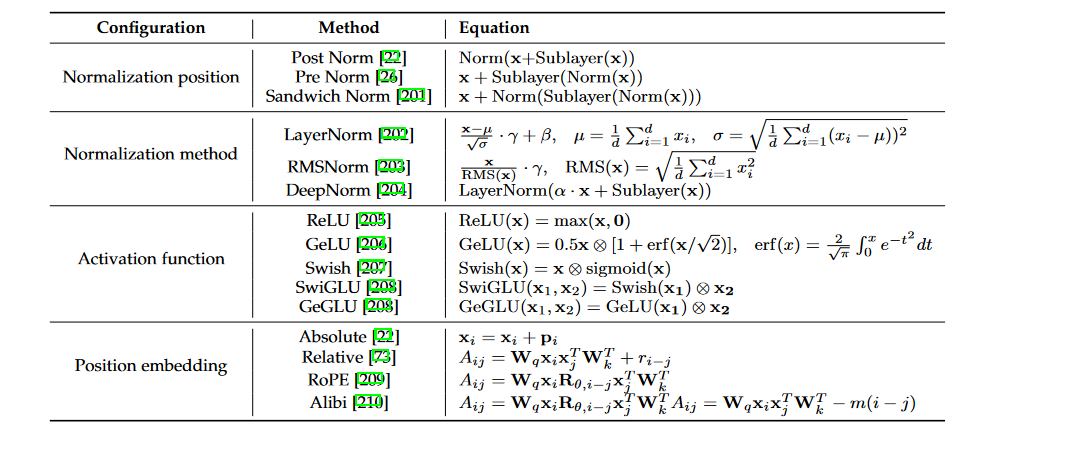

【Datawhale 大模型基础】第六章 大模型的模型架构(中文版)

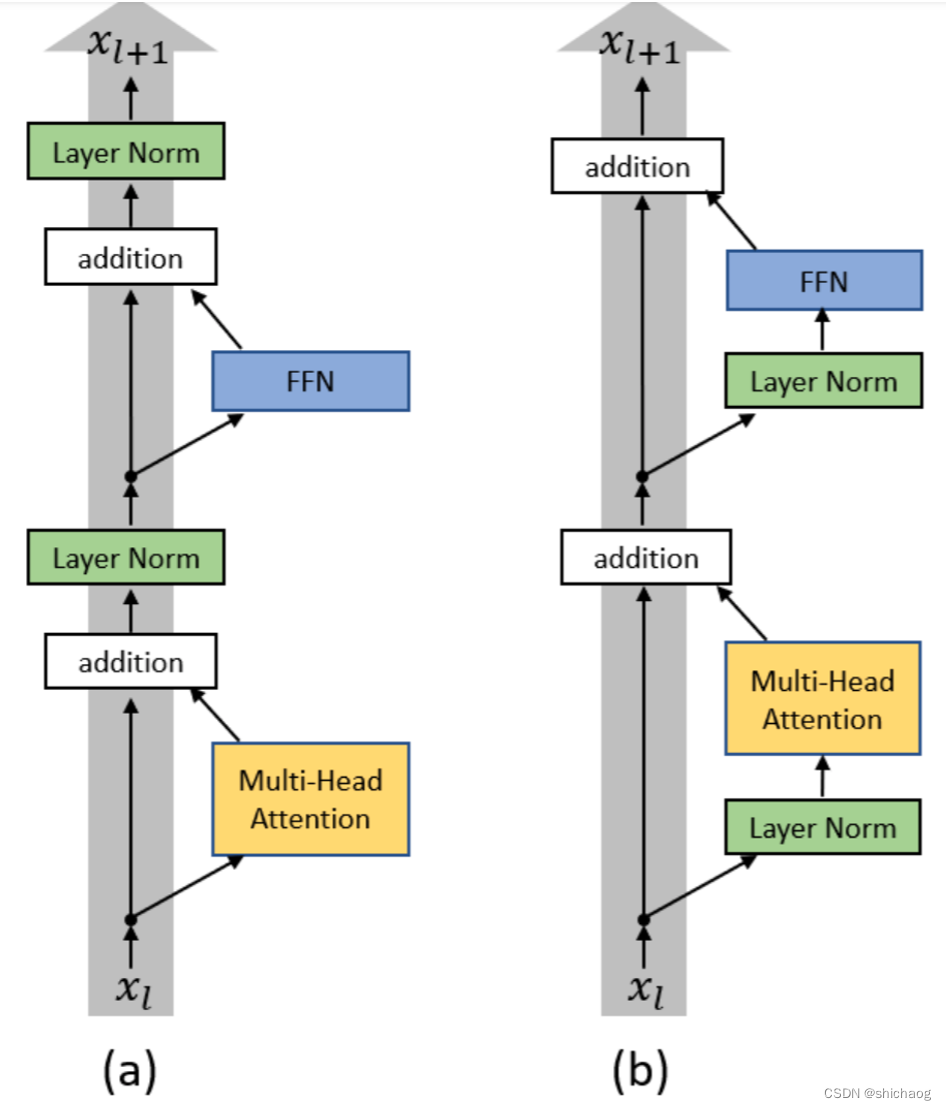

在之前的博客中,讨论了LLMs的训练数据及数据调度方法。这篇博客将聚焦于LLMs的另一个重要方面:模型架构。由于模型架构的复杂性和多样性,我将写一篇双语博客。这个版本是中文的,明天将发布英文版本(数据部分也将以中文…

大语言模型的未来进化路径及其影响

随着人工智能技术的飞速发展,大语言模型已成为智能时代的重要标志之一。从早期基于规则和统计学习的语言模型,到如今基于深度学习框架下的Transformer架构,如GPT系列、BERT等,大语言模型已经在自然语言处理领域取得了前所未有的突…

一个开源的大型语言模型LLaMA论文简单解读,LLaMA: Open and Efficient Foundation Language Models

一个开源的大型语言模型LLaMA论文解读,LLaMA: Open and Efficient Foundation Language Models返回论文和资料目录

1.导读

LLaMA 是 Meta AI 发布的包含 7B、13B、33B 和 65B 四种参数规模的基础语言模型集合,LLaMA-13B 仅以 1/10 规模的参数在多数的 …

开源大型语言模型(llm)总结

大型语言模型(LLM)是人工智能领域中的一个重要研究方向,在ChatGPT之后,它经历了快速的发展。这些发展主要涉及以下几个方面:

模型规模的增长:LLM的规模越来越大,参数数量显著增加。这种扩展使得…

Talk | 阿里巴巴算法专家王潇斌:开箱即用的文本理解大模型

本期为TechBeat人工智能社区第538期线上Talk! 北京时间10月18日(周三)20:00阿里巴巴算法专家—王潇斌的Talk已准时在TechBeat人工智能社区开播! 他与大家分享的主题是: “开箱即用的文本理解大模型”,介绍了他们提出的SeqGPT以及EcomGPT两个文…

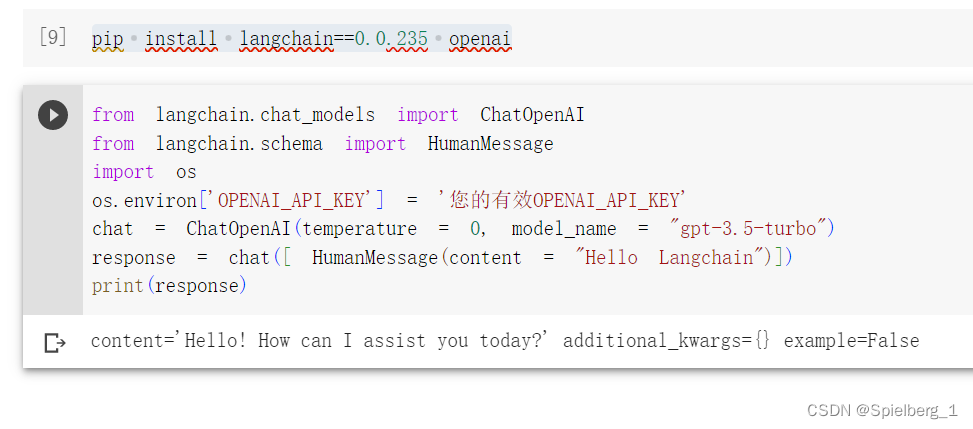

用LangChain构建大语言模型应用

用LangChain构建大语言模型应用

自 ChatGPT 发布以来,大型语言模型 (LLM) 广受欢迎。尽管您可能没有足够的资金和计算资源从头开始训练自己的大语言模型,但您仍然可以使用预训练的大语言模型来构建一些很酷的东西,例如:

可以根据…

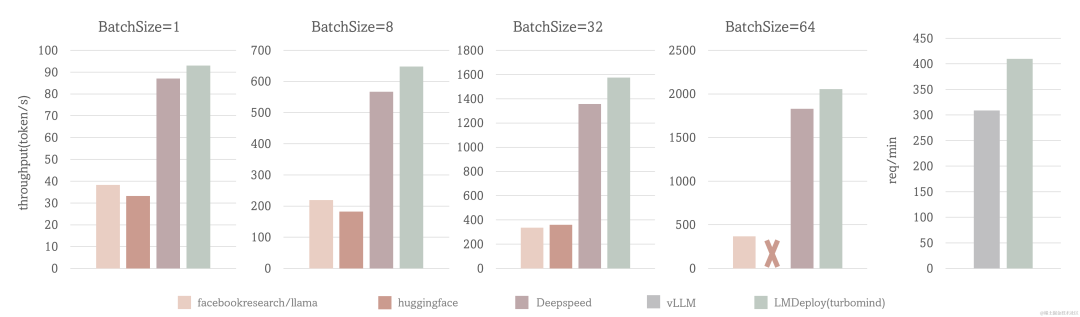

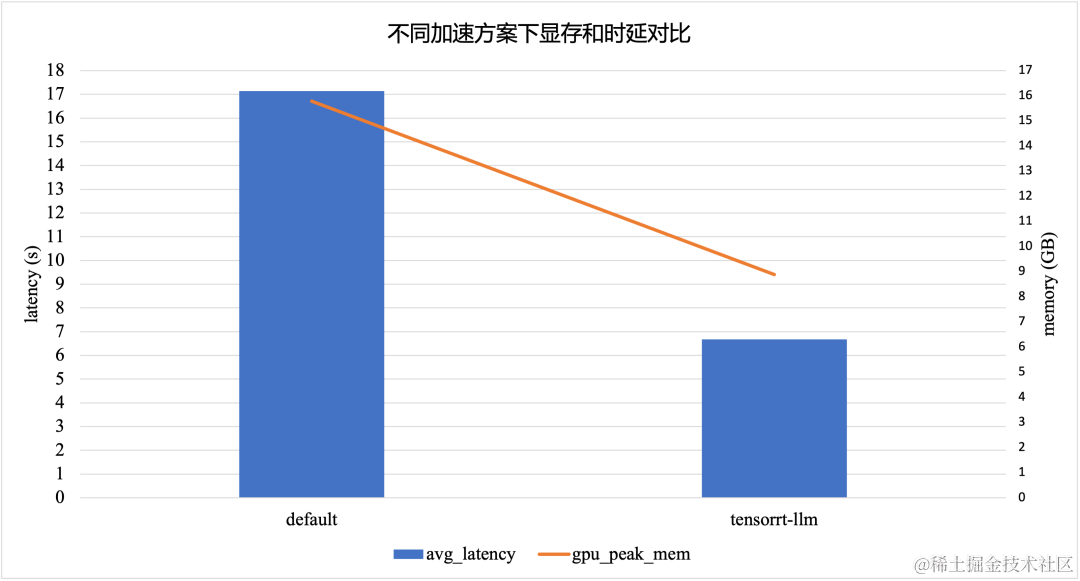

大语言模型推理提速:TensorRT-LLM 高性能推理实践

作者:顾静

TensorRT-LLM 如何提升 LLM 模型推理效率

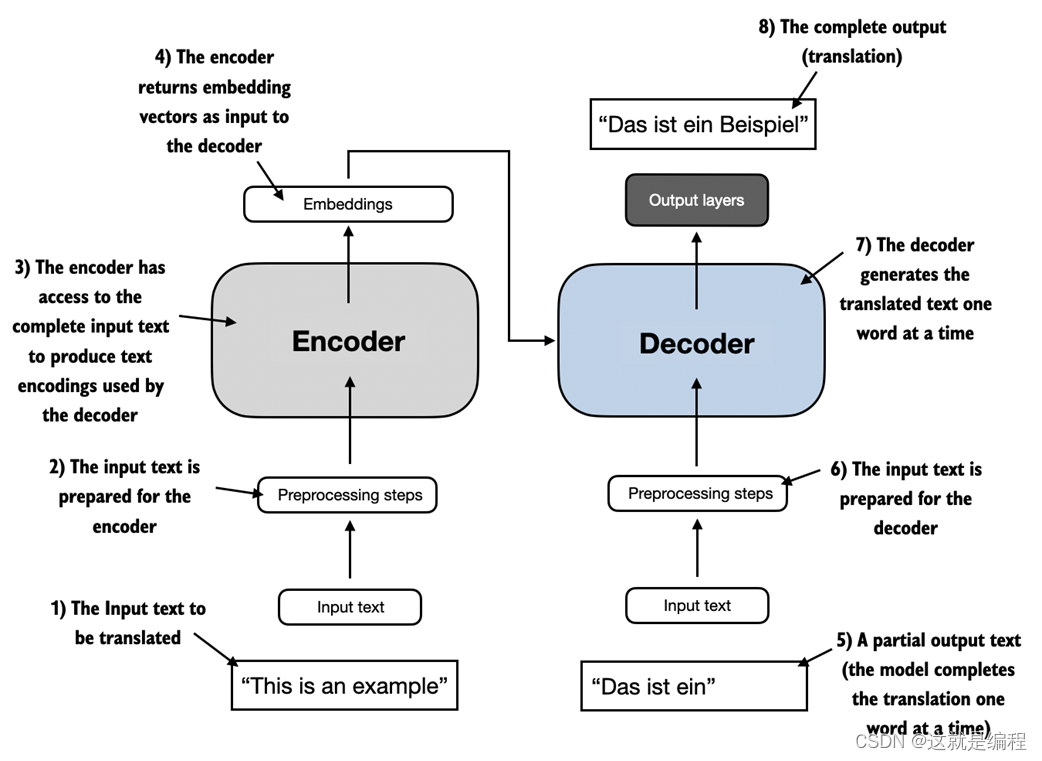

大型语言模型(Large language models,LLM)是基于大量数据进行预训练的超大型深度学习模型。底层转换器是一组神经网络,这些神经网络由具有 self-attention 的编码器和解码器组…

阿里正式加入ChatGPT战局,“通义千问”上线后表现如何?

ChatGPT发布后,数月间全世界都对AI的能力有了新的认知。 ChatGPT掀起的战局,现在又多了一位选手了! 阿里版类ChatGPT突然官宣正式对外开放企业邀测,由达摩院开发,名为“通义千问” 顾名思义,阿里正式加入Ch…

Talk预告 | 浙江大学乔硕斐:语言模型提示推理综述

本期为TechBeat人工智能社区第480期线上Talk!

北京时间3月9日(周四)20:00,浙江大学计算机科学与技术硕士——乔硕斐的Talk将准时在TechBeat人工智能社区开播!

他与大家分享的主题是: “语言模型提示推理综述 ”,届时将分享对语言…

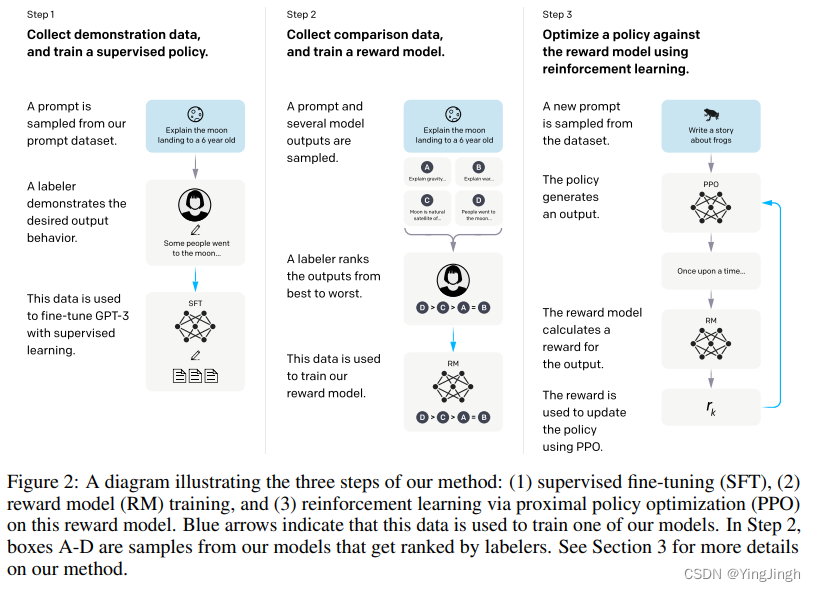

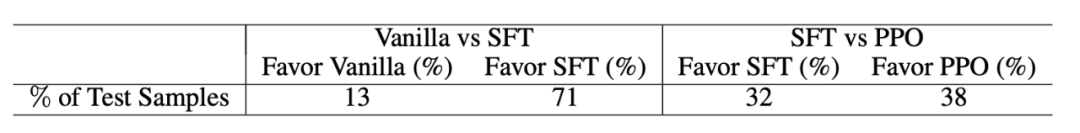

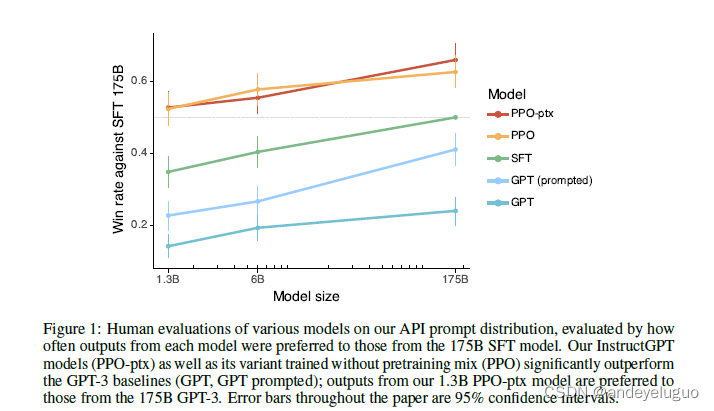

InstructGPT:Training language models to follow instrcutions with human feedback

InstructGPT:Training language models to follow instrcutions with human feedback 介绍模型数据集TaskHuman data collectionmodel 实验结果参考 介绍

现在LLM可以被prompt来完成一系列的下游任务,然而这些模型也总会产生一些用户不想要的结果&#…

Large Language Models and Knowledge Graphs: Opportunities and Challenges

本文是LLM系列的文章,针对《Large Language Models and Knowledge Graphs: Opportunities and Challenges》的翻译。 大语言模型和知识图谱:机会与挑战 摘要1 引言2 社区内的共同辩论点3 机会和愿景4 关键研究主题和相关挑战5 前景 摘要

大型语言模型&…

Scikit-LLM:将大语言模型整合进Sklearn的工作流

我们以前介绍过Pandas和ChaGPT整合,这样可以不了解Pandas的情况下对DataFrame进行操作。现在又有人开源了Scikit-LLM,它结合了强大的语言模型,如ChatGPT和scikit-learn。但这个并不是让我们自动化scikit-learn,而是将scikit-learn…

LLM、AGI、多模态AI 篇一:开源大语言模型简记

文章目录 系列开源大模型LlamaChinese-LLaMA-AlpacaLlama2-ChineseLinlyYaYiChatGLMtransformersGPT-3(未完全开源)BERTT5QwenBELLEMossBaichuan

Excel变天!微软把Python「塞」进去了,直接可搞机器学习

量子位 | 公众号 QbitAI

喜大普奔!

微软把Python弄进Excel了!

搭建一个机器学习天气预测模型,在Excel里即可实现。 而且无需任何设置,在单元格里输入“PY”,就能开搞。 数据清理、预测分析、可视化等等任务…

Large Graph Models: A Perspective

本文是LLM系列文章,针对《Large Graph Models: A Perspective》的翻译。 TOC

摘要

大型模型已成为人工智能,尤其是机器学习领域的最新突破性成就。然而,当涉及到图形时,大型模型并没有像在自然语言处理和计算机视觉等其他领域那…

基于大语言模型知识问答应用落地实践 – 知识库构建(上)

01 背景介绍 随着大语言模型效果明显提升,其相关的应用不断涌现呈现出越来越火爆的趋势。其中一种比较被广泛关注的技术路线是大语言模型(LLM)知识召回(Knowledge Retrieval)的方式,在私域知识问答方面可以…

LLMs之dataset:大语言模型LLMs相关开源数据集的简介、下载、使用方法之详细攻略

LLMs之dataset:大语言模型LLMs相关开源数据集的简介、下载、使用方法之详细攻略 目录

LLMs相关开源数据集的简介

1、SFT→RM+PPO三阶段关系梳理、数据集格式对比

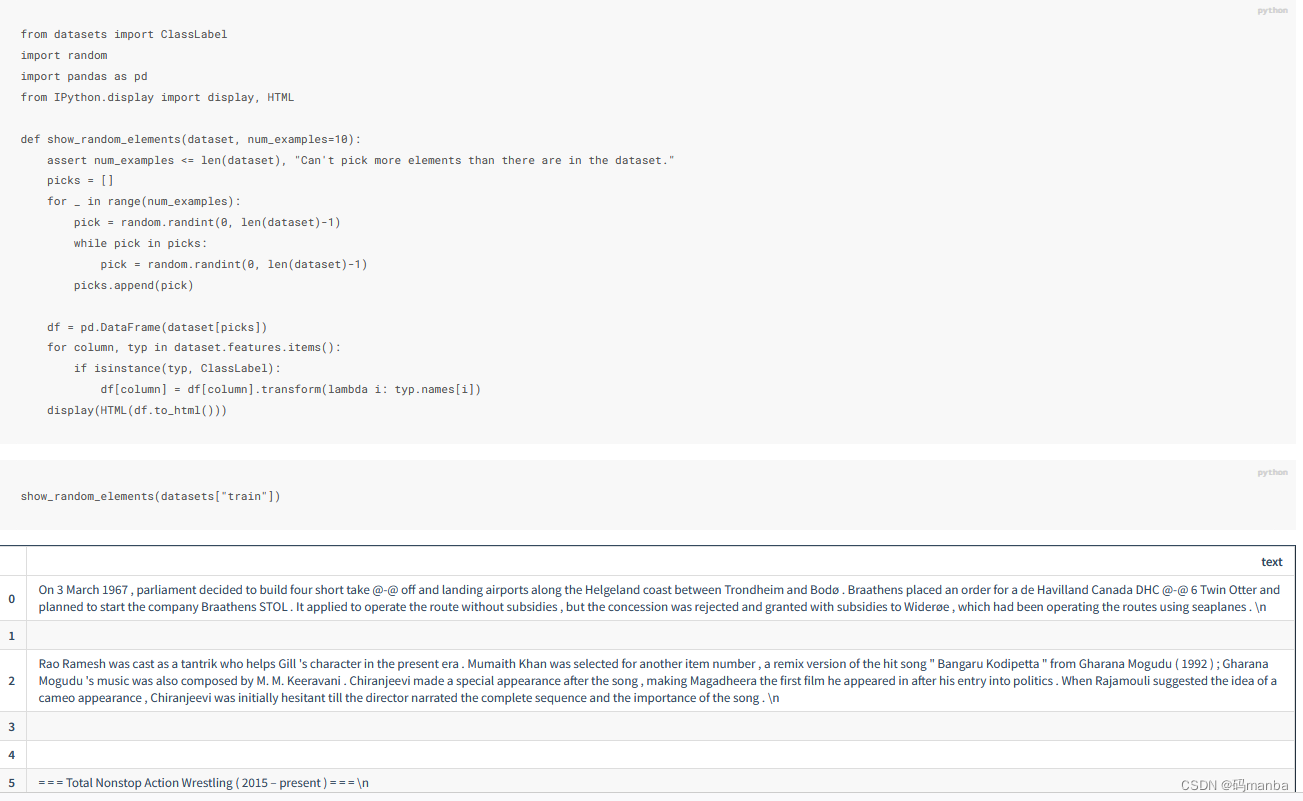

几个nlp的小任务(生成式任务——语言模型(CLM与MLM))

@TOC

本章节需要用到的类库 微调任意Transformers模型(CLM因果语言模型、MLM遮蔽语言模型)

CLM MLM 准备数据集 展示几个数据的结构

周鸿祎为360智脑招贤纳士;LLM时代的选择指南;Kaggle大语言模型实战;一文带你逛遍LLM全世界 | ShowMeAI日报

👀日报&周刊合集 | 🎡生产力工具与行业应用大全 | 🧡 点赞关注评论拜托啦! 🤖 思否「齐聚码力」黑客马拉松,用技术代码让生活变得更美好 主页:https://pages.segmentfault.com/google-hacka…

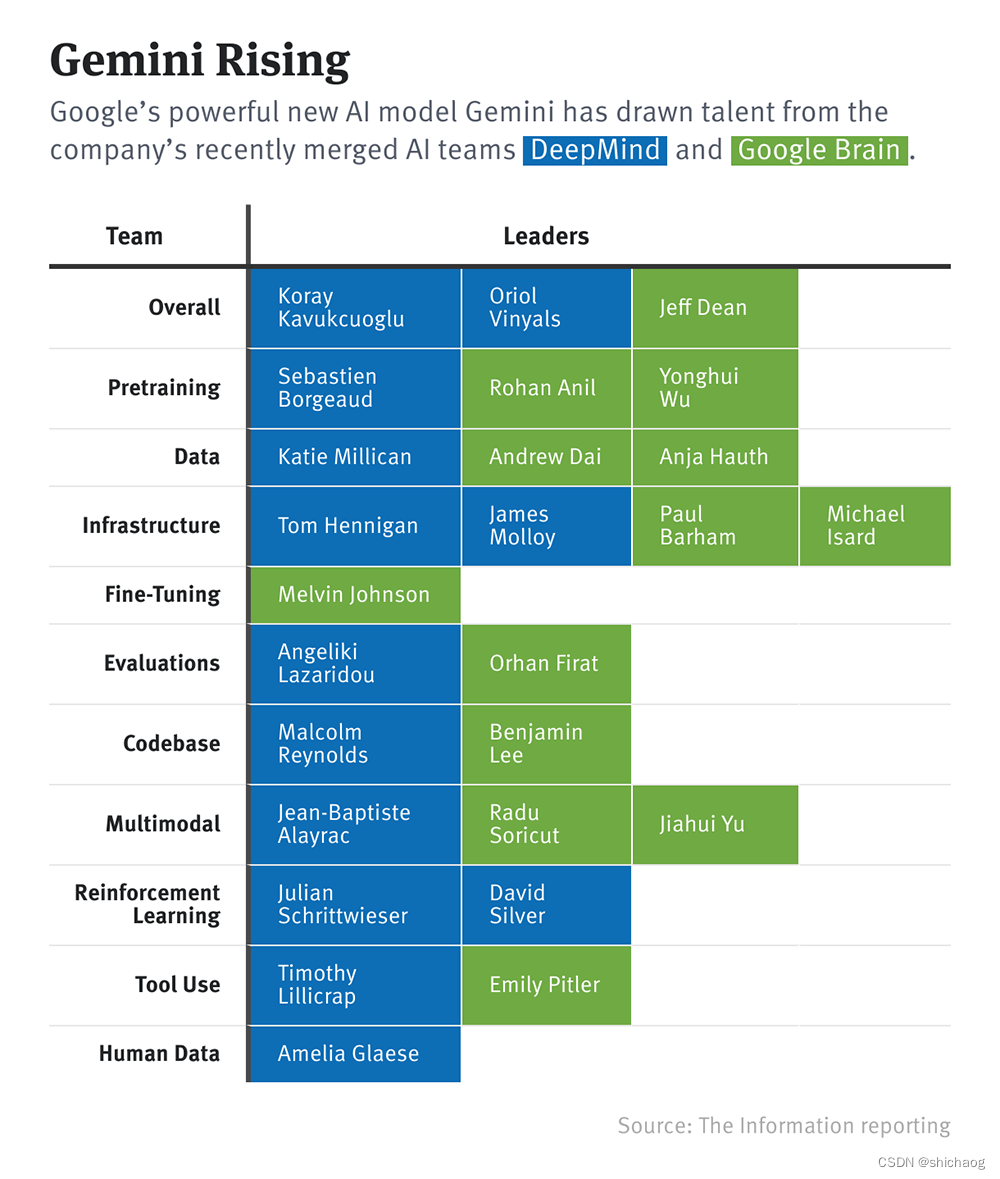

谷歌发布Gemini以5倍速击败GPT-4

在Covid疫情爆发之前,谷歌发布了MEENA模型,短时间内成为世界上最好的大型语言模型。谷歌发布的博客和论文非常可爱,因为它特别与OpenAI进行了比较。

相比于现有的最先进生成模型OpenAI GPT-2,MEENA的模型容量增加了1.7倍…

LM-INFINITE: SIMPLE ON-THE-FLY LENGTH GENERALIZATION FOR LARGE LANGUAGE MODELS

本文是LLM系列文章,针对《LM-INFINITE: SIMPLE ON-THE-FLY LENGTH GENERALIZATION FOR LARGE LANGUAGE MODELS》的翻译。 LM-INFiNITE:大语言模型的一个简单长度上推广 摘要1 引言2 相关工作3 LLMs中OOD因素的诊断4 LM-INFINITE5 评估6 结论和未来工作 …

Holistic Evaluation of Language Models

本文是LLM系列文章,针对《Holistic Evaluation of Language Models》的翻译。 语言模型的整体评价 摘要1 引言2 前言3 核心场景4 一般指标5 有针对性的评估6 模型7 通过提示进行调整8 实验和结果9 相关工作和讨论10 缺失11 不足和未来工作12 结论 摘要

语言模型&a…

CCKS2023:基于企业数仓和大语言模型构建面向场景的智能应用

8月24日-27日,第十七届全国知识图谱与语义计算大会(CCKS 2023)在沈阳召开。大会以“知识图谱赋能通用AI”为主题,探讨知识图谱对通用AI技术的支撑能力,探索知识图谱在跨平台、跨领域等AI任务中的作用和应用途径。

作为…

很全面的提示工程指南(包含大量示例!)

提示工程指南提示工程介绍基础提示配置参数的含义标准提示语提示语的要素提示设计的一般技巧从简单的提示开始指令(Instruction)具体(Specificity)避免不精确的描述(Preciseness)避免说不要做什么基础提示文…

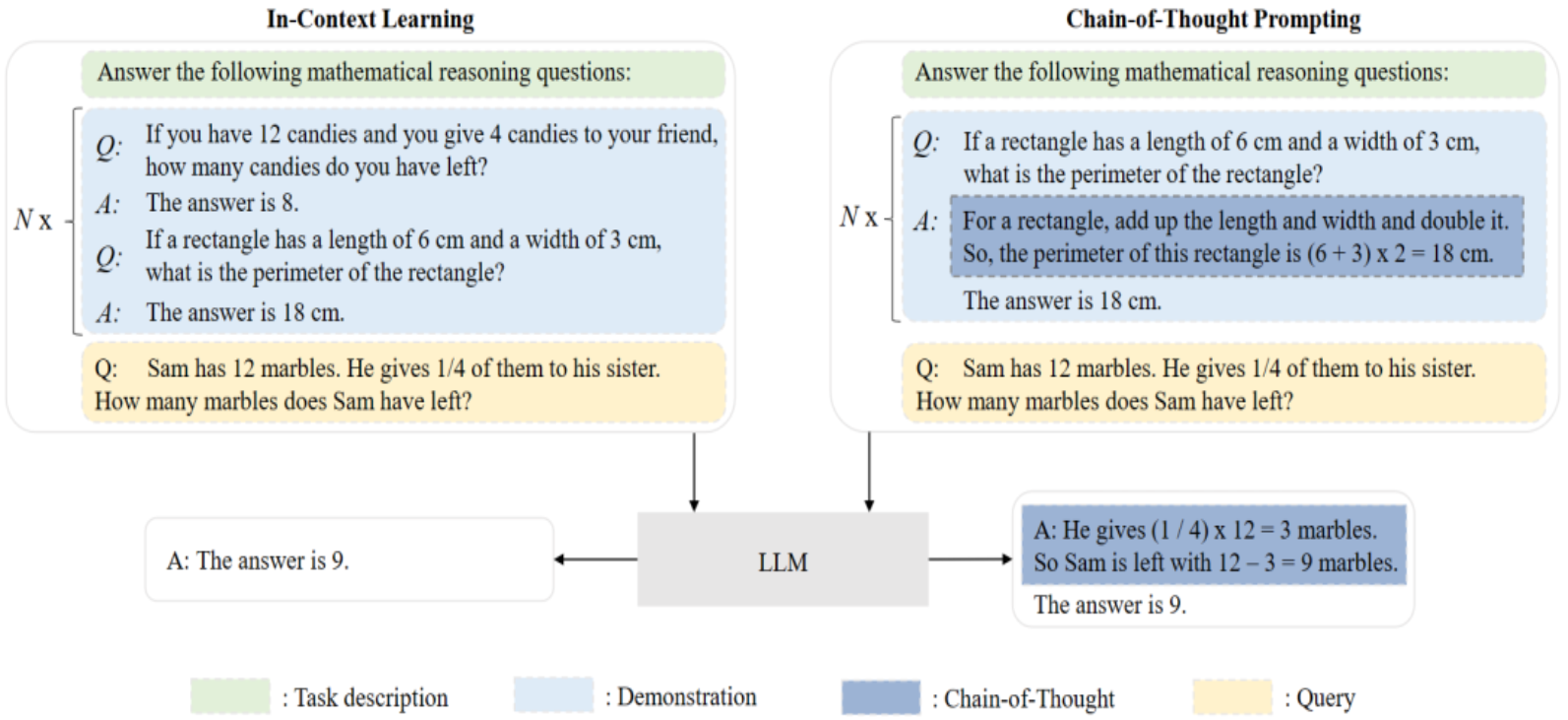

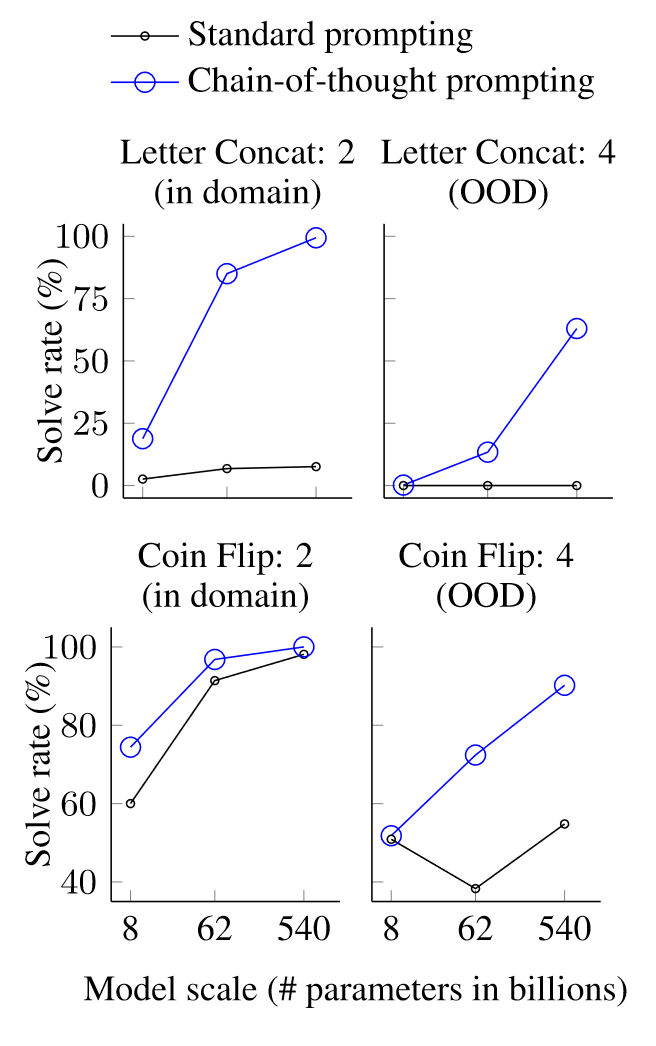

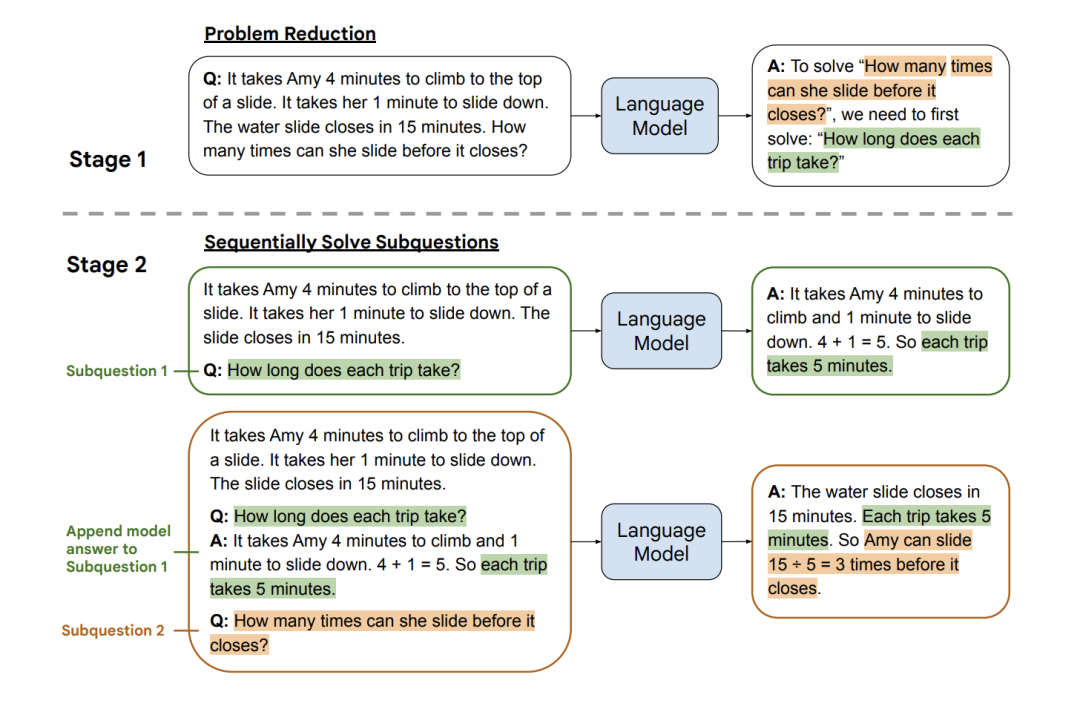

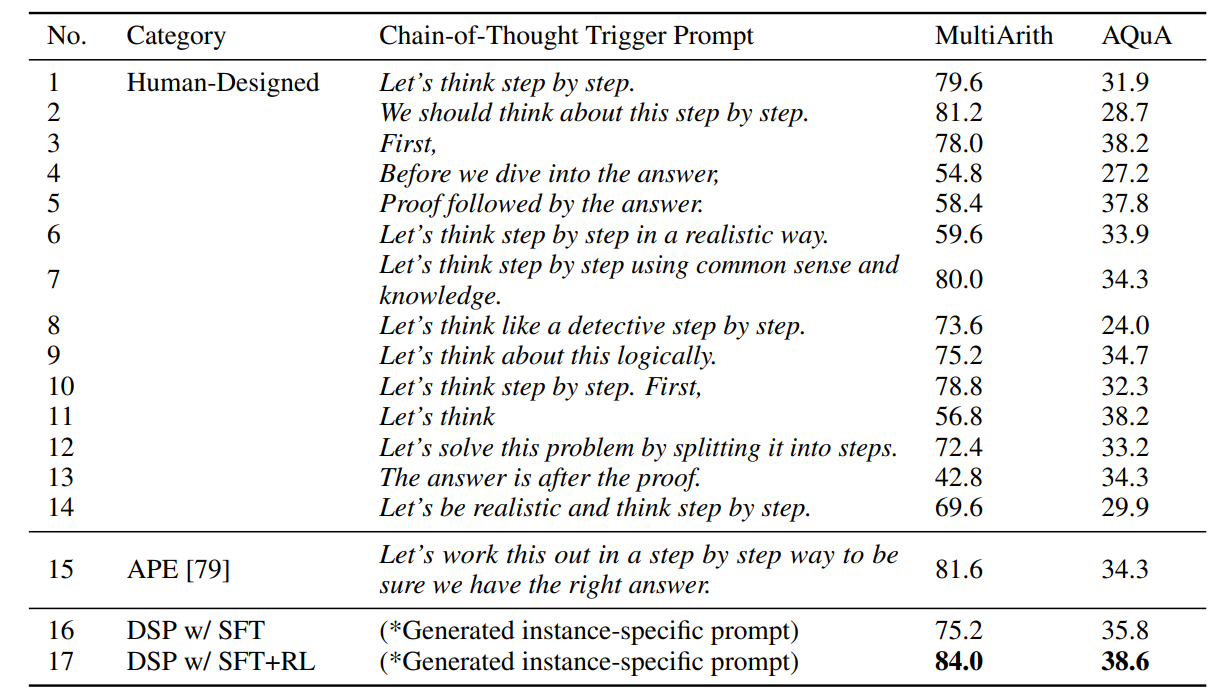

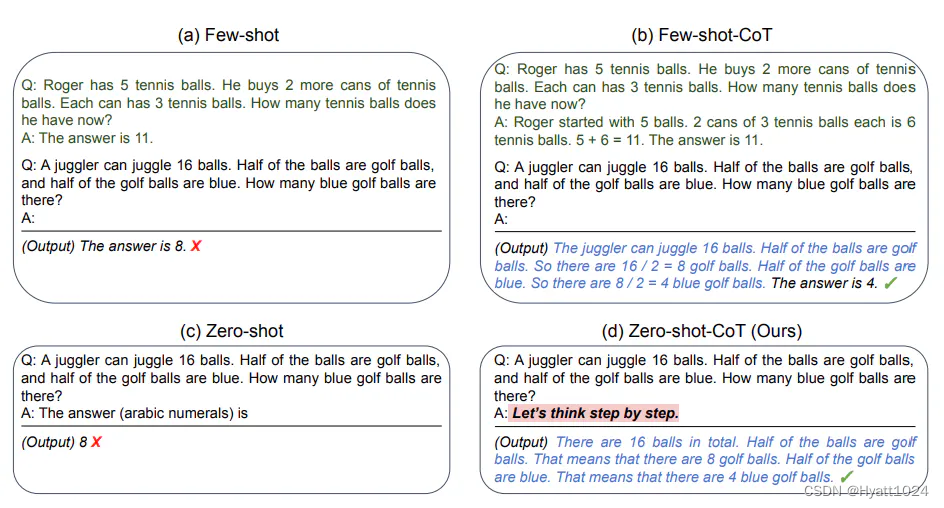

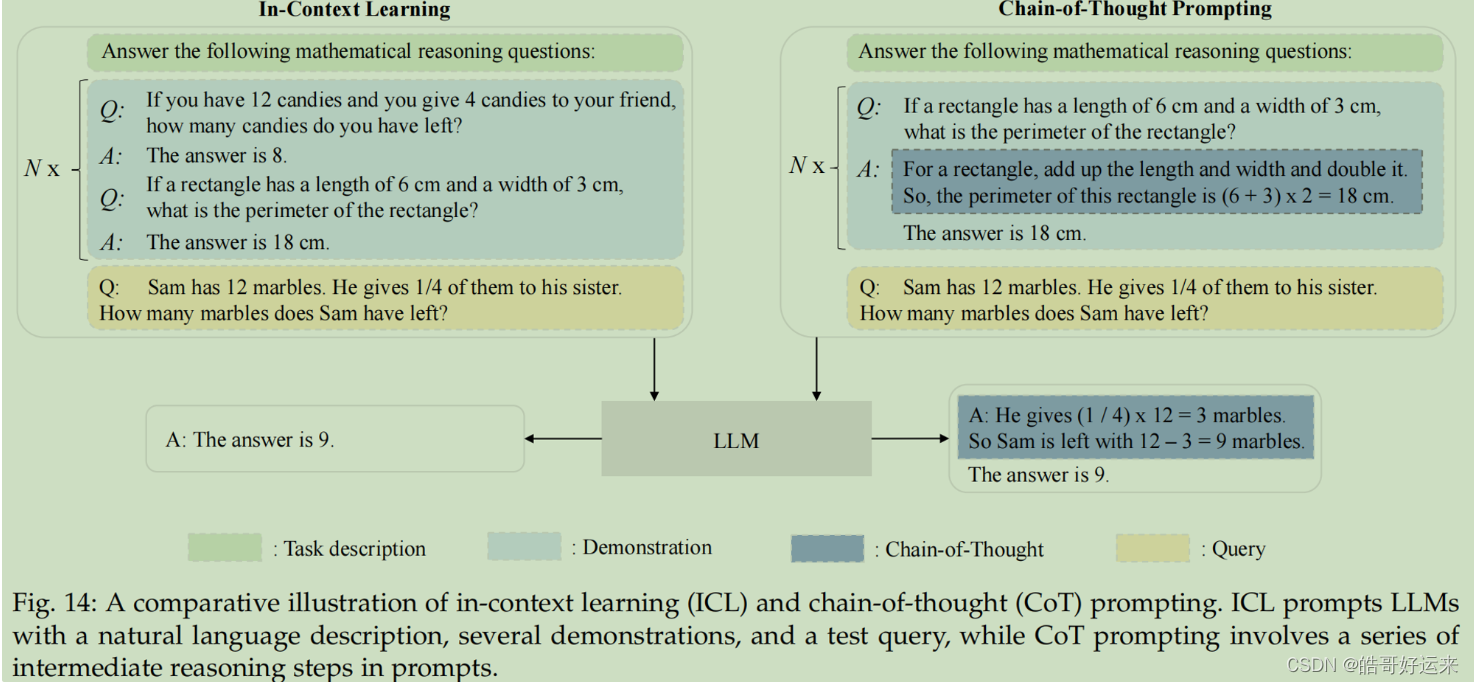

论文阅读:chain of thought Prompting elicits reasoning in large language models

论文阅读:chain of thought Prompting elicits reasoning in large language models

跟着沐神读论文 视频链接:https://www.bilibili.com/video/BV1t8411e7Ug/?spm_id_from333.788&vd_source350cece3ec9a0c2aee50da8ccc315bf4

title:chain of tho…

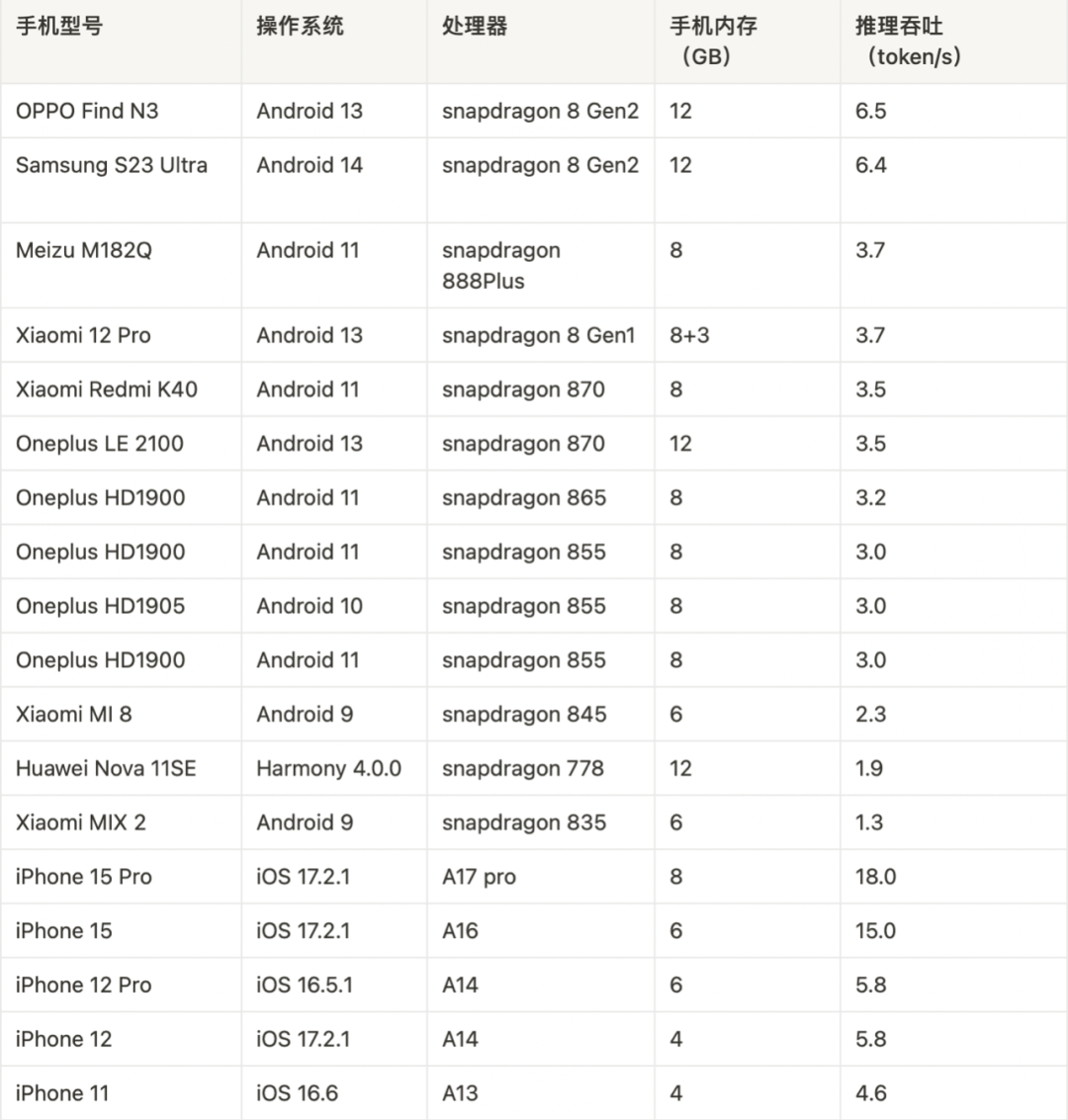

ChatGLM 大模型量化的基本原理

1.模型为啥需要量化? 我们都知道越宽越深的模型比越窄越浅的模型精度高,效果好;但是越来越多的模型需要再边缘设备上部署,云部署还能满足计算要求,边缘设备上的算力有限.因此我们不得不考虑存储空间,设别内存,设备运行功耗以及延时性等问题,特别是在消费级pc上和移动终端上部署…

【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型

Chinchilla:训练计算利用率最优的大语言模型《Training Compute-Optimal Large Language Models》论文地址:https://arxiv.org/pdf/2203.15556.pdf 相关博客 【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型 【自然语言…

Multitask Vision-Language Prompt Tuning

本文是LLM系列文章,针对《Multitask Vision-Language Prompt Tuning》的翻译。 多任务视觉语言提示调整 摘要1 引言2 相关工作3 方法4 实验5 讨论6 结论 摘要

提示调整以任务特定的学习提示向量为条件,已成为一种数据高效和参数高效的方法,…

包含文心一言在内的首批国产大模型 全面开放

8月31起,国内 11 家通过《生成式人工智能服务管理暂行办法》备案的 AI 大模型产品将陆续上线,面向全社会开放。北京 5 家大模型产品分别是百度的 “文心一言”、抖音的 “云雀”、百川智能的 “百川大模型”、清华系 AI 公司智谱华章旗下的 “智谱清言”…

AskIt: Unified Programming Interface for Programming with Large Language Models

本文是LLM系列文章,针对《AskIt: Unified Programming Interface for Programming with Large Language Models》的翻译。 AskIt:用于大型语言模型编程的统一编程接口 摘要1 引言2 动机例子3 设计与实现4 实验评估5 相关工作6 结论 摘要

在不断发展的软…

论文浅尝 | 训练语言模型遵循人类反馈的指令

笔记整理:吴亦珂,东南大学硕士,研究方向为大语言模型、知识图谱 链接:https://arxiv.org/abs/2203.02155 1. 动机 大型语言模型(large language model, LLM)可以根据提示完成各种自然语言处理任务。然而&am…

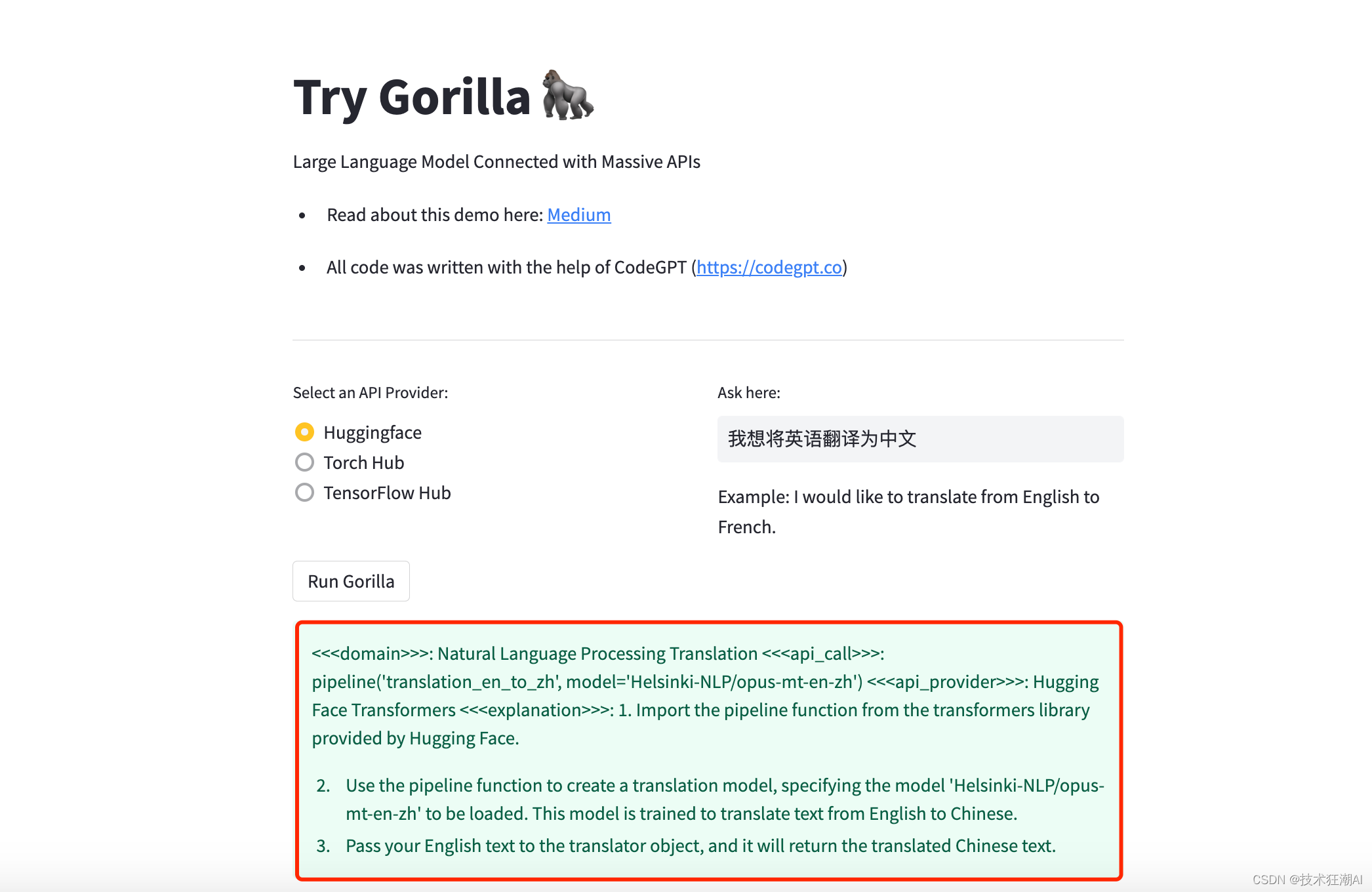

TOOLLLM: FACILITATING LARGE LANGUAGE MODELS TO MASTER 16000+ REAL-WORLD APIS

本文是LLM系列的文章之一,针对《TOOLLLM: FACILITATING LARGE LANGUAGE MODELS TO MASTER 16000 REAL-WORLD APIS》的翻译。 TOOLLLMs:让大模型掌握16000的真实世界APIs 摘要1 引言2 数据集构建3 实验4 相关工作5 结论 摘要

尽管开源大型语言模型&…

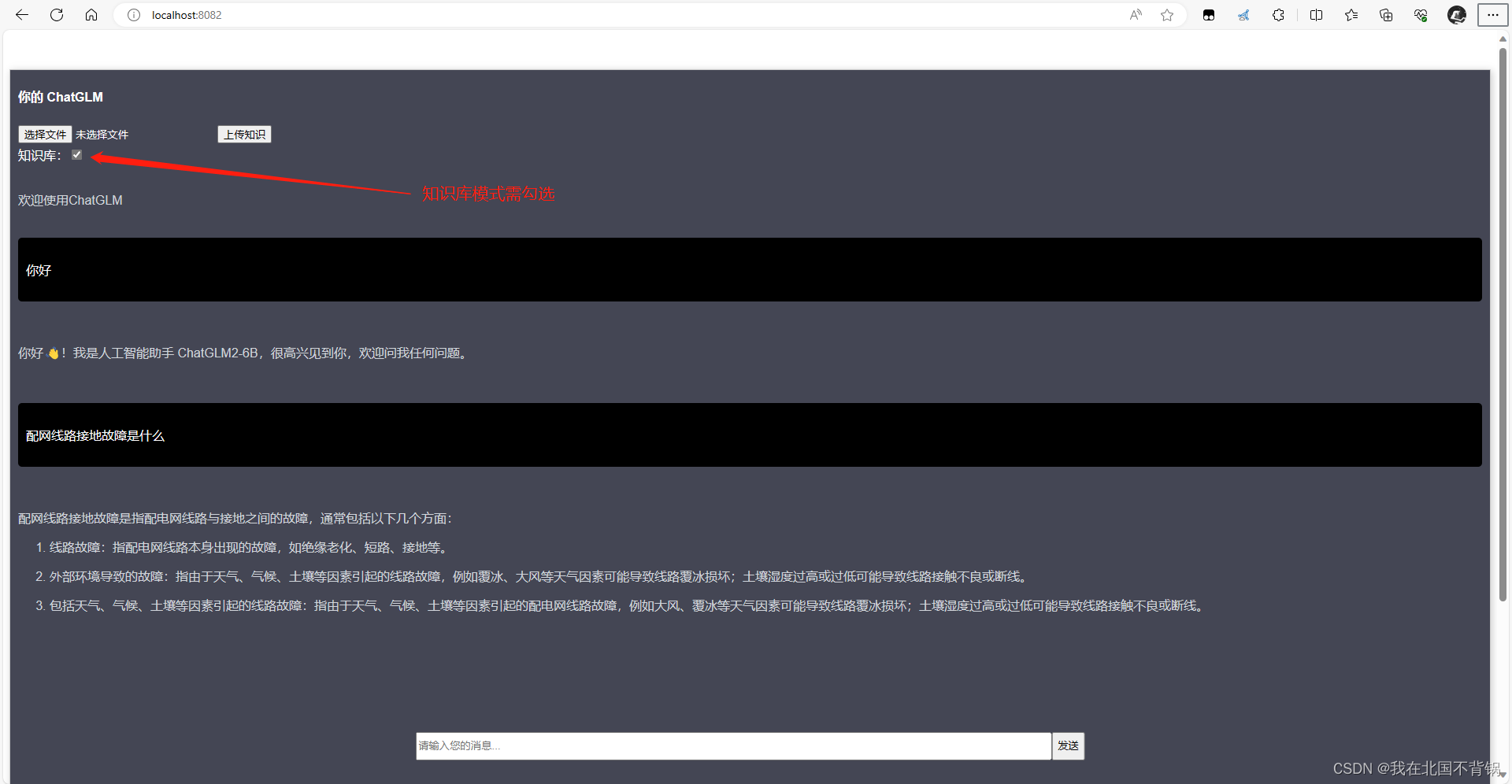

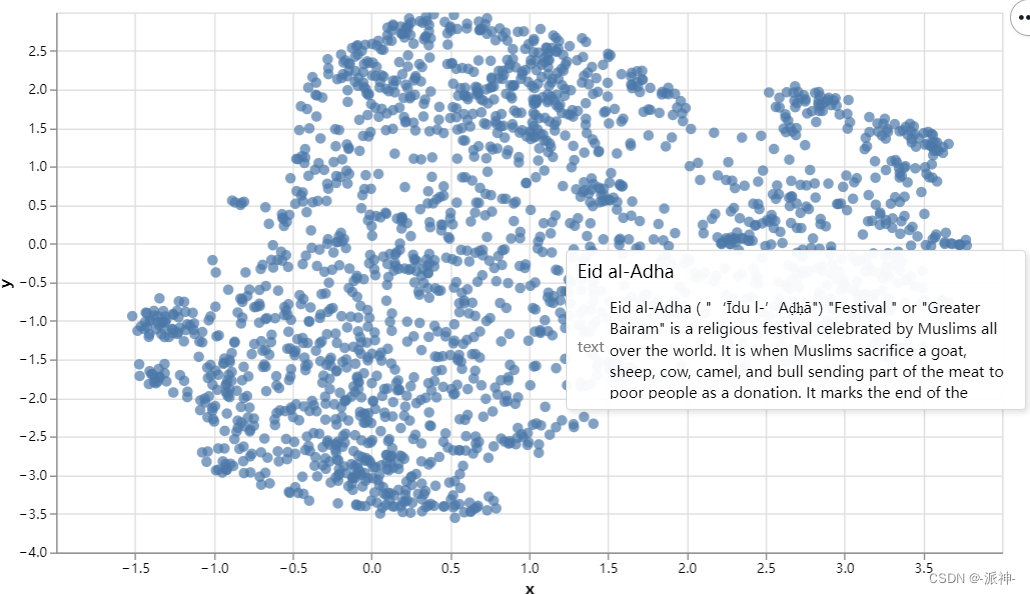

M3EChatGLM向量化构建本地知识库

M3E&ChatGLM向量化构建本地知识库 整体步骤向量数据库向量数据库简介主流数据库Milvus部署 文本向量化M3E介绍模型对比M3E使用向量数据存储 基于本地知识库的问答问句向量化向量搜索请求ChatGLM问答测试 整体步骤

向量化:首先,你需要将语言模型的数…

LLAMA2(Meta大语言模型)可运行整合包的下载与安装

LLAMA2(Meta大语言模型)可运行整合包的下载与安装

Windows10+消费级显卡可用

一、工程

github工程:

https://github.com/facebookresearch/llama

LLAMA2可运行整合包(Windows10+消费级显卡可用)

*现在只包括7B模型,会补充其他模型

文件夹下载

百度网盘链接:http…

【OSCAR开源产业大会分论坛】开源大模型走向何方?

再过俩月,ChatGPT 即将迎来推出一周年纪念日。作为开历史先河的 AI 大模型,ChatGPT 像一针猛戳进千行百业中枢神经的兴奋剂,在全球掀起空前绝后的 AI 军备竞赛热潮。 近一年来,我们看到 GPT-3.5 完成向多模态的 GPT-4 进化&#x…

ChatGPT架构师:语言大模型的多模态能力、幻觉与研究经验

来源 | The Robot Brains Podcast OneFlow编译 翻译|宛子琳、杨婷 9月26日,OpenAI宣布ChatGPT新增了图片识别和语音能力,使得ChatGPT不仅可以进行文字交流,还可以给它展示图片并进行互动,这是一次ChatGPT向多模态进化的…

吴恩达gradio课程:基于开源LLM(large language model)的聊天应用

文章目录 内容简介构建应用程序使用gradio在线体验接下来结合llm模型使用gradio构建一个完整的应用程序内容简介 Falcon 40B是当前最好的开源语言模型之一。使用text-generation库调用Falcon 40B的问答API接口。首先仅仅在代码中与模型聊天,后续通过Gradio构建聊天界面。Gradio…

IDEFICS 简介: 最先进视觉语言模型的开源复现

我们很高兴发布 IDEFICS ( Image-aware Decoder Enhanced la Flamingo with Ininterleaved Cross-attention S ) 这一开放视觉语言模型。IDEFICS 基于 Flamingo,Flamingo 作为最先进的视觉语言模型,最初由 DeepMind 开发,但目前尚未公开发布…

大语言模型 GPT历史简介

得益于数据、模型结构以及并行算力的发展,大语言模型应用现今呈井喷式发展态势,大语言神经网络模型成为了不可忽视的一项技术。 GPT在自然语言处理NLP任务上取得了突破性的进展,扩散模型已经拥有了成为下一代图像生成模型的代表的潜力&#x…

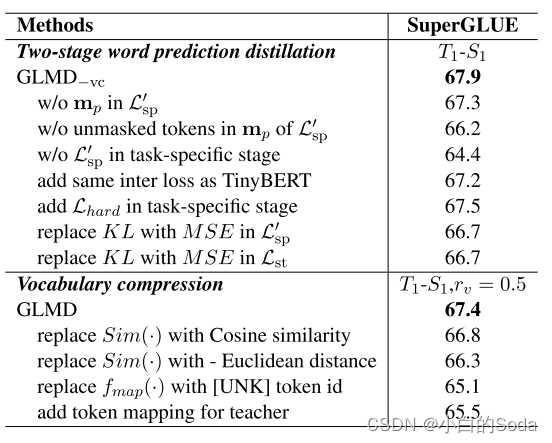

通用语言模型蒸馏-GLMD

文章目录 GLMD一、PPT内容论文背景P1 BackgroundP2 Approach 相关知识P3 知识蒸馏P4 语言建模词预测逻辑 方法P5 两阶段词汇预测蒸馏P6P7 词汇压缩 实验结果P8 results 二、论文泛读2.1 论文要解决什么问题?2.2 论文采用了什么方法?2.4 论文达到什么效果…

AI时代,程序员需要焦虑吗?

原文来自 微信公众号"互联网技术人进阶之路". 目录 前言一、程序员会被 AI 取代么?二、服务端开发尚难被 AI 取代三、服务端开发何去何从?四、业界首部体系化、全景式解读服务端开发的著作第一部分:服务端开发的技术和方法第二部分…

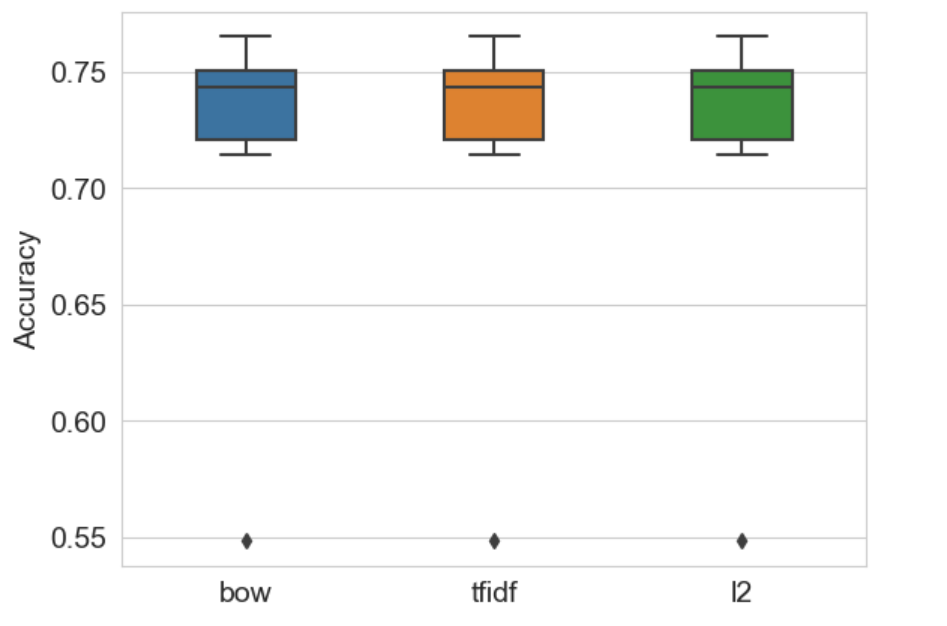

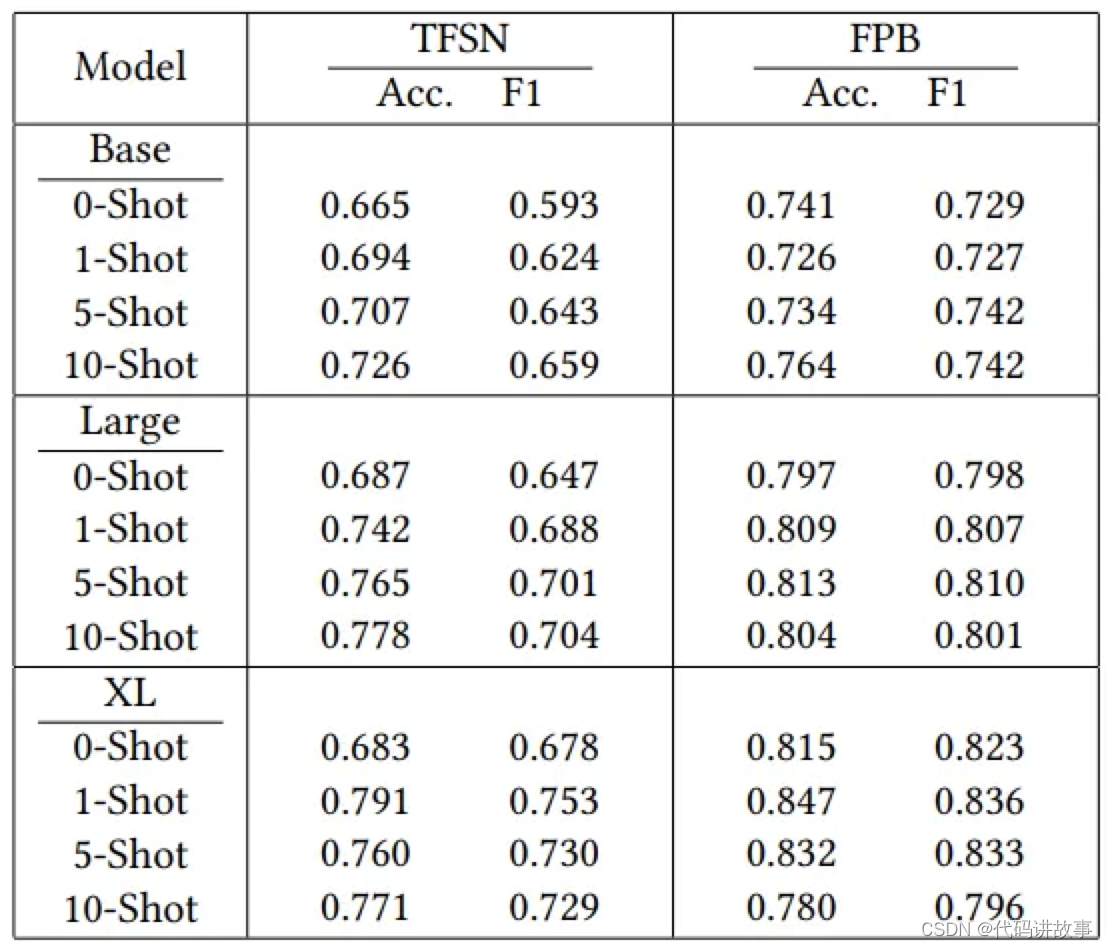

ChatGPT 使用 拓展资料:无需任何机器学习,如何利用大语言模型做情感分析?

ChatGPT 拓展资料:无需任何机器学习,如何利用大语言模型做情感分析? 目录 机器学习 :GloVe嵌入式向量基于文本数据的情感识别Data PreparationPreprocessing and CleaningLoad GloVe VectorML模型构建、训练和测试用于情感识别的支持向量机Fasttext 以及T5比较利用Embedd…

亲爱的小朋友,你好,今天我们聊一聊什么是ChatGPT?

亲爱的小朋友,你好!

今天我们要聊一聊的是我们的好朋友——ChatGPT,最近ChatGPT很火爆,你们可能已经在很多地方看到关于它的文章和视频了。

你可能会问,这个ChatGPT到底是什么东西呢?好像很厉害的样子&am…

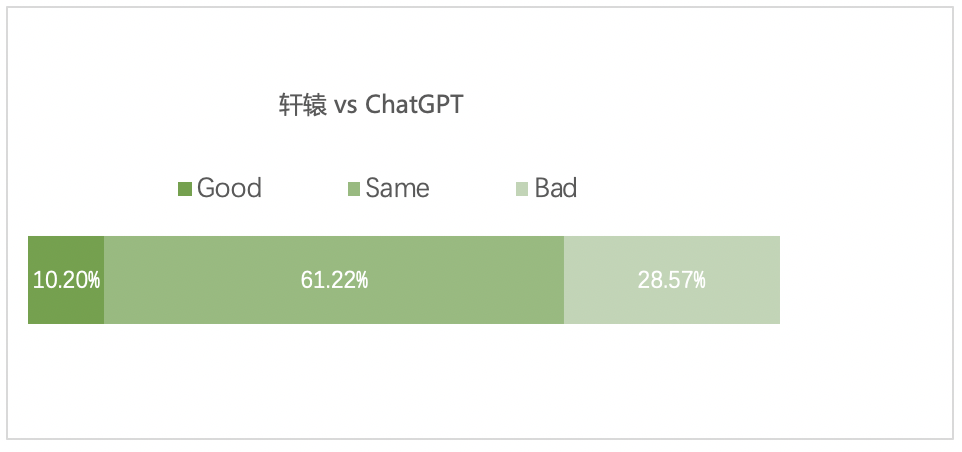

轩辕:首个千亿级中文金融对话模型

背景

目前开源的大语言模型或多或少存在以下痛点: 缺少专门针对中文进行优化过的的大语言模型。 支持中文的开源模型的参数规模偏小,没有超过千亿。比如清华和智谱AI的ChatGLM-6B目前只开源了6B参数模型,盘古alpha也只开源了13B的模型。 支…

大型语言模型作为属性化训练数据生成器

大型语言模型作为属性化训练数据生成器,提出一种使用多样化属性提示的数据生成方法,可以生成具有多样性和属性的训练数据,从而提高了模型的性能和数据生成的效率。

动机:大型语言模型(LLM)最近被用作各种自然语言处理(NLP)任务的…

ChatGPT技术解构

ChatGPT的训练主要分为三个步骤,如图所示: Step1:

使用有监督学习方式,基于GPT3.5微调训练一个初始模型;训练数据约为2w~3w量级(根据InstructGPT的训练数据量级估算,参照https://arxiv.org/pdf…

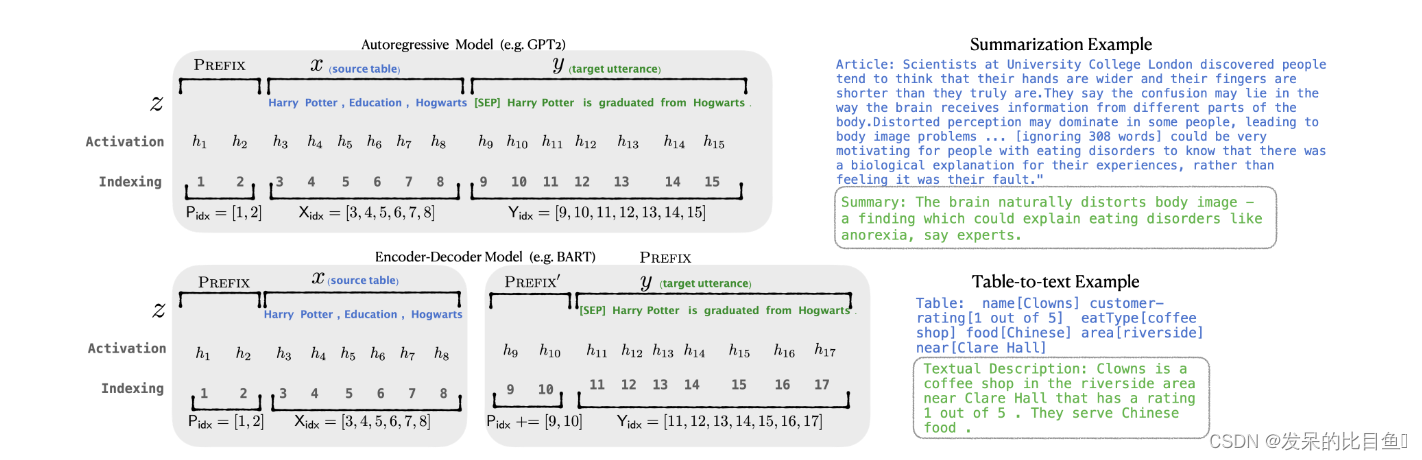

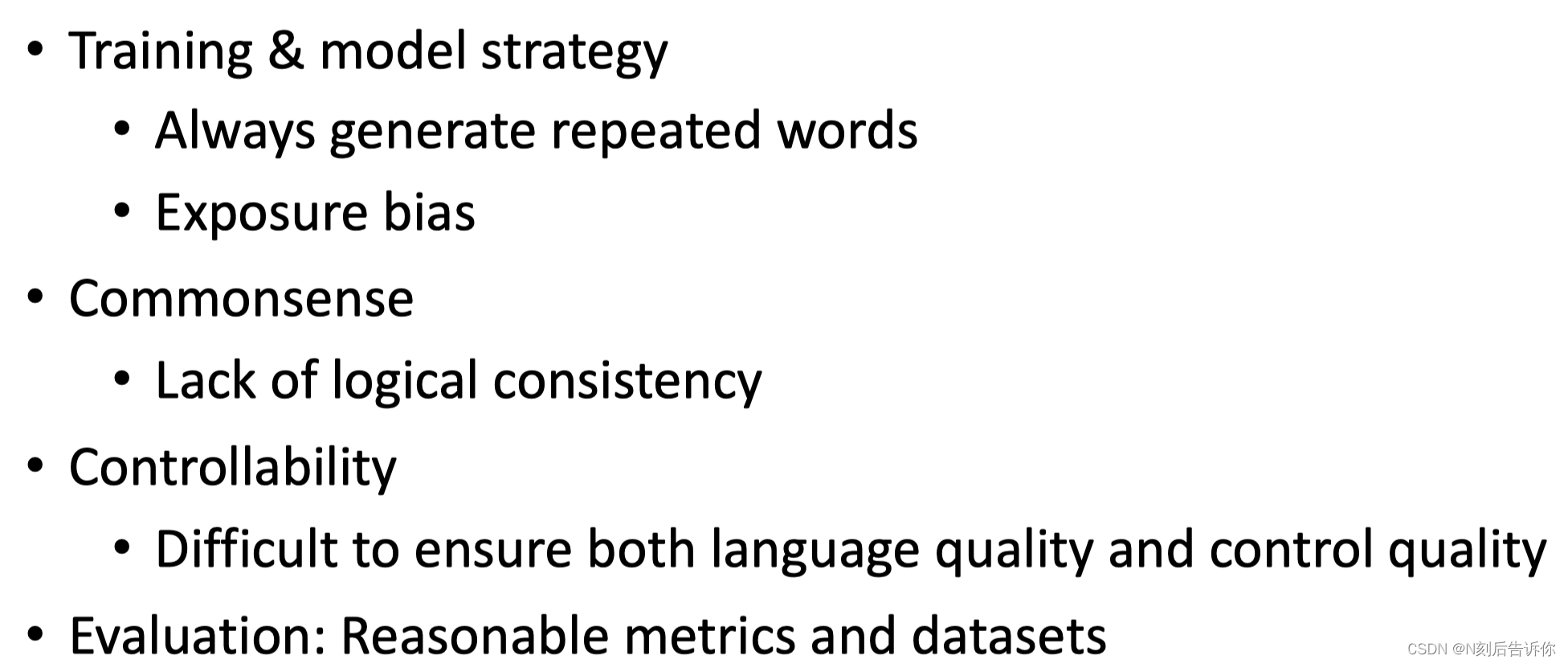

使用预训练语言模型进行文本生成的常用微调策略

译自Pretrained Language Models for Text Generation: A Survey 第六节

数据角度

小样本学习:在许多任务中,获取足够标记数据既困难又昂贵。预训练模型可以编码大量的语言和现实知识,这为数据稀缺提供了有效的解决方案。通常采用的方法是使…

GPT2计算流程详解

GPT-2 就像传统的语言模型一样,一次只输出一个单词(token)。这种模型之所以效果好是因为在每个新单词产生后,该单词就被添加在之前生成的单词序列后面,这个序列会成为模型下一步的新输入。这种机制叫做自回归ÿ…

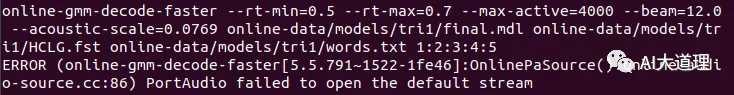

基于Kaldi的中文在线识别系统

三音子模型词错误率为:36.03%,对比单音素模型词错误率为50.58%。 可见三音素模型识别率已经有了提高。 不管模型识别率怎么样,先利用三音子模型搭建一个中文在线识别系统看看效果。 在线识别与离线识别

本文主要搭建在线语音识别࿰…

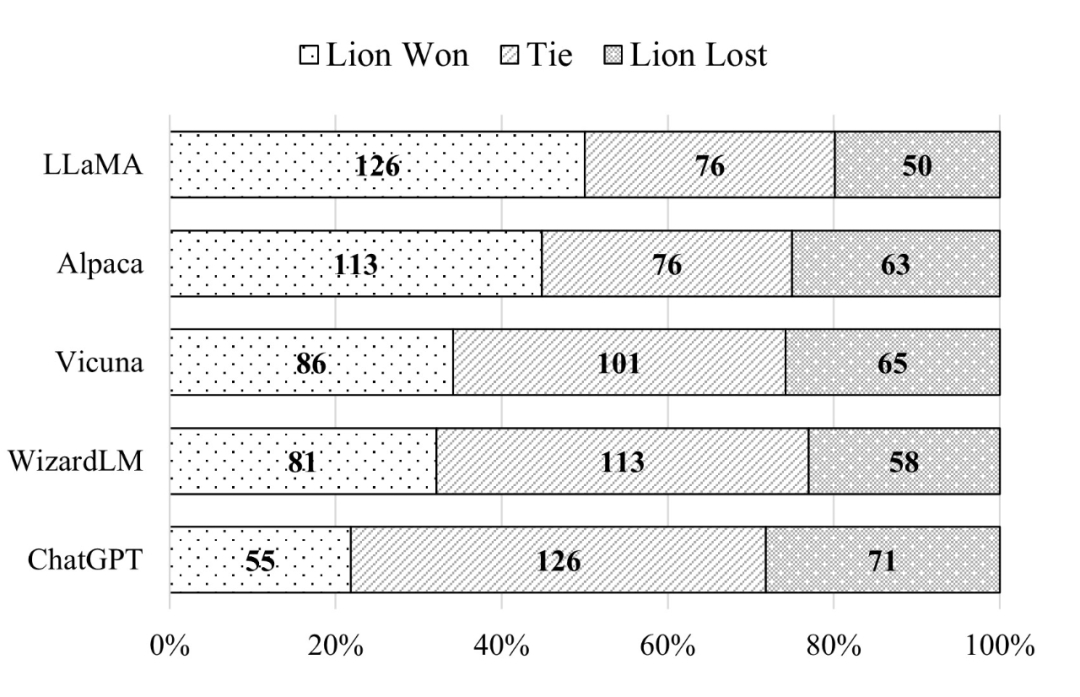

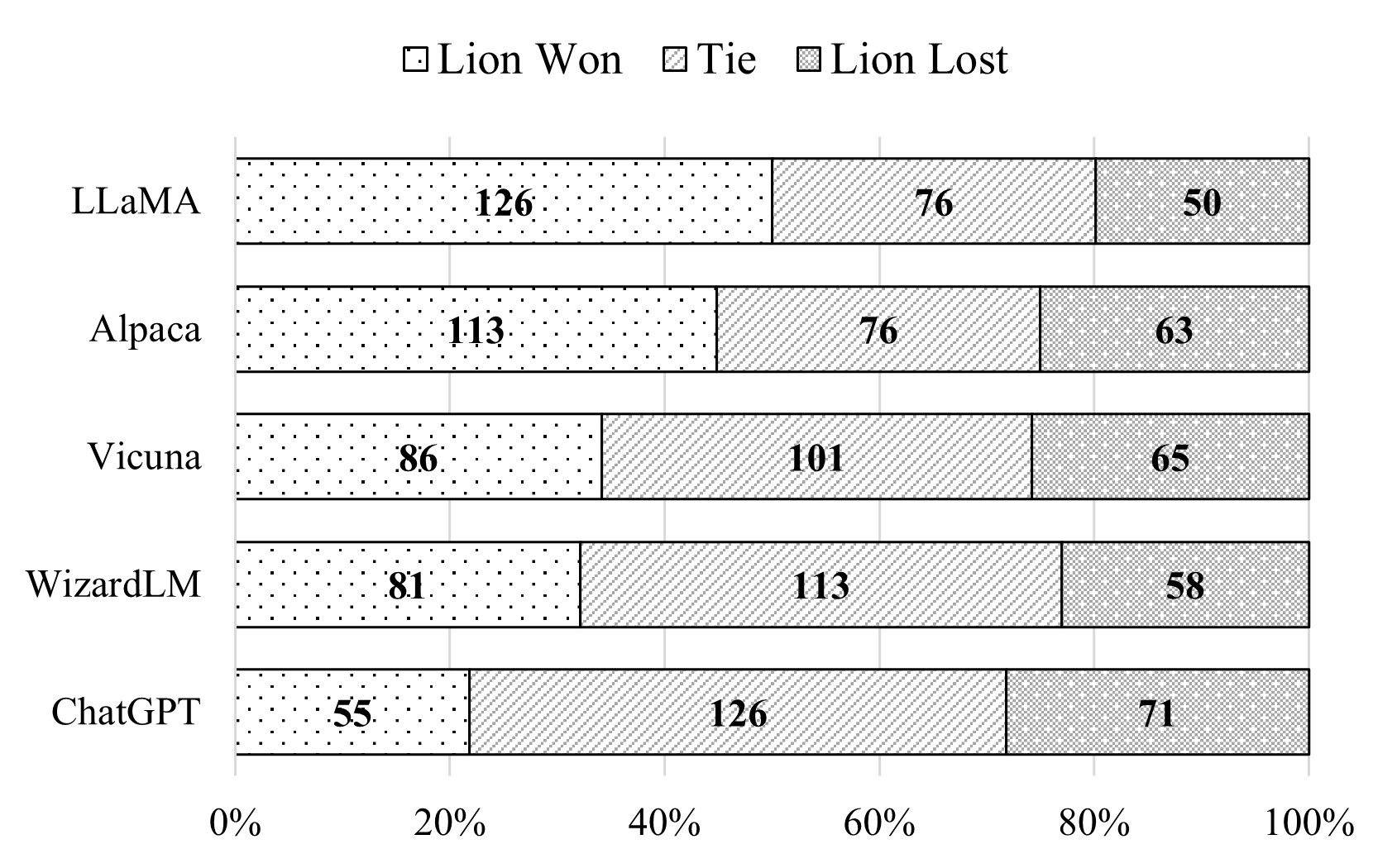

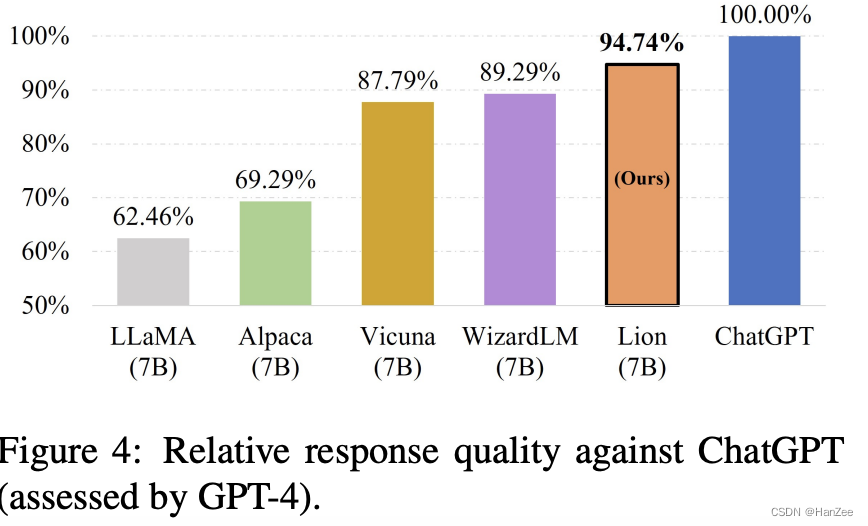

Lion闭源大语言模型的对抗蒸馏框架实践

Lion闭源大语言模型的对抗蒸馏框架实践

概述

对抗蒸馏框架概述:我们基于高级闭源LLM的基础上提炼一个学生LLM,该LLM具有三个角色:教师、裁判和生成器。有三个迭代阶段: 模仿阶段,对于一组指令,将学生的响…

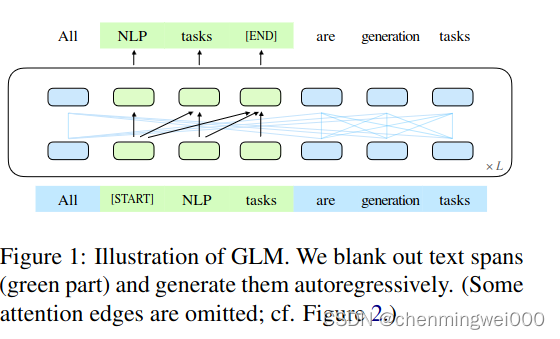

GLM: General Language Model Pretrainingwith Autoregressive Blank Infilling翻译理解

GPT(autoregressive)模型是一个自回归模型,利用left-to-right语言模型,由于不是双向attention 机制,因此不能再NLU任务中,获取充分的上下文信息,BERT类似自编码(autoencoding&#x…

清华开源LLM中英双语对话语言模型ChatGLM2,效果能赶超ChatGPT?

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数.ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,其第二代继承了第一代的优秀特点,并在第一代的基础上,更新了更多的新特性。 更强大的性能:

C…

ChatGPT基础知识系列之大型语言模型(LLM)初识

ChatGPT基础知识系列之大型语言模型(LLM)初识

ChatGPT本质是一个对话模型,它可以回答日常问题、挑战不正确的前提,甚至会拒绝不适当的请求,在去除偏见和安全性上不同于以往的语言模型。ChatGPT从闲聊、回答日常问题,到文本改写、诗歌小说生成、视频脚本生成,以及编写和调…

ChatGPT3 Transformer 的多模态全能语言模型

"Transformer 的多模态全能语言模型" 指的是一种融合了多种输入模态(如文本、图像、声音等)的语言模型,具有广泛的应用能力,可以理解和生成多种类型的信息。

"Transformer的多模态全能语言模型" 包含了多个…

AI大语言模型时代构建全新数据平台

在大语言模型的引领下,数据平台领军企业 Databricks 和 Snowflake 的未来重置,探讨了 Databricks 和 Snowflake 等知名平台,

存储领域的 Delta、udi、Iceberg,还是实时化数据处理领域的 Databricks、Snowflake 1、LLM 给大数据企…

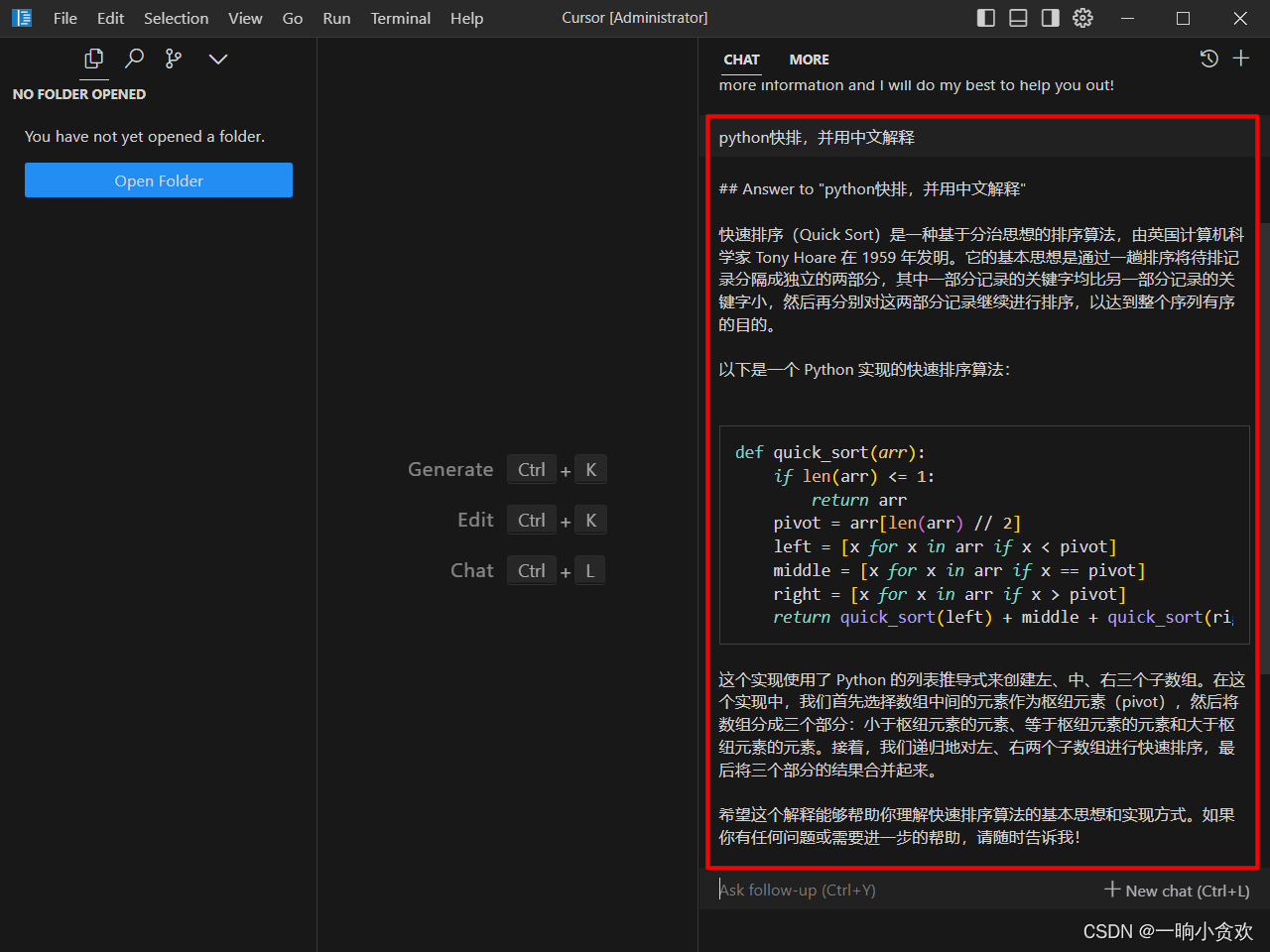

Cursor--一款强大的国内智能AI语言模型(据说对接了chatgpt4)

简介

Cursor是一个集成了 GPT-4 的国内直接可以访问的,优秀而强大的免费代码生成器,可以帮助你快速编写、编辑和讨论代码。 它支持多种编程语言,如 Python, Java, C#, JavaScript 等,并且可以根据你的输入和需求自动生成代码片段…

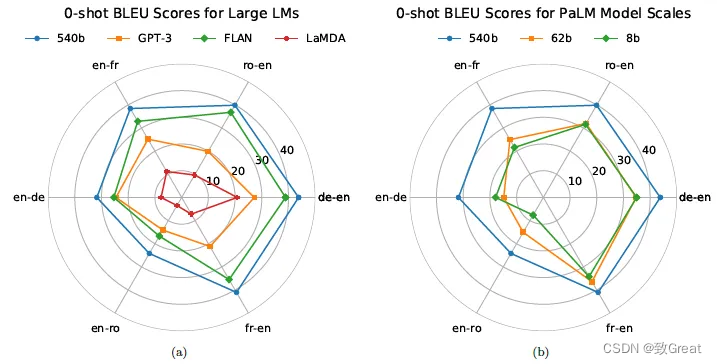

谷歌推出下一代大型语言模型 PaLM 2

谷歌在 2023 年度 I/O 大会上宣布推出了其下一代大型语言模型 PaLM 2,擅长高级推理任务,包括代码和数学、分类和问答、翻译和多语言能力以及自然语言生成。

谷歌声称 PaLM 2 是一种最先进的语言模型,要优于其之前所有的 LLM,包括…

案例告诉你 ChatGPT 最有可能取代哪些职业

ChatGPT 的应用场景ChatGPT 最可能取代哪些职业?写在最后 ChatGPT 的应用场景

ChatGPT 的应用场景大体上可以归类为三大模块。

第一类是 代码相关 的任务场景。包含程序语言之间的相互转换(如 python 转 java)、程序命令的生成、代码 bug 的…

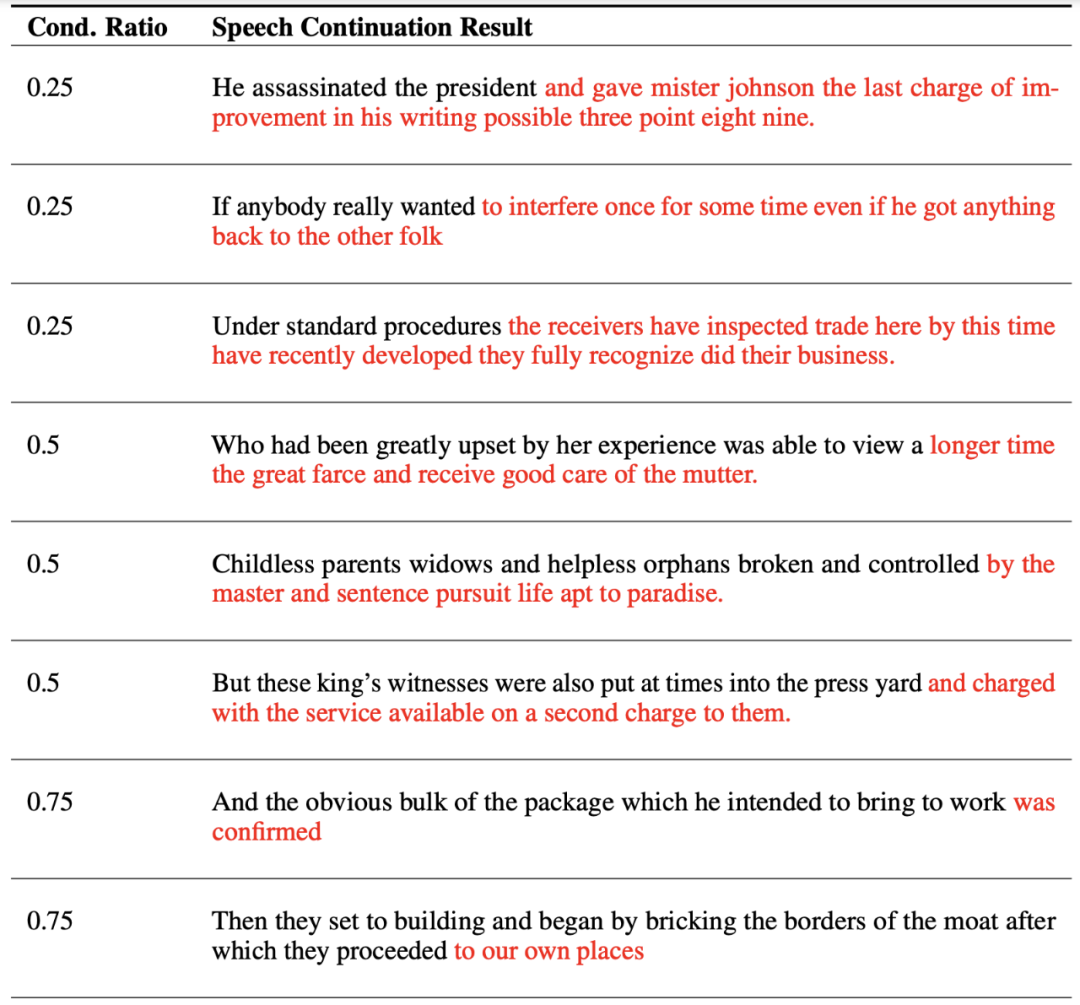

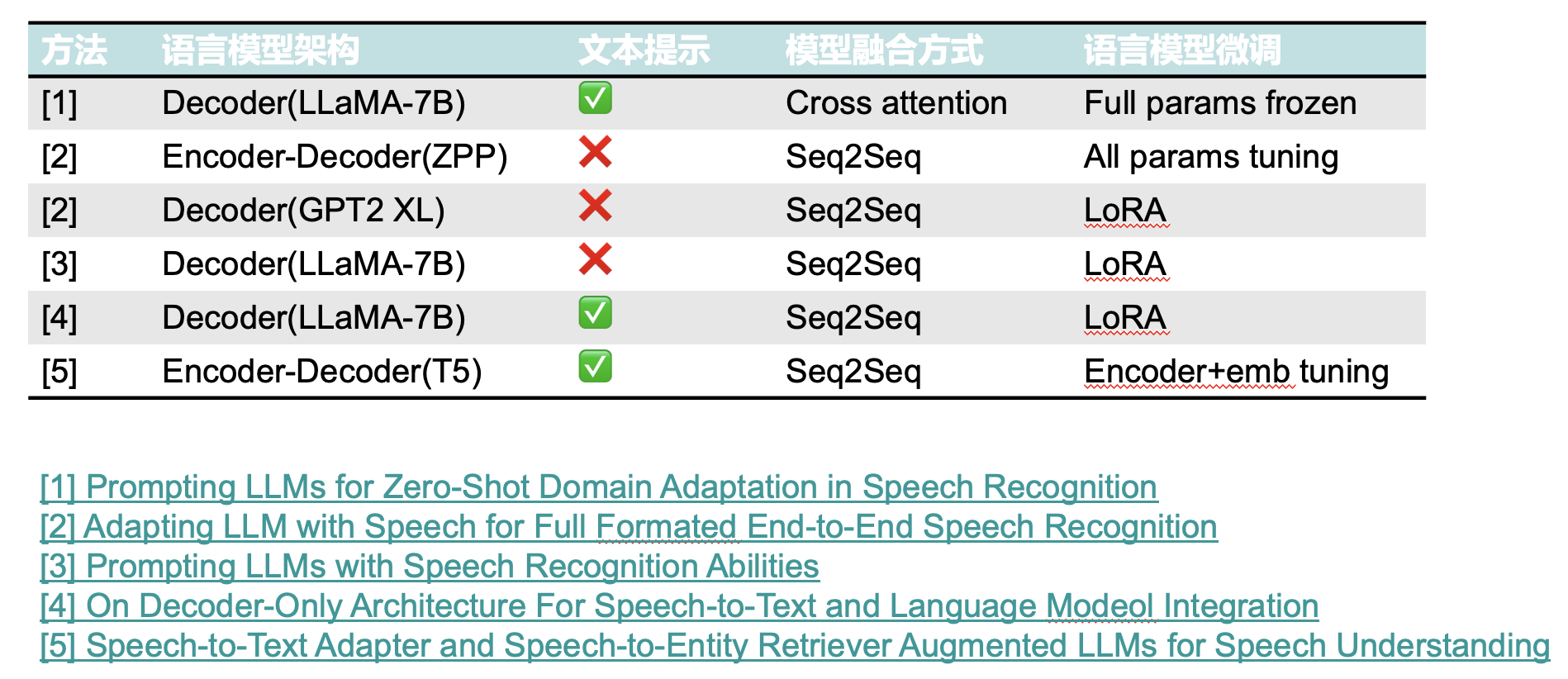

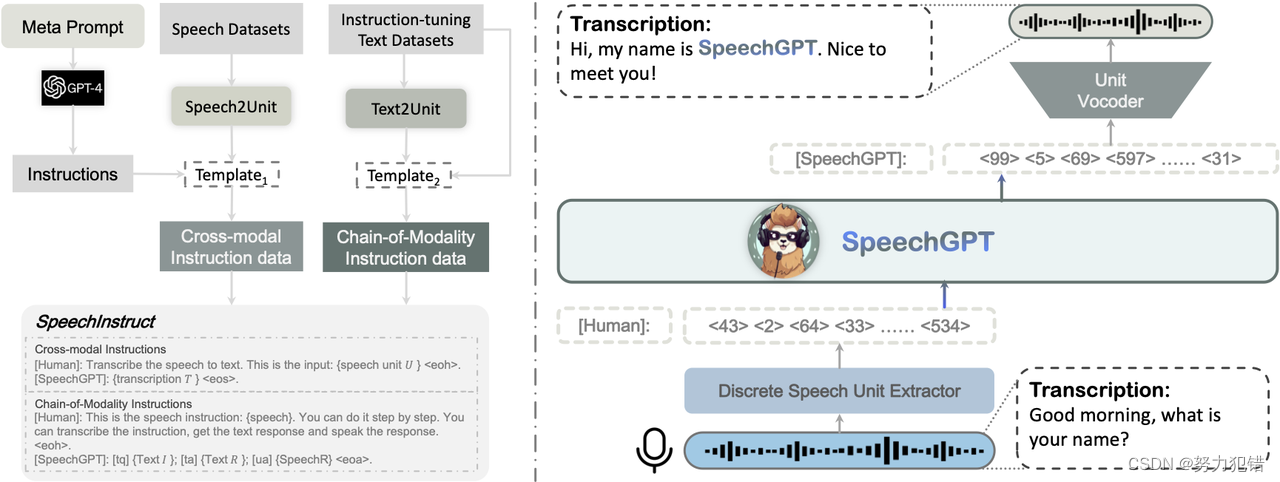

SpeechGen:用提示解锁语音语言模型(Speech LM)的生成能力

论文链接:

https://arxiv.org/pdf/2306.02207.pdf

Demo:

https://ga642381.github.io/SpeechPrompt/speechgen.html

Code:

https://github.com/ga642381/SpeechGen

引言与动机

大型语言模型 (LLMs)在人工智能生成内容(AIGC…

GPT4RoI: Instruction Tuning Large Language Model on Region-of-Interest

在图像-文本对上调整大语言模型(LLM)的指令已经实现了前所未有的视觉-语言多模态能力。然而,他们的视觉语言对齐仅建立在图像级别上,缺乏区域级别对齐限制了他们在细粒度多模态理解方面的进步。在本文中,我们提出对感兴趣区域进行指令调整。关键设计是将边界框重新表述…

吴恩达gradio课程:基于开源LLM(large language model)的聊天应用chatbot

文章目录 内容简介构建应用程序使用gradio在线体验接下来结合llm模型使用gradio构建一个完整的应用程序内容简介 Falcon 40B是当前最好的开源语言模型之一。使用text-generation库调用Falcon 40B的问答API接口。首先仅仅在代码中与模型聊天,后续通过Gradio构建聊天界面。Gradio…

从零开始-与大语言模型对话学技术-gradio篇(4)

前言

本文介绍「星火杯」认知大模型场景创新赛中的落选项目- AI命理分析系统,属于个人娱乐练手。总结提炼了往期文章精华并发掘出新的知识。 包括本地部署版本和Web在线版本,两种打包方式基于 半自动化使用.bat手动打包迁移python项目

如何把 Gradio …

大型语言模型,第 1 部分:BERT

一、介绍 2017是机器学习中具有历史意义的一年,当变形金刚模型首次出现在现场时。它在许多基准测试上都表现出色,并且适用于数据科学中的许多问题。由于其高效的架构,后来开发了许多其他基于变压器的模型,这些模型更专注于特定任务…

Augmented Large Language Models with Parametric Knowledge Guiding

本文是LLM系列文章,针对《Augmented Large Language Models with Parametric Knowledge Guiding》的翻译。 参数知识引导下的增强大型语言模型 摘要1 引言2 相关工作3 LLM的参数化知识引导4 实验5 结论 摘要

大型语言模型(LLM)凭借其令人印…

Lost in the Middle: How Language Models Use Long Contexts

本文是LLM系列文章,针对《Lost in the Middle: How Language Models Use Long Contexts》的翻译。 迷失在中间:语言模型如何使用长上下文 摘要1 引言2 语言模型3 多文档问答4 语言模型如何从输入上下文中检索?5 为什么语言模型很难使用它们的…

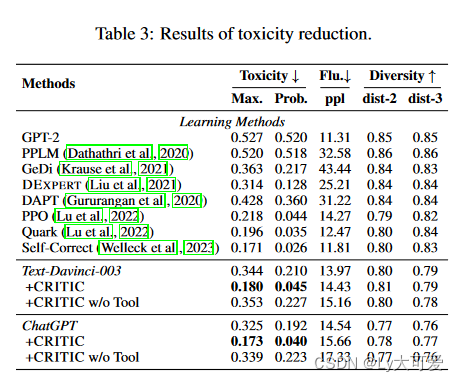

Textbooks Are All You Need II: phi-1.5 technical report

本文是LLM系列文章,针对《Textbooks Are All You Need II: phi-1.5 technical report》的翻译。 教科书是你所需要的一切:phi-1.5技术报告 摘要1 引言2 技术规范3 基准结果4 解决毒性和偏见5 我们的模型的使用6 讨论 摘要

我们继续调查TinyStories发起…

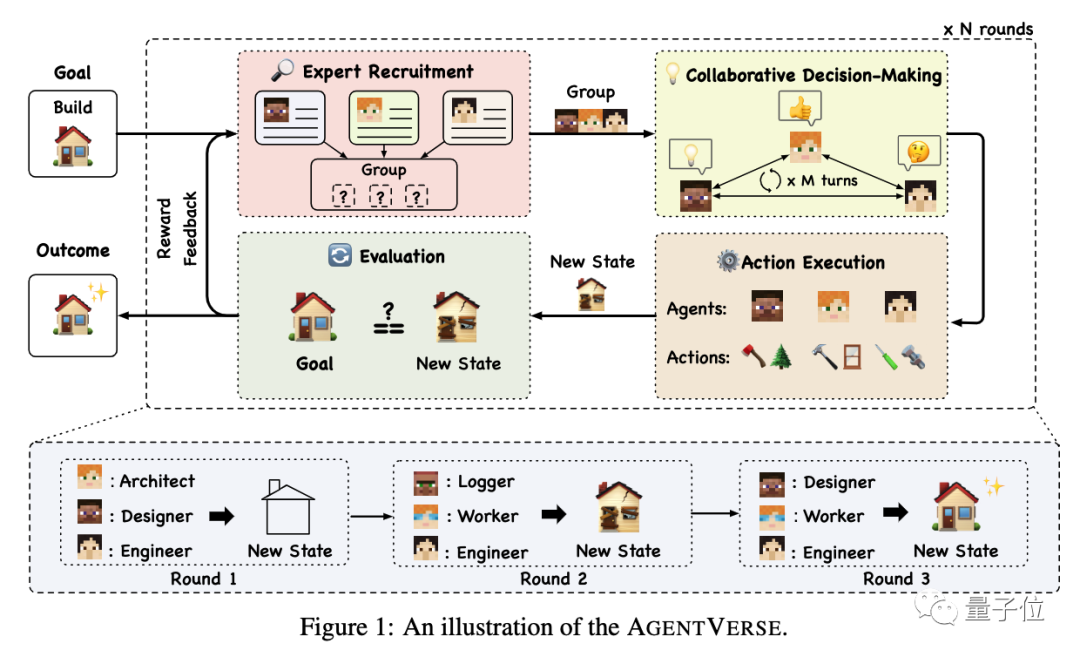

清华智能体宇宙火了;主流大语言模型的技术原理细节

🦉 AI新闻

🚀 清华智能体宇宙火了

摘要:清华大学联合北邮、微信团队推出了AgentVerse,这是一个可以轻松模拟多智能体宇宙的环境。它专为大语言模型开发,智能体可以利用LLM能力完成任务。AgentVerse提供了几个示例环境…

Unleashing the Power of Graph Learning through LLM-based Autonomous Agents

本文是LLM系列文章,针对《Unleashing the Power of Graph Learning through LLM-based Autonomous Agents》的翻译。 通过基于LLM的自动Agent释放图学习的力量 摘要1 引言2 相关工作3 方法4 实验5 结论 摘要

图结构数据在现实世界中广泛存在和应用,而以…

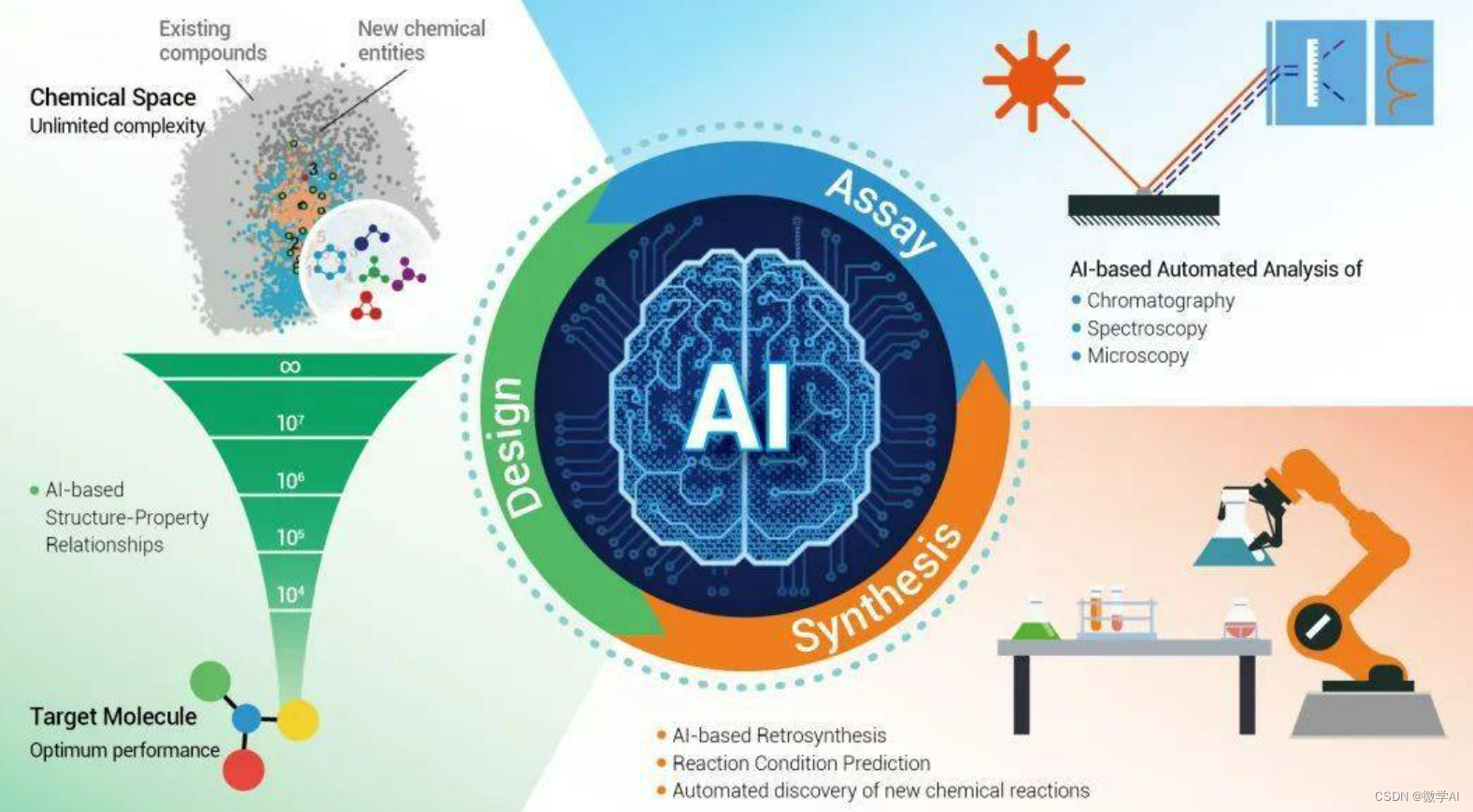

Challenges and Applications of Large Language Models

本文是LLM系列文章,针对《Challenges and Applications of Large Language Models》的翻译。 大语言模型的挑战与应用 摘要1 引言2 挑战3 应用3.1 聊天机器人3.2 计算生物学3.3 计算机程序3.4 创造性工作3.5 知识工作3.6 法律3.7 医学3.8 推理3.9 机器人和嵌入式代…

EasyEdit: An Easy-to-use Knowledge Editing Framework for Large Language Models

本文是LLM系列文章,针对《EasyEdit: An Easy-to-use Knowledge Editing Framework for Large Language Models》的翻译。 EasyEdit:一个易于使用的大型语言模型知识编辑框架 摘要1 引言2 背景3 设计和实现4 评估5 实验6 结论和未来工作 摘要

大型语言模…

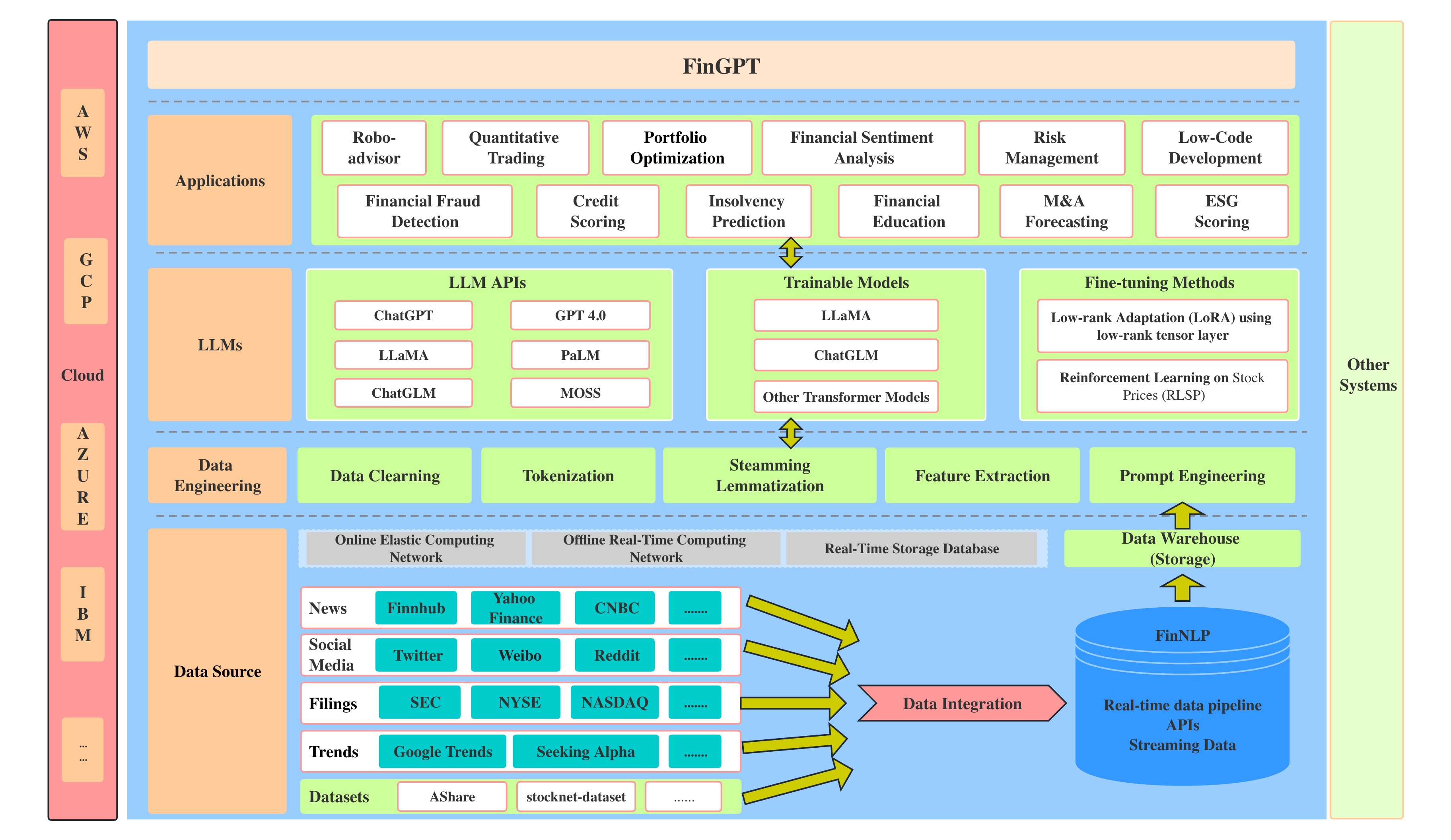

CFGPT: Chinese Financial Assistant with Large Language Model

本文是LLM系列文章,针对《CFGPT: Chinese Financial Assistant with Large Language Model》的翻译。 CFGPT:大型语言模型的中文财务助理 摘要1 引言2 相关工作3 数据集4 模型和训练5 应用6 结论 摘要

大型语言模型(LLM)在金融领…

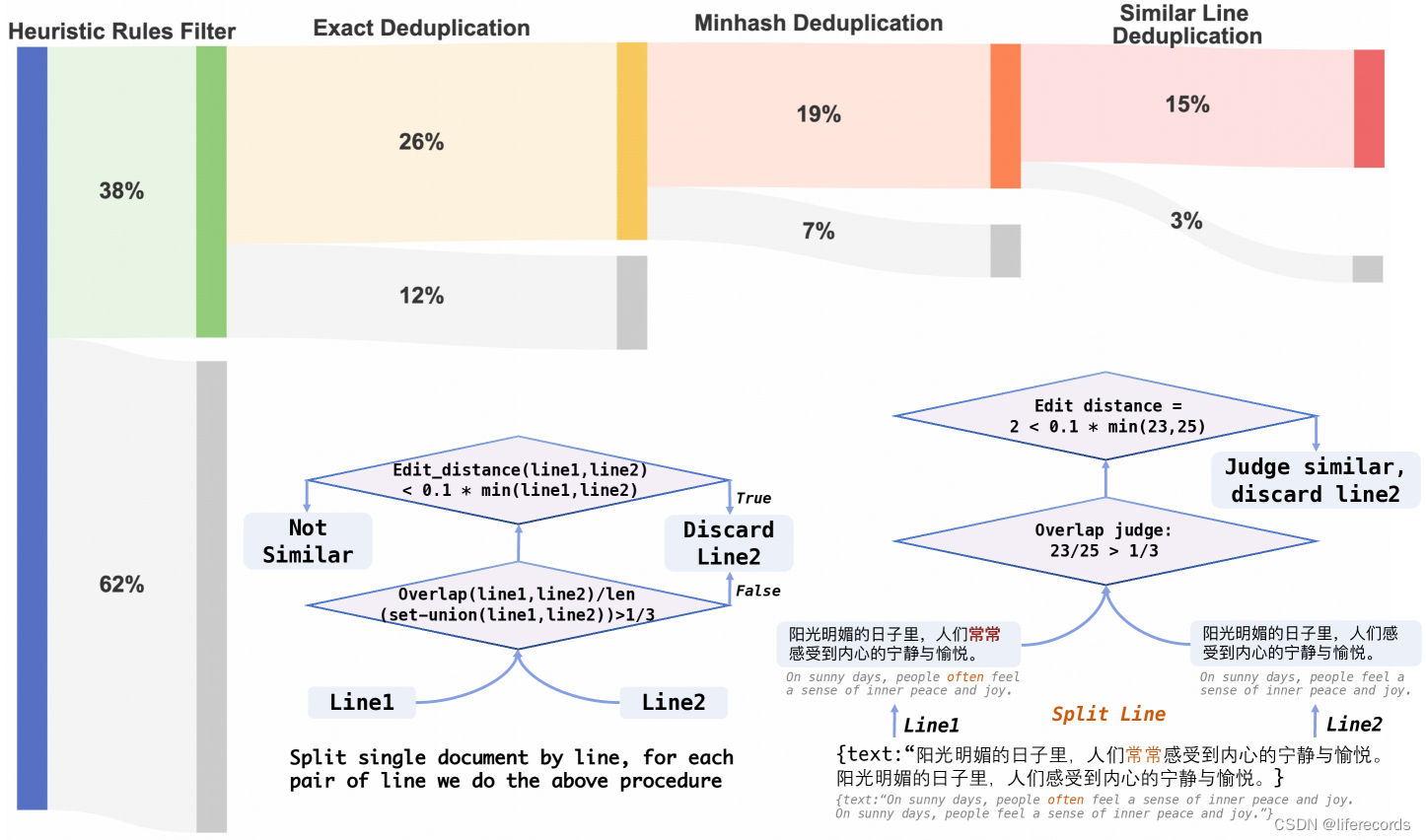

LLM-TAP随笔——语言模型训练数据【深度学习】【PyTorch】【LLM】

文章目录 3、语言模型训练数据3.1、词元切分3.2、词元分析算法 3、语言模型训练数据

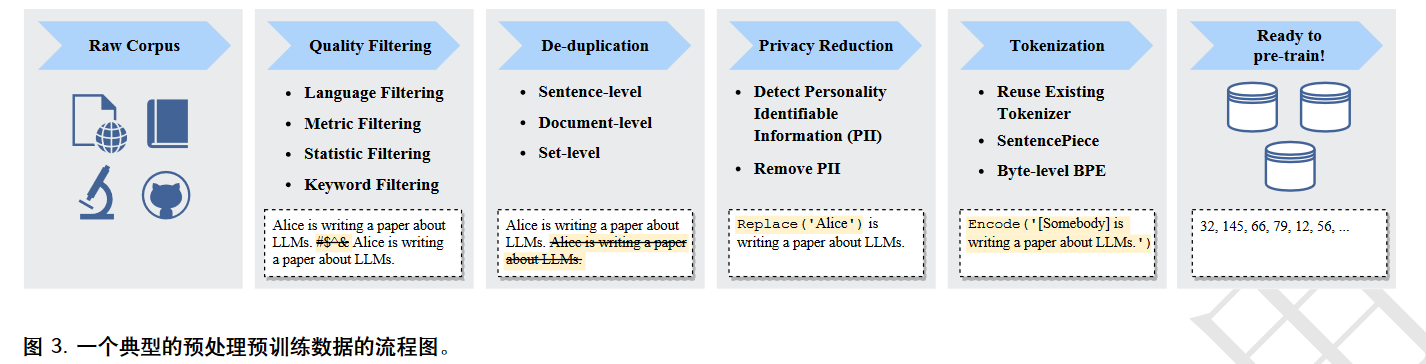

数据质量对模型影响非常大。 典型数据处理:质量过滤、冗余去除、隐私消除、词元切分等。 训练数据的构建时间、噪音或有害信息情况、数据重复率等因素都对模型性能有较大影响。训…

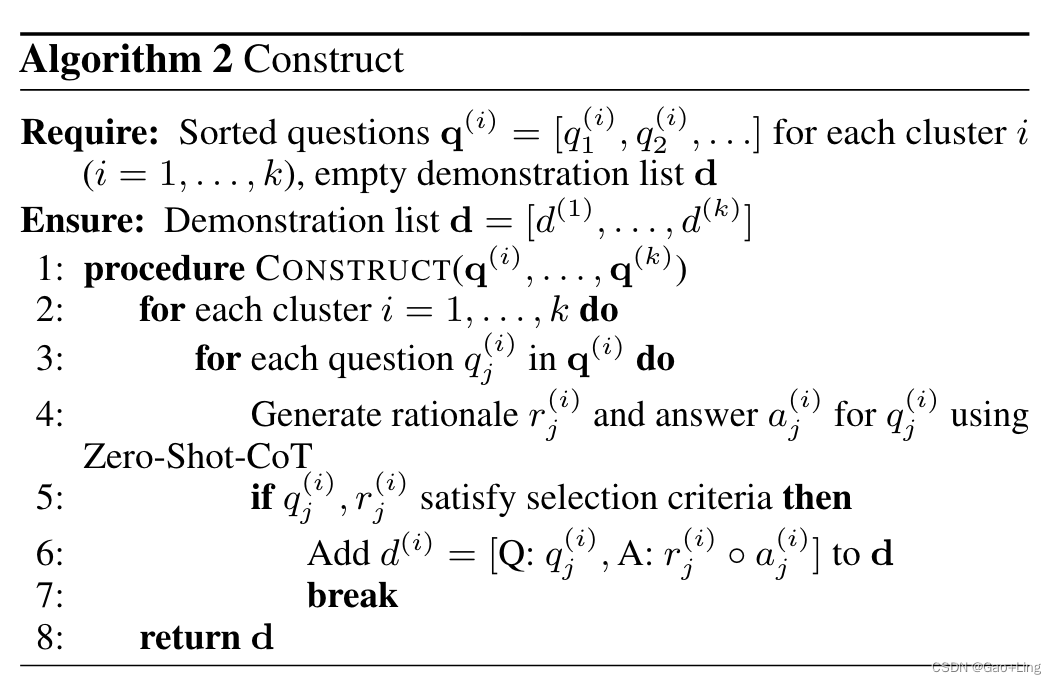

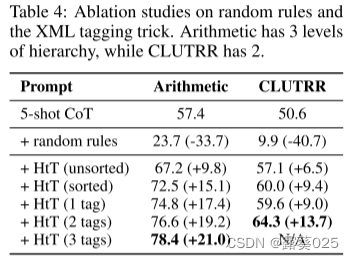

【论文精读】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models 前言Abstract1 Introduction2 Chain-of-Thought Prompting3 Arithmetic Reasoning3,1 Experimental Setup3.2 Results3.3 Ablation Study3.4 Robustness of Chain of Thought 4 Commonsense Reasoning5…

InstructGPT:Training language models to follow instructions with human feedback

Training language models to follow instructions with human feedback

通过人类反馈的微调,在广泛的任务中使语言模型与用户的意图保持一致 aligning language models with user intent on a wide range of tasks by fine-tuning with human feedback

实验动机 …

Lion:闭源大语言模型的对抗蒸馏

Lion:闭源大语言模型的对抗蒸馏

Lion,由香港科技大学提出的针对闭源大语言模型的对抗蒸馏框架,成功将 ChatGPT 的知识转移到了参数量 7B的 LLaMA 模型(命名为 Lion),在只有 70k训练数据的情况下࿰…

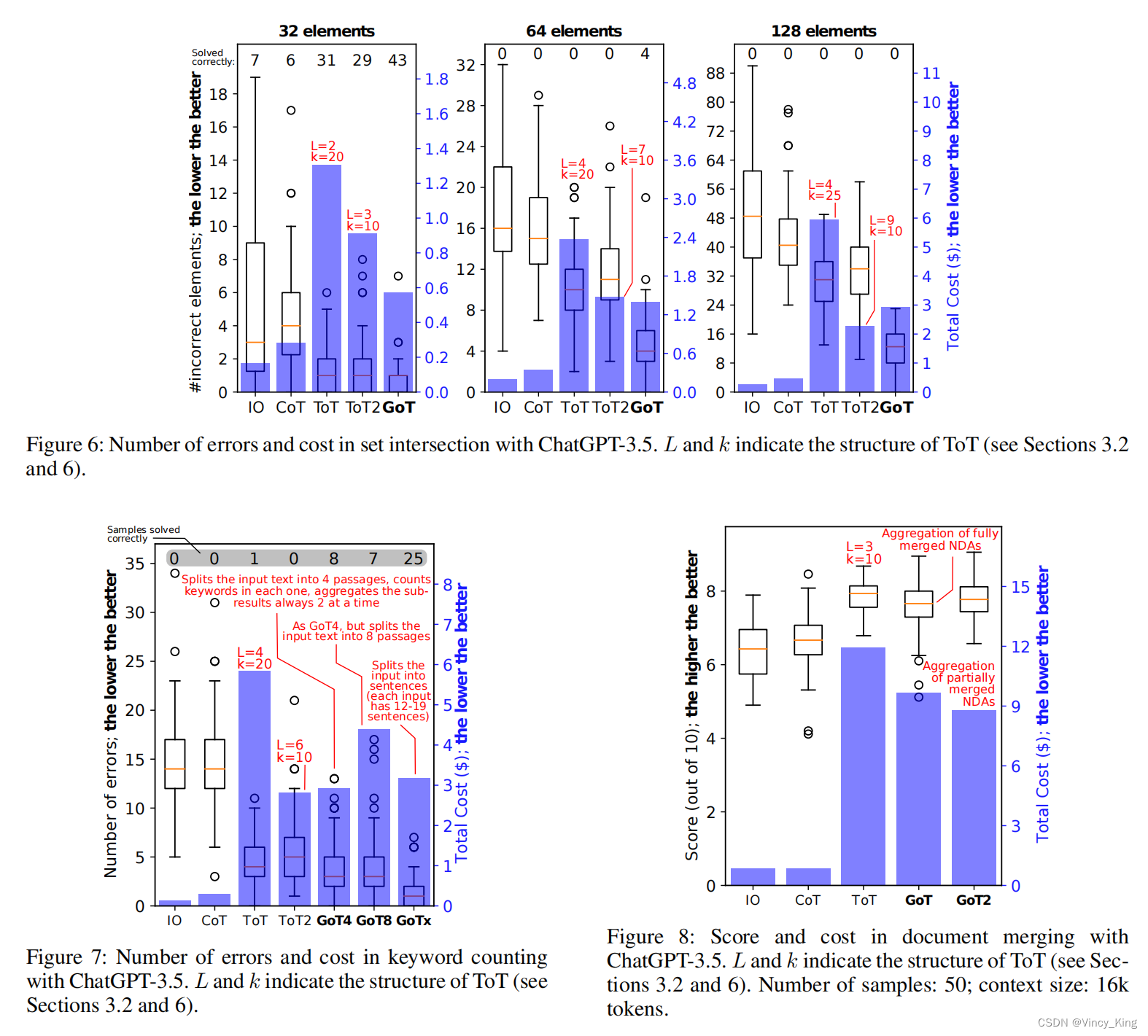

论文浅尝 | 思维树:使用大语言模型反复思考解决问题

笔记整理:许泽众,浙江大学博士,研究方向为知识图谱上的神经符号推理 链接:https://arxiv.org/abs/2305.10601 1. 动机 语言模型是一种强大的工具,可以用于各种需要数学、符号、常识或知识推理的任务。然而,…

论文浅尝 | 基于预训练语言模型的简单问题知识图谱问答

笔记整理:刘赫,天津大学硕士 链接:https://doi.org/10.1007/s11280-023-01166-y 动机 大规模预训练语言模型(PLM)如BERT近取得了巨大的成功,成为自然语言处理(NLP)的一个里程碑。现在NLP社区的共识是采用PLM下游任务的骨干。在最近…

【AI语言模型】阿里推出音视频转文字引擎

一、前言

阿里的音视频转文字引擎可以正式使用,用户可体验所有AI功能,含全文概要、章节速览、发言总结等高阶AI功能。通过阿里云主账号登录,可享受以下权益: 每日登录,自动获得2小时转写时长; 每邀请1名好…

极光笔记 | 大语言模型插件

在人工智能领域,大语言模型(LLMs)是根据预训练数据集进行”学习“,获取可以拟合结果的参数,虽然随着参数的增加,模型的功能也会随之增强。但无论专业领域的小模型,还是当下最火、效果最好的大模…

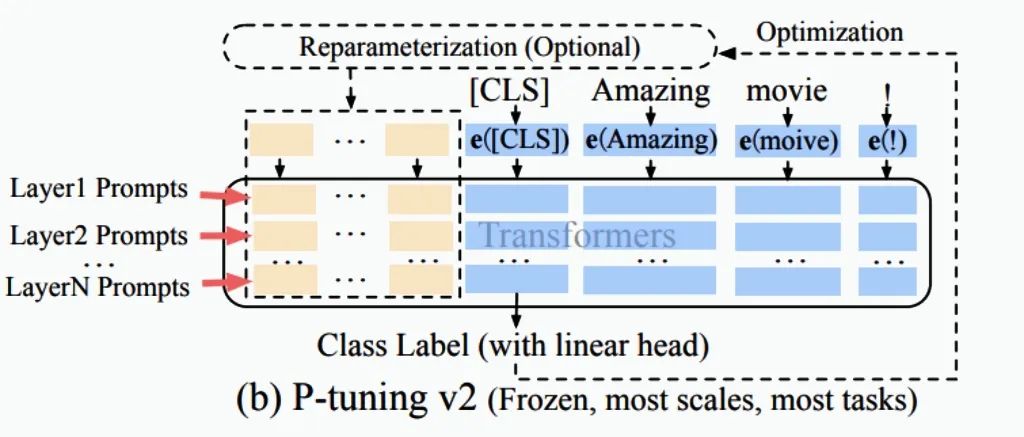

ChatGLM P-Tuningv2微调定制AI大模型

前言

什么是模型微调

想象一下,你正在学习如何弹奏一首钢琴曲目。你已经学会了一些基本的钢琴技巧,但你想要更进一步,尝试演奏一首特定的曲目。这时,你会选择一首你感兴趣的曲目,并开始深度练习。

Fine-tuning(微调)在机器学习中也是类似的概念。当我们使用预先训练好…

When Urban Region Profiling Meets Large Language Models

本文是LLM系列文章,针对《When Urban Region Profiling Meets Large Language Models》的翻译。 当城市区域轮廓遇到大型语言模型时 摘要1 引言2 前言3 方法4 实验5 结论与未来工作 摘要

基于网络数据的城市区域概况对城市规划和可持续发展至关重要。我们见证了LL…

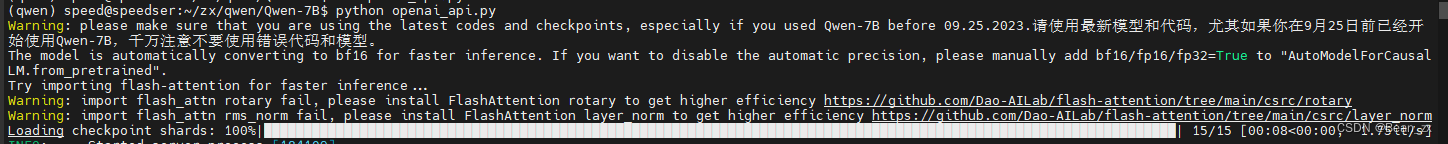

qwen大模型,推理速度慢,单卡/双卡速度慢,flash-attention安装,解决方案

场景

阿里的通义千问qwen大模型,推理速度慢,单卡/双卡速度慢。 详细: 1、今日在使用qwen-14b的float16版本进行推理(BF16/FP16) 1.1 在qwen-14b-int4也会有同样的现象 2、使用3090 24G显卡两张 3、模型加载的device是auto&#x…

OPENCHAT: ADVANCING OPEN-SOURCE LANGUAGE MODELS WITH MIXED-QUALITY DATA

本文是LLM系列文章,针对《OPENCHAT: ADVANCING OPEN-SOURCE LANGUAGE MODELS WITH MIXED-QUALITY DATA》的翻译。 OPENCHAT:利用混合质量数据推进开源语言模型 摘要1 引言2 前言3 OpenChat4 实验5 分析6 相关工作7 结论与未来工作 摘要

如今࿰…

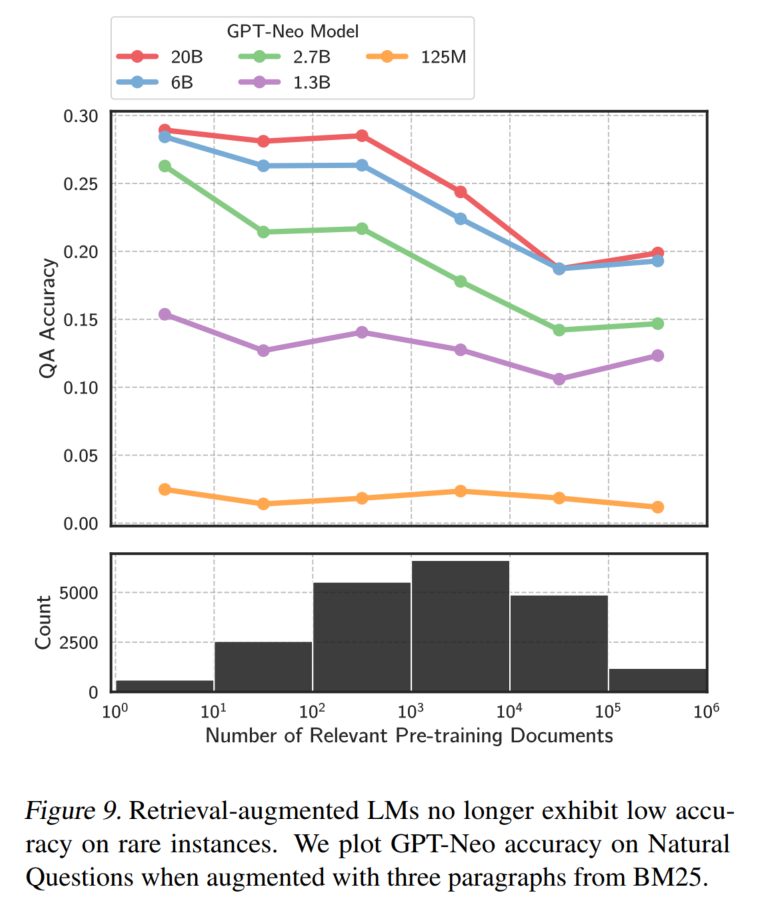

拓展认知边界:如何给大语言模型添加额外的知识

Integrating Knowledge in Language Models

P.s.这篇文章大部分内容来自Stanford CS224N这门课Integrating Knowledge in Language Models这一节😁

为什么需要给语言模型添加额外的知识

1.语言模型会输出看似make sense但实际上不符合事实的内容

语言模型在生成…

Are Large Language Models Really Robust to Word-Level Perturbations?

本文是LLM系列文章,针对《Are Large Language Models Really Robust to Word-Level Perturbations?》的翻译。 大型语言模型真的对单词级扰动具有鲁棒性吗? 摘要1 引言2 相关工作3 合理稳健性评价的奖励模型(TREvaL)4 LLM的词级…

大语言模型之十六-基于LongLoRA的长文本上下文微调Llama-2

增加LLM上下文长度可以提升大语言模型在一些任务上的表现,这包括多轮长对话、长文本摘要、视觉-语言Transformer模型的高分辨4k模型的理解力以及代码生成、图像以及音频生成等。

对长上下文场景,在解码阶段,缓存先前token的Key和Value&#…

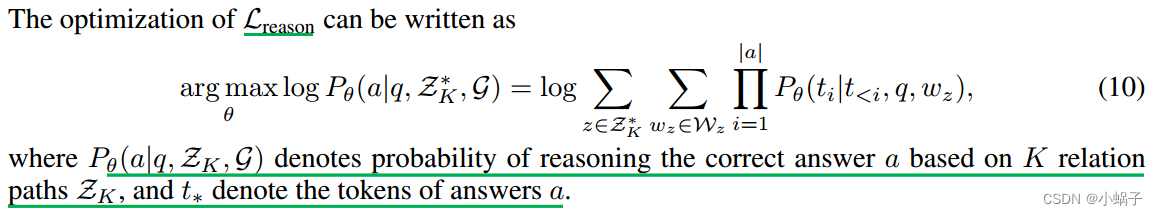

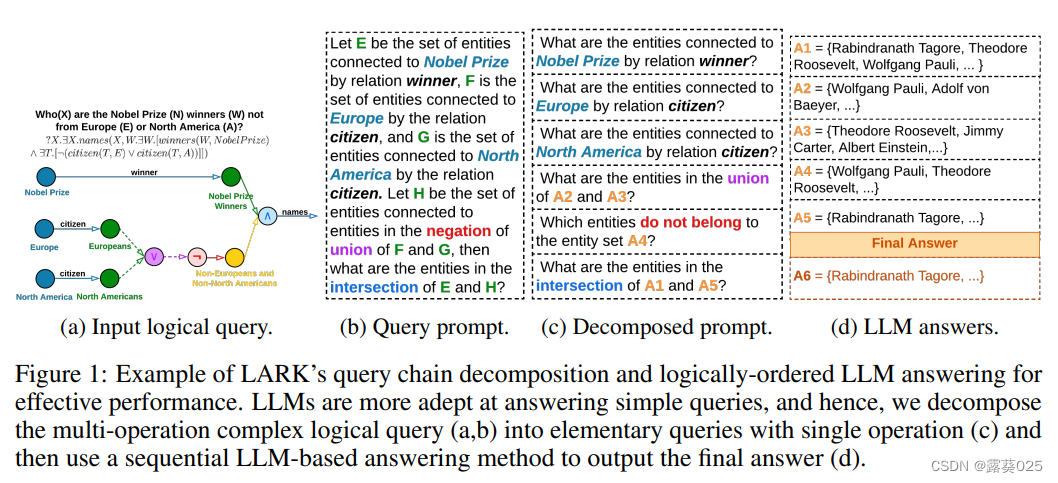

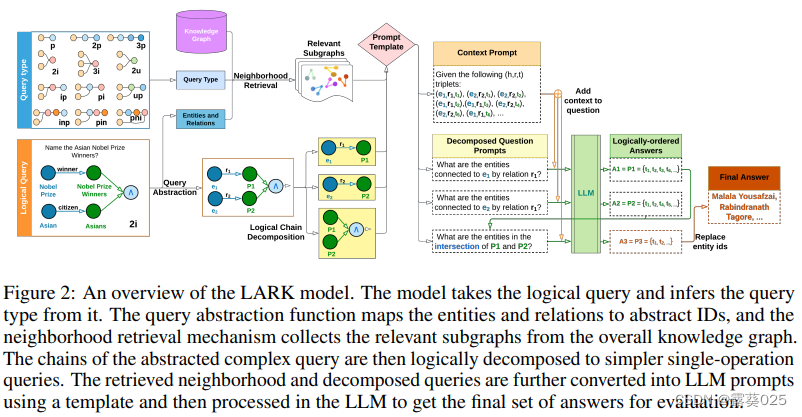

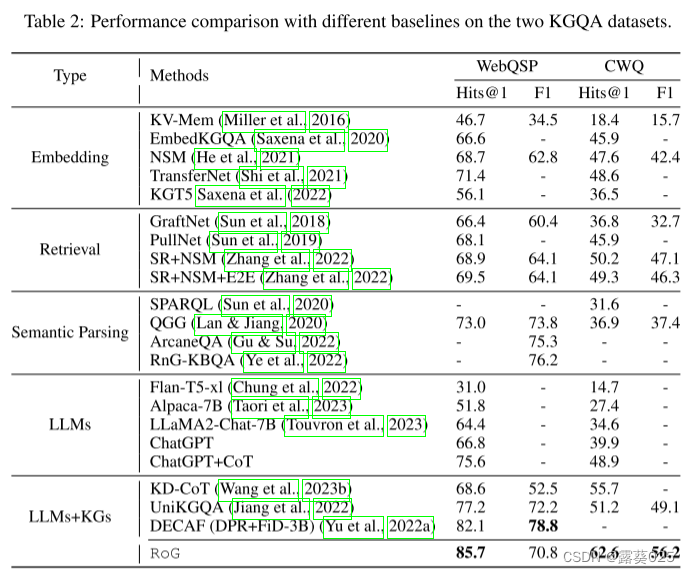

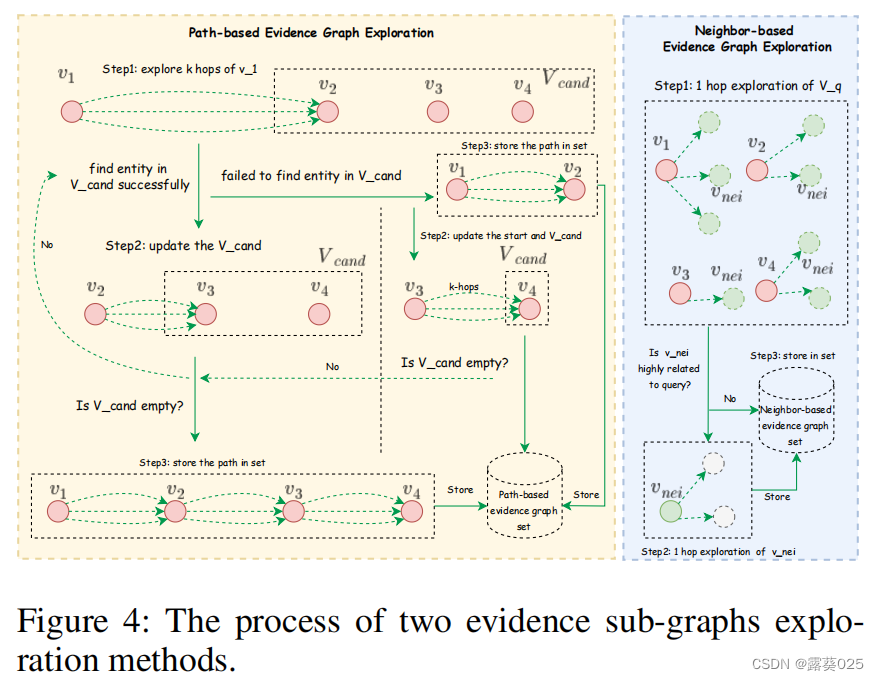

REASONING ON GRAPHS: FAITHFUL AND INTERPRETABLE LARGE LANGUAGE MODEL REASONING

本文是LLM系列文章,针对《REASONING ON GRAPHS: FAITHFUL AND INTERPRETABLE LARGE LANGUAGE MODEL REASONING》的翻译。 图上推理:忠实的和可解释的大语言模型推理 摘要1 引言2 相关工作3 前言4 方法5 实验6 结论 摘要

大型语言模型(llm)在复杂任务中表现出令人印…

百度Comate SaaS版本正式发布,助力开发者加速研发过程

百度Comate是基于文心大模型的智能代码助手,让开发者的编码更快、更好、更简单,为开发者自动生成完整的、且更符合实际研发场景的代码行或整个代码块,帮助每一位开发者轻松完成研发任务。10月17日召开的百度世界大会上,百度CTO王海…

Retrieve Anything To Augment Large Language Models

简介 论文主要介绍了一套通过对比学习和蒸馏学习的方法,来增强学习了embedding向量,然后能够在知识增强,长上下文建模,ICL和工具学习等方面来增强大模型能力。

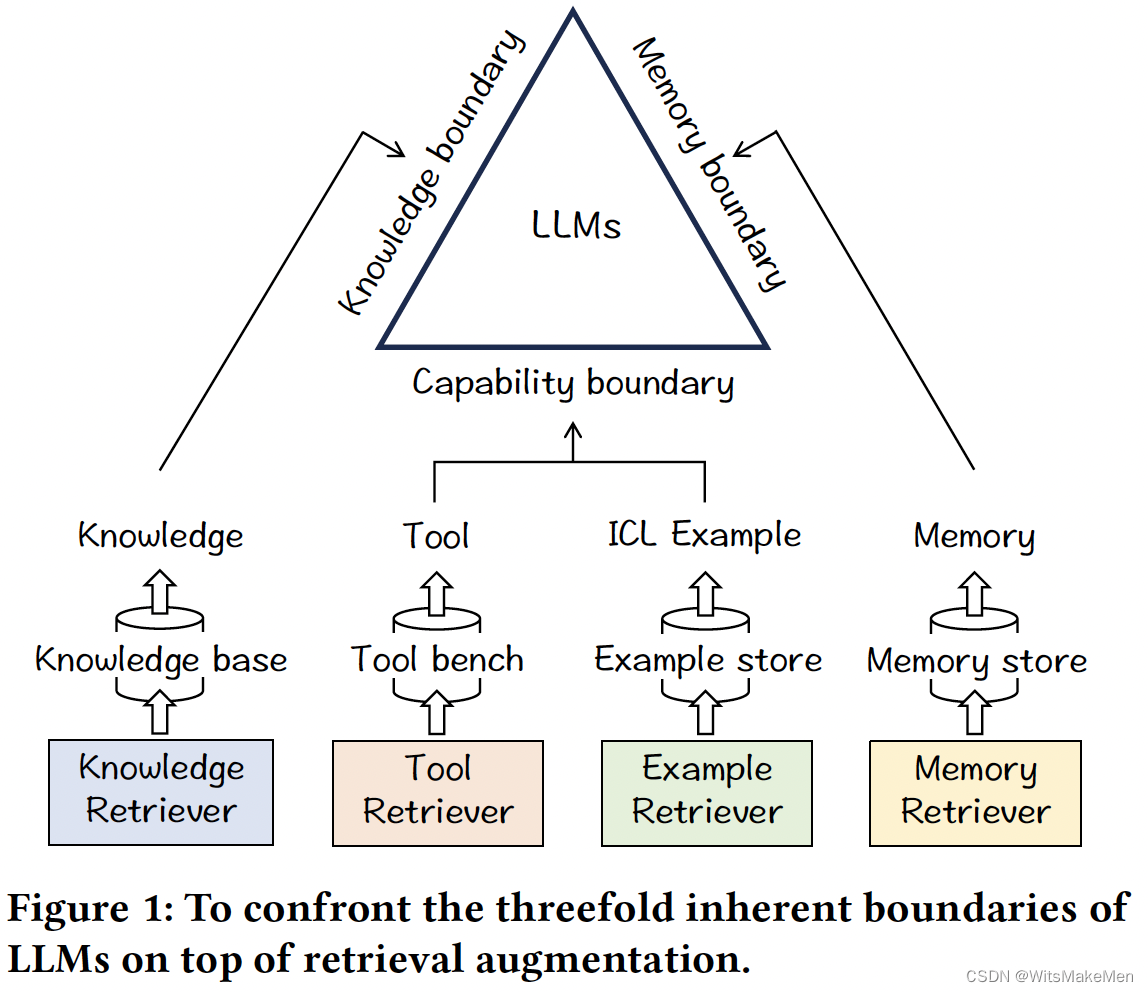

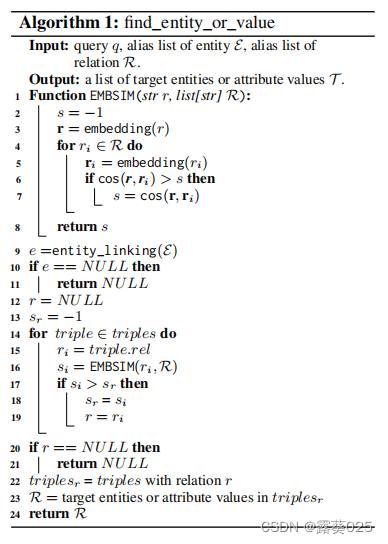

利用检索和存储访问知识库上增强大型语言模型10.30

利用检索和存储访问知识库上增强大型语言模型 摘要引言2 相关研究3方法3.1 任务定义3.2 知识检索3.2.1 代码实现3.2.2 实体链接3.2.3 获取实体信息3.2.4 查找实体或值3.2.5 查找关系 3.3 知识存储 4 实验 摘要

大型语言模型(LLM)在自然语言处理领域展现…

人工智能在电商领域的五大应用场景及未来趋势

作者:禅与计算机程序设计艺术

1.简介

欢迎来到第七期《人工智能在电商领域的五大应用场景及未来趋势》专题。人工智能(Artificial Intelligence)一直都是互联网行业的热点话题,电子商务网站的营销活动、商品推荐系统等领域均采用了人工智能技术。因此,对电商运营者来说,…

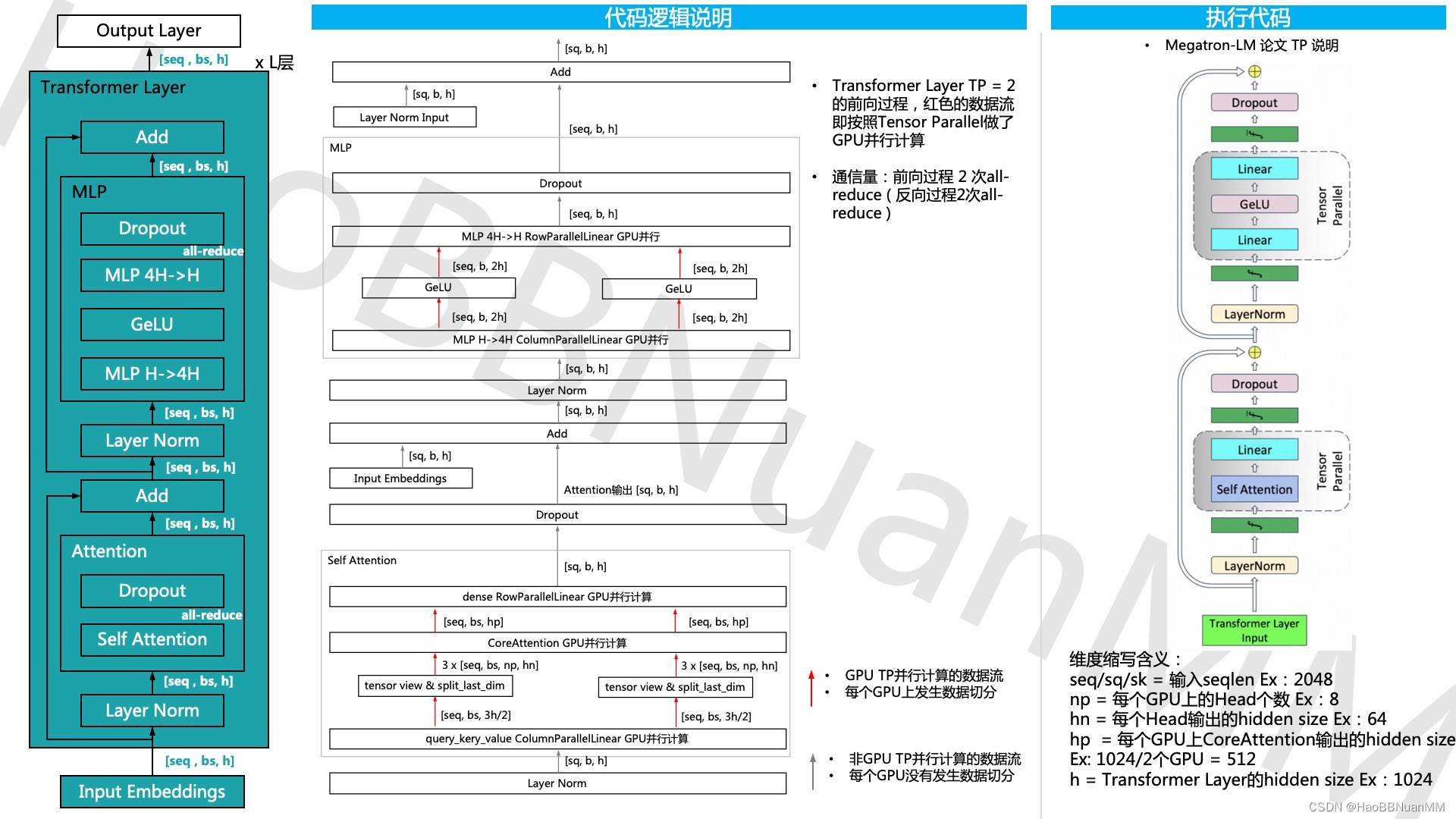

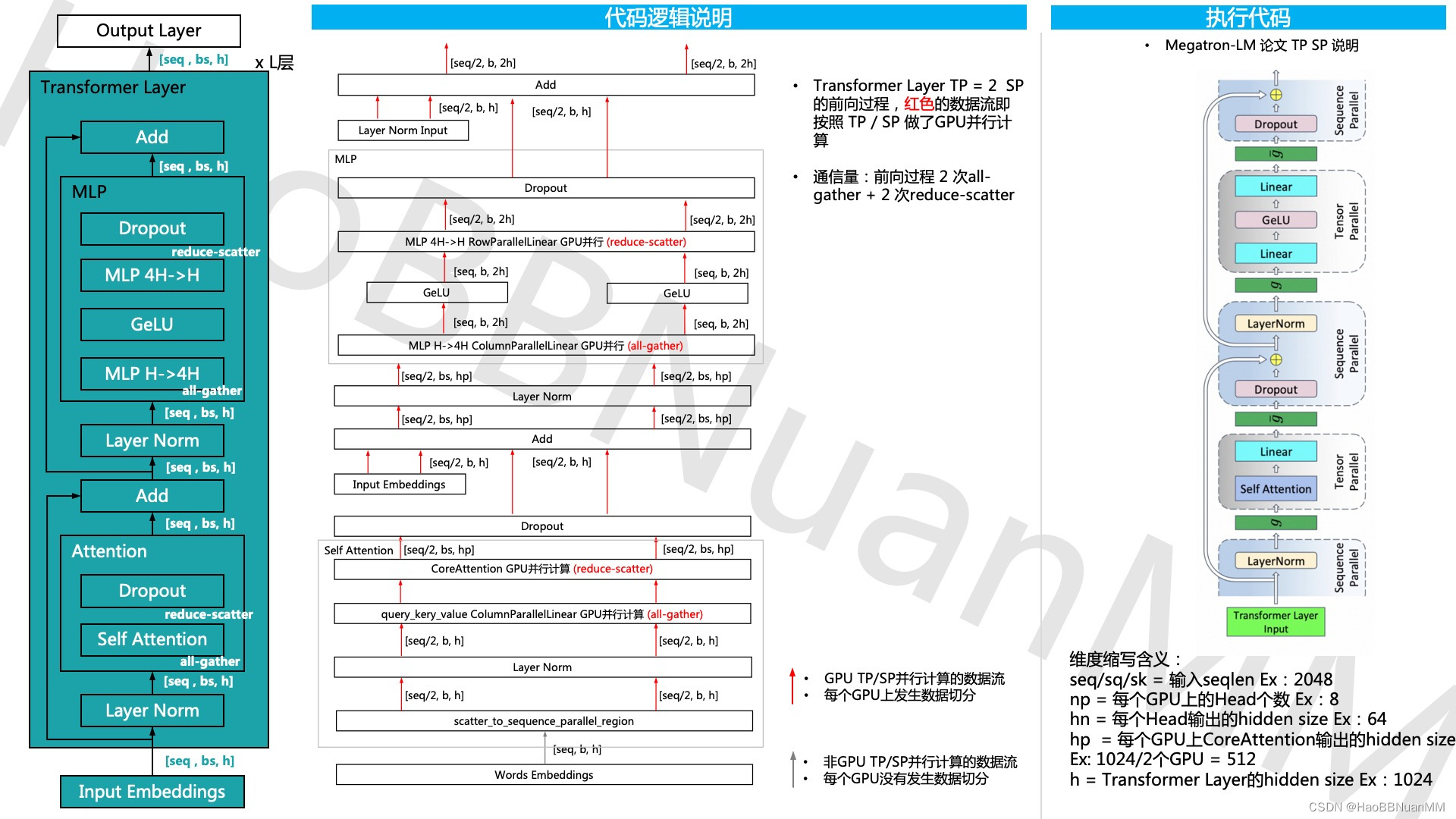

Megatron-LM GPT 源码分析(一) Tensor Parallel分析

引用

本文基于开源代码 https://github.com/NVIDIA/Megatron-LM ,通过GPT的模型运行示例,从三个维度 - 模型结构、代码运行、代码逻辑说明 对其源码做深入的分析。 Tensor Parallel源码分析

Unnatural Instructions: Tuning Language Models with (Almost) No Human Labor

本文是LLM系列文章,针对《Unnatural Instructions: Tuning Language Models with (Almost) No Human Labor》的翻译。 TOC

摘要

指令调优使预训练的语言模型能够从推理时间的自然语言描述中执行新的任务。这些方法依赖于以众包数据集或用户交互形式进行的大量人工…

大模型技术实践(五)|支持千亿参数模型训练的分布式并行框架

在上一期的大模型技术实践中,我们介绍了增加式方法、选择式方法和重新参数化式方法三种主流的参数高效微调技术(PEFT)。微调模型可以让模型更适合于我们当前的下游任务,但当模型过大或数据集规模很大时,单个加速器&…

Anthropic全球上线AI语言模型Claude 2;多模态系统:融合文本和图像的新前沿

🦉 AI新闻

🚀 Anthropic全球上线AI语言模型Claude 2,编程、数学、推理能力大幅提升

摘要:Anthropic在全球正式上线了AI语言模型Claude 2。相比前代版本,Claude 2在编程、数学、推理等方面都有大幅提升,支…

大语言模型面试心路历程【0 offer版】

记录自己大语言模型面试的经历,旨在可以帮助更多想要从事此方面的小伙伴。 北银金科

1.InstructGPT的训练过程 2.critic网络的作用 3.LSTM的原理,GRU与LSTM有什么不同 4.讲一下Bert的结构 5.讲一下自己的论文【KBQA相关】 6.GLM的结构和微调了哪些参数 …

垂直领域大模型落地思考

相比能做很多事,但每件事都马马虎虎的通用大模型;只能做一两件事,但这一两件事都能做好,可被信赖的垂直大模型会更有价值。这样的垂直大模型能帮助我们真正解决问题,提高生产效率。

本文将系统介绍如何做一个垂直领域…

大语言模型(LLM)综述(一):大语言模型介绍

A Survey of Large Language Models 前言1. INTRODUCTION2. OVERVIEW2.1 大语言模型的背景2.2 GPT系列模型的技术演变 前言

随着人工智能和机器学习领域的迅速发展,语言模型已经从简单的词袋模型(Bag-of-Words)和N-gram模型演变为更为复杂和…

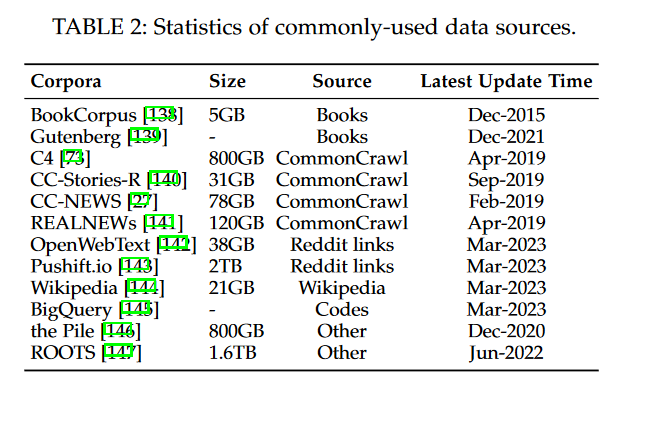

大语言模型(LLM)综述(二):开发大语言模型的公开可用资源

A Survey of Large Language Models 前言3. RESOURCES OF LLMS3.1 公开可用的模型CheckPoints或 API3.2 常用语料库3.3 库资源 前言

随着人工智能和机器学习领域的迅速发展,语言模型已经从简单的词袋模型(Bag-of-Words)和N-gram模型演变为更…

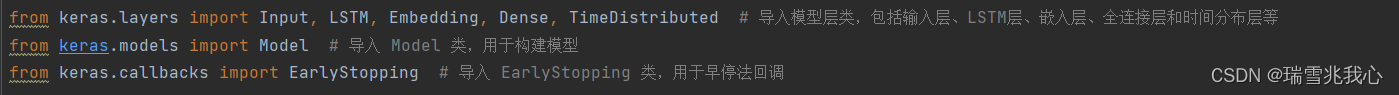

基于 LSTM 进行多类文本分类(附源码)

NLP 的许多创新是如何将上下文添加到词向量中。一种常见的方法是使用循环神经网络。以下是循环神经网络的概念: 他们利用顺序信息。 他们可以捕捉到到目前为止已经计算过的内容,即:我最后说的内容会影响我接下来要说的内容。 RNNs 是文本和…

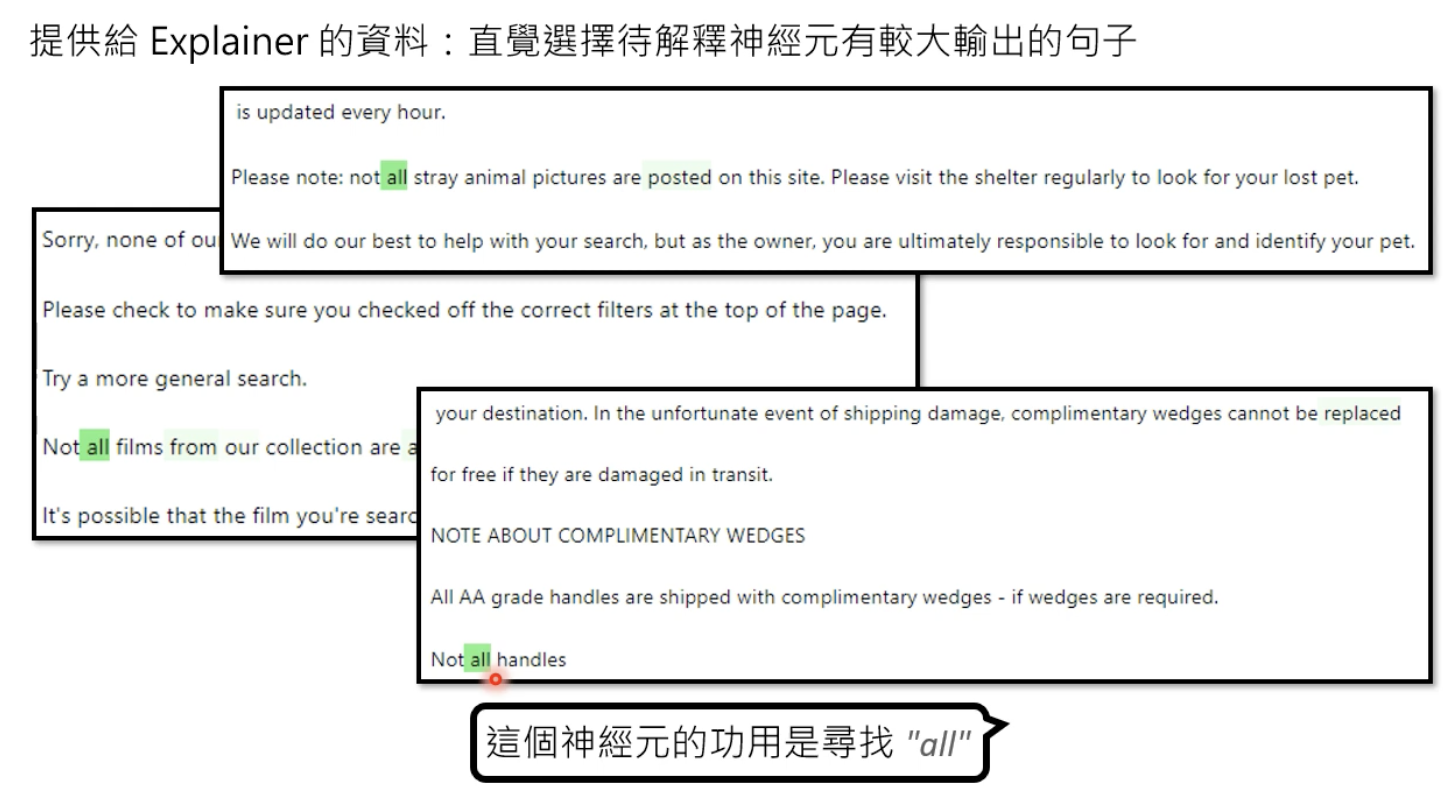

大语言模型迎来重大突破!找到解释神经网络行为方法

前不久,获得亚马逊40亿美元投资的ChatGPT主要竞争对手Anthropic在官网公布了一篇名为《朝向单义性:通过词典学习分解语言模型》的论文,公布了解释经网络行为的方法。

由于神经网络是基于海量数据训练而成,其开发的AI模型可以生成…

大语言模型的学习路线和开源模型的学习材料《一》

文章目录 第一层 LLMs to Natural Language Processing (NLP)第一重 ChatGLM-6B 系列ChatGLM3ChatGLM2-6BChatGLM-6B第十重 BaichuanBaichuan2Baichuan-13Bbaichuan-7B第十一重 Llama2第二重 Stanford Alpaca 7B第三重 Chinese-LLaMA-Alpaca第四重 小羊驼 Vicuna第五重 MOSS第六…

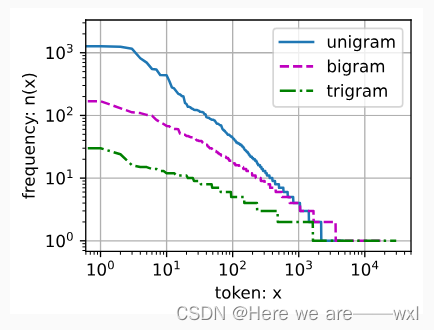

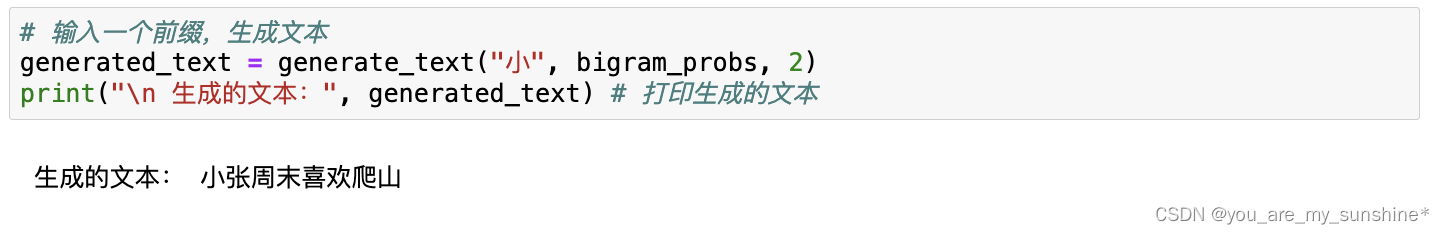

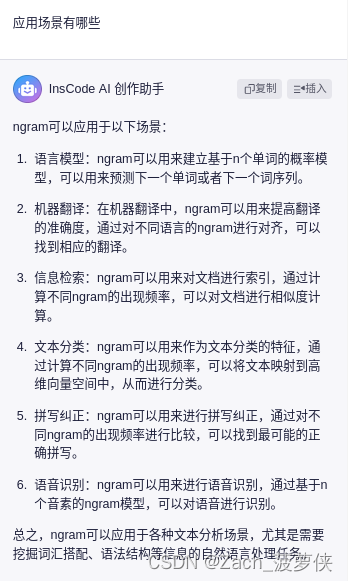

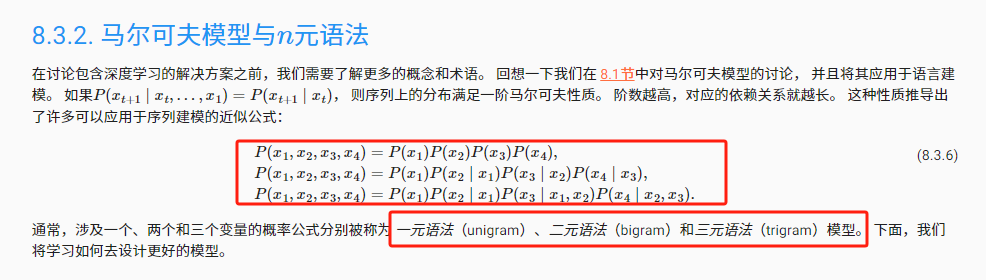

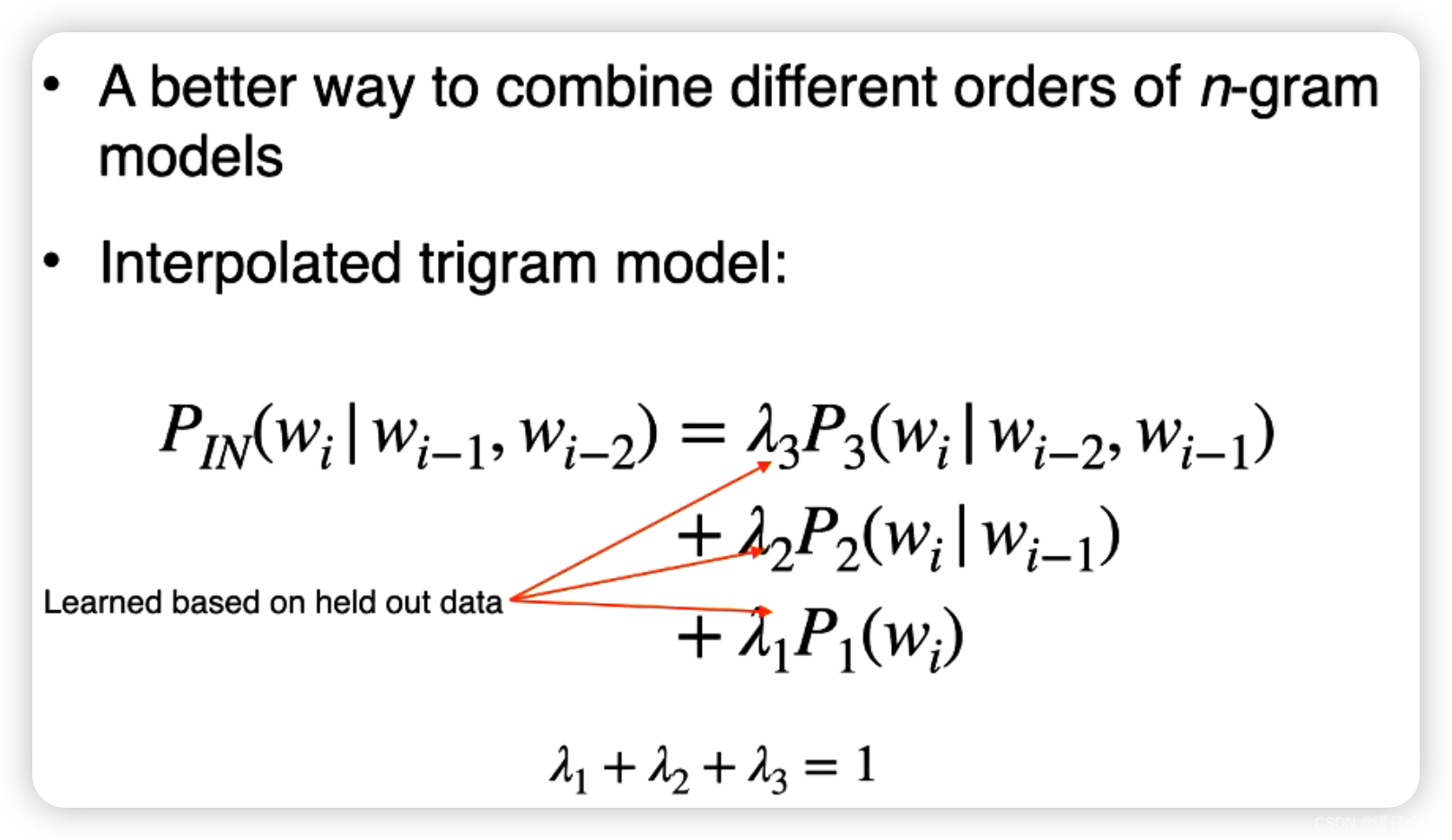

n-gram语言模型——句子概率分布计算与平滑

n-gram语言模型——句子概率分布计算与平滑 前言 语言模型 等价假设 n元语法 句子概率分布计算方式 数据平滑 Lidstone平滑(1-gram) Laplace平滑(1-gram) 附上两种平滑在1-gram下代码 Lidstone平滑与Laplace平滑(2-gram) 附上两种平滑在2-gram下代码 前言 语言模型…

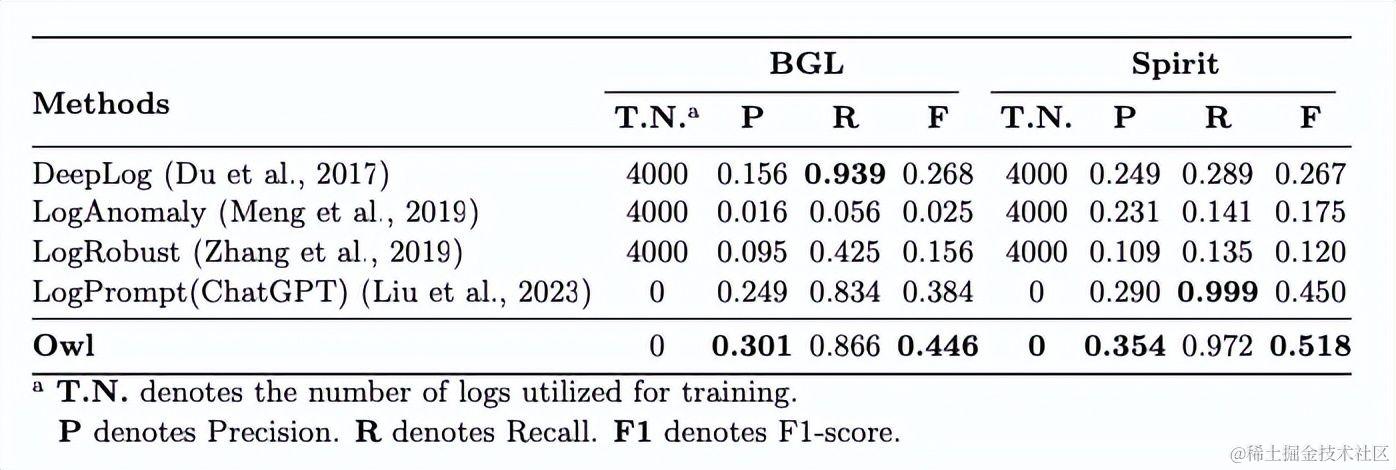

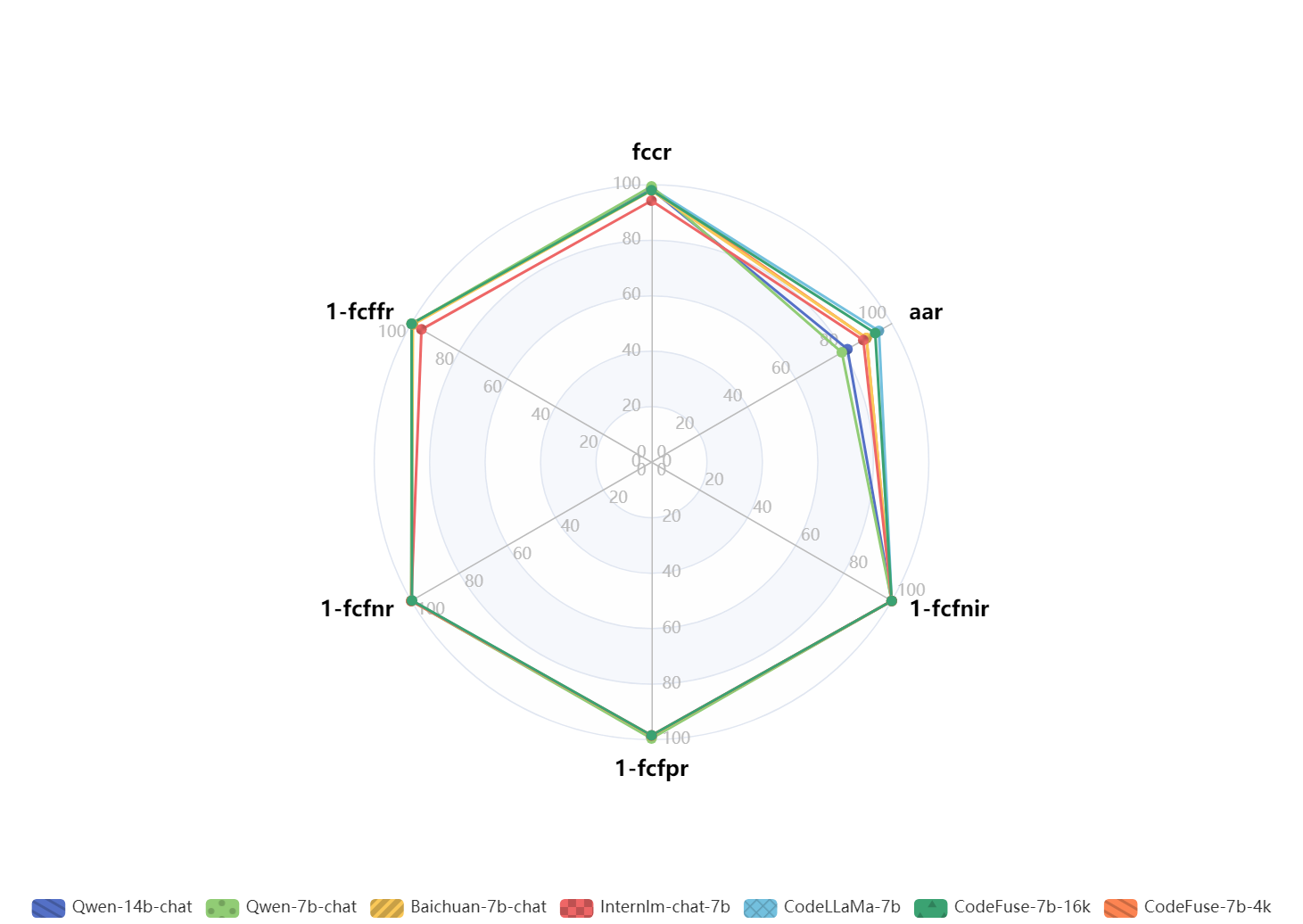

云智慧联合北航提出智能运维(AIOps)大语言模型及评测基准

随着各行业数字化转型需求的不断提高,人工智能、云计算、大数据等新技术的应用已不仅仅是一个趋势。各行业企业和组织纷纷投入大量资源,以满足日益挑剔的市场需求,追求可持续性和竞争力,这也让运维行业迎来了前所未有的挑战和机遇…

作为一个初学者,该如何入门大模型?

在生成式 AI 盛行的当下,你是否被这种技术所折服,例如输入一段简简单单的文字,转眼之间,一幅精美的图片,又或者是文笔流畅的文字就展现在你的面前。

相信很多人有这种想法,认为生成式 AI 深不可测…

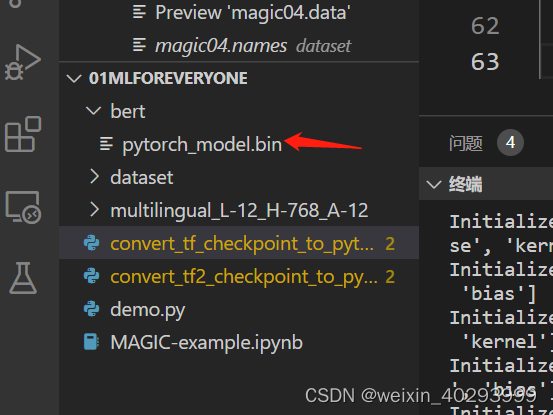

ChatGLM 如何应用一个BERT

前言 接着上一小节,我们对Huggingface开源代码库中的Bert模型进行了深入学习,这一节我们对如何应用BERT进行详细的讲解。 涉及到的jupyter可以在代码库:篇章3-编写一个Transformer模型:BERT,下载 本文基于 Transformers 版本 4.4.2(2021 年 3 月 19 日发布)项目中,pyto…

Windows安装GPU版本的pytorch详细教程

文章目录 chatGLM2-6B安装教程正式安装 chatGLM2-6B

ChatGLM2-6B版本要装pytorch2.0,而且要2.0.1 ,因此CUDA不能用12.0 ,也不能用10.0,只能用11.x 版本。

安装教程

pip install直接下载安装 官网: https://pytorch.…

n-gram语言模型——文本生成源码

n-gram语言模型——文本生成源码 n-gram模型的基本原理 文本生成的步骤 1. 准备和分词 2. 构建n-gram模型 3. 平滑技术的应用 4. 生成文本 源码 在自然语言处理的领域中,n-gram语言模型是一种基础而强大的工具。它通过考虑词汇的序列来预测文本内容ÿ…

第三章:人工智能深度学习教程-基础神经网络(第一节-ANN 和 BNN 的区别)

你有没有想过建造大脑之类的东西是什么感觉,这些东西是如何工作的,或者它们的作用是什么?让我们看看节点如何与神经元通信,以及人工神经网络和生物神经网络之间有什么区别。

1.人工神经网络:人工神经网络(…

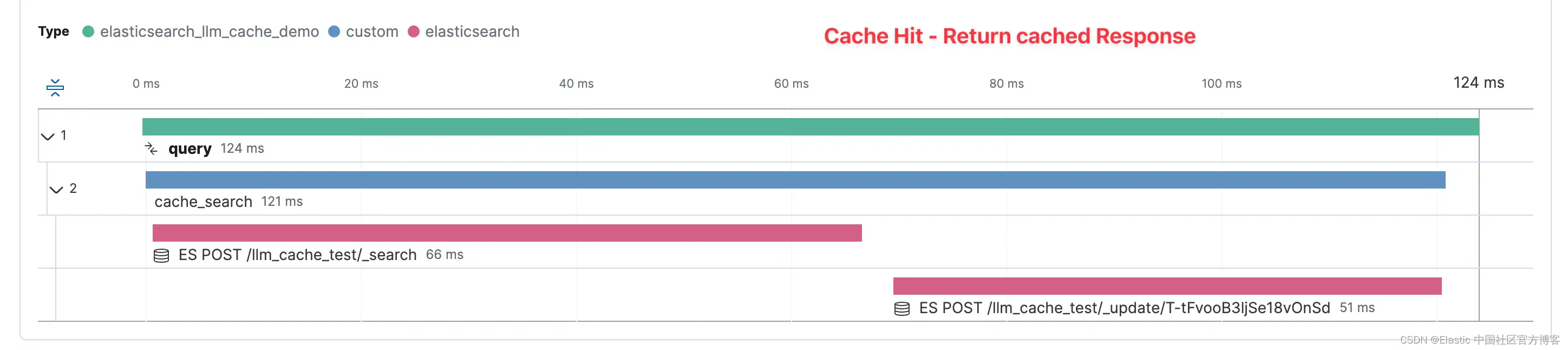

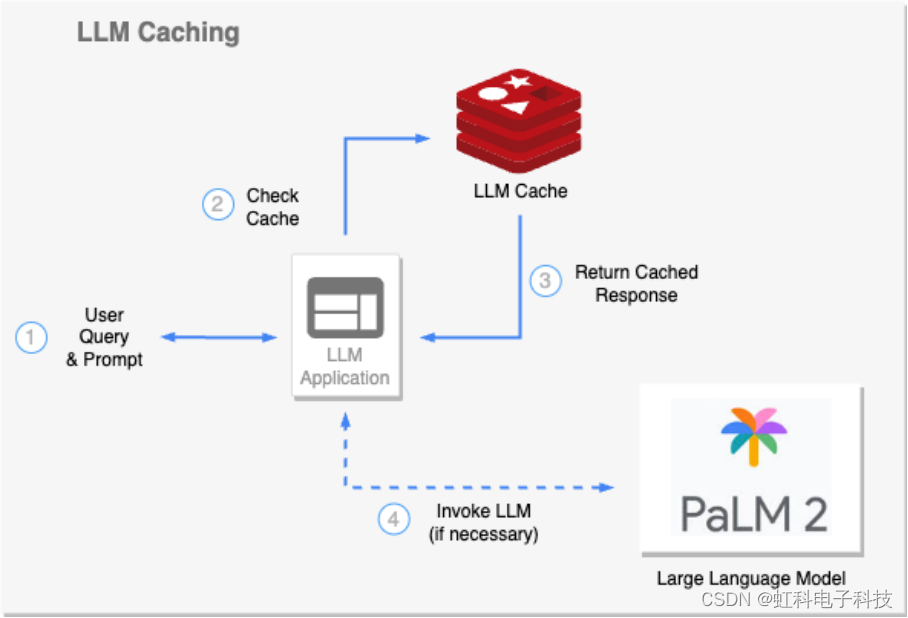

Elasticsearch 作为 GenAI 缓存层

作者:JEFF VESTAL,BAHA AZARMI

探索如何将 Elasticsearch 集成为缓存层,通过降低 token 成本和响应时间来优化生成式 AI 性能,这已通过实际测试和实际实施进行了证明。 随着生成式人工智能 (GenAI) 不断革新从客户服务到数据分析…

ChatRule:基于知识图推理的大语言模型逻辑规则挖掘11.10

ChatRule:基于知识图推理的大语言模型逻辑规则挖掘 摘要引言相关工作初始化和问题定义方法实验 摘要

逻辑规则对于揭示关系之间的逻辑联系至关重要,这可以提高推理性能并在知识图谱(KG)上提供可解释的结果。虽然已经有许多努力&a…

Benchmarking Large Language Models in Retrieval-Augmented Generation-学习翻译

提检索增强生成中大型语言模型的基准测试文献学习 作者将在https://github.com/chen700564/RGB上发布本文的代码和RGB。 y ˇ \check{y} yˇ 文章目录 摘要IntroductionRelated workRetrieval-Augmented Generation BenchmarkRAG所需能力数据构建评估指标 ExperimentsSetting…

ChatGLM HuggingFace大语言模型底座

基础介绍 HuggingFace 是一家专注于自然语言处理(NLP)、人工智能和分布式系统的创业公司,创立于2016年。最早是主营业务是做闲聊机器人,2018年 Bert 发布之后,他们贡献了一个基于 Pytorch 的 Bert 预训练模型,即 pytorch-pretrained-bert,大受欢迎,进而将重心转向维护 …

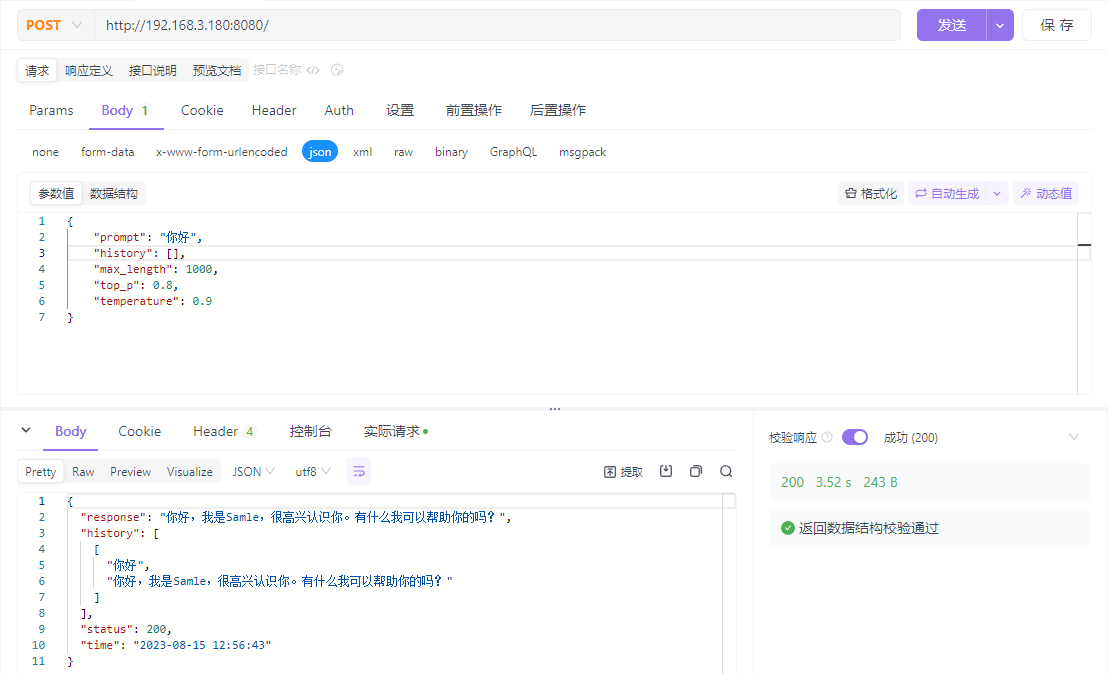

LLM大模型封装服务,不需加载,直接推理

一、前言

LLM十分火热,各种花样封装使用,但是每次infer的时候,加载模型都需要很久,那么就需要把服务挂载在服务器上,就不用每次infer都花那么多时间加载模型了。

二、使用fastapi或者flask

2.1 使用fastapi实现

使…

Think-on-Graph:基于知识图的大型语言模型的深层可靠推理11.12

Hink-on-Graph:基于知识图的大型语言模型的深层可靠推理 摘要1 引言2 方法2.1图上思考2.1.1图的初始化2.1.2 探索2.1.3推理 2.2 基于关系的Think on graph 摘要

尽管大型语言模型(LLM)在各种任务中取得了巨大的成功,但它们经常与…

ChatGPT的prompt技巧 心得

ChatGPT的prompt心得 写在最前面chatgpt咒语1(感觉最好用的竟然是这个,简单方便快捷,不需要多轮对话)chatgpt思维链2(复杂任务更适用,简单任务把他弄复杂了)机理chatgpt完整咒语1(感…

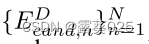

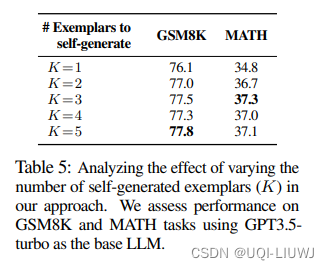

论文解读:Large Language Models as Analogical Reasoners

一、动机

大模型在各种类型的NLP任务上均展现出惊艳的表现。基于CoT propmt能够更好地激发大模型解决复杂推理问题的能力,例如解决数学解题,可以让模型生成reasoning path。现有的经典的CoT方法有few-shot cot、zero-shot cot等。然后现有的cot面临两个…

首发!动手学大模型应用开发教程来了

大模型正逐步成为信息世界的新革命力量,其通过强大的自然语言理解、自然语言生成能力,为开发者提供了新的、更强大的应用开发选择。随着国内外井喷式的大模型 API 服务开放,如何基于大模型 API 快速、便捷地开发具备更强能力、集成大模型的应…

大模型的全面回顾,看透大模型 | A Comprehensive Overview of Large Language Models

大模型的全面回顾:A Comprehensive Overview of Large Language Models 返回论文和资料目录

论文地址

1.导读

相比今年4月的中国人民大学发表的大模型综述,这篇综述角度更侧重于大模型的实现,更加硬核,更适合深入了解大模型的一…

用户交互引导大模型生成内容特征,LLM-Rec框架助力个性化推荐!

欢迎来到魔法宝库,传递AIGC的前沿知识,做有格调的分享❗

喜欢的话记得点个关注吧! 今天主要和大家分享一篇使用大语言模型做数据增强来提升推荐系统性能的研究 标题: LLM-Rec: Personalized Recommendation via Prompting Large …

【大语言模型】Docker部署清华大学ChatGLM3教程

官方地址:https://github.com/THUDM/ChatGLM3

1 将代码保存至本地

方法1:

git clone https://github.com/THUDM/ChatGLM3

方法2:

https://github.com/THUDM/ChatGLM3/archive/refs/heads/main.zip

2 创建Docker文件

注:请先…

Prevalence and prevention of large language model use in crowd work

本文是LLM系列文章,针对《Prevalence and prevention of large language model use in crowd work》的翻译。 众包工作中使用大型语言模型的流行率和预防 摘要1 研究1:LLM使用的普遍率2 研究2:LLM使用的预防3 讨论4 材料与方法 摘要

我们表…

Interview of ING internship for master thesis: LLM

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 1. Background2. Interview2.1 Intro2.2 project experience2.3 问题2.4 Q&A 总结 Interview of ING internship for master thesis: LLM 1. Background

Proje…

深入解析 Azure 机器学习平台:架构与组成部分

Azure机器学习平台是Microsoft Azure提供的一种云上机器学习服务,为开发者和数据科学家提供了一个全面且易于使用的环境来创建、训练、部署和管理机器学习模型。本文将对Azure机器学习平台的基本架构和组成部分进行深入解析,帮助读者全面了解该平台的工作…

Attention Is All You Need原理与代码详细解读

文章目录 前言一、Transformer结构的原理1、Transform结构2、位置编码公式3、transformer公式4、FFN结构 二、Encode模块代码解读1、编码数据2、文本Embedding编码3、位置position编码4、Attention编码5、FFN编码 三、Decode模块代码解读1、编码数据2、文本Embedding与位置编码…

世界互联网大会领先科技奖发布 百度知识增强大语言模型关键技术获奖

11月8日,2023年世界互联网大会乌镇峰会正式开幕,今年是乌镇峰会举办的第十年,本次峰会的主题为“建设包容、普惠、有韧性的数字世界——携手构建网络空间命运共同体”。 目录 百度知识增强大语言模型关键技术荣获“世界互联网大会领先科技奖”…

在Win11上部署ChatGLM2-6B详细步骤--(上)准备工作

一:简单介绍

ChatGLM-6B是清华大学知识工程和数据挖掘小组(Knowledge Engineering Group (KEG) & Data Mining at Tsinghua University)发布的一个开源的对话机器人。根据官方介绍,这是一个千亿参数规模的中英文语言模型。并…

零资源的大语言模型幻觉预防

零资源的大语言模型幻觉预防 摘要1 引言2 相关工作2.1 幻觉检测和纠正方法2.2 幻觉检测数据集 3 方法论3.1 概念提取3.2 概念猜测3.2.1 概念解释3.2.2 概念推理 3.3 聚合3.3.1 概念频率分数3.3.2 加权聚合 4 实验5 总结 摘要

大语言模型(LLMs)在各个领域…

大语言模型的三阶段训练

为了训练专有领域模型,选择LLaMA2-7B作为基座模型,由于LLaMA模型中文词表有限,因此首先进行中文词表的扩展,然后进行三阶段训练(增量预训练,有监督微调,强化学习)。

代码将全部上传…

开源语音大语言模型——Qwen-Audio

论文链接:https://arxiv.org/pdf/2311.07919.pdf

开源代码:https://github.com/QwenLM/Qwen-Audio 一、背景

大型语言模型(LLMs)由于其良好的知识保留能力、复杂的推理和解决问题能力,在通用人工智能(AGI…

LLM、ChatGPT与多模态必读论文150篇

为了写本 ChatGPT 笔记,我和10来位博士、业界大佬,在过去半年翻了大量中英文资料/paper,读完 ChatGPT 相关技术的150篇论文,当然还在不断深入。

由此而感慨:

读的论文越多,你会发现大部分人对ChatGPT的技…

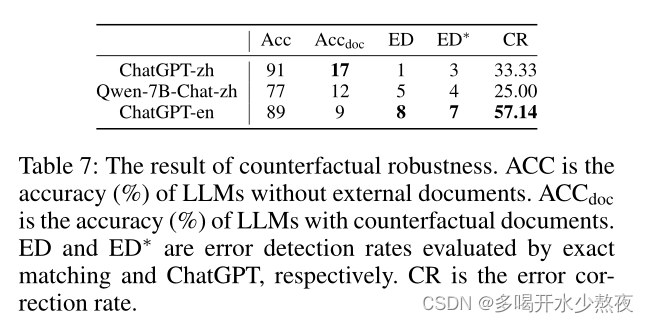

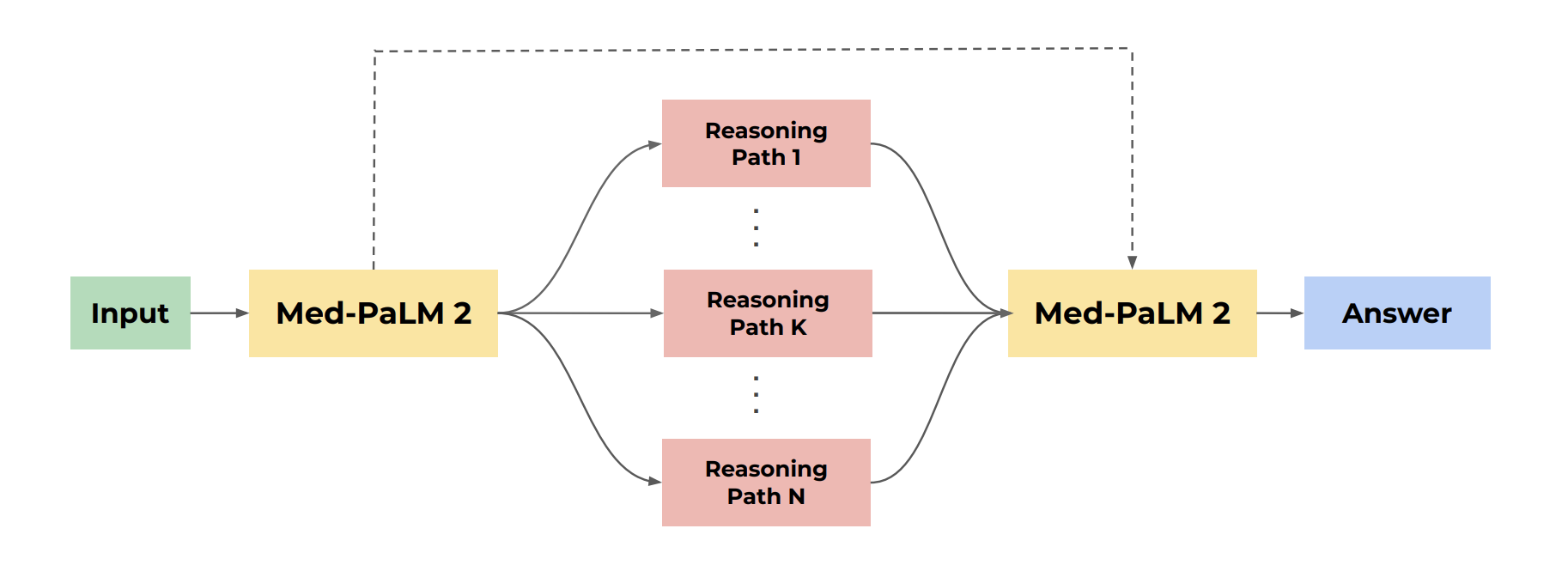

推理还是背诵?通过反事实任务探索语言模型的能力和局限性

推理还是背诵?通过反事实任务探索语言模型的能力和局限性 摘要1 引言2 反事实任务2.1 反事实理解检测 3 任务3.1 算术3.2 编程3.3 基本的句法推理3.4 带有一阶逻辑的自然语言推理3.5 空间推理3.6 绘图3.7 音乐3.8 国际象棋 结果5 分析5.1 反事实条件的“普遍性”5.2…

让 OpenAI GPT4 出 10 道题测试其他开源大语言模型

让 OpenAI GPT4 出 10 道题测试其他开源大语言模型 1. 中文题目及答案2. 日文题目及答案3. 英文题目及答案 1. 中文题目及答案 数学题:一个矩形的长是10厘米,宽是5厘米,求它的面积。 答案:面积 长 x 宽 10厘米 x 5厘米 50平方厘…

语言模型编码中/英文句子格式详解

文章目录 前言一、Bert的vocab.txt内容查看二、BERT模型转换方法(vocab.txt)三、vocab内容与模型转换对比四、中文编码总结 前言

最近一直在学习多模态大模型相关内容,特别是图像CV与语言LLM模型融合方法,如llama-1.5、blip、meta-transformer、glm等大…

亚马逊云科技大语言模型下的六大创新应用功能

目录

前言

亚马逊云科技的AI创新应用

编辑

Amazon CodeWhisperer

Amazon CodeWhisperer产品的优势

更快地完成更多工作 自信地进行编码

增强代码安全性

使用收藏夹工具

自定义 CodeWhisperer 以获得更好的建议

如何使用Amazon CodeWhisperer

步骤 1

步骤 2

具体…

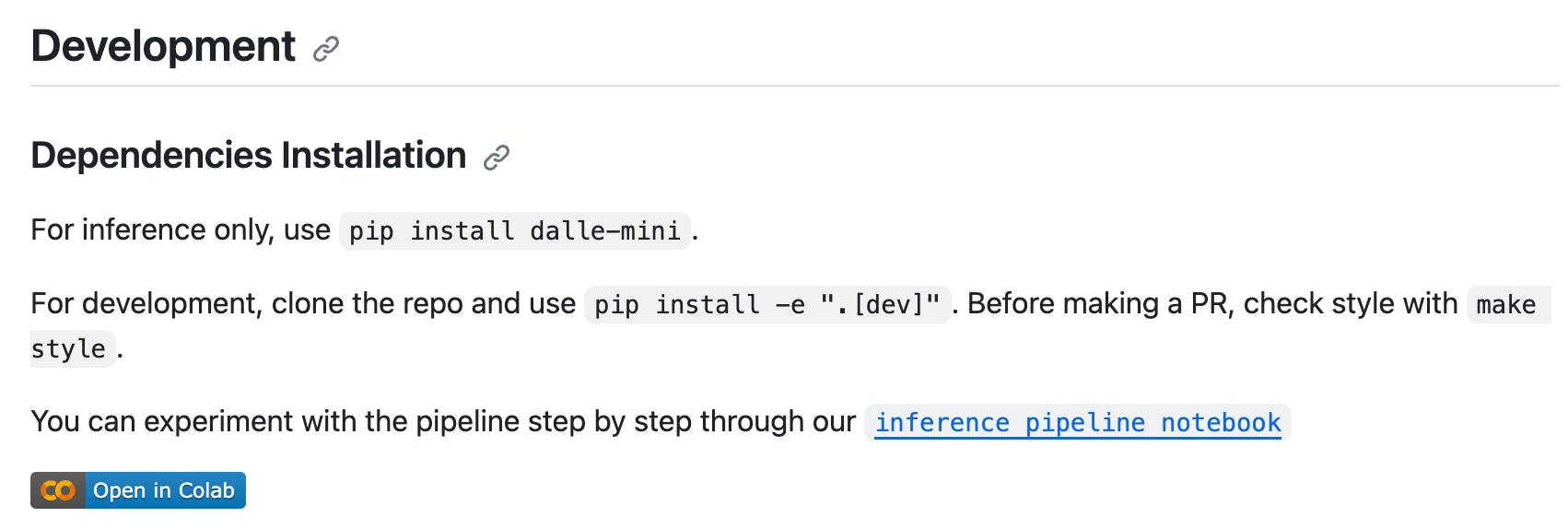

超详细!DALL · E 文生图模型实践指南

最近需要用到 DALLE的推断功能,在现有开源代码基础上发现还有几个问题需要注意,谨以此篇博客记录之。 我用的源码主要是 https://github.com/borisdayma/dalle-mini 仓库中的Inference pipeline.ipynb 文件。 运行环境:Ubuntu服务器

⚠️注意…

LangChain的函数,工具和代理(二):LangChain的表达式语言(LCEL)

LangChain Expression Language (LCEL) 是 LangChain 工具包的重要补充,旨在提高文本处理任务的效率和灵活性。LCEL 允许用户采用声明式方法来组合链,便于进行流处理、批处理和异步任务。其模块化架构还允许轻松定制和修改链组件。LCEL 的优势之一是它使…

大语言模型有那些能力和应用

目录

能力

应用 能力 理解语义的能力:LLM 具有强大的语义理解能力,能够理解大部分文本,包括不同语言(人类语言或计算机语言)和表达水平的文本,即使是多语言混杂、语法用词错误,也在多数情况下…

掌握大型语言模型(LLM)技术:推理优化

原文链接:Mastering LLM Techniques: Inference Optimization | NVIDIA Technical Blog 大模型相关技术文章已整理到Github仓库,欢迎start! 堆叠Transformer层以创建大型模型可以获得更好的准确性、few-shot学习能力,甚至在各种语言任务中具有…

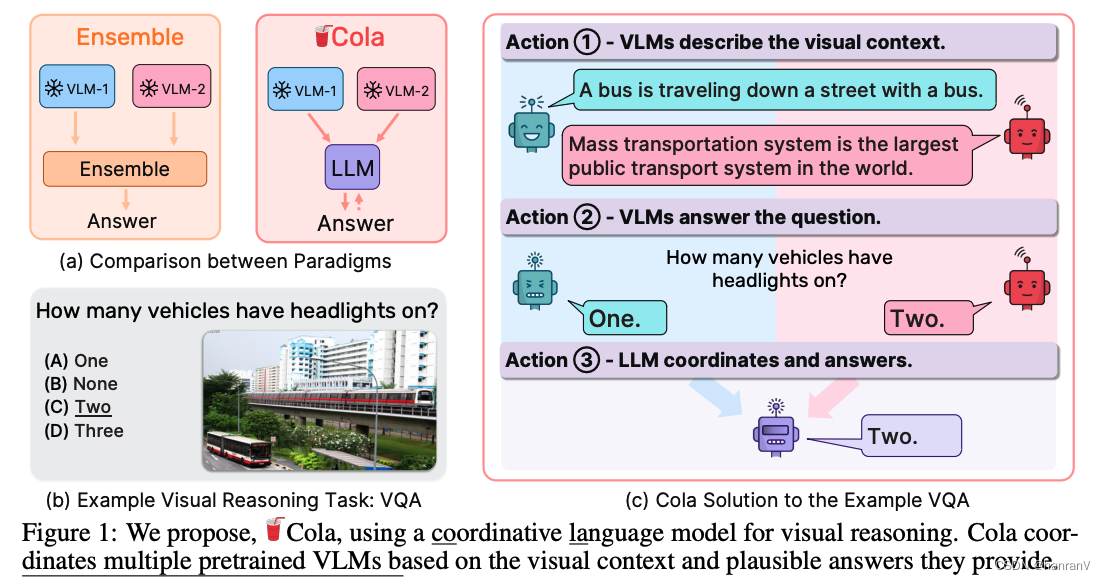

Large Language Models areVisual Reasoning Coordinators

目录

一、论文速读

1.1 摘要

1.2 论文概要总结

二、论文精度

2.1 论文试图解决什么问题?

2.2 论文中提到的解决方案之关键是什么?

2.3 用于定量评估的数据集是什么?代码有没有开源?

2.4 这篇论文到底有什么贡献࿱…

LLM推理部署(四):一个用于训练、部署和评估基于大型语言模型的聊天机器人的开放平台FastChat

FastChat是用于对话机器人模型训练、部署、评估的开放平台。体验地址为:https://chat.lmsys.org/,该体验平台主要是为了收集人类的真实反馈,目前已经支持30多种大模型,已经收到500万的请求,收集了10万调人类对比大模型…

【通义千问】大模型Qwen GitHub开源工程学习笔记(4)-- 模型的量化与离线部署

摘要:

量化方案基于AutoGPTQ,提供了Int4量化模型,其中包括Qwen-7B-Chat和Qwen-14B-Chat。更新承诺在模型评估效果几乎没有损失的情况下,降低存储要求并提高推理速度。量化是指将模型权重和激活的精度降低以节省存储空间并提高推理速度的过程。AutoGPTQ是一种专有量化工具。…

Continual Pre-Training of Large Language Models: How to (re)warm your model?

本文是LLM系列文章,针对《Continual Pre-Training of Large Language Models: How to (re)warm your model?》的翻译。 大型语言模型的持续预训练:如何(重新)预热你的模型 摘要1 引言2 设置3 相关工作4 持续加热5 讨论/局限性6 …

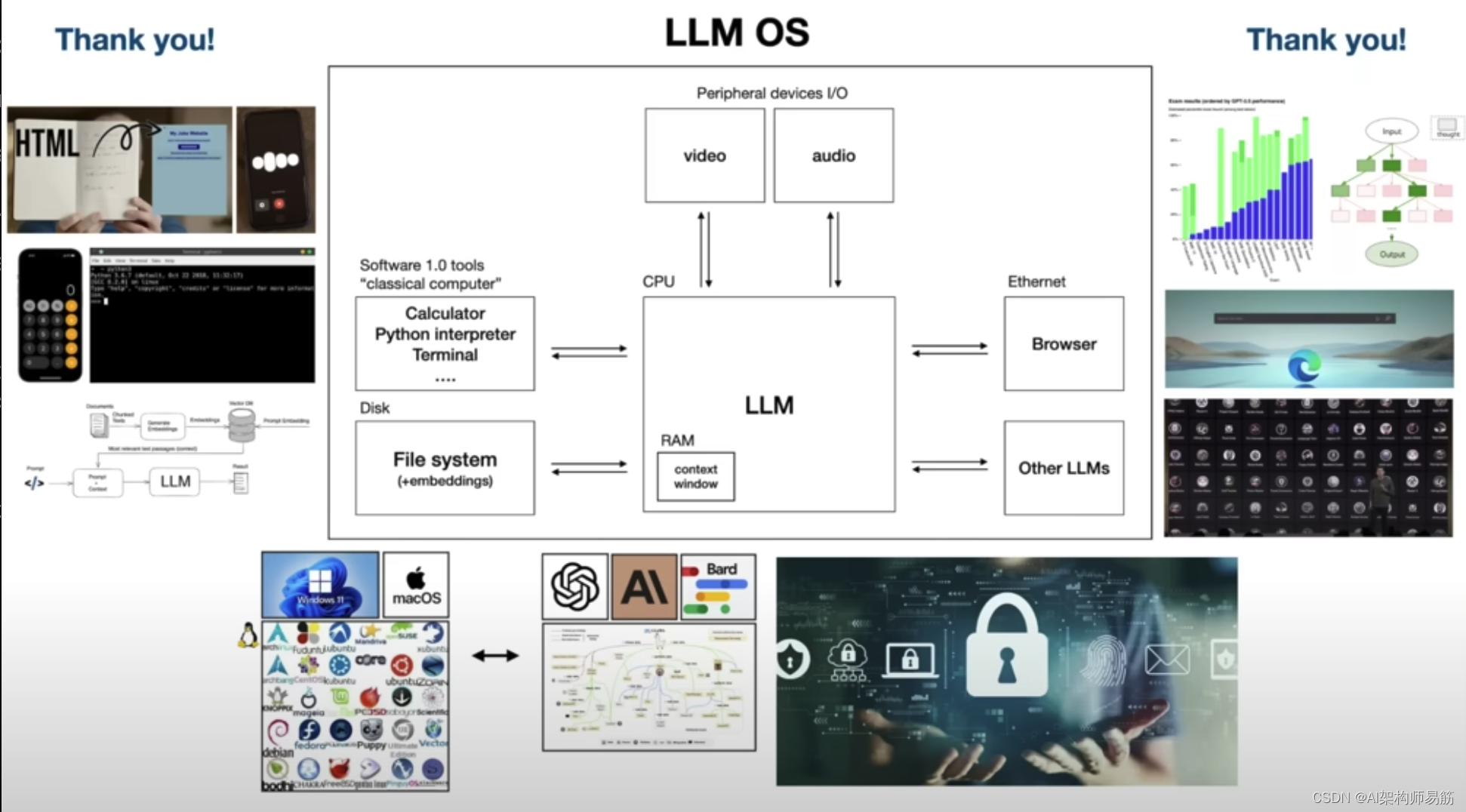

翻译: GPT4等大型语言模型的原理解析和未来预测慢思考和模型自我迭代和LLM安全

YouTube: Intro to Large Language Models - YouTube

1. Large Language Model LLM 大家好,最近我做了一个关于大型语言模型的 30 分钟演讲,有点像介绍性演讲,不幸的是,那个演讲没有被录制下来,但很多人在演讲结束后…

COGVLM论文解读(COGVLM:VISUAL EXPERT FOR LARGE LANGUAGE MODELS)

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、摘要二、引言三、模型方法1、模型思路2、融合公式 四、训练方法总结 前言

2023年5月18日清华&智谱AI发布并开源VisualGLM-6B以来,清华KEG&…

LLM-Intro to Large Language Models

LLM

some LLM’s model and weight are not opened to user

what is?

Llama 270b model 2 files parameters file parameter or weight of neural networkparameter – 2bytes, float number code run parameters(inference) c or python, etcfor c, 500 lines code withou…

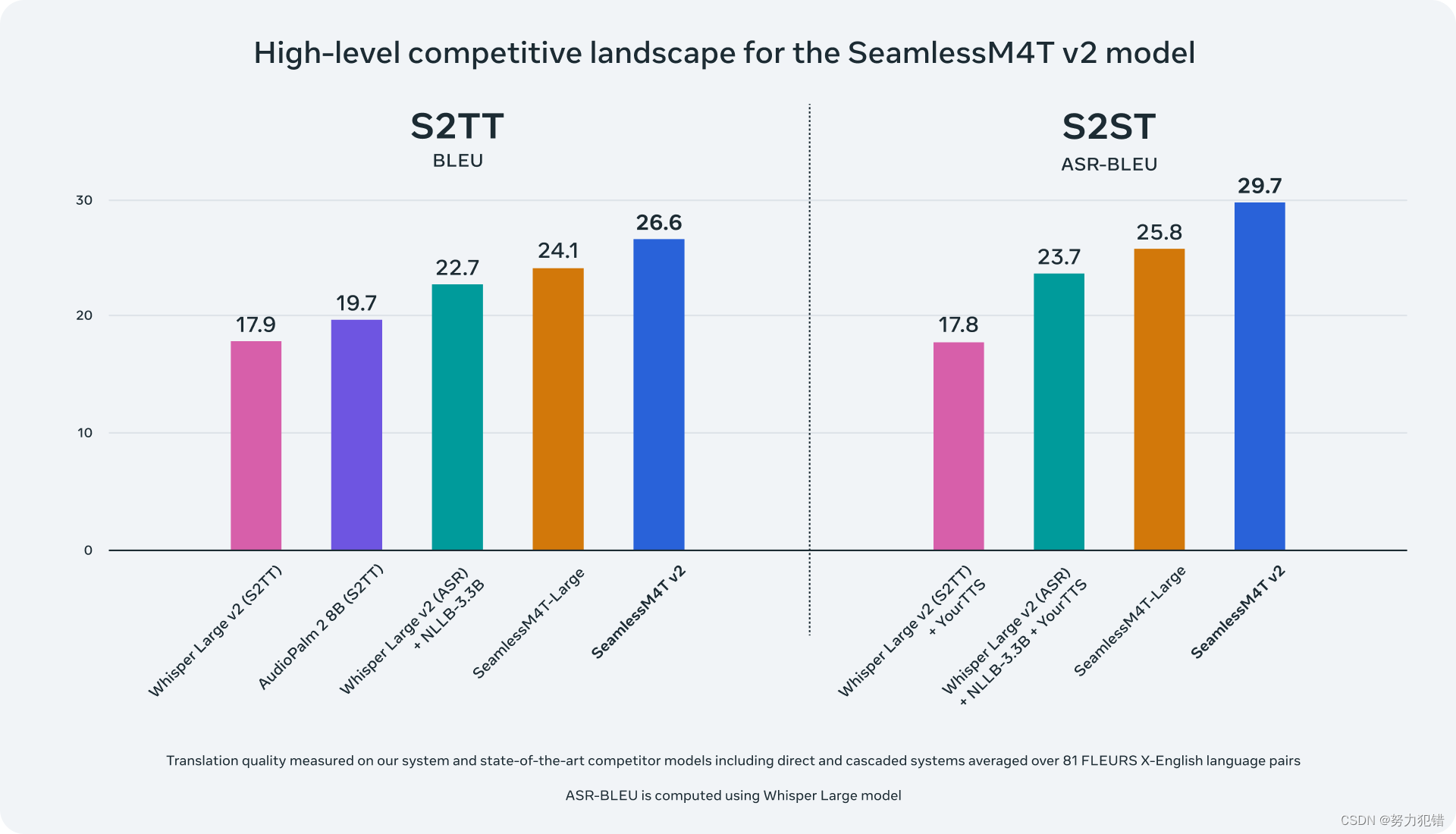

Meta推出了一套开源AI语言翻译模型,这些模型不仅能保留说话的表达方式,还能提升流式翻译的效果

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

CLIP:万物分类(视觉语言大模型)

本文来着公众号“AI大道理”

论文地址:https://arxiv.org/abs/2103.00020 传统的分类模型需要先验的定义固定的类别,然后经过CNN提取特征,经过softmax进行分类。然而这种模式有个致命的缺点,那就是想加入新的一类就得重新定义…

ChatGLM3本地部署运行(入门体验级)

文章目录 前言零 硬件小白基知填坑eForce Game Ready驱动程序CUDA常用命令 环境准备NVIDIA驱动更新CUDA安装 部署补充内容体验 前言

学习自B站up主技术爬爬虾,感谢up主提供的整合包!

零 硬件

6GB以上显存的NVIDIA显卡(品质越高,…

Elasticsearch:检索增强生成 (Retrieval Augmented Generation -RAG)

作者:JOE MCELROY

什么是检索增强生成 (RAG) 以及该技术如何通过提供相关源知识作为上下文来帮助提高 LLMs 生成的响应的质量。 生成式人工智能最近取得了巨大的成功和令人兴奋的成果,其模型可以生成流畅的文本、逼真的图像,甚至视频。 就语…

机器学习硬件十年:性能变迁与趋势

本文分析了机器学习硬件性能的最新趋势,重点关注不同GPU和加速器的计算性能、内存、互连带宽、性价比和能效等指标。这篇分析旨在提供关于ML硬件能力及其瓶颈的全面视图。本文作者来自调研机构Epoch,致力于研究AI发展轨迹与治理的关键问题和趋势。 &…

亚马逊云AI大语言模型应用下的创新Amazon Transcribe的使用

Transcribe简介

语音识别技术,也被称为自动语音识别(Automatic Speech Recognition,简称ASR),其目标是将人类的语音中的词汇内容转换为计算机可读的输入,例如按键、二进制编码或者字符序列。语音识别技术已…

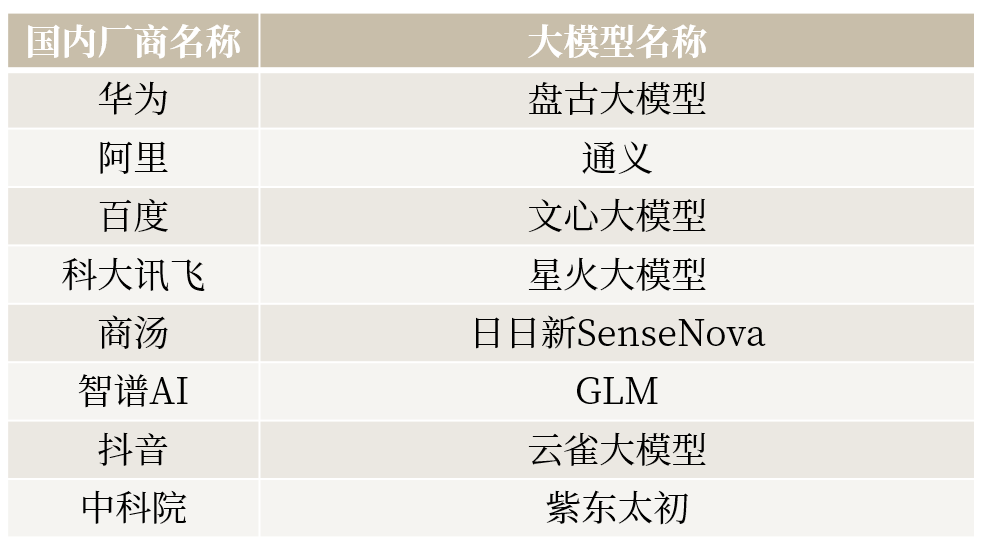

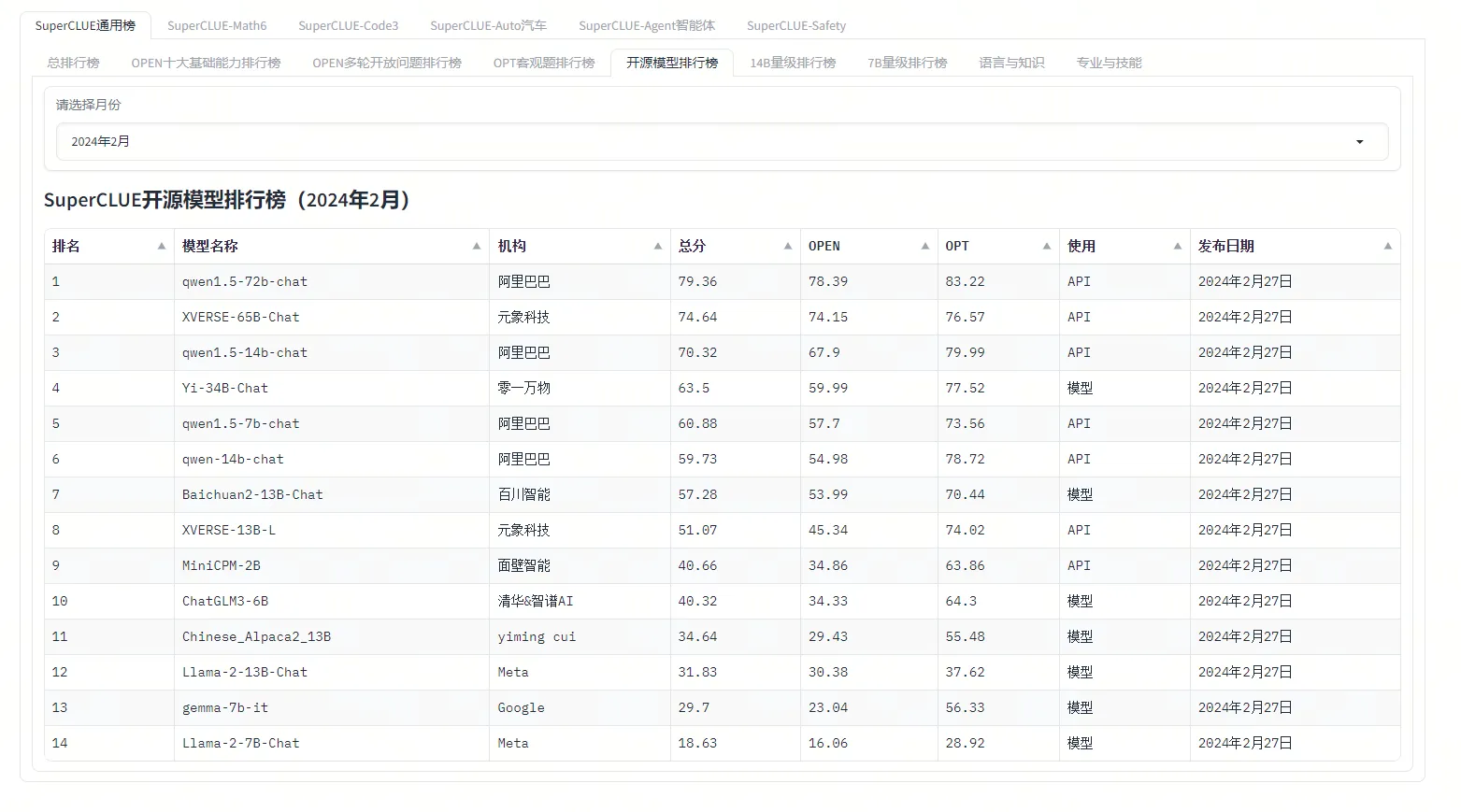

国内LLMs大型语言模型排行榜!

在人工智能领域,语言模型是一种被广泛应用的技术。它能够理解和生成人类语言,为我们的生活和工作带来了很多便利。

在国内,有许多大型语言模型在不断发展和进步,为用户提供更好的语言交互体验。下面就让我们来看看国内大型语言模…

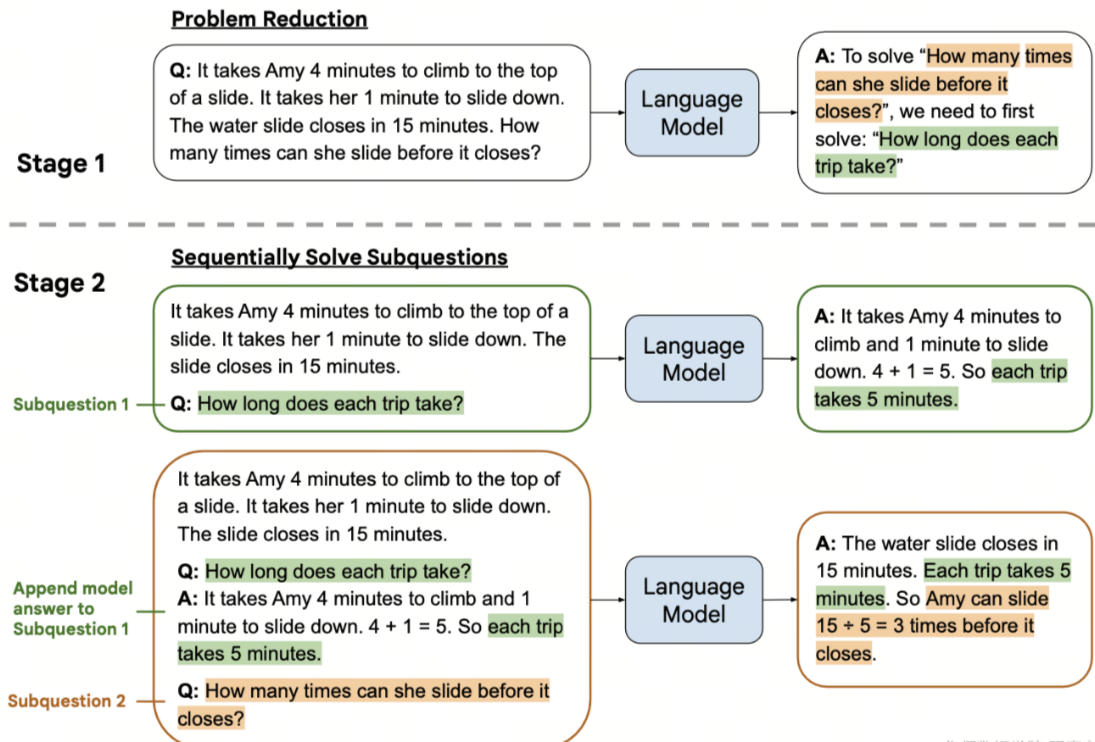

基于大语言模型的复杂任务认知推理算法CogTree

近日,阿里云人工智能平台PAI与华东师范大学张伟教授团队合作在自然语言处理顶级会议EMNLP2023上发表了基于认知理论所衍生的CogTree认知树生成式语言模型。通过两个系统:直觉系统和反思系统来模仿人类产生认知的过程。直觉系统负责产生原始问题的多个分解…

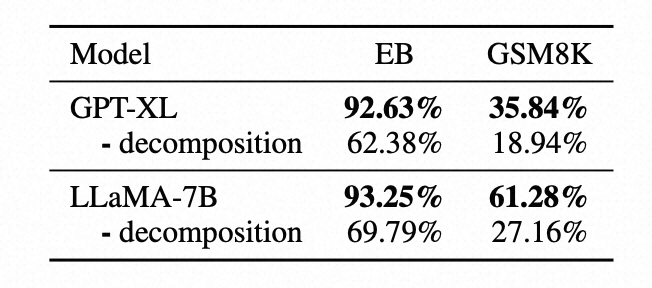

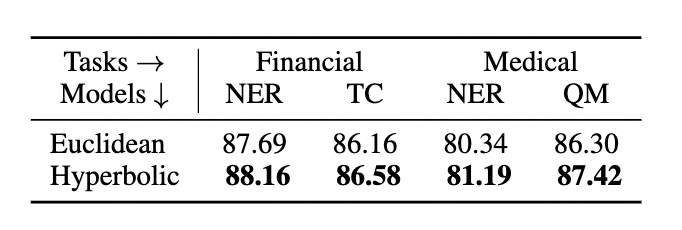

【EMNLP 2023】面向垂直领域的知识预训练语言模型

近日,阿里云人工智能平台PAI与华东师范大学数据科学与工程学院合作在自然语言处理顶级会议EMNLP2023上发表基于双曲空间和对比学习的垂直领域预训练语言模型。通过比较垂直领域和开放领域知识图谱数据结构的不同特性,发现在垂直领域的图谱结构具有全局稀…

ChatGLM3-6B:新一代开源双语对话语言模型,流畅对话与低部署门槛再升级

项目设计集合(人工智能方向):助力新人快速实战掌握技能、自主完成项目设计升级,提升自身的硬实力(不仅限NLP、知识图谱、计算机视觉等领域):汇总有意义的项目设计集合,助力新人快速实…

LangChain 26: 回调函数callbacks打印prompt verbose调用

LangChain系列文章

LangChain 实现给动物取名字,LangChain 2模块化prompt template并用streamlit生成网站 实现给动物取名字LangChain 3使用Agent访问Wikipedia和llm-math计算狗的平均年龄LangChain 4用向量数据库Faiss存储,读取YouTube的视频文本搜索I…

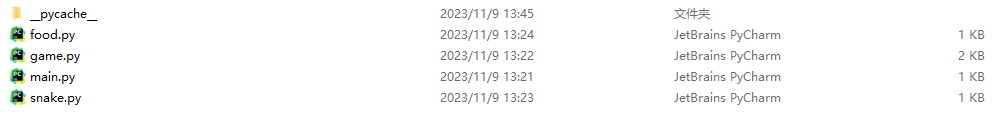

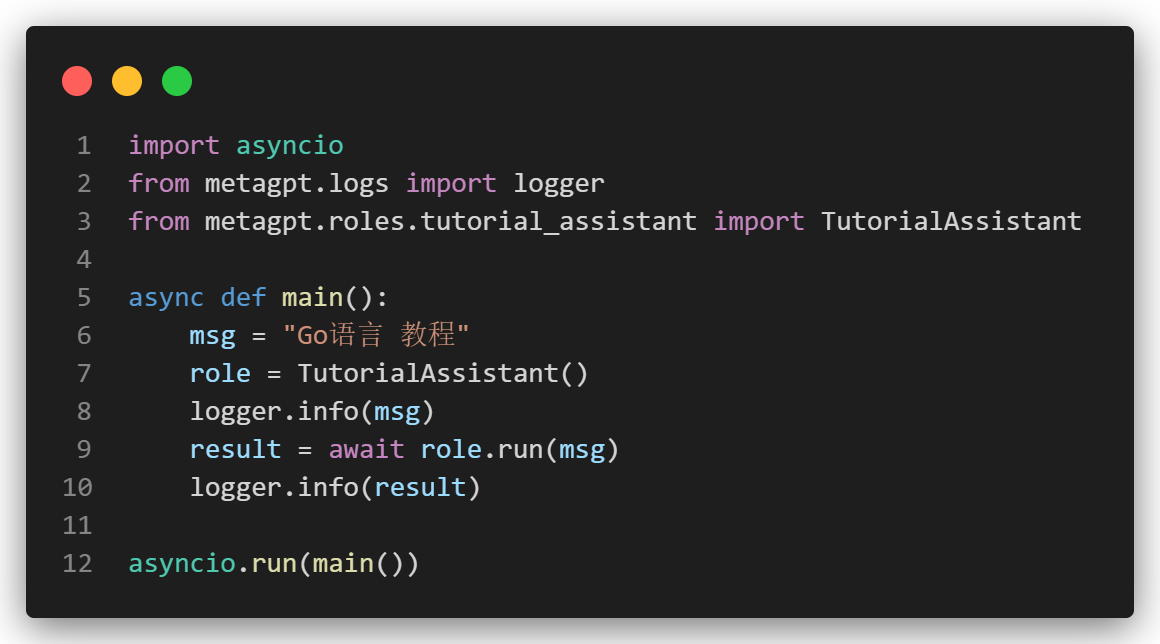

Python大语言模型实战-利用MetaGPT框架自动开发一个游戏软件(附完整教程)

实现功能

MetaGPT是一个应用在软件开发领域的多智能体框架,其主要创新点在于将SOP标准流水线和Agent结合在了一起,使得拥有不同技能的Role之间配合完成一项较为复杂的任务。本文将用一个案例来演示整个流程。

实现代码 项目地址:https://gi…

LLM中的Prompt提示

简介

在LLM中,prompt(提示)是一个预先设定的条件,它可以限制模型自由发散,而是围绕提示内容进行展开。输入中添加prompt,可以强制模型关注特定的信息,从而提高模型在特定任务上的表现。 结构

…

开源语音大语言模型来了!阿里基于Qwen-Chat提出Qwen-Audio!

论文链接:https://arxiv.org/pdf/2311.07919.pdf

开源代码:https://github.com/QwenLM/Qwen-Audio

引言

大型语言模型(LLMs)由于其良好的知识保留能力、复杂的推理和解决问题能力,在通用人工智能(AGI&am…

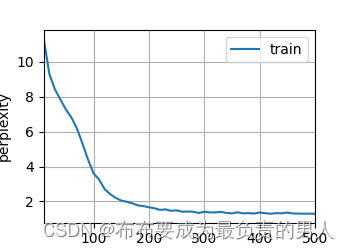

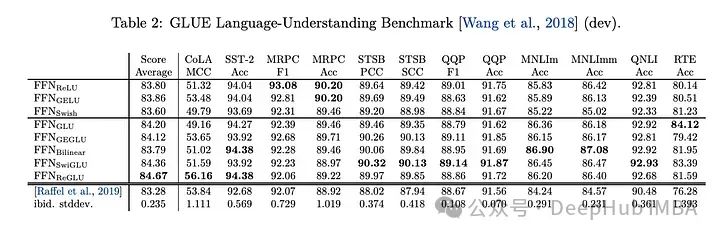

【UCAS自然语言处理作业二】训练FFN, RNN, Attention机制的语言模型,并计算测试集上的PPL

前言

本次实验主要针对前馈神经网络,RNN,以及基于注意力机制的网络学习语言建模任务,并在测试集上计算不同语言模型的PPL

PPL计算:我们采用teacher forcing的方式,给定ground truth context,让其预测next…

LLaMA 2:开源的预训练和微调语言模型推理引擎 | 开源日报 No.86

facebookresearch/llama

Stars: 36.0k License: NOASSERTION

LLaMA 2 是一个开源项目,用于加载 LLaMA 模型并进行推理。

该项目的主要功能是提供预训练和微调后的 LLaMA 语言模型的权重和起始代码。这些模型参数范围从 7B 到 70B 不等。

以下是该项目的关键特性…

多模态大模型总结1(2021和2022年)

常用损失函数

ITC (image-text contrasctive loss)

CLIP中采用的对比损失,最大化配对文本对的余弦相似度,最小化非配对文本对的余弦相似度,采用交叉熵损失实现

MLM (masked language modeling࿰…

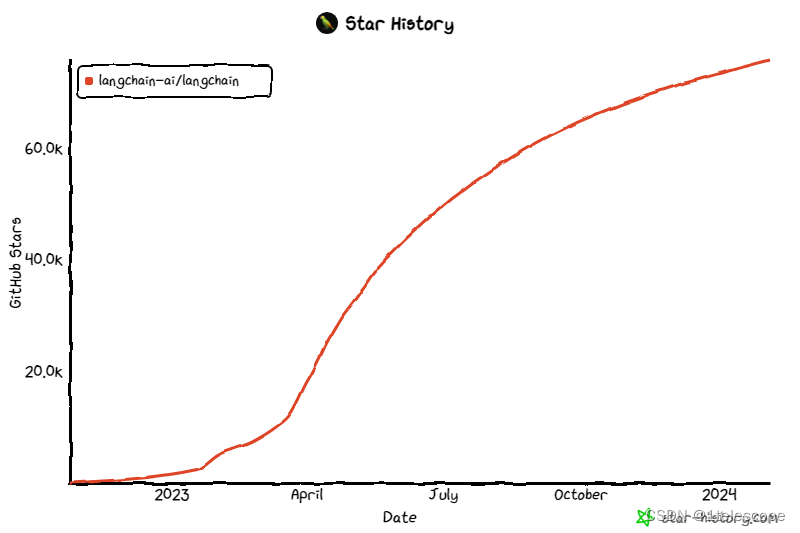

AIGC|LangChain新手入门指南,5分钟速读版!

如果你用大语言模型来构建AI应用,那你一定不可能绕过LangChain,LangChain是现在最热门的AI应用框架之一,去年年底才刚刚发布,它在github上已经有了4.6万颗星的点赞了,在github社区上,每天都有众多大佬,用它…

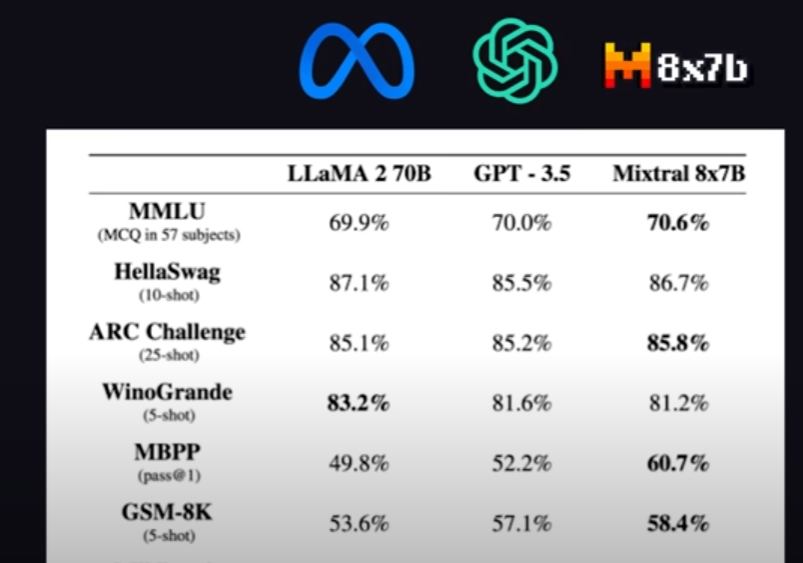

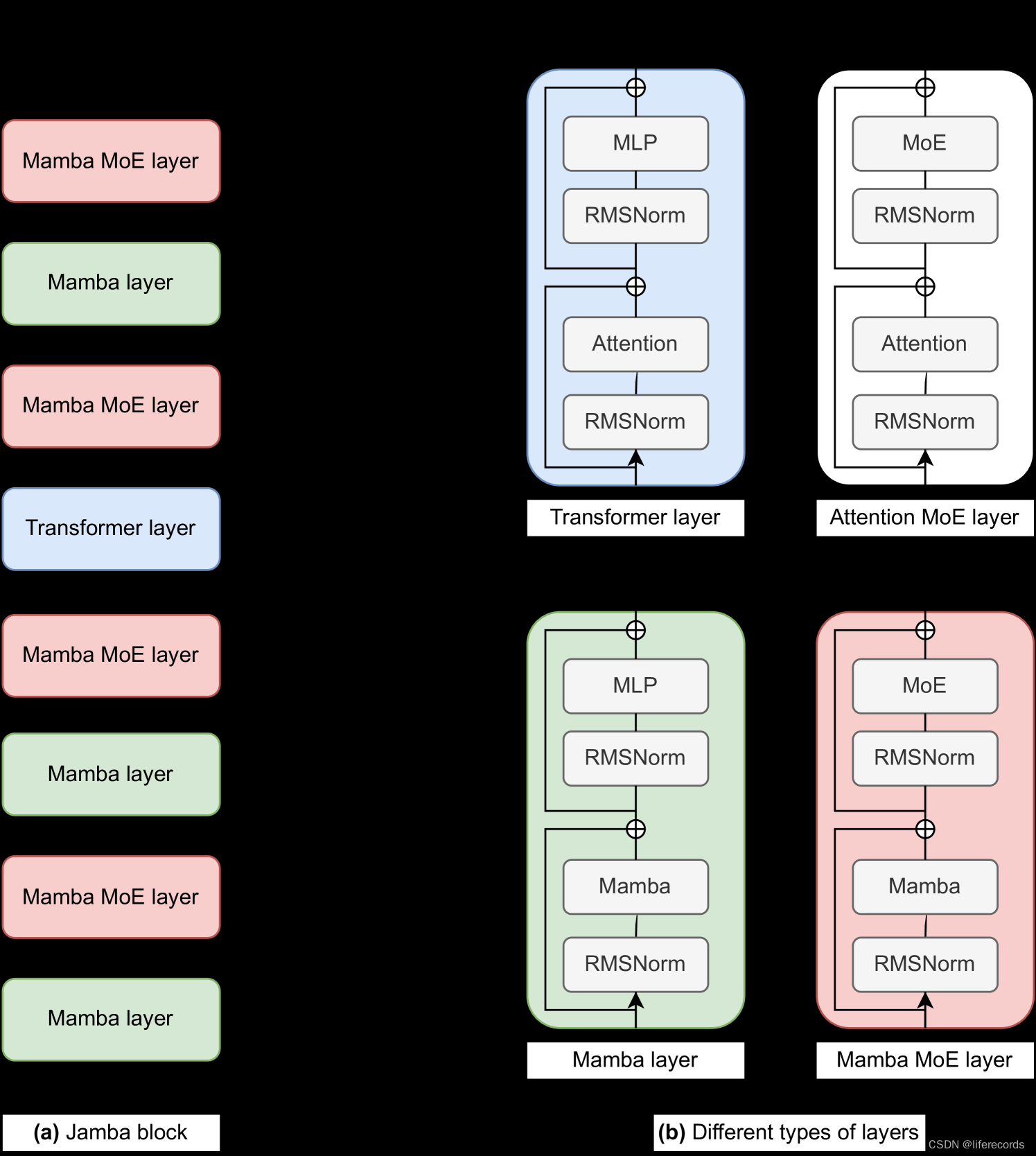

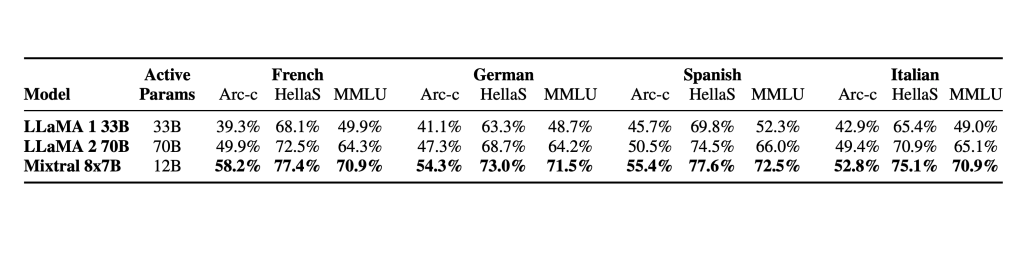

MistralAI发布全球首个MoE大模型-Mixtral 8x7B,创新超越GPT-4

引言

MistralAI,一家法国的初创企业,近期在AI界引发了轰动,刚刚发布了全球首个基于MoE(Mixture of Experts,混合专家)技术的大型语言模型——Mistral-8x7B-MoE。这一里程碑事件标志着AI技术的一个重要突破…

大语言模型的好坏是由您提示水平高底决定的

大语言模型是有"嫌贫爱富“特点的,当你的水平高于大语言模型时它常常可以帮你,当你的水平低于大语言模型时它往往会骗你。 这主要是因为大语言模型在处理文本时具有较强的生成能力,可以根据已有的语境生成合乎逻辑的文本。当你的水平高于…

大语言模型(LLMs)在 Amazon SageMaker 上的动手实践(一)

本期文章,我们将通过三个动手实验从浅到深地解读和演示大语言模型(LLMs),如何结合 Amazon SageMaker 的模型部署、模型编译优化、模型分布式训练等。

实验一:使用 Amazon SageMaker 构建基于开源 GPT-J 模型的对话机器…

用通俗的方式讲解Transformer:从Word2Vec、Seq2Seq逐步理解到GPT、BERT

直到今天早上,刷到CSDN一篇讲BERT的文章,号称一文读懂,我读下来之后,假定我是初学者,读不懂。

关于BERT的笔记,其实一两年前就想写了,迟迟没动笔的原因是国内外已经有很多不错的资料࿰…

序列模型,语言模型,RNN的相关概念

序列模型,语言模型,RNN

循环神经网络(RNN)通过引入状态变量来存储过去的信息和当前的输入,从而确定当前的输出。这种结构使得RNN非常适合处理序列信息,因为它可以捕捉到序列中的时间依赖性。这与卷积神经网…

综述 | 揭秘高效大型语言模型:技术、方法与应用展望

深度学习自然语言处理 原创作者:Xnhyacinth 近年来,大型语言模型(LLMs)在自然语言处理领域取得了显著的进展,如GPT-series(GPT-3, GPT-4)、Google-series(Gemini, PaLM), Meta-series(LLAMA1&2), BLOOM, GLM等模型…

快速了解ChatGPT(大语言模型)

目录

GPT原理:文字接龙,输入一个字,后面会接最有可能出现的文字。

GPT4

学会提问:发挥语言模型的最大能力 参考李宏毅老师的课快速了解大语言模型做的笔记:

Lee老师幽默的开场: GPT:chat Ge…

2023年度佳作:AIGC、AGI、GhatGPT、人工智能大语言模型的崛起与挑战

目录 前言

01 《ChatGPT 驱动软件开发》

内容简介

02 《ChatGPT原理与实战》

内容简介

03 《神经网络与深度学习》

04 《AIGC重塑教育》

内容简介

05 《通用人工智能》

目 录 前言

2023年是人工智能大语言模型大爆发的一年,一些概念和英文缩写也在这一…

WebLangChain_ChatGLM:结合 WebLangChain 和 ChatGLM3 的中文 RAG 系统

WebLangChain_ChatGLM 介绍 本文将详细介绍基于网络检索信息的检索增强生成系统,即 WebLangChain。通过整合 LangChain,成功将大型语言模型与最受欢迎的外部知识库之一——互联网紧密结合。鉴于中文社区中大型语言模型的蓬勃发展,有许多可供利…

熬了一个通宵,把国内外的大模型都梳理完了!

大家好,大模型越来越多了,真的有点让人眼花缭乱。

为了让大家清晰地了解大模型,我熬了一个通宵把国内和国外的大模型进行了全面梳理,国内有189个,国外有20,同时包括大模型的来源机构、来源信息和分类等。 …

【Datawhale 大模型基础】第六章 大模型的模型架构(英文版)

第六章 大模型的模型架构(英文版)

In the previous blog, I discussed the training data of LLMs and their data scheduling methods. This blog will focus on another important aspect of LLMs: model architecture. Due to the complexity and di…

LLMs 玩狼人杀:清华大学验证大模型参与复杂交流博弈游戏的能力

作者:彬彬 编辑:李宝珠,三羊 清华大学研究团队提出了一种用于交流游戏的框架,展示了大语言模型从经验中学习的能力,还发现大语言模型具有非预编程的策略行为,如信任、对抗、伪装和领导力。 近年来&#x…

ChatGPT 发布了免费提示指南 用PROMPT法打造完美的ChatGPT对话

ChatGPT 刚刚发布了免费提示指南。

但大多数人仍在为课程付费。

这里有 6 种免费策略,可以帮助您获得更好的即时结果: 1. 明确的指示

→ 准确表达您的要求。 → 对于简短的回复,请提及。 → 需要更多细节?直接询问。 → 展示您…

2023ChatGPT浪潮,2024开源大语言模型会成王者?

《2023ChatGPT浪潮,2024开源大语言模型会成王者?》

一、2023年的回顾

1.1、背景

我们正迈向2023年的终点,回首这一年,技术行业的发展如同车轮滚滚。尽管互联网行业在最近几天基本上处于冬天,但在这一年间我们仍然经…

详细介绍如何使用 SSD 进行实时物体检测:单次 MultiBox 探测器-含源码

介绍

在实时对象检测中,主流范例传统上采用多步骤方法,包括边界框、像素或特征重采样以及高质量分类器应用的提议。虽然这种方法已经实现了高精度,但其计算需求往往阻碍了其对实时应用的适用性。然而,单次多框检测器 (SSD) 代表了基于深度学习的对象检测的突破性飞跃。SSD…

大型语言模型:SBERT — Sentence-BERT

slavahead 一、介绍 Transformer 在 NLP 方面取得了进化进步,这已经不是什么秘密了。基于转换器,许多其他机器学习模型已经发展起来。其中之一是BERT,它主要由几个堆叠的变压器编码器组成。除了用于情感分析或问答等一系列不同的问题外&#…

从零构建属于自己的GPT系列2:模型训练1(预训练中文模型加载、中文语言模型训练、逐行代码解读)

🚩🚩🚩Hugging Face 实战系列 总目录 有任何问题欢迎在下面留言 本篇文章的代码运行界面均在PyCharm中进行 本篇文章配套的代码资源已经上传 从零构建属于自己的GPT系列1:数据预处理 从零构建属于自己的GPT系列2:模型训…

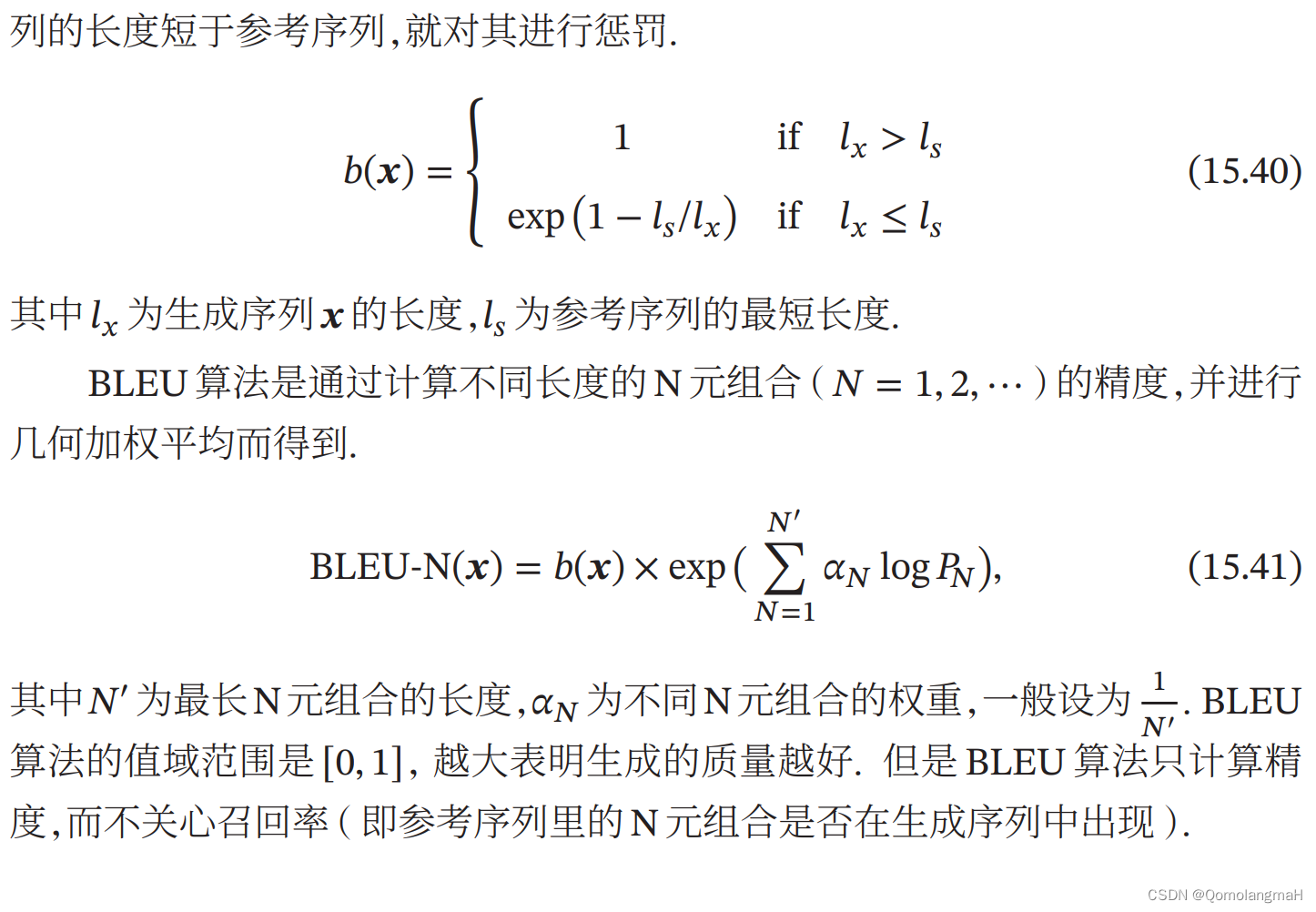

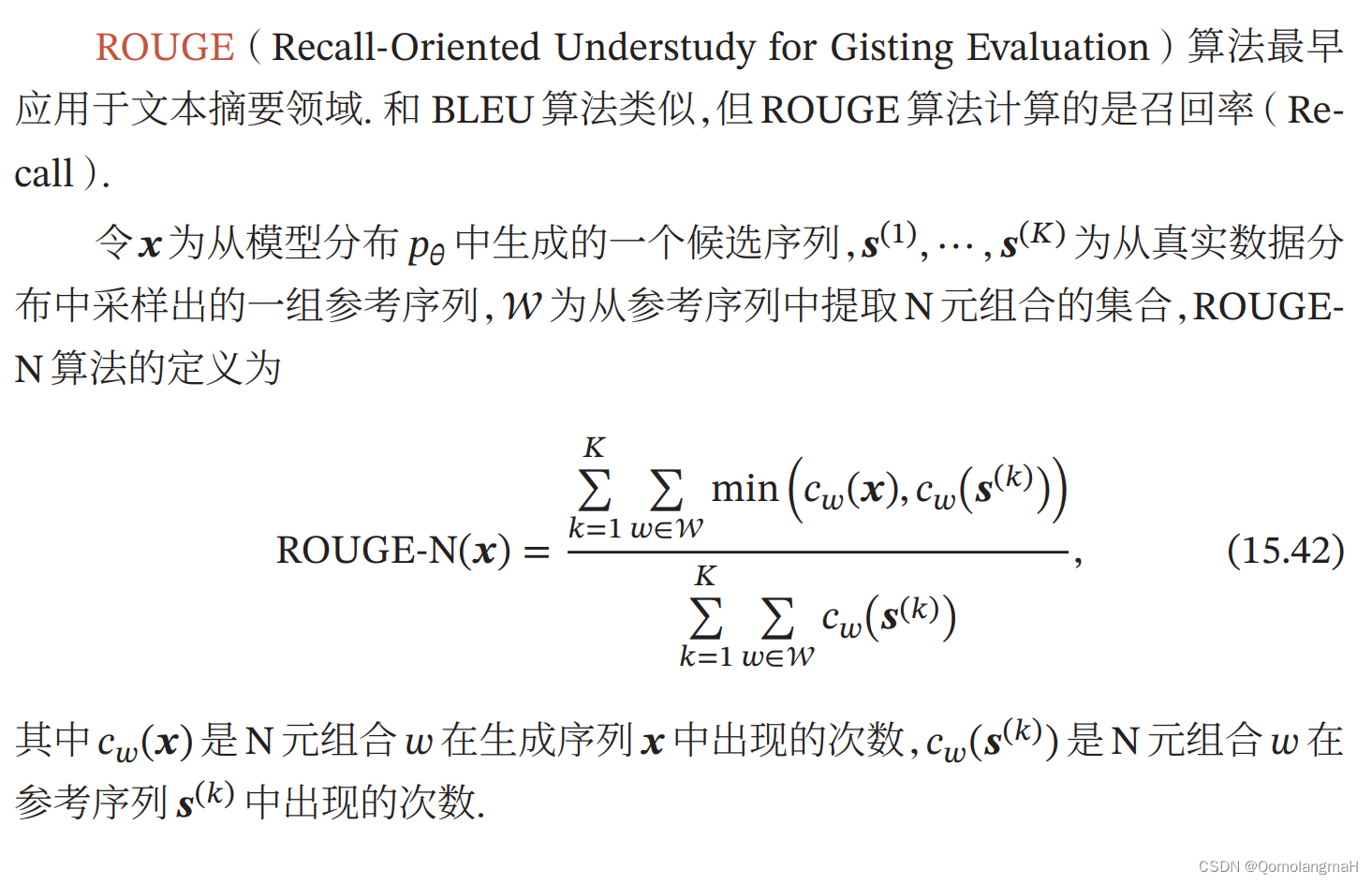

【深度学习】序列生成模型(五):评价方法计算实例:计算BLEU-N得分【理论到程序】

文章目录 一、BLEU-N得分(Bilingual Evaluation Understudy)1. 定义2. 计算N1N2BLEU-N 得分 3. 程序 给定一个生成序列“The cat sat on the mat”和两个参考序列“The cat is on the mat”“The bird sat on the bush”分别计算BLEU-N和ROUGE-N得分(N1或…

ELasticsearch:什么是语义搜索?

语义搜索定义

语义搜索是一种解释单词和短语含义的搜索引擎技术。 语义搜索的结果将返回与查询含义匹配的内容,而不是与查询中的单词字面匹配的内容。

语义搜索是一组搜索引擎功能,其中包括根据搜索者的意图及其搜索上下文理解单词。

此类搜索旨在通过…

Elasticsearch:什么是大语言模型(LLM)?

大语言模型定义

大语言模型 (LLM) 是一种深度学习算法,可以执行各种自然语言处理 (natural language processing - NLP) 任务。 大型语言模型使用 Transformer 模型,并使用大量数据集进行训练 —— 因此规模很大。 这使他们能够识别、翻译、预测或生成文…

大语言模型Prompt设计学习记录:Magic words(魔法词)的作用

文章目录 “扮演”或“成为”类指令:“总结”或“概述”类指令:“比较”或“对比”类指令:“解释”或“定义”类指令:“继续”或“接下来”类指令:“转换”或“改写”类指令: 在大语言模型中,Ma…

探索无监督域自适应,释放语言模型的力量:基于检索增强的情境学习实现知识迁移...

深度学习自然语言处理 原创作者: Xnhyacinth 在自然语言处理(NLP)领域,如何有效地进行无监督域自适应(Unsupervised Domain Adaptation, UDA) 一直是研究的热点和挑战。无监督域自适应的目标是在目标域无标签的情况下,将源域的知识…

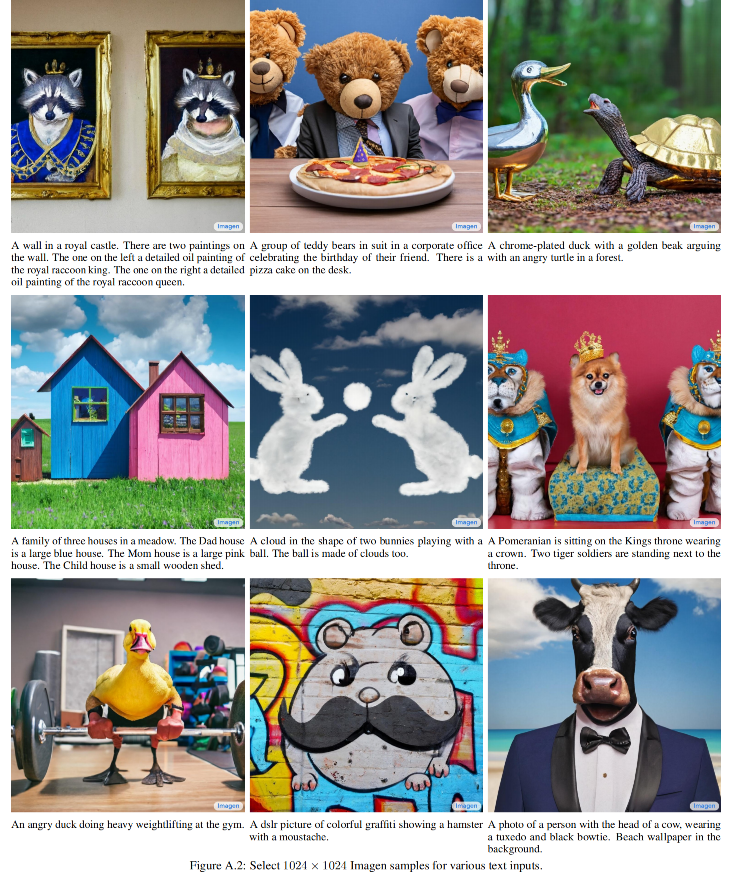

【扩散模型】9、Imagen | 借用语言模型的能力来实现文生图(NIPS2022 Oral)

文章目录 一、背景二、方法2.1 预训练的语言编码器2.2 扩散模型和 classifier-free guidance 三、效果 论文:Imagen: Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding

官网:https://www.assemblyai.com/blog/how-imag…

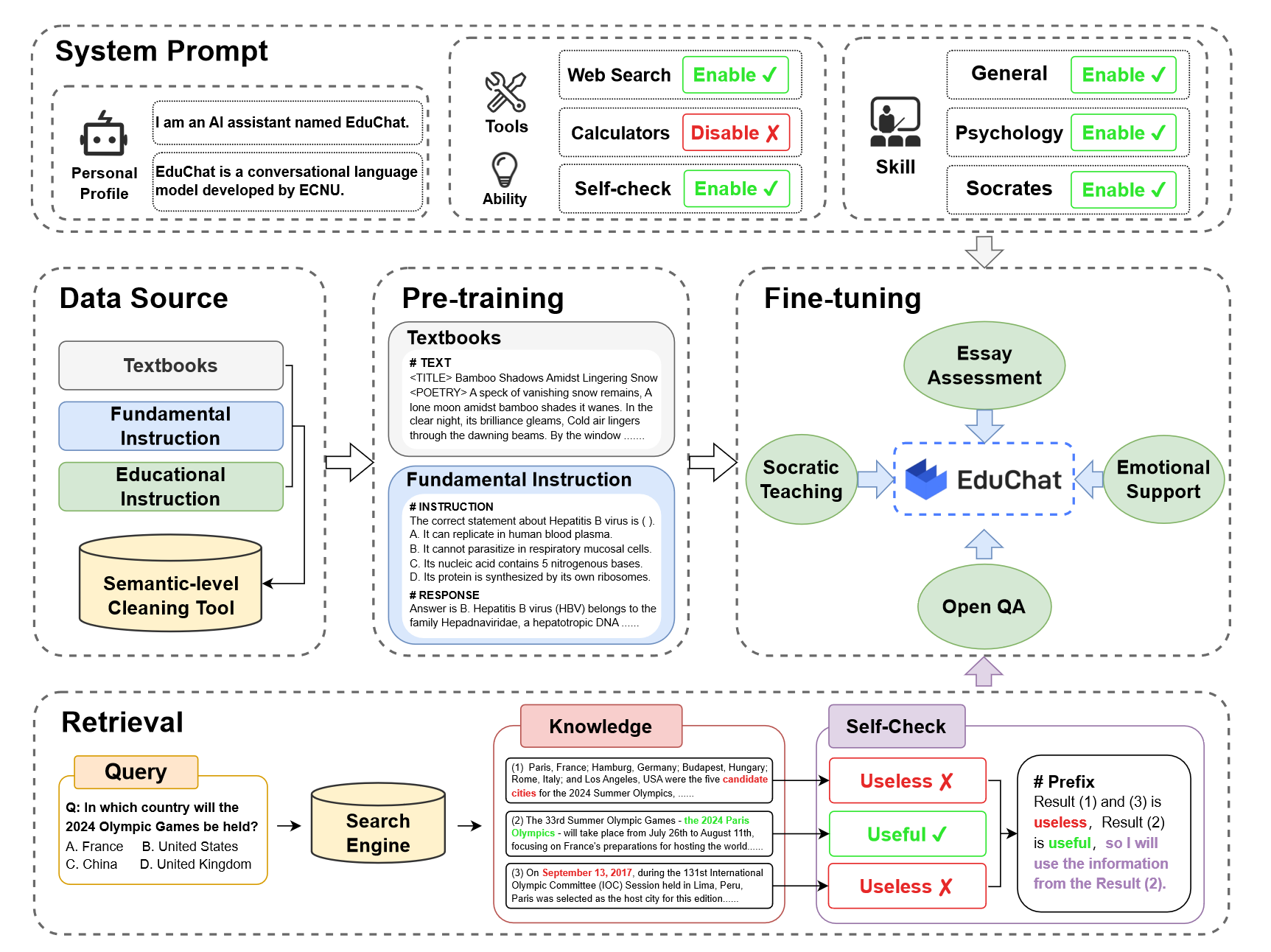

【学习笔记】LLM for Education

ChatGPT has entered the classroom: how LLMs could transform education 前言IntroductionThe risks are realEmbracing LLMsIntroducing the AI tutorAugmenting retrievalWill it catch on?总结 前言

一篇来自Nature的文章,探讨了教育行业的不同参与者&#x…

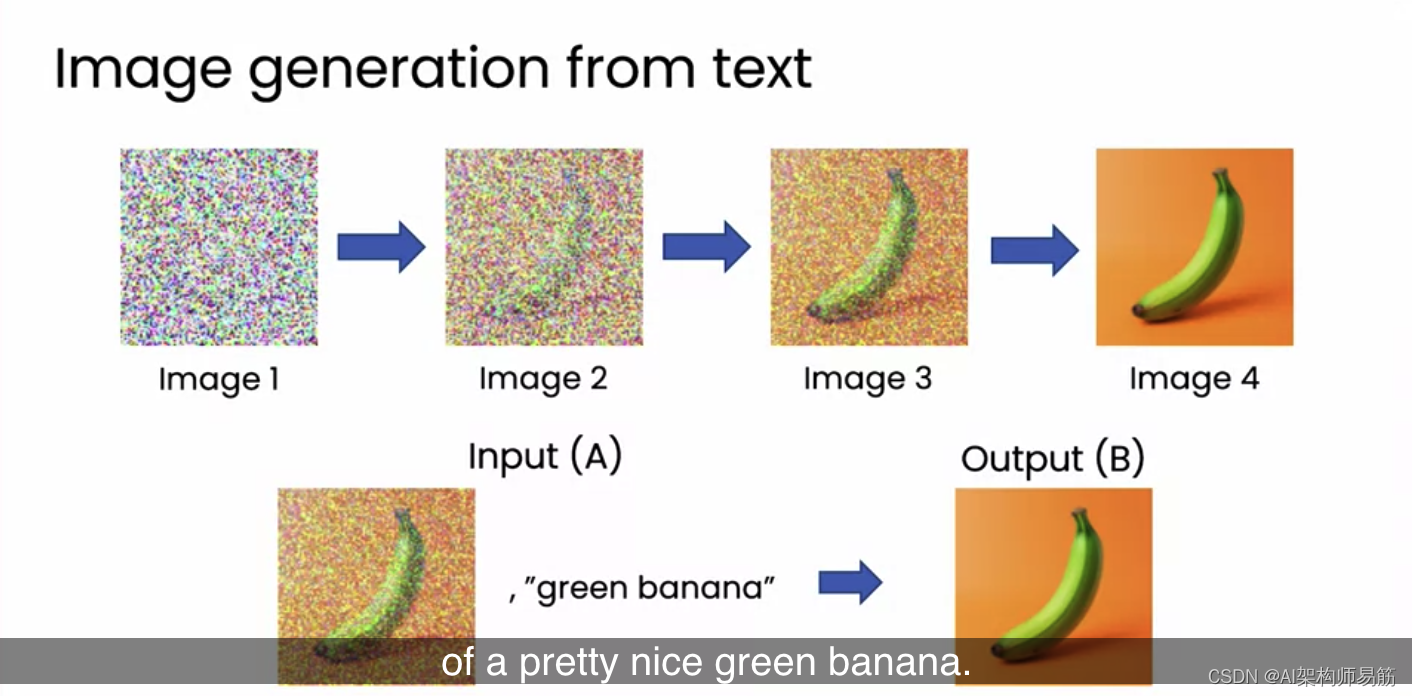

翻译: LLM大语言模型图像生成原理Image generation

文本生成是许多用户正在使用的,也是所有生成式人工智能工具中影响最大的。但生成式人工智能的一部分兴奋点也在于图像生成。目前也开始出现一些可以生成文本或图像的模型,这些有时被称为多模态模型,因为它们可以在多种模式中操作,…

Mistral AI 推出高质量的稀疏专家混合AI人工智能模型——SMoE,有望超越ChatGPT3.5

Mistral AI(“Mistral AI”是一家由前DeepMind和Meta Platforms(META.US)的研究人员组建的新公司。)继续履行为开发者社区提供最佳开放模型的使命。他们发布了 Mixtral 8x7B,这是一个高质量的稀疏专家混合模型…

Re58:读论文 REALM: Retrieval-Augmented Language Model Pre-Training

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类

论文名称:REALM: Retrieval-Augmented Language Model Pre-Training 模型名称:Retrieval-Augmented Language Model pre-training (REALM)

本文是2020年ICML论文,作者来自…

【论文解读】System 2 Attention提高大语言模型客观性和事实性

一、简要介绍 本文简要介绍了论文“System 2 Attention (is something you might need too) ”的相关工作。基于transformer的大语言模型(LLM)中的软注意很容易将上下文中的不相关信息合并到其潜在的表征中,这将对下一token的生成产生不利影响…

不用再找,这是大模型 LLM 微调经验最全总结

大家好,今天对大模型微调项目代码进行了重构,支持ChatGLM和ChatGLM2模型微调的切换,增加了代码的可读性,并且支持Freeze方法、Lora方法、P-Tuning方法、「全量参数方法」 微调。

PS:在对Chat类模型进行SFT时ÿ…

探索人工智能中的语言模型:原理、应用与未来发展

导言 语言模型在人工智能领域中扮演着重要的角色,它不仅是自然语言处理的基础,也是许多智能系统的核心。本文将深入研究语言模型的原理、广泛应用以及未来发展趋势。

1. 语言模型的原理

统计语言模型: 基于概率统计的传统语言模型&…

LCEL(Lang Chain Expression Language) 介绍:LangChain 的开发提效技巧

LCEL 介绍

LCEL(Lang Chain Expression Language)是将一些有趣的 Python 概念抽象成一种格式,使得可以构建 LangChain 组件链的 “极简主义” 代码层。

LCEL 具有以下强大的支持:

超快速开发链。高级特性,如流式处理…

AI模型平台Hugging Face存在API令牌漏洞;大型语言模型与任务模型

🦉 AI新闻

🚀 AI模型平台Hugging Face存在API令牌漏洞,黑客可窃取、修改模型

摘要:安全公司Lasso Security发现AI模型平台Hugging Face上存在API令牌漏洞,黑客可获取微软、谷歌等公司的令牌,并能够访问模…

一起学习:大型语言模型(LLM)中的QKV(Query, Key, Value)和多头注意力机制

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

认识“DRESS”:通过自然语言反馈与人类协调和互动的大视觉语言模型 (LVLM)

大视觉语言模型(LVLM)可以解释视觉线索并为用户交互提供简单的答复。这是通过巧妙地将大型语言模型 (LLM) 与大规模视觉指令微调融合来实现的。然而,LVLM 只需要手工制作或 LLM 生成的数据集即可通过监督微调 (SFT) 进行对齐。尽管将 LVLM 从…

本地搭建【文档助手】大模型版(LangChain+llama+Streamlit)

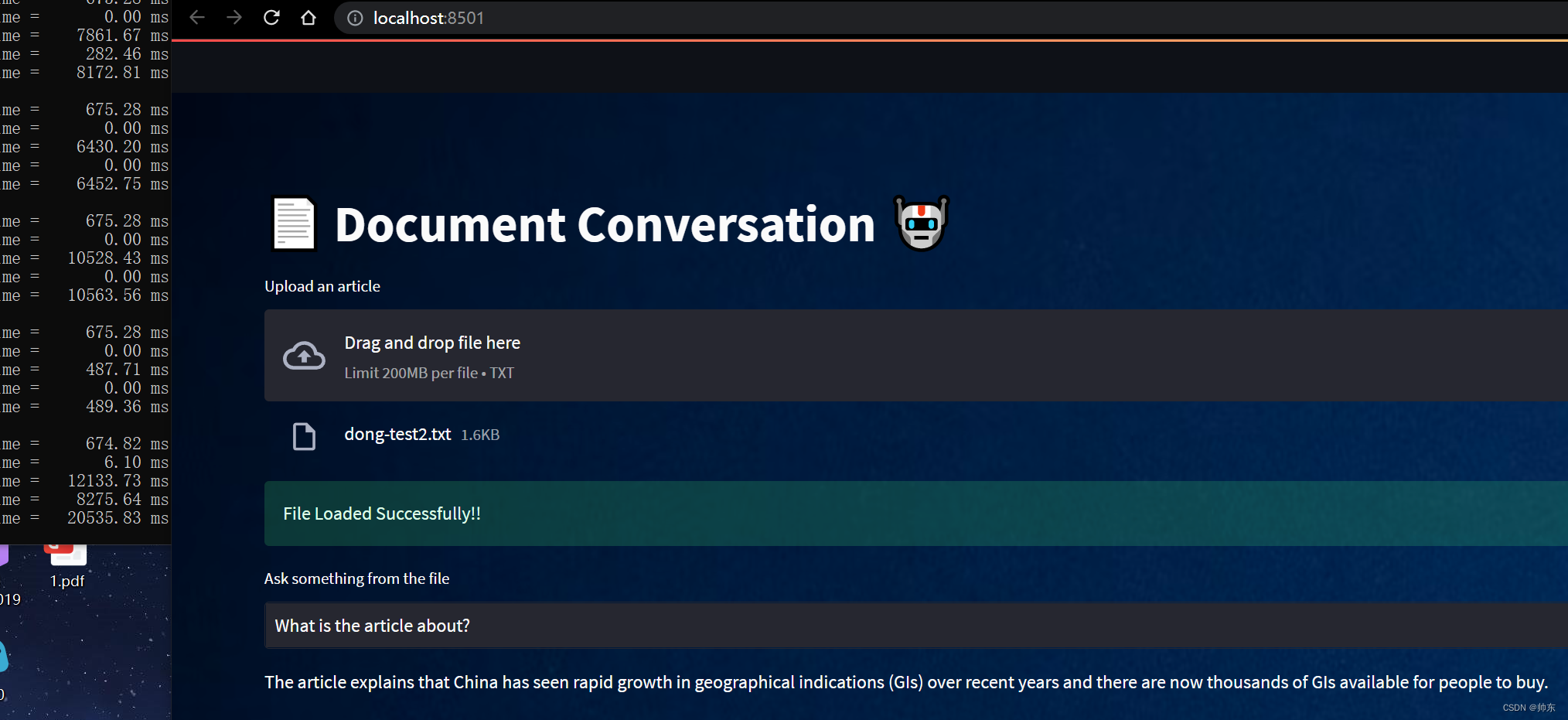

概述

本文的文档助手就是:我们上传一个文档,然后在对话框中输入问题,大模型会把问题的答案返回。

安装步骤

先下载代码到本地

LangChain调用llama模型的示例代码:https://github.com/afaqueumer/DocQA(代码不是本人…

LLM大语言模型(三):使用ChatGLM3-6B的函数调用功能前先学会Python的装饰器

目录 ChatGLM3-6B的函数调用模式示例

本地启动ChatGLM3-6B工具模式

如何在ChatGLM3-6B里新增一个自定义函数呢?

get_weather基于Python的装饰器实现

函数注解register_tool

现在我们来自定义一个kuakuawo()函数 ChatGLM3-6B的函数调用模式示例

ChatGLM3-6B目前…

第33期 | GPTSecurity周报

GPTSecurity是一个涵盖了前沿学术研究和实践经验分享的社区,集成了生成预训练Transformer(GPT)、人工智能生成内容(AIGC)以及大型语言模型(LLM)等安全领域应用的知识。在这里,您可以…

Nature | 大型语言模型(LLM)能够发现和产生新知识吗?

大型语言模型(LLM)是基于大量数据进行预训练的超大型深度学习模型。底层转换器是一组神经网络,这些神经网络由具有自注意力功能的编码器和解码器组成。编码器和解码器从一系列文本中提取含义,并理解其中的单词和短语之间的关系。通…

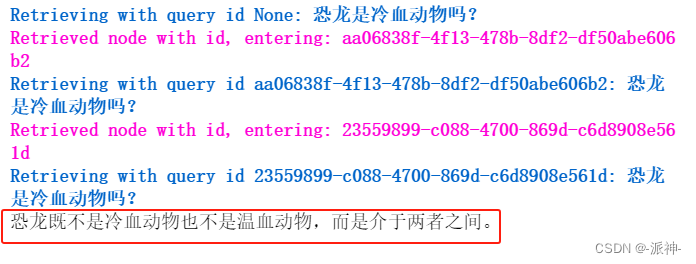

高级RAG(三):llamaIndex从小到大的检索

在上一篇博客:父文档检索器 中我们介绍了langchain中的两种父文档检索方式即:“检索完整文档”和“检索较大的文档块”。今天我们要介绍llamaIndex中与langchain的父文档检索有点相似的检索方法即“从小到大的检索”。

一、LlamaIndex 简介

LlamaIndex…

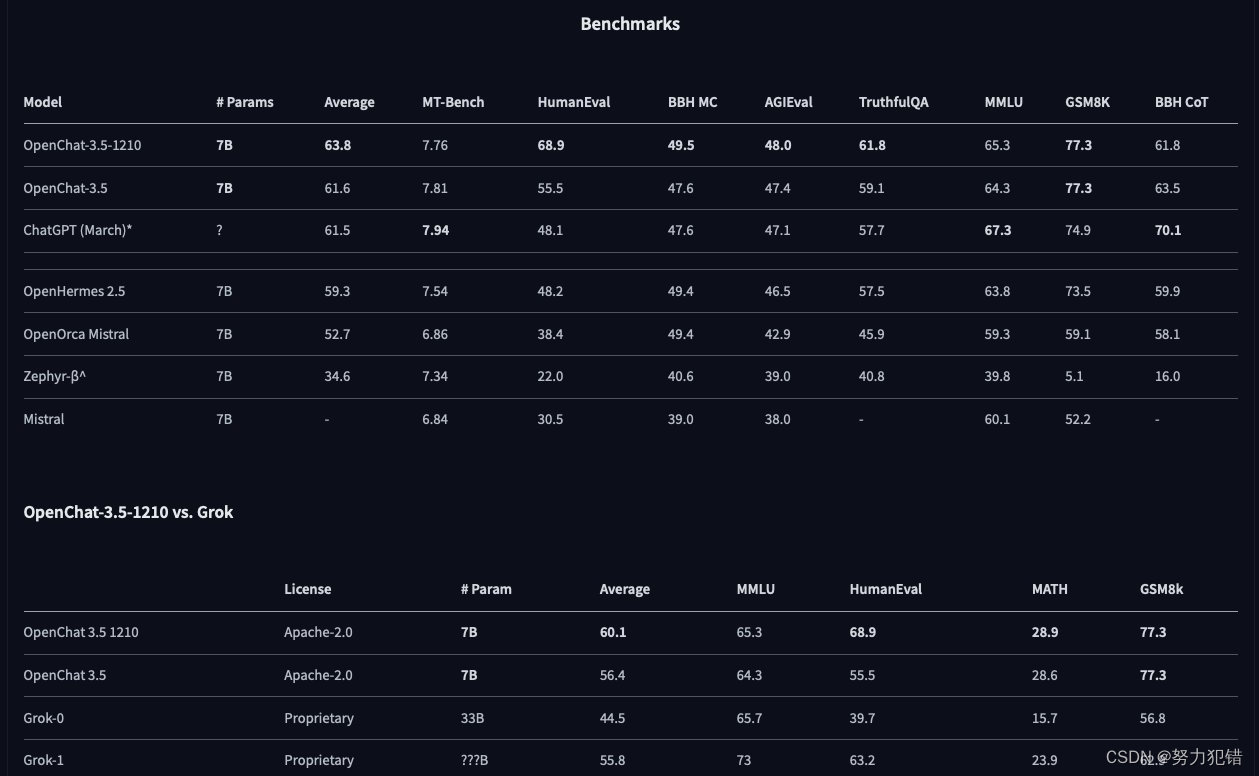

OpenChat-3.5:70亿参数下的AI突破

引言

在对话AI的发展史上,OpenChat-3.5标志着一个新纪元的到来。拥有70亿参数的这一模型,不仅是对现有语言学习模型(LLMs)的重大改进,更是在多模态任务中树立了新的标准。

模型概述

OpenChat-3.5作为一款先进的多模…

游戏NPC智能化:生成式AI如何改变虚拟世界

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

微软的 Copilot 已经如同 ChatGPT 一样,成为了安卓平台上的一款应用程序

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

用通俗易懂的方式讲解大模型:使用 Docker 部署大模型的训练环境

之前给大家介绍了主机安装方式——如何在 Ubuntu 操作系统下安装部署 AI 环境,但随着容器化技术的普及,越来越多的程序以容器的形式进行部署,通过容器的方式不仅可以简化部署流程,还可以随时切换不同的环境。

实际上很多云服务厂…

AI人工智能大模型讲师叶梓《基于人工智能的内容生成(AIGC)理论与实践》培训提纲

【课程简介】